W dynamicznie rozwijającym się świecie sztucznej inteligencji, publikacja każdego nowego modelu języka dużego (LLM) oznacza coś więcej niż tylko skok w wersji numerycznej – sygnalizuje postęp w rozumowaniu, umiejętnościach kodowania i współpracy człowiek-maszyna. Pod koniec września 2025 r. Zhipu AI (Z.ai) odsłonięty GLM-4.6, najnowszy członek rodziny modeli języka ogólnego. Bazując na solidnej architekturze i solidnych podstawach wnioskowania GLM-4.5, ta aktualizacja udoskonala możliwości modelu w rozumowanie agentowe, inteligencja kodowania i rozumienie długoterminowego kontekstu, pozostając jednocześnie otwartym i dostępnym zarówno dla programistów, jak i przedsiębiorstw.

Czym jest GLM-4.6?

GLM-4.6 to główne wydanie serii GLM (General Language Model), zaprojektowane w celu zrównoważenia wnioskowania o dużej pojemności z praktycznymi przepływami pracy programistów. Ogólnie rzecz biorąc, wydanie koncentruje się na trzech ściśle powiązanych przypadkach użycia: (1) zaawansowanym generowaniu kodu i wnioskowaniu o kodzie, (2) zadaniach o rozszerzonym kontekście, które wymagają zrozumienia modelu w oparciu o bardzo długie dane wejściowe, oraz (3) przepływach pracy opartych na agentach, w których model musi planować, wywoływać narzędzia i koordynować wieloetapowe procesy. Model jest dostarczany w wariantach przeznaczonych dla interfejsów API w chmurze i centrów modeli społecznościowych, umożliwiając zarówno hostowane, jak i hostowane samodzielnie wzorce wdrożeń.

W praktyce GLM-4.6 jest pozycjonowany jako flagowy produkt „najpierw dla programistów”: jego ulepszenia dotyczą nie tylko surowych wyników testów, ale także możliwości, które istotnie zmieniają sposób, w jaki programiści budują asystentów, pilotów kodu oraz agentów opartych na dokumentach lub wiedzy. Można się spodziewać wydania kładącego nacisk na dostrajanie instrukcji do korzystania z narzędzi, precyzyjne ulepszenia jakości kodu i debugowania oraz wybór infrastruktury, która umożliwia obsługę bardzo długich kontekstów bez liniowego spadku wydajności.

Jakie rozwiązanie ma GLM-4.6?

- Zmniejsz tarcie występujące podczas pracy z długimi bazami kodów i obszernymi dokumentami, obsługując dłuższe, efektywne okna kontekstowe.

- Popraw niezawodność generowania kodu i debugowania, uzyskując bardziej idiomatyczne, testowalne wyniki.

- Zwiększ solidność zachowań agentowych — planowania, używania narzędzi i wykonywania zadań wieloetapowych — poprzez ukierunkowane instrukcje i dostrajanie stylu wzmacniania.

Co zmieniło się w praktyce od GLM-4.5 do GLM-4.6?

- Skala kontekstowa: 128K skok do 200 XNUMX tokenów to największa zmiana w UX/architekturze dla użytkowników: długie dokumenty, całe bazy kodu czy rozszerzone transkrypcje agentów mogą być teraz przetwarzane w jednym oknie kontekstowym. Zmniejsza to potrzebę doraźnego dzielenia na fragmenty lub kosztownych pętli wyszukiwania w wielu przepływach pracy.

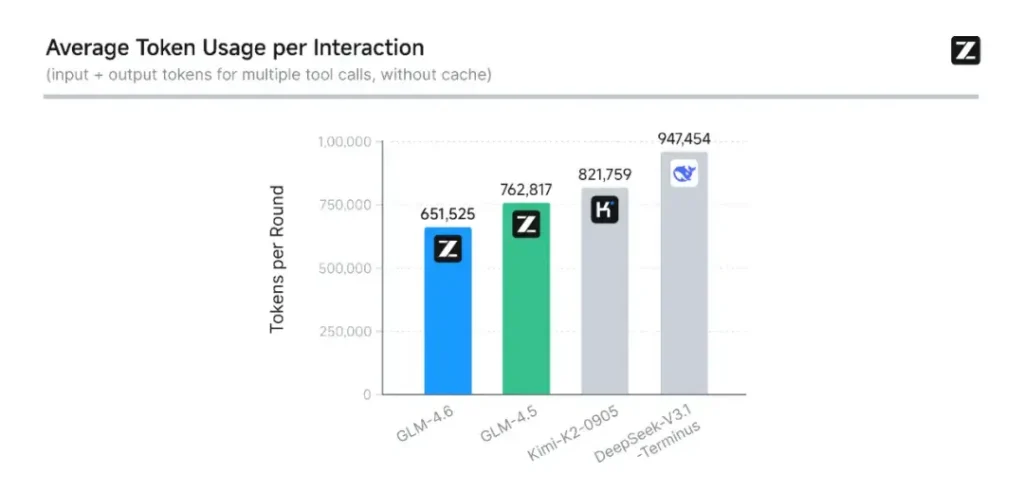

- Kodowanie i ocena w warunkach rzeczywistych: Firma Z.ai rozszerzyła CC-Bench (ich test porównawczy kodowania i ukończenia) o trudniejsze trajektorie zadań rzeczywistych i informuje, że GLM-4.6 kończy zadania z ~15% mniej tokenów niż GLM-4.5, jednocześnie poprawiając wskaźniki sukcesu w złożonych, wieloetapowych zadaniach inżynieryjnych. Oznacza to lepszą wydajność tokenów, a także poprawę surowych możliwości w scenariuszach kodowania. Z.ai

- Integracja agentów i narzędzi: GLM-4.6 zawiera lepsze wzorce obsługi wywoływania narzędzi i agentów wyszukiwania, co jest ważne w przypadku produktów, które opierają ten model na koordynacji wyszukiwania w sieci, wykonywania kodu lub innych mikrousług.

Jakie są najważniejsze cechy GLM-4.6?

1. Rozszerzone okno kontekstowe do 200 tys. tokenów

Jedną z najbardziej rzucających się w oczy cech GLM-4.6 jest jego masowo rozszerzone okno kontekstowe. Rozszerzenie z 128K w poprzedniej generacji do 200 XNUMX tokenówGLM-4.6 może przetwarzać całe książki, złożone zbiory danych obejmujące wiele dokumentów lub godziny dialogów w jednej sesji. To rozszerzenie nie tylko poprawia zrozumienie, ale także umożliwia… spójne rozumowanie w przypadku długich danych wejściowych — ogromny krok naprzód w zakresie podsumowywania dokumentów, analiz prawnych i przepływów pracy inżynierii oprogramowania.

2. Ulepszona inteligencja kodowania

Wewnętrzna wersja Zhipu AI Ławka CC benchmark, zestaw zadań programistycznych z zakresu realnego świata, pokazuje, że GLM-4.6 osiąga zauważalne ulepszenia w zakresie dokładności i wydajności kodowaniaModel może generować składniowo poprawny, logicznie poprawny kod przy użyciu około 15% mniej tokenów niż GLM-4.5 dla równoważnych zadań. Ta wydajność tokena oznacza szybsze i tańsze ukończenie projektu bez utraty jakości — co jest kluczowym czynnikiem dla wdrożeń w przedsiębiorstwach.

3. Zaawansowane rozumowanie i integracja narzędzi

Oprócz generowania surowego tekstu, GLM-4.6 wyróżnia się w rozumowanie wspomagane narzędziamiZostał on przeszkolony i dostosowany do wieloetapowego planowania i koordynacji systemów zewnętrznych – od baz danych, przez narzędzia wyszukiwania, po środowiska wykonawcze. W praktyce oznacza to, że GLM-4.6 może pełnić rolę „mózgu” autonomiczny agent AI, decydując, kiedy wywołać zewnętrzne interfejsy API, jak interpretować wyniki i jak zachować ciągłość zadania pomiędzy sesjami.

4. Ulepszone dopasowanie języka naturalnego

Dzięki ciągłemu uczeniu się przez wzmacnianie i optymalizacji preferencji, GLM-4.6 zapewnia płynniejszy przepływ konwersacji, lepsze dopasowanie stylu i silniejsze dopasowanie bezpieczeństwaModel dostosowuje swój ton i strukturę do kontekstu — niezależnie od tego, czy jest to formalna dokumentacja, korepetycje edukacyjne czy twórcze pisanie — zwiększając zaufanie użytkowników i czytelność.

Jaka architektura stanowi podstawę GLM-4.6?

Czy GLM-4.6 jest modelem mieszanym?

Ciągłość metody wnioskowania: Zespół GLM wskazuje, że GLM-4.5 i GLM-4.6 korzystają z tego samego fundamentalnego procesu wnioskowania, co pozwala na aktualizację istniejących konfiguracji wdrożeniowych z minimalnym oporem. Zmniejsza to ryzyko operacyjne dla zespołów już korzystających z GLM-4.x – parametry skalowania i wybory dotyczące projektowania modeli, które kładą nacisk na specjalizację w zakresie rozumowania agentowego, kodowania i efektywnego wnioskowania. Raport GLM-4.5 zawiera najbardziej przejrzysty publiczny opis strategii MoE i schematu szkolenia rodziny (wieloetapowe szkolenie wstępne, iteracja modelu eksperckiego, uczenie się przez wzmacnianie w celu zapewnienia zgodności); GLM-4.6 stosuje te wnioski, jednocześnie dostosowując długość kontekstu i możliwości specyficzne dla danego zadania.

Praktyczne notatki architektoniczne dla inżynierów

- Ślad parametrów a aktywowane obliczenia: Duże sumy parametrów (setki miliardów) nie przekładają się bezpośrednio na równoważny koszt aktywacji każdego żądania — MoE oznacza, że tylko podzbiór ekspertów aktywuje każdą sekwencję tokenów, co zapewnia korzystniejszy kompromis między kosztami a przepustowością w przypadku wielu obciążeń.

- Precyzja i formaty tokenów: Publiczne wagi są dystrybuowane w formatach BF16 i F32, a kwantyzacje społecznościowe (GGUF, 4-/8-/bity) szybko się pojawiają; umożliwiają one zespołom uruchamianie GLM-4.6 na różnych profilach sprzętowych.

- Zgodność stosu wnioskowania: Z.ai dokumentuje vLLM i inne nowoczesne środowiska uruchomieniowe LLM jako kompatybilne moduły wnioskowania, co sprawia, że GLM-4.6 nadaje się zarówno do wdrożeń w chmurze, jak i lokalnych.

Wydajność testowa: jak wypada GLM-4.6?

Jakie wyniki testów porównawczych podano?

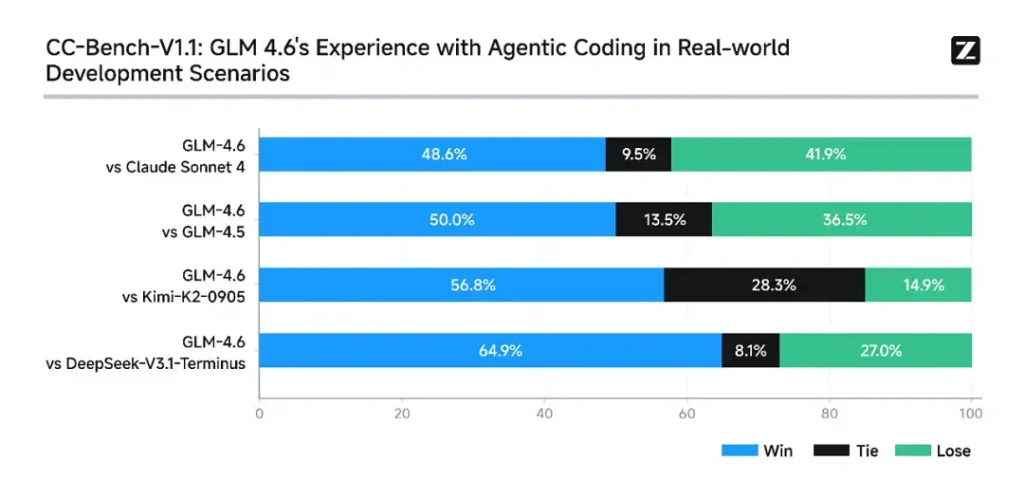

Z.ai ocenił GLM-4.6 w zestawie osiem publicznych benchmarków Obejmowały one zadania agentowe, wnioskowanie i kodowanie. Rozszerzyli również CC-Bench (test porównawczy kodowania zadań rzeczywistych, oceniany przez ludzi, uruchamiany w środowiskach odizolowanych od Dockera), aby lepiej symulować zadania inżynierii produkcji (programowanie front-end, testowanie, algorytmiczne rozwiązywanie problemów). W tych zadaniach GLM-4.6 wykazał stałą poprawę w porównaniu z GLM-4.5.

Wydajność kodowania

- Wygrane w prawdziwych zadaniach: W ocenach ludzi w CC-Bench GLM-4.6 osiągnął blisko parytetu z grą Claude Sonnet 4 firmy Anthropic w zadaniach wymagających bezpośredniego kontaktu i wielu tur — Z.ai informuje % 48.6 stopa zwycięstwo w ich izolowanych od Dockera, ocenianych przez ludzi ocenach (interpretacja: niemal 50/50 z Claude Sonnet 4 w ich starannie dobranym zestawie). Jednocześnie GLM-4.6 przewyższył szereg krajowych modeli otwartych (np. warianty DeepSeek) w swoich zadaniach.

- Efektywność tokena: Z.ai raportuje ~15% mniej tokenów używany do kończenia zadań w porównaniu z GLM-4.5 w trajektoriach CC-Bench — ma to znaczenie zarówno pod względem opóźnień, jak i kosztów.

Rozumowanie i matematyka

GLM-4.6 zapewnia lepszą zdolność rozumowania i lepszą wydajność w korzystaniu z narzędzi w porównaniu z GLM-4.5. Podczas gdy GLM-4.5 kładł nacisk na hybrydowe tryby „myślenia” i odpowiedzi bezpośredniej, GLM-4.6 zwiększa odporność na rozumowanie wieloetapowe – zwłaszcza po integracji z narzędziami do wyszukiwania lub wykonywania.

Publiczne komunikaty Z.ai przedstawiają GLM-4.6 jako konkurencyjna w stosunku do wiodących modeli międzynarodowych i krajowych w wybranych przez siebie testach porównawczych – konkretnie, konkurując z Claude Sonnet 4 i przewyższając niektóre krajowe alternatywy, takie jak warianty DeepSeek, w zadaniach kodu/agenta. Jednak w niektórych podtestach specyficznych dla kodowania** GLM-4.6 nadal ustępuje Claude Sonnet 4.5 (nowszej wersji Anthropic), co sprawia, że sytuacja jest bardziej zacięta niż absolutna dominacja.

Jak uzyskać dostęp do GLM-4.6

- 1. Za pośrednictwem platformy Z.ai: Deweloperzy mogą uzyskać dostęp do GLM-4.6 bezpośrednio za pośrednictwem API Z.ai or **interfejs czatu (chat.z.ai)**Te hostowane usługi umożliwiają szybkie eksperymentowanie i integrację bez konieczności lokalnego wdrażania. API obsługuje zarówno standardowe uzupełnianie tekstu, jak i ustrukturyzowane tryby wywoływania narzędzi – niezbędne dla przepływów pracy agentów.

- 2. Otwarte ciężarki na Hugging Face i ModelScope: Dla osób preferujących sterowanie lokalne firma Zhipu AI udostępniła pliki modelu GLM-4.6 Przytulanie Twarzy oraz Zakres modelu, w tym wersje z bezpiecznymi tensorami BF16 oraz F32 precyzja. Twórcy oprogramowania ze społeczności stworzyli już skwantyzowane wersje GGUF, umożliwiające wnioskowanie na procesorach graficznych klasy konsumenckiej.

- 3. Ramy integracyjne: GLM-4.6 płynnie integruje się z głównymi silnikami wnioskowania, takimi jak vLLM, SGLang, Wdrażanie LMDeploy, co czyni go kompatybilnym z nowoczesnymi systemami obsługi. Ta wszechstronność pozwala przedsiębiorstwom wybierać między chmura, krawędź, wdrożenie lokalne w zależności od wymagań zgodności lub opóźnień.

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Najnowsza integracja GLM-4.6 wkrótce pojawi się w CometAPI, więc bądźcie czujni! Podczas gdy finalizujemy przesyłanie modelu GLM 4.6, zapoznaj się z naszymi innymi modelami na stronie Modele lub wypróbuj je w AI Playground.

Deweloperzy mogą uzyskać dostęp Interfejs API GLM‑4.5 poprzez CometAPI, najnowsza wersja modelu jest zawsze aktualizowany na oficjalnej stronie internetowej. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Gotowy do drogi?→ Zarejestruj się w CometAPI już dziś !

Wnioski — dlaczego GLM-4.6 ma teraz znaczenie

GLM-4.6 to ważny kamień milowy w linii GLM, ponieważ łączy praktyczne usprawnienia dla programistów – dłuższe okna kontekstowe, ukierunkowane optymalizacje kodowania i agentów oraz wymierne korzyści z testów porównawczych – z otwartością i elastycznością ekosystemu, których oczekuje wiele organizacji. Dla zespołów tworzących asystentów kodu, agentów dokumentów o długiej formie lub automatyzację opartą na narzędziach, GLM-4.6 jest wart rozważenia jako najlepszy kandydat.