Kimi K2 stanowi znaczący krok naprzód w dziedzinie dużych modeli językowych open source, łącząc najnowocześniejszą architekturę opartą na połączeniu eksperckiej wiedzy ze specjalistycznym szkoleniem w zakresie zadań agentowych. Poniżej omawiamy jego genezę, projekt, wydajność oraz praktyczne aspekty dostępu i użytkowania.

Czym jest Kimi K2?

Kimi K2 to bilionowy model językowy oparty na mieszance ekspertów (MoE), opracowany przez Moonshot AI. Zawiera 32 miliardy „aktywowanych” parametrów – tych zaangażowanych w każdy token – i łączną liczbę biliona parametrów eksperckich, co zapewnia ogromną wydajność bez kosztów wnioskowania liniowego. Zbudowany na optymalizatorze Muon, Kimi K1 został wytrenowany na ponad 2 biliona tokenów, osiągając stabilność w skalach wcześniej uważanych za niepraktyczne. Model jest oferowany w dwóch głównych wariantach:

Kimi‑K2‑Instruct: Wstępnie dostrojone do zastosowań konwersacyjnych i agentowych, gotowe do natychmiastowego wdrożenia w systemach dialogowych i przepływach pracy obsługiwanych przez narzędzia.

Kimi‑K2‑Baza: Model podstawowy nadający się do badań, dostrajania na zamówienie i eksperymentów na niskim poziomie.

Jak działa jego architektura?

- Grupa ekspertów (MoE): Na każdym poziomie mechanizm bramkujący wybiera niewielką grupę ekspertów (8 z 384), którzy zajmują się przetwarzaniem każdego tokena. W ten sposób znacznie zmniejsza się zapotrzebowanie na moc obliczeniową potrzebną do wnioskowania, a jednocześnie utrzymywana jest ogromna baza wiedzy.

- Warstwy specjalistyczne: Zawiera pojedynczą gęstą warstwę wraz z 61 warstwami ogółem, z 64 głowicami skupiającymi uwagę i ukrytymi wymiarami dostosowanymi do wydajności MoE.

- Kontekst i słownictwo: Obsługuje do 128 tys. tokenów w długości kontekstu i słownik 160 tys. tokenów, umożliwiając zrozumienie i generowanie dłuższych form.

Dlaczego Kimi K2 jest ważny?

Kimi K2 przesuwa granice sztucznej inteligencji opartej na otwartym kodzie źródłowym, zapewniając wydajność porównywalną z wiodącymi zastrzeżonymi modelami, szczególnie w testach kodowania i wnioskowania.

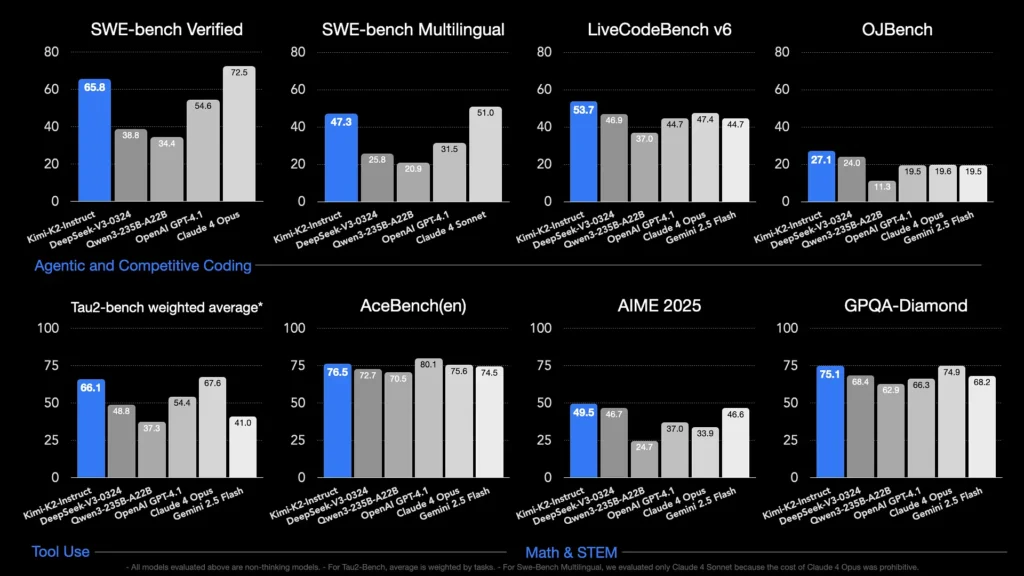

Jakie testy porównawcze prezentują jego możliwości?

- LiveCodeBench v6: Osiąga wskaźnik pass@1 na poziomie 53.7%, co daje mu pozycję lidera wśród modeli open-source i pozwala mu konkurować z zamkniętymi systemami, takimi jak GPT‑4.1 (44.7%).

- Zweryfikowano w SWE‑bench: Uzyskuje wynik 65.8%, przewyższając wynik GPT‑4.1 wynoszący 54.6% i zajmując drugie miejsce po Claude Sonnet 4 w publicznie dostępnych testach porównawczych.

- MultiPL‑E i OJBench: Wykazuje solidne umiejętności kodowania wielojęzycznego (85.7% w teście MultiPL‑E) i niezawodną wydajność w rozwiązywaniu rzeczywistych problemów programistycznych.

- Matematyka-500:Osiąga wynik 97.4%, przewyższając wynik GPT-4.1 wynoszący 92.4%, co dowodzi jego biegłości w formalnym rozumowaniu matematycznym.

W jaki sposób jest on zoptymalizowany pod kątem zadań agentowych?

Poza generowaniem surowych danych, Kimi K2 został przeszkolony z wykorzystaniem syntetycznych scenariuszy użycia narzędzi – danych Model Context Protocol (MCP) – w celu wywoływania narzędzi zewnętrznych, wnioskowania w oparciu o wieloetapowe procesy i autonomicznego rozwiązywania problemów. Dzięki temu jest szczególnie sprawny w środowiskach takich jak Cline, gdzie może płynnie koordynować wykonywanie kodu, interakcję z API i automatyzację przepływu pracy.

Jak uzyskać dostęp do Kimi K2?

Opcje dostępu obejmują oficjalne platformy, dystrybucje open source i integracje z rozwiązaniami stron trzecich, zaspokajając potrzeby w zakresie badań, rozwoju i przedsiębiorstw.

Oficjalna platforma Moonshot AI

Moonshot AI oferuje hostowaną inferencję za pośrednictwem swojej platformy, zapewniając dostęp do API o niskim opóźnieniu zarówno dla wariantów Kimi‑K2‑Base, jak i Kimi‑K2‑Instruct. Ceny zależą od zużycia mocy obliczeniowej, a plany korporacyjne obejmują priorytetowe wsparcie i wdrożenia lokalne. Użytkownicy mogą zarejestrować się na stronie internetowej Moonshot AI i pobrać klucze API do natychmiastowej integracji.

Interfejs API Comet

CometAPI zintegrowało już K2 ze swoją ofertą. Łączy ono wnioskowanie K2 z zarządzaną infrastrukturą GPU, gwarancjami SLA i skalowalnymi poziomami cenowymi, umożliwiając organizacjom wybór między płatnością za rzeczywiste wykorzystanie API a rezerwacją pojemności z rabatami ilościowymi.

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT OpenAI, Gemini Google, Claude Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami.

Deweloperzy mogą uzyskać dostęp Kimi K2 API(kimi-k2-0711-preview)Poprzez Interfejs API CometNa początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po APIaby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API.

Integracje z narzędziami innych firm

- Cline: Popularne środowisko IDE skoncentrowane na kodzie, które natywnie obsługuje Kimi K2 za pośrednictwem

cline:moonshotai/kimi-k2dostawca, dający programistom dostęp jednym kliknięciem do czatu, generowania kodu i przepływów pracy agentów w ich edytorze. - Przytulanie twarzy: Demo prowadzone przez społeczność i minimalistyczny interfejs użytkownika pozwalają użytkownikom na interakcję z modelami K2‑Instruct bezpośrednio w przeglądarce. Wymagane jest konto Hugging Face, a wydajność może się różnić w zależności od współdzielonych zasobów zaplecza.

Jak stosować Kimi K2?

Po wybraniu metody dostępu możesz używać K2 do różnych zadań — od czatów, przez wykonywanie kodu, po autonomicznych agentów.

Za pośrednictwem API lub platformy SDK

- Uwierzytelniać: Pobierz swój klucz API z Moonshot AI lub CometAPI.

- Zainicjuj klienta: Użyj oficjalnego zestawu SDK (Python/JavaScript) lub standardowych żądań HTTP.

- Wybierz wariant modelu:

- Kimi‑K2‑Base do dopracowania i badań.

- Kimi‑K2‑Instruct do czatów i agentów typu plug-and-play.

- Model CometAPI:

kimi-k2-0711-preview

- Wyślij monity: Formatuj dane wejściowe zgodnie ze szablonem czatu (role systemowe, użytkownika, asystenta), aby zoptymalizować zachowanie związane z przestrzeganiem instrukcji.

Uruchamianie lokalne z llama.cpp

W przypadku konfiguracji offline lub hostowanych samodzielnie należy używać wag GGUF skwantyzowanych według Unsloth (245 GB dla 1.8-bitowego kwantu dynamicznego).

- Wagi pobierania: Z repozytorium Moonshot AI GitHub lub Hugging Face.

- Zainstaluj llama.cpp: Upewnij się, że dysponujesz wystarczającą ilością miejsca na dysku (≥ 250 GB) i łączną pamięcią RAM+VRAM (≥ 250 GB) dla przepustowości ~5 tokenów/s.

- Model startowy:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Dostosuj ustawienia: Użyj zalecanych parametrów (

rope_freq_base,context_len) udokumentowano w podręczniku Unsloth pod kątem stabilnej wydajności.

Integracje z narzędziami programistycznymi

- Wtyczki IDE: Kilka wtyczek społecznościowych umożliwia korzystanie z K2 w środowiskach IDE VS Code, Neovim i JetBrains. Konfiguracja zazwyczaj polega na określeniu punktu końcowego API i identyfikatora modelu w ustawieniach.

- Ramy automatyzacji: Wykorzystaj rdzeń agentowy K2 wraz z frameworkami takimi jak LangChain lub Haystack, aby łączyć monity, wywołania API i kroki wykonywania kodu w złożone automatyzacje.

Jakie są typowe przypadki użycia Kimi K2?

Połączenie skali, szkolenia agentów i otwartego dostępu sprawia, że rozwiązanie K2 jest wszechstronne w różnych domenach.

Pomoc w kodowaniu

Począwszy od generowania szablonów i refaktoryzacji, aż po naprawianie błędów i profilowanie wydajności, testy porównawcze kodowania SOTA firmy K2 przekładają się na rzeczywisty wzrost produktywności, często przewyższając alternatywy pod względem czytelności i prostoty.

Wiedza i rozumowanie

Dzięki długości kontekstu 128 KB, K2 obsługuje długie dokumenty, pytania i odpowiedzi obejmujące wiele dokumentów oraz rozumowanie oparte na łańcuchu myślowym. Architektura MoE zapewnia zapamiętywanie różnorodnej wiedzy bez katastrofalnego zapominania.

Przepływy pracy agentów

K2 doskonale sprawdza się w organizowaniu zadań składających się z wielu etapów — pobierania danych, wywoływania interfejsów API, aktualizowania baz kodów i podsumowywania wyników — co czyni je idealnym rozwiązaniem dla autonomicznych asystentów w obsłudze klienta, analizie danych i DevOps.

Jak Kimi K2 wypada na tle innych modeli Open Source?

Podczas gdy ostatnie otwarte wydania DeepSeek V3 i Meta zdominowały nagłówki gazet na początku 2025 r., Kimi K2 wyróżnia się poprzez:

Inteligencja agentowa

Kimi K2 został zaprojektowany specjalnie z myślą o „agentowych” przepływach pracy – automatyzacji zadań za pomocą wywołań narzędzi, poleceń powłoki, automatyzacji sieciowej i integracji API. Jego zestaw danych treningowych, wzbogacony o funkcje samoodtwarzania, zawiera różnorodne przykłady wywołań narzędzi, umożliwiając bezproblemową integrację z systemami rzeczywistymi.

Efektywność kosztowa

Przy koszcie wnioskowania na token niższym o około 80–90% w porównaniu z modelami takimi jak Claude Sonnet 4, Kimi K2 oferuje wydajność klasy korporacyjnej w przystępnej cenie, co przyczynia się do szybkiej adopcji wśród programistów wrażliwych na cenę.

Licencje i dostępność

W przeciwieństwie do niektórych wydań open source obciążonych restrykcyjnymi licencjami, Kimi K2 jest dostępny na podstawie licencji zezwalającej na użytkowanie komercyjne, tworzenie prac pochodnych i lokalne wdrożenia, co jest zgodne z filozofią open source Moonshot AI.

- Łącząc najnowocześniejszą konstrukcję MoE, rygorystyczne szkolenie agentów i dostępność oprogramowania open source, Kimi K2 umożliwia programistom i badaczom tworzenie inteligentnych, autonomicznych aplikacji bez zaporowych kosztów i zamkniętych ekosystemów. Niezależnie od tego, czy piszesz kod, tworzysz złożone, wieloetapowe przepływy pracy, czy eksperymentujesz z wnioskowaniem na dużą skalę, K2 oferuje wszechstronne, wydajne podstawy.