Czym jest Llama 4?

Meta Platforms zaprezentowało swój najnowszy zestaw dużych modeli językowych (LLM) w ramach serii Llama 4, co oznacza znaczący postęp w technologii sztucznej inteligencji. Kolekcja Llama 4 wprowadza dwa główne modele w kwietniu 2025 r.: Llama 4 Scout i Llama 4 Maverick. Modele te są przeznaczone do przetwarzania i tłumaczenia różnych formatów danych, w tym tekstu, wideo, obrazów i dźwięku, prezentując ich możliwości multimodalne. Ponadto Meta zaprezentowała Llama 4 Behemoth, nadchodzący model reklamowany jako jeden z najpotężniejszych LLM do tej pory, mający pomóc w szkoleniu przyszłych modeli.

Czym Llama 4 różni się od poprzednich modeli?

Zwiększone możliwości multimodalne

W przeciwieństwie do swoich poprzedników, Llama 4 została zaprojektowana tak, aby bezproblemowo obsługiwać wiele modalności danych. Oznacza to, że może analizować i generować odpowiedzi na podstawie tekstu, obrazów, filmów i danych wejściowych audio, co czyni ją wysoce adaptowalną do różnych zastosowań.

Wprowadzenie modeli specjalistycznych

Firma Meta wprowadziła dwie specjalistyczne wersje w ramach serii Llama 4:

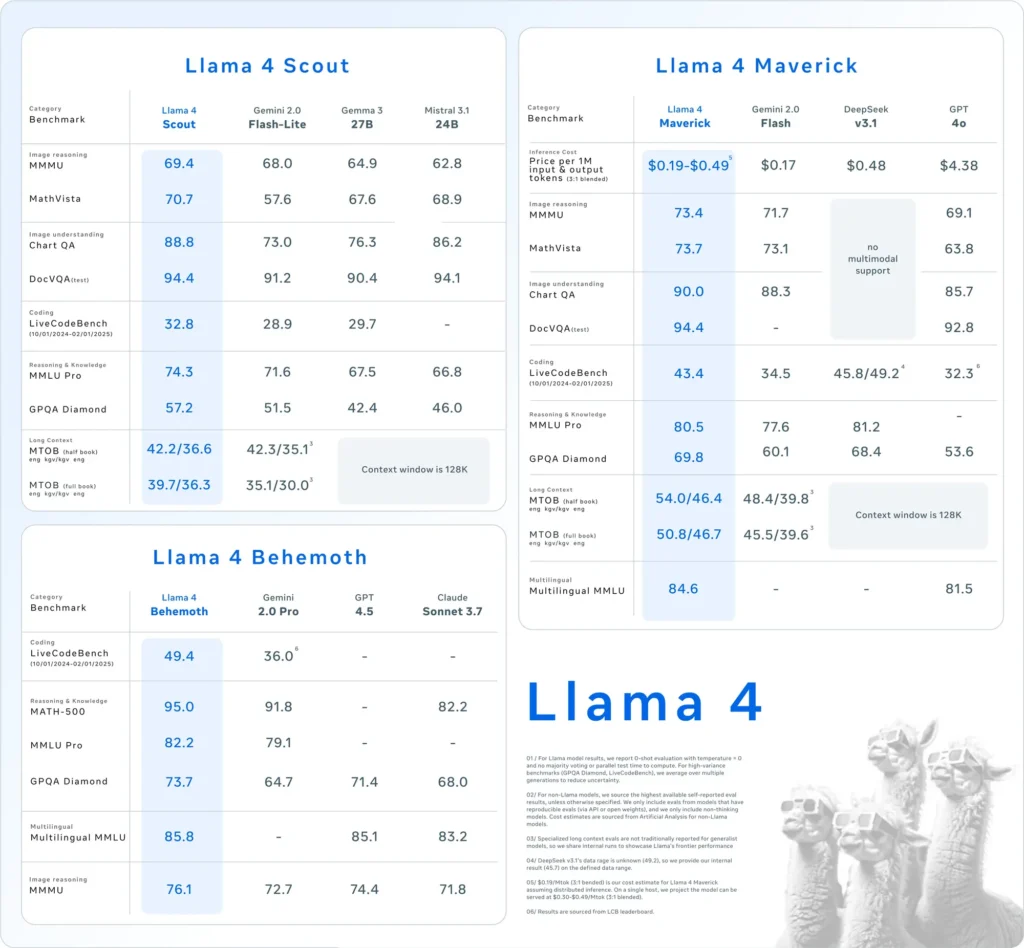

- Lama 4 Scout:Kompaktowy model zoptymalizowany do wydajnej pracy na pojedynczym procesorze graficznym Nvidia H100. Posiada okno kontekstowe o pojemności 10 milionów tokenów i wykazał wyższą wydajność w porównaniu z konkurentami, takimi jak Google Gemma 3 i Mistral 3.1 w różnych testach porównawczych.

- Lama 4 Maverick:Większy model, którego wydajność jest porównywalna z GPT-4o i DeepSeek-V3 firmy OpenAI, szczególnie wyróżniający się w zadaniach kodowania i wnioskowania przy wykorzystaniu mniejszej liczby aktywnych parametrów.

Ponadto Meta rozwija Lama 4 Behemoth, model z 288 miliardami aktywnych parametrów i łączną liczbą 2 bilionów, którego celem jest prześcignięcie modeli takich jak GPT-4.5 i Claude Sonnet 3.7 w testach porównawczych STEM.

Wdrożenie architektury mieszanej ekspertów (MoE)

Llama 4 wykorzystuje architekturę „mieszanki ekspertów” (MoE), dzieląc model na wyspecjalizowane jednostki w celu optymalizacji wykorzystania zasobów i zwiększenia wydajności. To podejście umożliwia bardziej wydajne przetwarzanie poprzez aktywowanie tylko odpowiednich podzbiorów modelu dla określonych zadań.

Jak Llama 4 wypada na tle innych modeli sztucznej inteligencji?

Llama 4 plasuje się w czołówce modeli sztucznej inteligencji:

- Benchmarki wydajności:Wydajność Llama 4 Maverick w przypadku zadań kodowania i wnioskowania dorównuje OpenAI GPT-4o i DeepSeek-V3, podczas gdy Llama 4 Scout przewyższa modele takie jak Google Gemma 3 i Mistral 3.1 w różnych testach porównawczych.

- Podejście typu open source:Meta nadal oferuje modele Llama jako open-source, promując szerszą współpracę i integrację na różnych platformach. Jednak licencja Llama 4 nakłada ograniczenia na podmioty komercyjne z ponad 700 milionami użytkowników, co wywołuje dyskusje na temat prawdziwej otwartości modelu.

| Kategoria | Benchmark | Lama 4 Maverick | GPT-4o | Gemini 2.0 Flash | DeepSeek v3.1 |

|---|---|---|---|---|---|

| Rozumowanie obrazowe | MMMU | 73.4 | 69.1 | 71.7 | Brak wsparcia multimodalnego |

| MatematykaVista | 73.7 | 63.8 | 73.1 | Brak wsparcia multimodalnego | |

| Zrozumienie obrazu | WykresQA | 90.0 | 85.7 | 88.3 | Brak wsparcia multimodalnego |

| DocVQA (test) | 94.4 | 92.8 | - | Brak wsparcia multimodalnego | |

| Kodowanie | LiveCodeBench | 43.4 | 32.3 | 34.5 | 45.8/49.2 |

| Rozumowanie i wiedza | MMLU Pro | 80.5 | - | 77.6 | 81.2 |

| Diament GPQA | 69.8 | 53.6 | 60.1 | 68.4 | |

| Wielojęzyczny | Wielojęzyczny MMLU | 84.6 | 81.5 | - | - |

| Długi kontekst | MTOB (pół książki) eng→kgv/kgv→eng | 54.0/46.4 | Kontekst ograniczony do 128K | 48.4/39.8 | Kontekst ograniczony do 128K |

| MTOB (pełna książka) eng→kgv/kgv→eng | 50.8/46.7 | Kontekst ograniczony do 128K | 45.5/39.6 | Kontekst ograniczony do 128K |

Jak Llama 4 wypada w testach porównawczych?

Oceny porównawcze dostarczają informacji na temat wydajności modeli Llama 4:

- Lama 4 Scout:Ten model przewyższa kilku konkurentów, w tym Google Gemma 3 i Mistral 3.1, w różnych testach porównawczych. Jego zdolność do działania z 10-milionowym oknem kontekstowym tokenów na jednym GPU podkreśla jego wydajność i skuteczność w obsłudze złożonych zadań.

- Lama 4 Maverick: Porównywalny pod względem wydajności do OpenAI's GPT-4o i DeepSeek-V3, Llama 4 Maverick wyróżnia się w zadaniach kodowania i rozumowania, wykorzystując jednocześnie mniej aktywnych parametrów. Ta wydajność nie wiąże się z kosztem możliwości, co czyni go silnym konkurentem w krajobrazie LLM.

- Lama 4 Behemoth: Z 288 miliardami aktywnych parametrów i łącznie 2 bilionami, Llama 4 Behemoth przewyższa modele takie jak GPT-4.5 i Claude Sonnet 3.7 w testach porównawczych STEM. Jego obszerna liczba parametrów i wydajność wskazują na jego potencjał jako modelu bazowego dla przyszłych osiągnięć w dziedzinie sztucznej inteligencji.

Wyniki testów porównawczych podkreślają zaangażowanie firmy Meta w rozwijanie możliwości sztucznej inteligencji i pozycjonowanie serii Llama 4 jako poważnego gracza na tym polu.

W jaki sposób użytkownicy mogą uzyskać dostęp do Llama 4?

Meta zintegrowała modele Llama 4 ze swoim asystentem AI, dzięki czemu są dostępne na platformach takich jak WhatsApp, Messenger, Instagram i sieć. Ta integracja pozwala użytkownikom doświadczyć ulepszonych możliwości Llama 4 w znanych aplikacjach.

Dla programistów i badaczy zainteresowanych wykorzystaniem Llama 4 do niestandardowych aplikacji, Meta zapewnia dostęp do wag modelu za pośrednictwem platform takich jak Hugging Face i własnych kanałów dystrybucji. To podejście typu open source umożliwia społeczności AI wprowadzanie innowacji i rozwijanie możliwości Llama 4.

Ważne jest, aby zauważyć, że chociaż Llama 4 jest sprzedawana jako oprogramowanie typu open source, licencja nakłada ograniczenia na podmioty komercyjne z ponad 700 milionami użytkowników. Organizacje powinny zapoznać się z warunkami licencji, aby zapewnić zgodność z wytycznymi Meta.

Buduj szybko z Llama 4 na CometAPI

CometAPI zapewnia dostęp do ponad 500 modeli AI, w tym modeli open source i specjalistycznych modeli multimodalnych dla czatu, obrazów, kodu i nie tylko. Jego główna siła polega na uproszczeniu tradycyjnie złożonego procesu integracji AI. Centralizując agregację API na jednej platformie, oszczędza użytkownikom cenny czas i zasoby, które w przeciwnym razie zostałyby wydane na zarządzanie oddzielnymi platformami i dostawcami. Dzięki temu dostęp do wiodących narzędzi AI, takich jak Claude, OpenAI, Deepseek i Gemini, jest dostępny za pośrednictwem pojedynczej, ujednoliconej subskrypcji. Możesz użyć API w CometAPI do tworzenia muzyki i dzieł sztuki, generowania filmów i budowania własnych przepływów pracy.

Interfejs API Comet zaoferuj cenę znacznie niższą od oficjalnej, aby ułatwić Ci integrację API Lamy 4, a otrzymasz 1$ na swoje konto po zarejestrowaniu się i zalogowaniu! Zapraszamy do rejestracji i doświadczenia CometAPI.CometAPI płaci za użytkowanie,API Lamy 4 Cennik CometAPI jest następujący:

| Kategoria | lama-4-maverick | lama-4-zwiadowca |

| Ceny API | Żetony wejściowe: 0.48 USD / mln żetonów | Tokeny wejściowe: 0.216 USD / mln tokenów |

| Żetony wyjściowe: 1.44 USD/M żetonów | Żetony wyjściowe: 1.152 USD/M żetonów |

- Sprawdź API Lamy 4 aby uzyskać szczegóły dotyczące integracji.

- Aby uzyskać informacje o modelu uruchomionym w interfejsie API Comet, zobacz https://api.cometapi.com/new-model.

- Informacje o cenie modelu w interfejsie API Comet można znaleźć tutaj https://api.cometapi.com/pricing

Zacznij budować na CometAPI już dziś – zarejestruj się tutaj, aby uzyskać bezpłatny dostęp lub skalować bez ograniczeń stawek, uaktualniając do Płatny plan CometAPI.

Jakie są implikacje wydania Llama 4?

Integracja pomiędzy platformami Meta

Llama 4 jest zintegrowana z asystentem AI firmy Meta na platformach takich jak WhatsApp, Messenger, Instagram i w sieci, co pozwala ulepszyć doświadczenia użytkowników dzięki zaawansowanym możliwościom AI.

Wpływ na branżę AI

Wydanie Llama 4 podkreśla agresywne działania Meta w kierunku AI, z planami zainwestowania do 65 miliardów dolarów w rozbudowę infrastruktury AI. Ten ruch odzwierciedla rosnącą konkurencję między gigantami technologicznymi o pozycję lidera w dziedzinie innowacji AI.

Rozważania na temat zużycia energii

Znaczne zasoby obliczeniowe wymagane dla Llama 4 budzą obawy dotyczące zużycia energii i zrównoważonego rozwoju. Obsługa klastra ponad 100,000 XNUMX GPU wymaga znacznej ilości energii, co wywołuje dyskusje na temat wpływu na środowisko modeli AI na dużą skalę.

Jaka przyszłość czeka Llamę 4?

Meta planuje omówić dalsze prace rozwojowe i zastosowania Llama 4 na nadchodzącej konferencji LlamaCon, która odbędzie się 29 kwietnia 2025 r. Społeczność zajmująca się sztuczną inteligencją oczekuje spostrzeżeń na temat strategii Meta w zakresie rozwiązywania bieżących wyzwań i wykorzystywania możliwości Llama 4 w różnych sektorach.

Podsumowując, Llama 4 stanowi znaczący postęp w modelach języka AI, oferując ulepszone możliwości multimodalne i wyspecjalizowane architektury. Pomimo wyzwań rozwojowych, znaczne inwestycje i inicjatywy strategiczne Meta pozycjonują Llama 4 jako groźnego konkurenta w ewoluującym krajobrazie AI.