Sztuczna inteligencja do edycji obrazów przeszła drogę od zabawy do praktycznego narzędzia do zarządzania przepływem pracy w ciągu miesięcy, a nie lat. Jeśli chcesz usunąć tła, zamienić twarze, zachować postać na różnych ujęciach lub wykonać wieloetapową kompozycję z wykorzystaniem podpowiedzi w języku naturalnym, kilka nowych modeli obiecuje zrobić to szybciej i z mniejszą liczbą ręcznych poprawek. W tym poście porównuję trzy narzędzia, o których obecnie się mówi: Obraz GPT-1 OpenAI, Qwen-Image Edit, wirusowy Nano Banan modele (Gemini-2.5-Flash-Image) i Flux KontextOmówię, w czym każdy z nich jest dobry, w czym zawodzi, i podam praktyczne zalecenia w zależności od tego, co chcesz osiągnąć.

Jakie są główne możliwości definiujące doskonałość sztucznej inteligencji w obrazie?

„Najlepszy” zależy od Twoich potrzeb. Moja ocena opiera się na siedmiu praktycznych kryteriach. Zanim przeanalizujemy poszczególne modele, kluczowe jest zrozumienie fundamentalnych możliwości, które definiują doskonałość w generowaniu i edycji obrazu za pomocą sztucznej inteligencji. Można je ogólnie podzielić na:

- Jakość i wierność generacji: Odnosi się to do zdolności sztucznej inteligencji do tworzenia wysoce realistycznych, estetycznych i spójnych obrazów na podstawie komunikatów tekstowych. Czynniki te obejmują szczegółowość, oświetlenie, kompozycję oraz brak artefaktów i zniekształceń.

- Wszechstronność i precyzja edycji: Poza początkowym generowaniem, zaawansowana sztuczna inteligencja powinna oferować rozbudowane funkcje edycyjne. Obejmują one zamalowywanie (uzupełnianie brakujących fragmentów), zamalowywanie (rozszerzanie obrazów), usuwanie/dodawanie obiektów, transfer stylu oraz precyzyjną kontrolę nad konkretnymi elementami.

- Szybkość i wydajność: W profesjonalnych procesach pracy czas potrzebny na generowanie lub edycję obrazów ma kluczowe znaczenie. Szybsze przetwarzanie bez utraty jakości to znacząca zaleta.

- Doświadczenie użytkownika i dostępność: Intuicyjny interfejs, przejrzyste sterowanie i łatwość integracji z istniejącymi procesami pracy są kluczowe dla powszechnego przyjęcia i zadowolenia użytkowników.

- Rozważania etyczne i zabezpieczenia: Wraz ze wzrostem możliwości sztucznej inteligencji, kluczowe znaczenie ma odpowiedzialny rozwój i wdrażanie. Obejmuje to również zabezpieczenia przed generowaniem szkodliwych lub stronniczych treści.

- Modele efektywności kosztowej i cenowe: Chociaż niektóre narzędzia oferują bezpłatne wersje próbne, zrozumienie struktury cenowej zaawansowanych funkcji i zastosowań komercyjnych jest kluczowe dla użytkowników dbających o budżet.

- Spójne, wieloetapowe edycje — zachowanie tożsamości/obiektów podczas wielu edycji lub obrazów.

Jestem zwolennikiem podejścia praktycznego: model, który generuje nieco mniej „efektownych” zdjęć, ale pozwala na uzyskanie powtarzalnych, szybkich i niezawodnych edycji, przebije efektowny model, który wymaga wielu poprawek.

Jakie modele są brane pod uwagę i co je wyróżnia?

Szybki podgląd modelu

- gpt-image-1 (OpenAI) — natywnie multimodalny model udostępniony w API w kwietniu 2025 r., który bezpośrednio obsługuje iteracyjne generowanie i edycję obrazów w ramach tego samego multimodalnego API odpowiedzi/obrazów.

- Obraz Flash Gemini 2.5 (Google) — ogłoszono 26 sierpnia 2025 r. („nano-banana”); zaprojektowane do szybkiego generowania z niskim opóźnieniem i bogatej edycji (łączenie wielu obrazów, spójność znaków); zawiera znak wodny SynthID wskazujący pochodzenie.

- Qwen-Image-Edit (QwenLM / grupa Alibaba) — wersja Qwen-Image (podstawa 20B) przeznaczona do edycji obrazów, kładąca nacisk na dwujęzyczną, precyzyjną edycję tekstu oraz łączoną edycję semantyczną i wyglądu.

- FLUX.1 Kontext (warianty platformy Flux / Black Forest Labs / Flux) — rodzina modeli (Dev / Pro / Max) nastawiona na szybką, lokalną, kontekstową edycję ze spójnością postaci i iteracyjnymi przepływami pracy.

Dlaczego akurat te cztery?

Obejmują one najważniejsze kwestie projektowe, o które pytają praktycy w 2025 roku: integrację multimodalną (OpenAI), skalę + produkcję plus wiedzę o świecie (Google), precyzyjną edycję i otwarte badania (Qwen) oraz iteracyjną edycję zorientowaną na UX (Flux). Każda z tych metod wiąże się z innymi kompromisami w zakresie kosztów, opóźnień i możliwości (renderowanie tekstu, łączenie wielu obrazów, iteracyjna edycja, zachowanie niezmienionych obszarów).

GPT-Image-1 (OpenAI) — ciężkie narzędzie dla programistów

Co to jest: GPT-Image-1 firmy OpenAI to natywnie multimodalny model, który akceptuje zarówno dane tekstowe, jak i graficzne oraz obsługuje generowanie i edycję obrazów (inpainting, image-to-image) za pośrednictwem API Images. Jest pozycjonowany jako model produkcyjny do integracji między aplikacjami i usługami. Został zaprojektowany jako natywny model tekstowo-obrazowy, który akceptuje dane wejściowe w postaci obrazów i podpowiedzi tekstowych oraz umożliwia edycję z precyzyjną kontrolą.

Jakie są mocne strony GPT-image-1?

- Wyjątkowe zrozumienie semantyczne: Jedną z głównych zalet GPT-image-1 jest jego zdolność do interpretowania niuansów i rozbudowanych podpowiedzi tekstowych. Użytkownicy mogą opisywać skomplikowane sceny, konkretne nastroje i abstrakcyjne koncepcje z niezwykłą dokładnością, a sztuczna inteligencja często generuje obrazy, które wiernie odzwierciedlają te opisy.

- Wysokiej jakości fotorealizm: W odpowiedzi na prośbę o realistyczne obrazy, GPT-image-1 często generuje obrazy o uderzająco realistycznym wyglądzie, z imponującą dbałością o tekstury, oświetlenie i naturalne kompozycje. To czyni go doskonałym narzędziem do fotorealistycznego renderowania i grafiki koncepcyjnej.

- Interpretacja kreatywna: Poza dosłownym tłumaczeniem, GPT-image-1 charakteryzuje się pewnym stopniem kreatywnej interpretacji, często dodając subtelne detale lub stylistyczne ozdobniki, które wzmacniają ogólną atrakcyjność artystyczną generowanego obrazu. Może to być szczególnie korzystne dla tworzenia pomysłów i eksplorowania różnorodnych koncepcji wizualnych.

- Solidne podstawy dla iteracji: Jego zdolność do generowania wysokiej jakości początkowych koncepcji stanowi doskonały punkt wyjścia do dalszego udoskonalania, zarówno w ramach możliwości edycyjnych sztucznej inteligencji (jeśli są dostępne), jak i za pomocą tradycyjnego oprogramowania do projektowania graficznego.

Jakie są ograniczenia GPT-image-1?

- Kontrola nad szczegółami: Choć doskonale radzi sobie z szerokimi koncepcjami, osiągnięcie absolutnej kontroli na poziomie pikseli lub precyzyjnej manipulacji bardzo małymi elementami może być czasem trudne. Jest to częsta przeszkoda dla wielu generatywnych SI, w których wynik jest w pewnym stopniu deterministyczny i zależny od komunikatu.

- Dostępność i integracja: W zależności od konkretnej implementacji, funkcje bezpośredniej edycji GPT-image-1 mogą być mniej rozbudowane lub mniej zintegrowane w porównaniu ze specjalistycznymi platformami do edycji obrazów. Użytkownicy mogą potrzebować eksportować i korzystać z innych narzędzi do intensywnej edycji po generowaniu.

- Wymagania obliczeniowe: Generowanie bardzo szczegółowych obrazów ze złożonymi monitami może być bardzo wymagające pod względem obliczeniowym, co może potencjalnie prowadzić do dłuższego czasu przetwarzania w porównaniu z bardziej wyspecjalizowanymi, lżejszymi modelami przeznaczonymi do szybkich edycji.

Nano Banana (obraz Flash Google/Gemini 2.5)

Co to jest: „Nano Banana” to żartobliwa nazwa najnowszej aktualizacji Google Gemini (Gemini 2.5 Flash Image). Została ona pozycjonowana jako generator/edytor obrazów nowej generacji w ekosystemie Google Gemini, reklamowany jako narzędzie do skuteczniejszej, bardziej zniuansowanej, wieloetapowej edycji i zapewniającej większą spójność edycji zdjęć.

Jakie miejsce zajmuje Gemini-2.5-Flash-Image na rynku wizualnej sztucznej inteligencji?

Gemini-2.5-Flash-Image, nowsza wersja zaprojektowana z myślą o szybkości i wydajności, to propozycja Google'a, która dąży do równowagi między wysoką jakością danych wyjściowych a szybkim przetwarzaniem. Oznaczenie „Flash” wskazuje na zoptymalizowaną architekturę, która zapewnia szybsze reakcje, dzięki czemu doskonale nadaje się do aplikacji, w których kluczowe znaczenie ma generowanie i edycja danych w czasie rzeczywistym lub zbliżonym do rzeczywistego.

Co sprawia, że Gemini-2.5-Flash-Image jest silnym konkurentem?

- Błyskawicznie szybka generacja: Jak sama nazwa wskazuje, szybkość jest kluczową zaletą. Gemini-2.5-Flash-Image doskonale radzi sobie z szybkim generowaniem obrazów, co jest nieocenione dla kreatywnych profesjonalistów, którym zależy na krótkim terminie lub w przypadku aplikacji interaktywnych.

- Solidna jakość obrazu: Pomimo swojej szybkości, model ten nie powoduje znaczącego pogorszenia jakości obrazu. Generuje spójne, atrakcyjne wizualnie obrazy, zazwyczaj pozbawione istotnych artefaktów, co czyni go konkurencyjnym w stosunku do wolniejszych i bardziej zasobochłonnych modeli w wielu zastosowaniach.

- Rozumienie multimodalne: Wykorzystując szersze ramy Gemini, narzędzie to często korzysta z zaawansowanego rozumienia multimodalnego, co oznacza, że potencjalnie może interpretować nie tylko tekst, ale także inne formy wprowadzania danych, aby kierować generowaniem i edycją obrazów, choć różni się to w zależności od konkretnego interfejsu API.

- Zintegrowane możliwości edycji: Gemini-2.5-Flash-Image jest zazwyczaj wyposażony w zintegrowane funkcje edycji, takie jak uzupełnianie brakujących fragmentów obrazu, uzupełnianie obrazu poza jego oryginalne granice i manipulowanie obiektami, co czyni go kompleksowym rozwiązaniem do kompleksowych procesów obróbki obrazów.

Jakie obszary wymagają udoskonalenia w Gemini-2.5-Flash-Image?

- Szczyt fotorealizmu: Choć jest dobry, nie zawsze osiąga absolutny szczyt fotorealizmu, obserwowany w niektórych wolniejszych, większych modelach w przypadku bardzo złożonych i pełnych niuansów scen. Może występować niewielki kompromis między szybkością a najwyższą wiernością.

- Niuanse artystyczne dla stylów złożonych: W przypadku bardzo specyficznych stylów artystycznych lub ekstremalnie abstrakcyjnych wymagań niektórzy użytkownicy mogą mieć wrażenie, że model ten ma mniejsze możliwości uchwycenia najsubtelniejszych niuansów artystycznych w porównaniu z modelami trenowanymi na dużych zbiorach danych dotyczących historii sztuki.

- Kontrola nad generowanym tekstem (w obrazach): Podobnie jak w przypadku wielu modeli generatywnych, generowanie idealnie spójnego i poprawnie napisanego tekstu na obrazie może nadal stanowić wyzwanie.

Czym jest Qwen-Image-Edit?

Co to jest: Qwen-Image-Edit (zespół Alibaba / Qwen) — model edycji obrazu oparty na rodzinie Qwen-Image; charakteryzuje się mocną dwujęzyczną edycją tekstu (chińską i angielską), kontrolą semantyki i wyglądu oraz bezpośrednią wiernością edycji obrazu.

Jakie są mocne strony programu Qwen-Image Edit?

- Wyższa precyzja edycji: Qwen-Image Edit często oferuje zaawansowane algorytmy do zamalowywania, zamalowywania i manipulacji obiektami, które umożliwiają niezwykle precyzyjną i płynną edycję. Program doskonale zachowuje spójność wizualną nawet przy wprowadzaniu znaczących zmian.

- Edycja uwzględniająca kontekst: Kluczową zaletą jest rozpoznawanie kontekstu. Na przykład podczas usuwania obiektu inteligentnie wypełnia pustkę treścią, która logicznie wtapia się w otoczenie, sprawiając, że edycja jest praktycznie niewykrywalna.

- Przenoszenie i harmonizacja stylu: Qwen-Image Edit może być niezwykle skuteczny w przenoszeniu stylów z jednego obrazu na drugi lub harmonizowaniu różnych elementów obrazu w celu uzyskania spójnego wyglądu. Jest to nieocenione narzędzie dla projektantów pracujących z różnorodnymi zasobami wizualnymi.

- Solidne usuwanie/dodawanie obiektów: Możliwość dodawania lub usuwania obiektów przy jednoczesnym zachowaniu oświetlenia, cieni i perspektywy jest imponująca, co umożliwia tworzenie złożonych rekonstrukcji scen lub usuwanie zbędnych elementów.

- Skalowanie i ulepszanie obrazu: Często zawiera zaawansowane funkcje umożliwiające zwiększanie skali obrazu bez utraty jakości oraz podnoszenie poziomu szczegółów, kolorów i ogólnej atrakcyjności wizualnej.

Jakie są potencjalne słabości programu Qwen-Image Edit?

- Początkowy nacisk na pokolenie: Choć potrafi generować obrazy, jego główną siłą i optymalizacją jest często edycja. Początkowe generowanie tekstu na obraz może być dobre, ale potencjalnie nie tak kreatywne i fotorealistyczne, jak modele skupione wyłącznie na generowaniu, w zależności od konkretnej wersji.

- Krzywa uczenia się dla zaawansowanych funkcji: Precyzja i zakres dostępnych narzędzi edycyjnych mogą wymagać nieco większej nauki dla użytkowników niezaznajomionych z zaawansowanymi koncepcjami manipulacji obrazem.

- Intensywność zasobów w przypadku złożonych edycji: Wysoce złożone, wielowarstwowe edycje mogą mimo wszystko wymagać dużych mocy obliczeniowych, co może prowadzić do dłuższego czasu przetwarzania bardzo dużych lub skomplikowanych zadań.

Jakie innowacje Flux Kontext wprowadza do Image AI?

Co to jest: Kontext firmy Flux (czasami sprzedawany jako FLUX.1 Kontext) to narzędzie do edycji i generowania obrazów przeznaczone dla projektantów i zespołów brandingowych. Podkreśla edycja uwzględniająca kontekst, precyzyjna typografia, transfer stylów i dopracowany interfejs użytkownika/doświadczenie użytkownika na potrzeby iteracyjnej pracy projektowej.

Jakie są mocne strony Flux Kontext?

- Spójność kontekstowa: Główną zaletą Flux Kontext jest zdolność do rozumienia i utrzymywania kontekstu w wielu generacjach lub edycjach obrazu. Jest to nieocenione przy tworzeniu spójnych narracji wizualnych, projektów postaci lub linii produktów, gdzie harmonia wizualna jest kluczowa.

- Poprawiona spójność serii: Jeśli chcesz wygenerować serię obrazów o wspólnym stylu, charakterze lub otoczeniu, Flux Kontext pozwala na redukcję niespójności, które mogą być zmorą innych modeli.

- Styl adaptacyjny: Może dostosować swoje wyniki na podstawie wcześniej wygenerowanych obrazów lub określonego przewodnika po stylach, co przekłada się na bardziej usprawniony i mniej iteracyjny proces twórczy.

- Specjalizacja w zakresie marki i narracji: Szczególnie przydatne w marketingu, budowaniu marki i opowiadaniu historii, gdzie spójna identyfikacja wizualna ma kluczowe znaczenie.

- Szybkie zrozumienie w kontekście: Szybkie zrozumienie nie dotyczy tylko bieżącego obrazu, ale także tego, jak wpisuje się on w szerszy kontekst lub zestaw instrukcji.

Jakie są ograniczenia Flux Kontext?

- Potencjał skupienia się na niszy: Nacisk na kontekst i spójność może oznaczać, że nie zawsze jest to absolutny lider w dziedzinie surowego, samodzielnego fotorealizmu lub skrajnej różnorodności artystycznej, jeśli jest to jedyne wymaganie.

- Mniej publicznie udokumentowane testy porównawcze: Dla nowszych i bardziej wyspecjalizowanych graczy, obszerne publiczne dane porównawcze mogą być mniej dostępne w porównaniu do bardziej ugruntowanych modeli.

- Zależne od jasnego kontekstowego wprowadzania danych: Aby w pełni wykorzystać zalety tego narzędzia, użytkownicy muszą przekazać jasne informacje kontekstowe lub skutecznie zdefiniować ramy narracji, co może wymagać innego podejścia do podpowiadania treści.

Który model jest najlepszy do edycji obrazu?

Dla singli, precyzyjne edycje bez maski oraz edycja tekstu wewnątrz obrazów, Qwen-Image-Edit oraz Obraz Flash Gemini 2.5 (i specjalistyczne modele, takie jak FLUX.1 Kontext) należą do najmocniejszych. złożone, wieloetapowe edycje łańcuchowepołączenie opartego na instrukcjach front-endu LLM (warianty Gemini lub GPT) z modelem obrazu często daje najlepsze rezultaty — niektóre testy porównawcze wykazały, że podpowiedzi w stylu Chain-of-Thought (Gemini-CoT) poprawiają skuteczność edycji wieloetapowej.

lokalne edycje, spójność znaków, obsługa tekstu

- Qwen-Image-Edit wyraźnie celuje w oba semantyczny oraz wygląd edycje — np. zastąpienie obiektu, obrót, dokładna zamiana tekstu — wyraźnie zbudowane jako Edytowanie obrazu Model z podwójnymi ścieżkami (kontrola semantyczna poprzez Qwen2.5-VL + kontrola wyglądu poprzez enkoder VAE). Reklamuje solidną dwujęzyczność (chiński/angielski). edycja tekstu na obrazach (np. zmiana tekstu znaku, etykiety produktu) przy jednoczesnym zachowaniu stylu, co jest rzadkością i wartością w przypadku prac związanych z lokalizacją i pakowaniem.

- Obraz Flash Gemini 2.5 Obsługuje edycję maskowaną, lokalne modyfikacje sterowane poleceniami (rozmycie tła, usunięcie osoby, zmiana pozy) oraz łączenie wielu obrazów. Google reklamuje edycję opartą na poleceniach, uwzględniającą regiony, a także zalety wynikające z wiedzy o świecie (np. lepszą semantykę obiektów w świecie rzeczywistym). Model ten dodaje również niewidoczny znak wodny SynthID do wygenerowanych/edytowanych obrazów, co ułatwia ustalenie pochodzenia i wykrycie.

- Kontekst FLUX.1: pozycjonuje się jako narzędzie do rozwiązywania kontekstu „obraz-obraz” — jest zoptymalizowane pod kątem precyzyjnych, kontekstowych edycji lokalnych i iteracyjnego eksperymentowania. Recenzenci chwalą jego zdolność do zachowania kontekstu i semantyki scen podczas wprowadzania lokalnych zmian. FLUX.1 Kontext i Flux Kontext UI są chwalone w testach praktycznych za iteracyjne procesy edycji i czytelność tekstu, co czyni je praktycznym wyborem w przypadku procesów wymagających wielu szybkich iteracji (materiały marketingowe, miniatury).

- Obraz GPT-1: obsługuje operacje edycyjne (monity tekstowe i graficzne do edycji), a narzędzia OpenAI integrują wzorce łączenia łańcuchowego i inżynierii błyskawicznej; wydajność jest wysoka, ale zależy od inżynierii błyskawicznej i może pozostawać w tyle za specjalistycznymi modelami „najpierw edycja” w przypadku edycji szczegółowej (np. dokładna zamiana tekstu dwujęzycznego) w niektórych testach.

Punkty odniesienia, takie jak ComplexBench-Edit oraz CompBench pokazują, że wiele modeli nadal zawodzi, gdy edycje są powiązane lub współzależne, ale połączenie modelu LLM do analizy instrukcji z solidnym modelem obrazu (orkiestracja modelu LLM→obraz) lub użycie komunikatów CoT może zmniejszyć liczbę błędów. Dlatego niektóre procesy produkcyjne łączą modele (np. model LLM z wnioskowaniem i generatorem obrazu) w celu przeprowadzenia trudnych edycji.

Kto najlepiej edytuje tekst na obrazach?

- Qwen-Image-Edit Został zaprojektowany specjalnie do precyzyjnej edycji tekstu w dwóch językach (chińskim i angielskim) i zapewnia doskonałe wyniki w testach porównawczych edycji tekstu (publiczne notatki techniczne i raportowane wyniki Qwen). Artefakty i wersje demonstracyjne Qwen (dostępne w otwartym kodzie źródłowym) zapewniają dokładne zachowanie czcionek, rozmiarów i stylów podczas edycji.

- obraz-gpt-1 oraz Obraz Flash Gemini 2.5 oba programy czynią postępy w renderowaniu tekstu, ale testy akademickie i notatki dostawców wskazują na wciąż istniejące wyzwania w przypadku tekstów krótkich/szczegółowych oraz długich fragmentów tekstu — ulepszenia następują stopniowo i różnią się w zależności od polecenia i rozwiązania.

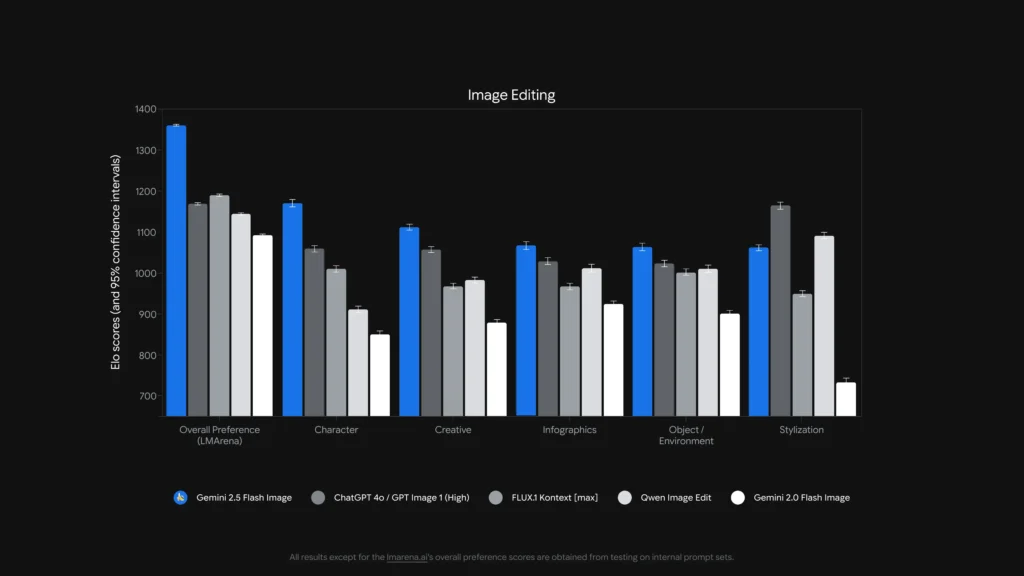

Analiza porównawcza: cecha, edycja

Aby uzyskać jaśniejszy obraz, zestawiamy najważniejsze aspekty tych wiodących modeli sztucznej inteligencji w tabeli porównawczej.

| Funkcja / Możliwość | GPT-obraz-1 (OpenAI) | Gemini-2.5-Flash-Image (Google) | Qwen-Image-Edit (Alibaba) | Kontekst FLUX.1 |

|---|---|---|---|---|

| Generowanie natywne + edycja | Tak. Tekst multimodalny i obraz w jednym API. | Tak — natywne generowanie i docelowa edycja; kładziony nacisk na łączenie wielu obrazów i spójność postaci. | Skupiony na redagowanie (Qwen-Image-Edit) z kontrolą semantyczną i wyglądem. | Skupiamy się na edycji obrazu po obrazie, z zachowaniem wysokiej jakości. |

| Głębokość edycji (korekty lokalne) | Wysoki (ale ogólny) | Bardzo wysoki (skierowane monity + edycje bez maski) | Bardzo wysoki poziom w przypadku edycji semantycznych/tekstowych (obsługa tekstu dwujęzycznego). | Bardzo wysoki — procesy edycji zależne od kontekstu. |

| Obsługa tekstu w obrazie | Dobrze, zależy od szybkości | Ulepszono (dostawca pokazuje demonstracje edycji szablonów i podpisów) | Bezcenne wśród nich zmiany w dwujęzycznym tekście czytelnym. | Ważne, aby zachować styl, czytelność zależy od szybkości. |

| Spójność postaci/obiektu | Dobrze, jeśli zostanie starannie podpowiedziany | Silny (cecha jawna) | Średni (skupienie na edycji, a nie na tożsamości wieloobrazowej) | Mocne dzięki iteracyjnym przepływom pracy edycyjnym. |

| Opóźnienie / przepustowość | Umiarkowany | Niskie opóźnienie / wysoka przepustowość (Model Flash) | Zależy od hostingu (lokalny/HF czy chmurowy) | Zaprojektowane do szybkich, iteracyjnych edycji w hostowanym oprogramowaniu SaaS. |

| Pochodzenie / znak wodny | Brak obowiązkowego znaku wodnego (mechanizmy polityki) | Niewidoczny znak wodny SynthID dla obrazów. | Zależy od hosta | Zależy od hosta |

Uwagi: „Głębokość edycji” mierzy, jak szczegółowe i niezawodne są w praktyce lokalne edycje; „Obsługa tekstu” ocenia zdolność do umieszczania/zmiany czytelnego tekstu wewnątrz obrazów

A co z opóźnieniami, ergonomią dla programistów i integracją korporacyjną?

Opcje opóźnień i wdrażania

- Obraz Flash Gemini 2.5 podkreśla małe opóźnienie i jest dostępny za pośrednictwem Gemini API, Google AI Studio i Vertex AI — doskonały wybór dla aplikacji korporacyjnych wymagających przewidywalnej przepustowości i integracji z chmurą. Google podaje również przybliżone ceny tokenów za obraz (a blog dewelopera zawiera przykładowe ceny za obraz).

- obraz-gpt-1 jest dostępny za pośrednictwem interfejsu API OpenAI Images i oferuje szeroką integrację z ekosystemem (Playground, partnerzy tacy jak Adobe/Canva). Ceny są tokenizowane i zależą od poziomu jakości obrazu (OpenAI publikuje przeliczenia tokenów na dolary).

- Flux Kontext koncentruje się na szybkim interaktywnym UX i oferuje kredyty + niskie czasy edycji w wersjach demonstracyjnych produktów — co jest przydatne dla projektantów i umożliwia szybką iterację. Qwen zapewnia otwarty dostęp do artefaktów i badań (idealne, jeśli chcesz hostować je samodzielnie lub sprawdzać ich zawartość).

Ile kosztują te usługi i która jest bardziej opłacalna?

Ceny zmieniają się często — poniżej znajdują się liczby podane przez wydawcę (sierpień 2025 r.) i reprezentatywne wyliczenia kosztów za obraz w przypadku, gdy dostawcy je opublikowali.

Opublikowane ceny (oświadczenia dostawców)

| Model/Sprzedawca | Publiczny przegląd cen (opublikowany) | Przybliżona ocena na obraz |

|---|---|---|

| gpt-image-1 (OpenAI) | Ceny tokenizowane (wprowadzanie tekstu 5 USD/1 mln, wprowadzanie obrazu 10 USD/1 mln, wyprowadzanie obrazu 40 USD/1 mln). OpenAI podaje, że to odpowiada mniej więcej $ $ 0.02 0.19- za każdy wygenerowany obraz, w zależności od jakości/rozmiaru. | ~$0.02 (niska jakość/miniaturka) → ~$0.19 (wysoka jakość kwadratu) |

| Obraz Flash Gemini 2.5 (Google) | 30 USD za 1 mln tokenów wyjściowych i przykład: każdy obraz ≈ 1290 tokenów wyjściowych (~$0.039 (za obraz) według bloga dewelopera. Ceny naliczane za pośrednictwem Gemini API/Vertex. | ~$0.039 na obraz (przykład Google) |

| Flux Kontext (Flux) | Bezpłatny poziom z kredytami; strony produktów Flux pokazują Darmowe kredyty 10 i typowe edycje w cenie 5 kredyty; dostępne są poziomy subskrypcji dla użytkowników intensywnie korzystających z Internetu. (Strona produktu sprzedawcy). | Bardzo niski koszt w przypadku okazjonalnych edycji, subskrypcja w przypadku intensywnego użytkowania. |

| Qwen-Image-Edit (QwenLM) | Otwarte wydanie i artefakty GitHub – otwarty dostęp do badań z darmowymi przykładami; wdrożenia komercyjne różnią się w zależności od integratora (hostowanie własne lub w chmurze). Brak jednej kanonicznej ceny za obraz; zazwyczaj jest najniższa w przypadku hostingu własnego. |

Interpretacja wartości: Jeśli potrzebujesz obrazów o dużej objętości generacja Jeśli jesteś w fazie produkcyjnej i chcesz przewidywalnych cen za obraz, przykład Google jest niezwykle konkurencyjny. Jeśli Twoje koszty zależą głównie od edycji z udziałem człowieka lub iteracyjnego czasu projektanta, bardziej ekonomiczne może okazać się Flux lub lokalne uruchomienie Qwen. OpenAI oferuje szeroki ekosystem SDK i wielu partnerów, co sprawia, że warto wybrać wyższy poziom dla wygody integracji.

Cena w CometAPI

| Model | Obraz GPT-1 | Gemini-2.5-Flash-Image | Kontekst FLUX.1 |

| Cena | Żetony wejściowe 8.00 USD; żetony wyjściowe 32.00 USD | $0.03120 | flux kontext pro: 0.09600 USD flux-kontext-max: $0.19200 |

Praktyczne, szybkie wskazówki, jak uzyskać najlepsze rezultaty

Wskazówki dotyczące podpowiedzi i przepływu pracy (dotyczy wszystkich modeli)

- Bądź precyzyjny w kwestii kompozycji: kąt kamery, oświetlenie, nastrój, ogniskowa, obiektyw i relacje przestrzenne między obiektami. Przykład: „Zbliżenie 35 mm, mała głębia ostrości, obiekt w centrum, miękkie światło krawędziowe w lewym górnym rogu”.

- Użyj iteracyjnego udoskonalania edycji: Najpierw wykonaj zgrubne edycje strukturalne, a następnie dopracuj tekstury/oświetlenie. Modele takie jak FLUX i Gemini są zaprojektowane tak, aby obsługiwać wieloetapowe dopracowywanie.

- Do tekstu na obrazach: podaj dokładny tekst, jaki chcesz i dodaj opcję „renderuj jako czytelny znak o wysokim kontraście z realistycznym wytłoczeniem” — w przypadku edycji dwujęzycznych użyj Qwen-Image-Edit, gdy wymagana jest wierność językowi chińskiemu i angielskiemu.

- Użyj obrazów referencyjnych:aby zapewnić spójność postaci lub wariantów produktu, dostarcz wysokiej jakości obrazy referencyjne i podpowiedzi, takie jak „dopasuj postać w referencji_01: rysy twarzy, kolor kostiumu i oświetlenie”. Gemini i Flux kładą nacisk na spójność i fuzję wielu obrazów.

- Edycje maskujące i bezmaskowe: jeśli to możliwe, zapewnij maskę, aby ściśle ograniczyć edycję. W przypadku korzystania z trybu bez maski należy spodziewać się sporadycznego rozlewania. Modele różnią się: Flux/Gemini dobrze radzą sobie z edycją bez maski, ale maska nadal jest pomocna.

- Zastosowanie Obraz GPT / GPT-4o W przypadku złożonych poleceń kompozycyjnych z wieloma obiektami, liczbami i ograniczeniami przestrzennymi. W miarę możliwości należy używać jednej, dokładnej instrukcji na pokolenie.

Wskazówki dotyczące kosztów i opóźnień

Partie: korzystaj z interfejsów API wsadowych lub funkcji w chmurze, aby efektywnie generować wiele wariantów. Gemini-2.5-Flash jest zoptymalizowany pod kątem przepustowości, jeśli potrzebujesz dużej ilości danych.

Jakość dostrojenia kontra cena:OpenAI udostępnia niskie/średnie/wysokie poziomy obrazów; generuje wersje robocze w niskiej jakości, finalizuje w wysokiej.

ostateczny werdykt

- Najlepsze do produkcji i integracji: GPT-Obraz-1 — najbardziej odpowiedni do potrzeb API, kompozycji i integracji z narzędziami profesjonalnymi.

- Najlepsza dla uzyskania fotorealistycznej spójności konsumenckiej: Nano Banan — Ulepszona wersja obrazu Gemini od Google wyróżnia się naturalnymi, sekwencyjnymi edycjami portretów i przystępnym UX.

- Najlepsze wrażenia na urządzeniach mobilnych/edytorach: Flux Kontext — świetne konwersacje na telefonie, bez zbędnych komplikacji.

- Jeśli oceniasz jakość tekstu pod kątem chirurgicznych edycji oraz edycji dwujęzycznej/wielojęzycznej → Qwen-Image-Edit** to najlepszy specjalista i doskonały wybór, gdy liczy się dokładność tekstu wewnątrz obrazów.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Deweloperzy mogą uzyskać dostęp Obraz GPT-1, Kontekst FLUX.1 oraz Obraz Flash Gemini 2.5 Za pośrednictwem CometAPI najnowsze wersje modeli są aktualne na dzień publikacji artykułu. Na początek zapoznaj się z możliwościami modelu w Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.

Najnowsza integracja Qwen-Image-Edit wkrótce pojawi się w CometAPI, więc bądźcie czujni! Gotowy, aby zacząć edytować zdjęcia? → Zarejestruj się w CometAPI już dziś !

Cena w CometAPI

| Model | Obraz GPT-1 | Gemini-2.5-Flash-Image | Kontekst FLUX.1 |

| Cena | Żetony wejściowe 8.00 USD; żetony wyjściowe 32.00 USD | $0.03120 | flux kontext pro: 0.09600 USD flux-kontext-max: $0.19200 |