28 lipca 2025 roku pekiński startup Zhipu AI oficjalnie zaprezentował serię GLM-4.5 otwartych modeli językowych, co stanowi jego najpotężniejszą jak dotąd premierę i jest ukierunkowane na zaawansowane aplikacje inteligentnych agentów. Ogłoszenie – ogłoszone podczas wydarzenia online na żywo po Światowej Konferencji Sztucznej Inteligencji (WAIC) – przedstawiło dwa warianty: pełnowymiarowy GLM-4.5 z 355 miliardami parametrów (32 miliardy aktywnych) oraz bardziej kompaktowy GLM-4.5-Air ze 106 miliardami parametrów (12 miliardów aktywnych). Oba modele wykorzystują hybrydową architekturę wnioskowania „myślącego” i „niemyślącego”, zaprojektowaną w celu zrównoważenia głębokiego wnioskowania z szybką reakcją, i oferują okno kontekstowe o pojemności 128,000 XNUMX tokenów dla rozbudowanych przypadków użycia zorientowanych na konwersację i zadania.

Premiera GLM-4.5 zbiega się z narastającym krajowym wyścigiem na rzecz sztucznej inteligencji. Według chińskiej państwowej agencji informacyjnej Xinhua, do lipca 1,509 roku chińscy programiści wydali 2025 modeli w dużych językach, co daje im pierwsze miejsce wśród 3,755 modeli na świecie – co wyraźnie świadczy o skali i tempie ekspansji chińskiego ekosystemu sztucznej inteligencji.

Licencjonowanie Open Source GLM-4.5

W wyraźnym odejściu od zamkniętych, zastrzeżonych paradygmatów, Z.ai udostępnia GLM-4.5 w ramach Licencja open-source w stylu MIT, w pełni audytowalna, zapewniając przedsiębiorstwom pełną transparentność w zakresie wag modeli i kodu treningowego. Organizacje mogą wdrażać GLM-4.5 na miejscu, dostosuj go do zastrzeżonych zestawów danych lub zintegruj za pośrednictwem samodzielnie hostowanych usług wnioskowania, unikając w ten sposób uzależnienia od dostawcy i nieprzejrzystych struktur cenowych API.

Dostępność obu GLM-4.5 do ogólnych zadań agenturalnych i GLM‑4.5‑Air, lekka wersja zoptymalizowana pod kątem środowisk o niższych zasobach, zapewnia szerokie spektrum przypadków użycia — od wdrożeń w centrach danych na dużą skalę po scenariusze wnioskowania na urządzeniach brzegowych.

Strategicznie, podejście Zhipu oparte na oprogramowaniu typu open source pozycjonuje firmę na tle zachodnich firm z zamkniętym kodem źródłowym, takich jak OpenAI. Poprzez demokratyzację dostępu do modelu porównywalnego z GPT‑4 na licencji MIT, Zhipu dąży do zbudowania silnej społeczności programistów niższego szczebla i ustanowienia technicznych wzorców dla możliwości agentowej sztucznej inteligencji. Obserwatorzy branży zauważają, że ten krok wpisuje się w szerszy trend wśród chińskich „Tygrysów AI”, takich jak Moonshot AI i Step AI, które również udostępniły duże modele w modelu open source, aby przyspieszyć cykle innowacji.

Testy wydajności i analiza porównawcza

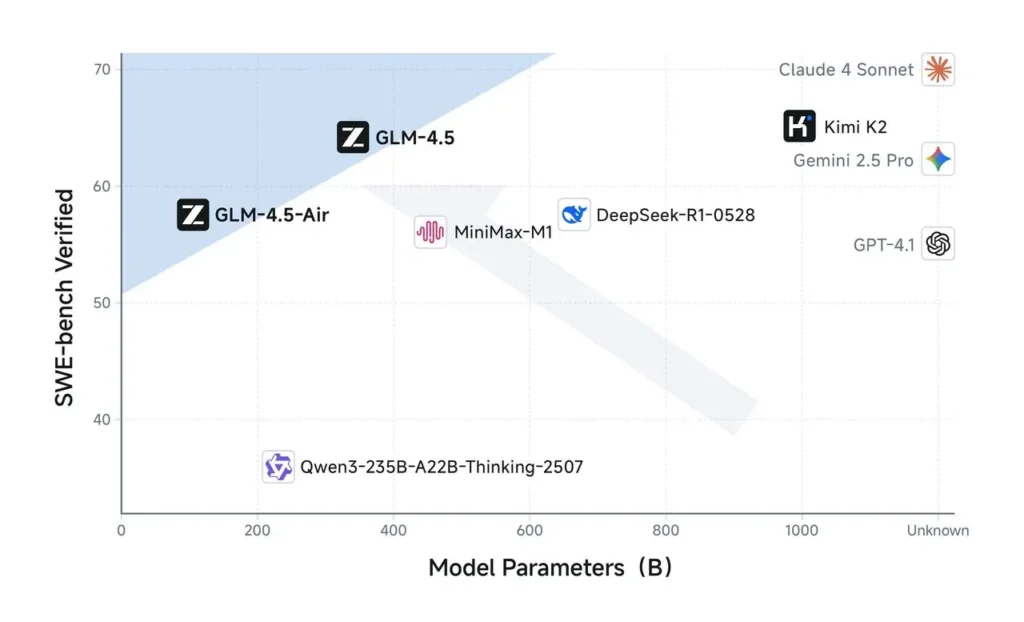

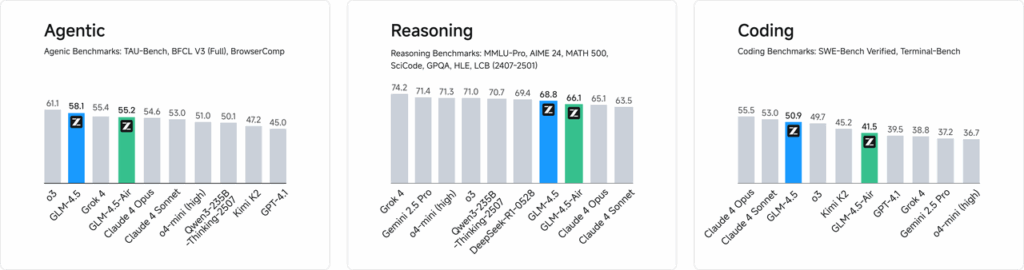

Wstępne testy porównawcze dostarczone przez Zhipu AI wskazują, że GLM‑4.5 osiąga łączny wynik 63.2 w 12 standardowych pakietach ewaluacyjnych – co plasuje go na trzecim miejscu wśród modeli open-source i zastrzeżonych – podczas gdy uproszczony GLM‑4.5‑Air osiąga wynik 59.8, łącząc wydajność z wysoką dokładnością. Wewnętrzne oceny kodowania dodatkowo dowodzą, że GLM‑4.5 przewyższa głównych konkurentów, zapewniając 53.9% wskaźnik wygranych w porównaniu z Kimi K2 i 80.8% wskaźnik sukcesu w porównaniu z Qwen3‑Coder w 52 zróżnicowanych zadaniach programistycznych.

Demonstracje podczas wydarzenia na żywo podkreśliły możliwości agentowe GLM‑4.5: model autonomicznie przeprowadzał badania internetowe – pobierając i syntetyzując informacje z wielu źródeł – oraz łączył się z symulowanymi mediami społecznościowymi i środowiskami programistycznymi, aby generować posty, wykonywać fragmenty kodu i manipulować elementami interfejsu użytkownika w czasie rzeczywistym. Zainteresowani użytkownicy mogą natychmiast wypróbować model w pełnej skali bezpłatnie za pośrednictwem portalu Qingyan firmy Zhipu i platformy CometAPI, a deweloperzy mogą uzyskać dostęp do punktów końcowych API w usłudze BigModel firmy CometAPI lub pobrać pełne wagi modelu z Hugging Face i ModelScope na licencji MIT.

Efektywność kosztowa jest fundamentem strategii Z.ai. Wyszkolony na korpusie 15 bilionów tokenów, GLM‑4.5 wykorzystuje zoptymalizowane ścieżki wnioskowania, aby zapewnić przepustowość na poziomie 100–200 tokenów na sekundę – nawet osiem razy szybciej niż porównywalni konkurenci krajowi – w reklamowanej cenie zaledwie 0.11 USD za milion tokenów, co przebija modele takie jak DeepSeek‑R1 i najnowsze wersje Alibaby. Zgodnie z liberalną licencją MIT, wszystkie wagi modeli, kod i dokumentacja są dostępne bezpłatnie za pośrednictwem Hugging Face, co ma na celu wspieranie dynamicznej społeczności programistów i badaczy na całym świecie.

„GLM‑4.5 ucieleśnia nasze zaangażowanie w demokratyzację dostępu do najnowocześniejszej technologii AI” – powiedział Zhang Peng, dyrektor generalny Z.ai, w wywiadzie dla CNBC. „Udostępniając na zasadzie open source model, który wyróżnia się wnioskowaniem, kodowaniem i funkcjami agentowymi, umożliwiamy organizacjom każdej wielkości wprowadzanie innowacji bez ograniczeń związanych z zastrzeżonymi interfejsami API i wygórowanymi kosztami”.

Jak zacząć

CometAPI to ujednolicona platforma API, która agreguje ponad 500 modeli AI od wiodących dostawców — takich jak seria GPT firmy OpenAI, Gemini firmy Google, Claude firmy Anthropic, Midjourney, Suno i innych — w jednym, przyjaznym dla programistów interfejsie. Oferując spójne uwierzytelnianie, formatowanie żądań i obsługę odpowiedzi, CometAPI radykalnie upraszcza integrację możliwości AI z aplikacjami. Niezależnie od tego, czy tworzysz chatboty, generatory obrazów, kompozytorów muzycznych czy oparte na danych potoki analityczne, CometAPI pozwala Ci szybciej iterować, kontrolować koszty i pozostać niezależnym od dostawcy — wszystko to przy jednoczesnym korzystaniu z najnowszych przełomów w ekosystemie AI.

Deweloperzy mogą uzyskać dostęp GLM-4.5 Air API oraz Interfejs API GLM‑4.5 przez Interfejs API CometNajnowsza wersja Claude Models podana jest na dzień publikacji artykułu. Na początek zapoznaj się z możliwościami modelu w… Plac zabaw i zapoznaj się z Przewodnik po API aby uzyskać szczegółowe instrukcje. Przed uzyskaniem dostępu upewnij się, że zalogowałeś się do CometAPI i uzyskałeś klucz API. Interfejs API Comet zaoferuj cenę znacznie niższą niż oficjalna, aby ułatwić Ci integrację.