A Inteligência Artificial (IA) revolucionou diversos setores, e uma de suas aplicações mais fascinantes é a geração de imagens. Da criação de rostos humanos realistas à produção de obras de arte surreais, a capacidade de geração de imagens por IA abriu novos caminhos na arte, no design e na tecnologia. Este artigo analisa os mecanismos por trás das imagens geradas por IA, os modelos que as impulsionam e as implicações mais amplas dessa tecnologia.

Compreendendo o básico: como funciona a geração de imagens por IA?

O que são modelos generativos?

Modelos generativos são uma classe de algoritmos de IA que podem criar novas instâncias de dados semelhantes aos dados de treinamento. No contexto da geração de imagens, esses modelos aprendem padrões de imagens existentes e usam esse conhecimento para produzir imagens novas e semelhantes.

O papel das redes neurais

No cerne da geração de imagens por IA estão as redes neurais, particularmente modelos de aprendizado profundo como as Redes Neurais Convolucionais (CNNs). As CNNs são projetadas para processar dados com uma topologia semelhante a uma grade, o que as torna ideais para análise e geração de imagens. Elas funcionam detectando padrões como bordas, texturas e formas, essenciais para a compreensão e recriação de imagens.

Principais modelos de IA na geração de imagens de IA

Redes Adversárias Generativas (GANs)

Introduzidas por Ian Goodfellow em 2014, as GANs consistem em duas redes neurais: um gerador e um discriminador. O gerador cria imagens, enquanto o discriminador as avalia em comparação com imagens reais. Por meio desse processo adversarial, o gerador aprimora sua saída para produzir imagens cada vez mais realistas.

Estilo GAN

Desenvolvido pela NVIDIA, o StyleGAN é uma variante do GAN conhecida por gerar rostos humanos de alta qualidade. Ele introduz uma arquitetura de gerador baseada em estilo, permitindo o controle sobre diferentes níveis de detalhe na imagem. O StyleGAN2 e o StyleGAN3 aprimoraram ainda mais a qualidade da imagem e corrigiram problemas como a aderência de texturas.

Modelos de Difusão

Modelos de difusão geram imagens partindo de ruído aleatório e refinando-o gradualmente para corresponder ao resultado desejado. Eles ganharam popularidade devido à sua capacidade de produzir imagens de alta qualidade e à sua flexibilidade em diversas aplicações.

Difusão Estável

Stable Diffusion é um modelo de difusão de código aberto que permite a geração de texto para imagem. Ele também pode realizar pinturas internas e externas, permitindo edição e extensão de imagens. Sua natureza de código aberto o tornou amplamente acessível para desenvolvedores e artistas.

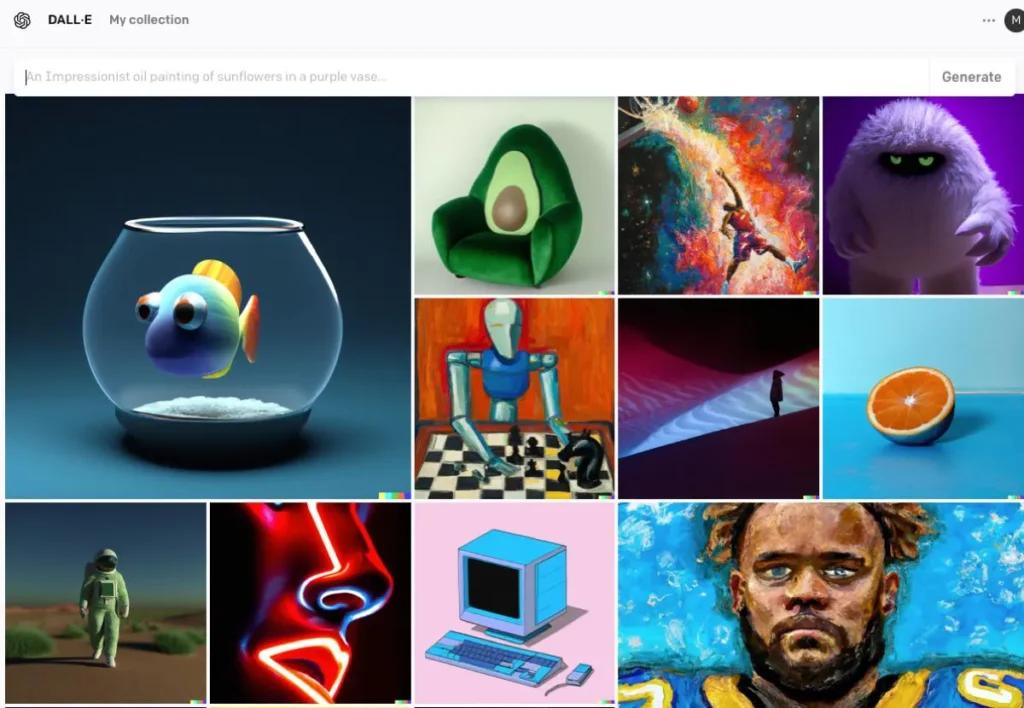

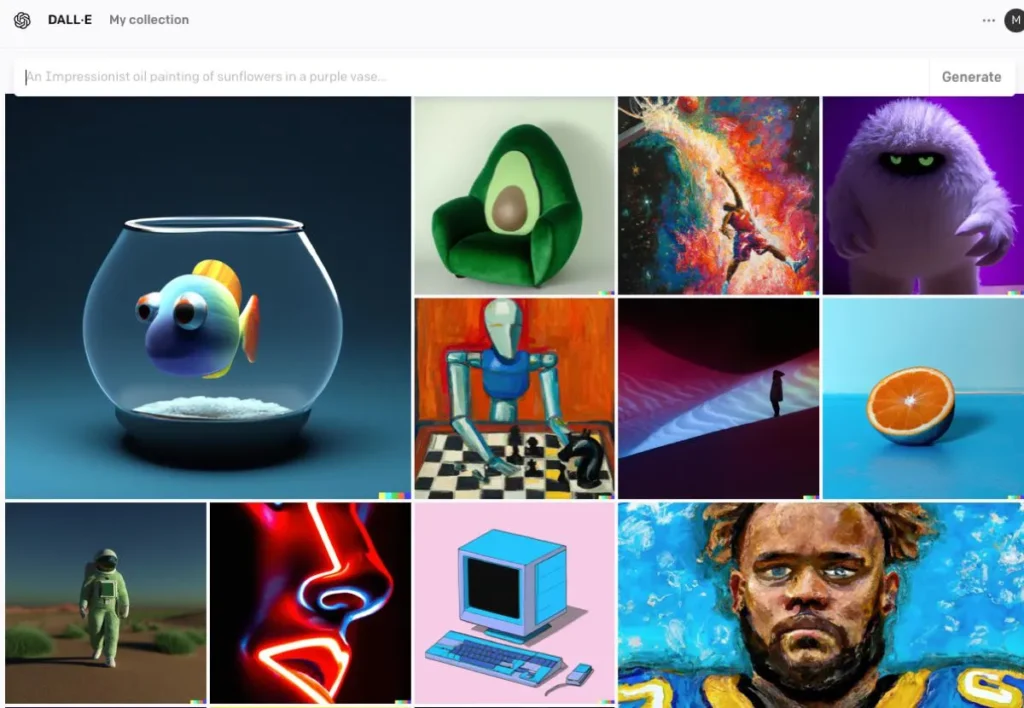

DALL · E

Desenvolvido pela OpenAI, o DALL·E é um modelo baseado em transformador capaz de gerar imagens a partir de descrições textuais. O DALL·E 2 e o DALL·E 3 aprimoraram o original, oferecendo maior resolução e alinhamento imagem-texto mais preciso. O DALL·E 3 é integrado ao ChatGPT para aprimorar a interação do usuário.

O processo de geração de imagens de IA

Treinando o modelo

Os modelos de IA exigem treinamento extensivo em grandes conjuntos de dados de imagens. Durante o treinamento, o modelo aprende a reconhecer padrões e características nas imagens, permitindo gerar novas imagens que imitam os dados de treinamento.

Gerando novas imagens

Uma vez treinado, o modelo pode gerar novas imagens por:

- Recebendo informações: Isso pode ser ruído aleatório (em GANs), um prompt de texto (em DALL·E) ou uma imagem existente (para edição). Essa etapa captura o significado semântico do texto, permitindo que a IA entenda o conteúdo e o contexto.

- Processamento de entrada: O modelo processa a entrada por meio de suas camadas de rede neural, aplicando padrões e recursos aprendidos. Utilizando o texto codificado, a IA emprega modelos como Redes Adversariais Generativas (GANs) ou modelos de difusão para criar imagens. Esses modelos geram imagens começando com ruído aleatório e refinando-o para corresponder à descrição textual.

- Refinamento e Avaliação: A imagem gerada é então refinada usando mecanismos de atenção para garantir a coerência com o texto. Um modelo discriminador avalia o realismo e a consistência da imagem com a entrada, fornecendo feedback para refinamento posterior.

- Saída de imagem:O resultado final é uma nova imagem que reflete as características dos dados de treinamento e a entrada específica fornecida.

Exemplo de código de geração de imagem de IA

aqui estão exemplos práticos de código Python demonstrando como gerar imagens usando três modelos de IA proeminentes: Redes Adversariais Generativas (GANs), Difusão Estável e DALL·E.

Redes Adversariais Generativas (GANs) com PyTorch

Redes Adversariais Generativas (GANs) consistem em duas redes neurais — a Geradora e a Discriminadora — que competem entre si para gerar novas instâncias de dados realistas. Aqui está um exemplo simplificado usando o PyTorch para gerar imagens:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Este código define uma rede geradora simples que recebe um vetor de ruído de 100 dimensões como entrada e produz uma saída de 784 dimensões, que pode ser remodelada em uma imagem de 28×28. tanh a função de ativação garante que os valores de saída estejam no intervalo , o que é comum para dados de imagem.

Difusão estável com difusores faciais envolventes

A Difusão Estável é um poderoso modelo de conversão de texto em imagem que gera imagens com base em descrições textuais. O Rosto Abraçado diffusers a biblioteca fornece uma interface fácil para usar este modelo:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Este script carrega o modelo de Difusão Estável e gera uma imagem com base no prompt fornecido. Certifique-se de ter as dependências necessárias instaladas e uma GPU compatível para um desempenho ideal.

DALL·E com API OpenAI

DALL·E é outro modelo de texto para imagem desenvolvido pela OpenAI. Você pode interagir com ele usando a API da OpenAI:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

Substituir "your-api-key" com sua chave de API OpenAI real. Este script envia um prompt para o modelo DALL·E e recupera a imagem gerada. A imagem é então salva localmente.

CometAPI também integra API DALL-E 3, você também pode usar a chave do CometAPI para acessar API DALL-E 3, que é mais conveniente e rápido que o OpenAI.

Para obter mais informações sobre o modelo na API Comet, consulte Doc API.

Estes exemplos fornecem um ponto de partida para a geração de imagens usando diferentes modelos de IA. Cada modelo tem suas próprias capacidades e requisitos, então escolha aquele que melhor se adapta às necessidades do seu projeto.

Conclusão

A geração de imagens por IA está na intersecção entre tecnologia e criatividade, oferecendo possibilidades sem precedentes na criação de conteúdo visual. Entender como a IA gera imagens, os modelos envolvidos e as implicações dessa tecnologia é essencial à medida que navegamos por sua integração em diversos aspectos da sociedade.

Acesse a API de imagens de IA no CometAPI

A CometAPI fornece acesso a mais de 500 modelos de IA, incluindo modelos multimodais de código aberto e especializados para bate-papo, imagens, código e muito mais. Seu principal ponto forte reside na simplificação do processo tradicionalmente complexo de integração de IA. Com ela, o acesso às principais ferramentas de IA, como Claude, OpenAI, Deepseek e Gemini, está disponível por meio de uma assinatura única e unificada. Você pode usar a API da CometAPI para criar músicas e artes, gerar vídeos e construir seus próprios fluxos de trabalho.

CometAPI oferecemos um preço muito mais baixo do que o preço oficial para ajudá-lo a integrar API GPT-4o ,API no meio da jornada API de difusão estável (API de difusão estável XL 1.0) e Flux API(API FLUX.1 etc) e você receberá US$ 1 na sua conta após se registrar e fazer login!

CometAPI integra o mais recente API de imagem GPT-4o .