Nos últimos meses, houve uma rápida ascensão da programação orientada a agentes: modelos especializados que não apenas respondem a solicitações pontuais, mas planejam, editam, testam e iteram em repositórios inteiros. Dois dos exemplos mais notáveis são... Compor, um modelo de codificação de baixa latência desenvolvido especificamente para esse fim, introduzido pelo Cursor com o lançamento do Cursor 2.0, e GPT-5-Codex, a variante do GPT-5 otimizada para agentes da OpenAI, ajustada para fluxos de trabalho de codificação contínuos. Juntos, eles ilustram as novas linhas divisórias nas ferramentas de desenvolvimento: velocidade versus profundidade, consciência do espaço de trabalho local versus raciocínio generalista e conveniência da "codificação intuitiva" versus rigor de engenharia.

Em resumo: principais diferenças entre os dois

- Objetivo do projeto: GPT-5-Codex — raciocínio profundo e autônomo, além de robustez para sessões longas e complexas; Composer — iteração ágil e adaptada ao espaço de trabalho, otimizada para velocidade.

- Superfície de integração primária: GPT-5-Codex — API de produto/respostas do Codex, IDEs, integrações corporativas; Composer — Editor de cursor e interface de usuário multiagente do Cursor.

- Latência/iteração: O Composer enfatiza curvas em menos de 30 segundos e alega grandes vantagens de velocidade; o GPT-5-Codex prioriza a precisão e a execução autônoma de várias horas quando necessário.

Eu testei o API GPT-5-Codex modelo fornecido por CometAPI (um provedor de agregação de APIs de terceiros, cujos preços de API são geralmente mais baratos do que os do provedor oficial), resumiu minha experiência usando o modelo Composer do Cursor 2.0 e comparou os dois em várias dimensões de avaliação da geração de código.

O que são Composer e GPT-5-Codex?

O que é o GPT-5-Codex e quais problemas ele visa resolver?

O GPT-5-Codex da OpenAI é uma versão especializada do GPT-5 que, segundo a OpenAI, é otimizada para cenários de programação autônoma: execução de testes, realização de edições de código em escala de repositório e iteração autônoma até que as verificações sejam aprovadas. O foco aqui é a ampla capacidade em diversas tarefas de engenharia — raciocínio profundo para refatorações complexas, operação autônoma de longo prazo (onde o modelo pode gastar minutos ou horas raciocinando e testando) e desempenho superior em benchmarks padronizados, projetados para refletir problemas de engenharia do mundo real.

O que é o Composer e quais problemas ele visa resolver?

O Composer é o primeiro modelo de codificação nativo do Cursor, apresentado com o Cursor 2.0. O Cursor descreve o Composer como um modelo de vanguarda, centrado no agente, criado para baixa latência e iteração rápida em fluxos de trabalho de desenvolvedores: planejamento de comparações entre vários arquivos, aplicação de busca semântica em todo o repositório e conclusão da maioria das etapas em menos de 30 segundos. Ele foi treinado com acesso a ferramentas no loop (busca, edição, ferramentas de teste) para ser eficiente em tarefas práticas de engenharia e minimizar o atrito de ciclos repetidos de solicitação e resposta na codificação diária. O Cursor posiciona o Composer como um modelo otimizado para a velocidade do desenvolvedor e ciclos de feedback em tempo real.

Escopo do modelo e comportamento em tempo de execução

- Compositor: O Cursor é otimizado para interações rápidas e centradas no editor, além de oferecer consistência entre vários arquivos. Sua integração em nível de plataforma permite que o Composer visualize mais do repositório e participe da orquestração multiagente (por exemplo, dois agentes do Composer versus outros), o que, segundo o Cursor, reduz a detecção de dependências não identificadas entre arquivos.

- GPT-5-Codex: Otimizado para raciocínio mais profundo e de duração variável, o modelo da OpenAI destaca sua capacidade de priorizar o raciocínio mais profundo quando necessário, em detrimento do poder computacional/tempo — variando de segundos para tarefas simples até horas para execuções autônomas extensas —, possibilitando refatorações mais completas e depuração guiada por testes.

Resumindo: Composer = Modelo de codificação integrado ao ambiente de desenvolvimento integrado (IDE) do Cursor, com reconhecimento do espaço de trabalho; GPT-5-Codex = Variante especializada do GPT-5 da OpenAI para engenharia de software, disponível via Responses/Codex.

Qual a comparação de velocidade entre o Composer e o GPT-5-Codex?

O que alegaram os vendedores?

A Cursor posiciona o Composer como um programador de "fronteira rápida": os números publicados destacam a taxa de geração medida em tokens por segundo e alegam tempos de conclusão interativa de 2 a 4 vezes mais rápidos em comparação com modelos de "fronteira" na estrutura interna da Cursor. Análises independentes (imprensa e testes iniciais) relatam que o Composer produz código a cerca de 200 a 250 tokens/seg no ambiente da Cursor e completa turnos típicos de programação interativa em menos de 30 segundos em muitos casos.

O GPT-5-Codex da OpenAI não se posiciona como um experimento de latência; ele prioriza robustez e raciocínio mais profundo e — em cargas de trabalho comparáveis de alto raciocínio — pode ser mais lento quando usado em contextos maiores, de acordo com relatos da comunidade e discussões em fóruns.

Como avaliamos a velocidade (metodologia)

Para produzir uma comparação de velocidade justa, você deve controlar o tipo de tarefa (conclusões rápidas versus raciocínio longo), o ambiente (latência da rede, integração local versus em nuvem) e medir ambos. tempo até o primeiro resultado útil e relógio de parede de ponta a ponta (incluindo quaisquer etapas de execução de teste ou compilação). Pontos principais:

- Tarefas escolhidas — geração de pequenos trechos de código (implementação de um endpoint de API), tarefa média (refatoração de um arquivo e atualização de importações), tarefa grande (implementação de funcionalidade em três arquivos, atualização de testes).

- Métrica — tempo até o primeiro token, tempo até a primeira diferença útil (tempo até que o patch candidato seja emitido) e tempo total, incluindo a execução e verificação dos testes.

- Repetições — cada tarefa foi executada 10 vezes, sendo utilizada a mediana para reduzir o ruído da rede.

- Meio Ambiente — Medições feitas a partir de uma máquina de desenvolvimento em Tóquio (para refletir a latência real) com conexão estável de 100/10 Mbps; os resultados podem variar regionalmente.

Abaixo está um exemplo reproduzível. arnês de velocidade para GPT-5-Codex (API de Respostas) e uma descrição de como medir o Composer (dentro do Cursor).

Arnês de velocidade (Node.js) — GPT-5-Codex (API de respostas):

// node speed_harness_gpt5_codex.js

// Requires: node16+, npm install node-fetch

import fetch from "node-fetch";

import { performance } from "perf_hooks";

const API_KEY = process.env.OPENAI_API_KEY; // set your key

const ENDPOINT = "https://api.openai.com/v1/responses"; // OpenAI Responses API

const MODEL = "gpt-5-codex";

async function runPrompt(prompt) {

const start = performance.now();

const body = {

model: MODEL,

input: prompt,

// small length to simulate short interactive tasks

max_output_tokens: 256,

};

const resp = await fetch(ENDPOINT, {

method: "POST",

headers: {

"Authorization": `Bearer ${API_KEY}`,

"Content-Type": "application/json"

},

body: JSON.stringify(body)

});

const json = await resp.json();

const elapsed = performance.now() - start;

return { elapsed, output: json };

}

(async () => {

const prompt = "Implement a Node.js Express route POST /signup that validates email and stores user in-memory with hashed password (bcrypt). Return code only.";

const trials = 10;

for (let i=0;i<trials;i++){

const r = await runPrompt(prompt);

console.log(`trial ${i+1}: ${Math.round(r.elapsed)} ms`);

}

})();

Esta métrica mede a latência de ponta a ponta das requisições para o GPT-5-Codex usando a API de Respostas pública (a documentação da OpenAI descreve a API de Respostas e o uso do modelo gpt-5-codex).

Como medir a velocidade do Composer (cursor):

O Composer é executado dentro do Cursor 2.0 (fork para desktop/VS Code). O Cursor não fornece (até o momento da redação deste documento) uma API HTTP externa geral para o Composer que corresponda à API de Respostas da OpenAI; o ponto forte do Composer é integração de espaço de trabalho com estado dentro do IDEPortanto, avalie o Composer como um desenvolvedor humano faria:

- Abra o mesmo projeto no Cursor 2.0.

- Use o Composer para executar o mesmo prompt como uma tarefa do agente (criar rota, refatorar, alterar vários arquivos).

- Inicie um cronômetro ao enviar o plano do Composer; pare quando o Composer gerar o diff atômico e executar o conjunto de testes (a interface do Cursor pode executar testes e mostrar um diff consolidado).

- Repita 10 vezes e use a mediana.

Os materiais publicados pela Cursor e as análises práticas mostram que o Composer completa muitas tarefas comuns em menos de 30 segundos na prática; essa é uma meta de latência interativa, e não o tempo bruto de inferência do modelo.

Leve em conta: O objetivo do design do Composer é permitir edições interativas rápidas dentro de um editor; se sua prioridade é baixa latência e ciclos de codificação conversacionais, o Composer foi desenvolvido para esse caso de uso. O GPT-5-Codex é otimizado para correção e raciocínio autônomo em sessões mais longas; ele pode sacrificar um pouco de latência em prol de um planejamento mais profundo. Os números do fornecedor corroboram esse posicionamento.

Qual a comparação entre o Composer e o GPT-5-Codex em termos de precisão?

O que significa precisão na programação de IA?

A precisão, neste caso, é multifacetada: correção funcional (O código compila e passa nos testes?) correção semântica (O comportamento atende às especificações?) e robustez (lida com casos extremos e questões de segurança).

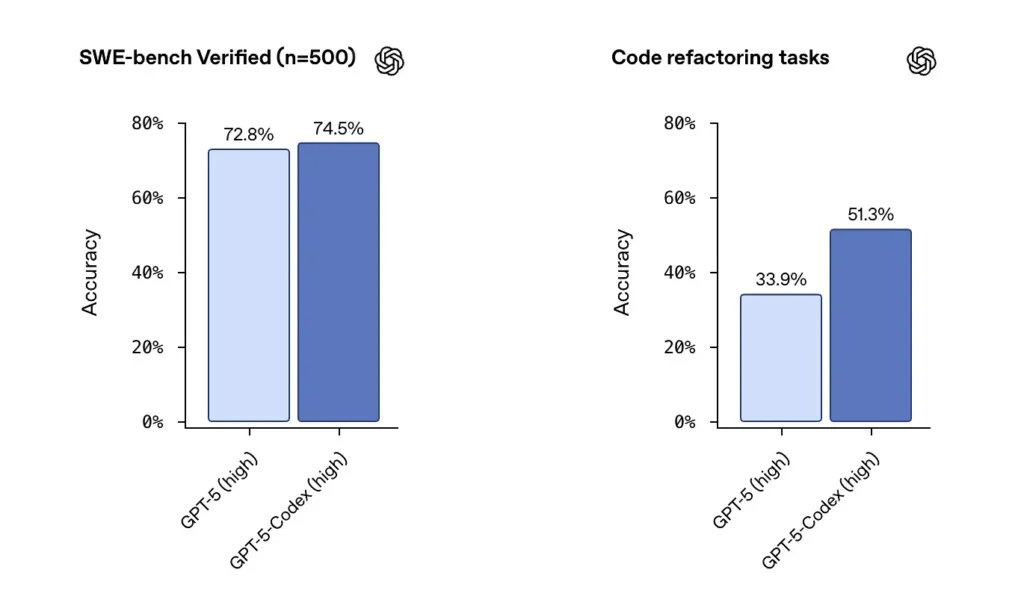

Números de fornecedores e imprensa

A OpenAI relata um forte desempenho do GPT-5-Codex em conjuntos de dados verificados pelo SWE-bench e destacou um 74.5% de sucesso em um teste de desempenho de codificação do mundo real (noticiado na imprensa) e um aumento notável no sucesso da refatoração (51.3% contra 33.9% para o GPT-5 base em seu teste interno de refatoração).

O lançamento do Cursor indica que o Composer frequentemente se destaca em edições contextuais com múltiplos arquivos, onde a integração com o editor e a visibilidade do repositório são importantes. Após meus testes, constatei que o Composer gerou menos erros de dependências não detectadas durante refatorações com múltiplos arquivos e obteve pontuações mais altas em testes de revisão cega para algumas cargas de trabalho com múltiplos arquivos. Os recursos de baixa latência e agentes paralelos do Composer também me ajudaram a melhorar a velocidade de iteração.

Testes de precisão independentes (método recomendado)

Um teste justo utiliza uma combinação de:

- Testes unitários: Alimente ambos os modelos com o mesmo repositório e conjunto de testes; gere o código e execute os testes.

- Testes de refatoração: fornecer uma função intencionalmente desorganizada e pedir ao modelo para refatorá-la e adicionar testes.

- Verificações de segurançaExecutar análise estática e ferramentas SAST no código gerado (por exemplo, Bandit, ESLint, semgrep).

- Revisão humana: Avaliações de código feitas por engenheiros experientes quanto à manutenibilidade e às melhores práticas.

Exemplo: ambiente de teste automatizado (Python) — executar código gerado e testes unitários

# python3 run_generated_code.py

# This is a simplified harness: it writes model output to file, runs pytest, captures results.

import subprocess, tempfile, os, textwrap

def write_file(path, content):

with open(path, "w") as f:

f.write(content)

# Suppose `generated_code` is the string returned from model

generated_code = """

# sample module

def add(a,b):

return a + b

"""

tests = """

# test_sample.py

from sample import add

def test_add():

assert add(2,3) == 5

"""

with tempfile.TemporaryDirectory() as d:

write_file(os.path.join(d, "sample.py"), generated_code)

write_file(os.path.join(d, "test_sample.py"), tests)

r = subprocess.run(, cwd=d, capture_output=True, text=True, timeout=30)

print("pytest returncode:", r.returncode)

print(r.stdout)

print(r.stderr)

Use esse padrão para verificar automaticamente se a saída do modelo está funcionalmente correta (se passa nos testes). Para tarefas de refatoração, execute o framework no repositório original, juntamente com as diferenças entre os modelos, e compare as taxas de aprovação nos testes e as alterações na cobertura.

Leve em conta: Em conjuntos de benchmarks brutos, o GPT-5-Codex apresenta resultados excelentes e uma forte capacidade de refatoração. Em fluxos de trabalho reais, com reparo de múltiplos arquivos e edição, o reconhecimento do espaço de trabalho do Composer pode resultar em maior aceitação prática e menos erros "mecânicos" (importações ausentes, nomes de arquivos incorretos). Para máxima correção funcional em tarefas algorítmicas de arquivo único, o GPT-5-Codex é uma forte opção; para alterações em múltiplos arquivos, que respeitam convenções, dentro de uma IDE, o Composer geralmente se destaca.

Composer vs GPT-5: Como se comparam em termos de qualidade de código?

O que é considerado qualidade?

A qualidade engloba legibilidade, nomenclatura, documentação, cobertura de testes, uso de padrões idiomáticos e práticas de segurança. Ela é medida tanto automaticamente (por meio de analisadores lógicos, métricas de complexidade) quanto qualitativamente (por revisão humana).

Diferenças observadas

- GPT-5-CodexPossui grande habilidade em gerar padrões idiomáticos quando solicitado explicitamente; destaca-se pela clareza algorítmica e consegue produzir conjuntos de testes abrangentes quando solicitado. As ferramentas Codex da OpenAI incluem testes/relatórios integrados e registros de execução.

- ComporO Composer é otimizado para observar automaticamente o estilo e as convenções de um repositório; ele pode seguir padrões de projeto existentes e coordenar atualizações em vários arquivos (propagação de renomeações/refatorações, importação de atualizações). Oferece excelente capacidade de manutenção sob demanda para grandes projetos.

Exemplos de verificações de qualidade de código que você pode executar.

- linters — ESLint / pylint

- Complexidade — radônio / flake8-complexidade

- Segurança — semgrep / Bandido

- Cobertura de teste — execute coverage.py ou vitest/nyc para JS

Automatize essas verificações após aplicar a correção do modelo para quantificar melhorias ou regressões. Exemplo de sequência de comandos (repositório JS):

# after applying model patch

npm ci

npm test

npx eslint src/

npx semgrep --config=auto .

Revisão humana e melhores práticas

Na prática, os modelos precisam de instruções para seguir as melhores práticas: solicitar docstrings, anotações de tipo, fixação de dependências ou padrões específicos (por exemplo, async/await). O GPT-5-Codex é excelente quando recebe diretivas explícitas; o Composer se beneficia do contexto implícito do repositório. Use uma abordagem combinada: instrua o modelo explicitamente e deixe o Composer impor o estilo do projeto se você estiver dentro do Cursor.

Recomendação: Para trabalhos de engenharia com múltiplos arquivos dentro de um IDE, prefira o Composer; para pipelines externos, tarefas de pesquisa ou automação de cadeias de ferramentas onde você pode chamar uma API e fornecer um contexto amplo, o GPT-5-Codex é uma excelente opção.

Opções de integração e implantação

O Composer é distribuído como parte do Cursor 2.0, integrado ao editor e à interface do usuário do Cursor. A abordagem do Cursor enfatiza um único plano de controle do fornecedor que executa o Composer juntamente com outros modelos — permitindo que os usuários executem várias instâncias do modelo no mesmo prompt e comparem as saídas dentro do editor. ()

O GPT-5-Codex está sendo integrado à oferta Codex da OpenAI e à família de produtos ChatGPT, com disponibilidade por meio dos planos pagos do ChatGPT e da API, que plataformas de terceiros como a CometAPI oferecem melhor custo-benefício. A OpenAI também está integrando o Codex às ferramentas de desenvolvimento e aos fluxos de trabalho de parceiros em nuvem (por exemplo, integrações com o Visual Studio Code/GitHub Copilot).

Para onde o Composer e o GPT-5-Codex podem levar a indústria no futuro?

Efeitos a curto prazo

- Ciclos de iteração mais rápidos: Modelos integrados ao editor, como o Composer, reduzem o atrito em pequenas correções e na geração de pull requests.

- Expectativas crescentes de verificação: A ênfase do Codex em testes, registros e capacidade autônoma pressionará os fornecedores a oferecerem uma verificação mais robusta e pronta para uso para o código gerado pelo modelo.

Médio a longo prazo

- A orquestração multimodelos torna-se normal: A interface gráfica multiagente do Cursor é um indício precoce de que, em breve, os engenheiros poderão executar vários agentes especializados em paralelo (linting, segurança, refatoração, otimização de desempenho) e aceitar os melhores resultados.

- Ciclos de feedback CI/IA mais eficientes: À medida que os modelos melhoram, os pipelines de CI incorporarão cada vez mais a geração de testes orientada por modelos e sugestões automatizadas de reparo — mas a revisão humana e a implementação em etapas continuam sendo cruciais.

Conclusão

Composer e GPT-5-Codex não são armas idênticas na mesma corrida armamentista; são ferramentas complementares otimizadas para diferentes partes do ciclo de vida do software. A proposta de valor do Composer é a velocidade: iteração rápida e ancorada no ambiente de trabalho que mantém os desenvolvedores em fluxo de trabalho. O valor do GPT-5-Codex é a profundidade: persistência assertiva, correção orientada a testes e auditabilidade para transformações complexas. O guia prático de engenharia é... orquestrar ambosAgentes de loop curto, semelhantes ao Composer, para fluxos de trabalho cotidianos, e agentes no estilo GPT-5 Codex para operações controladas e de alta confiabilidade. Os primeiros testes sugerem que ambos farão parte do conjunto de ferramentas de desenvolvimento em um futuro próximo, em vez de um substituir o outro.

Não existe um único vencedor objetivo em todas as dimensões. Os modelos trocam pontos fortes:

- GPT-5-Codex: Apresenta melhor desempenho em benchmarks de correção profunda, raciocínio de grande escopo e fluxos de trabalho autônomos de várias horas. Seu desempenho se destaca quando a complexidade da tarefa exige raciocínio extenso ou verificação complexa.

- Compositor: Mais eficiente em casos de uso com forte integração ao editor, consistência de contexto entre múltiplos arquivos e alta velocidade de iteração dentro do ambiente do Cursor. Pode ser melhor para a produtividade diária do desenvolvedor, onde edições imediatas, precisas e sensíveis ao contexto são necessárias.

Veja também Cursor 2.0 e Composer: como uma reformulação multiagente surpreendeu a programação de IA.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Os desenvolvedores podem acessar API GPT-5-Codexatravés do CometAPI, a versão mais recente do modelo está sempre atualizado com o site oficial. Para começar, explore as capacidades do modelo no Playground e consulte o Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Pronto para ir?→ Inscreva-se no CometAPI hoje mesmo !

Se você quiser saber mais dicas, guias e novidades sobre IA, siga-nos em VK, X e Discord!