O lançamento do GLM-5, apresentado nesta semana pela Zhipu AI da China (com marca pública Z.AI / zai-org em muitos canais de desenvolvedores), marca mais um passo no ritmo acelerado de lançamentos de modelos de grande porte. O novo modelo está sendo posicionado como o carro-chefe da Zhipu: maior em escala, ajustado para tarefas agênticas de longo horizonte e construído com escolhas de engenharia destinadas a reduzir o custo de inferência enquanto preserva contexto longo. Relatos iniciais da indústria e notas práticas de desenvolvedores sugerem ganhos significativos em programação, raciocínio de múltiplas etapas e orquestração de agentes em comparação com iterações anteriores do GLM — e em alguns testes ele chega a desafiar o Claude 4.5.

O que é o GLM-5 e quem o desenvolveu?

GLM-5 é a mais recente grande versão da família GLM: um modelo fundamental de código aberto desenvolvido e publicado pela Z.ai (a equipe por trás da série GLM). Anunciado no início de fevereiro de 2026, o GLM-5 é apresentado como um modelo de próxima geração especificamente ajustado para tarefas “agênticas” — ou seja, fluxos de trabalho de múltiplas etapas e longo horizonte em que o modelo precisa planejar, chamar ferramentas, executar e manter contexto ao longo de conversas estendidas ou agentes automatizados. O lançamento é notável não apenas pelo design do modelo, mas também por como e onde foi treinado: a Z.ai usou uma combinação de hardware e toolchains domésticos chineses como parte de um esforço por autossuficiência.

Números relatados de arquitetura e treinamento incluem:

- Escalonamento de parâmetros: o GLM-5 escala para cerca de 744B parâmetros (com uma contagem “ativa” menor citada em algumas notas técnicas, por exemplo, 40B ativos), em comparação com tamanhos anteriores da família GLM-4 de cerca de 355B/32B ativos.

- Dados de pré-treinamento: o tamanho do corpus de treinamento teria aumentado de ~23 trilhões de tokens (geração GLM-4) para ~28,5 trilhões de tokens no GLM-5.

- Atenção esparsa / DeepSeek Sparse Attention (DSA): um esquema de atenção esparsa para preservar contexto longo enquanto reduz o custo computacional durante a inferência.

- Ênfase de design: escolhas de engenharia focadas em orquestração de agentes, raciocínio de contexto longo e inferência econômica.

Origens e posicionamento

O GLM-5 se apoia em uma linha que incluiu o GLM-4.5 (lançado em meados de 2025) e algumas atualizações iterativas como a 4.7. A Z.ai posiciona o GLM-5 como um salto do “vibe coding” (saídas rápidas de código em uma única etapa) para a “engenharia agêntica”: raciocínio sustentado, orquestração de múltiplas ferramentas e síntese de sistemas ao longo de janelas de contexto extensas. Os materiais públicos enfatizam que o GLM-5 foi projetado para lidar com tarefas complexas de engenharia de sistemas — construir, coordenar e manter comportamentos de agentes de múltiplas etapas em vez de apenas responder a consultas isoladas.

Quais são os novos recursos do GLM-5?

Principais mudanças arquiteturais

- Escalonamento esparso massivo (MoE): o GLM-5 migra para uma arquitetura MoE (Mistura de Especialistas) esparsa muito maior. Números públicos em páginas de desenvolvedores e análises independentes listam o modelo com cerca de 744B parâmetros totais e ~40B ativos por token — um avanço significativo em relação à configuração de ~355B / 32B ativos do GLM-4.5. Esse escalonamento esparso permite apresentar uma capacidade total muito grande mantendo a computação por token viável.

- DeepSeek Sparse Attention (DSA): para preservar a capacidade de contexto longo sem escalar linearmente o custo de inferência, o GLM-5 integra um mecanismo de atenção esparsa (com marca DeepSeek) que retém dependências de longo alcance importantes enquanto reduz o custo da atenção em contextos de comprimento extremo.

Engenharia agêntica como objetivo de design fundamental

Um dos destaques do GLM-5 é ser explicitamente projetado para engenharia agêntica — ou seja, o modelo foi pensado não apenas para chat de uma única vez ou tarefas de resumo, mas como o “cérebro” de agentes de múltiplas etapas que podem planejar, emitir chamadas de ferramentas, gerenciar estado e raciocinar ao longo de contextos extensos. A Z.ai posiciona o GLM-5 para atuar em loops de orquestração: decompor problemas complexos, chamar ferramentas/APIs externas e acompanhar tarefas longas ao longo de muitas interações.

Por que o design agêntico importa

Fluxos agênticos são centrais para automação no mundo real: assistentes de pesquisa automatizados, engenheiros de software autônomos, orquestração de operações e controle de simulações. Um modelo construído para esse cenário precisa de planejamento sólido, comportamento estável de chamada de ferramentas e robustez ao longo de milhares de tokens de contexto.

Programação, raciocínio e comportamento de “longo horizonte” aprimorados

O GLM-5 enfatiza melhorias em geração de código e raciocínio. A Z.ai afirma melhorias direcionadas na capacidade do modelo de escrever, refatorar e depurar código, além de raciocínio multi-etapas mais consistente ao longo de interações extensas. Relatos de acesso antecipado independentes e avaliações de parceiros observaram o modelo significativamente mais forte em tarefas orientadas a desenvolvedores do que gerações anteriores do GLM.

Recursos práticos para desenvolvedores

- Janelas de contexto maiores para manter documentação, bases de código e estado de conversas.

- Primitivos de tooling para invocação segura de ferramentas e tratamento de resultados.

- Melhor desempenho em few-shot e chain-of-thought para decompor e executar tarefas complexas.

- Recursos agênticos e chamadas de ferramentas: o GLM-5 enfatiza suporte nativo a agentes: chamadas de funções/ferramentas, sessões com estado e melhor gerenciamento de diálogos longos e sequências de uso de ferramentas. Isso facilita a criação de agentes que integram busca na web, bancos de dados ou automação de tarefas.

Como o GLM-5 se sai em benchmarks?

Destaques específicos de benchmarks

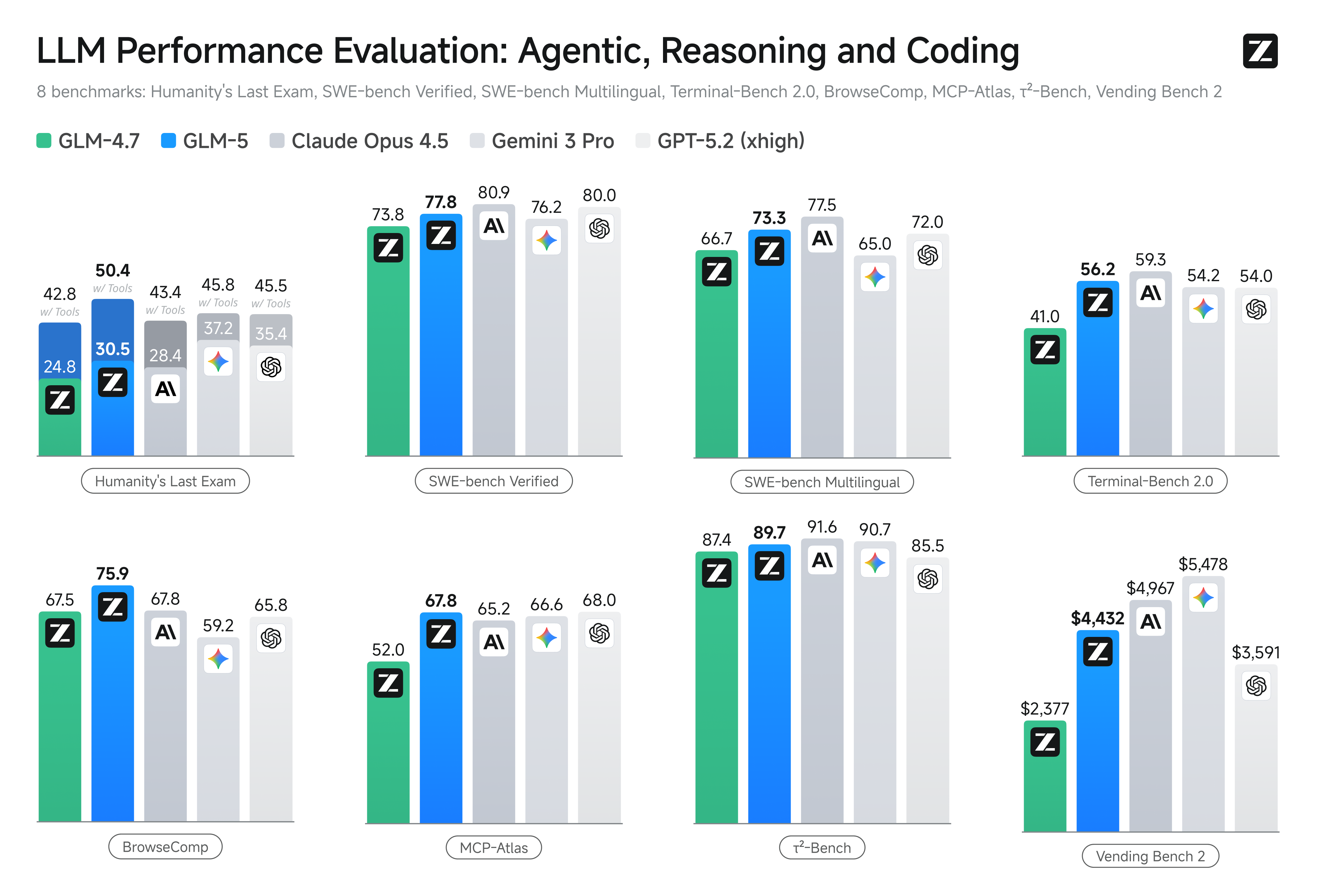

- Benchmarks de programação: o GLM-5 se aproxima (e, em alguns casos, iguala) o desempenho em programação de modelos proprietários altamente otimizados, como o Claude Opus 4.5 da Anthropic, em tarefas específicas de código. Esses resultados dependem da tarefa (testes unitários, codificação algorítmica, uso de API), mas marcam uma clara melhoria em relação ao GLM-4.5.

- Raciocínio e testes agênticos: em suítes de avaliação de raciocínio multi-etapas e agêntico (por exemplo, planejamento multi-turn, benchmarks de decomposição de tarefas), o GLM-5 atingiu resultados de ponta entre modelos de código aberto e, em algumas métricas, superou modelos fechados concorrentes em tarefas direcionadas.

Como acessar e experimentar o GLM-5?

GLM-5 é a quinta geração de modelo de linguagem grande da Zhipu AI (Z.ai), construído com uma arquitetura Mixture-of-Experts (~745 B total, ~44 B ativos) e voltado para forte raciocínio, programação e fluxos agênticos. Foi lançado oficialmente por volta de 12 de fevereiro de 2026.

Atualmente, há duas formas principais de acessá-lo:

A) Acesso oficial via API (Z.ai ou agregadores)

A própria Zhipu AI oferece APIs para seus modelos, e você pode chamar o GLM-5 por meio dessas APIs.

Etapas típicas:

- Cadastre-se em uma conta Z.ai/Open BigModel API.

- Obtenha uma chave de API no painel.

- Use um endpoint estilo OpenAPI ou REST API com o nome do modelo (por exemplo,

glm-5).

(Semelhante a como você chamaria modelos GPT da OpenAI). - Defina prompts e envie requisições HTTP.

👉 A página de preços da Z.ai mostra preços oficiais de tokens do GLM-5 como:

- ~$1.0 por milhão de tokens de entrada

- ~$3.2 por milhão de tokens de saída

B) Wrappers de API de terceiros —— CometAPI

APIs como CometAPI ou WaveSpeed envolvem múltiplos modelos de IA (OpenAI, Claude, Z.ai etc.) atrás de uma interface unificada.

- Com serviços como CometAPI, você pode chamar modelos GLM apenas trocando o ID do modelo.

(CometAPI atualmente oferece suporte a GLM-5/GLM-4.7.) - O glm-5 da CometAPI é precificado em 20% do preço oficial.

| Tipo de uso | Preço |

|---|---|

| Tokens de entrada | ~$0.8 por 1M de tokens |

| Tokens de saída | ~$2.56 por 1M de tokens |

Por que isso importa: você mantém seu código cliente compatível com OpenAI e apenas altera a URL base/ID do modelo.

C) Auto-hospedagem via Hugging Face / Weights

Há repositórios não oficiais de pesos do GLM-5 (por exemplo, versões nomeadas glm-5/glm-5-fp8) visíveis nas listas de modelos do Hugging Face.

Com eles você pode:

- Baixar os pesos do modelo.

- Usar ferramentas como vLLM, SGLang, xLLM ou Transformers para servir localmente ou na sua frota de GPUs em nuvem.

Prós: controle máximo, sem custo contínuo de API.

Contras: requisitos de computação enormes — provavelmente múltiplas GPUs de ponta e memória (centenas de GB), tornando impraticável em sistemas pequenos.

Então — vale a pena o GLM-5, e você deve manter o GLM-4.7?

Resposta curta (resumo executivo)

- Se seu trabalho exige comportamento agêntico robusto de múltiplas etapas, geração de código em nível de produção ou automação em nível de sistema: vale a pena avaliar o GLM-5 imediatamente. Sua arquitetura, escala e ajuste priorizam exatamente esses resultados.

- Se você precisa de microsserviços de alto throughput e custo eficiente (chat curto, classificação, prompts leves): o GLM-4.7 provavelmente continua sendo a escolha mais econômica. O GLM-4.7 preserva um conjunto forte de capacidades com custo por token significativamente menor em muitos provedores e já é amplamente testado.

Resposta longa (recomendação prática)

Adote uma estratégia de modelos em camadas: use o GLM-4.7 para interações cotidianas de alto volume e reserve o GLM-5 para problemas de engenharia de alto valor e orquestração agêntica. Faça um piloto com o GLM-5 em um recorte de produto que exercite contexto longo, integração de ferramentas e correção de código; meça o tempo de engenharia economizado e o custo incremental do modelo. Com o tempo, você saberá se o ganho de capacidade do GLM-5 justifica uma migração mais ampla.

Com a CometAPI, você pode alternar entre GLM-4.7 e GLM-5 a qualquer momento.

Casos de uso reais em que o GLM-5 se destaca

1. Orquestração complexa de agentes

O foco de design do GLM-5 em planejamento de múltiplas etapas e chamadas de ferramentas o torna adequado para sistemas que precisam coordenar busca, chamadas de API e execução de programas (por exemplo: assistentes de pesquisa automatizados, geradores iterativos de código ou agentes de atendimento ao cliente de múltiplas etapas que precisam consultar bancos de dados e APIs externas).

2. Engenharia de grande fôlego e raciocínio sobre bases de código

Quando você precisa que o modelo analise, refatore ou sintetize através de muitos arquivos ou uma grande base de código, o contexto estendido e a atenção esparsa do GLM-5 são vantagens diretas — menos modos de falha causados por contexto truncado e melhor consistência em longos trechos.

3. Síntese intensiva em conhecimento

Analistas e equipes de produto que produzem relatórios complexos — briefs de pesquisa multisseção, resumos jurídicos ou documentos regulatórios — podem se beneficiar das melhorias do modelo em raciocínio sustentado multi-etapas e redução de alucinações em testes relatados por fornecedores.

4. Automação agêntica para fluxos de trabalho

Equipes que constroem automação que precisa orquestrar múltiplos sistemas (por exemplo, planejamento + ticketing + pipelines de deploy) podem usar o GLM-5 como planejador e executor central, apoiado por frameworks de chamadas de ferramentas e camadas de segurança.

Conclusão

O GLM-5 é um lançamento importante no cenário em rápida evolução dos modelos de fronteira. Sua ênfase em engenharia agêntica, programação e raciocínio aprimorados, e disponibilidade de pesos abertos o torna atraente para equipes que constroem sistemas de IA com ferramentas e horizonte longo. Ganhos reais em tarefas selecionadas e relações custo/desempenho encorajadoras — mas compradores devem avaliar o GLM-5 em suas tarefas específicas e executar benchmarks controlados próprios antes de comprometerem-se com produção.

Desenvolvedores podem acessar GLM-5 via CometAPI agora. Para começar, explore as capacidades do modelo no Playground e consulte o API guide para instruções detalhadas. Antes de acessar, certifique-se de que fez login na CometAPI e obteve a chave de API. A CometAPI oferece um preço muito inferior ao oficial para ajudar você a integrar.

Pronto para começar? → Sign up fo glm-5 today !

Se você quer saber mais dicas, guias e notícias sobre IA, siga-nos no VK, X e Discord!