API de áudio GPT-4o: Um unificado /chat/completions extensão de ponto de extremidade que aceita entradas de áudio (e texto) codificadas pelo Opus e retorna fala sintetizada ou transcrições com parâmetros configuráveis (modelo=gpt-4o-audio-preview-<date>, speed, temperature) para interações de voz em lote e streaming.

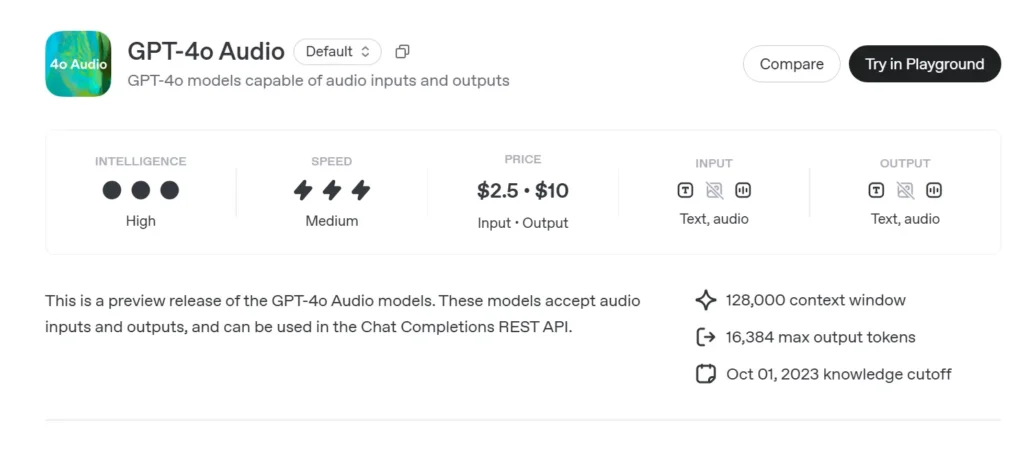

Informações básicas sobre áudio GPT-4o

Prévia de áudio do GPT-4o (gpt-4o-audio-preview-2025-06-03) é o mais novo da OpenAI modelo de linguagem grande centrado na fala disponibilizado através do padrão API de conclusões de bate-papo em vez do canal Realtime de latência ultrabaixa. Construída na mesma base “omni” do GPT-4o, esta variante é especializada em entrada e saída de fala de alta fidelidade para conversas por turnos, criação de conteúdo, ferramentas de acessibilidade e fluxos de trabalho agênticos que não exigem temporização em milissegundos. Ele herda todos os pontos fortes de raciocínio de texto dos modelos da classe GPT-4, adicionando transmissão de voz de ponta a ponta (S2S) pipelines, determinísticos chamada de função, E o novo speed parâmetro para controle de taxa de voz.

Conjunto de recursos principais do áudio GPT-4o

. Processamento unificado de fala para fala – O áudio é transformado diretamente em tokens semanticamente ricos, fundamentados e ressintetizados sem serviços STT/TTS externos, produzindo timbre de voz consistente, prosódia e retenção de contexto.

. Melhoria na instrução de acompanhamento – O ajuste de junho de 2025 entrega +19 pp aprovado em 1 em tarefas de comando de voz em comparação à linha de base GPT-2024o de maio de 4, reduzindo alucinações em domínios como suporte ao cliente e redação de conteúdo.

. Chamada de ferramenta estável – As saídas do modelo JSON estruturado que está em conformidade com o esquema de chamada de função OpenAI, permitindo que APIs de backend (pesquisa, reserva, pagamentos) sejam acionadas com >95% de precisão de argumento.

. speed Parâmetro (0.25–4×) – Os desenvolvedores podem modular a reprodução da fala para aprendizagem em ritmo lento, narração normal ou modos rápidos de “leitura audível”, sem ressintetizando texto externamente.

. Turntaking com reconhecimento de interrupção – Embora não seja tão baseado em latência quanto a variante em tempo real, a visualização oferece suporte streaming parcial: os tokens são emitidos assim que são computados, permitindo que os usuários interrompam mais cedo, se necessário.

Arquitetura Técnica do GPT-4o

• Transformador de pilha única – Como todos os derivados do GPT-4o, a pré-visualização de áudio emprega um codificador-decodificador unificado onde texto e tokens acústicos passam por blocos de atenção idênticos, promovendo aterramento intermodal.

• Tokenização de áudio hierárquica – PCM bruto de 16 kHz → patches log-mel → códigos acústicos grosseiros → tokens semânticos. Esta compressão em vários estágios atinge Redução de largura de banda de 40–50× preservando a nuance, permitindo clipes de vários minutos por janela de contexto.

• Pesos Quantizados NF4 – A inferência é servida em Normal-Float de 4 bits precisão, reduzindo a memória da GPU pela metade em comparação com o FP16 e sustentando Mais de 70 streaming RTF (fator em tempo real) em nós A100-80 GB.

• Atenção de streaming e cache KV – Os embeddings rotativos de janela deslizante mantêm o contexto ao longo de ~30 s de fala, mantendo O(L) uso de memória, ideal para editores de podcast ou ferramentas de leitura assistida.

Controle de versão e nomenclatura — Pré-visualização da trilha com compilações com data marcada

| Identificar | Canal | Propósito | Data de lançamento | Estabilidade |

|---|---|---|---|---|

| gpt-4o-audio-preview-2025-06-03 | API de conclusões de bate-papo | Interações de áudio baseadas em turnos, tarefas de agente | Junho 03 2025 | visualização (feedback encorajado) |

Elementos-chave do nome:

- gpt-4o – Família Omni multimodal.

- auditivo – Otimizado para casos de uso de fala.

- visualização – O contrato da API pode evoluir; ainda não está disponível para uso geral.

- 2025-06-03 – Instantâneo de treinamento e implantação para reprodutibilidade.

Como chamar a API de áudio GPT-4o da CometAPI

GPT-4o Audio API Preços da API no CometAPI:

- Tokens de entrada: $ 2 / M tokens

- Tokens de saída: $ 8 / M tokens

Etapas Necessárias

- Faça o login no cometapi.com. Se você ainda não é nosso usuário, registre-se primeiro

- Obtenha a chave de API da credencial de acesso da interface. Clique em "Adicionar Token" no token da API no centro pessoal, obtenha a chave de token: sk-xxxxx e envie.

- Obtenha a URL deste site: https://api.cometapi.com/

Métodos de uso

- Selecione a opção "

gpt-4o-audio-preview-2025-06-03” endpoint para enviar a solicitação e definir o corpo da solicitação. O método e o corpo da solicitação são obtidos da documentação da API do nosso site. Nosso site também oferece o teste Apifox para sua conveniência. - Substituir com sua chave CometAPI real da sua conta.

- Insira sua pergunta ou solicitação no campo de conteúdo — é a isso que o modelo responderá.

- . Processe a resposta da API para obter a resposta gerada.

Para obter informações sobre acesso ao modelo na API Comet, consulte Doc API.

Para obter informações sobre o preço do modelo na API Comet, consulte https://api.cometapi.com/pricing.

Fluxo de trabalho da API — Complementações de bate-papo com partes de áudio e ganchos de função

- Formato de entrada -

audio/*MIME oubase64Pedaços WAV incorporados emmessages[].content. - Opções de saída -

.mode: "text"→ texto puro para legendas.

.mode: "audio"→ retorna um streaming Carga útil Opus ou µ-law com registros de data e hora. - Invocação de função - Adicionar

functions:esquema; o modelo emiterole: "function"com argumentos JSON; o desenvolvedor executa a chamada da ferramenta e, opcionalmente, envia o resultado de volta. - Controle de taxa - Definir

voice.speed=1.25para acelerar a reprodução; intervalos seguros de 0.25 a 4.0. - Limites de Token/Áudio – 128 k contexto (~4 min de discurso) no lançamento; 4096 tokens de áudio / 8192 tokens de texto o que ocorrer primeiro.

Código de exemplo e integração de API

pythonimport openai

openai.api_key = "YOUR_API_KEY"

# Single-step audio completion (batch)

with open("prompt.wav", "rb") as audio:

response = openai.ChatCompletion.create(

model="gpt-4o-audio-preview-2025-06-03",

messages=[

{"role": "system", "content": "You are a helpful voice assistant."},

{"role": "user", "content": "audio", "audio": audio}

],

temperature=0.3,

speed=1.2 # 20% faster playback

)

print(response.choices.message)

- Destaques:

- modelo:

"gpt-4o-audio-preview-2025-06-03" - auditivo -chave na usuário mensagem para enviar fluxo binário

- velocidade: Controles taxa de voz entre lento (0.5) e rápido (2.0)

- temperatura: Saldos criatividade vs consistência

Indicadores Técnicos — Latência, Qualidade, Precisão

| métrico | Visualização de áudio | GPT-4o (somente texto) | Delta |

|---|---|---|---|

| Latência do primeiro token (1 disparo) | 1.2 s avg | 0.35 s | +0.85 segundos |

| MOS (Naturalidade da Fala, 5 pontos) | 4.43 | - | - |

| Conformidade com as instruções (voz) | 92% | 73% | +19pp |

| Precisão do argumento de chamada de função | 95.8% | 87% | +8.8pp |

| Taxa de erro de palavras (STT implícito) | 5.2% | não aplicável | - |

| Memória GPU/Stream (A100-80GB) | 7.1 GB | 14 GB (fp16) | -49% |

Benchmarks executados via streaming de conclusões de bate-papo, tamanho do lote = 1.

Veja também API em tempo real GPT-4o