API em tempo real GPT-4o: Um ponto de extremidade de streaming multimodal de baixa latência que permite aos desenvolvedores enviar e receber texto sincronizado, áudio e dados de visão por WebRTC ou WebSocket (modelo=gpt-4o-realtime-preview-<date>, stream=true) para aplicações interativas em tempo real.

Informações básicas e recursos

OpenAI's GPT-4o em tempo real (ID do modelo: gpt-4o-visualização-em-tempo-real-2025-06-03) é o primeiro modelo de fundação disponível ao público, projetado para transmissão de voz de ponta a ponta (S2S) interação com latência de subsegundos. Derivado da família “omni” GPT-4o, a variante Realtime funde reconhecimento de fala, raciocínio em linguagem natural e conversão neural de texto em fala em uma única rede, permitindo que os desenvolvedores criem agentes de voz que conversam com a mesma fluidez que os humanos. O modelo é exposto por meio de um recurso específico API em tempo real e está totalmente integrado com o novo Agente em tempo real abstração dentro do Agentes SDK (TypeScript e Python).

Conjunto de recursos principais — S2S de ponta a ponta • Tratamento de interrupções • Chamada de ferramentas

• Fala nativa para fala: A entrada de áudio é ingerida como fluxos contínuos, tokenizada internamente, analisada e retornada como fala sintetizada. Não são necessários buffers STT/TTS externos, eliminando o atraso de vários segundos no pipeline.

• Latência em escala de milissegundos: A poda arquitetônica, a destilação do modelo e uma pilha de serviço otimizada para GPU permitem Latências do primeiro token de ~300–500 ms em implantações típicas de nuvem, aproximando-se das normas de alternância de conversas humanas.

• Seguimento de instruções robusto: Ajustado em scripts de conversação e rastreamentos de chamada de função, o GPT-4o Realtime demonstra um >25% de redução em erros de execução de tarefas comparado com a linha de base GPT-2024o de maio de 4.

• Chamada de ferramentas determinística: O modelo produz JSON estruturado em conformidade com o OpenAI esquema de chamada de função, permitindo a invocação determinística de APIs de back-end (sistemas de reservas, bancos de dados, IoT). Repetições com reconhecimento de erros e validação de argumentos são integradas.

• Interrupções elegantes: Um detector de atividade de voz em tempo real emparelhado com decodificação incremental permite que o agente pausar a fala no meio da frase, ingira uma interrupção do usuário e retome ou replaneje a resposta perfeitamente.

• Taxa de fala configurável: Um novo velocidade parâmetro (0.25–4× tempo real) permite que os desenvolvedores ajustem o ritmo de saída para acessibilidade ou aplicativos rápidos.

Arquitetura Técnica — Transformador Multimodal Unificado

Codificador-Decodificador Unificado: O GPT-4o Realtime compartilha a arquitetura omni transformador de pilha única em que áudio, texto e tokens de visão (futura) coexistem em um espaço latente. A computação adaptativa em camadas redireciona os quadros de áudio diretamente para blocos de atenção posteriores, reduzindo de 20 a 40 ms por passagem.

Tokenização de áudio hierárquica: O PCM bruto de 16 kHz é dividido em patches log-mel → quantizado em tokens acústicos de granulação grossa → compactado em tokens semânticos, otimizando a token por segundo orçamento sem sacrificar a prosódia.

Kernels de inferência de baixo bit: Pesos implantados executados em Quantização NF4 de 4 bits via kernels Triton/TensorRT-LLM, dobrando a taxa de transferência em relação ao fp16, mas mantendo perda de qualidade MOS de <1 dB.

Atenção ao streaming: Os embeddings rotativos de janela deslizante e o cache de valor-chave permitem que o modelo atenda aos últimos 15 s de áudio com memória O(L), crucial para diálogos com duração de chamadas telefônicas.

Detalhes Técnicos

- Versão da API:

2025-06-03-preview - Protocolos de Transporte:

- WebRTC: Latência ultrabaixa (< 80 ms) para fluxos de áudio/vídeo do lado do cliente

- WebSocket: Streaming de servidor para servidor com latência inferior a 100 ms

- Codificação de Dados:

- Opus codec dentro RTP pacotes para áudio

- H.264 / H.265 wrappers de quadro para vídeo

- Game: Apoia

stream: truepara entregar incrementais respostas parciais à medida que os tokens são gerados - Nova paleta de vozes: Apresenta oito novas vozes—liga, cinza, balada, coral, eco, sábio, brilho e versículo—para mais expressivo, como humano interações ..

Evolução do GPT-4o em tempo real

- Maio de 2024: GPT-4o Omni estreia com suporte multimodal para texto, áudio e visão.

- Em Outubro de 2024: API em tempo real entra em beta privado (

2024-10-01-preview), otimizado para áudio de baixa latência. - Dezembro 2024: Disponibilidade global expandida de

gpt-4o-realtime-preview-2024-12-17, Adicionando cache de prompt e mais vozes. - 3 de Junho de 2025: Última atualização (

2025-06-03-preview) lança refinado paleta de vozes e otimizações de desempenho.

Desempenho de referência

- MMLU: 88.7, superando 4 do GPT-86.5 em Compreensão massiva de linguagem multitarefa .

- Reconhecimento de Voz: Conquistas líder da indústria taxas de erros de palavras em ambientes ruidosos, superando Sussurro linhas de base.

- Testes de Latência:

- XNUMX/XNUMX (fala em → texto para fora): 50–80 ms via WebRTC

- Áudio de ida e volta (fala de entrada → fala de saída): <100 ms .

Indicadores técnicos

- Produtividade: Sustenta 15 fichas/seg para fluxos de texto; Kbps 24 Opus para áudio.

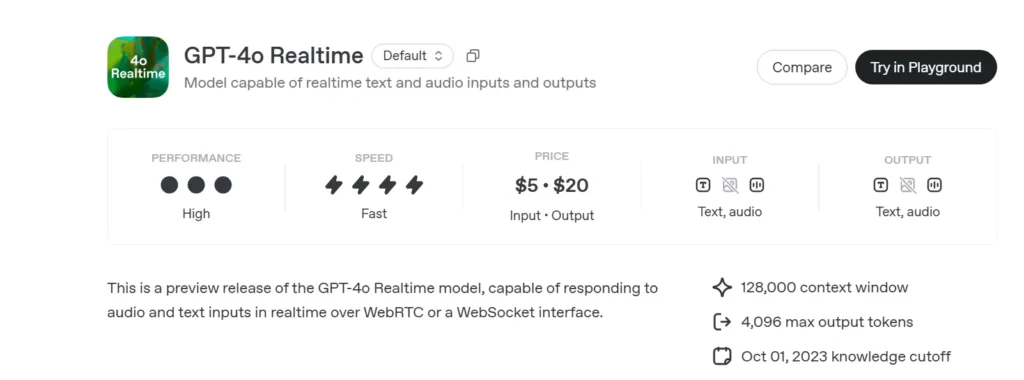

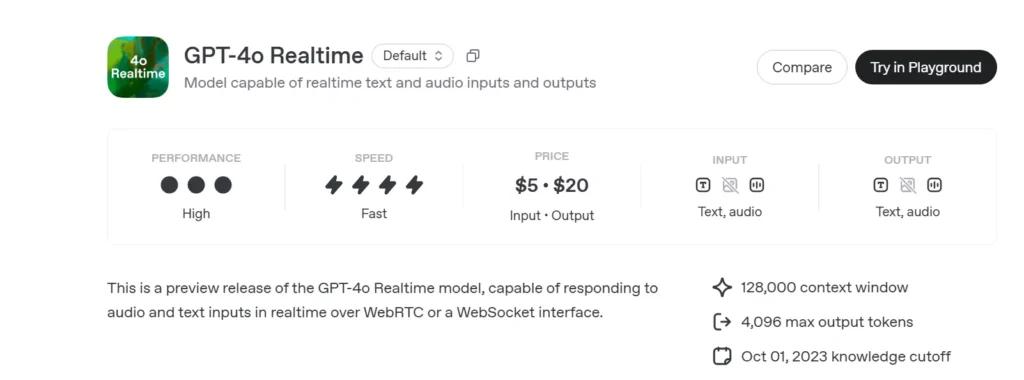

- Preços:

- Texto: $ 5 por 1 M de tokens de entrada; $ 20 por 1 M de tokens de saída

- em áudio: US$ 100 por 1 M de tokens de entrada; US$ 200 por 1 M de tokens de saída.

- Disponibilidade: Implantado globalmente em todas as regiões que oferecem suporte à API em tempo real.

Como chamar a API em tempo real GPT-4o do CometAPI

GPT-4o Realtime Preços da API no CometAPI:

- Tokens de entrada: $ 2 / M tokens

- Tokens de saída: $ 8 / M tokens

Etapas Necessárias

- Faça o login no cometapi.com. Se você ainda não é nosso usuário, registre-se primeiro

- Obtenha a chave de API da credencial de acesso da interface. Clique em "Adicionar Token" no token da API no centro pessoal, obtenha a chave de token: sk-xxxxx e envie.

- Obtenha a URL deste site: https://api.cometapi.com/

Métodos de uso

- Selecione a opção "

gpt-4o-realtime-preview-2025-06-03” endpoint para enviar a solicitação e definir o corpo da solicitação. O método e o corpo da solicitação são obtidos da documentação da API do nosso site. Nosso site também oferece o teste Apifox para sua conveniência. - Substituir com sua chave CometAPI real da sua conta.

- Insira sua pergunta ou solicitação no campo de conteúdo — é a isso que o modelo responderá.

- . Processe a resposta da API para obter a resposta gerada.

Para obter informações sobre acesso ao modelo na API Comet, consulte Doc API.

Para obter informações sobre o preço do modelo na API Comet, consulte https://api.cometapi.com/pricing.

Código de exemplo e integração de API

import openai

openai.api_key = "YOUR_API_KEY"

# Establish a Realtime WebRTC connection

connection = openai.Realtime.connect(

model="gpt-4o-realtime-preview-2025-06-03",

version="2025-06-03-preview",

transport="webrtc"

)

# Stream audio frames and receive incremental text

with open("user_audio.raw", "rb") as audio_stream:

for chunk in iter(lambda: audio_stream.read(2048), b""):

result = connection.send_audio(chunk)

print("Assistant:", result)

- Parâmetros-chave:

model: “gpt-4o-visualização-em-tempo-real-2025-06-03”version: “2025-06-03-prévia”transport: “webrtc” for latência mínimastream:truefor incrementais novidades

Combinando estado-da-arte raciocínio multimodal, um uma conta de despesas robusta nova paleta de vozes e ultra Baixo streaming de latência, GPT-4o em tempo real (2025-06-03) capacita os desenvolvedores a construir verdadeiramente interativo, conversação Aplicações de IA.

Veja também API o3-Pro

Segurança e Conformidade

O OpenAI envia o GPT-4o Realtime com:

. Guarda-corpos em nível de sistema: Política ajustada para recusar solicitações não permitidas (extremismo, comportamento ilícito).

. Filtragem de conteúdo em tempo real: Classificadores abaixo de 100 ms filtram a entrada do usuário e a saída do modelo antes da emissão.

. Caminhos de aprovação humana: Acionado em invocações de ferramentas de alto risco (pagamentos, aconselhamento jurídico), aproveitando os novos primitivos de aprovação do Agents SDK.