a partir de 15 de dezembro de 2025 os fatos públicos mostram que Google’s Gemini 3 Pro (preview) e OpenAI’s GPT-5.2 ambos estabelecem novas fronteiras em raciocínio, multimodalidade e trabalho de contexto longo — mas seguem rotas de engenharia diferentes (Gemini → MoE esparso + contexto enorme; GPT-5.2 → designs densos/de “roteamento”, compactação e modos de raciocínio x-high) e, portanto, trocam vitórias máximas em benchmarks vs. previsibilidade de engenharia, ferramentas e ecossistema. Qual é “melhor” depende da sua necessidade principal: aplicações agentivas multimodais com contexto extremo tendem ao Gemini 3 Pro; ferramentaria estável para desenvolvedores empresariais, custos previsíveis e disponibilidade imediata de API favorecem o GPT-5.2.

O que é o GPT-5.2 e quais são seus principais recursos?

GPT-5.2 é o lançamento de 11 de dezembro de 2025 da OpenAI na família GPT-5 (variantes: Instant, Thinking, Pro). É posicionado como o modelo mais capaz da empresa para “trabalho profissional de conhecimento” — otimizado para planilhas, apresentações, raciocínio de contexto longo, chamada de ferramentas, geração de código e tarefas de visão. A OpenAI disponibilizou o GPT-5.2 para usuários pagos do ChatGPT e via API da OpenAI (Responses API / Chat Completions) sob nomes de modelo como gpt-5.2, gpt-5.2-chat-latest e gpt-5.2-pro.

Variantes do modelo e uso pretendido

- gpt-5.2 / GPT-5.2 (Thinking) — melhor para raciocínio complexo e de múltiplas etapas (a variante padrão da família “Thinking” usada na Responses API).

- gpt-5.2-chat-latest / Instant — menor latência para uso cotidiano como assistente e chat.

- gpt-5.2-pro / Pro — a mais alta fidelidade/confiabilidade para os problemas mais difíceis (computação extra, suporta

reasoning_effort: "xhigh").

Principais recursos técnicos (voltados ao usuário)

- Melhorias em visão e multimodalidade — melhor raciocínio espacial em imagens e compreensão de vídeo aprimorada quando combinada com ferramentas de código (ferramenta Python), além de suporte a ferramentas no estilo code-interpreter para executar trechos.

- Esforço de raciocínio configurável (

reasoning_effort: none|minimal|low|medium|high|xhigh) para equilibrar latência/custo vs. profundidade.xhighé novo no GPT-5.2 (e suportado no Pro). - Melhor tratamento de contexto longo e recursos de compactação para raciocinar em centenas de milhares de tokens (a OpenAI reporta métricas fortes no MRCRv2/long-context).

- Chamada de ferramentas avançada e fluxos agentivos — coordenação multi-turn mais forte, melhor orquestração de ferramentas em uma arquitetura de “mega-agente único” (a OpenAI destaca desempenho em ferramentas no Tau2-bench).

O que é o Gemini 3 Pro Preview?

Gemini 3 Pro Preview é o modelo de IA generativa mais avançado do Google, lançado como parte da família Gemini 3 em novembro de 2025. O modelo foi construído com ênfase em compreensão multimodal — capaz de entender e sintetizar texto, imagens, vídeo e áudio — e apresenta uma janela de contexto grande (~1 milhão de tokens) para lidar com documentos extensos ou bases de código.

O Google posiciona o Gemini 3 Pro como referência em profundidade e nuance de raciocínio, servindo como o motor central de várias ferramentas para desenvolvedores e empresas, incluindo Google AI Studio, Vertex AI e plataformas de desenvolvimento agentivo como o Google Antigravity.

Até o momento, o Gemini 3 Pro está em preview — ou seja, funcionalidade e acesso ainda estão se expandindo, mas o modelo já atinge altas pontuações em lógica, compreensão multimodal e fluxos agentivos.

Principais recursos técnicos e de produto

- Janela de contexto: o Gemini 3 Pro Preview suporta 1.000.000 de tokens de entrada (e até 64k tokens de saída), o que é uma vantagem prática importante para ingerir documentos extremamente grandes, livros ou transcrições de vídeo em uma única solicitação.

- Recursos de API: parâmetro

thinking_level(low/high) para equilibrar latência e profundidade de raciocínio; configurações demedia_resolutionpara controlar fidelidade multimodal e uso de tokens; grounding de busca, contexto de arquivo/URL, execução de código e function calling são suportados. Thought signatures e cache de contexto ajudam a manter estado em fluxos multi-chamada. - Modo Deep Think / raciocínio mais alto: uma opção “Deep Think” oferece uma passagem extra de raciocínio para elevar as pontuações em benchmarks difíceis. O Google publica o Deep Think como um caminho separado de alto desempenho para problemas complexos.

- Suporte multimodal nativo: entradas de texto, imagem, áudio e vídeo com grounding estreito para busca e integrações de produto (pontuações em Video-MMMU e outros benchmarks multimodais são destacadas).

Visão rápida — GPT-5.2 vs Gemini 3 Pro

Tabela de comparação compacta com os fatos mais importantes (fontes citadas).

| Aspecto | GPT-5.2 (OpenAI) | Gemini 3 Pro (Google / DeepMind) |

|---|---|---|

| Fornecedor / posicionamento | OpenAI — upgrade principal da linha GPT-5.x focado em trabalho profissional de conhecimento, codificação e fluxos agentivos. | Google DeepMind / Google AI — geração principal do Gemini focada em raciocínio multimodal com contexto ultralongo e integração de ferramentas. |

| Principais sabores do modelo | Instant, Thinking, Pro (e comutação automática entre eles). Pro adiciona esforço de raciocínio mais alto. | Família Gemini 3 incluindo Gemini 3 Pro e modos Deep-Think; foco multimodal/agentivo. |

| Janela de contexto (entrada/saída) | ~400.000 tokens de capacidade total de entrada; até 128.000 tokens de saída/raciocínio (projetado para documentos e bases de código muito longos). | Até ~1.000.000 de tokens de entrada/janela de contexto (1M) com até 64K tokens de saída |

| Forças / foco principais | Raciocínio de contexto longo, chamada de ferramentas agentiva, codificação, tarefas estruturadas de trabalho (planilhas, apresentações); atualizações de segurança e system card enfatizam confiabilidade. | Compreensão multimodal em escala, raciocínio + composição de imagens, contexto muito grande + modo de raciocínio “Deep Think”, integrações fortes no ecossistema Google. |

| Capacidades multimodais e de imagem | Grounding em visão e multimodal aprimorado; ajustado para uso de ferramentas e análise de documentos. | Geração de imagens de alta fidelidade + composição com raciocínio, edição com múltiplas referências e renderização de texto legível. |

| Latência / interatividade | O fornecedor enfatiza inferência mais rápida e responsividade de prompt (menor latência que modelos GPT-5.x anteriores); vários níveis (Instant / Thinking / Pro). | O Google enfatiza “Flash”/serving otimizados e velocidades interativas comparáveis em muitos fluxos; o modo Deep Think troca latência por raciocínio mais profundo. |

| Recursos notáveis / diferenciais | Níveis de esforço de raciocínio (medium/high/xhigh), chamada de ferramentas aprimorada, geração de código de alta qualidade, alta eficiência de tokens para fluxos empresariais. | Contexto de 1M tokens, ingestão multimodal nativa forte (vídeo/áudio), modo de raciocínio “Deep Think”, integrações estreitas com produtos Google (Docs/Drive/NotebookLM). |

| Melhores usos típicos (curto) | Análise de documentos longos, fluxos agentivos, projetos de codificação complexos, automação empresarial (planilhas/relatórios). | Projetos multimodais extremamente grandes, fluxos agentivos de longo horizonte que precisam de contexto de 1M tokens, pipelines avançados de imagem + raciocínio. |

Como GPT-5.2 e Gemini 3 Pro se comparam arquiteturalmente?

Arquitetura central

- Benchmarks / avaliações de trabalho real: o GPT-5.2 Thinking obteve 70,9% de vitórias/empates no GDPval (avaliação de trabalho de conhecimento com 44 ocupações) e grandes ganhos em benchmarks de engenharia e matemática vs. variantes anteriores do GPT-5. Melhorias significativas em codificação (SWE-Bench Pro) e QA em ciências de domínio (GPQA Diamond).

- Ferramentas e agentes: suporte embutido forte para chamada de ferramentas, execução Python e fluxos agentivos (busca em documentos, análise de arquivos, agentes de ciência de dados). 11x mais rápido / <1% do custo vs. especialistas humanos em algumas tarefas do GDPval (medida de valor econômico potencial, 70,9% vs. ~38,8% anterior), e ganhos concretos em modelagem de planilhas (por exemplo, +9,3% em uma tarefa de banco de investimento júnior vs. GPT-5.1).

- Gemini 3 Pro: Transformer com Mixture-of-Experts esparso (MoE). O modelo ativa um pequeno conjunto de especialistas por token, permitindo capacidade total de parâmetros extremamente grande com computação por token sublinear. O Google publica um model card esclarecendo que o design MoE esparso é um contribuidor central para o perfil de desempenho melhorado. Essa arquitetura torna viável elevar a capacidade do modelo muito mais sem custo de inferência linear.

- GPT-5.2 (OpenAI): A OpenAI continua usando arquiteturas baseadas em Transformer com estratégias de roteamento/compactação na família GPT-5 (um “roteador” aciona modos diferentes — Instant vs. Thinking — e a empresa documenta técnicas de compactação e gestão de tokens para contextos longos). O GPT-5.2 enfatiza treinamento e avaliação para “pensar antes de responder” e compactação para tarefas de longo horizonte, em vez de anunciar MoE esparso clássico em escala.

Implicações das arquiteturas

- Trade-offs de latência e custo: modelos MoE como o Gemini 3 Pro podem oferecer capacidade de pico por token mais alta mantendo o custo de inferência menor para muitas tarefas porque apenas um subconjunto de especialistas é executado. Porém, podem adicionar complexidade ao serving e agendamento (balanceamento de especialistas em cold-start, IO). A abordagem do GPT-5.2 (denso/roteado com compactação) favorece latência previsível e ergonomia para desenvolvedores — especialmente quando integrado às ferramentas estabelecidas da OpenAI como Responses, Realtime, Assistants e APIs em lote.

- Escalonando contexto longo: a capacidade de 1M tokens de entrada do Gemini permite alimentar documentos extremamente longos e fluxos multimodais de forma nativa. Os ~400k de contexto combinado (entrada+saída) do GPT-5.2 ainda são enormes e cobrem a maioria das necessidades empresariais, mas são menores que a especificação de 1M do Gemini. Para corpora muito grandes ou transcrições de vídeo de várias horas, a especificação do Gemini oferece uma vantagem técnica clara.

Ferramentas, agentes e infraestrutura multimodal

- OpenAI: integração profunda para chamada de ferramentas, execução Python, modos de raciocínio “Pro” e ecossistemas de agentes pagos (ChatGPT Agents / integrações empresariais de ferramentas). Forte foco em fluxos centrados em código e geração de planilhas/slides como saídas de primeira classe.

- Google / Gemini: grounding embutido no Google Search (recurso opcional faturado), execução de código, contexto de URL e arquivo, e controles explícitos de resolução de mídia para equilibrar tokens e fidelidade visual. A API oferece

thinking_levele outros ajustes para calibrar custo/latência/qualidade.

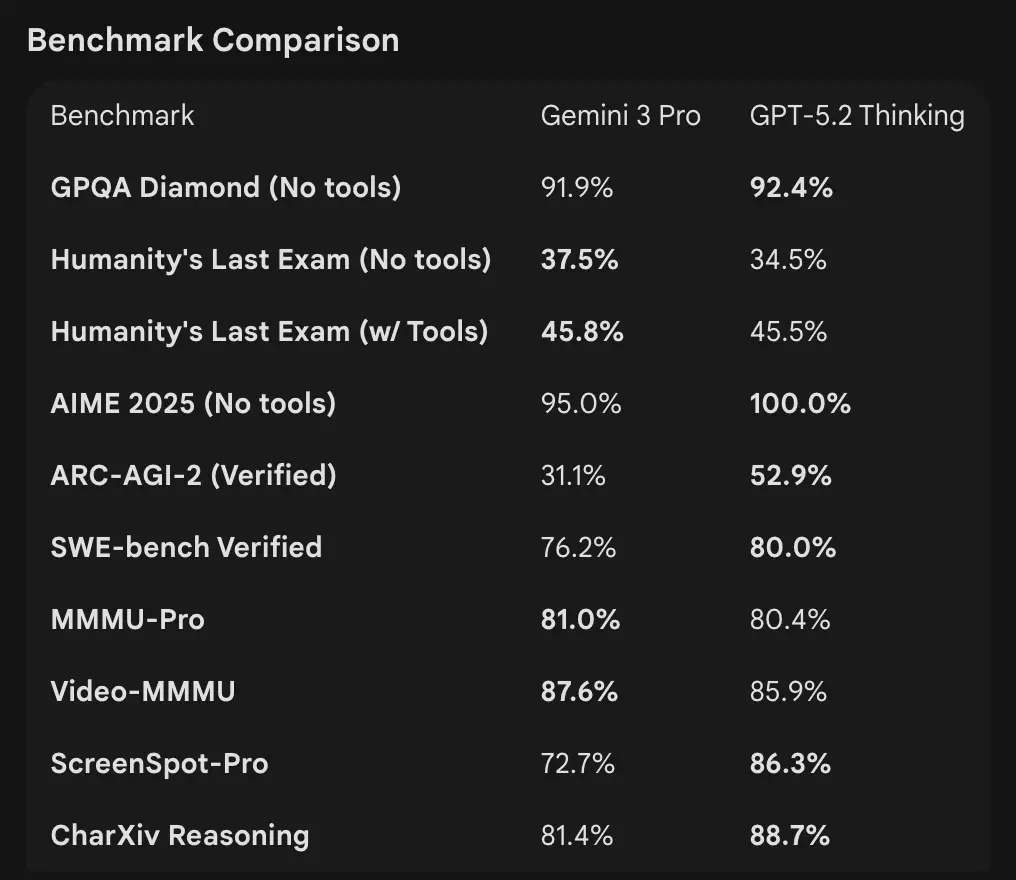

Como os números de benchmark se comparam

Janelas de contexto e tratamento de tokens

- Gemini 3 Pro Preview: 1.000.000 de tokens de entrada / 64k tokens de saída (model card da prévia Pro). Data de corte de conhecimento: janeiro de 2025 (Google).

- GPT-5.2: a OpenAI demonstra desempenho forte em contexto longo (pontuações MRCRv2 em tarefas de agulha 4k–256k com faixas >85–95% em muitas configurações) e usa recursos de compactação; exemplos públicos de contexto indicam desempenho robusto mesmo em contextos muito grandes, mas a OpenAI lista janelas específicas por variante (e enfatiza compactação em vez de um número único de 1M). Para uso via API, os nomes de modelo são

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-pro.

Benchmarks de raciocínio e agentivos

- OpenAI (selecionados): Tau2-bench Telecom 98,7% (GPT-5.2 Thinking), ganhos fortes em uso de ferramentas de múltiplas etapas e tarefas agentivas (a OpenAI destaca o colapso de sistemas multiagente em um “mega-agente”). GPQA Diamond e ARC-AGI mostraram saltos em relação ao GPT-5.1.

- Google (selecionados): Gemini 3 Pro: LMArena 1501 Elo, MMMU-Pro 81%, Video-MMMU 87,6%, GPQA e Humanity’s Last Exam altos; o Google também demonstra planejamento de longo horizonte robusto por meio de exemplos agentivos.

Ferramentas e agentes:

GPT-5.2: suporte embutido forte para chamada de ferramentas, execução Python e fluxos agentivos (busca em documentos, análise de arquivos, agentes de ciência de dados). 11x mais rápido / <1% do custo vs. especialistas humanos em algumas tarefas do GDPval (medida de valor econômico potencial, 70,9% vs. ~38,8% anterior), e ganhos concretos em modelagem de planilhas (por exemplo, +9,3% em uma tarefa de banco de investimento júnior vs. GPT-5.1).

Interpretação: os benchmarks são complementares — a OpenAI enfatiza benchmarks de trabalho real de conhecimento (GDPval), mostrando que o GPT-5.2 se destaca em tarefas de produção como planilhas, slides e sequências agentivas longas. O Google enfatiza leaderboards de raciocínio bruto e janelas de contexto de solicitação única extremamente grandes. O que importa mais depende da sua carga de trabalho: pipelines empresariais agentivos e de documentos longos favorecem o desempenho comprovado do GPT-5.2 no GDPval; ingestão de contexto bruto massivo (por exemplo, corpora inteiros de vídeo / livros completos em uma só passada) favorece a janela de 1M de entrada do Gemini.

Como as capacidades multimodais se comparam?

Entradas e saídas

- Gemini 3 Pro Preview: suporta entradas texto, imagem, vídeo, áudio, PDF e saídas de texto; o Google fornece controles granulares de

media_resolutione um parâmetrothinking_levelpara ajustar custo vs. fidelidade em trabalho multimodal. Limite de saída em 64k tokens; entrada até 1M tokens. - GPT-5.2: suporta fluxos ricos de visão e multimodal; a OpenAI destaca raciocínio espacial aprimorado (rótulos estimados de bounding de componentes de imagem), compreensão de vídeo (pontuações em Video MMMU) e visão habilitada por ferramentas (ferramenta Python em tarefas de visão melhora as pontuações). O GPT-5.2 enfatiza que tarefas complexas de visão + código se beneficiam muito quando o suporte a ferramentas (execução de código Python) está habilitado.

Diferenças práticas

Granularidade vs. abrangência: o Gemini expõe um conjunto de ajustes multimodais (media_resolution, thinking_level) voltados a permitir que desenvolvedores calibrem trade-offs por tipo de mídia. O GPT-5.2 enfatiza uso integrado de ferramentas (executar Python no loop) para combinar visão, código e tarefas de transformação de dados. Se o seu caso de uso for análise pesada de vídeo + imagem com contextos extremamente grandes, a alegação de 1M de contexto do Gemini é convincente; se seus fluxos exigem executar código no loop (transformações de dados, geração de planilhas), a ferramenta de código e a amizade com agentes do GPT-5.2 podem ser mais convenientes.

E quanto a acesso à API, SDKs e preços?

OpenAI GPT-5.2 (API e preços)

- API:

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-provia Responses API / Chat Completions. SDKs estabelecidos (Python/JS), guias cookbook e um ecossistema maduro. - Preços (públicos): US$ 1,75 / 1M tokens de entrada e US$ 14 / 1M tokens de saída; descontos de cache (90% para entradas em cache) reduzem o custo efetivo para dados repetidos. A OpenAI enfatiza eficiência de tokens (preço por token mais alto, mas menor custo total para atingir um patamar de qualidade).

Gemini 3 Pro Preview (API e preços)

- API:

gemini-3-pro-previewvia Google GenAI SDK e endpoints Vertex AI/GenerativeLanguage. Novos parâmetros (thinking_level,media_resolution) e integração com groundings e ferramentas do Google. - Preços (prévia pública): Aproximadamente US$ 2 / 1M tokens de entrada e US$ 12 / 1M tokens de saída para camadas de prévia abaixo de 200k tokens; cobranças adicionais podem se aplicar para Search grounding, Maps ou outros serviços do Google (faturamento do Search grounding começa em 5 de janeiro de 2026).

Use GPT-5.2 e Gemini 3 via CometAPI

CometAPI é um gateway / API agregadora: um único endpoint REST no estilo OpenAI que dá acesso unificado a centenas de modelos de vários fornecedores (LLMs, modelos de imagem/vídeo, embeddings etc.). Em vez de integrar diversos SDKs de fornecedores, a CometAPI permite chamar endpoints em formato OpenAI conhecidos (chat/completions/embeddings/images) enquanto alterna modelos ou fornecedores por baixo dos panos.

Desenvolvedores podem usar modelos flagship de duas empresas diferentes simultaneamente via CometAPI sem trocar de fornecedor, e os preços da API são mais acessíveis, geralmente com 20% de desconto.

Exemplo: snippets rápidos de API (copiar e colar para testar)

Abaixo estão exemplos mínimos que você pode executar. Eles refletem os quickstarts publicados pelos fornecedores (OpenAI Responses API + cliente Google GenAI). Substitua $OPENAI_API_KEY / $GEMINI_API_KEY por suas chaves.

GPT-5.2 — Python (OpenAI Responses API, reasoning definido como xhigh para problemas profundos)

# Python (requires openai SDK that supports responses API)from openai import OpenAIclient = OpenAI(api_key="YOUR_OPENAI_API_KEY")resp = client.responses.create( model="gpt-5.2-pro", # gpt-5.2 or gpt-5.2-pro input="Summarize this 50k token company report and output a 10-slide presentation outline with speaker notes.", reasoning={"effort": "xhigh"}, # deeper reasoning max_output_tokens=4000)print(resp.output_text) # or inspect resp to get structured outputs / tokens

Notas: reasoning.effort permite trocar custo vs. profundidade. Use gpt-5.2-chat-latest para estilo de chat Instant. A documentação da OpenAI mostra exemplos para responses.create.

GPT-5.2 — curl (simples)

curl https://api.openai.com/v1/responses \ -H "Authorization: Bearer $OPENAI_API_KEY" \ -H "Content-Type: application/json" \ -d '{ "model": "gpt-5.2", "input": "Write a Python function that converts a PDF with tables into a normalized CSV with typed columns.", "reasoning": {"effort":"high"} }'

(Inspecione o JSON para output_text ou saídas estruturadas.)

Gemini 3 Pro Preview — Python (cliente Google GenAI)

# Python (google genai client) — example from Google docsfrom google import genaiclient = genai.Client(api_key="YOUR_GEMINI_API_KEY")response = client.models.generate_content( model="gemini-3-pro-preview", contents="Find the race condition in this multi-threaded C++ snippet: <paste code here>", config={ "thinkingConfig": {"thinking_level": "high"} })print(response.text)

Notas: thinking_level controla a deliberação interna do modelo; media_resolution pode ser definido para imagens/vídeos. Exemplos REST e JS estão no guia de desenvolvimento do Gemini do Google.

Gemini 3 Pro — curl (REST)

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \ -H "x-goog-api-key: $GEMINI_API_KEY" \ -H "Content-Type: application/json" \ -X POST \ -d '{ "contents": [{ "parts": [{"text": "Explain the race condition in this C++ code: ..."}] }], "generationConfig": {"thinkingConfig": {"thinkingLevel": "high"}} }'

A documentação do Google inclui exemplos multimodais (dados inline de imagem, media_resolution).

Qual modelo é “melhor” — orientação prática

Não há um “vencedor” único; em vez disso, escolha com base no caso de uso e nas restrições. Abaixo, uma matriz curta de decisão.

Escolha o GPT-5.2 se:

- Você precisa de integração estreita com ferramentas de execução de código (ecossistema de interpretador/ferramentas da OpenAI) para pipelines programáticos de dados, geração de planilhas ou fluxos agentivos de código. A OpenAI destaca melhorias na ferramenta Python e uso de mega-agente.

- Você prioriza eficiência de tokens segundo as declarações do fornecedor e quer preços por token explícitos e previsíveis da OpenAI com grandes descontos para entradas em cache (ajuda em fluxos em lote/produção).

- Você quer o ecossistema da OpenAI (integração com o produto ChatGPT, parcerias com Azure / Microsoft e tooling em torno da Responses API e Codex).

Escolha o Gemini 3 Pro se:

- Você precisa de entrada multimodal extrema (vídeo + imagens + áudio + PDFs) e quer um único modelo que aceite nativamente todas essas entradas com 1.000.000 de tokens de janela de entrada. O Google comercializa explicitamente isso para vídeos longos, pipelines de documentos grandes + vídeo e casos de uso interativos com Search/AI Mode.

- Você está construindo no Google Cloud / Vertex AI e quer integração estreita com grounding de busca do Google, provisionamento no Vertex e as APIs do cliente GenAI. Você se beneficiará das integrações com produtos do Google (Search AI Mode, AI Studio, ferramenta de agentes Antigravity).

Conclusão: qual é melhor em 2026?

No confronto GPT-5.2 vs. Gemini 3 Pro Preview, a resposta é dependente do contexto:

- GPT-5.2 lidera em trabalho profissional de conhecimento, profundidade analítica e fluxos estruturados.

- Gemini 3 Pro Preview se destaca em compreensão multimodal, ecossistemas integrados e tarefas de contexto grande.

Nenhum modelo é universalmente “melhor” — em vez disso, seus pontos fortes atendem a demandas reais diferentes. Adotantes inteligentes devem combinar a escolha do modelo com casos de uso específicos, restrições de orçamento e alinhamento de ecossistema.

O que está claro em 2026 é que a fronteira da IA avançou significativamente, e tanto o GPT-5.2 quanto o Gemini 3 Pro estão expandindo os limites do que sistemas inteligentes podem alcançar na empresa e além.

Se quiser experimentar agora, explore as capacidades de GPT-5.2 e Gemini 3 Pro da CometAPI no Playground e consulte o guia da API para instruções detalhadas. Antes de acessar, certifique-se de ter feito login na CometAPI e obtido a chave de API. A CometAPI oferece um preço muito inferior ao oficial para ajudar na sua integração.

Pronto para começar? → Teste grátis do GPT-5.2 e Gemini 3 Pro !

Se você quiser