A Luma AI se tornou uma das ferramentas mais comentadas na criação de conteúdo para consumidores e prosumers: um aplicativo e serviço de nuvem que converte fotos e vídeos de smartphones em NeRFs 3D fotorrealistas e — por meio de seus modelos Dream Machine/Ray2 — gera imagens e vídeos curtos a partir de textos ou imagens. Mas a velocidade é uma das primeiras perguntas práticas que os criadores fazem: quanto tempo realmente leva uma captura, renderização ou geração de vídeo?

Quanto tempo a Luma AI leva para gerar um clipe da Dream Machine (texto → vídeo)?

Tempos de referência oficiais

As páginas de produtos e o centro de aprendizagem da Luma fornecem tempos de referência rápidos para seus pipelines de geração de imagens e vídeos curtos: lotes de imagens são medidos em dezenas de segundos e trabalhos de vídeos curtos em segundos a alguns minutos em condições normais para usuários pagos e benchmarks internos. Essas métricas oficiais refletem execuções otimizadas de modelos na infraestrutura da Luma (pilha Ray2/Dream Machine) e são os números mais adequados para clipes curtos e curtos.

Intervalos do mundo real que você deve esperar

Casos extremos / nível livre ou carga de pico: usuários livres ou períodos de alta demanda produziram esperas de horas ou trabalhos "presos na fila" até que a capacidade seja liberada; tópicos da comunidade documentam esperas de várias horas durante períodos de pico ou interrupções. Se a baixa latência for crítica, considere essa variabilidade e considere opções pagas/prioritárias.

Pequenos clipes sociais (5–15 seg): em muitos casos, a etapa de geração sozinha pode ser concluída em menos de um minuto a alguns minutos para usuários pagos durante o carregamento normal — mas o tempo total de uso pode ser maior quando você inclui etapas de enfileiramento, pré-processamento e streaming/exportação.

Clipes mais longos ou com mais detalhes (20–60 segundos): estes podem levar vários minutos a dezenas de minutos, principalmente se você solicitar maior resolução, movimentos de câmera complexos ou refinamento iterativo. Avaliações de terceiros e contas de usuários relatam tempos típicos no 5–30 minutos banda para vídeos curtos mais complexos.

Quanto tempo a Luma AI leva para produzir uma captura 3D (captura NeRF / Genie / Phone)?

Fluxos de trabalho típicos de captura 3D e seus perfis de tempo

As ferramentas de captura 3D da Luma (o aplicativo de captura móvel + recursos semelhantes aos do Genie) transformam um conjunto de fotos ou um vídeo gravado em um modelo 3D ou malha texturizada semelhante ao NeRF. Ao contrário dos clipes curtos da Dream Machine, a reconstrução 3D é mais complexa: ela precisa processar muitos quadros, estimar poses de câmera, otimizar a geometria volumétrica e sintetizar texturas. Tutoriais públicos e guias práticos relatam tempos de processamento no mundo real de vários minutos até várias horas, dependendo do comprimento e da qualidade da captura. Um exemplo de tutorial comumente citado mostrou 30 minutos a uma hora para uma captura moderada; outros tipos de captura (longas caminhadas, quadros de alta resolução) podem levar mais tempo.

Intervalos representativos

- Digitalizações rápidas de objetos/produtos (20 a 80 fotos, captura curta): alguns minutos a ~30 minutos.

- Capturas em escala de sala ou passo a passo (centenas a milhares de quadros): 30 minutos a várias horas, dependendo do tamanho da entrada e da fidelidade da exportação final.

- Exportações de alta fidelidade para motores de jogos (malhas, texturas de alta resolução): adicione tempo extra para geração de malha, retopologia e cozimento — isso pode empurrar os trabalhos para o horas.

Por que vídeos 3D demoram mais que vídeos curtos

A reconstrução 3D é iterativa e exige muita otimização: o modelo refina campos volumétricos e previsões de textura em vários quadros, o que exige um alto nível de processamento computacional. O backend da Luma paraleliza grande parte desse trabalho, mas a escala de computação por tarefa permanece maior do que a geração de um único vídeo curto.

Quais são os principais fatores que afetam o tempo de processamento do Luma AI?

Escolha de modelo e pipeline (Ray2, Photon, Genie, Modify Video)

Diferentes modelos e recursos do Luma são projetados para diferentes compensações: o Ray2 e o Dream Machine priorizam a geração de vídeo fotorrealista com feedback interativo de baixa latência, enquanto o Photon e o Genie são otimizados para aprimoramento de imagem ou reconstrução 3D e podem ser mais pesados por design. A escolha de um modelo com configurações de fidelidade mais altas aumentará o tempo de computação. A documentação oficial e a API descrevem vários endpoints do modelo e sinalizadores de qualidade que afetam o tempo de execução.

Tamanho e complexidade da entrada

- Número de quadros / fotos: mais entrada = mais etapas de otimização.

- Resolução: resoluções de saída mais altas e entradas de resolução mais alta aumentam o tempo de processamento.

- Duração do clipe solicitado: clipes mais longos exigem mais verificações de renderização e coerência de movimento.

Nível de conta, enfileiramento e prioridade

Assinaturas pagas e clientes empresariais/API geralmente recebem prioridade ou limites de tarifas mais altos. Usuários do plano gratuito geralmente enfrentam filas mais longas quando o sistema está sobrecarregado. Relatórios da comunidade comprovam isso: planos pagos geralmente reduzem a espera e melhoram a taxa de transferência.

Carga do sistema e hora do dia

Tópicos de usuários reais mostram que os tempos de geração podem aumentar durante os horários de pico ou quando lançamentos de recursos importantes geram picos de demanda. A equipe da Luma atualiza continuamente a infraestrutura (veja os registros de alterações) para lidar com a capacidade, mas atrasos temporários ainda ocorrem.

Tempo de rede/upload e dispositivo cliente

Para fluxos de trabalho de captura, a velocidade de upload e o desempenho do dispositivo são importantes: uploads de captura grandes, com vários gigabytes, aumentam o tempo de processamento antes mesmo do início. A documentação da Luma indica os tamanhos máximos de arquivo e recomenda as melhores práticas de captura para minimizar a transferência desnecessária de dados.

Como posso estimar o tempo de trabalho com antecedência e reduzir a espera?

Lista de verificação de estimativa rápida

- Classifique seu trabalho: imagem, vídeo curto (<15s), vídeo mais longo (>15s) ou captura 3D.

- Contagem de entradas: número de fotos / duração do vídeo (segundos) / tamanho do arquivo de captura.

- Decida a qualidade: baixa, padrão ou alta fidelidade — maior fidelidade = computação mais longa.

- Nível de conta de verificação: gratuito vs pago vs empresarial; leve em consideração a provável fila.

- Execute um teste curto: crie um trabalho de teste de 5 a 10 segundos para reunir uma linha de base do mundo real.

Dicas práticas para acelerar a produtividade

- Use padrões de captura recomendados (movimento suave da câmera, iluminação consistente) para que a reconstrução converja mais rapidamente. O centro de aprendizagem e as páginas do aplicativo móvel da Luma fornecem as melhores práticas de captura.

- Reduzir o tamanho da entrada quando aceitável: corte, diminua a resolução ou apare a filmagem antes do upload para reduzir o tempo e o custo de processamento.

- Escolha predefinições de qualidade inferior para rascunhos, então finalize em alta qualidade somente quando estiver satisfeito com a composição.

- Programe corridas pesadas fora do horário de pico se puder; relatórios da comunidade indicam que as filas diminuem fora dos horários de pico.

- Considere opções de API/empresa se você precisa de escala e SLA previsível; a API e o changelog da Luma mostram investimentos contínuos em desempenho e novos endpoints como o Modify Video para otimizar fluxos de trabalho.

Como os números de tempo da Luma se comparam aos de outras ferramentas?

Comparar serviços generativos de imagem/vídeo ou NeRF é complexo porque cada provedor otimiza para diferentes compensações (qualidade vs. velocidade vs. custo). Para geração de imagens e vídeos de curtíssima duração, a Dream Machine da Luma — especialmente com Ray2 Flash — compete com latência interativa abaixo de um minuto, o que está em linha com os principais serviços generativos voltados para o consumidor. Para captura NeRF de cena completa e criação de modelos 3D de alta fidelidade, as necessidades de computação em nuvem e os tempos de enfileiramento são maiores do que os geradores rápidos de imagens: espere maior variação e planeje adequadamente. Documentação de parceiros e relatórios de terceiros geralmente indicam minutos para renderizações curtas e simples e horas (ou imprevisivelmente mais) para pipelines 3D complexos.

Veredicto final — quanto tempo precisarão Luma leva para my trabalho?

Não existe um número único que se aplique a todos os usuários ou a todas as funções. Use estas âncoras pragmáticas para estimar:

- Geração de imagens (Dream Machine): ~20–30 segundos por lote pequeno sob carga normal.

- Geração de vídeo curto (Dream Machine / Ray2): dezenas de segundos a alguns minutos para clipes curtos; o Ray2 Flash pode ser significativamente mais rápido em fluxos suportados.

- Captura 3D → NeRF: altamente variável. Melhor caso: minutos para um objeto pequeno e computação leve; pior caso (relatado): Muitas horas ou dias durante alta demanda ou para capturas muito grandes. Se precisar de cronogramas firmes, adquira planos prioritários/empresariais ou execute testes piloto de pré-produção e inclua um tempo de reserva planejado em sua agenda.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

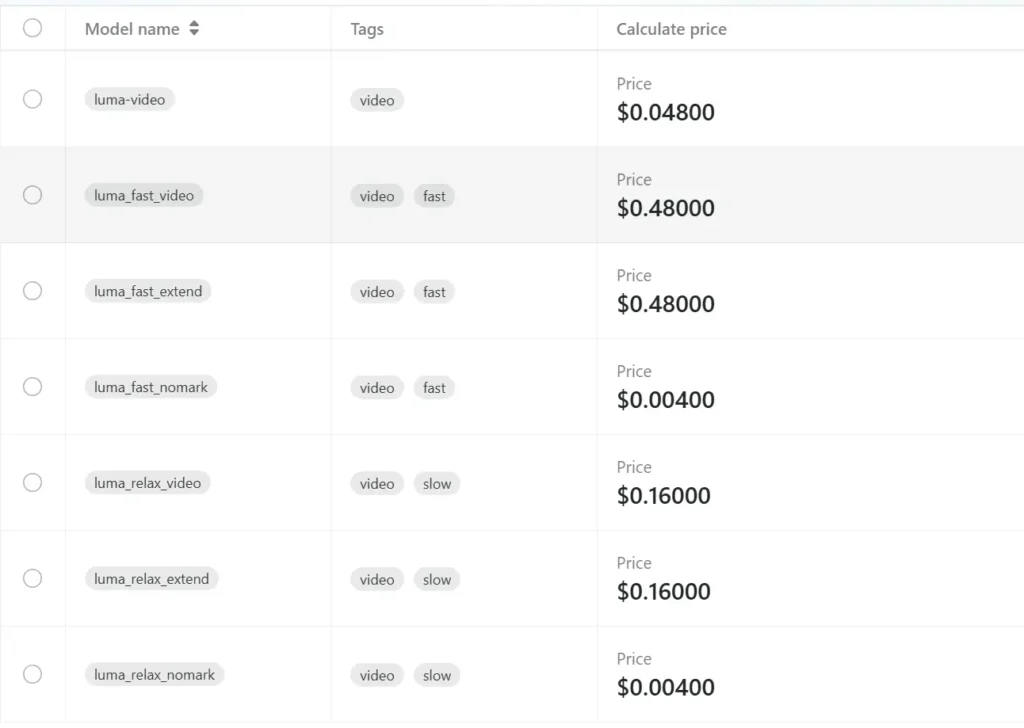

Os desenvolvedores podem acessar API Luma através de CometAPI, as versões mais recentes dos modelos listados são as da data de publicação do artigo. Para começar, explore os recursos do modelo no Playground e consulte o Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecemos um preço muito mais baixo que o preço oficial para ajudar você a se integrar: