A série GLM-4.5, desenvolvida pela Zhipu AI (Z.ai), representa um avanço significativo em modelos de grandes linguagens (LLMs) de código aberto. Projetada para unificar raciocínio, codificação e recursos de agente, a série GLM-4.5 oferece desempenho robusto em diversas aplicações. Seja você um desenvolvedor, pesquisador ou entusiasta, este guia fornece informações detalhadas sobre como acessar e utilizar a série GLM-4.5 de forma eficaz.

O que é a série GLM-4.5 e por que ela é importante?

O GLM-4.5 é um modelo de raciocínio híbrido que combina dois modos distintos: um "modo de raciocínio" para raciocínio complexo e uso de ferramentas, e um "modo não-pensante" para respostas imediatas. Essa abordagem de modo duplo permite que o modelo lide com uma ampla gama de tarefas com eficiência. A série inclui duas variantes principais:

- GLM-4.5:Com 355 bilhões de parâmetros totais e 32 bilhões de parâmetros ativos, este modelo foi projetado para implantação em larga escala em tarefas de raciocínio, geração e multiagentes.

- GLM-4.5-Ar: Uma versão leve com 106 bilhões de parâmetros totais e 12 bilhões de parâmetros ativos, otimizada para inferência no dispositivo e na nuvem em menor escala, sem sacrificar os recursos principais.

Ambos os modelos suportam modos de raciocínio híbridos, oferecendo modos de "pensamento" e "não pensamento" para equilibrar tarefas complexas de raciocínio e respostas rápidas. Eles são de código aberto e lançados sob a licença do MIT, tornando-os acessíveis para uso comercial e desenvolvimento secundário.

Princípios de Arquitetura e Design

Em sua essência, o GLM-4.5 utiliza o MoE para rotear tokens dinamicamente por meio de sub-redes especializadas, permitindo maior eficiência de parâmetros e comportamento de escala (). Essa abordagem significa que menos parâmetros precisam ser ativados por passagem de avanço, reduzindo os custos operacionais e mantendo o desempenho de ponta em tarefas de raciocínio e codificação ().

Principais características

- Raciocínio e codificação híbridos: O GLM-4.5 demonstra o desempenho SOTA em benchmarks de compreensão de linguagem natural e testes de geração de código, muitas vezes rivalizando com modelos proprietários em precisão e fluência.

- Integração Agénica: Interfaces de chamada de ferramentas integradas permitem que o GLM-4.5 orquestre fluxos de trabalho de várias etapas, como consultas de banco de dados, orquestração de API e geração de front-end interativo, em uma única sessão.

- Artefatos Multimodais:De miniaplicativos HTML/CSS a simulações baseadas em Python e SVGs interativos, o GLM-4.5 pode gerar artefatos totalmente funcionais, melhorando o envolvimento do usuário e a produtividade do desenvolvedor.

Por que o GLM-4.5 mudou o jogo?

O GLM-4.5 foi elogiado não apenas por seu desempenho bruto, mas também por redefinir a proposta de valor dos LLMs de código aberto em ambientes empresariais e de pesquisa.

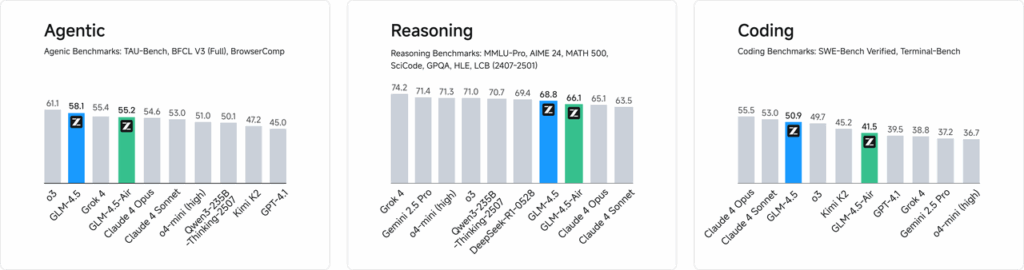

Benchmarks de desempenho

Em avaliações independentes de 52 tarefas de programação — abrangendo desenvolvimento web, análise de dados e automação — o GLM-4.5 superou consistentemente outros modelos de código aberto líderes em confiabilidade de chamada de ferramentas e conclusão geral de tarefas. Em testes comparativos com Claude Code, Kimi-K2 e Qwen3-Coder, o GLM-4.5 alcançou as melhores pontuações da categoria em benchmarks como o ranking "SWE-bench Verified".

Eficiência de custos

Além da precisão, o design MoE do GLM-4.5 reduz drasticamente os custos de inferência. Os preços públicos para chamadas de API começam em RMB 0.8 por milhão de tokens de entrada e RMB 2 por milhão de tokens de saída — aproximadamente um terço do custo de ofertas proprietárias comparáveis. Combinado com velocidades de pico de geração de 100 tokens/s, o modelo suporta implantações de alto rendimento e baixa latência sem custos proibitivos.

Como você pode acessar o GLM-4.5?

1. Acesso direto via plataforma Z.ai

O método mais simples para interagir com o GLM-4.5 é através da plataforma Z.ai. Ao visitar chat.z.aiOs usuários podem selecionar o modelo GLM-4.5 e começar a interagir por meio de uma interface amigável. Esta plataforma permite testes e prototipagem imediatos, sem a necessidade de integrações complexas. Os usuários podem selecionar o modelo GLM-4.5 ou GLM-4.5-Air no canto superior esquerdo e começar a conversar imediatamente. Esta interface é amigável e não requer configuração, tornando-a ideal para interações e demonstrações rápidas.

2. Acesso à API para desenvolvedores

Para desenvolvedores que buscam integrar o GLM-4.5 em aplicações, a plataforma Z.ai API oferece suporte abrangente. A API oferece interfaces compatíveis com OpenAI para os modelos GLM-4.5 e GLM-4.5-Air, facilitando a integração perfeita com fluxos de trabalho existentes. Documentação detalhada e diretrizes de integração estão disponíveis em Documentação da API Z.ai .

3. Implantação de código aberto

Para aqueles interessados em implantação local, os modelos GLM-4.5 estão disponíveis em plataformas como Hugging Face e ModelScope. Esses modelos são lançados sob a licença de código aberto do MIT, permitindo uso comercial e desenvolvimento secundário. Eles podem ser integrados a frameworks de inferência tradicionais, como vLLM e SGLang.

4. Integração com CometAPI

CometAPI oferece acesso simplificado aos modelos GLM-4.5 por meio de sua plataforma API unificada em DasboradEssa integração simplifica a autenticação, a limitação de taxas e o tratamento de erros, tornando-a uma excelente opção para desenvolvedores que buscam uma configuração descomplicada. Além disso, o formato de API padronizado da CometAPI permite fácil alternância de modelos e testes A/B entre o GLM-4.5 e outros modelos disponíveis.

Como os desenvolvedores podem acessar a série GLM-4.5?

Há vários canais para obter e implantar o GLM-4.5, desde downloads diretos de modelos até APIs gerenciadas.

Via Hugging Face e ModelScope

Tanto o Hugging Face quanto o ModelScope hospedam a série completa do GLM-4.5 sob o namespace zai-org. Após concordar com a licença do MIT, os desenvolvedores podem:

- Clonar o repositório:

git clone https://huggingface.co/zai-org/GLM-4.5

- Instalar dependências:

pip install transformers accelerate

- Carregar o modelo:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Através do CometAPI

CometAPI fornece uma API sem servidor para GLM‑4.5 e GLM-4.5 Air API com taxas de pagamento por token, acessíveis via, configurando endpoints compatíveis com OpenAI, você pode chamar GLM-4.5 através do cliente Python do OpenAI com ajustes mínimos nas bases de código existentes. O CometAPI não fornece apenas GLM4.5 e GLM-4.5-air, mas também todos os modelos oficiais:

| Nome do modelo | introduzir | Preço |

glm-4.5 | Nosso modelo de raciocínio mais poderoso, com 355 bilhões de parâmetros | Tokens de entrada $ 0.48 Tokens de saída $ 1.92 |

glm-4.5-air | Desempenho leve e robusto, com boa relação custo-benefício | Tokens de entrada $ 0.16 Tokens de saída $ 1.07 |

glm-4.5-x | Alto desempenho, raciocínio forte, resposta ultrarrápida | Tokens de entrada $ 1.60 Tokens de saída $ 6.40 |

glm-4.5-airx | Desempenho leve e forte, resposta ultrarrápida | Tokens de entrada $ 0.02 Tokens de saída $ 0.06 |

glm-4.5-flash | Desempenho forte, excelente para codificação de raciocínio e agentes | Tokens de entrada $ 3.20 Tokens de saída $ 12.80 |

Integração de Python e API REST

Para implantações personalizadas, as organizações podem hospedar o GLM-4.5 em clusters de GPU dedicados usando Docker ou Kubernetes. Uma configuração RESTful típica envolve:

Iniciando o servidor de inferência:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Envio de solicitações:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Quais são as melhores práticas para integrar o GLM-4.5 em aplicativos?

Para maximizar o ROI e garantir um desempenho robusto, as equipes devem considerar o seguinte:

Otimização de API e limites de taxa

- Solicitações em lote: Agrupe prompts semelhantes para reduzir a sobrecarga e aproveitar a taxa de transferência da GPU.

- Cache de consultas comuns: Armazene conclusões frequentes localmente para evitar chamadas de inferência redundantes.

- Amostragem Adaptativa: Ajuste dinamicamente

temperatureetop_pcom base na complexidade da consulta para equilibrar criatividade e determinismo.

Segurança e conformidade

- Sanitização de dados: Pré-processe entradas para remover informações confidenciais antes de enviá-las ao modelo.

- Controle de Acesso: Implemente chaves de API, listas de permissões de IP e limitação de taxas para evitar uso indevido e abuso.

- Registro de auditoria: Registre prompts, conclusões e metadados para conformidade com requisitos corporativos e regulatórios, especialmente em contextos financeiros ou de saúde.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Para desenvolvedores que buscam integrar o GLM-4.5 em seus aplicativos, a plataforma CometAPI oferece uma solução robusta. A API fornece interfaces compatíveis com OpenAI, permitindo integração perfeita com fluxos de trabalho existentes. Documentação detalhada e diretrizes de uso estão disponíveis no site. Página da API do Comet.

Os desenvolvedores podem acessar GLM‑4.5 e GLM-4.5 Air API através de CometAPI, as versões mais recentes dos modelos listados são as da data de publicação do artigo. Para começar, explore os recursos do modelo no Playground e consulte o Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Conclusão

O GLM-4.5 representa um avanço significativo na área de grandes modelos de linguagem, oferecendo uma solução versátil para uma ampla gama de aplicações. Sua arquitetura de raciocínio híbrido, recursos agênticos e natureza de código aberto o tornam uma opção atraente para desenvolvedores e organizações que buscam alavancar tecnologias avançadas de IA. Ao explorar os diversos métodos de acesso descritos neste guia, os usuários podem integrar o GLM-4.5 de forma eficaz em seus projetos e contribuir para seu desenvolvimento contínuo.