As notícias sobre o Gemini 3.0 têm sido o assunto mais comentado entre os desenvolvedores desde agosto, com constantes reportagens anunciando com confiança a data de lançamento, apenas para descobrirmos que ela não se concretizou. As esperanças foram frustradas repetidas vezes, mas a expectativa continua alta — porque o desempenho do Gemini 2.5 Pro já ficou para trás em relação aos seus concorrentes, Chatgpt e Claude. Agora trago a vocês as últimas notícias em primeira mão e tenho o prazer de anunciar que ele já está disponível em CometAPI.

A próxima geração do Gemini 3 do Google gerou mais burburinho devido a vazamentos do que a maioria dos lançamentos de produtos — pontos de verificação da comunidade aparecendo em sites públicos de benchmarking, nomes de modelos surgindo nas próprias ferramentas do Google e um caminho ativo para desenvolvedores testarem modelos por meio da CLI do Gemini e da API Comet.

O que é Gemini 3.0 — e por que é tão aguardado?

Em linhas gerais, Gemini 3.0 é o próxima grande iteração da família Gemini de grandes modelos de IA multimodais desenvolvidos pelo Google DeepMind (e sua controladora, Google LLC). A série Gemini se posiciona como a principal linha de modelos de IA do Google — criada não apenas para compreensão e geração de texto, mas também para tarefas multimodais (texto + imagem + código + áudio/vídeo), raciocínio, uso de ferramentas e, em última instância, comportamento mais proativo.

O motivo pelo qual as pessoas estão tão entusiasmadas com o Gemini 3.0 é que ele parece representar um grande salto em frente — não se trata apenas de uma pequena atualização — na capacidade do modelo, no comprimento do contexto, no raciocínio e na utilidade no mundo real. Vazamentos da comunidade, referências de código, sinais de benchmarking e artigos sugerem que o Gemini 3.0 irá explorar um novo território de "modelos pensantes", janelas de contexto mais longas, integração multimodal mais profunda e orquestração de ferramentas de agentes.

A seguir, explicarei exatamente o porquê. porque isso importa, o que sabemos até agora e o que ainda é especulativo.

O que são “lithiumflow” e “orionmist”, e por que apareceram no LMArena?

O que a LM Arena e a comunidade descobriram?

Entre 19 e 23 de outubro, investigadores da comunidade encontraram dois novos pontos de verificação no LM Arena, chamados lithiumflow e orionmist. Esses nomes parecem consistentes com as convenções de nomenclatura internas do Google (o nome da família "orion" já foi usado em codinomes Gemini anteriores), e os analistas da comunidade os interpretam como identificadores iniciais ou pontos de verificação para variantes do Gemini 3.x — coloquialmente relatados como pontos de verificação do Gemini 3 Pro/Flash.

Por que isso Importa?

Se o lithiumflow e o orionmist forem de fato pontos de verificação do Gemini 3, a divisão sugere que o Google pode estar preparando múltiplas subfamílias (Flash e Pro): por exemplo, uma variante do "lithiumflow" otimizada para taxa de transferência e eficiência, e uma variante do "orionmist" ajustada para recuperação de dados atualizados ou recursos multimodais. O lithiumflow parece (segundo especulações da comunidade) ser o modelo de geração base ajustado para raciocínio/geração (sem ancoragem de busca). O orionmist parece ser uma variante com integração a dados externos/busca em tempo real, possivelmente mais forte em geração aprimorada por recuperação ou tarefas "ao vivo".

Meu teste

O show de check-ins da LM Arena muito forte Os resultados do lithiumflow em tarefas clássicas de linguagem (raciocínio, código e algumas tarefas de SVG/layout) são impressionantes. Vários analistas da comunidade também publicaram comparações lado a lado, afirmando que o lithiumflow supera o Gemini 2.x e outros softwares similares em microbenchmarks específicos.

O uso do Lithiumflow para escrita resulta em maior criatividade e qualidade literária do que o Gemini 2.5, mas a contagem de palavras continua sendo um ponto fraco, limitando-se a apenas duas ou três mil palavras. Combinado com o OrionMist, ele pode rivalizar com o Claude 4.5 em desempenho e precisão de codificação, mas a diferença não é significativa.

Veja como esses modelos se comparam nos testes de desempenho realizados até o momento:

| referência | Gemini 3.0 (fluxo de lítio) | Gemini 3.0 (orionmist) | Gêmeos 2.5 Pró | Claude Opus 4.1 | Soneto de Cláudio 3.7 |

|---|---|---|---|---|---|

| Banco Simples | 80-100% | 80-100% | 62.4% | 60.0% | 46.4% |

Ambos os modelos ainda apresentavam ilusões e instabilidades em certas tarefas de conhecimento — o que é compreensível para uma versão preliminar. Esse padrão (excelência em tarefas criativas e geração de excelente estrutura/código, mas ocasionalmente apresentando erros factuais) é comum quando os modelos são combinados com novas capacidades multimodais ou de geração de código.

Os testes desses dois modelos foram concluídos na LM Arena, confirmando ainda mais que se tratam, de fato, do Gemini 3.0.

Envolvimento da Apple e especificações vazadas

Diferenças de modelo

Em mid-2025, Apple Trechos de código supostamente vazados em uma versão beta do iOS mostram identificadores como com.google.gemini_3_pro e gemini_3_ultra.

Analistas inferiram que o Google e a Apple estavam se preparando. Integrações com tecnologia Gemini e "Apple Intelligence", provavelmente para a Siri e para o resumo no dispositivo:

- Gemini 3 Pro (camada de raciocínio baseada em nuvem)

- Gemini 3 Nano (variante integrada ao dispositivo)

- Inferência multimodal em tempo real

Isso está alinhado com o esforço do Google para alcançar um Tecido de IA Conectando dispositivos móveis, APIs na nuvem e o ecossistema da web.

Vazamento de especificações

Apple e Google negociam uma integração mais profunda do Gemini para a Apple Intelligence/Siri — um furo de reportagem descreve os planos da Apple de usar uma variante personalizada do Gemini em sua plataforma de IA. Apple e Google mencionaram o parâmetro de 1.2 TB em seu plano colaborativo para modelos de inteligência artificial, que pode ser a especificação do Gemini 3.0.

Como começar a usar a versão de pré-visualização do Gemini 3 Pro

Com base nas informações disponíveis e nos testes realizados, apresentarei três métodos: Vertex, Gemini CLI e API. Os desenvolvedores podem escolher o método que melhor se adapta às suas necessidades e ambiente. Os nomes dos modelos Gemini 3.0 Pro são gemini-3-pro-preview-11-2025 e gemini-3-pro-preview-11-2025-thinking.

Vértice cruzado

Gemini 3.0 pro (gemini-3-pro-preview-11-2025) O modelo foi adicionado à lista de modelos da Vertex, e alguns usuários da comunidade afirmam que podem testá-lo diretamente, desde que possuam uma conta paga da Vertex e consigam acessá-lo usando suas credenciais. De fato, os rastreamentos podem ser encontrados nos logs de rede da Vertex:

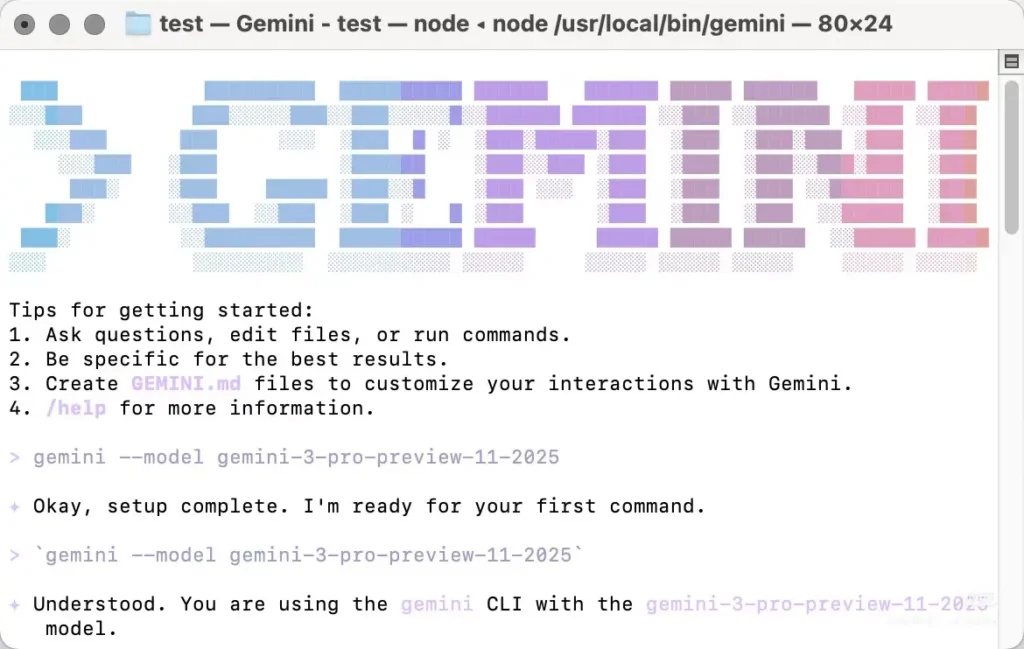

Accoss Gemini cli

O Gemini 3.0 Pro também pode ser chamado através da CLI do Gemini, mas o modelo precisa ser especificado manualmente ao utilizá-lo. A maioria das avaliações mais recentes do Gemini 3.0 Pro são referentes ao uso da CLI do Gemini. No entanto, ela apresenta algumas desvantagens: funciona apenas com alguns nós da América do Norte, exigindo que você altere manualmente seu endereço IP local para testar, e pode ser necessário tentar várias vezes. Além disso, não é muito estável e retorna um erro 404 quando a conexão falha.

Você precisa Instale a CLI do Gemini localmenteEm seguida, autentique-se com uma conta que tenha permissões de acesso (conta do Google / conta CometAPI) e especifique manualmente o nome do modelo “gemini-3-pro-preview-11-2025Para usar o Gemini 3.0 pro-preview, por exemplo: instale e execute (no shell).

```bash

# instant run (no install)

npx https://github.com/google-gemini/gemini-cli

or install globally:

npm install -g @google/gemini-cli

# or on macOS/Linux using Homebrew

brew install gemini-cli

A CLI aceita identificadores de modelo da mesma forma que a API. Na prática: defina o identificador do seu modelo (por exemplo, `model: "gemini-3-pro-preview-11-2025"`) em uma solicitação ou configuração da CLI e invocá-la — se sua conta tiver acesso, a solicitação será bem-sucedida.

### A API da CometAPI

[CometAPI](https://www.cometapi.com/pt/) É uma plataforma de API unificada que agrega mais de 500 modelos de IA de fornecedores líderes — como a série GPT da OpenAI, o Gemini do Google, o Claude da Anthropic, o Midjourney, o Suno e muitos outros — em uma única interface amigável para desenvolvedores. Oferece autenticação consistente, formatação de requisições e tratamento de respostas.

A CometAPI integrou o [API de visualização do Gemini 3 Pro](https://www.cometapi.com/pt/gemini-3-pro-api/) e o nome da chamada da API interna é `gemini-3-pro-preview`Ao fazer a chamada, você só precisa alterar o endereço da solicitação para `https://api.cometapi.com/v1/chat/completions`.

Você pode chamar a versão de pré-visualização do Gemini 3.0 Pro da mesma forma que chama a API da OpenAI. Nos meus testes, a chamada via CometAPI se mostrou mais estável do que usar a CLI do Gemini.

## Quais são as características previstas para o Gemini 3.0?

Abaixo estão as funcionalidades mais discutidas (indicando explicitamente quais itens foram confirmados e quais correspondem às expectativas da comunidade/analistas).

### Projeto e arquitetura principais (confirmados vs. esperados)

- **Fundamento multimodal:** O Gemini foi desenvolvido como uma família multimodal (texto, imagens, código, áudio/vídeo), e o Google já publicou modelos e ferramentas multimodais na API do Gemini. Isso está confirmado e continuará sendo fundamental.

- **Raciocínio avançado / planejamento:** Espere uma integração mais profunda das técnicas de planejamento e aprendizado por reforço, baseadas na pesquisa da DeepMind — uma provável diferença na ênfase do design em comparação com alguns concorrentes. Essa expectativa se fundamenta na história da DeepMind, e não em uma especificação pública.

### Janela de contexto e memória

Janelas de contexto mais longas: o Gemini 3.0 aumentará a capacidade efetiva de contexto (especula-se em milhões de tokens), com base em trabalhos anteriores de contexto amplo. Esta é uma previsão — o Google ainda não publicou os limites oficiais de tokens do Gemini 3.0.

### Desempenho, latência e variantes do modelo

- **Alta precisão de raciocínio e codificação:** Postagens da comunidade no LM Arena para “lithiumflow” (e “orionmist”) sugerem um bom desempenho em tarefas de raciocínio e código. Esses são benchmarks da comunidade não verificados, mas são o principal motivo de entusiasmo. Considere-os como sinais iniciais, não como prova definitiva.

- **Múltiplas variantes:** Rumores e vazamentos apontam para diferentes versões — uma variante de geração bruta/“Pro” (frequentemente associada em postagens com a tag lithiumflow) e uma variante com aterramento/habilitada para busca (orionmist). Novamente, essas são inferências da comunidade a partir de IDs de modelo e comportamento em testes.

### Multimodalidade e novas capacidades

- **Integração de vídeo e imagem:** O Google recentemente expôs modelos de vídeo (como o Veo 3) e recursos de imagem na API Gemini; espera-se que o Gemini 3.0 aproveite e unifique esses recursos para fluxos de trabalho multimodais mais robustos. Isso é corroborado por versões anteriores do Google no ecossistema Gemini.

- **Funcionalidades no dispositivo e de privacidade (objetivo):**A expectativa é de opções mais eficientes, tanto no dispositivo quanto na nuvem privada, para dados sensíveis, visto que o Google e seus parceiros priorizam a privacidade e a menor latência. Essa previsão se baseia em tendências do ecossistema; detalhes específicos do Gemini 3.0 ainda não foram divulgados.

## Ponto final

A versão pro-preview do Gemini 3.0 é amplamente esperada como um divisor de águas para os modelos multimodais e focados em raciocínio do Google, oferecendo potencialmente um contexto mais amplo, planejamento mais robusto e recursos multimodais mais avançados. A empolgação atual é uma mistura de **Ferramentas de desenvolvimento confirmadas e sinais de produtos do Google** (API Gemini, CLI, modelos Veo/vídeo) e **sinais comunitários não oficiais, mas ruidosos** (Entradas do LM Arena para lithiumflow/orionmist, vazamentos e cronogramas de rumores de analistas). Considere os benchmarks da comunidade como indicadores iniciais e prepare-se aprendendo as ferramentas de desenvolvedor do Gemini para que você possa avaliar o modelo objetivamente quando o Google liberar o acesso oficial.

Especula-se que a data de lançamento oficial mais provável seja 18 de novembro, coincidindo com o plano de migração de modelos do Google para o dia 18. Aguardemos mais informações sobre a prévia do Gemini 3 Pro!

### Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Os desenvolvedores podem acessar a versão de pré-visualização do Gemini 3.0 Pro através da CometAPI. [a versão mais recente do modelo](https://api.cometapi.com/pricing) está sempre atualizado com o site oficial. Para começar, explore as capacidades do modelo no [Playground](https://www.cometapi.com/console/playground) e consulte o [Guia de API](https://api.cometapi.com/doc) para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. [CometAPI](https://www.cometapi.com/pt/) oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Pronto para ir?→ [Inscreva-se no CometAPI hoje mesmo](https://api.cometapi.com/login) !

Se você quiser saber mais dicas, guias e novidades sobre IA, siga-nos em [VK](https://vk.com/id1078176061), [X](https://x.com/cometapi2025) e [Discord](https://discord.com/invite/HMpuV6FCrG)!