O Google anunciou o Gemini 3 Flash em 17–18 de dezembro de 2025 como um membro de baixa latência e custo eficiente da família Gemini 3. Ele traz raciocínio em nível Pro para um footprint de classe Flash, oferece suporte a entradas multimodais extensas (texto, imagem, áudio, vídeo), introduz controles de thinking_level e resolução de mídia, e está disponível via Google AI Studio, a Gemini API (REST / SDKs), Vertex AI, Gemini CLI e como o modelo padrão no Google Search / aplicativo Gemini.

O que é o Gemini 3 Flash e por que isso importa

O Gemini 3 Flash faz parte dos modelos da série 3 do Google. Ele foi projetado para empurrar a fronteira de Pareto de qualidade vs. custo vs. latência: entregando grande parte da capacidade de raciocínio do Gemini 3 Pro enquanto é significativamente mais rápido e barato de operar. Essa combinação o torna adequado para cenários interativos de alta frequência (chatbots, assistentes em IDEs, fluxos agentivos em tempo real), geração de conteúdo em massa onde a latência importa e aplicações que precisam de raciocínio multimodal (imagens + texto + áudio) com baixo overhead.

Pontos-chave em alto nível:

- Ele é explicitamente otimizado para velocidade + baixo custo, mantendo raciocínio sólido e fidelidade multimodal (três vezes mais rápido que o antigo Gemini 2.5 Pro; mantém as capacidades de inferência de topo do Gemini 3).

- É posicionado como o “sweet spot” para loops baseados em agentes e fluxos de trabalho iterativos de desenvolvedores (por exemplo, assistência a código, agentes multi-turn).

- Flexível: ele pode “ajustar seu tempo de pensamento” conforme a complexidade do problema — respondendo perguntas simples instantaneamente e considerando mais etapas para tarefas complexas.

Desempenho técnico e resultados de benchmarks

O Gemini 3 Flash alcança um triplo avanço em velocidade, inteligência e custo:

1) Loops baseados em agentes e compreensão multimodal

O Gemini 3 Flash herda melhorias de arquitetura e treinamento da família mais ampla Gemini 3, produzindo forte competência multimodal (entradas de texto, imagem, vídeo, áudio) e raciocínio aprimorado em comparação com modelos Flash anteriores. O Google posiciona o Flash como capaz de lidar com tarefas como análise de documentos (OCR + raciocínio), sumarização de vídeo, perguntas e respostas de imagem + texto e tarefas de codificação multimodal. Essa capacidade multimodal, combinada com baixa latência, é um dos principais pontos técnicos de venda do modelo.

O Google publicou alegações internas de benchmark destacando forte desempenho em codificação com agentes (SWE-bench Verified ~78% para fluxos de codificação baseados em agentes) e o Flash se aproxima do raciocínio em nível Pro em muitas tarefas, permanecendo rápido o suficiente para loops de agentes e fluxos quase em tempo real.

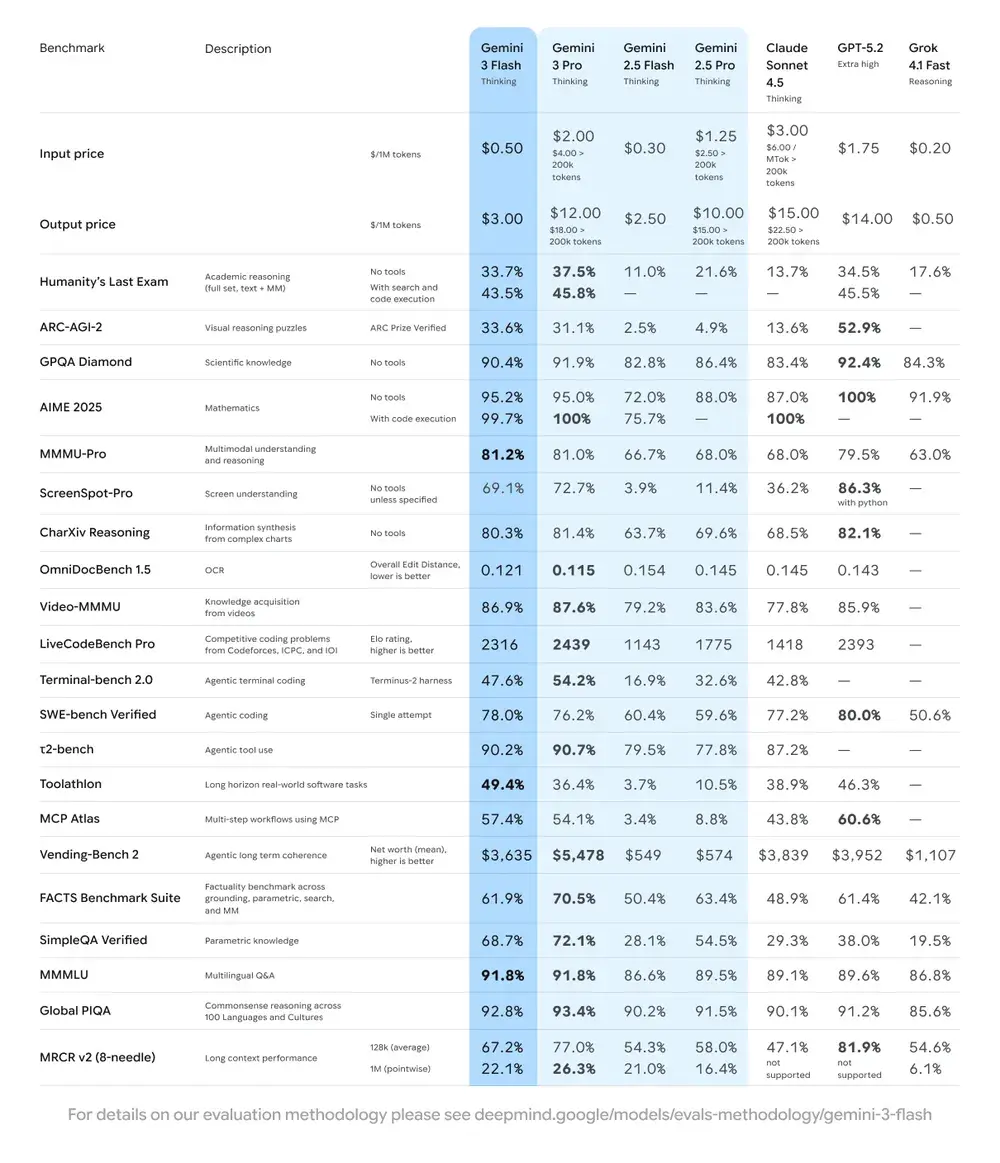

| Benchmark | Pontuação do Gemini 3 Flash | Modelo de comparação | Melhoria |

|---|---|---|---|

| GPQA Diamond (raciocínio em nível de PhD) | 90,4% | Supera o Gemini 2.5 Pro | Significativa |

| Humanity’s Last Exam (teste de conhecimento geral) | 33,7% (sem ferramentas) | Próximo ao Gemini 3 Pro | Raciocínio avançado |

| MMMU Pro (compreensão multimodal) | 81,2% | No mesmo nível do Gemini 3 Pro | — |

| SWE-bench Verified (benchmark de capacidade de codificação) | 78% | Maior que o Gemini 3 Pro e a série 2.5 | Excelente |

2) Custo e eficiência

A filosofia de desenvolvimento do Gemini 3 Flash é “Fronteira de Pareto”: isto é, encontrar o equilíbrio ideal entre velocidade, qualidade e custo. O Gemini 3 Flash é explicitamente otimizado para preço-desempenho. O Google lista preços do Flash significativamente abaixo do Pro para tarefas comparáveis e o posiciona para processar grandes volumes de requisições com menor custo operacional. Para muitas cargas de trabalho, a variante Flash é pensada como o padrão com melhor custo-benefício — por exemplo, preços de preview do Flash em aproximadamente $0.50 por 1M tokens de entrada e $3.00 por 1M tokens de saída para o nível de preview do Flash. Na prática, isso o torna viável para tarefas de alta frequência em que a cobrança por token mais alta do Pro seria proibitiva.

Eficiência

- Velocidade: 3x mais rápido que o Gemini 2.5 Pro (com base em testes da Artificial Analysis).

- Eficiência de tokens: usa em média 30% menos tokens para concluir a mesma tarefa. Em outras palavras, você obtém resultados mais rápidos e melhores pelo mesmo valor.

- O Gemini 3 Flash inclui o "Dynamic Thinking Mode" — adaptando a profundidade do raciocínio à complexidade da tarefa, “pensando um pouco mais” quando necessário e respondendo rapidamente a tarefas simples.

Implicações práticas: menor custo por token ou por chamada significa que você pode executar mais consultas, contextos mais longos ou taxas de amostragem superiores com o mesmo orçamento. Ganhos de eficiência também podem reduzir a complexidade da infraestrutura (menos instâncias ativas necessárias) e melhorar garantias de tempo de resposta.

3) Benchmark de desempenho

O Gemini 3 Flash atinge desempenho de “classe de fronteira” em diversos benchmarks acadêmicos e de aplicação, ao mesmo tempo em que oferece melhor latência e custo do que modelos Pro anteriores. O Google apresenta números como pontuações altas em benchmarks de raciocínio e conhecimento complexos (por exemplo, variantes do GPQA) para ilustrar sua competência.

Como usar a API do Gemini 3 Flash?

Qual método de acesso devo usar?

- Recomendado (simples + robusto): use o padrão de integração do SDK mostrado pela Comet — ele apenas aponta um SDK GenAI existente para a base URL da Comet e fornece sua chave de API da Comet. Isso evita ter que replicar você mesmo a análise de requisições/streams.

- Alternativo (HTTP bruto / curl / stacks customizadas): você pode fazer POST diretamente para os endpoints do CometAPI (a Comet aceita formatos estilo OpenAI ou específicos do provedor). Use

Authorization: Bearer <sk-...>(os exemplos da Comet usam um cabeçalho Bearer) e a string de modelogemini-3-flashno corpo. Confirme o caminho exato e parâmetros de query na documentação da Comet para o modelo desejado.

Resumo rápido — o que você fará

- Cadastre-se no CometAPI e crie um token de API.

- Escolha um método de acesso (recomendado: padrão com wrapper do SDK mostrado abaixo; fallback: HTTP/cURL bruto).

- Chame o modelo

gemini-3-flashvia a base URL do CometAPI (a Comet encaminha sua requisição para o backend do Gemini do Google). - Trate streaming / function-calls / entradas multimodais conforme os requisitos do modelo (detalhes abaixo).

Abaixo está um exemplo compacto (com base nos padrões de amostra do CometAPI) mostrando como chamar gemini-3-flash via CometAPI; substitua <YOUR_COMETAPI_KEY> por sua chave real. O ID do modelo e os endpoints abaixo correspondem à documentação do CometAPI.

from google import genaiimport os# Get your CometAPI key from https://api.cometapi.com/console/token, and paste it hereCOMETAPI_KEY = os.environ.get("COMETAPI_KEY") or "<YOUR_COMETAPI_KEY>"BASE_URL = "https://api.cometapi.com"client = genai.Client( http_options={"api_version": "v1beta", "base_url": BASE_URL}, api_key=COMETAPI_KEY,)response = client.models.generate_content( model="gemini-3-flash", contents="Explain how AI works in a few words",)print(response.text)

Principais parâmetros de requisição a considerar

thinking_level— controla a profundidade do raciocínio interno:MINIMAL,LOW,MEDIUM,HIGH. UseMINIMALpara menor latência e custo quando você não precisa de raciocínio profundo em várias etapas.media_resolution— para entradas de visão/vídeo:low,medium,high,ultra_high. Resoluções menores reduzem a equivalência de tokens e a latência.streamGenerateContentvsgenerateContent— use streaming para melhor latência percebida quando quiser respostas parciais conforme chegam.- Function calling / JSON Mode — use respostas estruturadas quando precisar de saídas legíveis por máquina.

Envio de entradas multimodais (dicas práticas)

- Imagens/PDFs: prefira URIs do Cloud Storage (gs://) para mídias grandes; muitas APIs aceitam base64 para imagens pequenas. Observe a contabilização de tokens por modalidade — PDFs podem ser contabilizados sob cotas de imagem/documento dependendo do endpoint.

- Vídeo/áudio: para clipes curtos, você pode passar URIs; para mídias longas, use fluxos de processamento em lote ou envie em chunks. Verifique tamanhos máximos de entrada e restrições de codificação na documentação da API.

- Function calling / tools: use esquemas de função estruturados para obter saídas em JSON e permitir invocação segura de ferramentas. O Gemini 3 Flash suporta function calling com streaming para melhor UX.

Onde posso acessar o Gemini 3 Flash?

O Gemini 3 Flash está disponível nas superfícies de consumidor e de desenvolvedor do Google:

- Google Search e o aplicativo Gemini — o Flash foi lançado como o modelo padrão para o Modo de IA na Busca e está integrado à experiência do aplicativo Gemini para usuários finais.

- Google AI Studio — lugar imediato para desenvolvedores experimentarem e gerarem chaves de API para testes.

- Gemini API (Generative Language / AI Developer API) — disponível como

gemini-3-flash-preview(ID de modelo usado na documentação/notas de lançamento) e por meio dos endpoints padrão generateContent / streamGenerateContent. - Vertex AI (Google Cloud) — acesso em nível de produção por meio das APIs de modelos de IA Generativa do Vertex AI e preços/cotas adequados a workloads corporativos.

- Gemini CLI — para desenvolvimento em terminal e fluxos de scripting.

Gateway de terceiros CometAPI

CometAPI já adicionou gemini-3-flash ao seu catálogo, e a página do modelo explica como chamá-lo pelo endpoint unificado da CometAPI. A API de modelo fornecida é precificada em 20% do preço oficial.

Quais são as melhores práticas ao usar o Gemini 3 Flash?

1) Escolha thinking_level por tarefa e ajuste

- Defina

MINIMAL/LOWpara perguntas e respostas simples e tarefas interativas de alta frequência. - Use

MEDIUM/HIGHde forma seletiva para tarefas que exigem cadeias de raciocínio mais profundas ou planejamento em várias etapas. - Faça benchmark de custo vs. qualidade quando você mudar o

thinking_level. A documentação do Google alerta quethinking_levelaltera assinaturas internas de pensamento e a latência.

2) Use media_resolution para controlar o processamento de visão

Se você enviar imagens ou vídeo, escolha a media_resolution mais baixa aceitável para a tarefa; por exemplo, use low para miniaturas e extração em massa, high para crítica de design visual. Isso reduz a equivalência de tokens para imagens e diminui a latência.

3) Prefira saídas estruturadas para automação

Use Modo JSON / function calling quando sua aplicação precisar de saídas legíveis por máquina (por exemplo, extração de entidades, invocação de ferramentas). Isso simplifica drasticamente o processamento downstream. Faça cumprir esquemas JSON estritos quando possível e valide no cliente.

4) Use amplamente streaming para respostas longas

streamGenerateContent reduz a latência percebida e permite renderização progressiva na UI. Para tarefas multimodais longas, faça streaming de saídas parciais para que os usuários vejam progresso imediato.

5) Controle custos com cache e gestão de contexto

- Use cache de contexto para referências repetidas (preços e tokens variam entre modelos).

- Evite enviar contextos longos desnecessariamente — prefira prompts concisos e use recuperação + grounding para grandes bases de conhecimento.

Cenários típicos de uso do Gemini 3 Flash

Agentes conversacionais de alto volume

O Flash é uma opção natural para chatbots e assistentes de suporte ao cliente que exigem baixa latência e baixo custo por inferência. Com suporte a streaming e alta taxa de tokens/s, o Flash reduz o tempo de espera percebido e os custos operacionais.

Assistentes multimodais e pipelines de documentos

Como o Flash lida bem com imagens, PDFs e vídeos curtos, aplicações comuns incluem extração de notas fiscais, perguntas e respostas multimodais sobre manuais, suporte ao cliente com imagens e ingestão de PDFs para bases de conhecimento.

Análise e moderação de vídeo em tempo real

Alta velocidade de saída relatada (≈218 t/s em testes de pré-lançamento) possibilita análise e sumarização quase em tempo real de vídeos curtos, detecção de destaques e pipelines de moderação de conteúdo ao vivo quando bem arquitetados.

Ferramentas de desenvolvedor baseadas em agentes e assistência a código

As pontuações no SWE-bench e o desempenho de codificação relatado tornam o Flash uma boa opção para assistentes de codificação rápidos, helpers de CLI e outros fluxos de trabalho de desenvolvedor que priorizam baixa latência.

Conclusão — você deve adotar o Gemini 3 Flash agora?

O Gemini 3 Flash é uma oferta estratégica para equipes que precisam de raciocínio robusto e inteligência multimodal sem a latência e o custo dos modelos Pro topo de linha. O modelo é especialmente adequado para assistentes de codificação baseados em agentes, agentes multimodais interativos, pipelines de processamento de documentos e qualquer sistema em que baixa latência e escala sejam prioridades. Benchmarks iniciais (tanto do Google quanto de análises independentes) indicam que o Flash é competitivo em qualidade, oferecendo vantagens substanciais de throughput e custo.

Para começar, explore os recursos do Gemini 3 Flash no Playground e consulte o guia da API para instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave de API. A CometAPI oferece um preço muito inferior ao oficial para ajudar na integração.

Pronto para começar? → Teste gratuito do Gemini 3 Flash !