O espaço de ferramentas de IA visual de baixo código está evoluindo rapidamente. O Flowise — um construtor visual de código aberto para fluxos de trabalho de LLM — continua a adicionar integrações à comunidade e a lançar atualizações frequentes; o CometAPI é um dos vários API de IA unificada Plataformas que agora expõem centenas de modelos por meio de um único endpoint; e construtores de backend sem código, como o BuildShip, também fornecem nós para chamar o CometAPI, permitindo que você conecte os mesmos modelos aos fluxos de trabalho do servidor. Este guia mostra por que e quando combinar essas partes e, em seguida, orienta você em uma integração concreta Flowise → CometAPI, como conectar Prompt → LLM Chain → CometAPI, práticas recomendadas e exemplos de casos de uso.

O que é FlowiseAI e por que isso é importante?

FlowiseAI é uma plataforma visual de código aberto para a criação de fluxos de trabalho de LLM, assistentes de bate-papo e pipelines de agentes. Ela oferece uma tela de arrastar e soltar composta por nós (integrações) que representam prompts, cadeias, conectores de LLM, recuperadores, memória, ferramentas e saídas — permitindo que as equipes criem protótipos e enviem sistemas baseados em LLM sem precisar conectar tudo manualmente. O Flowise também expõe APIs, rastreamento, ferramentas de avaliação e nós mantidos pela comunidade, sendo útil tanto para prototipagem rápida quanto para experimentação em produção.

Por que isso é importante: Ao usar o Flowise, você obtém observabilidade visual e iteração rápida em cadeias de prompts e escolhas de modelos — e, ao adicionar conectores de terceiros (como CometAPI), você pode alternar ou experimentar muitos modelos subjacentes com alterações mínimas.

O que é CometAPI e o que ele fornece?

CometAPI é uma camada de API unificada que agrega acesso a centenas de modelos de IA (OpenAI, Anthropic/Claude, Google/Gemini, modelos Replicate, provedores de imagem e áudio, etc.) por trás de um formato de solicitação e esquema de autenticação únicos e consistentes. Isso significa que você pode escolher ou trocar modelos, comparar custo/latência ou recorrer a provedores programaticamente sem precisar reescrever o código do seu aplicativo. A plataforma se posiciona como uma camada de acesso independente de fornecedor e gerenciamento de custos para LLMs e modelos multimodais.

O que isso lhe traz na prática: gerenciamento de credenciais mais simples para avaliação de vários modelos, capacidade de comparar diferentes modelos A/B rapidamente e (frequentemente) otimização de custos selecionando variantes de modelo mais baratas quando apropriado.

Por que você integraria o FlowiseAI com o CometAPI?

A integração do Flowise com o CometAPI oferece a conveniência do construtor visual do Flowise, além de acesso centralizado a diversos backends de modelos via CometAPI. Os benefícios incluem:

- Gerenciamento de credenciais únicas para vários endpoints de modelo (por meio do CometAPI).

- Modelo fácil A/Bing e roteamento em nível de provedor dentro de uma cadeia visual (troque de modelos sem alterar a fiação do nó).

- Experimentação mais rápida: troque modelos, ajuste prompts e compare saídas dentro dos fluxos do Flowise.

- Redução do atrito de engenharia para equipes que desejam uma camada de orquestração visual, mas precisam de vários provedores de modelos nos bastidores.

- Por que você integraria o FlowiseAI com o CometAPI?

- A integração do Flowise com o CometAPI oferece a conveniência do construtor visual do Flowise, além de acesso centralizado a diversos backends de modelos via CometAPI. Os benefícios incluem:

- Gerenciamento de credenciais únicas para vários endpoints de modelo (por meio do CometAPI).

- Modelo fácil A/Bing e roteamento em nível de provedor dentro de uma cadeia visual (troque de modelos sem alterar a fiação do nó).

- Experimentação mais rápida: troque modelos, ajuste prompts e compare saídas dentro dos fluxos do Flowise.

- Redução do atrito de engenharia para equipes que desejam uma camada de orquestração visual, mas precisam de vários provedores de modelos nos bastidores.

- Esses recursos aceleram as configurações do RAG, a orquestração de agentes e os fluxos de trabalho de composição de modelos, mantendo a procedência visual e a rastreabilidade fornecidas pelo Flowise.

Esses recursos aceleram as configurações do RAG, a orquestração do agente e os fluxos de trabalho de composição do modelo, mantendo a proveniência visual e rastreabilidade que a Flowise fornece.

Que ambiente e pré-condições você precisa antes da integração?

Lista de verificação (mínimo):

- Faça o login no Flowise AI

- A CometAPI conta + chave de API (você recuperará isso do Console CometAPI). Observação: o CometAPI usa um caminho base (por exemplo,

https://api.cometapi.com/v1/) para solicitações — você fornecerá isso nas configurações do nó Flowise.

Preparativos de segurança e operacionais:

- Armazene chaves de API em Credenciais Flowise — não coloque chaves em modelos de prompt ou código de nó.

- Planeje limites de cota e taxa: tanto a CometAPI quanto os fornecedores do modelo subjacente podem impor limites — verifique seu plano e aplique limitação do lado do cliente ou novas tentativas, se necessário.

- Observe o custo: ao alternar modelos, você pode alterar materialmente o uso do token e os custos — instrumentar métricas e definir barreiras.

Como integro o CometAPI com o FlowiseAI? (Encontre e adicione o nó CometAPI — quais são as etapas?)

Siga estas etapas práticas para adicionar o ChatCometAPI nó e configurar credenciais.

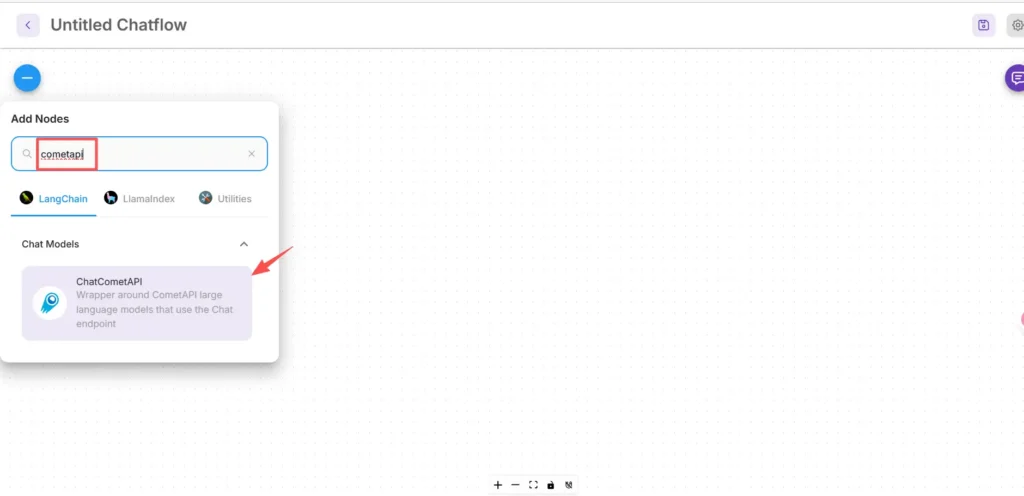

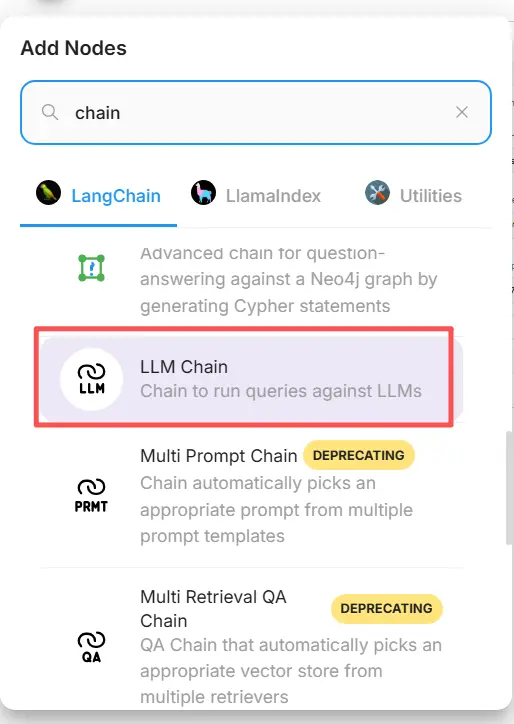

Etapa 1 — Confirme se o nó está disponível

- Na tela FlowiseAI, clique em Adicionar novo.

- Na caixa de pesquisa, digite e pesquise por “cometapi” para encontrar a caixa CometAPI. Alguns nós da comunidade aparecem em LangChain → Modelos de Chat.

Etapa 2 — Adicione o nó CometAPI ao seu fluxo

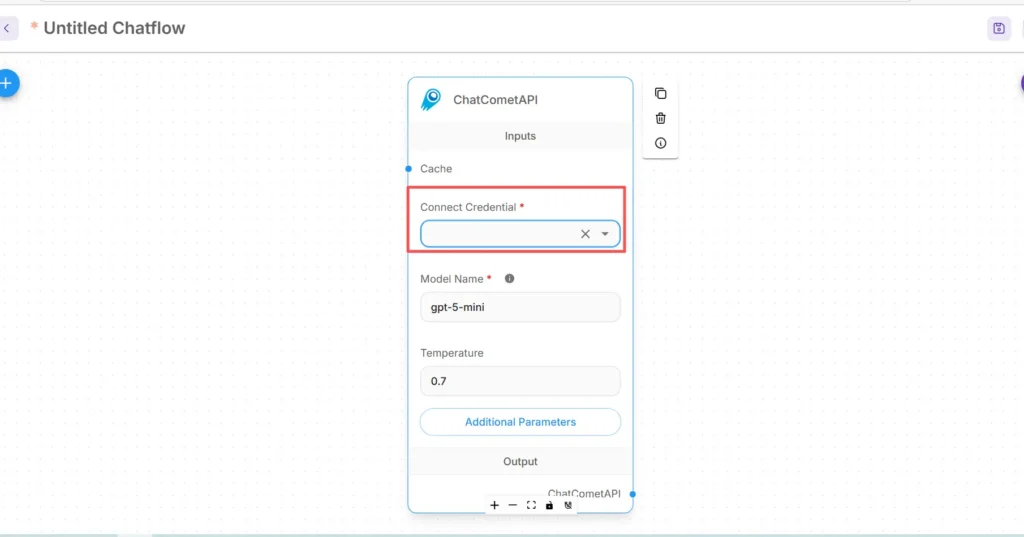

- Arraste o ChatCometAPI nó no seu espaço de trabalho. O nó expõe a seleção do modelo, temperatura, tokens máximos e outros parâmetros de inferência.

- Colocar um Início/Entrada nó (ou seu nó de front-end do chatbot) a montante do nó CometAPI.

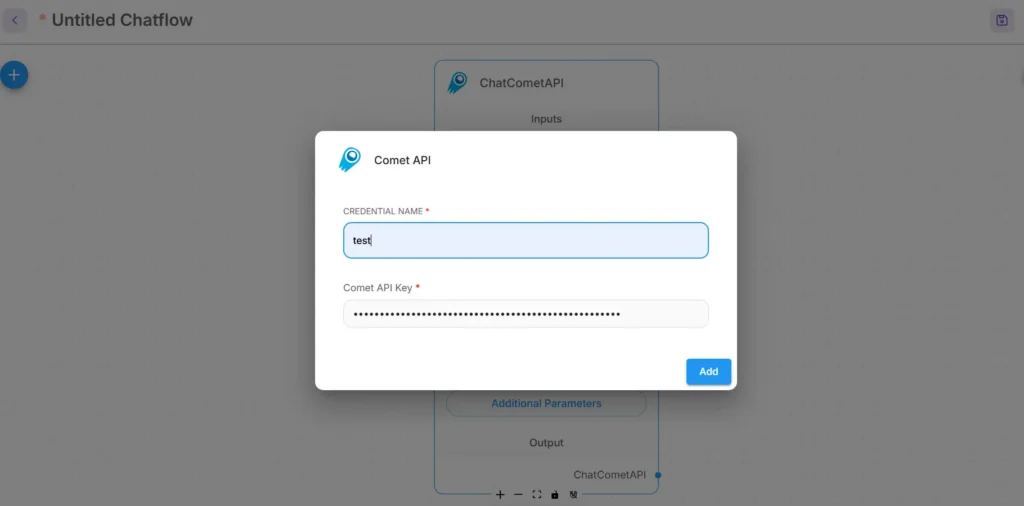

Etapa 3 — Configurar credenciais para CometAPI

- No menu suspenso Conectar credencial do nó CometAPI, selecione Criar novo e encontre o Chave API / Credenciais campo.(Em Flowise, ou aberto Credenciais)

- Digite seu Chave API CometAPI (de preferência por meio do gerenciador de credenciais do Flowise ou como uma variável de ambiente). Em produção, use o gerenciamento de segredos

- Escolha o modelo subjacente padrão (ou deixe-o ajustável a partir das entradas do nó, se desejar alternar o modelo em tempo de execução). A CometAPI normalmente aceita um

modelparâmetro que indica qual fornecedor/modelo usar.

Etapa 4 — Defina o caminho base e parâmetros adicionais.

Nas configurações do nó ChatCometAPI, expanda Parâmetros adicionais e definir o Caminho Base para https://api.cometapi.com/v1/ (isso é necessário para que o nó aponte para o gateway v1 do CometAPI). Opcionalmente, ajuste o nome do modelo padrão ou os parâmetros do provedor suportados pelo CometAPI.

Dicas de soluções de problemas:

- Se as chamadas falharem, verifique a saída da rede e quaisquer regras de firewall/NAT entre os pontos de extremidade do Flowise e do CometAPI.

- Verifique os limites de taxa e as respostas de erro retornadas pelo CometAPI; implemente o backoff exponencial em 429/5xx.

Como adiciono um nó Prompt e configuro a cadeia LLM no Flowise?

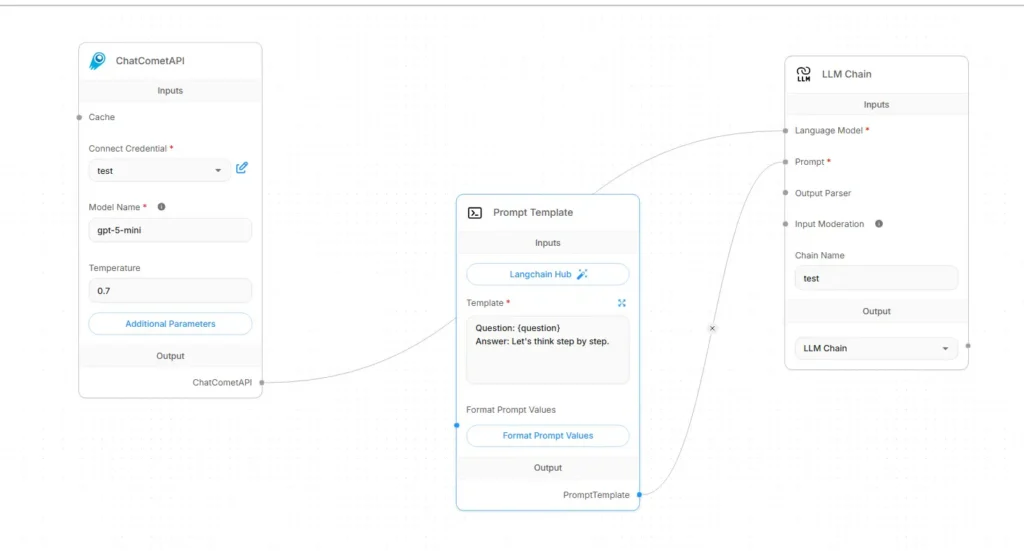

Os fluxos LLM do Flowise são normalmente montados como Entrada → Modelo de Prompt → Cadeia LLM → Saída. Aqui está uma receita de fiação concreta usando CometAPI como modelo de linguagem:

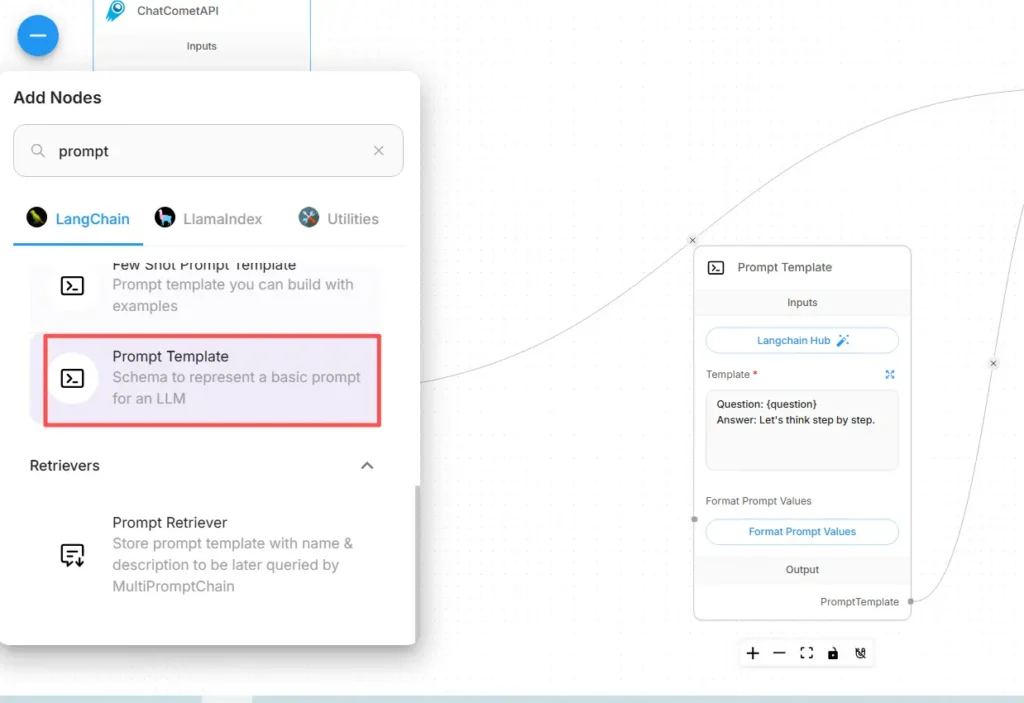

Etapa A — Criar um nó de modelo de prompt

- Adicionar uma Modelo de solicitação nó (ou nó “Prompt”) para a tela.

- No nó Prompt, crie seu modelo usando variáveis para conteúdo dinâmico, por exemplo:

You are an expert SRE. Given the following user question: {{user_input}}

Produce a step-by-step diagnostic plan and concise summary.

- Expor

user_inputcomo a variável a ser preenchida a partir do nó Início/Entrada.

Etapa B — Adicionar um nó de cadeia LLM (wrapper LLM)

Adicione um Cadeia LLM or LLM nó que representa uma invocação de prompt → modelo. No Flowise, o nó da Cadeia LLM geralmente tem duas entradas principais: Modelo de linguagem (o nó modelo/inferência) e Prompt (o modelo de prompt).

Etapa C — Conecte os nós (fiação explícita)

- Conecte o nó CometAPI ao LLM Chain Modelo de linguagem entrada.

Isso informa à cadeia qual modelo chamar para geração. (O CometAPI se torna o provedor do modelo.) - Conecte o nó do modelo de prompt ao LLM Chain Prompt entrada.

A cadeia combinará o modelo de prompt com os valores das variáveis e enviará o prompt resultante para o CometAPI. - Conecte o nó Iniciar/Entrada ao Prompt Template

user_inputvariável. - Conecte a saída da cadeia LLM ao nó Saída (resposta da interface do usuário ou ferramenta downstream).

Visualmente, o fluxo deve ser:

Start/Input → Prompt Template → LLM Chain (Language Model = CometAPI node) → Output

Etapa D — Teste com uma execução de teste

- Execute o fluxo no console de testes do Flowise. Inspecione o prompt enviado à CometAPI, os tokens de resposta e a latência. Ajuste a temperatura, o número máximo de tokens ou o número máximo de pontos nas configurações do nó da CometAPI para ajustar a criatividade em relação ao determinismo.

Quais casos de uso prático essa integração possibilita?

Abaixo estão alguns casos de uso importantes em que Flowise + CometAPI oferecem benefícios tangíveis:

1) Roteamento multimodelo / seleção da melhor ferramenta

Crie fluxos que escolham modelos por subtarefa: sumarização rápida com um modelo de baixo custo, aterramento factual com um modelo de alta precisão e geração de imagens por meio de um modelo de imagem — tudo por meio de parâmetros CometAPI sem alterar a fiação do Flowise.

2) Teste e avaliação do modelo A/B

Crie duas cadeias LLM paralelas no Flowise (A vs. B), encaminhe o mesmo prompt para diferentes opções de modelo CometAPI e envie os resultados para um pequeno nó comparador que pontua as saídas. Use métricas para decidir qual modelo adotar.

3) RAG Híbrido (Retriever + LLM)

Use o repositório de documentos e o recuperador de vetores do Flowise para coletar contexto e, em seguida, enviar um modelo de prompt combinado para o modelo da CometAPI. A API unificada simplifica a troca do LLM usado para a síntese final.

4) Ferramentas de agente (APIs, bancos de dados, código)

Ferramentas de composição (HTTP GET/POST, chamadas de banco de dados) dentro de agentes Flowise, usam CometAPI para raciocínio de linguagem e seleção de ações, e encaminham saídas para conectores/ferramentas. O Flowise oferece suporte a ferramentas de solicitação e padrões de agentes para isso.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Para começar, explore as capacidades do modelo no Playground e consulte o Flowise Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Pronto para ir?→ Inscreva-se no CometAPI hoje mesmo !

Recomendações finais e conclusão

Integrar o Flowise com o CometAPI é uma maneira pragmática de combinar orquestração visual rápida (Flowise) com acesso flexível a diversos provedores de modelos (CometAPI). O padrão — armazenar prompts como modelos, manter os nós do modelo desacoplados e instrumentar execuções cuidadosamente — permite que as equipes iterem rapidamente e troquem de provedores sem reescrever os fluxos. Lembre-se de gerenciar credenciais com segurança, considerar latência e custo e instrumentar seus fluxos para observabilidade e governança.