Gemini 3 Pro (Preview) é o mais novo modelo carro-chefe de raciocínio multimodal da Google/DeepMind na família Gemini 3. Está posicionado como o “modelo mais inteligente até agora”, projetado para raciocínio profundo, fluxos de trabalho agentic, codificação avançada e compreensão multimodal de contexto longo (texto, imagens, áudio, vídeo, código e integrações de ferramentas).

Principais recursos

- Modalidades: Texto, imagem, vídeo, áudio, PDFs (e saídas estruturadas de ferramentas).

- Agentic/ferramentas: Chamadas de função embutidas, busca como ferramenta, execução de código, contexto de URL e suporte para orquestrar agentes de múltiplas etapas. O mecanismo "Thought-signature" preserva o raciocínio de múltiplas etapas entre chamadas.

- Codificação e “vibe coding”: Otimizado para geração de front-end, geração de UI interativa e codificação agentic (lidera rankings relevantes reportados pela Google). É promovido como o modelo de “vibe-coding” mais forte deles até agora.

- Novos controles para desenvolvedores:

thinking_level(low|high) para equilibrar custo/latência vs profundidade de raciocínio, emedia_resolutioncontrola a fidelidade multimodal por imagem ou quadro de vídeo. Isso ajuda a balancear desempenho, latência e custo.

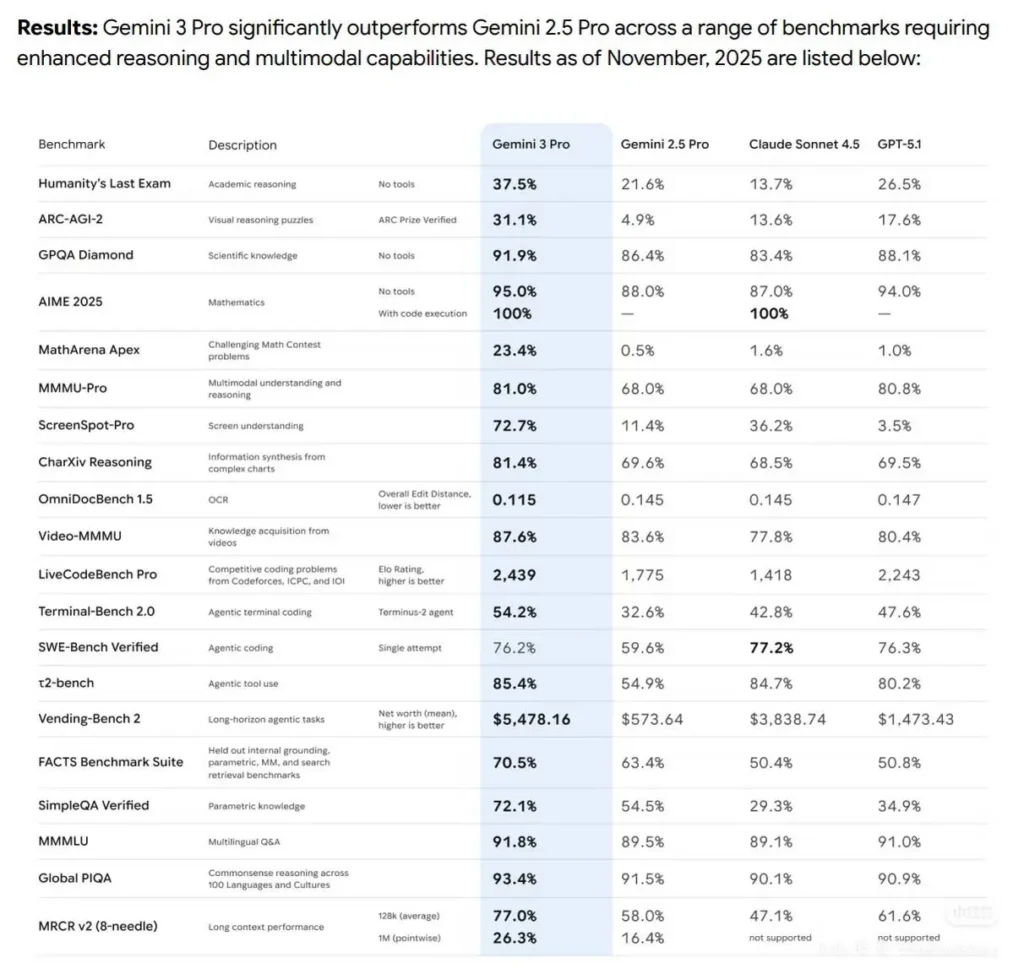

Desempenho em benchmarks

- O Gemini3Pro conquistou o primeiro lugar no LMARE com uma pontuação de 1501, superando os 1484 pontos do Grok-4.1-thinking e também liderando o Claude Sonnet 4.5 e o Opus 4.1.

- Também ficou em primeiro lugar na arena de programação WebDevArena com pontuação de 1487.

- Em raciocínio acadêmico no Humanity’s Last Exam, atingiu 37.5% (sem ferramentas); em ciência no GPQA Diamond, 91.9%; e na competição de matemática MathArena Apex, 23.4%, estabelecendo um novo recorde.

- Em capacidades multimodais, o MMMU-Pro alcançou 81%; e em compreensão de vídeo no Video-MMMU, 87.6%.

Detalhes técnicos e arquitetura

- Parâmetro “Thinking level”: O Gemini 3 expõe um controle

thinking_levelque permite aos desenvolvedores equilibrar profundidade de raciocínio interno vs latência/custo. O modelo tratathinking_levelcomo uma permissão relativa para raciocínio interno de múltiplas etapas, em vez de uma garantia estrita de tokens. O padrão é normalmentehighpara o Pro. Este é um novo controle explícito para os desenvolvedores ajustarem o planejamento de múltiplas etapas e a profundidade da cadeia de raciocínio. - Saídas estruturadas e ferramentas: O modelo suporta saídas JSON estruturadas e pode ser combinado com ferramentas incorporadas (grounding do Google Search, contexto de URL, execução de código, etc.). Alguns recursos de saídas estruturadas + ferramentas estão disponíveis apenas em preview para

gemini-3-pro-preview. - Integrações multimodais e agentic: O Gemini 3 Pro é explicitamente construído para fluxos de trabalho agentic (ferramentas + múltiplos agentes sobre código/terminais/navegador).

Limitações e ressalvas conhecidas

- Factualidade não perfeita — alucinações continuam possíveis. Apesar das fortes melhorias de factualidade reivindicadas pela Google, verificação com grounding e revisão humana ainda são necessárias em contextos de alto risco (jurídico, médico, financeiro).

- O desempenho em contexto longo varia por tarefa. O suporte a uma janela de entrada de 1M é uma capacidade concreta, mas a eficácia empírica pode cair em alguns benchmarks em comprimentos extremos (foram observadas quedas pontuais em 1M em alguns testes de contexto longo).

- Compensações entre custo e latência. Contextos grandes e configurações mais altas de

thinking_levelaumentam computação, latência e custo; faixas de preço se aplicam com base em volumes de tokens. Usethinking_levele estratégias de chunking para gerenciar custos. - Segurança e filtros de conteúdo. A Google continua a aplicar políticas de segurança e camadas de moderação; certos conteúdos e ações permanecem restritos ou acionarão modos de recusa.

Como o Gemini 3 Pro Preview se compara a outros modelos de ponta

Comparação em alto nível (preview → qualitativa):

Contra o Gemini 2.5 Pro: Melhorias de mudança de patamar em raciocínio, uso de ferramentas agentic e integração multimodal; tratamento de contexto muito maior e melhor compreensão de textos longos. A DeepMind mostra ganhos consistentes em raciocínio acadêmico, codificação e tarefas multimodais.

Contra GPT-5.1 e Claude Sonnet 4.5 (conforme reportado): No conjunto de benchmarks da Google/DeepMind, o Gemini 3 Pro é apresentado como líder em várias métricas de agentic, multimodal e contexto longo (veja Terminal-Bench, MMMU-Pro, AIME). Resultados comparativos variam por tarefa.

Casos de uso típicos e de alto valor

- Sumarização de documentos/livros e Q&A: o suporte a contexto longo o torna atraente para equipes jurídicas, de pesquisa e compliance.

- Compreensão e geração de código em escala de repositório: integração com cadeias de ferramentas de código e raciocínio aprimorado ajuda em grandes refatorações de bases de código e fluxos de revisão de código automatizados.

- Assistentes de produto multimodais: fluxos de imagem + texto + áudio (suporte ao cliente que ingere capturas de tela, trechos de chamadas e documentos).

- Geração e edição de mídia (foto → vídeo): recursos anteriores da família Gemini agora incluem capacidades de foto→vídeo estilo Veo/Flow; o preview sugere geração multimídia mais profunda para protótipos e fluxos de trabalho de mídia.