O que é a API GPT-5.2

GPT-5.2 API é a mesma que GPT-5.2 Thinking no ChatGPT. GPT-5.2 Thinking é a variante de nível intermediário da família GPT-5.2 da OpenAI, projetada para trabalho mais profundo: raciocínio em múltiplas etapas, sumarização de documentos longos, geração de código de qualidade e trabalho profissional de conhecimento, em que precisão e estrutura utilizável importam mais do que throughput bruto. Na API, é exposto como o modelo gpt-5.2 (Responses API / Chat Completions), e fica entre a variante de baixa latência Instant e a variante de maior qualidade porém mais cara Pro.

Principais recursos

- Contexto muito longo e compactação: janela efetiva de 400K e ferramentas de compactação para gerenciar relevância ao longo de conversas e documentos extensos.

- Esforço de raciocínio configurável:

none | medium | high | xhigh(xhigh habilita o máximo de computação interna para raciocínios difíceis).xhighestá disponível nas variantes Thinking/Pro. - Suporte mais robusto a ferramentas e funções: chamadas de ferramentas de primeira classe, gramáticas (CFG/Lark) para restringir saídas estruturadas e comportamentos agentivos aprimorados que simplificam automações complexas em múltiplas etapas.

- Compreensão multimodal: entendimento mais rico de imagem + texto e integração em tarefas de múltiplas etapas.

- Segurança aprimorada / tratamento de conteúdo sensível: intervenções direcionadas para reduzir respostas indesejadas em áreas como autolesão e outros contextos sensíveis.

Capacidades técnicas e especificações (visão de desenvolvedor)

- Endpoints de API e IDs de modelo:

gpt-5.2para Thinking (Responses API),gpt-5.2-chat-latestpara fluxos de chat/instant, egpt-5.2-propara o nível Pro; disponíveis via Responses API e Chat Completions onde indicado. - Tokens de raciocínio e gestão de esforço: a API suporta parâmetros explícitos para alocar computação (esforço de raciocínio) por requisição; maior esforço aumenta a latência e o custo, mas melhora a qualidade da saída em tarefas complexas.

- Ferramentas de saída estruturada: suporte a gramáticas (Lark / CFG) para restringir a saída do modelo a uma DSL ou sintaxe exata (útil para SQL, JSON, geração de DSL).

- Chamadas paralelas de ferramentas e coordenação agentiva: paralelismo aprimorado e uma orquestração de ferramentas mais limpa reduzem a necessidade de prompts de sistema elaborados e de estruturas multiagente.

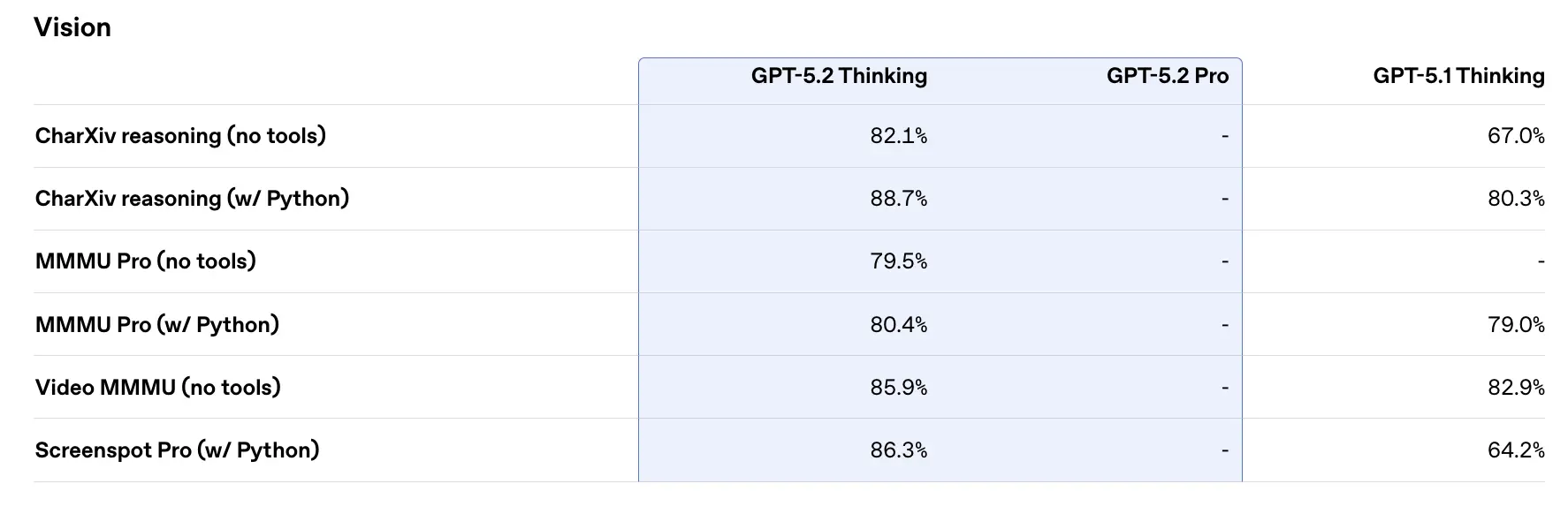

Desempenho em benchmarks e dados de suporte

A OpenAI publicou uma variedade de resultados de benchmarks internos e externos para GPT-5.2. Destaques selecionados (números reportados pela OpenAI):

- GDPval (44 ocupações, trabalho de conhecimento) — GPT-5.2 Thinking “supera ou iguala profissionais de ponta do setor em 70.9% das comparações”; a OpenAI reporta que as saídas foram produzidas a >11× da velocidade e a <1% do custo de profissionais especialistas em suas tarefas GDPval (estimativas de velocidade e custo são baseadas em históricos). Essas tarefas incluem modelos de planilhas, apresentações e vídeos curtos.

- SWE-Bench Pro (coding) — GPT-5.2 Thinking alcança ≈55.6% no SWE-Bench Pro e ~80% no SWE-Bench Verified (apenas Python), segundo a OpenAI, estabelecendo um novo estado da arte para avaliação de geração de código/engenharia em seus testes. Isso se traduz em depuração mais confiável e correções de ponta a ponta na prática, de acordo com exemplos da OpenAI.

- GPQA Diamond (Q&A de ciência em nível de pós-graduação) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% no GPQA Diamond (sem ferramentas, raciocínio máximo).

- ARC-AGI series — No ARC-AGI-2 (um benchmark mais difícil de raciocínio fluido), GPT-5.2 Thinking obteve 52.9% e GPT-5.2 Pro 54.2% (a OpenAI afirma que estes são novos recordes de estado da arte para modelos no estilo chain-of-thought).

- Long-context (OpenAI MRCRv2) — GPT-5.2 Thinking mostra precisão próxima de 100% na variante MRCR de 4 agulhas até 256k tokens e pontuações substancialmente melhores em relação ao GPT-5.1 em cenários de contexto longo. (A OpenAI publicou gráficos e tabelas do MRCRv2.)

Comparação com contemporâneos

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro foi divulgado com uma ~1,048,576 (≈1M) token janela de contexto e entradas multimodais amplas (texto, imagem, áudio, vídeo, PDFs) e fortes integrações agentivas via Vertex AI / AI Studio. No papel, a janela de contexto maior do Gemini 3 é um diferencial para cargas de trabalho de sessão única extremamente grandes; os trade-offs incluem superfície de ferramentas e adequação ao ecossistema.

- vs Anthropic Claude Opus 4.5: O Opus 4.5 da Anthropic enfatiza fluxos de trabalho de codificação/agentes para empresas e reporta resultados fortes no SWE-bench e robustez para longas sessões agentivas; a Anthropic posiciona o Opus para automação e geração de código com uma janela de contexto de 200k e integrações especializadas de agente/Excel. Opus 4.5 é um concorrente forte em automação empresarial e tarefas de código.

Conclusão prática: GPT-5.2 mira um conjunto equilibrado de melhorias (contexto de 400k, saídas com muitos tokens, raciocínio/codificação aprimorados). Gemini 3 mira os maiores contextos de sessão única (≈1M), enquanto Claude Opus foca em engenharia empresarial e robustez agentiva. Escolha conforme tamanho de contexto, necessidades de modalidade, compatibilidade de recursos/ferramentas e trade-offs de custo/latência.

Como acessar e usar a API GPT-5.2

Etapa 1: Inscreva-se para obter a chave de API

Faça login em cometapi.com. Se você ainda não é nosso usuário, registre-se primeiro. Entre no seu CometAPI console. Obtenha a credencial de acesso (chave de API) da interface. Clique em “Add Token” no token da API na central pessoal, obtenha a chave de token: sk-xxxxx e envie.

Etapa 2: Envie solicitações para a API GPT-5.2

Selecione o endpoint “gpt-5.2” para enviar a solicitação de API e defina o corpo da requisição. O método de requisição e o corpo da requisição são obtidos na documentação de API do nosso site. Nosso site também fornece teste no Apifox para sua conveniência. Substitua <YOUR_API_KEY> pela sua chave CometAPI real da sua conta. Desenvolvedores chamam isso via a Responses API / Chat endpoints.

Insira sua pergunta ou solicitação no campo de conteúdo — é isso que o modelo irá responder. Processe a resposta da API para obter a resposta gerada.

Etapa 3: Recupere e verifique os resultados

Processe a resposta da API para obter a resposta gerada. Após o processamento, a API responde com o status da tarefa e os dados de saída.

Veja também Gemini 3 Pro Preview API