OpenAI, Anthropic e Google continuam a expandir os limites dos modelos de linguagem de grande porte com suas mais recentes ofertas emblemáticas: o o3 da OpenAI (e sua variante aprimorada o3-pro), o Claude Opus 4 da Anthropic e o Gemini 2.5 Pro do Google. Cada um desses modelos traz inovações arquitetônicas exclusivas, vantagens de desempenho e integrações de ecossistema que atendem a diferentes casos de uso, desde assistência de codificação de nível empresarial até aprimoramentos de pesquisa voltados para o consumidor. Esta comparação detalhada examina seu histórico de lançamentos, recursos técnicos, desempenho de benchmark e aplicativos recomendados para ajudar as organizações a escolher o modelo certo para suas necessidades.

O que é o o3 da OpenAI e como ele evoluiu?

A OpenAI apresentou o o3 pela primeira vez em 16 de abril de 2025, posicionando-o como "nosso modelo mais inteligente", projetado para contexto estendido e respostas altamente confiáveis. Pouco depois, em 10 de junho de 2025, a OpenAI lançou o o3-pro — uma variante com desempenho otimizado, disponível para usuários Pro no ChatGPT e também via API — que oferece inferência mais rápida e maior rendimento sob cargas pesadas.

Janela de contexto e taxa de transferência

OpenAI o3 oferece uma 200K-token janela de contexto para entrada e saída, permitindo o processamento de documentos extensos, bases de código ou conversas multi-turn sem truncamento frequente. Sua taxa de transferência é de cerca de 37.6 fichas/seg, que — embora não seja o líder do grupo — fornece capacidade de resposta consistente para cargas de trabalho sustentadas.

Raciocínio Deliberativo Avançado

- “Cadeia privada de pensamento”: o3 foi treinado com aprendizagem por reforço para planejar e raciocinar por meio de etapas intermediárias antes de produzir seu resultado final, melhorando significativamente sua capacidade de dedução lógica e decomposição de problemas.

- Alinhamento deliberativo:Ele incorpora técnicas de segurança que orientam o modelo a aderir de forma mais confiável às diretrizes por meio de raciocínio passo a passo, reduzindo grandes erros em tarefas complexas do mundo real.

Preços e integração empresarial

O preço do o3 da OpenAI é de aproximadamente $2 por milhão de tokens de entrada e $8 por milhão de tokens de saídaIsso o posiciona na faixa intermediária: mais acessível do que modelos premium como o Claude Opus 4 para cargas de trabalho pesadas, mas mais caro do que alternativas mais acessíveis como o Gemini 2.5 Pro. Fundamentalmente, as empresas se beneficiam da integração perfeita com o ecossistema mais amplo da OpenAI API — abrangendo embeddings, ajustes finos e endpoints especializados — minimizando a sobrecarga de integração.

Como o Claude Opus 4 se diferencia no mercado?

A Anthropic anunciou o Claude Opus 4 em 22 de maio de 2025, comercializando-o como "o melhor modelo de codificação do mundo", com desempenho sustentado em tarefas complexas e de longa duração e fluxos de trabalho de agentes. O lançamento ocorreu simultaneamente na API da Anthropic e via Amazon Bedrock, tornando-o acessível aos clientes da AWS por meio das funções LLM e da API REST da Bedrock...

Capacidades de “pensamento” ampliadas

Uma característica distintiva do Opus 4 é a sua “pensamento estendido” Modo beta, que aloca dinamicamente a computação entre o raciocínio no modelo e as invocações de ferramentas (por exemplo, pesquisa, recuperação, APIs externas). Combinado com "resumos de pensamento", os usuários ganham visibilidade da cadeia de raciocínio interna do modelo — essencial para aplicações sensíveis à conformidade em finanças e saúde.

Compensações entre preço e contexto

At $15 por milhão de tokens de entrada e $75 por milhão de tokens de saída, Claude Opus 4 está no topo do espectro de preços. Seu 200K-token janela de entrada (com uma 32K-token O limite de saída (output cap) é menor que a janela de 2.5 milhão de tokens do Gemini 1 Pro, mas é suficiente para a maioria das tarefas de revisão de código e raciocínio de formato longo. A Anthropic justifica o prêmio enfatizando a intensidade computacional interna e a fidelidade sustentada da cadeia de pensamento, com economia de até 90% por meio do cache de prompts e 50% por meio do processamento em lote. Orçamentos de pensamento estendidos estão incluídos para níveis pagos; usuários gratuitos podem acessar apenas a variante Sonnet.

Quais recursos e desempenho exclusivos o Gemini 2.5 Pro oferece?

Lançado como a próxima geração do nível “Pro” do Google, Gêmeos 2.5 Pró visa organizações que necessitam de contexto massivo, entradas multimodais e escalonamento econômico. Notavelmente, ele suporta até Tokens 1,048,576 em um único prompt — de entrada — e Tokens 65,535 saída, permitindo fluxos de trabalho de documentos de ponta a ponta que abrangem centenas de milhares de páginas.

Contexto superior e multimodalidade

Gemini 2.5 Pro brilha com seu 1M-token janela de contexto, facilitando casos de uso como análise de contratos legais, mineração de patentes e refatoração abrangente da base de código. O modelo aceita nativamente texto, código, imagens, áudio, PDFs e quadros de vídeo, simplificando pipelines multimodais sem etapas separadas de pré-processamento.

Como o Gemini aprimora a pesquisa multimodal e conversacional?

O Gemini 2.5 Pro se destaca por sua metodologia de "fan-out de consultas": ele decompõe consultas complexas em subperguntas, executa buscas paralelas e sintetiza respostas abrangentes e conversacionais em tempo real. Com suporte para entradas de texto, voz e imagem, o Modo IA aproveita os recursos multimodais do Gemini para atender às diversas interações do usuário — embora ainda esteja em estágio inicial e possa ocasionalmente interpretar consultas incorretamente.

Preços competitivos

Com uma taxa de entrada de $1.25–$2.50 por milhão de tokens e $10–$15 por milhão de tokens de saída, o Gemini 2.5 Pro oferece o melhor preço-token proporção entre os três. Isso o torna particularmente atraente para aplicações de alto volume e uso intensivo de documentos, onde contextos longos impulsionam o consumo de tokens mais do que métricas brutas de desempenho. Com planos premium que liberam orçamentos de "Pensamento Profundo" e maior rendimento. As assinaturas do Google AI Pro e Ultra combinam o acesso ao Gemini 2.5 Pro com outras ferramentas, como a geração de vídeo Veo e o NotebookLM.

Arquiteturas e capacidades subjacentes

OpenAI o3: Raciocínio reflexivo em escala

O o3 da OpenAI é um transformador generativo reflexivo pré-treinado, projetado para dedicar tempo adicional de deliberação a tarefas de raciocínio lógico passo a passo. Arquitetonicamente, ele se baseia na estrutura do transformador do GPT-4, mas incorpora um mecanismo de "orçamento de pensamento": o modelo aloca dinamicamente mais ciclos de computação para problemas complexos, criando cadeias internas de pensamento antes de gerar saídas. Isso resulta em um desempenho significativamente melhorado em domínios que exigem raciocínio em várias etapas, como matemática avançada, investigação científica e síntese de código.

Claude Opus 4: Raciocínio híbrido para fluxos de trabalho estendidos

O Claude Opus 4 da Anthropic é seu modelo mais poderoso até o momento, otimizado para codificação e fluxos de trabalho agênticos sustentados. Assim como o o3, ele utiliza um núcleo transformador, mas introduz modos de raciocínio híbridos — respostas quase instantâneas ("pensamento rápido") versus deliberação prolongada ("pensamento profundo") — permitindo manter o contexto ao longo de milhares de etapas e horas de computação. Essa abordagem híbrida torna o Opus 4 especialmente adequado para pipelines de engenharia de software de longa duração, tarefas de pesquisa em vários estágios e orquestração autônoma de agentes.

Gemini 2.5 Pro: Pensamento multimodal com orçamentos adaptáveis

O Gemini 2.5 Pro do Google DeepMind amplia a multimodalidade nativa e as capacidades de raciocínio do Gemini. Ele introduz o "Deep Think", um mecanismo adaptativo de pensamento paralelo que distribui subtarefas entre módulos internos, sintetizando os resultados em respostas coerentes. O Gemini 2.5 Pro também possui uma janela de contexto excepcionalmente longa, permitindo a ingestão de bases de código inteiras, grandes conjuntos de dados (texto, áudio, vídeo) e documentos de design em uma única passagem, ao mesmo tempo em que oferece controles precisos sobre orçamentos de pensamento para compensar custos e desempenho.

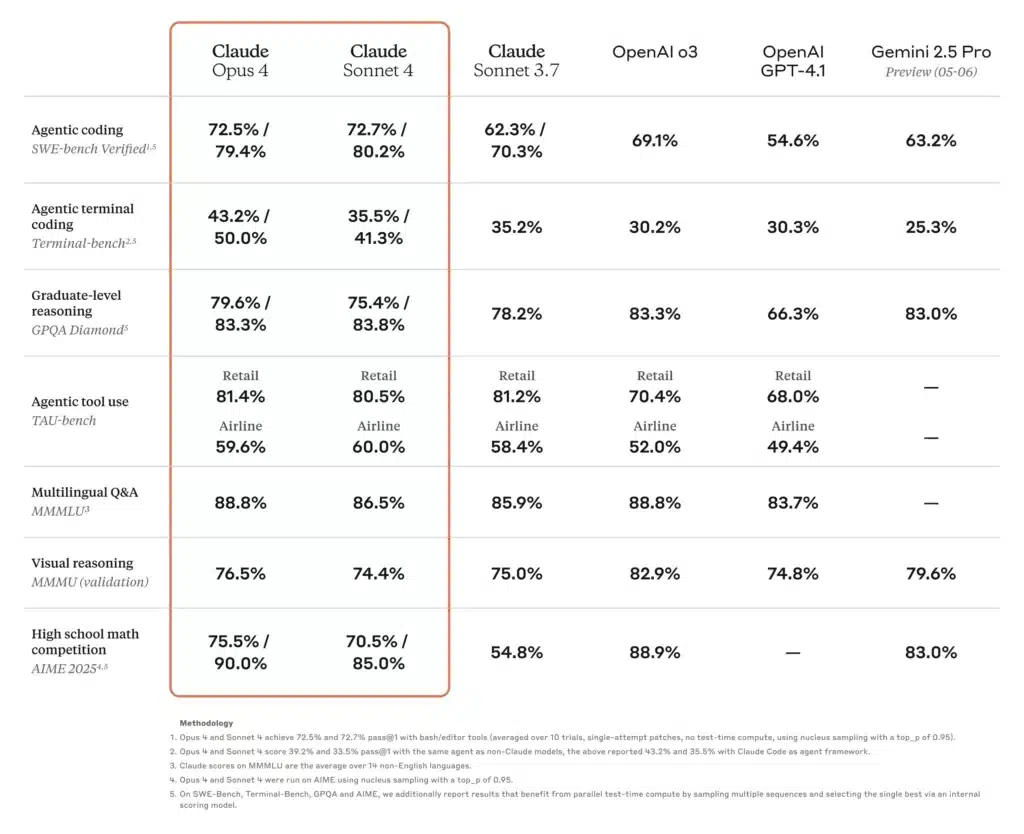

Como os benchmarks de desempenho se comparam entre esses modelos?

Raciocínio acadêmico e científico

Em uma tabela recente da SciArena, o o3 superou seus pares em questões de raciocínio técnico avaliadas por pesquisadores, refletindo a forte confiança da comunidade em sua precisão científica. Enquanto isso, o Claude Opus 4 demonstrou desempenho superior em benchmarks baseados em agentes que exigem resolução de problemas sustentada por várias horas, superando os modelos Sonnet em até 30% em tarefas de TAU-bench e raciocínio preditivo. O Gemini 2.5 Pro também lidera muitos benchmarks acadêmicos, alcançando o primeiro lugar no LMArena em medidas de preferência humana e apresentando margens significativas em testes de matemática e ciências.

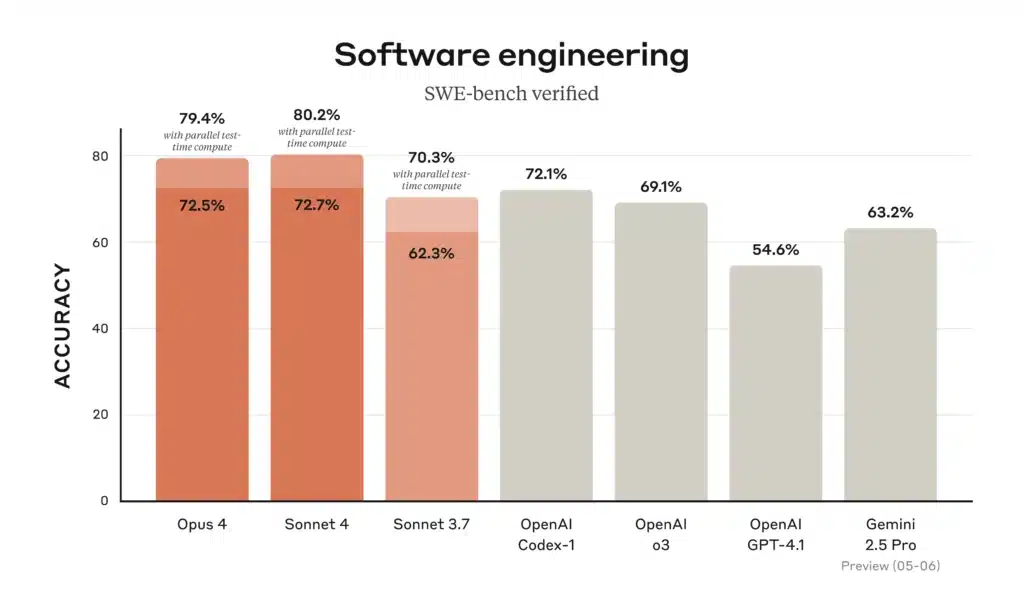

Codificação e engenharia de software

Em tabelas de classificação de codificação, o Gemini 2.5 Pro "lidera a popular WebDev Arena" e lidera benchmarks de codificação comuns, graças à sua capacidade de carregar e raciocinar sobre repositórios inteiros. O Claude Opus 4 detém o título de "melhor modelo de codificação do mundo", com 72.5% no SWE-bench e 43.2% no Terminal-bench — benchmarks focados em tarefas de software complexas e de longa duração. O o3 também se destaca na síntese e depuração de código, mas fica ligeiramente atrás do Opus 4 e do Gemini em cenários de engenharia de larga escala e com várias etapas; no entanto, sua cadeia de pensamento intuitiva o torna altamente confiável para tarefas de codificação individuais.

Uso de ferramentas e integração multimodal

O design multimodal do Gemini 2.5 Pro — processamento de texto, imagens, áudio e vídeo — lhe dá uma vantagem em fluxos de trabalho criativos, como simulações interativas, análise de dados visuais e storyboard de vídeo. O uso de ferramentas de agente do Claude Opus 4, incluindo o Claude Code CLI e operações integradas de sistema de arquivos, se destaca na construção de pipelines autônomos em APIs e bancos de dados. O o3 suporta navegação na web, análise de arquivos, execução de Python e raciocínio de imagem, tornando-o um "canivete suíço" versátil para tarefas de formato misto, embora com limites de contexto mais curtos do que o Gemini 2.5 Pro.

Como esses modelos se comparam em cenários de codificação do mundo real?

Quando se trata de assistência na codificação, os benchmarks contam apenas parte da história. Os desenvolvedores buscam geração de código precisa, capacidade de refatoração e a capacidade de entender o contexto do projeto distribuído entre vários arquivos.

Taxas de precisão e alucinação

- Claude Opus 4 lidera na prevenção de alucinações, com menos ocorrências de referências de API inexistentes ou assinaturas de biblioteca incorretas — essencial para bases de código de missão crítica. Sua taxa de alucinações é relatada em ~% 12 em auditorias de código extensivas versus ~% 18 para Gêmeos e ~% 20 para o3.

- Gêmeos 2.5 Pró se destaca em transformações em massa (por exemplo, migração de padrões de código em dezenas de milhares de linhas), graças à sua vasta janela de contexto, mas ocasionalmente tem dificuldades com erros lógicos sutis em grandes blocos de código.

- OpenAI o3 continua sendo a melhor opção para snippets rápidos, geração de boilerplate e depuração interativa devido à sua latência estável e alta disponibilidade, mas os desenvolvedores geralmente fazem validação cruzada com outro modelo para detectar erros extremos.

Ecossistema de ferramentas e APIs

- Ambos o3 e Gemini aproveite ferramentas abrangentes — a API de chamada de função da OpenAI e a estrutura de ações integrada do Google, respectivamente — permitindo orquestração perfeita de recuperação de dados, consultas de banco de dados e chamadas de API externas.

- Claude Opus 4 está sendo integrado em estruturas de agente como Claude Code (ferramenta CLI da Anthropic) e Amazon Bedrock, oferecendo abstrações de alto nível para a construção de fluxos de trabalho autônomos sem orquestração manual.

Qual modelo oferece a melhor relação custo-benefício?

O equilíbrio entre capacidades brutas, duração do contexto e custo produz diferentes conclusões de “melhor valor” dependendo das características da carga de trabalho.

Casos de uso de alto volume centrados em documentos

Se estiver processando vastos corpora — como repositórios legais, literatura científica ou arquivos empresariais —Gêmeos 2.5 Pró muitas vezes emerge como vencedor. Seu 1M-token janela e preço de $ $ 1.25- 2.50 (entrada) e $ $ 10- 15 Os tokens (de saída) fornecem uma estrutura de custo imbatível para tarefas de longo contexto.

Raciocínio profundo e fluxos de trabalho multietapas

Quando a precisão, a fidelidade da cadeia de pensamento e as capacidades de longo prazo dos agentes são importantes — como em modelagem financeira, verificações de conformidade legal ou pipelines de P&D —Claude Opus 4, apesar do seu preço mais alto, pode reduzir a sobrecarga de tratamento de erros e melhorar o rendimento de ponta a ponta, minimizando reexecuções e ciclos de revisão humana.

Adoção empresarial equilibrada

Para equipes que buscam desempenho confiável de uso geral sem escala extrema, OpenAI o3 oferece um meio-termo. Com amplo suporte de API, preços moderados e resultados de benchmark sólidos, continua sendo uma escolha atraente para plataformas de ciência de dados, automação de suporte ao cliente e integrações de produtos em estágio inicial.

Qual modelo de IA você deve escolher para suas necessidades específicas?

Em última análise, seu modelo ideal depende de três fatores principais:

- Escala de contexto: Para cargas de trabalho que exigem grandes janelas de entrada, o Gemini 2.5 Pro domina.

- Profundidade de raciocínio:Se suas tarefas envolvem lógica multietapas e baixa tolerância a erros, o Claude Opus 4 oferece consistência superior.

- Sensibilidade de custos e adequação do ecossistema:Para tarefas de uso geral dentro da pilha OpenAI — especialmente onde a integração com pipelines de dados existentes é importante — o o3 apresenta uma opção equilibrada e econômica.

Ao avaliar o perfil de token do seu aplicativo (entrada vs. saída), a tolerância a alucinações e os requisitos de ferramentas, você pode selecionar o modelo que melhor se adapta às necessidades técnicas e às restrições orçamentárias.

Aqui está um gráfico de comparação lado a lado resumindo as principais especificações, métricas de desempenho, preços e casos de uso ideais para OpenAI o3, Anthropic Claude Opus 4 e Google Gemini 2.5 Pro:

| Recurso/Métrica | OpenAI o3 | Claude Opus 4 | Gêmeos 2.5 Pró |

|---|---|---|---|

| Janela de contexto (entrada / saída) | 200 mil tokens / 200 mil tokens | 200 mil tokens / 32 mil tokens | 1 048 576 fichas / 65 535 fichas |

| Taxa de transferência (tokens/s) | ~ 37.6 | ~ 42.1 | ~ 83.7 |

| Latência média | ~2.8 segundos | ~3.5 segundos | ~2.52 segundos |

| Benchmark de codificação (SWE-bench) | 69.1% | 72.5% | 63.2% |

| Referência de Matemática (AIME-2025) | 78.4%¹ | 81.7%¹ | 83.0% |

| Taxa de alucinação (auditorias de código) | ~ 20% | ~ 12% | ~ 18% |

| Entradas multimodais | Texto e código | Texto e código | Texto, código, imagens, áudio, PDFs, vídeo |

| Suporte de “Cadeia de Pensamento” | Padrão | Pensamento estendido com resumos | Padrão |

| API de chamada de função/ferramenta | Sim (Funções OpenAI) | Sim (via agentes antrópicos e Bedrock) | Sim (Ações do Google) |

| Precificação (tokens de entrada) | $ 2.00 / M tokens | $ 15.00 / M tokens | US$ 1.25–US$ 2.50 / fichas M |

| Precificação (tokens de saída) | $ 8.00 / M tokens | $ 75.00 / M tokens | US$ 10–US$ 15 / fichas M |

| Casos de uso ideais | Chatbots de uso geral, suporte ao cliente, trechos de código rápidos | Raciocínio profundo, bases de código complexas, agentes autônomos | Análise de documentos em grande escala, fluxos de trabalho multimodais |

As pontuações de matemática do AIME-2025 para o3 e Opus 4 são valores médios aproximados com base em benchmarks relatados.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Os desenvolvedores podem acessar Gêmeos 2.5 Pró,Claude Opus 4 e API O3 através de CometAPI, as versões mais recentes dos modelos listados são as da data de publicação do artigo. Para começar, explore os recursos do modelo no Playground e consulte o Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Em última análise, a escolha entre a série o3 da OpenAI, o Claude Opus 4 da Anthropic e o Gemini 2.5 Pro do Google depende de prioridades organizacionais específicas — sejam elas desempenho técnico de ponta, integração empresarial segura ou experiências multimodais perfeitas para o consumidor. Ao alinhar seus casos de uso com os pontos fortes e o ecossistema de cada modelo, você pode aproveitar a vanguarda da IA para impulsionar a inovação em pesquisa, desenvolvimento, educação e muito mais.

Nota do autor: Em 31 de julho de 2025, cada um desses modelos continua a evoluir, com pequenas atualizações frequentes e melhorias no ecossistema. Consulte sempre a documentação mais recente da API CometAPI e os benchmarks de desempenho antes de tomar uma decisão final.