A API Qwen2.5-Omni-7B fornece aos desenvolvedores métodos compatíveis com OpenAI para interagir com o modelo, permitindo o processamento de entradas de texto, imagem, áudio e vídeo e gerando respostas de texto e fala natural em tempo real.

O que é Qwen2.5-Omni-7B?

Qwen2.5-Omni-7B é o principal modelo de IA multimodal da Alibaba, ostentando 7 bilhões de parâmetros. Projetado para processar e entender múltiplas modalidades de dados, ele suporta entradas de texto, imagem, áudio e vídeo. O modelo facilita interações de fala e vídeo em tempo real, tornando-o uma ferramenta versátil para várias aplicações.

Principais recursos do Qwen2.5-Omni-7B

- Processamento multimodal: Capaz de lidar com diversas entradas, incluindo texto, imagens, áudio e vídeo, permitindo uma compreensão abrangente dos dados.

- Interação em tempo real: Suporta processamento de baixa latência, permitindo conversas por voz e vídeo em tempo real.

- Arquitetura do Pensador-Falante: Emprega um sistema de arquitetura dupla onde o "Pensador" gerencia o processamento e a compreensão de dados, enquanto o "Falante" gera saídas de fala fluentes.

- RoPE multimodal alinhado no tempo (TMRoPE): Utiliza o TMRoPE para sincronização precisa de dados temporais em diferentes modalidades, garantindo compreensão coerente e geração de respostas.

Métricas de Desempenho

Conquistas de referência

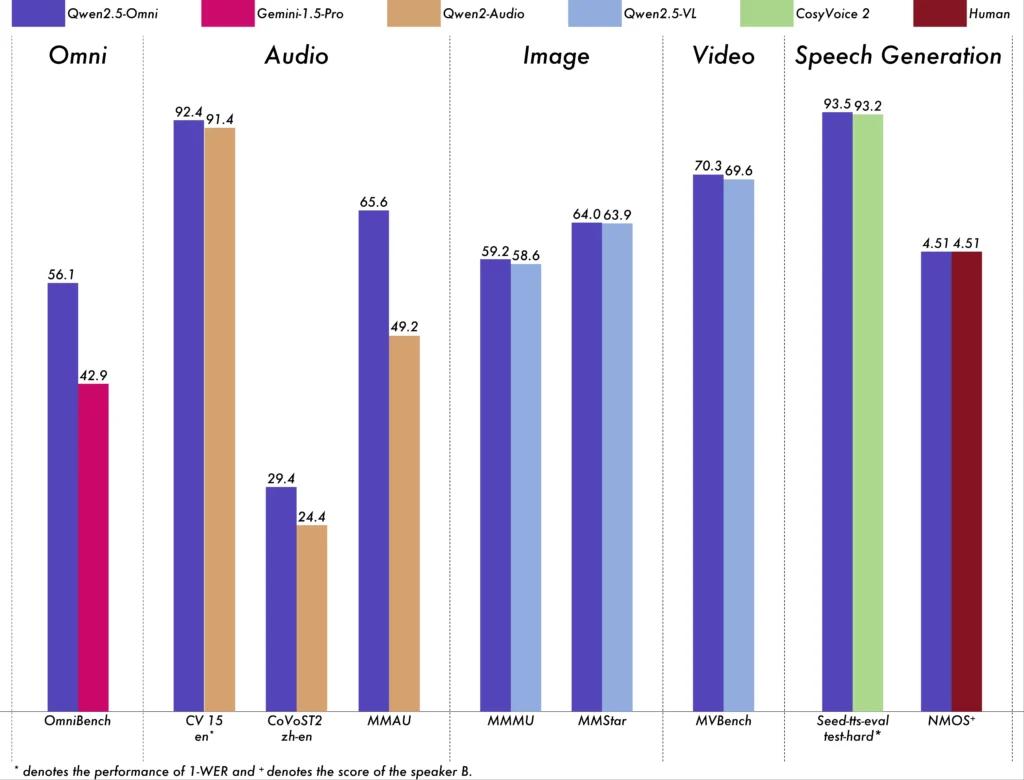

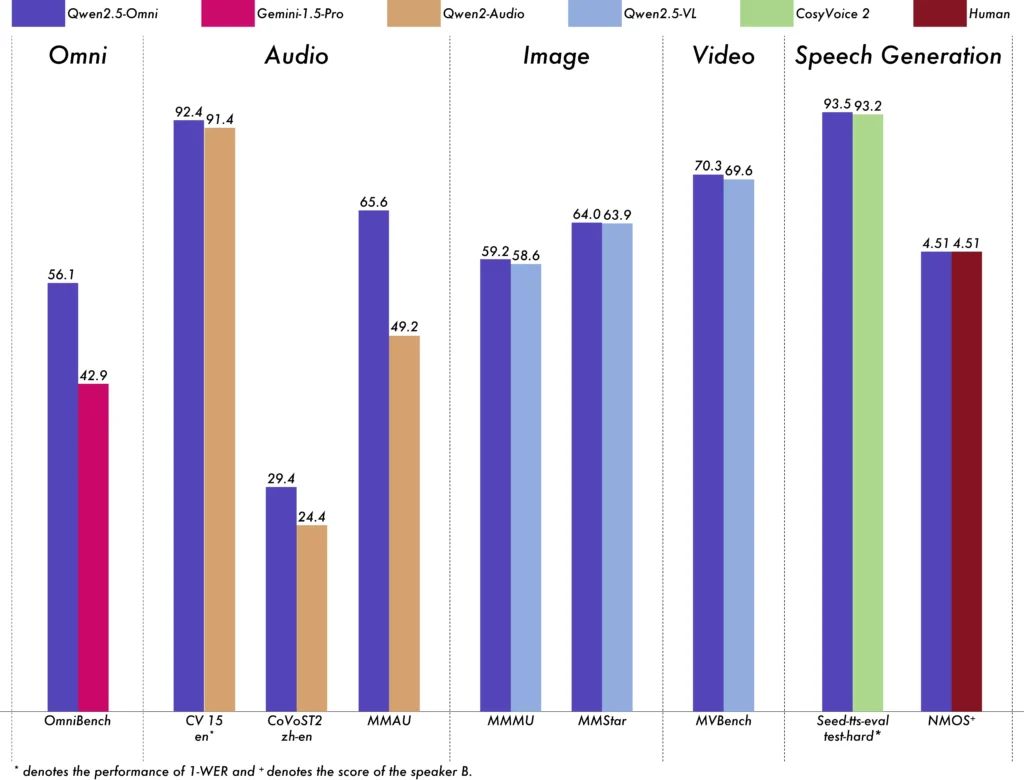

O Qwen2.5-Omni-7B demonstrou desempenho excepcional em vários benchmarks:

- OmniBench: Obteve uma pontuação média de 56.13%, superando modelos como Gemini-1.5-Pro (42.91%) e MIO-Instruct (33.80%).

- Reconhecimento de fala: No conjunto de dados Librispeech, foram obtidas taxas de erro de palavras variando de 1.6% a 3.5%, comparáveis a modelos especializados como o Whisper-large-v3.

- Reconhecimento de eventos sonoros: Obteve uma pontuação de 0.570 no conjunto de dados Meld, estabelecendo um novo padrão na área.

- Compreensão musical: Obteve uma pontuação de 0.88 no benchmark GiantSteps Tempo, destacando sua proficiência em compreensão musical.

Capacidades de processamento em tempo real

Projetado para aplicações em tempo real, o Qwen2.5-Omni-7B suporta streaming bloco a bloco, permitindo geração imediata de áudio com latência mínima. Esse recurso é particularmente benéfico para aplicações que exigem respostas rápidas, como assistentes virtuais e sistemas de IA interativos.

Especificações técnicas

Projeto arquitetônico

- Estrutura do pensador-falante: O componente 'Thinker' processa e entende entradas multimodais, gerando representações semânticas de alto nível e saídas textuais. O 'Talker' converte essas representações em fala natural e fluente, garantindo comunicação perfeita entre o sistema de IA e os usuários.

- Mecanismo TMRoPE: Aborda o desafio de sincronizar dados temporais de várias fontes alinhando registros de data e hora de entradas de vídeo e áudio, facilitando a compreensão multimodal coerente.

Metodologia de Treinamento

O modelo passou por um processo de treinamento de três fases:

- Fase um: Parâmetros fixos do modelo de linguagem durante o treinamento de codificadores visuais e de áudio usando pares extensos de áudio-texto e imagem-texto para melhorar a compreensão multimodal.

- Fase Dois: Descongelou todos os parâmetros e treinou em um conjunto de dados diversificado, incluindo imagem, vídeo, áudio e texto, melhorando ainda mais a compreensão multimodal abrangente.

- Fase Três: Focado no treinamento de dados de sequência longa para reforçar a capacidade do modelo de lidar com entradas complexas e extensas.

Evolução dos modelos Qwen

Progressão de Qwen para Qwen2.5

A evolução do Qwen para o Qwen2.5 significa um salto substancial no desenvolvimento de modelos de IA:

- Parâmetros aprimorados: O Qwen2.5 foi expandido para modelos com até 72 bilhões de parâmetros, oferecendo soluções escaláveis para diversas aplicações.

- Processamento de contexto estendido: Introduziu a capacidade de processar até 128,000 tokens, facilitando o manuseio de documentos extensos e conversas complexas.

- Capacidades de codificação: A variante Qwen2.5-Coder suporta mais de 92 linguagens de programação, auxiliando em tarefas de geração de código, depuração e otimização.

Vantagens do Qwen2.5-Omni-7B

Integração multimodal abrangente

Ao processar texto, imagens, áudio e vídeo de forma eficaz, o Qwen2.5-Omni-7B fornece uma solução de IA holística adequada para uma ampla gama de aplicações.

Interação em tempo real

Seu processamento de baixa latência garante respostas imediatas, melhorando a experiência do usuário em aplicações interativas.

Acessibilidade de código aberto

Como um modelo de código aberto, o Qwen2.5-Omni-7B promove transparência e permite que os desenvolvedores personalizem e integrem o modelo em várias plataformas sem restrições de propriedade.

Indicadores técnicos

- Parâmetros do modelo: 7 bilhões

- Modalidades de entrada: Texto, Imagem, Áudio, Vídeo

- Modalidades de saída: Texto, Discurso

- Capacidade de processamento: Interação de fala e vídeo em tempo real

- Referências de desempenho:

- OmniBench: Pontuação média de 56.13%

- Librispeech (taxa de erro de palavras): Teste-limpo: 1.8%, Teste-outro: 3.4%

Cenários de Aplicativos

Assistentes virtuais interativos

O processamento em tempo real e a compreensão multimodal do Qwen2.5-Omni-7B o tornam ideal para assistentes virtuais que podem ver, ouvir e responder naturalmente.

Criação de conteúdo multimídia

Os criadores de conteúdo podem aproveitar o modelo para gerar conteúdo multimídia envolvente, combinando texto, imagens e áudio perfeitamente.

Tecnologias Assistivas

Os recursos do modelo podem ajudar indivíduos com deficiências, como fornecer áudio descritivo para conteúdo visual.

Dicas de uso

Otimizando o desempenho

Para atingir o desempenho ideal, especialmente em aplicações em tempo real, é recomendável utilizar aceleradores de hardware e garantir memória de GPU suficiente.

Integração com sistemas existentes

Os desenvolvedores devem considerar os formatos de entrada e saída do modelo ao integrá-lo com aplicativos existentes para garantir a compatibilidade e maximizar a eficiência.

Permanecendo atualizado

Verifique regularmente os repositórios e a documentação oficiais para obter atualizações e melhores práticas para aproveitar ao máximo os recursos do Qwen2.5-Omni-7B.

Tópicos relacionados Como executar o modelo Qwen2.5-Omni-7B

Conclusão

Qwen2.5-Omni-7B exemplifica a convergência de pesquisa avançada de IA e aplicação prática, oferecendo uma solução versátil e eficiente para uma infinidade de tarefas em vários setores. Sua natureza de código aberto garante que ele permaneça acessível e adaptável, abrindo caminho para futuras inovações em IA multimodal.

Como chamar a API Qwen2.5-Omni-7B do CometAPI

1.Entrar para cometapi.com. Se você ainda não é nosso usuário, registre-se primeiro

2.Obtenha a chave da API de credencial de acesso da interface. Clique em “Add Token” no token da API no centro pessoal, pegue a chave do token: sk-xxxxx e envie.

-

Obtenha a URL deste site: https://api.cometapi.com/

-

Selecione o endpoint Qwen2.5-Omni-7B para enviar a solicitação de API e defina o corpo da solicitação. O método de solicitação e o corpo da solicitação são obtidos de nosso site API doc. Nosso site também oferece o teste Apifox para sua conveniência.

-

Processe a resposta da API para obter a resposta gerada. Após enviar a solicitação da API, você receberá um objeto JSON contendo a conclusão gerada.