Nos dias 19 e 20 de novembro de 2025, a OpenAI lançou duas atualizações relacionadas, mas distintas: GPT-5.1-Codex-Max, um novo modelo de codificação agética para o Codex que enfatiza a codificação de longo horizonte, a eficiência de tokens e a “compactação” para sustentar sessões com múltiplas janelas; e GPT-5.1 Pro, um modelo ChatGPT de nível profissional atualizado, otimizado para respostas mais claras e eficazes em trabalhos complexos e profissionais.

O que é o GPT-5.1-Codex-Max e qual problema ele tenta resolver?

O GPT-5.1-Codex-Max é um modelo Codex especializado da OpenAI, otimizado para fluxos de trabalho de codificação que exigem raciocínio e execução sustentados e de longo prazoEnquanto os modelos comuns podem falhar devido a contextos extremamente longos — por exemplo, refatorações em vários arquivos, loops de agentes complexos ou tarefas persistentes de CI/CD — o Codex-Max foi projetado para Compactar e gerenciar automaticamente o estado da sessão em várias janelas de contexto., permitindo que continue funcionando de forma coerente, visto que um único projeto abrange milhares (ou mais) de tokens. A OpenAI posiciona o Codex-Max como o próximo passo para tornar agentes com capacidade de codificação verdadeiramente úteis para trabalhos de engenharia de grande escala.

O que é o GPT-5.1-Codex-Max e qual problema ele tenta resolver?

O GPT-5.1-Codex-Max é um modelo Codex especializado da OpenAI, otimizado para fluxos de trabalho de codificação que exigem raciocínio e execução sustentados e de longo prazoEnquanto os modelos comuns podem falhar devido a contextos extremamente longos — por exemplo, refatorações em vários arquivos, loops de agentes complexos ou tarefas persistentes de CI/CD — o Codex-Max foi projetado para Compactar e gerenciar automaticamente o estado da sessão em várias janelas de contexto., permitindo que continue funcionando de forma coerente, já que um único projeto abrange muitos milhares (ou mais) de tokens.

É descrito pela OpenAI como "mais rápido, mais inteligente e mais eficiente em termos de tokens em todas as etapas do ciclo de desenvolvimento" e destina-se explicitamente a substituir o GPT-5.1-Codex como modelo padrão nas superfícies do Codex.

Visão geral do recurso

- Compactação para continuidade entre múltiplas janelas: Elimina e preserva o contexto crítico para funcionar de forma coerente em milhões de tokens e ao longo de milhões de horas. 0

- Eficiência de tokens aprimorada em comparação com o GPT-5.1-Codex: Em alguns testes de desempenho de código, são necessários até 30% menos tokens de raciocínio para um esforço semelhante.

- Durabilidade agentiva de longo prazo: Internamente, observou-se a capacidade de sustentar ciclos de agentes de várias horas/vários dias (a OpenAI documentou execuções internas com duração superior a 24 horas).

- Integrações de plataforma: Disponível hoje no Codex CLI, extensões de IDE, nuvem e ferramentas de revisão de código; acesso à API em breve.

- Suporte ao ambiente Windows: A OpenAI destaca especificamente que o Windows agora é compatível pela primeira vez com os fluxos de trabalho do Codex, ampliando o alcance real dos desenvolvedores.

Como se compara a produtos concorrentes (por exemplo, GitHub Copilot, outras IAs de programação)?

O GPT-5.1-Codex-Max é apresentado como um colaborador mais autônomo e de longo prazo em comparação com ferramentas de autocompletar sob demanda. Embora o Copilot e assistentes similares se destaquem em autocompletar tarefas de curto prazo dentro do editor, os pontos fortes do Codex-Max residem na orquestração de tarefas com várias etapas, na manutenção de um estado coerente entre sessões e no gerenciamento de fluxos de trabalho que exigem planejamento, testes e iteração. Dito isso, a melhor abordagem na maioria das equipes será híbrida: usar o Codex-Max para automação complexa e tarefas contínuas do agente e usar assistentes mais leves para autocompletar tarefas em nível de linha.

Como funciona o GPT-5.1-Codex-Max?

O que é “compactação” e como ela possibilita trabalhos de longa duração?

Um dos principais avanços técnicos é compactação—um mecanismo interno que elimina o histórico da sessão, preservando os elementos relevantes do contexto para que o modelo possa continuar a funcionar de forma coerente. múltiplo janelas de contexto. Na prática, isso significa que as sessões do Codex que se aproximam do limite de contexto serão compactadas (tokens mais antigos ou de menor valor serão resumidos/preservados) para que o agente tenha uma nova janela e possa continuar iterando repetidamente até que a tarefa seja concluída. A OpenAI relata execuções internas em que o modelo trabalhou em tarefas continuamente por mais de 24 horas.

Raciocínio adaptativo e eficiência de tokens

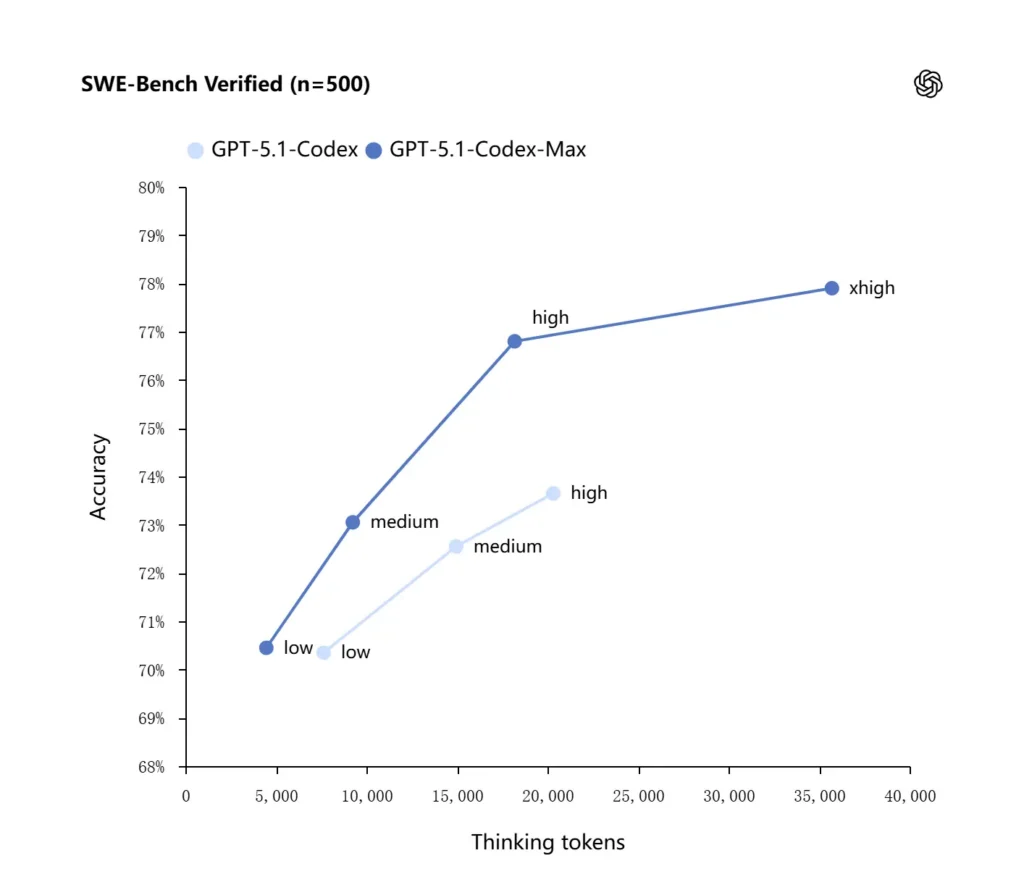

O GPT-5.1-Codex-Max aplica estratégias de raciocínio aprimoradas que o tornam mais eficiente em termos de tokens: nos benchmarks internos da OpenAI, o modelo Max alcança desempenho semelhante ou superior ao do GPT-5.1-Codex, utilizando um número significativamente menor de tokens de "pensamento" — a OpenAI cita aproximadamente 30% menos O modelo verifica a compatibilidade dos tokens de raciocínio no SWE-bench quando executado com o mesmo esforço de raciocínio. Ele também introduz um modo de esforço de raciocínio "Extra Alto (xhigh)" para tarefas não sensíveis à latência, que permite o uso de mais raciocínio interno para obter resultados de maior qualidade.

Integrações de sistemas e ferramentas de agentes

O Codex-Max está sendo distribuído dentro dos fluxos de trabalho do Codex (CLI, extensões de IDE, nuvem e plataformas de revisão de código) para que possa interagir com as ferramentas de desenvolvimento reais. As primeiras integrações incluem a CLI do Codex e os agentes de IDE (VS Code, JetBrains, etc.), com acesso à API planejado para breve. O objetivo do projeto não é apenas uma síntese de código mais inteligente, mas uma IA capaz de executar fluxos de trabalho com várias etapas: abrir arquivos, executar testes, corrigir falhas, refatorar e executar novamente.

Qual o desempenho do GPT-5.1-Codex-Max em testes de benchmark e em tarefas reais?

Raciocínio sustentado e tarefas de longo prazo

As avaliações apontam para melhorias mensuráveis no raciocínio sustentado e em tarefas de longo prazo:

- Avaliações internas da OpenAIO Codex-Max consegue trabalhar em tarefas por "mais de 24 horas" em experimentos internos, e a integração do Codex com ferramentas de desenvolvimento aumentou as métricas internas de produtividade da engenharia (por exemplo, uso e taxa de transferência de pull requests). Essas são afirmações internas da OpenAI e indicam melhorias na produtividade em nível de tarefa no mundo real.

- **Avaliações independentes (METR)**O relatório independente da METR mediu o horizonte temporal observado de 50% (uma estatística que representa o tempo mediano que o modelo consegue manter uma tarefa longa de forma coerente) para GPT-5.1-Codex-Max em torno de 2 horas 40 minutos (com um amplo intervalo de confiança), um aumento em relação às 2 horas e 17 minutos do GPT-5 em medições comparáveis — uma melhoria significativa e consistente na coerência sustentada. A metodologia e o intervalo de confiança da METR enfatizam a variabilidade, mas o resultado corrobora a ideia de que o Codex-Max melhora o desempenho prático a longo prazo.

Referências de código

A OpenAI relata resultados aprimorados em avaliações de codificação de ponta, notavelmente no SWE-bench Verified, onde o GPT-5.1-Codex-Max supera o GPT-5.1-Codex com melhor eficiência de tokens. A empresa destaca que, para o mesmo esforço de raciocínio "médio", o modelo Max produz melhores resultados usando aproximadamente 30% menos tokens de pensamento; para usuários que permitem raciocínio interno mais longo, o modo xhigh pode elevar ainda mais as respostas, ao custo de latência.

| GPT‑5.1-Codex (alto) | GPT‑5.1-Codex-Max (xhigh) | |

| Verificado por SWE-bench (n=500) | 73.7% | 77.9% |

| SWE-Lancer IC SWE | 66.3% | 79.9% |

| Bancada de terminais 2.0 | 52.8% | 58.1% |

Como o GPT-5.1-Codex-Max se compara ao GPT-5.1-Codex?

Diferenças de desempenho e propósito

- Escopo: O GPT-5.1-Codex era uma variante de codificação de alto desempenho da família GPT-5.1; Codex-Max É explicitamente um sucessor de longo prazo, com foco na capacidade de atuação do usuário, destinado a ser o padrão recomendado para o Codex e ambientes semelhantes ao Codex.

- Eficiência do token: O Codex-Max demonstra ganhos de eficiência em tokens materiais (alegação da OpenAI de redução de aproximadamente 30% no uso de tokens de pensamento) no SWE-bench e em uso interno.

- Gerenciamento de contexto: O Codex-Max introduz compactação e gerenciamento nativo de múltiplas janelas para suportar tarefas que excedem uma única janela de contexto; o Codex não fornecia essa capacidade nativamente na mesma escala.

- Preparação das ferramentas: O Codex-Max é fornecido como o modelo Codex padrão em toda a CLI, IDE e superfícies de revisão de código, sinalizando uma migração para fluxos de trabalho de desenvolvedores em produção.

Quando usar cada modelo?

- Use o Codex GPT-5.1 Para assistência interativa na codificação, edições rápidas, pequenas refatorações e casos de uso de baixa latência, onde todo o contexto relevante cabe facilmente em uma única janela.

- Use GPT-5.1-Codex-Max Para refatorações de múltiplos arquivos, tarefas automatizadas que exigem muitos ciclos de iteração, fluxos de trabalho semelhantes a CI/CD ou quando você precisa que o modelo mantenha uma perspectiva em nível de projeto em diversas interações.

Padrões práticos de instruções e exemplos para obter os melhores resultados?

Padrões de estímulo que funcionam bem

- Seja explícito quanto aos objetivos e restrições: “Refatorar X, preservar a API pública, manter os nomes das funções e garantir que os testes A, B e C sejam aprovados.”

- Forneça um contexto mínimo reproduzível: Forneça um link para o teste com falha, inclua rastreamentos de pilha e trechos de arquivos relevantes em vez de despejar repositórios inteiros. O Codex-Max compactará o histórico conforme necessário.

- Utilize instruções passo a passo para tarefas complexas: Divida tarefas grandes em uma sequência de subtarefas e deixe o Codex-Max iterar por elas (por exemplo, “1) executar testes 2) corrigir os 3 principais testes com falha 3) executar o linter 4) resumir as alterações”).

- Peça explicações e diferenças: Solicite tanto a correção quanto uma breve justificativa para que os revisores humanos possam avaliar rapidamente a segurança e a intenção.

Exemplos de modelos de prompts

Tarefa de refatoração

“Refatorar o

payment/módulo para extrair o processamento de pagamentos empayment/processor.pyMantenha as assinaturas das funções públicas estáveis para os chamadores existentes. Crie testes unitários paraprocess_payment()que abrangem sucesso, falha de rede e cartão inválido. Execute o conjunto de testes e retorne os testes com falha e um patch em formato diff unificado.”

Correção de bugs + teste

“Um teste

tests/test_user_auth.py::test_token_refreshfalha com traceback . Investigue a causa raiz, proponha uma correção com alterações mínimas e adicione um teste unitário para evitar regressão. Aplique o patch e execute os testes.

Geração iterativa de RP

“Implementar a funcionalidade X: adicionar ponto de extremidade

POST /api/exportque transmite resultados de exportação e é autenticado. Crie o endpoint, adicione a documentação, crie testes e abra um PR com um resumo e uma lista de verificação dos itens manuais.”

Para a maioria deles, comece com média esforço; mudar para xhigh Quando você precisa que o modelo realize raciocínio complexo em diversos arquivos e múltiplas iterações de teste.

Como acessar o GPT-5.1-Codex-Max

Onde está disponível hoje

A OpenAI integrou o GPT-5.1-Codex-Max em Ferramentas Codex Atualmente: a CLI do Codex, as extensões de IDE, a nuvem e os fluxos de revisão de código usam o Codex-Max por padrão (você pode optar pelo Codex-Mini). A disponibilidade da API ainda precisa ser preparada; o GitHub Copilot possui prévias públicas que incluem os modelos GPT-5.1 e da série Codex.

Os desenvolvedores podem acessar o GPT-5.1-Codex-Max e API GPT-5.1-Codex por meio da CometAPI. Para começar, explore os recursos do modelo deCometAPI no Playground e consulte o guia da API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login na CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Pronto para ir?→ Inscreva-se no CometAPI hoje mesmo !

Se você quiser saber mais dicas, guias e novidades sobre IA, siga-nos em VK, X e Discord!

Início rápido (passo a passo prático)

- Certifique-se de ter acesso: Confirme se o seu plano de produto ChatGPT/Codex (Plus, Pro, Business, Edu, Enterprise) ou o seu plano de API de desenvolvedor é compatível com os modelos da família GPT-5.1/Codex.

- Instale a extensão Codex CLI ou IDE: Se você deseja executar tarefas de código localmente, instale a CLI do Codex ou a extensão Codex IDE para VS Code / JetBrains / Xcode, conforme aplicável. As ferramentas usarão por padrão o GPT-5.1-Codex-Max em configurações compatíveis.

- Escolha o nível de esforço de raciocínio: começar com média esforço para a maioria das tarefas. Para depuração profunda, refatorações complexas ou quando você deseja que o modelo pense mais e não se importa com a latência de resposta, mude para Alto or xhigh modos. Para pequenos ajustes rápidos, baixo é razoável.

- Forneça o contexto do repositório: Forneça ao modelo um ponto de partida claro — um URL de repositório ou um conjunto de arquivos e uma breve instrução (por exemplo, “refatorar o módulo de pagamento para usar E/S assíncrona e adicionar testes unitários, mantendo contratos em nível de função”). O Codex-Max compactará o histórico à medida que se aproximar dos limites de contexto e continuará a tarefa.

- Iterar com testes: Após o modelo gerar correções, execute conjuntos de testes e retorne os resultados das falhas como parte da sessão em andamento. A compactação e a continuidade entre múltiplas janelas permitem que o Codex-Max retenha o contexto importante dos testes com falha e continue iterando.

Conclusão:

O GPT-5.1-Codex-Max representa um avanço substancial em direção a assistentes de codificação ágeis que podem executar tarefas de engenharia complexas e de longa duração com maior eficiência e raciocínio. Os avanços técnicos (compactação, modos de esforço de raciocínio, treinamento em ambiente Windows) o tornam excepcionalmente adequado para organizações de engenharia modernas — desde que as equipes combinem o modelo com controles operacionais conservadores, políticas claras de intervenção humana e monitoramento robusto. Para equipes que o adotam com cuidado, o Codex-Max tem o potencial de transformar a maneira como o software é projetado, testado e mantido — convertendo o trabalho repetitivo de engenharia em uma colaboração de maior valor entre humanos e modelos.