No mundo da inteligência artificial, em rápido desenvolvimento, o lançamento de cada novo modelo de grande linguagem (LLM) representa mais do que um aumento na versão numérica — sinaliza progresso no raciocínio, na capacidade de codificação e na colaboração entre humanos e máquinas. No final de setembro de 2025, Zhipu AI (Z.ai) revelou GLM-4.6, o mais novo membro da família do Modelo de Linguagem Geral. Com base na arquitetura robusta e na sólida base de raciocínio do GLM-4.5, esta atualização aprimora as capacidades do modelo em raciocínio agêntico, inteligência de codificação e compreensão de longo contexto, permanecendo aberto e acessível tanto para desenvolvedores quanto para empresas.

O que é GLM-4.6?

O GLM-4.6 é uma versão importante da série GLM (General Language Model), projetada para equilibrar raciocínio de alta capacidade com fluxos de trabalho práticos para desenvolvedores. Em um nível mais amplo, a versão visa três casos de uso intimamente relacionados: (1) geração avançada de código e raciocínio sobre código, (2) tarefas de contexto estendido que exigem a compreensão do modelo em entradas muito longas e (3) fluxos de trabalho agênticos, nos quais o modelo deve planejar, chamar ferramentas e orquestrar processos de várias etapas. O modelo é entregue em variantes destinadas a APIs de nuvem e hubs de modelos de comunidade, permitindo padrões de implantação hospedados e auto-hospedados.

Na prática, o GLM-4.6 se posiciona como um carro-chefe "primeiro o desenvolvedor": suas melhorias não se referem apenas a números brutos de benchmark, mas também a recursos que mudam substancialmente a forma como os desenvolvedores criam assistentes, copilotos de código e agentes baseados em documentos ou conhecimento. Espere uma versão com ênfase no ajuste de instruções para o uso de ferramentas, melhorias refinadas na qualidade e depuração do código e opções de infraestrutura que permitam contextos muito longos sem degeneração linear no desempenho.

O que o GLM-4.6 pretende resolver?

- Reduza o atrito de trabalhar com longas bases de código e documentos grandes oferecendo suporte a janelas de contexto mais longas e eficazes.

- Melhore a confiabilidade da geração e depuração de código, produzindo saídas mais idiomáticas e testáveis.

- Aumente a robustez dos comportamentos de agente — planejamento, uso de ferramentas e execução de tarefas em várias etapas — por meio de instruções direcionadas e ajuste no estilo de reforço.

Do GLM-4.5 para o GLM-4.6, o que mudou na prática?

- Escala de contexto: 128K pular para 200 mil fichas é a maior mudança de UX/arquitetura para os usuários: documentos longos, bases de código inteiras ou transcrições estendidas de agentes agora podem ser processados como uma única janela de contexto. Isso reduz a necessidade de agrupamentos ad hoc ou loops de recuperação caros para muitos fluxos de trabalho.

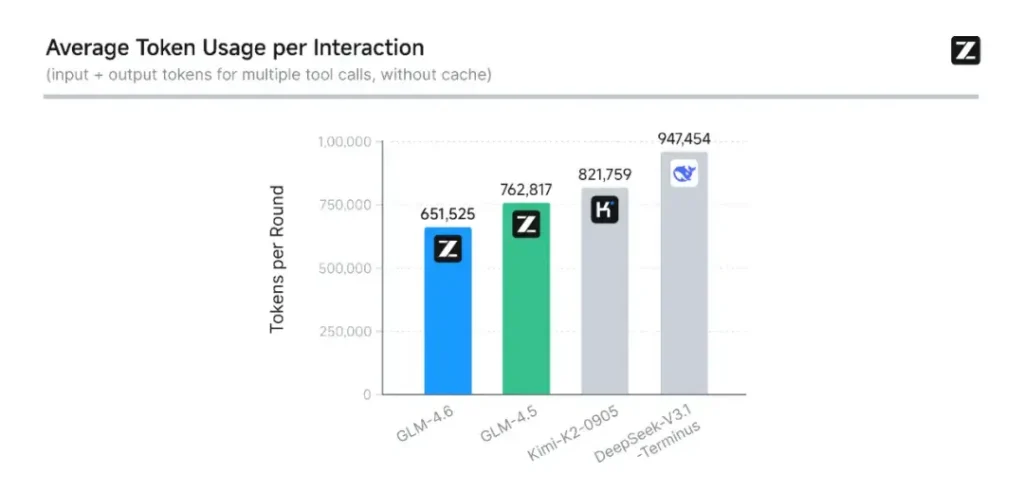

- Codificação e avaliação no mundo real: Z.ai estendeu o CC-Bench (seu benchmark de codificação e conclusão) com trajetórias de tarefas reais mais difíceis e relata que o GLM-4.6 conclui tarefas com ~15% menos tokens do que o GLM-4.5, ao mesmo tempo em que melhora as taxas de sucesso em tarefas complexas de engenharia multi-turno. Isso sinaliza maior eficiência de token, bem como melhorias na capacidade bruta em cenários de codificação aplicada. Z.ai

- Integração de agente e ferramenta: O GLM-4.6 inclui melhores padrões de suporte para chamadas de ferramentas e agentes de pesquisa, o que é importante para produtos que dependem do modelo para orquestrar pesquisas na web, execução de código ou outros microsserviços.

Quais são os principais recursos do GLM-4.6?

1. Janela de contexto estendida para 200 mil tokens

Um dos recursos mais chamativos do GLM-4.6 é seu janela de contexto massivamente estendida. Expandindo de 128K na geração anterior para 200 mil fichasO GLM-4.6 pode processar livros inteiros, conjuntos de dados complexos de vários documentos ou horas de diálogo em uma única sessão. Essa expansão não apenas melhora a compreensão, mas também permite raciocínio consistente em entradas longas — um grande salto para sumarização de documentos, análise jurídica e fluxos de trabalho de engenharia de software.

2. Inteligência de codificação aprimorada

Interno da Zhipu AI CC-Banco benchmark, um conjunto de tarefas de programação do mundo real, mostra que o GLM-4.6 alcança melhorias notáveis na precisão e eficiência da codificação. O modelo pode produzir código sintaticamente correto e logicamente sólido ao usar aproximadamente 15% menos tokens do que o GLM-4.5 para tarefas equivalentes. Essa eficiência simbólica significa conclusões mais rápidas e baratas sem sacrificar a qualidade — um fator vital para a implantação empresarial.

3. Raciocínio Avançado e Integração de Ferramentas

Além da geração de texto bruto, o GLM-4.6 brilha em raciocínio aumentado por ferramentas. Ele foi treinado e alinhado para planejamento em várias etapas e para orquestrar sistemas externos — de bancos de dados a ferramentas de busca e ambientes de execução. Na prática, isso significa que o GLM-4.6 pode atuar como o "cérebro" de um agente de IA autônomo, decidindo quando chamar APIs externas, como interpretar resultados e como manter a continuidade das tarefas entre as sessões.

4. Alinhamento de linguagem natural aprimorado

Por meio do aprendizado de reforço contínuo e da otimização de preferências, o GLM-4.6 oferece fluxo de conversação mais suave, melhor correspondência de estilo e alinhamento de segurança mais forte. O modelo adapta seu tom e estrutura para se adequar ao contexto — seja documentação formal, tutoria educacional ou escrita criativa — melhorando a confiança e a legibilidade do usuário.

Qual arquitetura alimenta o GLM-4.6?

O GLM-4.6 é um modelo de mistura de especialistas?

Continuidade do método de inferência: A equipe do GLM indica que o GLM-4.5 e o GLM-4.6 compartilham o mesmo pipeline de inferência fundamental, permitindo que as configurações de implantação existentes sejam atualizadas com o mínimo de atrito. Isso reduz o risco operacional para equipes que já utilizam o GLM-4.x — parâmetros de escala e escolhas de design de modelo que enfatizam a especialização para raciocínio agêntico, codificação e inferência eficiente. O relatório do GLM-4.5 fornece a descrição pública mais clara da estratégia e do regime de treinamento do MoE da família (pré-treinamento em vários estágios, iteração do modelo especialista, aprendizado por reforço para alinhamento); o GLM-4.6 aplica essas lições enquanto ajusta a duração do contexto e as capacidades específicas da tarefa.

Notas práticas de arquitetura para engenheiros

- Pegada de parâmetro vs. computação ativada: Grandes totais de parâmetros (centenas de bilhões) não se traduzem diretamente em custo de ativação equivalente em cada solicitação — MoE significa que apenas um subconjunto de especialistas é ativado por sequência de tokens, proporcionando uma compensação de custo/rendimento mais favorável para muitas cargas de trabalho.

- Precisão e formatos de token: Os pesos públicos são distribuídos nos formatos BF16 e F32, e as quantizações da comunidade (GGUF, 4-/8-/bits) estão aparecendo rapidamente; elas permitem que as equipes executem o GLM-4.6 em perfis de hardware variados.

- Compatibilidade da pilha de inferência: O Z.ai documenta o vLLM e outros tempos de execução LLM modernos como backends de inferência compatíveis, o que torna o GLM-4.6 viável para implantações na nuvem e no local.

Desempenho de referência: como o GLM-4.6 se sai?

Quais benchmarks foram relatados?

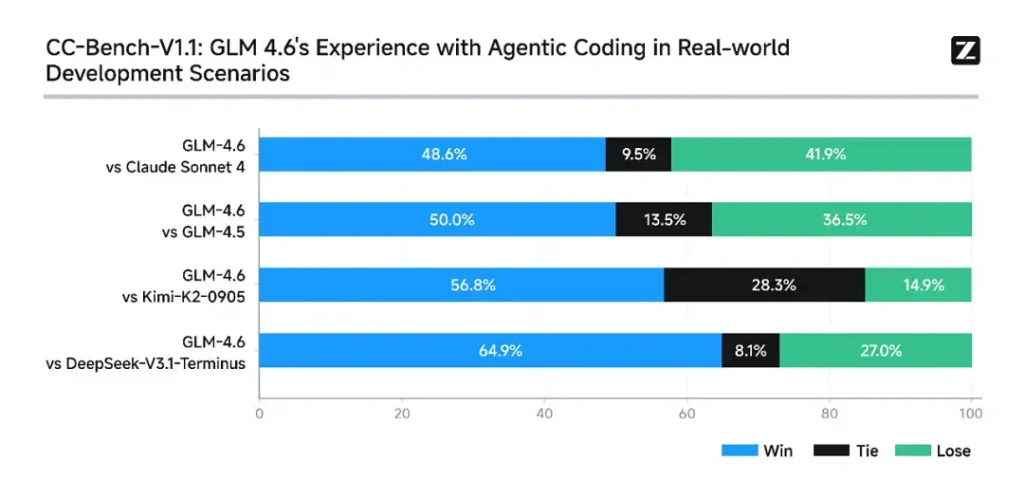

A Z.ai avaliou o GLM-4.6 em um conjunto de oito benchmarks públicos abrangendo tarefas de agente, raciocínio e codificação. Eles também estenderam o CC-Bench (um benchmark de codificação de tarefas reais, avaliado por humanos e executado em ambientes isolados do Docker) para simular melhor tarefas de engenharia de produção (desenvolvimento front-end, testes, resolução de problemas algorítmicos). Nessas tarefas, o GLM-4.6 apresentou melhorias consistentes em relação ao GLM-4.5.

Desempenho de codificação

- Vitórias em tarefas reais: Nas avaliações humanas do CC-Bench, o GLM-4.6 atingiu quase paridade com Claude Sonnet 4 da Anthropic em tarefas frente a frente e em várias voltas - Z.ai relata um 48.6% de taxa de vitória em suas avaliações isoladas do Docker e julgadas por humanos (interpretação: quase 50/50 com Claude Sonnet 4 em seu conjunto selecionado). Ao mesmo tempo, o GLM-4.6 superou vários modelos abertos domésticos (por exemplo, variantes do DeepSeek) em suas tarefas.

- Eficiência do token: Relatórios Z.ai ~15% menos tokens usado para concluir tarefas em comparação com o GLM-4.5 em trajetórias CC-Bench — isso é importante tanto para latência quanto para custo.

Raciocínio e matemática

O GLM-4.6 afirma melhorar a capacidade de raciocínio e melhorar o desempenho no uso de ferramentas em comparação com o GLM 4.5. Enquanto o GLM 4.5 enfatizava os modos híbridos de "pensamento" e resposta direta, o GLM 4.6 aumenta a robustez para o raciocínio em várias etapas, especialmente quando integrado a ferramentas de busca ou execução.

As mensagens públicas da Z.ai posicionam o GLM-4.6 como competitivo com os principais modelos nacionais e internacionais em seus benchmarks escolhidos — especificamente, competitivo com o Claude Sonnet 4 e superando certas alternativas nacionais, como variantes do DeepSeek, em tarefas de código/agente. Mas em alguns subbenchmarks específicos de codificação**, o GLM-4.6 ainda está atrás do Claude Sonnet 4.5 (uma versão mais recente do Anthropic), tornando o cenário de competição acirrada em vez de domínio absoluto.

Como acessar o GLM-4.6

- 1. Através da Plataforma Z.ai: Os desenvolvedores podem acessar o GLM-4.6 diretamente via API da Z.ai or interface de bate-papo (chat.z.ai). Esses serviços hospedados permitem experimentação e integração rápidas, sem implantação local. A API suporta os modos de preenchimento de texto padrão e de chamada de ferramentas estruturada — essenciais para fluxos de trabalho com agentes.

- 2. Pesos abertos no rosto abraçado e no ModelScope: Para aqueles que preferem o controle local, a Zhipu AI lançou os arquivos do modelo GLM-4.6 em Abraçando o rosto e ModelScope, incluindo versões de tensores de segurança em BF16 e F32 precisão. Desenvolvedores da comunidade já produziram versões quantizadas do GGUF, permitindo inferência em GPUs de nível de consumidor.

- 3. Estruturas de integração: O GLM-4.6 integra-se perfeitamente com os principais mecanismos de inferência, como vLLM, SGLang e Implantação LM, tornando-o adaptável a pilhas de serviço modernas. Essa versatilidade permite que as empresas escolham entre Nuvem, Beira e implantação no local dependendo dos requisitos de conformidade ou latência.

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

A integração mais recente, GLM-4.6, aparecerá em breve no CometAPI, então fique ligado! Enquanto finalizamos o upload do modelo GLM 4.6, explore nossos outros modelos na página Modelos ou experimente-os no AI Playground.

Os desenvolvedores podem acessar API GLM‑4.5 através do CometAPI, a versão mais recente do modelo está sempre atualizado com o site oficial. Para começar, explore as capacidades do modelo no Playground e consulte o Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

Pronto para ir?→ Inscreva-se no CometAPI hoje mesmo !

Conclusão — Por que o GLM-4.6 é importante agora

O GLM-4.6 é um marco importante na linha GLM porque reúne melhorias práticas para desenvolvedores — janelas de contexto mais longas, codificação direcionada e otimizações agentísticas, além de ganhos tangíveis em benchmarks — com a abertura e a flexibilidade do ecossistema que muitas organizações desejam. Para equipes que criam assistentes de código, agentes de documentos longos ou automações habilitadas por ferramentas, o GLM-4.6 vale a pena ser avaliado como um dos principais candidatos.