GPT-5.2 é a versão pontual de dezembro de 2025 da família GPT-5 da OpenAI: uma família multimodal de modelos de ponta (texto + visão + ferramentas) ajustada para trabalho profissional de conhecimento, raciocínio com contexto longo, uso agente de ferramentas e engenharia de software. A OpenAI posiciona o GPT-5.2 como o modelo mais capaz da série GPT-5 até hoje e afirma que foi desenvolvido com ênfase em raciocínio confiável de múltiplas etapas, manipulação de documentos muito grandes e segurança/conformidade de políticas aprimoradas; o lançamento inclui três variantes voltadas ao usuário — Instant, Thinking e Pro — e está sendo disponibilizado primeiro para assinantes pagos do ChatGPT e clientes da API.

O que é o GPT-5.2 e por que isso importa?

GPT-5.2 é o membro mais recente da família GPT-5 — uma nova série de modelos “fronteira” projetada especificamente para fechar a lacuna entre assistentes conversacionais de uma única interação e sistemas que precisam raciocinar sobre documentos longos, chamar ferramentas, interpretar imagens e executar fluxos de trabalho de várias etapas de forma confiável. A OpenAI posiciona o 5.2 como seu lançamento mais capaz até agora para trabalho profissional de conhecimento: ele estabelece novos resultados state-of-the-art em benchmarks internos (notavelmente um novo benchmark GDPval para trabalho de conhecimento), demonstra desempenho de codificação mais forte em benchmarks de engenharia de software e oferece melhorias significativas em capacidades de contexto longo e visão.

Na prática, o GPT-5.2 é mais do que apenas “um modelo de chat maior”. É uma família de três variantes ajustadas (Instant, Thinking, Pro) que equilibram latência, profundidade de raciocínio e custo — e que, junto com a API da OpenAI e o roteamento do ChatGPT, podem ser usadas para executar pesquisas longas, construir agentes que chamam ferramentas externas, interpretar imagens e gráficos complexos e gerar código de nível de produção com fidelidade mais alta do que lançamentos anteriores. O modelo oferece janelas de contexto muito grandes (os documentos da OpenAI listam uma janela de contexto de 400.000 tokens e um limite de saída máxima de 128.000 para os modelos carro-chefe), novos recursos de API para níveis explícitos de esforço de raciocínio e comportamento de invocação de ferramentas “agente”.

5 capacidades centrais aprimoradas no GPT-5.2

1) O GPT-5.2 é melhor em lógica e matemática de múltiplas etapas?

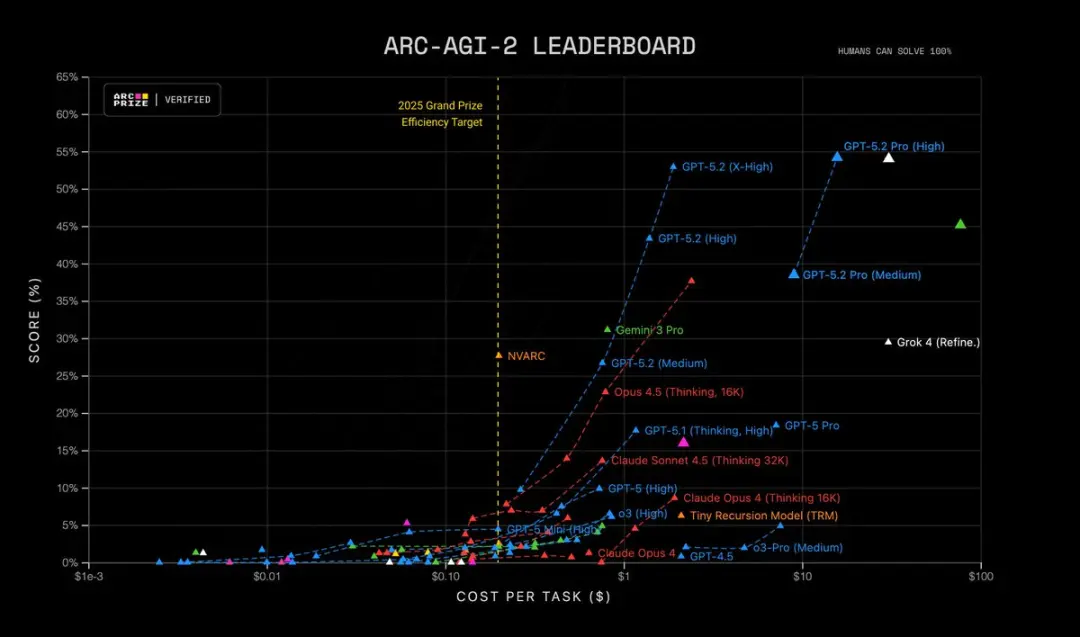

O GPT-5.2 traz raciocínio de múltiplas etapas mais afiado e desempenho visivelmente mais forte em matemática e resolução estruturada de problemas. A OpenAI diz que adicionou controle mais granular sobre o esforço de raciocínio (novos níveis como xhigh), engenhou suporte a “tokens de raciocínio” e ajustou o modelo para manter o chain-of-thought em trilhas internas de raciocínio mais longas. Benchmarks como FrontierMath e testes no estilo ARC-AGI mostram ganhos substanciais em relação ao GPT-5.1; há margens maiores em benchmarks específicos de domínio usados em fluxos de trabalho científicos e financeiros. Em resumo: o GPT-5.2 “pensa por mais tempo” quando solicitado e consegue trabalhos simbólicos/matemáticos mais complicados com melhor consistência.

| RC-AGI-1 (Verificado) Raciocínio abstrato | 86.2% | 72.8% |

|---|---|---|

| ARC-AGI-2 (Verificado) Raciocínio abstrato | 52.9% | 17.6% |

O GPT-5.2 Thinking estabelece recordes em vários testes avançados de ciência e raciocínio matemático:

- GPQA Diamond Science Quiz: 92.4% (versão Pro 93.2%)

- ARC-AGI-1 Raciocínio Abstrato: 86.2% (primeiro modelo a romper o patamar de 90%)

- ARC-AGI-2 Raciocínio de Ordem Superior: 52.9%, estabelecendo um novo recorde para o modelo Thinking Chain

- FrontierMath Teste de Matemática Avançada: 40.3%, superando em muito seu predecessor;

- HMMT Problemas de Competição de Matemática: 99.4%

- AIME Teste de Matemática: 100% Solução Completa

Além disso, o GPT-5.2 Pro (High) é state-of-the-art no ARC-AGI-2, atingindo uma pontuação de 54.2% a um custo de US$15.72 por tarefa! Superando todos os outros modelos.

Por que isso importa: muitas tarefas do mundo real — modelagem financeira, design de experimentos, síntese de programas que exigem raciocínio formal — são limitadas pela capacidade do modelo de encadear muitos passos corretos. O GPT-5.2 reduz “passos alucinados” e produz trilhas intermediárias de raciocínio mais estáveis quando você pede para mostrar o procedimento.

2) Como melhorou a compreensão de texto longo e o raciocínio entre documentos?

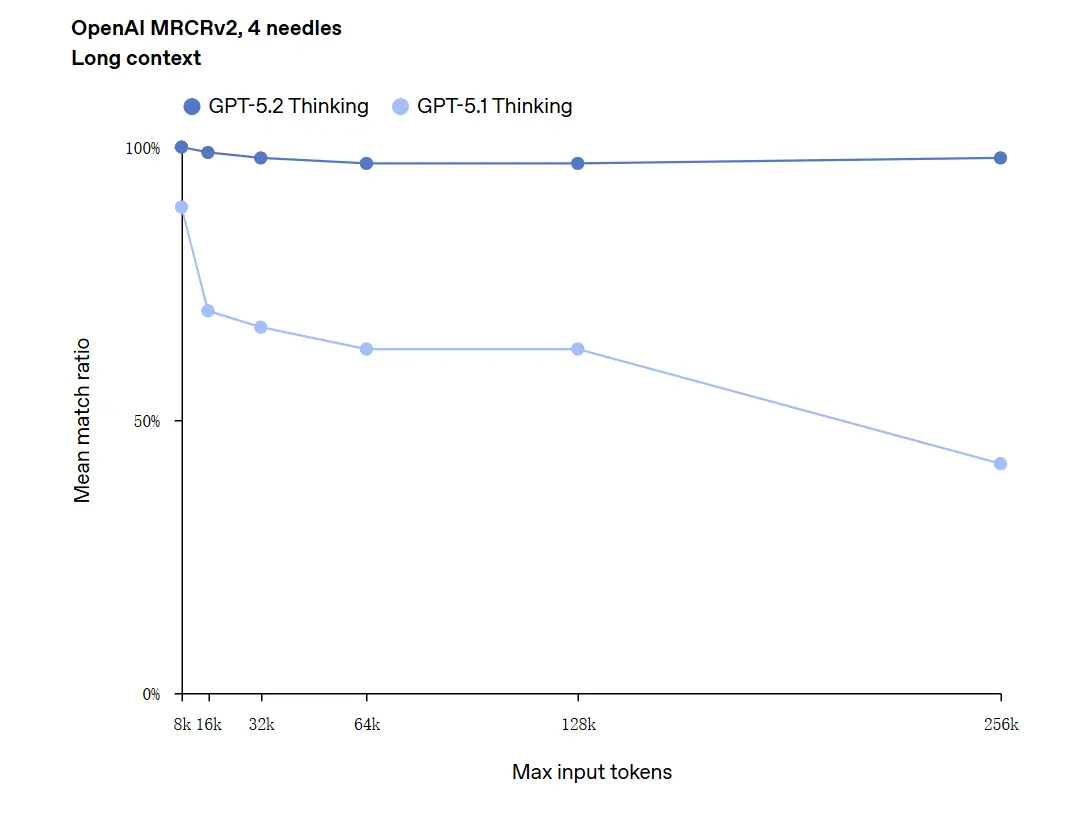

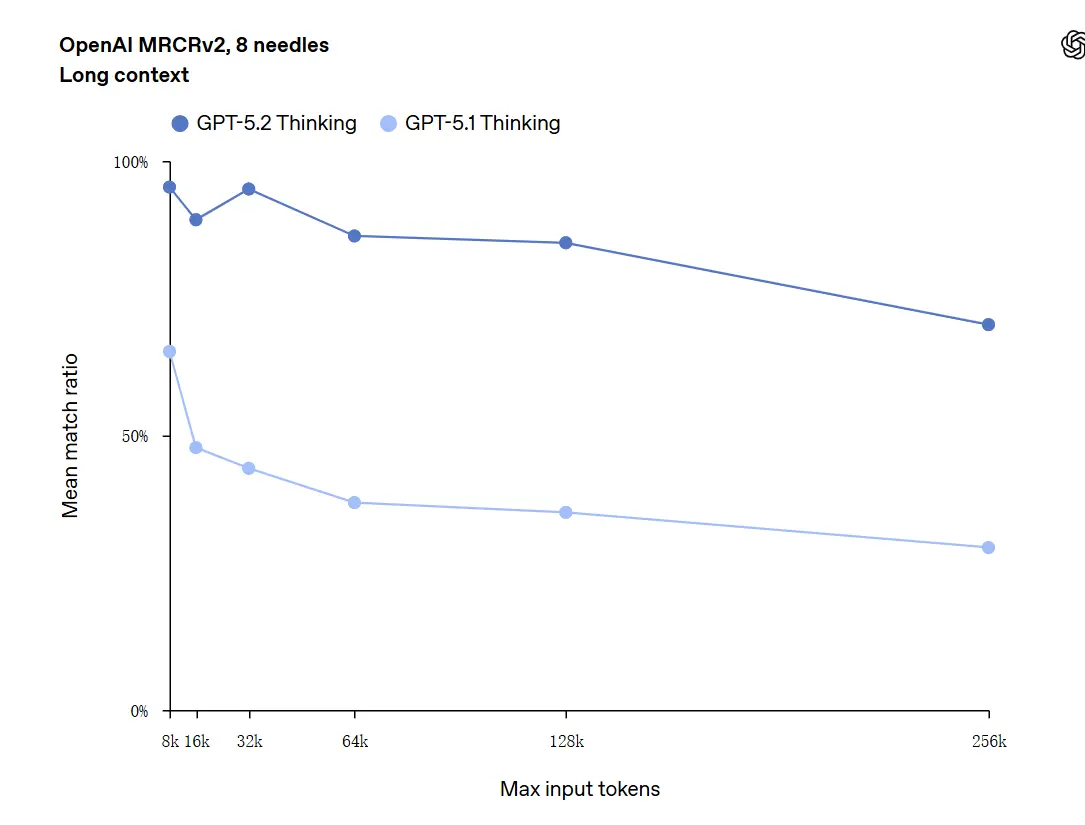

Entendimento de contexto longo é uma das melhorias de destaque. O modelo subjacente do GPT-5.2 suporta uma janela de contexto de 400 mil tokens e — importante — mantém maior acurácia à medida que o conteúdo relevante se desloca para o fundo desse contexto. GDPval, um conjunto de tarefas para “trabalho de conhecimento bem especificado” em 44 ocupações, onde o GPT-5.2 Thinking atinge paridade ou supera juízes humanos especialistas em uma grande parcela de tarefas. Relatos independentes confirmam que o modelo mantém e sintetiza informações em muitos documentos muito melhor do que modelos anteriores. Isso é um avanço realmente prático para tarefas como due diligence, sumarização jurídica, revisões de literatura e compreensão de bases de código.

O GPT-5.2 pode lidar com contextos de até 256.000 tokens (aproximadamente 200+ páginas de documentos). Além disso, no teste de compreensão de texto longo "OpenAI MRCRv2", o GPT-5.2 Thinking alcançou uma taxa de acerto próxima de 100%.

Advertência sobre “100% de precisão”: As melhorias foram descritas como “aproximando-se de 100%” para microtarefas estreitas; os dados da OpenAI são melhor descritos como “state-of-the-art e em muitos casos iguais ou acima dos níveis de especialistas humanos nas tarefas avaliadas”, não literalmente perfeitos em todos os usos. Os benchmarks mostram grandes ganhos, mas não perfeição universal.

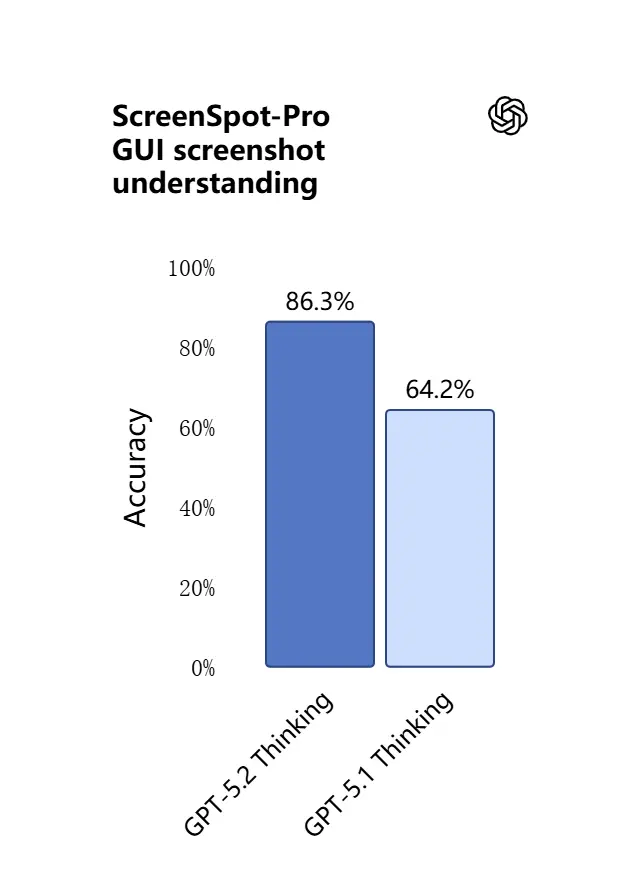

3) O que há de novo em compreensão visual e raciocínio multimodal?

As capacidades de visão no GPT-5.2 estão mais nítidas e práticas. O modelo está melhor em interpretar capturas de tela, ler gráficos e tabelas, reconhecer elementos de IU e combinar entradas visuais com contexto textual longo. Não é apenas legendagem: o GPT-5.2 pode extrair dados estruturados de imagens (por exemplo, tabelas em um PDF), explicar gráficos e raciocinar sobre diagramas de maneiras que suportam ações de ferramentas downstream (por exemplo, gerar uma planilha a partir de um relatório fotografado).

.webp)

Efeito prático: equipes podem fornecer decks completos de slides, relatórios de pesquisa digitalizados ou documentos ricos em imagens diretamente ao modelo e solicitar sínteses entre documentos — reduzindo bastante o trabalho manual de extração.

4) Como mudaram a invocação de ferramentas e a execução de tarefas?

O GPT-5.2 avança ainda mais no comportamento agente: ele está melhor em planejar tarefas de múltiplas etapas, decidir quando chamar ferramentas externas e executar sequências de chamadas de API/ferramentas para concluir um trabalho de ponta a ponta. Melhorias em “agentic tool-calling” — o modelo proporá um plano, chamará ferramentas (bancos de dados, computação, sistemas de arquivos, navegador, executores de código) e sintetizará os resultados em um entregável final com mais confiabilidade do que modelos anteriores. A API introduz roteamento e controles de segurança (listas de ferramentas permitidas, scaffolding de ferramentas) e a interface do ChatGPT pode direcionar automaticamente solicitações para a variante 5.2 apropriada (Instant vs Thinking).

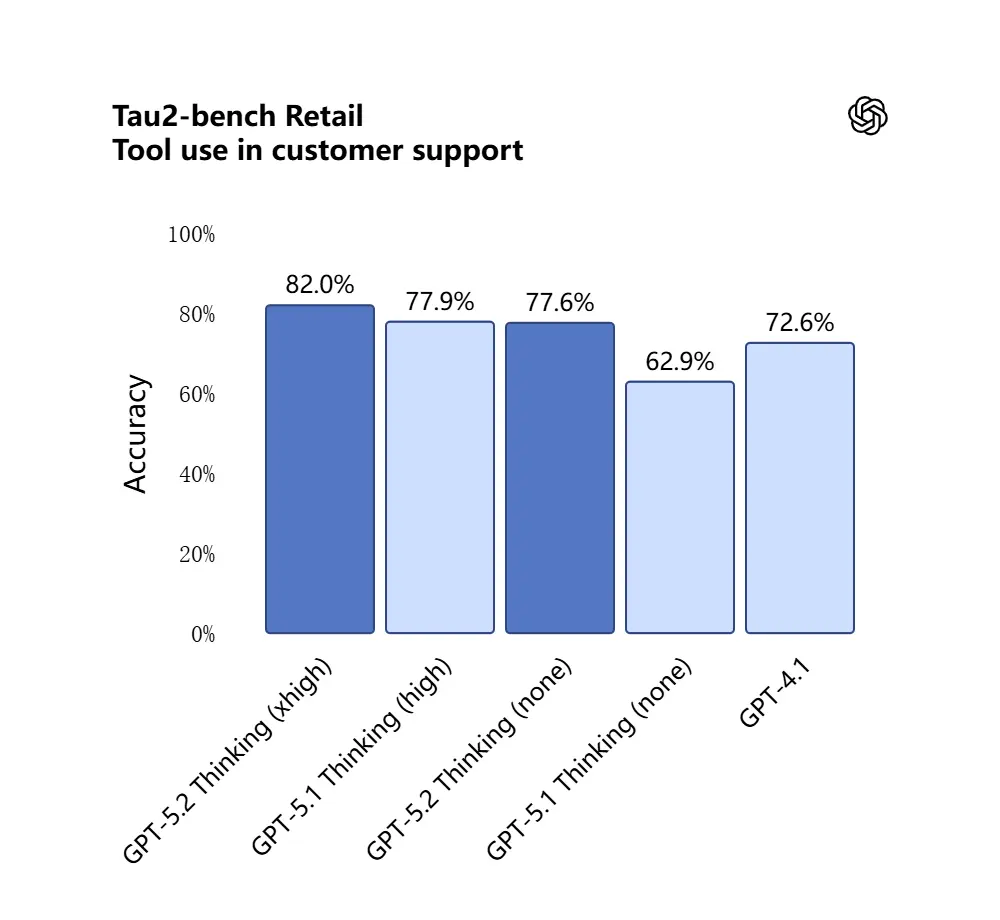

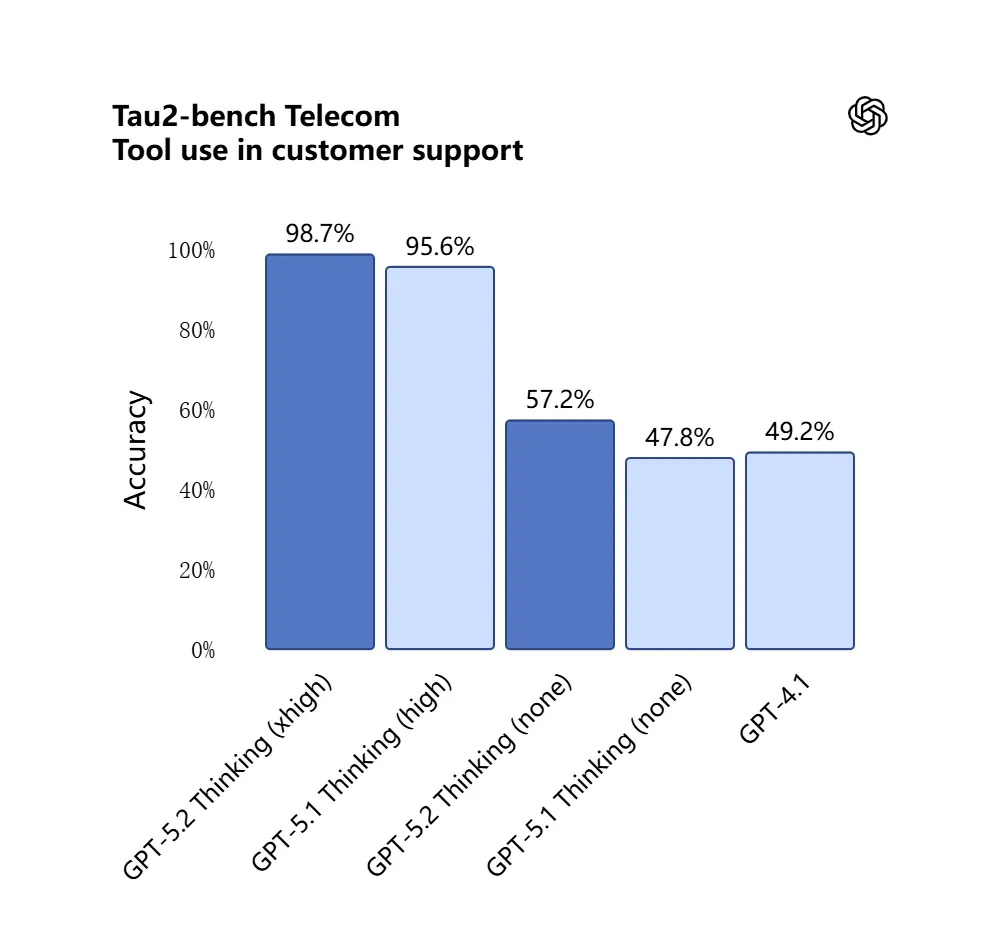

O GPT-5.2 obteve 98.7% no benchmark Tau2-Bench Telecom, demonstrando suas capacidades maduras de chamadas de ferramentas em tarefas complexas de múltiplas interações.

Por que isso importa: isso torna o GPT-5.2 mais útil como um assistente autônomo para fluxos de trabalho como “ingira estes contratos, extraia cláusulas, atualize uma planilha e escreva um e-mail-resumo” — tarefas que antes precisavam de orquestração cuidadosa.

5) Capacidade de programação evoluiu

O GPT-5.2 está significativamente melhor em tarefas de engenharia de software: escreve módulos mais completos, gera e executa testes com mais confiabilidade, compreende gráficos de dependências de projetos complexos e é menos propenso a “preguiça de código” (pular boilerplate ou deixar de conectar módulos). Em benchmarks de codificação de nível industrial (SWE-bench Pro, etc.) o GPT-5.2 estabelece novos recordes. Para equipes que usam LLMs como pares-programadores, essa melhoria pode reduzir a verificação manual e o retrabalho necessários após a geração.

No teste SWE-Bench Pro (tarefa de engenharia de software industrial do mundo real), a pontuação do GPT-5.2 Thinking melhorou para 55.6%, enquanto também alcançou um novo pico de 80% no teste SWE-Bench Verified.

_Software%20engineering.webp)

Na aplicação prática, isso significa:

- Depuração automática de código em ambiente de produção, resultando em maior estabilidade;

- Suporte a programação multilíngue (não limitado a Python);

- Capacidade de concluir de forma independente tarefas de reparo de ponta a ponta.

Quais são as diferenças entre GPT-5.2 e GPT-5.1?

Resposta curta: o GPT-5.2 é uma melhoria iterativa, porém substantiva. Mantém a arquitetura da família GPT-5 e as bases multimodais, mas avança em quatro dimensões práticas:

- Profundidade e consistência do raciocínio. O 5.2 introduz níveis mais altos de esforço de raciocínio e melhor encadeamento para problemas de múltiplas etapas; o 5.1 já havia melhorado o raciocínio, mas o 5.2 eleva o teto para matemática complexa e lógica multistágio.

- Confiabilidade em contexto longo. Ambas as versões ampliaram o contexto, mas o 5.2 é ajustado para manter a acurácia profundamente em entradas muito longas (a OpenAI afirma retenção aprimorada até centenas de milhares de tokens).

- Fidelidade visão + multimodal. O 5.2 melhora a referência cruzada entre imagens e texto — por exemplo, ler um gráfico e integrar esses dados em uma planilha — mostrando maior acurácia no nível da tarefa.

- Comportamento agente de ferramentas e recursos de API. O 5.2 expõe novos parâmetros de esforço de raciocínio (

xhigh) e recursos de compactação de contexto na API, e a OpenAI refinou a lógica de roteamento no ChatGPT para que a IU possa escolher automaticamente a melhor variante. - Menos erros, maior estabilidade: o GPT-5.2 reduz sua “taxa de alucinações” (taxa de respostas falsas) em 38%. Ele responde a perguntas de pesquisa, redação e análise com mais confiabilidade, reduzindo casos de “fatos fabricados”. Em tarefas complexas, sua saída estruturada é mais clara e sua lógica mais estável. Enquanto isso, a segurança das respostas do modelo melhorou significativamente em tarefas relacionadas à saúde mental. Ele tem desempenho mais robusto em cenários sensíveis, como saúde mental, autoagressão, suicídio e dependência emocional.

Em avaliações de sistema, o GPT-5.2 Instant marcou 0.995 (de 1.0) na tarefa de “Apoio em Saúde Mental”, significativamente acima do GPT-5.1 (0.883).

Quantitativamente, os benchmarks publicados pela OpenAI mostram ganhos mensuráveis no GDPval, benchmarks de matemática (FrontierMath) e avaliações de engenharia de software. O GPT-5.2 supera o GPT-5.1 em tarefas de planilhas de banco de investimento júnior por alguns pontos percentuais.

O GPT-5.2 é gratuito — quanto custa?

Posso usar o GPT-5.2 gratuitamente?

A OpenAI lançou o GPT-5.2 começando pelos planos pagos do ChatGPT e acesso via API. Historicamente, a OpenAI manteve os modelos mais rápidos/profundos atrás de níveis pagos, enquanto tornou variantes mais leves disponíveis mais amplamente depois; com o 5.2 a empresa disse que o lançamento começaria nos planos pagos (Plus, Pro, Business, Enterprise) e que a API está disponível para desenvolvedores. Isso significa que o acesso gratuito imediato é limitado: o nível gratuito pode receber acesso degradado ou roteado (por exemplo, para subvariantes mais leves) mais tarde, à medida que a OpenAI escala o lançamento.

A boa notícia é que a CometAPI agora integra com o GPT-5.2, e está atualmente em promoção de Natal. Você agora pode usar o GPT-5.2 através da CometAPI; o playground permite interagir livremente com o GPT-5.2, e desenvolvedores podem usar a API do GPT-5.2 (a CometAPI tem preço em 20% do da OpenAI) para construir fluxos de trabalho.

Quanto custa via a API (uso de desenvolvedor / produção)?

O uso da API é cobrado por token. A precificação publicada da plataforma da OpenAI no lançamento mostra (a CometAPI tem preço em 20% do da OpenAI):

- GPT-5.2 (chat padrão) — US$1.75 por 1M de tokens de entrada e US$14 por 1M de tokens de saída (descontos para entradas em cache se aplicam).

- GPT-5.2 Pro (carro-chefe) — US$21 por 1M de tokens de entrada e US$168 por 1M de tokens de saída (significativamente mais caro porque é destinado a cargas de trabalho de alta acurácia e alto compute).

- Em comparação, o GPT-5.1 era mais barato (por exemplo, US$1.25 entrada / US$10 saída por 1M de tokens).

Interpretação: os custos da API aumentaram em relação a gerações anteriores; o preço sinaliza que o raciocínio premium e o desempenho de contexto longo do 5.2 são precificados como um nível de produto distinto. Para sistemas de produção, os custos do plano dependem fortemente de quantos tokens você insere/gera e com que frequência você reutiliza entradas em cache (entradas em cache recebem grandes descontos).

O que isso significa na prática

- Para uso casual pela interface do ChatGPT, planos de assinatura mensais (Plus, Pro, Business, Enterprise) são o caminho principal. Os preços dos níveis de assinatura do ChatGPT não mudaram com o lançamento do 5.2 (a OpenAI mantém os preços dos planos estáveis mesmo que as ofertas de modelo mudem).

- Para uso de produção e desenvolvedores, orce os custos por token. Se seu app transmite muitas respostas longas ou processa documentos extensos, o preço de tokens de saída (US$14 / 1M de tokens para Thinking) dominará os custos, a menos que você faça cache de entradas com cuidado e reutilize saídas.

GPT-5.2 Instant vs GPT-5.2 Thinking vs GPT-5.2 Pro

A OpenAI lançou o GPT-5.2 com três variantes orientadas por propósito para corresponder a casos de uso: Instant, Thinking e Pro:

- GPT-5.2 Instant: rápido, econômico, ajustado para trabalho do dia a dia — FAQs, tutoriais, traduções, rascunhos rápidos. Menor latência; bons primeiros rascunhos e fluxos simples.

- GPT-5.2 Thinking: respostas mais profundas e de maior qualidade para trabalho sustentado — sumarização de documentos longos, planejamento de múltiplas etapas, revisões de código detalhadas. Latência e qualidade equilibradas; o ‘cavalo de batalha’ padrão para tarefas profissionais.

- GPT-5.2 Pro: máxima qualidade e confiabilidade. Mais lento e mais caro; melhor para tarefas difíceis e de alto risco (engenharia complexa, síntese jurídica, decisões de alto valor) e quando é necessário um esforço de raciocínio ‘xhigh’.

Tabela de comparação

| Recurso / Métrica | GPT-5.2 Instant | GPT-5.2 Thinking | GPT-5.2 Pro |

|---|---|---|---|

| Uso previsto | Tarefas cotidianas, rascunhos rápidos | Análise profunda, documentos longos | Máxima qualidade, problemas complexos |

| Latência | Mais baixa | Moderada | Mais alta |

| Esforço de raciocínio | Padrão | Alto | xHigh disponível |

| Melhor para | FAQ, tutoriais, traduções, prompts curtos | Resumos, planejamento, planilhas, tarefas de código | Engenharia complexa, síntese jurídica, pesquisa |

| Exemplos de nomes na API | gpt-5.2-chat-latest | gpt-5.2 | gpt-5.2-pro |

| Preço token de entrada (API) | US$1.75 / 1M | US$1.75 / 1M | US$21 / 1M |

| Preço token de saída (API) | US$14 / 1M | US$14 / 1M | US$168 / 1M |

| Disponibilidade (ChatGPT) | Lançamento gradual; planos pagos e depois mais amplo | Lançamento gradual para planos pagos | Usuários Pro / Enterprise (pagos) |

| Exemplo típico de uso | Redigir e-mail, pequenos trechos de código | Construir modelo financeiro multi-aba, Q&A de relatório longo | Auditar base de código, gerar design de sistema de produção |

Quem deve usar o GPT-5.2?

O GPT-5.2 é projetado com um conjunto amplo de usuários-alvo em mente. Abaixo estão recomendações por perfil:

Empresas e equipes de produto

Se você constrói produtos de trabalho de conhecimento (assistentes de pesquisa, revisão de contratos, pipelines de análise ou ferramentas para desenvolvedores), as capacidades de contexto longo e comportamento agente do GPT-5.2 podem reduzir significativamente a complexidade de integração. Empresas que precisam de entendimento robusto de documentos, relatórios automatizados ou copilotos inteligentes acharão o Thinking/Pro úteis. A Microsoft e outros parceiros de plataforma já estão integrando o 5.2 em pilhas de produtividade (por exemplo, Microsoft 365 Copilot).

Desenvolvedores e equipes de engenharia

Equipes que desejam usar LLMs como pares-programadores ou automatizar geração/teste de código se beneficiarão da fidelidade de programação aprimorada no 5.2. O acesso via API (com modos thinking ou pro) permite sínteses mais profundas de bases de código grandes graças à janela de contexto de 400k tokens. Espere pagar mais na API ao usar o Pro, mas a redução na depuração e revisão manuais pode justificar esse custo para sistemas complexos.

Pesquisadores e analistas intensivos em dados

Se você sintetiza literatura regularmente, analisa relatórios técnicos longos ou deseja design de experimentos assistido por modelo, as melhorias de contexto longo e matemática do GPT-5.2 ajudam a acelerar fluxos de trabalho. Para pesquisa reprodutível, combine o modelo com engenharia de prompt cuidadosa e etapas de verificação.

Pequenas empresas e usuários avançados

O ChatGPT Plus (e Pro para usuários avançados) terá acesso roteado às variantes 5.2; isso torna automação avançada e saídas de alta qualidade acessíveis para equipes menores sem precisar construir uma integração de API. Para usuários não técnicos que precisam de melhor sumarização de documentos ou criação de slides, o GPT-5.2 oferece valor prático perceptível.

Observações práticas para desenvolvedores e operadores

Recursos da API a observar

- Níveis de

reasoning.effort(por exemplo,medium,high,xhigh) permitem dizer ao modelo quanto compute gastar no raciocínio interno; use isso para trocar latência por acurácia por solicitação. - Compactação de contexto: a API inclui ferramentas para comprimir e compactar o histórico, de modo que o conteúdo realmente relevante seja preservado em cadeias longas. Isso é crítico quando você precisa manter o uso efetivo de tokens sob controle.

- Scaffolding de ferramentas e controles de ferramentas permitidas: sistemas de produção devem listar explicitamente o que o modelo pode invocar e registrar chamadas de ferramentas para auditoria.

Dicas de controle de custos

- Faça cache de embeddings de documentos usados com frequência e use entradas em cache (que recebem descontos elevados) para consultas repetidas contra o mesmo corpus. A precificação da plataforma da OpenAI inclui descontos significativos para entradas em cache.

- Direcione consultas exploratórias/de baixo valor para o Instant e mantenha Thinking/Pro para lotes ou passes finais.

- Estime cuidadosamente o uso de tokens (entrada + saída) ao projetar custos de API, pois saídas longas multiplicam o custo.

Em resumo — você deve atualizar para o GPT-5.2?

Se seu trabalho depende de raciocínio sobre documentos longos, síntese entre documentos, interpretação multimodal (imagens + texto) ou construção de agentes que chamam ferramentas, o GPT-5.2 é uma atualização clara: ele eleva a acurácia prática e reduz o trabalho manual de integração. Se você está principalmente executando chatbots de alto volume e baixa latência ou aplicações estritamente limitadas por orçamento, o Instant (ou modelos anteriores) ainda pode ser uma escolha razoável.

O GPT-5.2 representa uma mudança deliberada de “melhor chat” para “melhor assistente profissional”: mais compute, mais capacidade e níveis de custo mais altos — mas também ganhos reais de produtividade para equipes que podem aproveitar contexto longo confiável, matemática/raciocínio aprimorados, compreensão de imagens e execução agente de ferramentas.

Para começar, explore as capacidades dos modelos GPT-5.2 (GPT-5.2; GPT-5.2 pro, GPT-5.2 chat) no Playground e consulte o guia da API para instruções detalhadas. Antes de acessar, certifique-se de ter feito login na CometAPI e obtido a chave da API. A CometAPI oferece um preço muito inferior ao oficial para ajudar na sua integração.

Pronto para começar? → Teste gratuito dos modelos gpt-5.2