O GPT-5-Codex é a nova variante do GPT-5 da OpenAI, focada em engenharia, ajustada especificamente para engenharia de software agêntica dentro da família de produtos Codex. Ele foi projetado para lidar com grandes fluxos de trabalho de engenharia do mundo real: criar projetos completos do zero, adicionar recursos e testes, depurar, refatorar e realizar revisões de código enquanto interage com ferramentas externas e suítes de testes. Esta versão representa um refinamento direcionado do produto, em vez de um novo modelo fundamental: a OpenAI integrou o GPT-5-Codex ao Codex CLI, à extensão do Codex IDE, ao Codex Cloud, aos fluxos de trabalho do GitHub e às experiências móveis do ChatGPT; a disponibilidade da API está planejada, mas não é imediata.

O que é o GPT-5-Codex — e por que ele existe?

O GPT-5-Codex é o GPT-5 "especializado em codificação". Em vez de ser um assistente de conversação genérico, ele é ajustado e treinado com aprendizado por reforço e conjuntos de dados específicos de engenharia para melhor suportar tarefas de codificação iterativas e auxiliadas por ferramentas (pense: executar testes, iterar em falhas, refatorar módulos e seguir as convenções de RP). A OpenAI o descreve como o sucessor dos esforços anteriores do Codex, mas foi construído sobre a estrutura do GPT-5 para aprimorar a profundidade do raciocínio sobre grandes bases de código e executar tarefas de engenharia em várias etapas com mais confiabilidade.

A motivação é prática: os fluxos de trabalho dos desenvolvedores dependem cada vez mais de agentes que podem fazer mais do que sugestões de snippets únicos. Ao alinhar um modelo especificamente ao ciclo de "gerar → executar testes → corrigir → repetir" e às normas de relações públicas da organização, a OpenAI visa criar uma IA que pareça uma companheira de equipe, em vez de uma fonte de conclusões pontuais. Essa mudança de "gerar uma função" para "lançar um recurso" é o valor único do modelo.

Como o GPT-5-Codex é arquitetado e treinado?

Arquitetura de alto nível

O GPT-5-Codex é uma variante da arquitetura GPT-5 (a linhagem mais ampla do GPT-5) e não uma arquitetura totalmente nova. Isso significa que ele herda o design baseado em transformadores, as propriedades de escala e as melhorias de raciocínio do GPT-5, mas adiciona treinamento específico do Codex e ajustes finos baseados em RL, voltados para tarefas de engenharia de software. O adendo da OpenAI descreve o GPT-5-Codex como treinado para tarefas complexas de engenharia do mundo real e enfatiza o aprendizado por reforço em ambientes onde o código é executado e validado.

Como ele foi treinado e otimizado para código?

O regime de treinamento do GPT-5-Codex enfatiza tarefas de engenharia do mundo real. Ele utiliza o ajuste fino no estilo aprendizado por reforço em conjuntos de dados e ambientes construídos a partir de fluxos de trabalho tangíveis de desenvolvimento de software: refatorações de múltiplos arquivos, diffs de PR, execução de suítes de testes, sessões de depuração e sinais de revisão humana. O objetivo do treinamento é maximizar a correção em edições de código, passar em testes e produzir comentários de revisão com alta precisão e relevância. Esse foco é o que diferencia o Codex do ajuste fino geral orientado a chats: as funções de perda, os métodos de avaliação e os sinais de recompensa são alinhados aos resultados de engenharia (aprovação em testes, diffs corretos, menos comentários espúrios).

Como é o treinamento “agente”

- Ajuste fino orientado à execução: O modelo é treinado em contextos onde o código gerado é executado, testado e avaliado. Os ciclos de feedback vêm dos resultados dos testes e dos sinais de preferência humana, incentivando o modelo a iterar até que um conjunto de testes seja aprovado.

- Aprendizagem por reforço com feedback humano (RLHF): Semelhante em espírito ao trabalho anterior do RLHF, mas aplicado a tarefas de codificação de várias etapas (criar PR, executar testes, corrigir falhas), de modo que o modelo aprende a atribuição de crédito temporal ao longo de uma sequência de ações.

- Contexto em escala de repositório: O treinamento e a avaliação incluem grandes repositórios e refatores, ajudando o modelo a aprender o raciocínio entre arquivos, convenções de nomenclatura e impactos no nível da base de código. ()

Como o GPT-5-Codex lida com o uso de ferramentas e interações com o ambiente?

Uma característica arquitetônica fundamental é a capacidade aprimorada do modelo de chamar e coordenar ferramentas. O Codex historicamente combinava as saídas do modelo com um pequeno sistema de tempo de execução/agente que pode executar testes, abrir arquivos ou chamar pesquisas. O GPT-5-Codex amplia essa capacidade aprendendo quando chamar ferramentas e integrando melhor o feedback do teste na geração subsequente de código — fechando efetivamente o ciclo entre a síntese e a verificação. Isso é alcançado por meio do treinamento em trajetórias em que o modelo emite ações (como "executar o teste X") e condiciona as gerações posteriores às saídas e comparações dos testes.

O que o GPT-5-Codex realmente pode fazer — quais são seus recursos?

Uma das inovações de produto que definem é duração do pensamento adaptativoO GPT-5-Codex ajusta a quantidade de raciocínio oculto que executa: solicitações triviais são executadas de forma rápida e econômica, enquanto refatorações complexas ou tarefas de longa duração permitem que o modelo "pense" por muito mais tempo. Ao mesmo tempo, para turnos pequenos e interativos, o modelo consome muito menos tokens do que uma instância GPT-5 de uso geral. Economiza 93.7% dos tokens (incluindo inferência e saída) em comparação com o GPT-5. Essa estratégia de raciocínio variável visa produzir respostas rápidas quando necessário e execução profunda e completa quando necessário.

Capacidades principais

- Geração e bootstrapping de projetos: Crie esqueletos de projetos inteiros com CI, testes e documentação básica a partir de prompts de alto nível.

- Teste e iteração de agentes: Gere código, execute testes, analise falhas, aplique patches no código e execute novamente até que os testes sejam aprovados — automatizando efetivamente partes do ciclo de edição → teste → correção do desenvolvedor.

- Refatoração em larga escala: Execute refatorações sistemáticas em vários arquivos, mantendo o comportamento e os testes. Esta é uma área de otimização declarada para o GPT-5-Codex em comparação ao GPT-5 genérico.

- Revisão de código e geração de RP: Produza descrições de RP, sugira alterações com diferenças e revise comentários alinhados às convenções do projeto e às expectativas de revisão humana.

- Raciocínio de código de contexto amplo: Melhor na navegação e no raciocínio sobre bases de código de vários arquivos, gráficos de dependência e limites de API em comparação com modelos de bate-papo genéricos.

- Entradas e saídas visuais: Ao trabalhar na nuvem, o GPT-5-Codex pode aceitar imagens/capturas de tela, inspecionar visualmente o progresso e anexar artefatos visuais (capturas de tela da interface do usuário criada) às tarefas — um benefício prático para depuração front-end e fluxos de trabalho de controle de qualidade visual.

Integrações de editor e fluxo de trabalho

O Codex está profundamente integrado aos fluxos de trabalho do desenvolvedor:

- Codex CLI — interação que prioriza o terminal, suporta capturas de tela, rastreamento de tarefas e aprovações de agentes. A CLI é de código aberto e ajustada para fluxos de trabalho de codificação agêntica.

- Extensão Codex IDE — incorpora o agente no VS Code (e bifurcações) para que você possa visualizar diferenças locais, criar tarefas na nuvem e mover o trabalho entre contextos locais e na nuvem com estado preservado.

- Codex Cloud / GitHub — as tarefas na nuvem podem ser configuradas para revisar automaticamente os PRs, gerar contêineres temporários para testes e anexar logs de tarefas e capturas de tela aos threads de PR.

Limitações e compensações notáveis

- Otimização estreita:Algumas avaliações de produção não codificantes são ligeiramente mais baixas para o GPT-5-Codex do que para a variante geral do GPT-5 — um lembrete de que a especialização pode comprometer a generalidade.

- Teste de confiança: O comportamento do agente depende dos testes automatizados disponíveis. Bases de código com baixa cobertura de testes exporão limites na verificação automática e podem exigir supervisão humana.

Em que tipos de tarefas o GPT-5-Codex é especialmente bom ou ruim?

Bom em: refatorações complexas, criação de andaimes para grandes projetos, escrita e correção de testes, acompanhamento de expectativas de RP e diagnóstico de problemas de tempo de execução de vários arquivos.

Menos bom em: tarefas que exigem conhecimento interno atualizado ou proprietário, não fornecido no ambiente de trabalho, ou aquelas que exigem alta garantia de correção sem revisão humana (sistemas críticos de segurança ainda precisam de especialistas). Revisões independentes também observam um panorama misto da qualidade do código bruto em comparação com outros modelos de codificação especializados — os pontos fortes em fluxos de trabalho agênticos não se traduzem uniformemente na melhor correção da categoria em todos os benchmarks.

O que os benchmarks revelam sobre o desempenho do GPT-5-Codex?

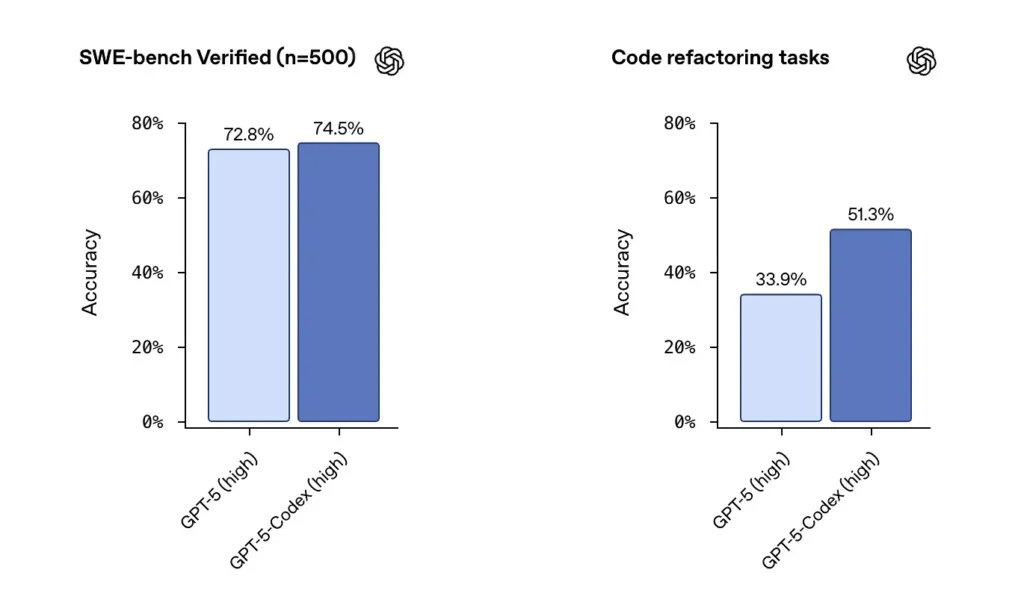

SWE-bench / SWE-bench Verificado: A OpenAI afirma que o GPT-5-Codex supera o GPT-5 em benchmarks de codificação agêntica, como o SWE-bench Verified, e apresenta ganhos em tarefas de refatoração de código extraídas de grandes repositórios. No conjunto de dados SWE-bench Verified, que contém 500 tarefas reais de engenharia de software, o GPT-5-Codex atingiu uma taxa de sucesso de 74.5%. Isso supera os 5% do GPT-72.8 no mesmo benchmark, destacando os recursos aprimorados do agente. 500 tarefas de programação de projetos reais de código aberto. Anteriormente, apenas 477 tarefas podiam ser testadas, mas agora todas as 500 tarefas podem ser testadas → resultados mais completos.

Das configurações anteriores do GPT-5 para o GPT-5-Codex, as pontuações de avaliação da refatoração de código aumentaram substancialmente — números como a mudança de ~34% para ~51% em uma métrica específica de refatoração de alta verbosidade foram destacados nas análises iniciais). Esses ganhos são significativos, pois refletem melhorias em grandes refatores realistas em vez de exemplos de brinquedo — mas ainda há ressalvas sobre a reprodutibilidade e o equipamento de teste exato.

Como desenvolvedores e equipes podem acessar o GPT-5-Codex?

A OpenAI implementou o GPT-5-Codex nas plataformas de produtos do Codex: ele está disponível em todos os lugares onde o Codex é executado atualmente (por exemplo, na CLI do Codex e nas experiências integradas do Codex). Para desenvolvedores que usam o Codex via CLI e login via ChatGPT, a experiência atualizada do Codex apresentará o modelo GPT-5-Codex. A OpenAI afirmou que o modelo será disponibilizado na API mais ampla "em breve" para aqueles que usam chaves de API, mas, desde o lançamento inicial, o principal caminho de acesso é por meio das ferramentas do Codex, em vez de um endpoint de API pública.

Codex CLI

Habilite o Codex para revisar rascunhos de PRs em um repositório em sandbox para que você possa avaliar a qualidade dos comentários sem riscos. Use os modos de aprovação com moderação.

- Redesenhado em torno de um fluxo de trabalho de codificação de agente.

- O suporte para anexar imagens (como wireframes, designs e capturas de tela de bugs da interface do usuário) fornece contexto para modelos.

- Adicionou um recurso de lista de tarefas para acompanhar o progresso de tarefas complexas.

- Forneceu suporte a ferramentas externas (pesquisa na web, conexão MCP).

- A nova interface do terminal melhora a invocação de ferramentas e a formatação de diferenças, e o modo de permissão foi simplificado em três níveis (somente leitura, automático e acesso total).

Extensão IDE

Integre aos fluxos de trabalho do IDE: Adicione a extensão Codex IDE para desenvolvedores que desejam pré-visualizações em linha e iteração mais rápida. Mover tarefas entre a nuvem e o ambiente local com contexto preservado pode reduzir o atrito em recursos complexos.

- Suporta VS Code, Cursor e muito mais.

- Chame o Codex diretamente do editor para aproveitar o contexto do arquivo e do código abertos no momento para obter resultados mais precisos.

- Alterne tarefas facilmente entre ambientes locais e na nuvem, mantendo a continuidade contextual.

- Visualize e trabalhe com resultados de tarefas na nuvem diretamente no editor, sem alternar entre plataformas.

Integração com GitHub e Cloud Functions

- Revisão automatizada de RP: aciona automaticamente o progresso do rascunho para a versão pronta.

- Oferece suporte aos desenvolvedores para solicitar avaliações direcionadas diretamente na seção @codex de um PR.

- Infraestrutura de nuvem significativamente mais rápida: reduza os tempos de resposta de tarefas em 90% por meio do cache de contêineres.

- Configuração automatizada do ambiente: executa scripts de configuração e instala dependências (por exemplo, pip install).

- Executa automaticamente um navegador, verifica implementações de front-end e anexa capturas de tela a tarefas ou PRs.

Quais são as considerações sobre segurança, proteção e limitação?

O OpenAI enfatiza múltiplas camadas de mitigação para agentes do Codex:

- Treinamento em nível de modelo: treinamento de segurança direcionado para resistir a injeções imediatas e limitar comportamentos prejudiciais ou de alto risco.

- Controles em nível de produto: Comportamento padrão em sandbox, acesso à rede configurável, modos de aprovação para a execução de comandos, registros de terminal e citações para rastreabilidade e a capacidade de exigir aprovações humanas para ações sensíveis. A OpenAI também publicou um "adendo ao cartão do sistema" descrevendo essas mitigações e suas avaliações de risco, especialmente para recursos dos domínios biológico e químico.

Esses controles refletem o fato de que um agente capaz de executar comandos e instalar dependências tem superfície de ataque e risco no mundo real — a abordagem da OpenAI é combinar o treinamento do modelo com restrições do produto para limitar o uso indevido.

Quais são as limitações conhecidas?

- Não é um substituto para revisores humanos: A OpenAI recomenda explicitamente o Codex como um adicional revisor, não um substituto. A supervisão humana continua sendo crucial, especialmente para decisões de segurança, licenciamento e arquitetura.

- Os benchmarks e as reivindicações precisam de uma leitura cuidadosa: Revisores apontaram diferenças em subconjuntos de avaliação, configurações de verbosidade e compensações de custo ao comparar modelos. Testes independentes iniciais sugerem resultados mistos: o Codex mostra forte comportamento agêntico e melhorias na refatoração, mas a precisão relativa em relação a outros fornecedores varia de acordo com o benchmark e a configuração.

- Alucinações e comportamento instável: Como todos os LLMs, o Codex pode ter alucinações (inventar URLs, distorcer gráficos de dependência), e suas execuções de agentes de várias horas ainda podem apresentar fragilidade em casos extremos. Espere validar seus resultados com testes e revisão humana.

Quais são as implicações mais amplas para a engenharia de software?

O GPT-5-Codex demonstra uma mudança de amadurecimento no design do LLM: em vez de apenas melhorar os recursos da linguagem simples, os fornecedores estão otimizando comportamento para tarefas longas e complexas (execução de várias horas, desenvolvimento orientado a testes, pipelines de revisão integrados). Isso muda a unidade de produtividade de um único snippet gerado para conclusão da tarefa — a capacidade do modelo de aceitar um ticket, executar um conjunto de testes e produzir iterativamente uma implementação validada. Se esses agentes se tornarem robustos e bem governados, eles remodelarão os fluxos de trabalho (menos refatorações manuais, ciclos de RP mais rápidos, tempo do desenvolvedor focado em design e estratégia). Mas a transição requer um design de processo cuidadoso, supervisão humana e governança de segurança.

Conclusão — O que você deve levar consigo?

O GPT-5-Codex é um passo focado em direção nível de engenheiro LLMs: uma variante do GPT-5 treinada, ajustada e produzida para atuar como um agente de codificação capaz dentro do ecossistema do Codex. Ela traz novos comportamentos tangíveis — tempo de raciocínio adaptativo, longas execuções autônomas, execução integrada em sandbox e melhorias direcionadas na revisão de código — mantendo as ressalvas familiares dos modelos de linguagem (a necessidade de supervisão humana, nuances de avaliação e alucinações ocasionais). Para as equipes, o caminho prudente é a experimentação medida: pilotar em repositórios seguros, monitorar métricas de resultados e incorporar o agente aos fluxos de trabalho dos revisores de forma incremental. À medida que a OpenAI expande o acesso às APIs e os benchmarks de terceiros proliferam, devemos esperar comparações mais claras e orientações mais concretas sobre custo, precisão e governança de melhores práticas.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, Google Gemini, Claude da Anthropic, Midjourney, Suno e outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Os desenvolvedores podem acessar API GPT-5-Codex Através do CometAPI, os modelos mais recentes listados são os da data de publicação do artigo. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API.