O Kimi K2 representa um salto significativo em modelos de linguagem de código aberto para grandes empresas, combinando arquitetura de ponta com mistura de especialistas e treinamento especializado para tarefas agênticas. A seguir, exploramos suas origens, design, desempenho e considerações práticas para acesso e uso.

O que é Kimi K2?

Kimi K2 é um modelo de linguagem de mistura de especialistas (MoE) com trilhões de parâmetros desenvolvido pela Moonshot AI. Ele apresenta 32 bilhões de parâmetros "ativados" — aqueles engajados por token — e um total de 1 trilhão de parâmetros de especialistas, permitindo capacidade massiva sem custos de inferência linear. Construído com base no otimizador Muon, o Kimi K2 foi treinado em mais de 15.5 trilhões de tokens, alcançando estabilidade em escalas antes consideradas impraticáveis. O modelo é oferecido em duas variantes principais:

Kimi‑K2‑Instruct: Pré-ajustado para aplicativos de conversação e agentes, pronto para implantação imediata em sistemas de diálogo e fluxos de trabalho habilitados por ferramentas.

Kimi-K2-Base: Um modelo de base adequado para pesquisa, ajustes finos personalizados e experimentação de baixo nível.

Como funciona sua arquitetura?

- Mistura de Especialistas (MoE): Em cada camada, um mecanismo de controle seleciona um pequeno subconjunto de especialistas (8 de 384) para processar cada token, reduzindo drasticamente a computação para inferência e, ao mesmo tempo, mantendo uma enorme base de conhecimento.

- Camadas especializadas: Incorpora uma única camada densa junto com 61 camadas no total, com 64 cabeças de atenção e dimensões ocultas adaptadas para eficiência de MoE.

- Contexto e vocabulário: Suporta até 128 K tokens em comprimento de contexto e um vocabulário de 160 K tokens, permitindo a compreensão e geração de formatos longos.

Por que Kimi K2 é importante?

O Kimi K2 expande os limites da IA de código aberto ao oferecer desempenho equivalente aos principais modelos proprietários, especialmente em benchmarks de codificação e raciocínio.

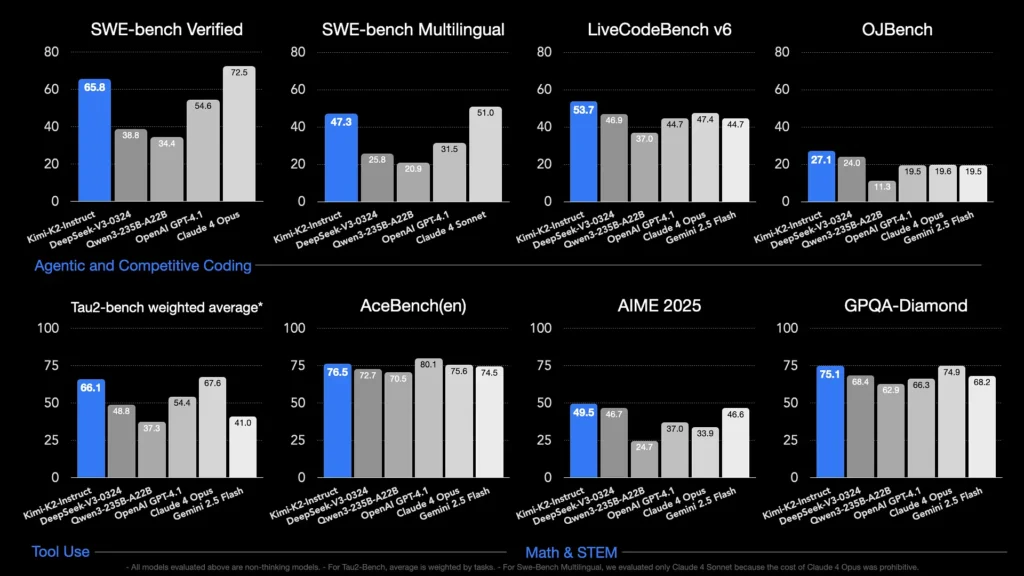

Quais benchmarks demonstram suas capacidades?

- LiveCodeBench v6: Atinge uma taxa de aprovação de 1%, liderando modelos de código aberto e rivalizando com sistemas fechados como o GPT‑53.7 (4.1%).

- Verificado pelo SWE-bench: Obteve 65.8% de pontuação, superando os 4.1% do GPT‑54.6 e ficando atrás apenas do Claude Sonnet 4 em testes de comparação disponíveis publicamente.

- MultiPL‑E e OJBench: Demonstra capacidade robusta de codificação multilíngue (85.7% no MultiPL‑E) e desempenho confiável em desafios de programação do mundo real.

- Matemática-500: Atinge 97.4%, superando os 4.1% do GPT-92.4, demonstrando sua proeza no raciocínio matemático formal.

Como ele é otimizado para tarefas de agente?

Além da geração bruta, o Kimi K2 foi treinado com cenários sintéticos de uso de ferramentas — dados do Protocolo de Contexto do Modelo (MCP) — para chamar ferramentas externas, raciocinar em processos de várias etapas e resolver problemas de forma autônoma. Isso o torna particularmente adequado em ambientes como o Cline, onde pode orquestrar a execução de código, a interação com APIs e a automação do fluxo de trabalho de forma integrada.

Como posso acessar o Kimi K2?

As opções de acesso abrangem plataformas oficiais, distribuições de código aberto e integrações de terceiros, atendendo às necessidades de pesquisa, desenvolvimento e empresas.

Plataforma oficial Moonshot AI

A Moonshot AI oferece inferência hospedada por meio de sua plataforma, fornecendo acesso de API de baixa latência às variantes Kimi-K2-Base e Kimi-K2-Instruct. O preço é escalonado com base no consumo de computação, com planos corporativos incluindo suporte prioritário e implantações locais. Os usuários podem se cadastrar no site da Moonshot AI e obter chaves de API para integração imediata.

CometAPI

A CometAPI já integrou o K2 em seus serviços. Ela alia a inferência do K2 à infraestrutura de GPU gerenciada, garantias de SLA e níveis de preços escaláveis, permitindo que as organizações escolham entre o uso da API com pagamento conforme o uso ou capacidade reservada com descontos por volume.

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos.

Os desenvolvedores podem acessar API Kimi K2(kimi-k2-0711-preview)através CometAPI. Para começar, explore as capacidades do modelo no Playground e consulte o Guia de APIpara obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API.

Integrações de ferramentas de terceiros

- Clina: Um IDE popular centrado em código que oferece suporte nativo ao Kimi K2 por meio do

cline:moonshotai/kimi-k2provedor, dando aos desenvolvedores acesso com um clique ao bate-papo, geração de código e fluxos de trabalho de agente em seu editor. - Espaços de rostos abraçados: Demonstrações hospedadas pela comunidade e interfaces de usuário minimalistas permitem que os usuários interajam com os modelos do K2-Instruct diretamente no navegador. É necessária uma conta no Hugging Face, e o desempenho pode variar de acordo com os recursos de back-end compartilhados.

Como usar o Kimi K2?

Depois de escolher um método de acesso, você pode empregar o K2 para uma variedade de tarefas, do bate-papo à execução de código e agentes autônomos.

Via API ou SDK da plataforma

- Autenticar: Recupere sua chave de API do Moonshot AI ou CometAPI.

- Inicializar cliente: Use o SDK oficial (Python/JavaScript) ou solicitações HTTP padrão.

- Escolha a variante do modelo:

- Kimi-K2-Base para ajustes finos e pesquisas.

- Kimi-K2-Instruct para chat e agentes plug-and-play.

- Modelo da CometAPI:

kimi-k2-0711-preview

- Enviar prompts: Formate as entradas de acordo com o modelo de bate-papo (sistema, usuário, funções de assistente) para aproveitar o comportamento otimizado de acompanhamento de instruções.

Executando localmente com llama.cpp

Para configurações offline ou auto-hospedadas, use os pesos GGUF quantizados da Unsloth (245 GB para quantização dinâmica de 1.8 bits).

- Pesos para download: Do repositório Moonshot AI GitHub ou Hugging Face.

- Instalar llama.cpp: Certifique-se de ter disco suficiente (≥ 250 GB) e RAM+VRAM combinadas (≥ 250 GB) para uma taxa de transferência de ~5 tokens/s.

- Modelo de lançamento:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - Ajuste as configurações: Use os parâmetros recomendados (

rope_freq_base,context_len) documentado no guia Unsloth para desempenho estável.

Integrações com ferramentas de desenvolvimento

- Plugins IDE: Vários plugins da comunidade habilitam o K2 em IDEs do VS Code, Neovim e JetBrains. A configuração normalmente envolve a especificação do endpoint da API e do ID do modelo nas configurações.

- Estruturas de automação: Aproveite o núcleo agentivo do K2 com estruturas como LangChain ou Haystack para encadear prompts, chamadas de API e etapas de execução de código em automações complexas.

Quais são os casos de uso típicos do Kimi K2?

A combinação de escala, treinamento de agentes e acesso aberto do K2 o torna versátil em todos os domínios.

Assistência de codificação

Da geração de boilerplate e refatoração à correção de bugs e criação de perfis de desempenho, os benchmarks de codificação SOTA da K2 se traduzem em ganhos de produtividade no mundo real, muitas vezes superando alternativas em legibilidade e simplicidade.

Conhecimento e raciocínio

Com 128 K de contexto, o K2 lida com documentos longos, perguntas e respostas com vários documentos e raciocínio em cadeia. Sua arquitetura MoE garante a retenção de conhecimento diverso sem esquecimentos catastróficos.

Fluxos de trabalho de agentes

O K2 se destaca na orquestração de tarefas de várias etapas — busca de dados, invocação de APIs, atualização de bases de código e resumo de resultados —, tornando-o ideal para assistentes autônomos em suporte ao cliente, análise de dados e DevOps.

Como o Kimi K2 se compara a outros modelos de código aberto?

Embora o V3 do DeepSeek e os lançamentos abertos recentes do Meta tenham dominado as manchetes no início de 2025, o Kimi K2 se diferencia por:

Inteligência Agentic

O Kimi K2 foi projetado especificamente para fluxos de trabalho "agentes" — automatizando tarefas por meio de chamadas de ferramentas, comandos de shell, automação web e integrações de API. Seu conjunto de dados de treinamento aumentado e autoexecutável inclui diversos exemplos de chamadas de ferramentas, permitindo integração perfeita com sistemas do mundo real.

Eficiência de custos

Com um custo de inferência por token cerca de 80–90% menor em comparação a modelos como o Claude Sonnet 4, o Kimi K2 oferece desempenho de nível empresarial sem preços exorbitantes, catalisando uma rápida adoção entre desenvolvedores sensíveis a preços.

Licenças e Acessibilidade

Ao contrário de certas versões de código aberto sobrecarregadas por licenças restritivas, o Kimi K2 está disponível sob uma licença permissiva que permite uso comercial, trabalhos derivados e implantações locais, alinhando-se com o ethos de código aberto da Moonshot AI.

- Ao unir design MoE de ponta, treinamento rigoroso em agentes e disponibilidade de código aberto, o Kimi K2 capacita desenvolvedores e pesquisadores a criar aplicações inteligentes e autônomas sem custos proibitivos ou ecossistemas fechados. Seja escrevendo código, criando fluxos de trabalho complexos de várias etapas ou experimentando raciocínio em larga escala, o K2 oferece uma base versátil e de alto desempenho.