A IA de edição de imagens deixou de ser apenas um brinquedo e se tornou uma ferramenta de fluxo de trabalho em meses — não anos. Se você precisa remover fundos, trocar rostos, preservar um personagem em diferentes cenas ou fazer composições em várias etapas com prompts em linguagem natural, vários modelos novos prometem fazer isso mais rápido e com menos correções manuais. Neste post, comparo três das ferramentas que estão sendo comentadas atualmente: GPT-image-1 da OpenAI, Qwen-Image Edit, o viral Nano Banana modelos (Gemini-2.5-Flash-Image) e Flux KontextVou explicar em que cada um deles é bom, onde eles falham e dar uma recomendação prática dependendo do que você deseja realizar.

Quais são os principais recursos que definem a excelência em IA de imagem?

"Melhor" depende do que você precisa. Minha avaliação utiliza sete critérios práticos. Antes de dissecarmos modelos individuais, é crucial entender os recursos fundamentais que definem a excelência em geração e edição de imagens por IA. Estes podem ser amplamente categorizados em:

- Qualidade e Fidelidade da Geração: Isso se refere à capacidade da IA de produzir imagens altamente realistas, esteticamente agradáveis e coerentes a partir de prompts de texto. Os fatores incluem detalhes, iluminação, composição e ausência de artefatos ou distorções.

- Versatilidade e precisão na edição: Além da geração inicial, uma IA superior deve oferecer funcionalidades de edição robustas. Isso inclui pintura interna (preenchimento de partes ausentes), pintura externa (ampliação de imagens), remoção/adição de objetos, transferência de estilo e controle preciso sobre elementos específicos.

- Velocidade e eficiência: Para fluxos de trabalho profissionais, o tempo gasto na geração ou edição de imagens é fundamental. Processamento mais rápido sem comprometer a qualidade é uma vantagem significativa.

- Experiência do usuário e acessibilidade: Uma interface intuitiva, controles claros e facilidade de integração aos fluxos de trabalho existentes são essenciais para ampla adoção e satisfação do usuário.

- Considerações éticas e recursos de segurança: À medida que a IA se torna mais poderosa, o desenvolvimento e a implantação responsáveis são cruciais. Isso inclui salvaguardas contra a geração de conteúdo prejudicial ou tendencioso.

- Modelos de Custo-Eficácia e Precificação: Embora algumas ferramentas ofereçam níveis gratuitos, entender a estrutura de preços de recursos avançados e uso comercial é essencial para usuários preocupados com o orçamento.

- Edições consistentes em várias etapas — preservando identidade/objetos em múltiplas edições ou imagens.

Eu prefiro o prático: um modelo que produz um pouco menos de imagens "uau", mas que permite edições reproduzíveis, rápidas e confiáveis, superará um modelo chamativo que precisa de muita limpeza.

Quais são os modelos em consideração e o que os torna diferentes?

Instantâneo rápido do modelo

- gpt-image-1 (OpenAI) — um modelo nativamente multimodal lançado na API em abril de 2025 que oferece suporte direto à geração e edição iterativas de imagens dentro da mesma API multimodal de Respostas/Imagens.

- Imagem Flash Gemini 2.5 (Google) — anunciado em 26 de agosto de 2025 (“nano-banana”); projetado para geração rápida, baixa latência e edição rica (fusão de múltiplas imagens, consistência de caracteres); inclui marca d'água SynthID para procedência.

- Qwen-Image-Edit (QwenLM / grupo Alibaba) — uma versão de edição de imagem do Qwen-Image (base 20B) enfatizando edições de texto bilíngues e precisas e edição combinada de semântica e aparência.

- FLUX.1 Kontext (variantes da plataforma Flux / Black Forest Labs / Flux) — família de modelos (Dev / Pro / Max) focada em edição rápida, local e sensível ao contexto, com consistência de caracteres e fluxos de trabalho iterativos.

Por que esses quatro?

Eles abordam os pontos de design mais relevantes que os profissionais questionam em 2025: integração multimodal (OpenAI), escala + produção mais conhecimento global (Google), edição de precisão e pesquisa aberta (Qwen) e edição iterativa com foco em UX (Flux). Cada um tem diferentes compensações em termos de custo, latência e onde se destacam (renderização de texto, fusão de múltiplas imagens, edição iterativa, preservação de áreas inalteradas).

GPT-Image-1 (OpenAI) — o peso-pesado do desenvolvedor

O que é: O GPT-Image-1 da OpenAI é um modelo multimodal nativo que aceita entradas de texto e imagem e suporta geração e edição de imagens (pintura, imagem para imagem) por meio da API de imagens. Ele é posicionado como um modelo de nível de produção para integração entre aplicativos e serviços. Ele foi projetado como um modelo nativo de texto+imagem que aceita entradas de imagem e prompts de texto e realiza edições com controle preciso.

Quais são os pontos fortes do GPT-image-1?

- Compreensão Semântica Excepcional: Um dos principais pontos fortes do GPT-image-1 reside na sua capacidade de interpretar textos complexos e detalhados. Os usuários podem descrever cenas complexas, estados de espírito específicos e conceitos abstratos com notável precisão, e a IA frequentemente produz imagens que refletem fielmente essas descrições.

- Fotorrealismo de alta qualidade: Quando solicitado a fornecer imagens realistas, o GPT-image-1 frequentemente fornece resultados incrivelmente realistas, com atenção impressionante às texturas, iluminação e composições naturais. Isso o torna uma ferramenta formidável para renderização fotorrealista e arte conceitual.

- Interpretação Criativa: Além da mera tradução literal, a GPT-image-1 exibe um grau de interpretação criativa, frequentemente adicionando detalhes sutis ou floreios estilísticos que realçam o apelo artístico geral da imagem gerada. Isso pode ser particularmente benéfico para a ideação e a exploração de diversos conceitos visuais.

- Base sólida para iteração: Sua capacidade de gerar conceitos iniciais de alta qualidade fornece um excelente ponto de partida para refinamento adicional, seja dentro dos recursos de edição da IA (se disponíveis) ou por meio de software de design gráfico tradicional.

Quais são as limitações do GPT-image-1?

- Controle sobre detalhes finos: Embora seja excelente em conceitos amplos, alcançar controle absoluto em nível de pixel ou a manipulação precisa de elementos muito pequenos pode, às vezes, ser desafiador. Este é um obstáculo comum para muitas IAs generativas, onde a saída é um tanto determinística com base no prompt.

- Disponibilidade e integração: Dependendo da implementação específica, os recursos de edição direta do GPT-image-1 podem ser menos robustos ou integrados em comparação com plataformas dedicadas à edição de imagens. Os usuários podem precisar exportar e usar outras ferramentas para edição intensiva pós-geração.

- Demandas Computacionais: Gerar imagens altamente detalhadas com prompts complexos pode exigir muito processamento, o que pode levar a tempos de processamento mais longos em comparação a modelos mais especializados e leves para edições rápidas.

Nano Banana (Google / Imagem Flash Gemini 2.5)

O que é: “Nano Banana” é o nome brincalhão dado à recente atualização de imagens Gemini do Google (Gemini 2.5 Flash Image). Ela foi posicionada como um gerador/editor de imagens de última geração dentro do ecossistema Gemini do Google, comercializado por edições em várias etapas mais potentes e detalhadas, além de consistência superior na edição de fotos.

Onde o Gemini-2.5-Flash-Image se destaca no cenário da IA visual?

Gemini-2.5-Flash-Image, uma iteração mais recente projetada para velocidade e eficiência, é o concorrente do Google que busca um equilíbrio entre saída de alta qualidade e processamento rápido. Sua designação "Flash" se refere especificamente à sua arquitetura otimizada para respostas mais rápidas, tornando-o altamente adequado para aplicações onde a geração e edição em tempo real ou quase real são cruciais.

O que torna o Gemini-2.5-Flash-Image um forte concorrente?

- Geração extremamente rápida: Como o próprio nome sugere, a velocidade é uma vantagem fundamental. O Gemini-2.5-Flash-Image se destaca na geração rápida de imagens, o que é inestimável para profissionais criativos com prazos apertados ou para aplicações interativas.

- Qualidade de imagem sólida: Apesar de sua velocidade, o modelo não compromete significativamente a qualidade da imagem. Ele produz imagens coerentes e visualmente atraentes, geralmente livres de artefatos importantes, o que o torna competitivo com modelos mais lentos e que exigem mais recursos em muitos casos de uso.

- Compreensão multimodal: Aproveitando a estrutura mais ampla do Gemini, ele geralmente se beneficia da compreensão multimodal avançada, o que significa que pode interpretar não apenas texto, mas também outras formas de entrada para orientar a geração e edição de imagens, embora isso varie de acordo com a API específica.

- Recursos de edição integrados: O Gemini-2.5-Flash-Image normalmente vem com recursos de edição integrados, como pintura interna (preenchimento de partes ausentes de uma imagem), pintura externa (extensão de uma imagem além de suas bordas originais) e manipulação de objetos, tornando-o uma solução mais completa para fluxos de trabalho de imagem de ponta a ponta.

Quais são as áreas de melhoria do Gemini-2.5-Flash-Image?

- Pico do Fotorrealismo: Embora seja bom, nem sempre atinge o ápice absoluto do fotorrealismo visto em alguns dos modelos maiores e mais lentos para cenas altamente complexas e cheias de nuances. Pode haver uma ligeira compensação entre velocidade e fidelidade máxima.

- Nuance artística para estilos complexos: Para estilos artísticos altamente específicos ou solicitações extremamente abstratas, alguns usuários podem achar que ele é um pouco menos capaz de capturar as nuances artísticas mais sutis em comparação a modelos treinados em vastos conjuntos de dados históricos da arte.

- Controle sobre o texto gerado (dentro das imagens): Como muitos modelos generativos, gerar um texto perfeitamente coerente e escrito corretamente em uma imagem ainda pode ser um desafio.

O que é Qwen-Image-Edit?

O que é: Qwen-Image-Edit (equipe Alibaba / Qwen) — modelo de edição de imagens baseado na família Qwen-Image; oferece forte edição de texto bilíngue (chinês e inglês), controle semântico e de aparência, além de fidelidade na edição direta de imagens.

Quais são os pontos fortes exclusivos do Qwen-Image Edit?

- Precisão de edição superior: O Qwen-Image Edit frequentemente ostenta algoritmos avançados para pintura interna, pintura externa e manipulação de objetos, permitindo edições altamente precisas e fluidas. Ele se destaca por manter a coerência visual mesmo ao fazer alterações significativas.

- Edição sensível ao contexto: Um ponto forte é a sua percepção de contexto. Ao remover um objeto, por exemplo, ele preenche o vazio de forma inteligente com conteúdo que se integra logicamente ao ambiente ao redor, tornando a edição praticamente imperceptível.

- Transferência de estilo e harmonização: O Qwen-Image Edit pode ser altamente eficaz na transferência de estilos de uma imagem para outra ou na harmonização de diferentes elementos dentro de uma imagem para criar um visual coeso. Isso é inestimável para designers que trabalham com diversos recursos visuais.

- Remoção/adição de objetos robustos: Sua capacidade de adicionar ou remover objetos, mantendo a iluminação, as sombras e a perspectiva, é impressionante, permitindo reconstruções complexas de cenas ou eliminação de objetos.

- Melhoria e ampliação de imagens: Geralmente inclui recursos avançados para ampliar imagens sem perder qualidade e aprimorar detalhes, cores e o apelo visual geral.

Quais são as possíveis fraquezas do Qwen-Image Edit?

- Foco na Geração Inicial: Embora possa gerar imagens, seu principal ponto forte e otimização geralmente estão na edição. Sua geração inicial de texto para imagem pode ser boa, mas potencialmente não tão criativamente diversa ou fotorrealista quanto modelos focados puramente em geração, dependendo da versão específica.

- Curva de aprendizado para recursos avançados: A precisão e a profundidade de suas ferramentas de edição podem exigir uma curva de aprendizado um pouco mais íngreme para usuários não familiarizados com conceitos avançados de manipulação de imagens.

- Intensidade de recursos para edições complexas: Edições altamente complexas e multicamadas ainda podem exigir muito dos cálculos, o que pode levar a tempos de processamento mais longos para tarefas muito grandes ou complexas.

Que inovações o Flux Kontext traz para a IA de imagens?

O que é: O Kontext da Flux (às vezes comercializado como FLUX.1 Kontext) é uma ferramenta de edição/geração de imagens voltada para designers e equipes de marca. Ele enfatiza edição sensível ao contexto, tipografia precisa, transferências de estilo e UI/UX precisos para trabalho de design iterativo.

Quais são os pontos fortes do Flux Kontext?

- Coesão contextual: O principal ponto forte do Flux Kontext é sua capacidade de compreender e manter o contexto em múltiplas gerações ou edições de imagens. Isso é inestimável para criar narrativas visuais consistentes, designs de personagens ou linhas de produtos onde a harmonia visual é essencial.

- Consistência aprimorada em séries: Se você precisa gerar uma série de imagens que compartilham um estilo, personagem ou ambiente comum, o Flux Kontext visa reduzir inconsistências que podem afetar outros modelos.

- Estilo Adaptável: Ele pode adaptar sua saída com base em imagens geradas anteriormente ou em um guia de estilo definido, resultando em um processo criativo mais simplificado e menos iterativo.

- Especializado em Marca e Narrativa: Particularmente benéfico para marketing, branding e narrativa, onde uma identidade visual unificada é crucial.

- Compreensão rápida no contexto: Sua compreensão imediata não diz respeito apenas à imagem atual, mas também a como ela se encaixa em um contexto maior ou conjunto de instruções.

Quais são as limitações do Flux Kontext?

- Potencial para foco em nicho: Sua ênfase no contexto e na consistência pode significar que ele nem sempre é o líder absoluto em fotorrealismo bruto e independente ou em extrema diversidade artística, se esse for o único requisito.

- Menos benchmarks documentados publicamente: Como um player mais novo ou especializado, dados de referência públicos abrangentes podem estar menos disponíveis em comparação a modelos mais estabelecidos.

- Dependente de entrada contextual clara: Para aproveitar seus pontos fortes, os usuários precisam fornecer informações contextuais claras ou definir a estrutura narrativa de forma eficaz, o que pode exigir uma abordagem de incentivo diferente.

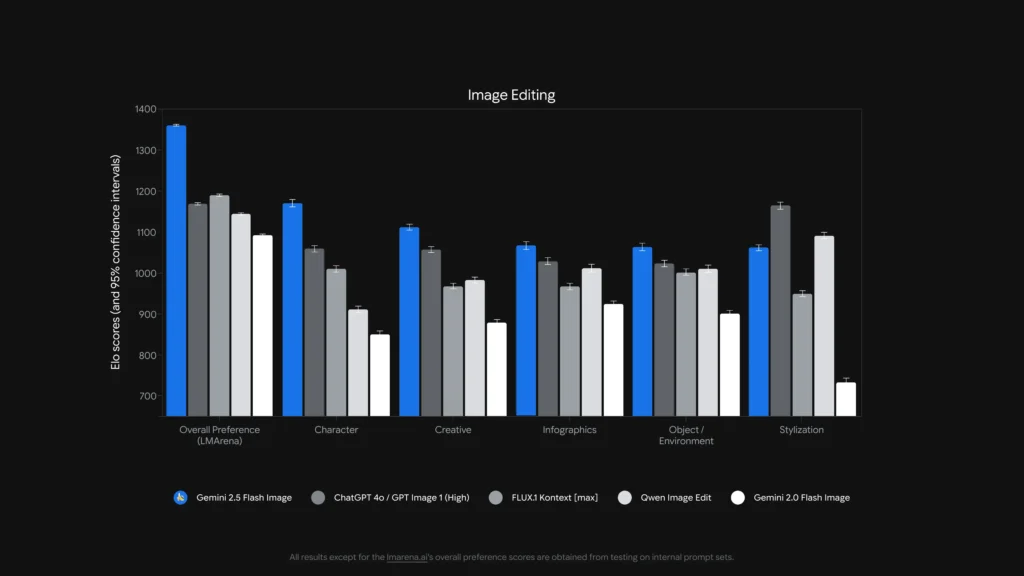

Qual modelo é melhor para edição de imagens?

Para solteiro, edições precisas sem máscara e edição de texto dentro de imagens, Qwen-Image-Edit e Imagem Flash Gemini 2.5 (e modelos especializados como o FLUX.1 Kontext) estão entre os mais fortes. Para edições encadeadas complexas em várias etapas, combinar um front-end LLM com muitas instruções (variantes Gemini ou GPT) com um modelo de imagem geralmente produz o melhor resultado — alguns trabalhos de benchmark mostraram que o estilo de prompting Chain-of-Thought (Gemini-CoT) melhora o sucesso da edição em várias etapas.

edições locais, consistência de caracteres, tratamento de texto

- Qwen-Image-Edit visa explicitamente ambos semântico e aparência edições — por exemplo, substituir objeto, girar, substituição precisa de texto — explicitamente construídas como um edição de imagem Modelo com vias duplas (controle semântico via Qwen2.5-VL + controle de aparência via codificador VAE). Anuncia um sistema bilíngue robusto (chinês/inglês). edições de texto em imagens (por exemplo, alterar texto de sinalização, rótulos de produtos) preservando o estilo, o que é raro e valioso para trabalhos de localização e embalagem.

- Imagem Flash Gemini 2.5 suporta edições mascaradas, modificações locais orientadas por prompt (desfocar fundo, remover pessoa, alterar pose) e fusão de múltiplas imagens. O Google anuncia edições com reconhecimento de região baseadas em prompt, além de vantagens de conhecimento do mundo (por exemplo, melhor semântica de objetos do mundo real). O modelo também adiciona um marca d'água SynthID invisível para imagens geradas/editadas para ajudar na procedência e detecção.

- FLUX.1 Contexto: posiciona-se como um solucionador de contexto imagem a imagem — otimizado para edições locais precisas e sensíveis ao contexto, além de experimentação iterativa. Os revisores elogiam sua capacidade de preservar o contexto e a semântica da cena enquanto realiza alterações locais. O FLUX.1 Kontext e o Flux Kontext UI foram elogiados em testes práticos comparativos para fluxos de trabalho de edição iterativa e legibilidade de texto, tornando-os uma escolha prática para fluxos de trabalho que exigem muitas iterações rápidas (ativos de marketing, miniaturas).

- GPT-imagem-1: suporta operações de edição (prompts de texto+imagem para edições), e as ferramentas do OpenAI integram encadeamento e padrões de engenharia de prompts; o desempenho é forte, mas depende da engenharia de prompts e pode ficar atrás de modelos especializados de edição primeiro em edições detalhadas (por exemplo, substituição exata de texto bilíngue) em alguns testes.

Referências como ComplexBench-Edit e CompBench mostram que muitos modelos ainda falham quando as edições são encadeadas ou interdependentes, mas que a combinação de um LLM para análise sintática de instruções com um modelo de imagem robusto (LLM → orquestração de modelos de imagem) ou o uso de prompts de CoT pode reduzir falhas. É por isso que alguns fluxos de trabalho de produção unem modelos (por exemplo, um LLM de raciocínio mais um gerador de imagens) para edições complexas.

Quem é melhor em editar texto em imagens?

- Qwen-Image-Edit foi projetado explicitamente para edição precisa de texto bilíngue (chinês + inglês) e apresenta resultados superiores em benchmarks de edição de texto (notas técnicas públicas e pontuações reportadas do Qwen). Os artefatos e demonstrações de código aberto do Qwen demonstram a preservação precisa de fonte, tamanho e estilo durante as edições.

- gpt-image-1 e Imagem Flash Gemini 2.5 ambos fazem progresso na renderização de texto, mas referências acadêmicas e notas de fornecedores indicam desafios restantes para textos pequenos/detalhados e passagens textuais longas — as melhorias são incrementais e variam de acordo com o prompt e a resolução.

Análise Comparativa: Matéria, Edição

Para fornecer uma imagem mais clara, vamos consolidar os principais aspectos desses principais modelos de IA em uma tabela comparativa.

| Recurso / Capacidade | GPT-image-1 (OpenAI) | Gemini-2.5-Flash-Image (Google) | Qwen-Image-Edit (Alibaba) | FLUX.1 Contexto |

|---|---|---|---|---|

| Geração nativa + edição | Sim. Texto+imagem multimodal em uma API. | Sim — geração nativa e edição direcionada; fusão de múltiplas imagens e consistência de personagens enfatizadas. | Focado em edição (Qwen-Image-Edit) com controle semântico + de aparência. | Focado em edições de alta fidelidade de imagem para imagem. |

| Profundidade de edição (ajustes locais) | Alto (mas generalista) | Muito alto (avisos direcionados + edições sem máscara) | Muito alto para edições semânticas/de texto (suporte a texto bilíngue). | Muito alto — pipelines de edição com reconhecimento de contexto. |

| Manipulação de texto em imagem | Bom, depende do prompt | Melhorado (o fornecedor mostra o modelo e assina demonstrações de edição) | Melhores entre elas, alterações em textos legíveis bilíngues. | Forte para preservar o estilo; a legibilidade depende da prontidão. |

| Consistência de personagem/objeto | Bom com orientação cuidadosa | Forte (recurso explícito) | Médio (o foco é a edição e não a identidade de múltiplas imagens) | Forte por meio de fluxos de trabalho de edição iterativos. |

| Latência / taxa de transferência | Moderado | Baixa latência / alto rendimento (Modelo Flash) | Varia de acordo com a hospedagem (local/HF vs. nuvem) | Projetado para edições iterativas rápidas em SaaS hospedado. |

| Proveniência / marca d'água | Nenhuma marca d'água obrigatória (mecanismos de política) | Marca d'água invisível SynthID para imagens. | Depende do host | Depende do host |

Observações: “Profundidade de edição” mede o quão precisas e confiáveis as edições locais são na prática; “Tratamento de texto” avalia a capacidade de colocar/alterar texto legível dentro de imagens

E quanto à latência, ergonomia do desenvolvedor e integração empresarial?

Opções de latência e implantação

- Imagem Flash Gemini 2.5 enfatiza baixa latência e está disponível via Gemini API, Google AI Studio e Vertex AI — uma ótima opção para aplicativos corporativos que precisam de taxa de transferência previsível e integração com a nuvem. O Google também informa o preço aproximado do token por imagem (e o blog do desenvolvedor inclui um exemplo de preço por imagem).

- gpt-image-1 está disponível via OpenAI Images API e possui ampla integração com o ecossistema (Playground, parceiros como Adobe/Canva). O preço é tokenizado e varia de acordo com o nível de qualidade da imagem (a OpenAI publica conversões de token para dólar).

- Flux Kontext é focado em uma UX interativa rápida e oferece créditos + tempos baixos por edição em demonstrações de produtos — útil para designers e iteração rápida. Qwen fornece artefatos abertos e acesso à pesquisa (ideal se você deseja hospedar ou inspecionar componentes internos).

Quanto custam esses serviços — qual tem melhor custo-benefício?

Os preços mudam com frequência — abaixo estão os números declarados pelo editor (agosto de 2025) e cálculos representativos de custo por imagem onde os fornecedores os publicaram.

Preços publicados (declarações do fornecedor)

| Modelo / Fornecedor | Visão geral dos preços públicos (publicado) | Estimativa aproximada por imagem |

|---|---|---|

| gpt-image-1 (OpenAI) | Preço tokenizado (entrada de texto US$ 5/1 milhão, entrada de imagem US$ 10/1 milhão, saída de imagem US$ 40/1 milhão). A OpenAI observa que isso corresponde a aproximadamente $ $ 0.02- 0.19 por imagem gerada dependendo da qualidade/tamanho. | ~$0.02 (baixa qualidade/miniatura) → ~$0.19 (quadrado de alta qualidade) |

| Imagem Flash Gemini 2.5 (Google) | US$ 30 por 1 milhão de tokens de saída e exemplo: cada imagem ≈ 1290 tokens de saída (~$0.039 por imagem), de acordo com o blog do desenvolvedor. Preços aplicados via API Gemini/Vertex. | ~$0.039 por imagem (exemplo do Google) |

| Flux Kontext (Fluxo) | Nível gratuito com créditos; páginas de produtos Flux mostram Créditos gratuitos 10 e edições típicas com preços de créditos 5; níveis de assinatura disponíveis para usuários frequentes. (Página do produto do fornecedor). | Custo muito baixo para edições ocasionais; assinatura para uso intenso. |

| Qwen-Image-Edit (QwenLM) | Lançamento aberto e artefatos do GitHub — acesso aberto para pesquisa com exemplos gratuitos; as implantações comerciais variam de acordo com o integrador (auto-hospedagem vs. nuvem). Não há preço canônico único por imagem; tende a ser menor se for auto-hospedagem. |

Interpretação de valor: Se você precisa de imagens de alto volume geração Em produção e deseja um preço previsível por imagem, o exemplo do Google por imagem é extremamente competitivo. Se seus custos são dominados pela edição humana ou pelo tempo iterativo do designer, o Flux ou a execução local do Qwen podem ser mais econômicos. O OpenAI oferece um amplo ecossistema de SDKs e muitos parceiros, que valem a pena o nível mais alto pela conveniência da integração.

Preço no CometAPI

| Modelo | GPT-imagem-1 | Gemini-2.5-Flash-Image | FLUX.1 Contexto |

| Preço | Tokens de entrada $ 8.00; Tokens de saída $ 32.00 | $0.03120 | flux kontext pro: $ 0.09600 fluxo-kontexto-máximo: $ 0.19200 |

Dicas práticas e rápidas para obter os melhores resultados

Dicas de prompt e fluxo de trabalho (aplica-se a todos os modelos)

- Seja explícito sobre a composição: ângulo da câmera, iluminação, clima, distância focal, lente e as relações espaciais entre os objetos. Exemplo: “Close-up de 35 mm, profundidade de campo rasa, assunto centralizado, luz de borda suave no canto superior esquerdo.”

- Use refinamento iterativo para edições: faça primeiro edições estruturais grosseiras e, em seguida, prossiga com refinamentos de textura/iluminação. Modelos como FLUX e Gemini são desenvolvidos para suportar refinamento em várias etapas.

- Para texto em imagens: forneça o texto exato que você deseja e adicione “renderizar como sinal legível de alto contraste com relevo realista” — para edições bilíngues, use Qwen-Image-Edit quando precisar de fidelidade chinês/inglês.

- Usar imagens de referência: para consistência de personagens ou variantes de produtos, forneça imagens de referência de alta qualidade e prompts de âncora como "combine o personagem na referência_01: características faciais, cor do traje e iluminação". Gemini e Flux enfatizam a fusão/consistência de múltiplas imagens.

- Edições com máscara vs. sem máscara: sempre que possível, forneça uma máscara para restringir as edições. Ao usar a funcionalidade sem máscara, espere transbordamentos ocasionais. Os modelos variam: Flux/Gemini lidam bem com edições sem máscara, mas uma máscara ainda ajuda.

- Uso Imagem GPT / GPT-4o Para prompts composicionais complexos com múltiplos objetos, contagens e restrições espaciais. Use uma única instrução exata por geração, sempre que possível.

Dicas de custo e latência

Lote: use APIs em lote ou funções de nuvem para gerar diversas variantes com eficiência. O Gemini-2.5-Flash é otimizado para throughput caso você precise de alto volume.

Qualidade da afinação vs preço: O OpenAI expõe níveis de imagem baixos/médios/altos; gera rascunhos em baixa qualidade e finaliza em alta.

veredicto final

- Melhor para produção e integração: GPT-Imagem-1 — mais adequado para necessidades de API, composição e integração em ferramentas profissionais.

- Melhor para consistência fotorrealista do consumidor: Nano Banana — A atualização de imagens Gemini do Google se destaca com edições de retrato naturais e sequenciais e uma UX acessível.

- Melhor experiência móvel/editor: Flux Kontext — ótimas edições de conversação no telefone com baixo atrito.

- Se você mede por edições de texto cirúrgicas e edições bilíngues/multilíngues → Qwen-Image-Edit** é o melhor especialista e uma excelente escolha quando a precisão do texto dentro das imagens é importante.

Começando a jornada

A CometAPI é uma plataforma de API unificada que agrega mais de 500 modelos de IA de provedores líderes — como a série GPT da OpenAI, a Gemini do Google, a Claude da Anthropic, a Midjourney e a Suno, entre outros — em uma interface única e amigável ao desenvolvedor. Ao oferecer autenticação, formatação de solicitações e tratamento de respostas consistentes, a CometAPI simplifica drasticamente a integração de recursos de IA em seus aplicativos. Seja para criar chatbots, geradores de imagens, compositores musicais ou pipelines de análise baseados em dados, a CometAPI permite iterar mais rapidamente, controlar custos e permanecer independente de fornecedores — tudo isso enquanto aproveita os avanços mais recentes em todo o ecossistema de IA.

Os desenvolvedores podem acessar GPT-imagem-1, FLUX.1 Contexto e Imagem Flash Gemini 2.5 Por meio do CometAPI, as versões mais recentes dos modelos listados são as da data de publicação do artigo. Para começar, explore os recursos do modelo no Playground e consulte o Guia de API para obter instruções detalhadas. Antes de acessar, certifique-se de ter feito login no CometAPI e obtido a chave da API. CometAPI oferecem um preço muito mais baixo que o preço oficial para ajudar você a se integrar.

A mais recente integração Qwen-Image-Edit aparecerá em breve no CometAPI, então fique ligado! Pronto para começar a editar imagens? → Inscreva-se no CometAPI hoje mesmo !

Preço no CometAPI

| Modelo | GPT-imagem-1 | Gemini-2.5-Flash-Image | FLUX.1 Contexto |

| Preço | Tokens de entrada $ 8.00; Tokens de saída $ 32.00 | $0.03120 | flux kontext pro: $ 0.09600 fluxo-kontexto-máximo: $ 0.19200 |