Искусственный интеллект (ИИ) произвел революцию во многих отраслях, и одно из его самых захватывающих применений — генерация изображений. От создания реалистичных человеческих лиц до создания сюрреалистических произведений искусства, способность ИИ-генерации изображений открыла новые горизонты в искусстве, дизайне и технологиях. В этой статье рассматриваются механизмы, лежащие в основе изображений, созданных ИИ, модели, которые их приводят в действие, и более широкие последствия этой технологии.

Понимание основ: как работает генерация изображений с помощью ИИ?

Что такое генеративные модели?

Генеративные модели — это класс алгоритмов ИИ, которые могут создавать новые экземпляры данных, напоминающие данные обучения. В контексте генерации изображений эти модели изучают закономерности из существующих изображений и используют эти знания для создания новых, похожих изображений.

Роль нейронных сетей

В основе генерации изображений с помощью ИИ лежат нейронные сети, в частности, модели глубокого обучения, такие как сверточные нейронные сети (CNN). CNN предназначены для обработки данных с топологией, похожей на сетку, что делает их идеальными для анализа и генерации изображений. Они работают, обнаруживая закономерности, такие как края, текстуры и формы, которые необходимы для понимания и воссоздания изображений.

Ключевые модели ИИ в создании изображений с помощью ИИ

Генеративные состязательные сети (GAN)

Представленные Яном Гудфеллоу в 2014 году, GAN состоят из двух нейронных сетей: генератора и дискриминатора. Генератор создает изображения, а дискриминатор сравнивает их с реальными изображениями. Благодаря этому состязательному процессу генератор улучшает свой вывод, чтобы производить все более реалистичные изображения.

СтильGAN

Разработанный NVIDIA, StyleGAN — это вариант GAN, известный тем, что он генерирует высококачественные человеческие лица. Он представляет архитектуру генератора на основе стилей, позволяя контролировать различные уровни детализации изображения. StyleGAN2 и StyleGAN3 еще больше улучшили качество изображения и решили такие проблемы, как прилипание текстуры.

Диффузионные модели

Модели диффузии генерируют изображения, начиная со случайного шума и постепенно улучшая его, чтобы он соответствовал желаемому результату. Они приобрели популярность благодаря своей способности создавать высококачественные изображения и гибкости в различных приложениях.

Стабильная диффузия

Stable Diffusion — это модель диффузии с открытым исходным кодом, которая позволяет генерировать текст в изображение. Она также может выполнять inpainting и outpainting, позволяя редактировать и расширять изображения. Ее открытый исходный код сделал ее широко доступной для разработчиков и художников.

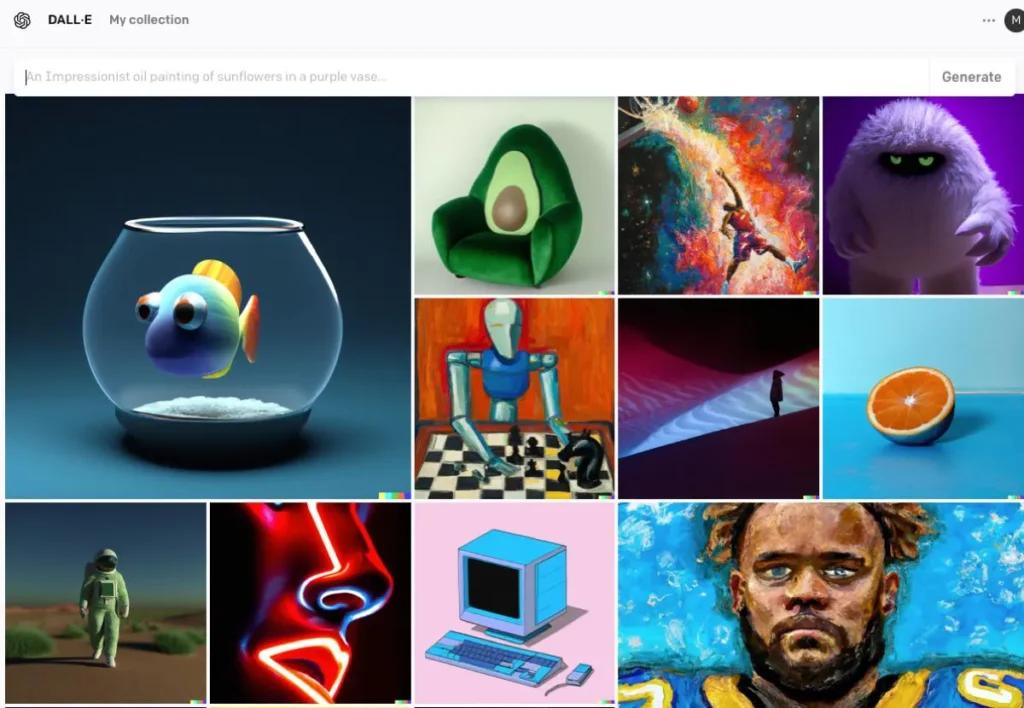

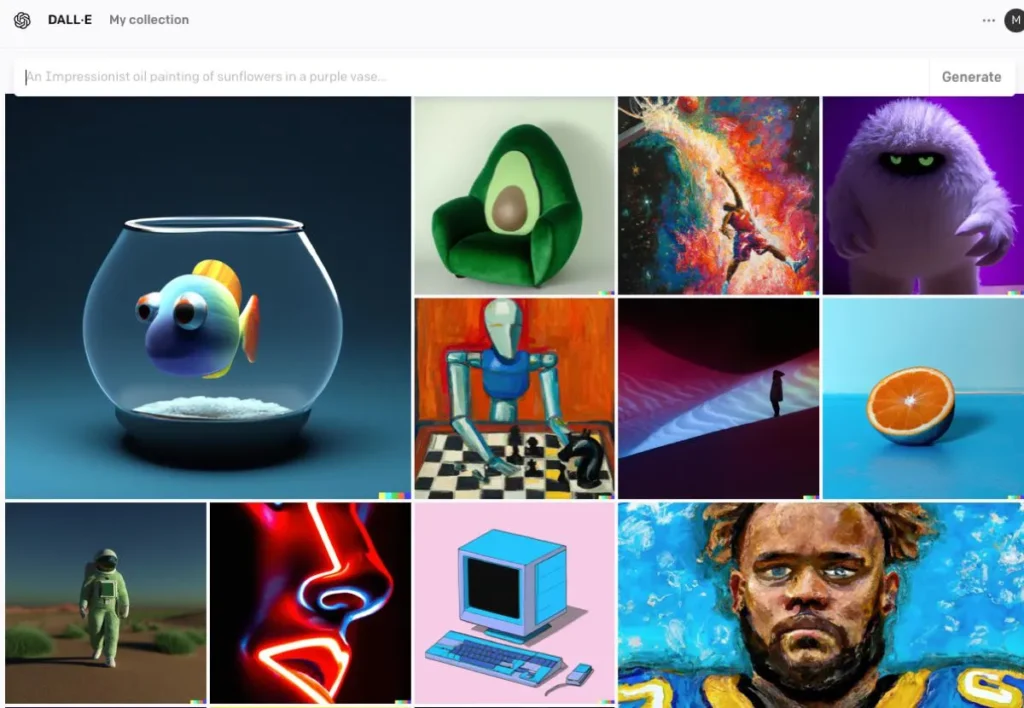

DALL · E

Разработанная OpenAI, DALL·E — это модель на основе трансформатора, способная генерировать изображения из текстовых описаний. DALL·E 2 и DALL·E 3 усовершенствовали оригинал, предложив более высокое разрешение и более точное выравнивание изображения и текста. DALL·E 3 интегрирован в ChatGPT для улучшенного взаимодействия с пользователем.

Процесс генерации изображений с помощью ИИ

Обучение модели

Модели ИИ требуют обширного обучения на больших наборах данных изображений. Во время обучения модель учится распознавать закономерности и особенности на изображениях, что позволяет ей генерировать новые изображения, которые имитируют данные обучения.

Создание новых изображений

После обучения модель может генерировать новые изображения:

- Получение ввода: Это может быть случайный шум (в GAN), текстовая подсказка (в DALL·E) или существующее изображение (для редактирования). На этом этапе фиксируется семантическое значение текста, что позволяет ИИ понимать содержание и контекст.

- Обработка входных данных: Модель обрабатывает входные данные через свои нейронные сетевые слои, применяя изученные шаблоны и признаки.Используя закодированный текст, ИИ использует такие модели, как генеративно-состязательные сети (GAN) или диффузионные модели для создания изображений. Эти модели генерируют изображения, начиная со случайного шума и уточняя его для соответствия текстовому описанию.

- Уточнение и оценка: Сгенерированное изображение затем дорабатывается с использованием механизмов внимания для обеспечения согласованности с текстом. Модель дискриминатора оценивает реалистичность изображения и согласованность с вводом, предоставляя обратную связь для дальнейшего уточнения.

- Вывод изображения: Конечный результат — это новое изображение, отражающее характеристики обучающих данных и предоставленные конкретные входные данные.

Пример кода для генерации изображений с помощью ИИ

Ниже приведены практические примеры кода Python, демонстрирующие, как генерировать изображения с использованием трех известных моделей искусственного интеллекта: генеративно-состязательных сетей (GAN), стабильной диффузии и DALL·E.

Генеративно-состязательные сети (GAN) с PyTorch

Генеративные состязательные сети (GAN) состоят из двух нейронных сетей — Генератора и Дискриминатора, — которые конкурируют друг с другом, чтобы генерировать новые, реалистичные экземпляры данных. Вот упрощенный пример использования PyTorch для генерации изображений:

pythonimport torch

import torch.nn as nn

# Define the Generator network

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.fc1 = nn.Linear(100, 128)

self.fc2 = nn.Linear(128, 784) # Assuming output image size is 28x28

def forward(self, x):

x = torch.relu(self.fc1(x))

x = torch.tanh(self.fc2(x))

return x

# Instantiate the generator

generator = Generator()

# Generate a random noise vector

noise = torch.randn(1, 100)

# Generate an image

generated_image = generator(noise)

Этот код определяет простую сеть генератора, которая принимает 100-мерный вектор шума в качестве входных данных и создает 784-мерный выходной сигнал, который можно преобразовать в изображение размером 28×28. tanh Функция активации гарантирует, что выходные значения находятся в диапазоне , что является обычным для данных изображений.

Стабильная диффузия с помощью диффузоров, охватывающих лицо

Stable Diffusion — это мощная модель преобразования текста в изображение, которая генерирует изображения на основе текстовых описаний. Обнимающее лицо diffusers Библиотека предоставляет простой интерфейс для использования этой модели:

pythonfrom diffusers import StableDiffusionPipeline

import torch

# Load the pre-trained Stable Diffusion model

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

pipe = pipe.to("cuda") # Move the model to GPU for faster inference

# Generate an image from a text prompt

prompt = "A serene landscape with mountains and a river"

image = pipe(prompt).images

# Save the generated image

image.save("generated_image.png")

Этот скрипт загружает модель Stable Diffusion и генерирует изображение на основе предоставленного запроса. Убедитесь, что у вас установлены необходимые зависимости и совместимый графический процессор для оптимальной производительности.

DALL·E с API OpenAI

DALL·E — еще одна модель преобразования текста в изображение, разработанная OpenAI. Вы можете взаимодействовать с ней с помощью API OpenAI:

pythonimport openai

import requests

from PIL import Image

from io import BytesIO

# Set your OpenAI API key

openai.api_key = "your-api-key"

# Generate an image using DALL·E

response = openai.Image.create(

prompt="A futuristic cityscape at sunset",

n=1,

size="512x512"

)

# Get the URL of the generated image

image_url = response

# Download and display the image

image_response = requests.get(image_url)

image = Image.open(BytesIO(image_response.content))

image.save("dalle_generated_image.png")

Замените "your-api-key" с вашим фактическим ключом API OpenAI. Этот скрипт отправляет запрос в модель DALL·E и извлекает сгенерированное изображение. Затем изображение сохраняется локально.

CometAPI также интегрируется ДАЛЛ-Э 3 API, вы также можете использовать ключ CometAPI для доступа ДАЛЛ-Э 3 API, который удобнее и быстрее OpenAI.

Более подробную информацию о моделях в Comet API см. API документ.

Эти примеры предоставляют отправную точку для создания изображений с использованием различных моделей ИИ. Каждая модель имеет свои уникальные возможности и требования, поэтому выберите ту, которая лучше всего соответствует потребностям вашего проекта.

Заключение

Генерация изображений с помощью ИИ находится на стыке технологий и креативности, предлагая беспрецедентные возможности в создании визуального контента. Понимание того, как ИИ генерирует изображения, задействованных моделей и последствий этой технологии имеет важное значение, поскольку мы направляем ее интеграцию в различные аспекты общества.

Доступ к API изображений AI в CometAPI

CometAPI предоставляет доступ к более чем 500 моделям ИИ, включая модели с открытым исходным кодом и специализированные мультимодальные модели для чата, изображений, кода и многого другого. Его основная сила заключается в упрощении традиционно сложного процесса интеграции ИИ. С его помощью доступ к ведущим инструментам ИИ, таким как Claude, OpenAI, Deepseek и Gemini, предоставляется через единую унифицированную подписку. Вы можете использовать API в CometAPI для создания музыки и произведений искусства, создания видео и создания собственных рабочих процессов

CometAPI предложить цену намного ниже официальной, чтобы помочь вам интегрироваться API-интерфейс GPT-4o ,API в середине пути API стабильной диффузии (Стабильная диффузия XL 1.0 API) и API Flux(API FLUX.1 и т. д.), и вы получите 1 доллар на свой счет после регистрации и входа в систему!

CometAPI интегрирует новейшие API GPT-4o-image .