Серия GLM-4.5, разработанная Zhipu AI (Z.ai), представляет собой значительный шаг вперёд в области больших языковых моделей (LLM) с открытым исходным кодом. GLM-4.5, разработанная для объединения возможностей рассуждений, программирования и агентных алгоритмов, обеспечивает надёжную работу в различных приложениях. Независимо от того, являетесь ли вы разработчиком, исследователем или энтузиастом, это руководство содержит подробную информацию о том, как получить доступ к серии GLM-4.5 и эффективно её использовать.

Что такое серия GLM-4.5 и почему она важна?

GLM-4.5 — это гибридная модель рассуждений, сочетающая два различных режима: «режим мышления» для сложных рассуждений и использования инструментов и «режим без мышления» для немедленных ответов. Этот двухрежимный подход позволяет модели эффективно решать широкий спектр задач. Серия включает два основных варианта:

- ГЛМ-4.5: Эта модель, включающая 355 миллиардов общих параметров и 32 миллиарда активных параметров, предназначена для широкомасштабного развертывания в задачах рассуждения, генерации и многоагентных задачах.

- ГЛМ-4.5-Воздух: облегченная версия со 106 миллиардами общих параметров и 12 миллиардами активных параметров, оптимизированная для вывода на устройстве и в облаке меньшего масштаба без ущерба для основных возможностей.

Обе модели поддерживают гибридные режимы рассуждений, предлагая режимы «мышления» и «немышления» для баланса между сложными задачами рассуждения и быстрыми ответами. Они имеют открытый исходный код и выпущены по лицензии MIT, что делает их доступными для коммерческого использования и вторичной разработки.

Принципы архитектуры и дизайна

В основе GLM-4.5 лежит технология MoE для динамической маршрутизации токенов через специализированные экспертные подсети, что обеспечивает превосходную эффективность параметров и масштабируемость (). Такой подход позволяет активировать меньше параметров за один прямой проход, что снижает эксплуатационные расходы и при этом сохраняет высочайший уровень производительности при выполнении задач рассуждений и кодирования ().

Ключевые возможности

- Гибридное мышление и кодирование: GLM-4.5 демонстрирует производительность SOTA как в тестах понимания естественного языка, так и в тестах генерации кода, часто соперничая с фирменными моделями по точности и беглости.

- Агентская интеграция: Встроенные интерфейсы вызова инструментов позволяют GLM-4.5 организовывать многоэтапные рабочие процессы, такие как запросы к базе данных, оркестровка API и интерактивная генерация внешнего интерфейса, в рамках одного сеанса.

- Мультимодальные артефакты: От мини-приложений HTML/CSS до моделирования на основе Python и интерактивных SVG-изображений — GLM-4.5 может выводить полнофункциональные артефакты, повышая вовлеченность пользователей и производительность разработчиков.

Почему GLM-4.5 меняет правила игры?

GLM-4.5 получил высокую оценку не только за свою высокую производительность, но и за переосмысление ценностного предложения программ LLM с открытым исходным кодом в корпоративной и исследовательской среде.

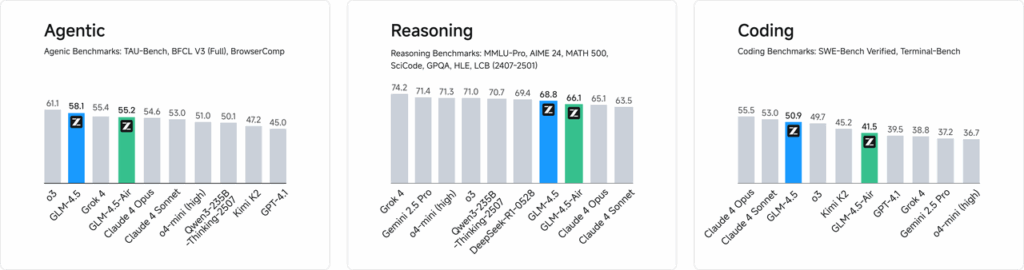

Тесты производительности

В независимых испытаниях по 52 задачам программирования, охватывающим веб-разработку, анализ данных и автоматизацию, GLM-4.5 стабильно превосходил другие ведущие модели с открытым исходным кодом по надёжности вызова инструментов и общему выполнению задач. В сравнительных тестах с Claude Code, Kimi-K2 и Qwen3-Coder GLM-4.5 показал лучшие в своём классе результаты в таких бенчмарках, как таблица лидеров «SWE-bench Verified».

Эффективность затрат

Помимо точности, архитектура MoE в GLM-4.5 значительно снижает затраты на вывод. Стоимость вызовов API для публичных приложений начинается от 0.8 юаня за миллион входящих токенов и 2 юаня за миллион исходящих токенов — примерно в три раза меньше, чем у аналогичных фирменных решений. В сочетании с пиковой скоростью генерации 100 токенов в секунду, модель поддерживает высокопроизводительные развёртывания с малой задержкой без чрезмерных затрат.

Как получить доступ к GLM-4.5?

1. Прямой доступ через платформу Z.ai

Самый простой способ взаимодействия с GLM-4.5 — через платформу Z.ai. Перейдя по ссылке чат.z.aiПользователи могут выбрать модель GLM-4.5 и начать взаимодействие через удобный интерфейс. Эта платформа позволяет сразу же приступить к тестированию и созданию прототипов без необходимости сложной интеграции. Пользователи могут выбрать модель GLM-4.5 или GLM-4.5-Air в левом верхнем углу и сразу же начать общение. Этот интерфейс удобен в использовании и не требует настройки, что делает его идеальным для быстрого взаимодействия и демонстраций.

2. API-доступ для разработчиков

Для разработчиков, стремящихся интегрировать GLM-4.5 в приложения, платформа API Z.ai обеспечивает комплексную поддержку. API предлагает совместимые с OpenAI интерфейсы для моделей GLM-4.5 и GLM-4.5-Air, что обеспечивает беспроблемную интеграцию в существующие рабочие процессы. Подробная документация и руководства по интеграции доступны по адресу Документация API Z.ai .

3. Развертывание с открытым исходным кодом

Для тех, кто заинтересован в локальном развертывании, модели GLM-4.5 доступны на таких платформах, как Hugging Face и ModelScope. Эти модели выпускаются под открытой лицензией MIT, что допускает коммерческое использование и вторичную разработку. Их можно интегрировать с распространёнными фреймворками для вывода, такими как vLLM и SGLang.

4. Интеграция с CometAPI

CometAPI предлагает оптимизированный доступ к моделям GLM-4.5 через единую платформу API ДасборадЭта интеграция упрощает аутентификацию, ограничение скорости и обработку ошибок, что делает его отличным выбором для разработчиков, которым нужна простая настройка. Кроме того, стандартизированный формат API CometAPI позволяет легко переключаться между моделями и проводить A/B-тестирование между GLM-4.5 и другими доступными моделями.

Как разработчики могут получить доступ к серии GLM-4.5?

Существует несколько каналов получения и развертывания GLM-4.5: от прямой загрузки моделей до управляемых API.

Через Hugging Face и ModelScope

Hugging Face и ModelScope размещают полную серию GLM-4.5 в пространстве имён zai-org. Приняв лицензию MIT, разработчики могут:

- Клонировать репозиторий:

git clone https://huggingface.co/zai-org/GLM-4.5

- Установить зависимости:

pip install transformers accelerate

- Загрузите модель:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

Через CometAPI

CometAPI предоставляет бессерверный API для ГЛМ‑4.5 и GLM-4.5 Воздушный API по тарифам с оплатой за токены, доступным через настройку конечных точек, совместимых с OpenAI, вы можете вызывать GLM-4.5 через клиент OpenAI Python с минимальными изменениями в существующих кодовых базах. CometAPI предоставляет не только GLM4.5 и GLM-4.5-air, но и все официальные модели:

| Название модели | вводить | Цена |

glm-4.5 | Наша самая мощная модель рассуждений с 355 миллиардами параметров | Входные токены $0.48 Выходные токены $1.92 |

glm-4.5-air | Экономичный, легкий, с высокой производительностью | Входные токены $0.16 Выходные токены $1.07 |

glm-4.5-x | Высокая производительность, мощное мышление, сверхбыстрый отклик | Входные токены $1.60 Выходные токены $6.40 |

glm-4.5-airx | Легкий, мощный, сверхбыстрый отклик | Входные токены $0.02 Выходные токены $0.06 |

glm-4.5-flash | Высокая производительность, отлично подходящая для кодирования рассуждений и агентов | Входные токены $3.20 Выходные токены $12.80 |

Интеграция Python и REST API

Для индивидуальных развёртываний организации могут размещать GLM-4.5 на выделенных кластерах графических процессоров с использованием Docker или Kubernetes. Типичная конфигурация RESTful включает в себя:

Запуск сервера вывода:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

Отправка запросов:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

Каковы наилучшие практики интеграции GLM-4.5 в приложения?

Чтобы максимизировать рентабельность инвестиций и обеспечить надежную работу, командам следует учитывать следующее:

Оптимизация API и ограничения скорости

- Пакетные запросы: Группируйте похожие запросы, чтобы сократить накладные расходы и использовать пропускную способность графического процессора.

- Кэширование распространенных запросов: Храните частые завершения локально, чтобы избежать избыточных вызовов вывода.

- Адаптивная выборка: Динамическая настройка

temperatureиtop_pна основе сложности запроса для баланса креативности и детерминизма.

Безопасность и соответствие

- Очистка данных: Предварительная обработка входных данных для удаления конфиденциальной информации перед отправкой в модель.

- Контроль доступа: Внедрите ключи API, списки разрешенных IP-адресов и ограничение скорости для предотвращения нецелевого использования и злоупотреблений.

- Ведение журнала аудита: Записывайте запросы, варианты завершения и метаданные для соответствия корпоративным и нормативным требованиям, особенно в сфере финансов или здравоохранения.

Первые шаги

CometAPI — это унифицированная платформа API, которая объединяет более 500 моделей ИИ от ведущих поставщиков, таких как серия GPT OpenAI, Gemini от Google, Claude от Anthropic, Midjourney, Suno и других, в единый, удобный для разработчиков интерфейс. Предлагая последовательную аутентификацию, форматирование запросов и обработку ответов, CometAPI значительно упрощает интеграцию возможностей ИИ в ваши приложения. Независимо от того, создаете ли вы чат-ботов, генераторы изображений, композиторов музыки или конвейеры аналитики на основе данных, CometAPI позволяет вам выполнять итерации быстрее, контролировать расходы и оставаться независимыми от поставщика — и все это при использовании последних достижений в экосистеме ИИ.

Для разработчиков, стремящихся интегрировать GLM-4.5 в свои приложения, платформа CometAPI предлагает надежное решение. API предоставляет интерфейсы, совместимые с OpenAI, что обеспечивает беспроблемную интеграцию в существующие рабочие процессы. Подробная документация и руководства по использованию доступны на сайте Страница API Comet.

Разработчики могут получить доступ ГЛМ‑4.5 и GLM-4.5 Воздушный API через CometAPIПоследние версии моделей указаны на дату публикации статьи. Для начала изучите возможности модели в Детская Площадка и проконсультируйтесь с API-руководство для получения подробных инструкций. Перед доступом убедитесь, что вы вошли в CometAPI и получили ключ API. CometAPI предложить цену намного ниже официальной, чтобы помочь вам интегрироваться.

Заключение

GLM-4.5 представляет собой значительный шаг вперёд в области больших языковых моделей, предлагая универсальное решение для широкого спектра приложений. Гибридная архитектура рассуждений, агентные возможности и открытый исходный код делают GLM-4.5 привлекательным вариантом для разработчиков и организаций, стремящихся использовать передовые технологии искусственного интеллекта. Изучив различные методы доступа, описанные в этом руководстве, пользователи смогут эффективно интегрировать GLM-XNUMX в свои проекты и внести свой вклад в его дальнейшее развитие.