Недавно компания OpenAI анонсировала несколько обновлений, включая выпуск модели GPT-5-Codex-Mini, улучшения ограничения скорости для многопользовательских иерархий и оптимизацию эффективности обработки моделей.

OpenAI-х GPT-5-Codex-Mini — это недавно анонсированный вариант GPT-5-Codex, ориентированный на разработчиков: уменьшенная модель с оптимизированной стоимостью и пропускной способностью, призванная обеспечить большую часть возможностей GPT-5-Codex при написании кода, но с гораздо более низкой стоимостью и большим объёмом использования. Вариант «Mini» позиционируется как практичный выбор для длительных сеансов кодирования, фоновой автоматизации и высокочастотных рабочих процессов разработки, где чистая пиковая производительность менее важна, чем получение большего количества токенов/запросов по тому же тарифному плану.

Что такое GPT-5-Codex-Mini и каковы его особенности?

GPT-5-Codex-Mini — это компактный и экономичный вариант семейства OpenAI GPT-5-Codex, специально разработанный для продуктов Codex (интеграция с CLI и IDE). Он позиционируется как «меньшая, более экономичная» модель, которая жертвует небольшой пиковой производительностью ради существенного снижения потребления ресурсов и увеличения доступной квоты для интерактивных рабочих процессов разработки. Мини-модель предназначена для того, чтобы разработчики могли выполнять гораздо больше этапов кодирования (OpenAI описывает примерно… В 4 раза больше использования для того же уровня подписки ChatGPT) при одновременном снижении задержек и затрат для стандартных, четко определенных инженерных задач.

С точки зрения возможностей, GPT-5-Codex-Mini наследует основные особенности линейки продуктов Codex: глубокое понимание кодовой базы и выполнение многошаговых задач «агентским» способом. Благодаря функциям Codex CLI разработчики могут отправлять команды на естественном языке, фрагменты кода, снимки экрана или схемы дизайна интерфейса в Codex через интерактивный терминал. Модель сначала предоставит план, а затем автоматически просматривает файлы, редактирует код, выполняет команды и проводит тестирование после получения одобрения пользователя.

С точки зрения модального интерфейса продукты Codex позволяют прикреплять изображения (например, скриншоты пользовательского интерфейса, черновики дизайна или скриншоты сообщений об ошибках) к сеансу в терминале или IDE. Модель распознаёт как текстовый, так и графический контент, но на выходе по-прежнему в основном текстовый код и пояснения. Таким образом, GPT-5-Codex-Mini можно рассматривать как модель прокси-кода, которая в основном представляет собой «ввод текста + изображения, вывод текста» и не выполняет такие задачи, как генерация изображений, аудио- или видеоконтента.

Чем GPT-5-Codex-Mini отличается от GPT-5-Codex?

Что нового в Кодексе?

В дополнение к GPT-5-Codex-Mini, OpenAI единообразно увеличила лимит запросов Codex на 50% для пользователей уровней ChatGPT Plus, Business и Edu, значительно увеличив доступный лимит запросов. Кроме того, пользователи ChatGPT Pro получат приоритетные разрешения на обработку запросов, что улучшит скорость ответа и качество выполнения задач.

Кроме того, OpenAI внесла небольшое обновление в модель GPT-5-Codex, оптимизировав её производительность в сценариях совместной работы. Обновлённая модель демонстрирует улучшение ключевых показателей оценки на несколько процентных пунктов, повышение эффективности использования токенов примерно на 3% и более надёжную обработку пограничных случаев, что снижает необходимость в руководстве пользователя.

| уровень пользователя | GPT-5-Кодекс | GPT-5-Codex-Mini |

|---|---|---|

| Плюс/Биз/Образование | увеличивает громкость сообщения в 1.5 раза соответственно. | увеличивает громкость сообщения в 6 раз соответственно. |

GPT-5-Codex-Mini против GPT-5-Codex: различия в тестах

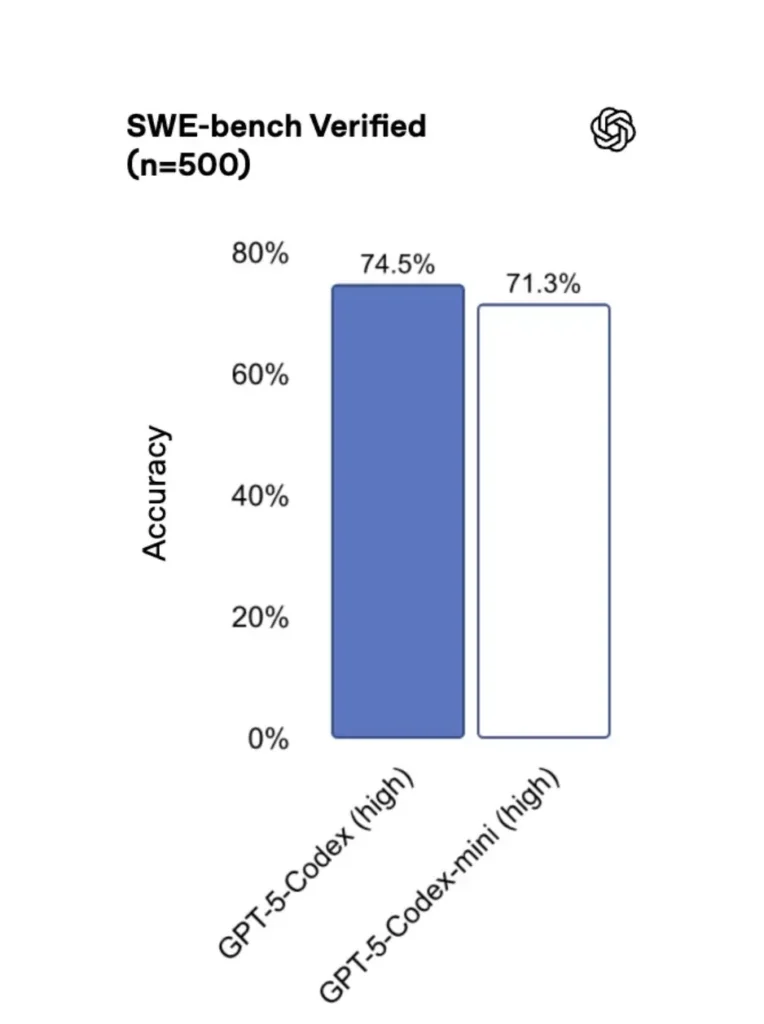

По сравнению с оригинальной версией GPT-5-Codex-Mini производительность немного ниже, но разработчики получают примерно в четыре раза больше баллов за использование. В тесте SWE-bench Verified GPT-5 High набрал 72.8%, GPT-5-Codex — 74.5%, а GPT-5-Codex-Mini — 71.3%.

Codex (и его мини-вариант) используют значительно меньше токенов для легких взаимодействий — материалы OpenAI заявляют о сокращении порядка десятков процентных пунктов для простых подсказок (например, приведенная цифра ≈на 93.7% меньше токенов облегченных взаимодействиях для семейства Codex против GPT-5 в некоторых сценариях).

GPT-5-Codex-Mini и GPT-5-Codex: различия в функциях

- Размер и стоимость: Mini явно меньше и экономичнее; OpenAI утверждает, что он позволяет использовать его примерно в 4 раза чаще при тех же ограничениях подписки. Это оптимизация квот/эффективности для рутинных задач разработчиков.

- Диапазон возможностей: GPT-5-Codex остаётся вариантом с более высокой производительностью для длительных и сложных агентных задач (крупный рефакторинг, глубокий анализ кода, расширенные циклы тестирования). Mini настроен на более быструю и менее ресурсоёмкую работу при частом и коротком взаимодействии.

- Ограничения задержки и скорости: Mini обычно обеспечивает меньшую задержку и допускает более высокие ограничения скорости для каждого плана, что делает его подходящим для плотных интерактивных рабочих процессов.

- Поверхности по умолчанию: Mini доступен как выбираемая модель в Codex CLI и расширении IDE; GPT-5-Codex является моделью по умолчанию для облачных задач и потоков глубокого обзора кода в Codex.

Когда использовать Mini или Full Codex

- Используйте Mini для: создания шаблонов, генерации повторяющегося кода, небольших рефакторингов, интерактивных дополнений во время редактирования, а также при работе в условиях квоты или ограничения по стоимости.

- Используйте GPT-5-Кодекс для: комплексных проверок кода, многочасовых автономных задач, сложных рефакторингов и задач, требующих максимально обоснованной модели и выполнения на основе тестирования.

Как получить доступ к GPT-5-Codex-Mini (CLI, IDE, API)?

Codex CLI (сначала терминал)

Представлен OpenAI gpt-5-codex-mini как вариант модели в Codex CLI. Типичные сценарии использования соответствуют рабочему процессу Codex CLI: запуск интерактивного сеанса, указание модели, прикрепление файлов или снимков экрана, запуск «задач Codex Cloud» и многое другое. CLI также поддерживает быструю /model переключение между полным gpt-5-codex и gpt-5-codex-miniПри первом запуске вам потребуется пройти аутентификацию, используя учётную запись ChatGPT/Pro/Enterprise (или предоставить ключ API). Интерфейс командной строки (CLI) предоставляет различные команды, позволяющие Codex сканировать кодовые базы, запускать тесты, открывать REPL-файлы и применять рекомендуемые исправления.

Пример (интерактивный сеанс Codex CLI):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

Этот процесс соответствует новым настройкам Codex CLI по умолчанию, где инструмент будет предлагать Mini, близкий к лимитам использования.

Расширение VS Code/IDE

Да — расширение Codex IDE (VS Code) уже включает gpt-5-codex-mini (опция). Установите расширение Codex в Visual Studio Code, чтобы получать встроенное автодополнение кода, предложения по рефакторингу и быстрые исправления на основе ИИ. Расширение также предоставляет быстрые действия (генерация кода, объяснение выбранного кода, рефакторинг) и может запускать задачи Codex Cloud из редактора. Шаги VS Code:

- Установите расширение OpenAI Codex/ChatGPT для VS Code.

- Войдите в систему, используя свою учетную запись ChatGPT (Plus/Pro/Business).

- Откройте палитру команд:

Cmd/Ctrl+Shift+P → Codex: Set Model→ выбратьgpt-5-codex-mini. - Используйте встроенные команды (выберите код → щелкните правой кнопкой мыши → «Объяснить с помощью Codex» или нажмите настроенную горячую клавишу).

Пример: встроенная команда VS Code (псевдошаги)

- Выберите функцию в

user_service.py. - Press

Cmd/Ctrl+Shift+P → Codex: Explain Selectionили щелкните правой кнопкой мыши → «Объяснить с помощью Codex». - Расширение открывает боковую панель с пояснениями Mini, предлагаемыми тестами и кнопкой «Создать PR», которая активируется одним щелчком мыши и использует задачи Codex Cloud для отправки ветки на рассмотрение.

А как насчет API — могу ли я вызвать его из своего приложения?

Объявления OpenAI указывают на то, Поддержка API появится скоро для GPT-5-Codex-Mini; на момент написания статьи модель впервые была доступна в цепочке инструментов Codex (CLI/IDE). Это означает, что клиенты API, работающие в производственном режиме, должны быть готовы к появлению имени модели. gpt-5-codex-mini в API запросов/ответов после публикации. Тем временем вы можете создавать прототипы с помощью Codex CLI и IDE.

Если доступ к API включен, типичный вызов (в стиле Responses) может выглядеть так:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

Каковы наилучшие практики быстрого проектирования с использованием Codex Mini?

Ниже приведены конкретные, проверенные на практике передовые практики и шаблоны для получения максимальной выгоды от Codex Mini в рабочих процессах организации производства.

1) Стратегия выбора модели — смешивание и сопоставление

Используйте Mini для часто встречающихся задач низкой сложности (форматирование, небольшой рефакторинг, автоматическое тестирование) и переходите на полную версию Codex для сложного проектирования, глубокой отладки или масштабных преобразований в масштабах репозитория. Автоматизируйте переход: Codex CLI уже предлагает Mini при загрузке 90%, и вы можете написать скрипт. /model переключая инструменты, выбирайте модель в зависимости от сложности задачи.

2) Шаблоны оперативной разработки

Создавайте небольшие, детерминированные шаблоны подсказок для повторяющихся задач: создания тестов, черновиков журнала изменений, создания сообщений о коммитах и описаний запросов на изменение. Сохраняйте их в виде многократно используемых фрагментов в вашем репозитории или в виде шаблонов подсказок Codex.

Пример шаблона приглашения для модульных тестов:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) Автоматизация сетей безопасности — утверждений и контроля CI

Никогда не позволяйте модели напрямую отправлять код без одобрения человека. Используйте режимы одобрения Codex и задачи Codex Cloud для создания различий и подтверждения человеком в непрерывной интеграции. Интерфейс командной строки Codex поддерживает «режимы одобрения», поэтому изменения должны быть одобрены перед применением.

4) Кэширование и дедупликация вызовов модели

Для повторяющихся запросов (например, для объяснения функции) кэшируйте ответ, ключ которого — запрос + хэш файла. Это сокращает количество избыточных вызовов и сохраняет прогнозируемый профиль затрат.

5) Используйте потоковую передачу + инкрементные различия

По возможности запрашивайте потоковые данные и инкрементальные изменения, а не переписывание целых файлов. Это сокращает использование токенов и помогает проверяющим видеть целевые изменения.

6) Генераторный поток для модульного теста

Сгенерируйте тесты и запустите их локально в эфемерной среде. Если тесты не пройдут, выполните итерацию, используя модель для исправления не пройденных тестов. Оформите каждую итерацию как отдельное приглашение с включенными результатами теста.

Пример фрагмента кода автоматизации Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

Заключение

GPT-5-Codex-Mini — это прагматичный шаг в разработке продукта: он учитывает, что рабочие процессы разработчиков часто состоят из множества коротких взаимодействий, где важны задержка, стоимость и непрерывность. Предоставляя мини-уровень, ориентированный на использование IDE и CLI, OpenAI дает командам возможность масштабировать ежедневную помощь в кодировании, не прибегая к модели с самой высокой стоимостью для каждого взаимодействия.

Разработчики могут получить доступ API GPT-5-Codex ,API GPT-5 Pro Последние модели CometAPI, перечисленные в CometAPI, актуальны на дату публикации статьи. Перед доступом убедитесь, что вы вошли в CometAPI и получили ключ API.CometAPI предложить цену намного ниже официальной, чтобы помочь вам интегрироваться.

Готовы к работе?→ Зарегистрируйтесь в CometAPI сегодня !

Если вы хотите узнать больше советов, руководств и новостей об искусственном интеллекте, подпишитесь на нас VK, X и Discord!