В 2025–2026 годах ландшафт инструментов ИИ продолжал консолидироваться: API шлюзов (например, CometAPI) расширились, обеспечив доступ к сотням моделей в стиле OpenAI, в то время как приложения LLM для конечных пользователей (например, AnythingLLM) продолжили совершенствовать своего поставщика «Generic OpenAI», позволяя настольным и локальным приложениям вызывать любые конечные точки, совместимые с OpenAI. Благодаря этому сегодня стало проще направлять трафик AnythingLLM через CometAPI, получая преимущества выбора модели, маршрутизации затрат и унифицированного биллинга, при этом продолжая использовать локальный пользовательский интерфейс AnythingLLM и функции RAG/агента.

Что такое AnythingLLM и зачем его подключать к CometAPI?

Что такое AnythingLLM?

AnythingLLM — это комплексное приложение с открытым исходным кодом на основе искусственного интеллекта и локально-облачный клиент для создания чат-помощников, рабочих процессов дополненной генерации (RAG) и агентов на базе LLM. Оно предоставляет удобный пользовательский интерфейс, API разработчика, функции рабочего пространства/агента и поддержку локальных и облачных LLM. AnythingLLM изначально разработан как приватный и расширяемый с помощью плагинов. Универсальный OpenAI провайдер, позволяющий ему взаимодействовать с совместимыми с OpenAI API LLM.

Что такое CometAPI?

CometAPI — это коммерческая платформа агрегации API, которая предоставляет 500+ моделей ИИ через единый REST-интерфейс в стиле OpenAI и унифицированный биллинг. На практике это позволяет вызывать модели от разных поставщиков (OpenAI, Anthropic, варианты Google/Gemini, модели изображений/аудио и т.д.) через один и тот же https://api.cometapi.com/v1 конечные точки и один ключ API (формат sk-xxxxx). CometAPI поддерживает стандартные конечные точки в стиле OpenAI, такие как /v1/chat/completions, /v1/embeddingsи т. д., что упрощает адаптацию инструментов, которые уже поддерживают API, совместимые с OpenAI.

Зачем интегрировать AnythingLLM с CometAPI?

Три практические причины:

- Выбор модели и гибкость поставщика: AnythingLLM может использовать «любой совместимый с OpenAI» LLM через свою оболочку Generic OpenAI. Указание этой оболочки на CometAPI обеспечивает мгновенный доступ к сотням моделей без изменения пользовательского интерфейса или потоков AnythingLLM.

- Оптимизация затрат/операций: Использование CometAPI позволяет вам централизованно переключать модели (или переходить на более дешевые) для контроля затрат и сохранять единую систему выставления счетов вместо жонглирования ключами нескольких поставщиков.

- Более быстрые эксперименты: Вы можете использовать A/B-модели разных моделей (например,

gpt-4o,gpt-4.5, варианты Клода или многомодальные модели с открытым исходным кодом) через тот же пользовательский интерфейс AnythingLLM — полезно для агентов, ответов RAG, реферирования и многомодальных задач.

Окружающую среду и условия необходимо подготовить перед интеграцией.

Системные и программные требования (высокий уровень)

- Настольный компьютер или сервер под управлением AnythingLLM (Windows, macOS, Linux) — установка на компьютере или локальный экземпляр. Убедитесь, что вы используете последнюю сборку, которая предоставляет доступ к Настройки LLM / Поставщики ИИ настройки.

- Учетная запись CometAPI и ключ API (

sk-xxxxx(секрет стиля). Этот секрет будет использоваться в поставщике Generic OpenAI от AnythingLLM. - Сетевое подключение от вашего компьютера к

https://api.cometapi.com(исходящий HTTPS-трафик не блокируется брандмауэром). - Необязательно, но рекомендуется: современная среда Python или Node для тестирования (Python 3.10+ или Node 18+), curl и HTTP-клиент (Postman / HTTPie) для проверки работоспособности CometAPI перед подключением его к AnythingLLM.

Любые условия, специфичные для LLM

The Универсальный OpenAI Поставщик LLM — рекомендуемый вариант для конечных точек, имитирующих API OpenAI. В документации AnythingLLM указано, что этот поставщик ориентирован на разработчиков, и вам следует понимать, какие входные данные вы предоставляете. Если вы используете потоковую передачу или ваша конечная точка не поддерживает потоковую передачу, AnythingLLM включает настройку для отключения потоковой передачи для Generic OpenAI.

Контрольный список безопасности и эксплуатации

- Обращайтесь с ключом CometAPI как с любым другим секретом — не передавайте его в репозитории; храните его в цепочках ключей ОС или переменных среды, где это возможно.

- Если вы планируете использовать конфиденциальные документы в RAG, убедитесь, что гарантии конфиденциальности конечной точки соответствуют вашим требованиям (см. документацию/условия CometAPI).

- Определите максимальное количество токенов и ограничения контекстного окна, чтобы предотвратить неконтролируемые расходы.

Как настроить AnythingLLM для использования CometAPI (пошагово)?

Ниже приведена конкретная последовательность шагов, за которой следуют примеры переменных среды и фрагменты кода для тестирования соединения перед сохранением настроек в пользовательском интерфейсе AnythingLLM.

Шаг 1 — Получите ключ CometAPI

- Зарегистрируйтесь или войдите в CometAPI.

- Перейдите в раздел «Ключи API» и сгенерируйте ключ. Вы получите строку, которая выглядит так:

sk-xxxxx. Держите это в секрете.

Шаг 2 — Проверка работоспособности CometAPI с быстрым запросом

Используйте curl или Python для вызова простой конечной точки завершения чата для подтверждения подключения.

Пример завитка

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

Если это возвращает 200 и ответ JSON с choices массив, ваш ключ и сеть работают. (В документации CometAPI показаны поверхность и конечные точки в стиле OpenAI).

Пример Python (запросы)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

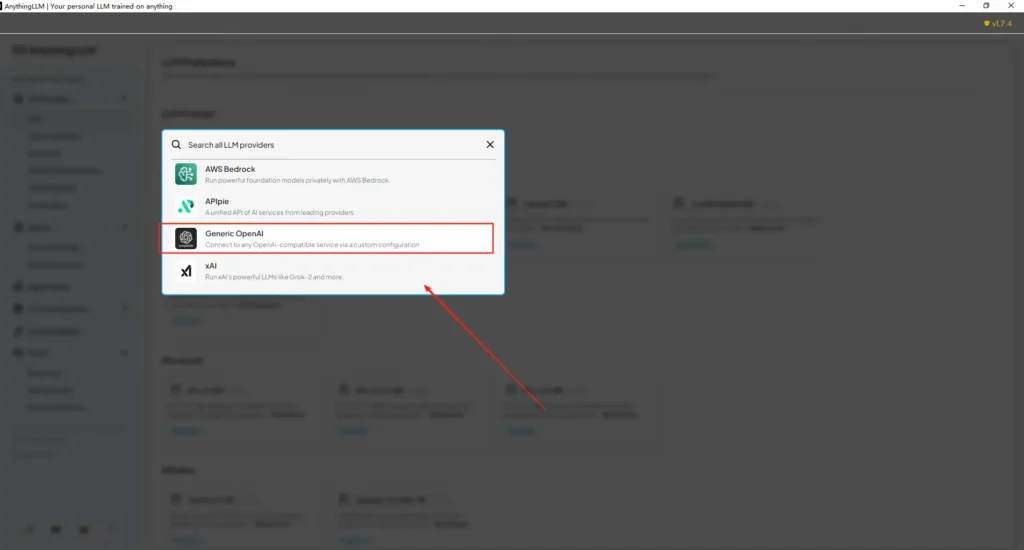

Шаг 3 — Настройка AnythingLLM (пользовательский интерфейс)

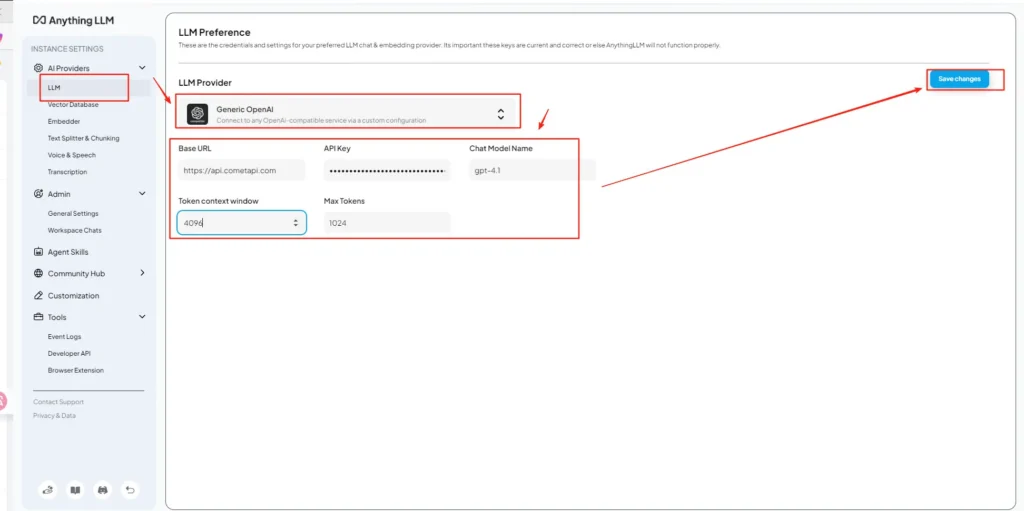

Откройте AnythingLLM → Настройки → Поставщики ИИ → Настройки LLM (или аналогичный путь в вашей версии). Используйте Универсальный OpenAI поставщика и заполните поля следующим образом:

Конфигурация API (пример)

• Войдите в меню настроек AnythingLLM, найдите «Настройки LLM» в разделе «Поставщики ИИ».

• Выберите Generic OpenAI в качестве поставщика модели, введитеhttps://api.cometapi.com/v1в поле URL.

• Вставьтеsk-xxxxxиз CometAPI в поле ввода ключа API. Заполните окно контекста токена и максимальное количество токенов в соответствии с текущей моделью. Вы также можете настроить названия моделей на этой странице, например, добавивgpt-4oмодели.

Это соответствует руководству AnythingLLM «Generic OpenAI» (оболочка для разработчиков) и подходу CometAPI к базовым URL-адресам, совместимым с OpenAI.

Шаг 4 — Задайте названия моделей и лимиты токенов

На том же экране настроек добавьте или настройте названия моделей точно так, как их публикует CometAPI (например, gpt-4o, minimax-m2, kimi-k2-thinking), чтобы пользовательский интерфейс AnythingLLM мог представить эти модели пользователям. CometAPI публикует строки моделей для каждого поставщика.

Шаг 5 — Тестирование по программе AnythingLLM

Создайте новый чат или используйте существующее рабочее пространство, выберите поставщика Generic OpenAI (если у вас несколько поставщиков), выберите одно из добавленных вами названий моделей CometAPI и запустите простой запрос. Если вы получаете согласованные ответы, значит, интеграция выполнена.

Как AnythingLLM использует эти настройки внутри

Generic OpenAI-оболочка AnythingLLM создает запросы в стиле OpenAI (/v1/chat/completions, /v1/embeddings), поэтому после указания базового URL и предоставления ключа CometAPI AnythingLLM будет прозрачно направлять чаты, вызовы агентов и запросы на встраивание через CometAPI. Если вы используете агентов AnythingLLM ( @agent потоки), они будут наследовать одного и того же поставщика.

Каковы передовые практики и возможные подводные камни?

Лучшие практики

- Используйте соответствующие модели настройки контекста: Сопоставьте окно контекста токенов и максимальное количество токенов AnythingLLM с моделью, выбранной в CometAPI. Несоответствие приводит к неожиданному усечению или сбоям вызовов.

- Защитите свои ключи API: Храните ключи CometAPI в переменных окружения и/или в Kubernetes/Secret Manager; никогда не сохраняйте их в Git. AnythingLLM сохранит ключи в своих локальных настройках, если вы введёте их в пользовательском интерфейсе — относитесь к хранилищу на хосте как к конфиденциальному.

- Начните с более дешевых/меньших моделей для экспериментальных потоков: Используйте CometAPI, чтобы попробовать недорогие модели для разработки и зарезервировать премиум-модели для производства. CometAPI открыто рекламирует переключение стоимости и унифицированный биллинг.

- Мониторинг использования и настройка оповещений: CometAPI предоставляет панели управления использованием — устанавливайте бюджеты/оповещения, чтобы избежать неожиданных счетов.

- Тестовые агенты и инструменты изолированно: Агенты AnythingLLM могут инициировать действия; сначала протестируйте их с помощью безопасных подсказок и на промежуточных экземплярах.

Общие подводные камни

- UI против

.envконфликты: При самостоятельном размещении настройки пользовательского интерфейса могут перезаписать.envизменения (и наоборот). Проверьте сгенерированный/app/server/.envЕсли после перезапуска всё вернётся в норму. Отчёт о проблемах сообщества.LLM_PROVIDERсбрасывает. - Несоответствия названий моделей: Использование имени модели, недоступной в CometAPI, приведёт к ошибке 400/404 на шлюзе. Всегда проверяйте наличие моделей в списке CometAPI.

- Лимиты токенов и потоковая передача: Если вам нужны потоковые ответы, убедитесь, что модель CometAPI поддерживает потоковую передачу (и версия пользовательского интерфейса AnythingLLM поддерживает её). У некоторых поставщиков семантика потоковой передачи различается.

Какие реальные варианты использования открывает эта интеграция?

Поисково-дополненная генерация (RAG)

Используйте загрузчики документов AnythingLLM и базу данных векторных данных с моделями CometAPI LLM для генерации контекстно-зависимых ответов. Вы можете экспериментировать с недорогим встраиванием и дорогими моделями чата или использовать CometAPI для унифицированного биллинга. RAG-потоки AnythingLLM — основная встроенная функция.

Автоматизация агентов

AnythingLLM поддерживает @agent Рабочие процессы (просмотр страниц, вызов инструментов, запуск автоматизаций). Маршрутизация вызовов LLM агентов через CometAPI позволяет выбирать модели для этапов управления/интерпретации без изменения кода агента.

Многомодельное A/B-тестирование и оптимизация затрат

Переключение моделей по рабочему пространству или функции (например, gpt-4o для производственных ответов, gpt-4o-mini (для разработки). CometAPI упрощает замену моделей и централизует затраты.

Мультимодальные трубопроводы

CometAPI предоставляет модели изображений, аудио и специализированные модели. Мультимодальная поддержка AnythingLLM (через провайдеров) и модели CometAPI позволяют создавать субтитры изображений, мультимодальное реферирование и транскрибировать аудио через один и тот же интерфейс.

Заключение

CometAPI продолжает позиционировать себя как многомодельный шлюз (более 500 моделей, API в стиле OpenAI), что делает его естественным партнёром для таких приложений, как AnythingLLM, которые уже поддерживают универсальный поставщик OpenAI. Аналогично, универсальный поставщик AnythingLLM и новые возможности конфигурации упрощают подключение к таким шлюзам. Эта конвергенция упрощает эксперименты и миграцию в производство в конце 2025 года.

Как начать работу с Comet API

CometAPI — это унифицированная платформа API, которая объединяет более 500 моделей ИИ от ведущих поставщиков, таких как серия GPT OpenAI, Gemini от Google, Claude от Anthropic, Midjourney, Suno и других, в единый, удобный для разработчиков интерфейс. Предлагая последовательную аутентификацию, форматирование запросов и обработку ответов, CometAPI значительно упрощает интеграцию возможностей ИИ в ваши приложения. Независимо от того, создаете ли вы чат-ботов, генераторы изображений, композиторов музыки или конвейеры аналитики на основе данных, CometAPI позволяет вам выполнять итерации быстрее, контролировать расходы и оставаться независимыми от поставщика — и все это при использовании последних достижений в экосистеме ИИ.

Для начала изучите возможности моделиCometAPI в Детская Площадка Подробные инструкции см. в руководстве по API. Перед доступом убедитесь, что вы вошли в CometAPI и получили ключ API. сetAPI предложить цену намного ниже официальной, чтобы помочь вам интегрироваться.

Готовы к работе?→ Зарегистрируйтесь в CometAPI сегодня !

Если вы хотите узнать больше советов, руководств и новостей об искусственном интеллекте, подпишитесь на нас VK, X и Discord!