DeepSeek-V3.1 — это новейшая гибридная модель рассуждений от DeepSeek, которая поддерживает как быстрый режим чата «без размышлений», так и более осознанный режим «размышлений/рассуждений», предлагает длинный (до 128 КБ) контекст, структурированные выходные данные и вызовы функций. Доступ к ней возможен напрямую через совместимый с OpenAI API DeepSeek, через конечную точку, совместимую с Anthropic, или через CometAPI. Ниже я расскажу вам об этой модели, бенчмарках и стоимости, расширенных функциях (вызов функций, выходные данные JSON, режим рассуждений), а также приведу конкретные примеры кода: прямые вызовы DeepSeek REST (curl / Node / Python), использование Anthropic-клиента и вызовы через CometAPI.

Что такое DeepSeek-V3.1 и что нового в этой версии?

DeepSeek-V3.1 — это новейшая версия семейства DeepSeek V3: высокопроизводительная линейка моделей для широкого спектра языков, которая поставляется с гибридный дизайн вывода с двумя рабочими «режимами» — быстрый бездумный чат режим и думающий / рассуждающий Режим, который позволяет выявлять следы цепочки мыслей для более сложных задач на рассуждение и использования агентов/инструментов. В этом выпуске особое внимание уделяется сокращению задержки «мышления», улучшенным возможностям инструментов/агентов и более длительной обработке контекста для рабочих процессов, масштабируемых документами.

Основные практические выводы:

- Два режима работы:

deepseek-chatдля пропускной способности и стоимости,deepseek-reasoner(модель рассуждения), когда вам нужны следы цепочки мыслей или более высокая точность рассуждений. - Улучшена обработка агентов/инструментов и улучшен токенизатор/контекст для длинных документов.

- Длина контекста: до ~128 тыс. токенов (позволяет создавать длинные документы, кодовые базы и журналы).

Прорыв в эталонных показателях

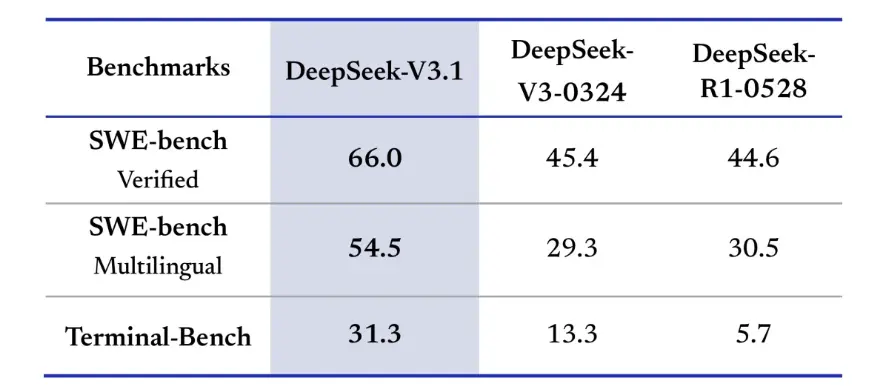

DeepSeek-V3.1 продемонстрировал значительные улучшения в решении реальных задач кодирования. В оценке SWE-bench Verified, которая измеряет, как часто модель исправляет ошибки GitHub для обеспечения прохождения модульных тестов, V3.1 достигла 66% успеха по сравнению с 45% для V3-0324 и R1. В многоязычной версии V3.1 решила 54.5% проблем, что почти вдвое больше, чем примерно 30% успеха других версий. В оценке Terminal-Bench, которая проверяет, может ли модель успешно выполнять задачи в реальной среде Linux, DeepSeek-V3.1 успешно справился с 31% задач по сравнению с 13% и 6% для других версий соответственно. Эти улучшения показывают, что DeepSeek-V3.1 более надежен при выполнении кода и работе в реальных инструментальных средах.

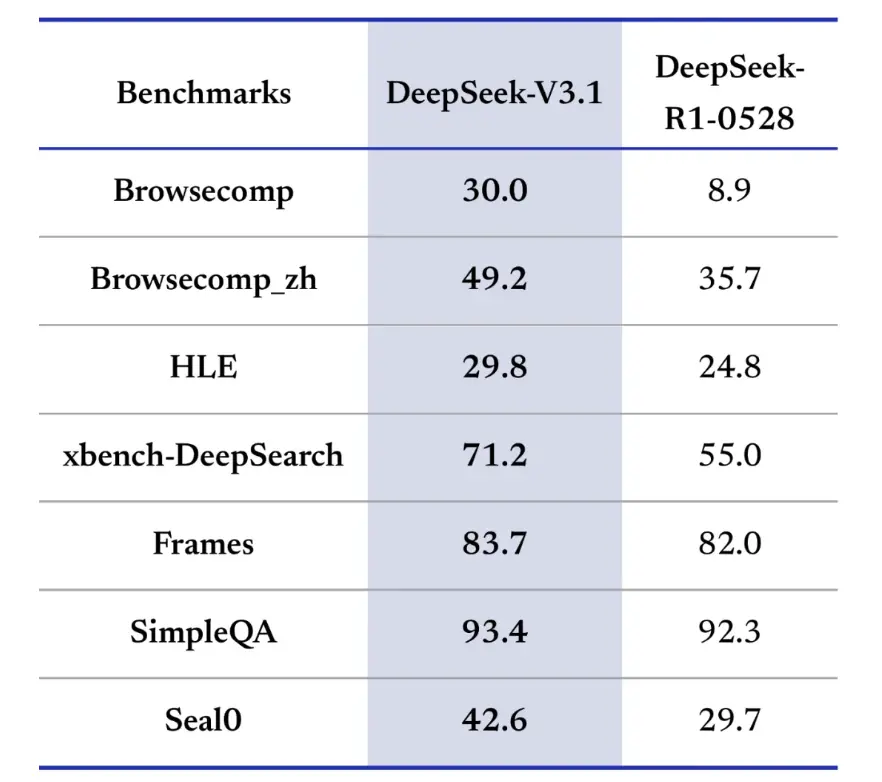

Тесты информационного поиска также отдают предпочтение DeepSeek-V3.1 в просмотре страниц, поиске и ответах на вопросы. В оценке BrowseComp, которая требует навигации и извлечения ответов с веб-страницы, V3.1 правильно ответил на 30% вопросов, по сравнению с 9% для R1. В китайской версии DeepSeek-V3.1 достиг 49% точности по сравнению с 36% для R1. На экзамене по сложному языку (HLE) V3.1 немного превзошел R1, достигнув 30% и 25% точности соответственно. В задачах глубокого поиска, таких как xbench-DeepSearch, которые требуют синтеза информации из разных источников, V3.1 набрал 71% против 1% у R55. DeepSeek-V3.1 также продемонстрировал небольшое, но стабильное лидерство в таких тестах, как (структурированное рассуждение), SimpleQA (ответ на фактические вопросы) и Seal0 (ответ на вопросы, специфичные для предметной области). В целом V3.1 значительно превзошел R1 по поиску информации и ответам на легкие вопросы.

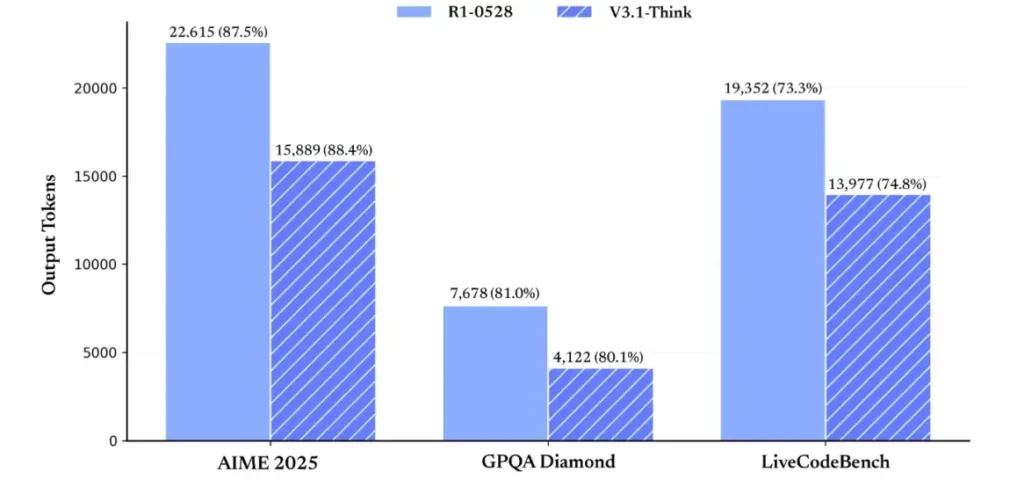

Что касается эффективности рассуждений, результаты использования токенов демонстрируют её эффективность. На AIME 2025 (сложном экзамене по математике) V3.1-Think достигла точности, сравнимой или немного превышающей R1 (88.4% против 87.5%), но использовала примерно на 30% меньше токенов. На GPQA Diamond (многопредметном выпускном экзамене) обе модели показали практически одинаковый результат (80.1% против 81.0%), но V3.1 использовала почти вдвое меньше токенов, чем R1. В бенчмарке LiveCodeBench, оценивающем рассуждения кода, V3.1 оказалась не только точнее (74.8% против 73.3%), но и лаконичнее. Это демонстрирует, что V3.1-Think способна предоставлять подробные рассуждения, избегая при этом многословия.

В целом, версия 3.1 представляет собой значительный скачок вперёд по сравнению с версией 3-0324. По сравнению с R1, версия 3.1 продемонстрировала более высокую точность практически во всех тестах и была более эффективна при решении сложных задач на рассуждение. Единственным тестом, где R1 показал себя на уровне, был GPQA, но с почти вдвое большей стоимостью.

Как получить ключ API и настроить учетную запись разработчика?

Шаг 1. Зарегистрируйтесь и создайте учетную запись.

- Посетите портал разработчиков DeepSeek (документация DeepSeek / консоль). Создайте учётную запись у своего поставщика электронной почты или системы единого входа (SSO).

- Выполните все необходимые проверки личности или настройки платежных систем, требуемые порталом.

Шаг 2. Создайте ключ API

- На панели инструментов перейдите в раздел API ключи → Создать ключ. Назовите свой ключ (например,

dev-local-01). - Скопируйте ключ и сохраните его в надежном менеджере секретов (см. рекомендации по производству ниже).

Совет: некоторые шлюзы и сторонние маршрутизаторы (например, CometAPI) позволяют использовать один ключ шлюза для доступа к моделям DeepSeek через них — это полезно для избыточности нескольких поставщиков (см. API DeepSeek V3.1 раздел).

Как настроить среду разработки (Linux/macOS/Windows)?

Это простая, воспроизводимая настройка для Python и Node.js, которая работает для DeepSeek (конечные точки, совместимые с OpenAI), CometAPI и Anthropic.

Предпосылки

- Python 3.10+ (рекомендуется), pip, virtualenv.

- Node.js 18+ и npm/yarn.

- curl (для быстрых тестов).

Среда Python (пошаговое руководство)

- Создайте каталог проекта:

mkdir deepseek-demo && cd deepseek-demo

python -m venv .venv

source .venv/bin/activate # macOS / Linux

# .venv\Scripts\activate # Windows PowerShell

- Установить минимальные пакеты:

pip install --upgrade pip

pip install requests

# Optional: install an OpenAI-compatible client if you prefer one:

pip install openai

- Сохраните свой ключ API в переменных среды (никогда не фиксируйте):

export DEEPSEEK_KEY="sk_live_xxx"

export CometAPI_KEY="or_xxx"

export ANTHROPIC_KEY="anthropic_xxx"

(Windows PowerShell использует $env:DEEPSEEK_KEY = "…")

Среда узла (шаг за шагом)

- Инициализировать:

mkdir deepseek-node && cd deepseek-node

npm init -y

npm install node-fetch dotenv

- Создайте

.envфайл:

DEEPSEEK_KEY=sk_live_xxx

CometAPI_KEY=or_xxx

ANTHROPIC_KEY=anthropic_xxx

Как вызвать DeepSeek-V3.1 напрямую — пошаговые примеры кода?

API DeepSeek совместим с OpenAI. Ниже приведены копировать-вставить примеры: curl, Python (в стиле requests и openai SDK) и Node.

Шаг 1: Простой пример завитка

curl https://api.deepseek.com/v1/chat/completions \

-H "Authorization: Bearer $DEEPSEEK_KEY" \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-chat-v3.1",

"messages": [

{"role":"system","content":"You are a concise engineering assistant."},

{"role":"user","content":"Give a 5-step secure deployment checklist for a Django app."}

],

"max_tokens": 400,

"temperature": 0.0,

"reasoning_enabled": true

}'

Примечание: reasoning_enabled Переключает режим «Обдумывание» (флаг поставщика). Точное название флага может различаться у разных поставщиков — см. документацию по модели.

Шаг 2: Python (запросы) с простой телеметрией

import os, requests, time, json

API_KEY = os.environ

URL = "https://api.deepseek.com/v1/chat/completions"

payload = {

"model": "deepseek-chat-v3.1",

"messages": [

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Refactor this Flask function to be testable: ..."}

],

"max_tokens": 600,

"temperature": 0.1,

"reasoning_enabled": True

}

start = time.time()

r = requests.post(URL, headers={

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}, json=payload, timeout=60)

elapsed = time.time() - start

print("Status:", r.status_code, "Elapsed:", elapsed)

data = r.json()

print(json.dumps(data, indent=2))

CometAPI: совершенно бесплатный доступ к DeepSeek V3.1

Для разработчиков, которым нужен немедленный доступ без регистрации, CometAPI предлагает привлекательную альтернативу DeepSeek V3.1 (название модели: deepseek-v3-1-250821; deepseek-v3.1). Этот шлюзовой сервис объединяет несколько моделей ИИ через единый API, предоставляя доступ к DeepSeek и предлагая другие преимущества, включая автоматическое переключение при отказе, аналитику использования и упрощенный кросс-провайдерский биллинг.

Сначала создайте учетную запись CometAPI на https://www.cometapi.com/— весь процесс занимает всего две минуты и требует только подтверждения адреса электронной почты. После входа в систему сгенерируйте новый ключ в разделе «Ключ API». https://www.cometapi.com/ предлагает бесплатные кредиты для новых аккаунтов и скидку 20% от официальной цены API.

Техническая реализация требует минимальных изменений кода. Просто измените конечную точку API с прямого URL DeepSeek на шлюз CometAPI.

Примечание: API поддерживает потоковую передачу (

stream: true),max_tokens, температура, последовательности останова и функции вызова функций, аналогичные другим совместимым с OpenAI API.

Как вызвать DeepSeek с помощью Anthropic SDK?

DeepSeek предоставляет конечную точку, совместимую с Anthropic, поэтому вы можете повторно использовать Anthropc SDK или инструменты Claude Code, указав SDK на https://api.deepseek.com/anthropic и установив имя модели на deepseek-chat (или deepseek-reasoner (где поддерживается).

Вызов модели DeepSeek через антропный API

Установите Anthropic SDK: pip install anthropic. Настройте среду:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_API_KEY=YOUR_DEEPSEEK_KEY

Создать сообщение:

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="deepseek-chat",

max_tokens=1000,

system="You are a helpful assistant.",

messages=[

{

"role": "user",

"content": [

{

"type": "text",

"text": "Hi, how are you?"

}

]

}

]

)

print(message.content)

Используйте DeepSeek в Claude Code

Установка: npm install -g @anthropic-ai/claude-code. Настройте среду:

export ANTHROPIC_BASE_URL=https://api.deepseek.com/anthropic

export ANTHROPIC_AUTH_TOKEN=${YOUR_API_KEY}

export ANTHROPIC_MODEL=deepseek-chat

export ANTHROPIC_SMALL_FAST_MODEL=deepseek-chat

Войдите в каталог проекта и выполните код Клода:

cd my-project

claude

Используйте DeepSeek в Claude Code через CometAPI

CometAPI поддерживает Claude Code. После установки при настройке среды просто замените базовый URL на https://api.cometapi.com, а ключ — на ключ CometAPI, чтобы использовать модель DeepSeek CometAPI в Claude Code.

# Navigate to your project folder cd your-project-folder

# Set environment variables (replace sk-... with your actual token)

export ANTHROPIC_AUTH_TOKEN=sk-...

export ANTHROPIC_BASE_URL=https://www.cometapi.com/console/

# Start Claude Code

claude

Примечание:

- DeepSeek сопоставляет неподдерживаемые имена антропных моделей с

deepseek-chat. - Уровень антропной совместимости поддерживает

system,messages,temperature, потоковая передача, последовательности остановок и массивы мышления.

Каковы конкретные передовые производственные практики (безопасность, стоимость, надежность)?

Ниже приведены рекомендуемые шаблоны производства, применимые к DeepSeek или любому другому крупномасштабному использованию LLM.

Секреты и личность

- Храните ключи API в секретном менеджере (не используйте

.env(в прод.). Регулярно проводите ротацию ключей и создавайте ключи с минимальными привилегиями для каждой службы. - Используйте отдельные проекты/аккаунты для разработки/стажировки/производства.

Ограничения скорости и повторные попытки

- Осуществлять экспоненциальный откат HTTP 429/5xx с дрожанием. Ограничение количества попыток (например, 3).

- Используйте ключи идемпотентности для запросов, которые могут повторяться.

Пример Python — повтор с отсрочкой

import time, random, requests

def post_with_retries(url, headers, payload, attempts=3):

for i in range(attempts):

r = requests.post(url, json=payload, headers=headers, timeout=60)

if r.status_code == 200:

return r.json()

if r.status_code in (429, 502, 503, 504):

backoff = (2 ** i) + random.random()

time.sleep(backoff)

continue

r.raise_for_status()

raise RuntimeError("Retries exhausted")

Управление затратами

- Ограничивать

max_tokensи избегайте случайного запроса больших объемов данных. - Ответы модели кэширования При необходимости (особенно при повторных запросах). DeepSeek чётко различает попадание в кэш и его отсутствие при ценообразовании — кэширование экономит деньги.

- Используйте

deepseek-chatдля обычных небольших ответов; резервdeepseek-reasonerдля случаев, когда действительно необходим CoT (это дороже).

Наблюдаемость и ведение журнала

- Регистрируйте только метаданные запросов в виде открытого текста (хэши запросов, количество токенов, задержки). Избегайте регистрации полных пользовательских данных или конфиденциального контента. Сохраняйте идентификаторы запросов/ответов для поддержки и сверки счетов.

- Отслеживайте использование токенов по каждому запросу и предоставляйте бюджет/оповещения о расходах.

Безопасность и контроль галлюцинаций

- Используйте результаты работы инструмента и детерминированные валидаторы для всего, что критически важно с точки зрения безопасности (финансового, юридического, медицинского).

- Для структурированных выходных данных используйте

response_format+JSON-схема и проверка выходных данных перед выполнением необратимых действий.

Модели развертывания

- Выполнение вызовов модели из выделенного рабочего процесса для управления параллелизмом и очередями.

- Переложите сложные задачи на асинхронных исполнителей (задачи Celery, Fargate, задания Cloud Run) и предоставляйте пользователям индикаторы хода выполнения.

- При экстремальных требованиях к задержке/пропускной способности рассмотрите соглашения об уровне обслуживания провайдера и возможность самостоятельного размещения или использования ускорителей провайдера.

Закрытие заметки

DeepSeek-V3.1 — это практичная гибридная модель, разработанная как для быстрого чата, так и для сложных агентских задач. Совместимость с OpenAI упрощает миграцию во многие проекты, а совместимость с Anthropic и CometAPI делает её гибкой для существующих экосистем. Тесты производительности и отчёты сообщества демонстрируют многообещающие компромиссы между стоимостью и производительностью, но, как и любую новую модель, перед её полноценным внедрением проверьте её на реальных рабочих нагрузках (подсказки, вызов функций, проверки безопасности, задержка).

На CometAPI вы можете безопасно запустить его и взаимодействовать с ним через совместимый с OpenAI API или удобный для пользователя интерфейс. детская площадка, без ограничений по ставкам.

👉 Разверните DeepSeek-V3.1 на CometAPI прямо сейчас!

Зачем использовать CometAPI?

- Мультиплексирование провайдера: смена провайдера без переписывания кода.

- Единый биллинг/метрики: если вы направляете несколько моделей через CometAPI, вы получаете единую поверхность интеграции.

- Метаданные модели: просмотр длины контекста и активных параметров для каждого варианта модели.