Что такое GPT-5.2 API

GPT-5.2 API — это то же, что GPT-5.2 Thinking в ChatGPT. GPT-5.2 Thinking — вариант среднего уровня в семействе OpenAI GPT-5.2, созданный для более глубокой работы: многошаговые рассуждения, суммирование длинных документов, качественная генерация кода и профессиональная интеллектуальная работа, где точность и пригодная структура важнее, чем чистая производительность. В API он представлен как модель gpt-5.2 (Responses API / Chat Completions) и находится между низколатентным вариантом Instant и более качественным, но более дорогим вариантом Pro.

Основные возможности

- Очень длинный контекст и компактация: эффективное окно в 400K и инструменты сжатия для управления релевантностью в длинных диалогах и документах.

- Настраиваемые усилия на рассуждения:

none | medium | high | xhigh(xhigh включает максимальные внутренние вычисления для сложных рассуждений).xhighдоступен вариантам Thinking/Pro. - Усиленная поддержка инструментов и функций: первоклассные вызовы инструментов, грамматики (CFG/Lark) для ограничения структурированных ответов и улучшенные агентные возможности, упрощающие сложную многошаговую автоматизацию.

- Мультимодальное понимание: более глубокое понимание изображений и текста и интеграция в многошаговые задачи.

- Улучшенная безопасность / обработка чувствительного контента: точечные меры для снижения нежелательных ответов в областях вроде самоповреждения и других чувствительных контекстов.

Технические возможности и спецификации (для разработчиков)

- API endpoints и идентификаторы моделей:

gpt-5.2для Thinking (Responses API),gpt-5.2-chat-latestдля чат/instant рабочих процессов иgpt-5.2-proдля уровня Pro; доступны через Responses API и Chat Completions, где указано. - Reasoning tokens и управление усилиями: API поддерживает явные параметры для распределения вычислений (усилий на рассуждения) на запрос; более высокий уровень усилий увеличивает задержку и стоимость, но улучшает качество вывода для сложных задач.

- Инструменты структурированного вывода: поддержка грамматик (Lark / CFG) для ограничения вывода модели до DSL или точного синтаксиса (полезно для SQL, JSON, генерации DSL).

- Параллельные вызовы инструментов и агентная координация: улучшенный параллелизм и более чистая оркестрация инструментов сокращают потребность в сложных системных промптах и многоагентных каркасах.

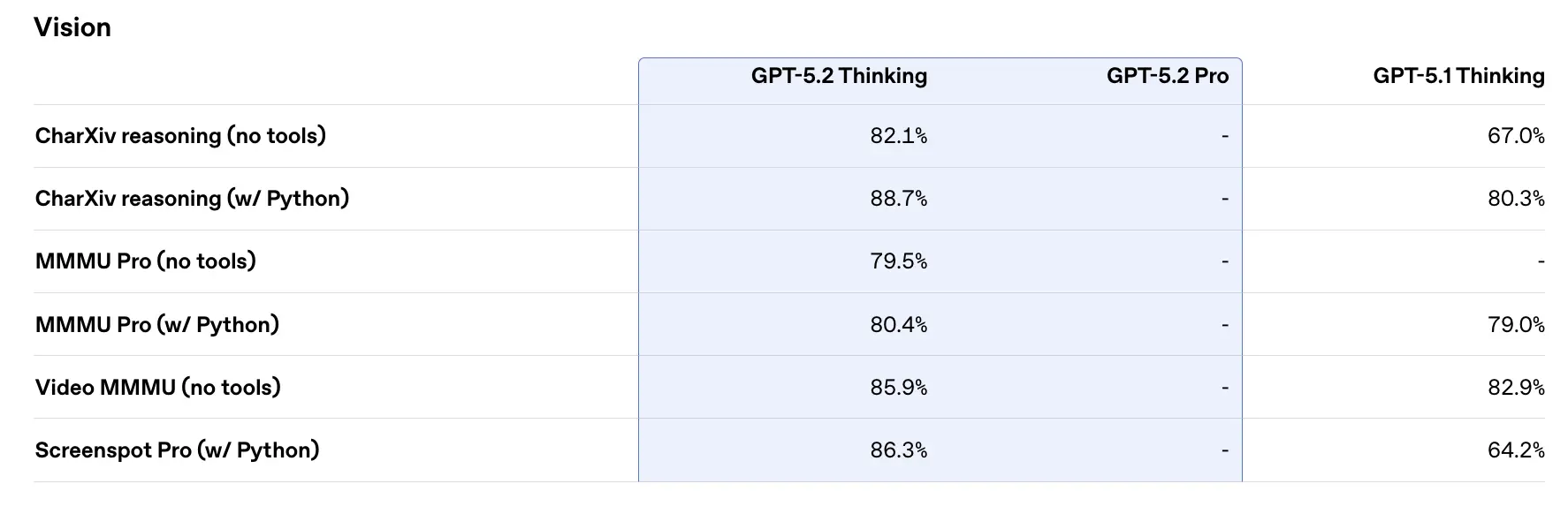

Результаты на бенчмарках и сопутствующие данные

OpenAI опубликовала множество внутренних и внешних результатов бенчмарков для GPT-5.2. Выбранные основные моменты (по данным OpenAI):

- GDPval (44 профессии, интеллектуальная работа) — GPT-5.2 Thinking «обходит или сравнивается с ведущими отраслевыми профессионалами в 70.9% сравнений»; OpenAI сообщает, что результаты были получены на >11× скорости и при <1% стоимости по сравнению с экспертами-профессионалами в их задачах GDPval (оценки скорости и стоимости основаны на исторических данных). Эти задачи включают модели в таблицах, презентации и короткие видео.

- SWE-Bench Pro (кодинг) — GPT-5.2 Thinking достигает ≈55.6% на SWE-Bench Pro и ~80% на SWE-Bench Verified (только Python) по данным OpenAI, устанавливая новый уровень для оценки генерации кода/инженерии в их тестах. На практике это означает более надёжную отладку и end-to-end исправления, согласно примерам OpenAI.

- GPQA Diamond (вопросы и ответы уровня магистратуры по науке) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% на GPQA Diamond (без инструментов, максимальные рассуждения).

- Серия ARC-AGI — На ARC-AGI-2 (более сложный бенчмарк «мягких» рассуждений) GPT-5.2 Thinking набрал 52.9%, а GPT-5.2 Pro 54.2% (OpenAI говорит, что это новые рекордные показатели для моделей в стиле chain-of-thought).

- Длинный контекст (OpenAI MRCRv2) — GPT-5.2 Thinking показывает почти 100% точность на варианте 4-needle MRCR до 256k токенов и существенно улучшенные результаты по сравнению с GPT-5.1 в сценариях длинного контекста. (OpenAI опубликовала графики и таблицы MRCRv2.)

Сравнение с современными аналогами

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro заявлен с контекстным окном ~1,048,576 (≈1M) токенов и широкими мультимодальными входами (текст, изображение, аудио, видео, PDF) и сильными агентными интеграциями через Vertex AI / AI Studio. На бумаге более крупное контекстное окно Gemini 3 — дифференциатор для чрезвычайно больших задач в одной сессии; компромиссы включают поверхность инструментов и соответствие экосистеме.

- vs Anthropic Claude Opus 4.5: Anthropic Opus 4.5 делает акцент на корпоративные кодинг/агентные рабочие процессы и сообщает о сильных результатах SWE-Bench и устойчивости для длительных агентных сессий; Anthropic позиционирует Opus для автоматизации и генерации кода с контекстным окном 200k и специализированными интеграциями агент/Excel. Opus 4.5 — сильный конкурент в корпоративной автоматизации и задачах по коду.

Практический вывод: GPT-5.2 нацелен на сбалансированный набор улучшений (контекст 400k, высокий объём вывода токенов, улучшенные рассуждения/кодинг). Gemini 3 нацелен на максимально большой контекст одной сессии (≈1M), а Claude Opus фокусируется на корпоративной инженерии и устойчивости агентных сценариев. Выбирайте, сопоставляя размер контекста, потребности в модальности, соответствие функционалу/инструментам и компромиссы по стоимости/латентности.

Как получить доступ и использовать GPT-5.2 API

Шаг 1: зарегистрируйтесь и получите API-ключ

Войдите на cometapi.com. Если вы ещё не являетесь нашим пользователем, сначала зарегистрируйтесь. Авторизуйтесь в своей CometAPI console. Получите учётные данные доступа — API key интерфейса. Нажмите “Add Token” в разделе API token в личном кабинете, получите ключ токена: sk-xxxxx и отправьте.

Шаг 2: отправляйте запросы к GPT-5.2 API

Выберите endpoint “gpt-5.2” для отправки API-запроса и задайте тело запроса. Метод и тело запроса берутся из API doc на нашем сайте. Наш сайт также предоставляет тест Apifox для вашего удобства. Замените <YOUR_API_KEY> на ваш фактический ключ CometAPI из аккаунта. Разработчики вызывают это через Responses API / Chat endpoints.

Вставьте свой вопрос или запрос в поле content — именно на него модель ответит. Обработайте ответ API, чтобы получить сгенерированный результат.

Шаг 3: получите и проверьте результаты

Обработайте ответ API, чтобы получить сгенерированный результат. После обработки API возвращает статус задачи и выходные данные.

См. также Gemini 3 Pro Preview API