GLM-4.6 — последний крупный релиз семейства GLM компании Z.ai (ранее Zhipu AI): LLM 4-го поколения на основе MoE (Mixture-of-Experts), настроенная для агентных рабочих процессов, рассуждений на длинном контексте и реального программирования. Релиз делает упор на практическую интеграцию с агентами/инструментами, очень большое окно контекста и доступность открытых весов для локального развертывания.

Key features

- Long context — родное окно контекста 200K токенов (расширено с 128K). (docs.z.ai)

- Coding & agentic capability — заявлены улучшения на задачах реального программирования и лучший вызов инструментов для агентов.

- Efficiency — сообщается о ~30% более низком потреблении токенов по сравнению с GLM-4.5 на тестах Z.ai.

- Deployment & quantization — впервые объявлена интеграция FP8 и Int4 для чипов Cambricon; родная поддержка FP8 на Moore Threads через vLLM.

- Model size & tensor type — опубликованные артефакты указывают на модель с ~357B параметров (тензоры BF16 / F32) на Hugging Face.

Technical details

Modalities & formats. GLM-4.6 — текстовая LLM (входные и выходные модальности: текст). Длина контекста = 200K токенов; макс. вывод = 128K токенов.

Quantization & hardware support. Команда сообщает о квантовании FP8/Int4 на чипах Cambricon и о родном выполнении FP8 на GPU Moore Threads с использованием vLLM для инференса — важно для снижения стоимости инференса и для on-prem и отечественных облачных развертываний.

Tooling & integrations. GLM-4.6 распространяется через API Z.ai, сети сторонних провайдеров (например, CometAPI) и интегрирована в кодовые агенты (Claude Code, Cline, Roo Code, Kilo Code).

Technical details

Modalities & formats. GLM-4.6 — текстовая LLM (входные и выходные модальности: текст). Длина контекста = 200K токенов; макс. вывод = 128K токенов.

Quantization & hardware support. Команда сообщает о квантовании FP8/Int4 на чипах Cambricon и о родном выполнении FP8 на GPU Moore Threads с использованием vLLM для инференса — важно для снижения стоимости инференса и для on-prem и отечественных облачных развертываний.

Tooling & integrations. GLM-4.6 распространяется через API Z.ai, сети сторонних провайдеров (например, CometAPI) и интегрирована в кодовые агенты (Claude Code, Cline, Roo Code, Kilo Code).

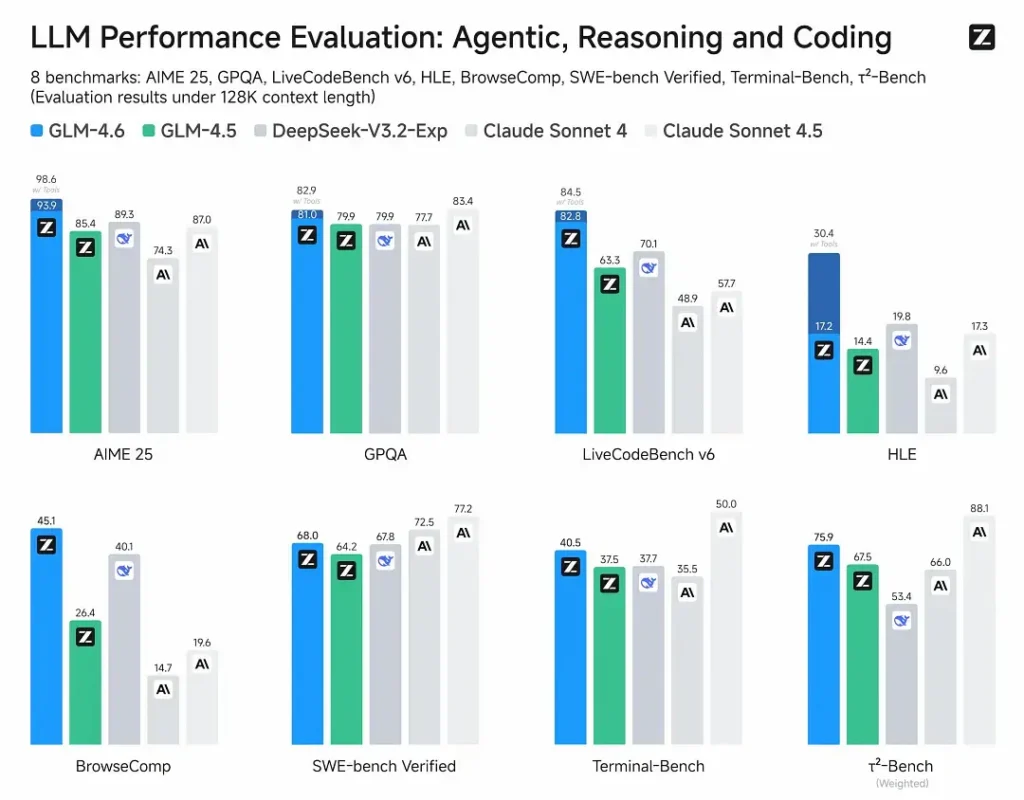

Benchmark performance

- Published evaluations: GLM-4.6 была протестирована на восьми публичных бенчмарках, охватывающих агентов, рассуждение и программирование, и показывает очевидные приросты по сравнению с GLM-4.5. На оценённых людьми тестах реального программирования (расширенный CC-Bench) GLM-4.6 использует ~15% меньше токенов по сравнению с GLM-4.5 и демонстрирует ~48,6% долю побед против Claude Sonnet 4 от Anthropic (почти паритет на многих рейтингах).

- Positioning: результаты утверждают, что GLM-4.6 конкурентоспособна с ведущими отечественными и международными моделями (в качестве примеров упомянуты DeepSeek-V3.1 и Claude Sonnet 4).

Limitations & risks

- Hallucinations & mistakes: как и все современные LLM, GLM-4.6 может допускать фактические ошибки — документация Z.ai прямо предупреждает, что выводы могут содержать ошибки. Пользователям следует применять верификацию & retrieval/RAG для критичного контента.

- Model complexity & serving cost: окно в 200K и очень большие ответы резко увеличивают требования к памяти & задержкам и могут повысить стоимость инференса; для работы на масштабе требуются квантование/инженерия инференса.

- Domain gaps: при заявленной сильной производительности в агентных/кодовых задачах некоторые публичные отчёты отмечают, что модель всё ещё отстаёт от отдельных версий конкурентов в конкретных микробенчмарках (например, по некоторым метрикам программирования против Sonnet 4.5). Оценивайте по задачам, прежде чем заменять производственные модели.

- Safety & policy: открытые веса повышают доступность, но также поднимают вопросы ответственности; смягчения, гардрейлы и редтиминг остаются обязанностью пользователя.

Use cases

- Agentic systems & tool orchestration: длинные трассы агента, планирование с несколькими инструментами, динамический вызов инструментов; агентная настройка модели — ключевое преимущество.

- Real-world coding assistants: многотуровая генерация кода, ревью кода и интерактивные ассистенты IDE (интегрированы в Claude Code, Cline, Roo Code — по данным Z.ai). Улучшения эффективности по токенам делают модель привлекательной для тарифов разработчиков с интенсивным использованием.

- Long-document workflows: суммаризация, синтез по нескольким документам, длительные юридические/технические обзоры благодаря окну в 200K.

- Content creation & virtual characters: протяжённые диалоги, поддержание согласованной персоны в многотуровых сценариях.

How GLM-4.6 compares to other models

- GLM-4.5 → GLM-4.6: скачок в размере контекста (128K → 200K) и эффективности по токенам (~15% меньше токенов на CC-Bench); улучшено использование агентов/инструментов.

- GLM-4.6 vs Claude Sonnet 4 / Sonnet 4.5: Z.ai сообщает почти паритет на нескольких рейтингах и ~48,6% долю побед на задачах реального программирования CC-Bench (т.е. близкая конкуренция, при этом на отдельных микробенчмарках Sonnet всё ещё лидирует). Для многих инженерных команд GLM-4.6 позиционируется как экономичный альтернативный вариант.

- GLM-4.6 vs другие модели с длинным контекстом (DeepSeek, варианты Gemini, семейство GPT-4): GLM-4.6 делает акцент на большом контексте и агентных рабочих процессах для программирования; относительные сильные стороны зависят от метрики (эффективность по токенам/интеграция с агентами vs точность синтеза кода или пайплайны безопасности). Эмпирический выбор должен быть задачево ориентирован.

Последняя флагманская модель Zhipu AI GLM-4.6 выпущена: 355B всего параметров, 32B активных. Превосходит GLM-4.5 по всем ключевым возможностям.

- Coding: Сопоставима с Claude Sonnet 4, лучшая в Китае.

- Context: Расширено до 200K (с 128K).

- Reasoning: Улучшено, поддерживает вызов инструментов во время инференса.

- Search: Усилен вызов инструментов и производительность агентов.

- Writing: Лучше согласуется с человеческими предпочтениями по стилю, читаемости и ролевому взаимодействию.

- Multilingual: Усилены возможности межъязыкового перевода.