В стремительно развивающемся мире искусственного интеллекта выпуск каждой новой модели большого языка (LLM) представляет собой нечто большее, чем просто числовое обновление версии — это сигнал о прогрессе в области рассуждений, навыков программирования и взаимодействия человека и машины. В конце сентября 2025 года Жипу АИ (Z.ai) представила ГЛМ-4.6, новейшего представителя семейства General Language Model. Основываясь на надежной архитектуре и прочной логической базе GLM-4.5, это обновление расширяет возможности модели. агентное мышление, кодирующий интеллект и понимание в длительном контексте, оставаясь при этом открытым и доступным как для разработчиков, так и для предприятий.

Что такое GLM-4.6?

GLM-4.6 — это основной релиз в серии GLM (General Language Model), призванный сбалансировать высокопроизводительные рассуждения с практическими рабочими процессами разработчиков. В целом, релиз ориентирован на три тесно связанных варианта использования: (1) расширенная генерация кода и рассуждения о коде, (2) задачи с расширенным контекстом, требующие понимания модели на очень больших объемах входных данных, и (3) агентные рабочие процессы, где модель должна планировать, вызывать инструменты и организовывать многоэтапные процессы. Модель поставляется в вариантах, предназначенных для облачных API и хабов моделей сообщества, что позволяет использовать как развёртываемые, так и развёртываемые шаблоны.

Фактически, GLM-4.6 позиционируется как флагманская версия, ориентированная на разработчиков: её улучшения касаются не только чистых показателей бенчмарков, но и возможностей, которые существенно меняют подход разработчиков к созданию помощников, помощников по коду и агентов, управляемых документами или знаниями. Ожидается, что в релизе особое внимание будет уделено настройке инструкций для использования инструментов, детальным улучшениям качества и отладки кода, а также выбору инфраструктуры, позволяющему работать с очень длинными контекстами без линейного снижения производительности.

Какую задачу призван решить GLM-4.6?

- Уменьшите неудобства при работе с длинными кодовыми базами и большими документами за счет поддержки более длинных эффективных контекстных окон.

- Повысить надежность генерации и отладки кода, создавая более идиоматические, проверяемые результаты.

- Повысить надежность агентного поведения — планирования, использования инструментов и многоэтапного выполнения задач — за счет целенаправленных инструкций и настройки в стиле подкрепления.

Что изменилось на практике при переходе от GLM-4.5 к GLM-4.6?

- Контекстное масштабирование: 128K перейти к 200 тысяч токенов Это самое значительное изменение пользовательского опыта и архитектуры для пользователей: длинные документы, целые кодовые базы или расширенные расшифровки агентов теперь можно обрабатывать в одном контекстном окне. Это снижает необходимость в произвольном разделении данных на фрагменты и дорогостоящих циклах поиска для многих рабочих процессов.

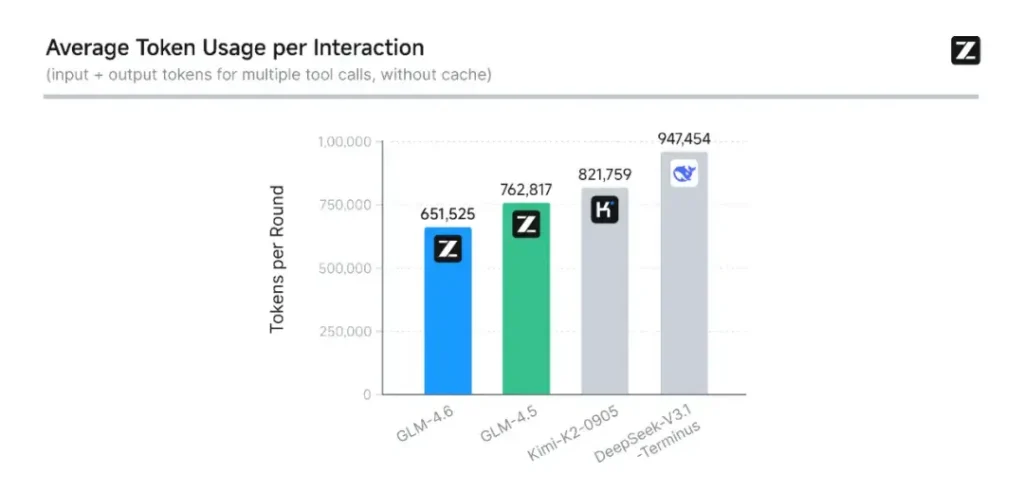

- Кодирование и реальная оценка: Z.ai расширил CC-Bench (их тест кодирования и завершения) более сложными траекториями реальных задач и сообщает, что GLM-4.6 завершает задачи с ~на 15% меньше токенов по сравнению с GLM-4.5, при этом повышая показатели успешности решения сложных многоэтапных инженерных задач. Это свидетельствует о более высокой эффективности токенов, а также об улучшении базовых возможностей в прикладных сценариях кодирования. Z.ai

- Интеграция агента и инструмента: GLM-4.6 включает улучшенные шаблоны поддержки для вызова инструментов и агентов поиска, что важно для продуктов, которые используют эту модель для организации веб-поиска, выполнения кода или других микросервисов.

Каковы основные особенности GLM-4.6?

1. Расширенное контекстное окно до 200 тыс. токенов

Одной из самых примечательных особенностей GLM-4.6 является его значительно расширенное контекстное окно. Расширение с 128К в предыдущем поколении до 200 тысяч токеновGLM-4.6 может обрабатывать целые книги, сложные многодокументные наборы данных или многочасовые диалоги за один сеанс. Это расширение не только улучшает понимание, но и позволяет последовательное рассуждение на основе длинных входных данных — большой шаг вперед в процессах реферирования документов, юридического анализа и разработки программного обеспечения.

2. Улучшенный интеллект кодирования

Внутренний Zhipu AI CC-Bench Тест, набор реальных задач программирования, показывает, что GLM-4.6 достигает заметные улучшения в точности и эффективности кодирования. Модель может создавать синтаксически правильный, логически обоснованный код при использовании примерно на 15% меньше токенов чем GLM-4.5 для аналогичных задач. Такая высокая эффективность означает более быстрое и дешевое выполнение задач без ущерба для качества — важнейший фактор для корпоративного внедрения.

3. Расширенные возможности логического мышления и интеграции инструментов

Помимо генерации сырого текста, GLM-4.6 блистает рассуждения, дополненные инструментами. Он обучен и настроен для многоэтапного планирования и управления внешними системами — от баз данных до инструментов поиска и сред выполнения. На практике это означает, что GLM-4.6 может выступать в роли «мозга» автономный агент ИИ, решая, когда вызывать внешние API, как интерпретировать результаты и как поддерживать непрерывность задач между сеансами.

4. Улучшенное выравнивание естественного языка

Благодаря непрерывному обучению с подкреплением и оптимизации предпочтений GLM-4.6 обеспечивает более плавный ход разговора, лучшее соответствие стилям и более строгая настройка безопасности. Модель адаптирует свой тон и структуру к контексту — будь то официальная документация, образовательные занятия или творческое письмо — повышая доверие пользователей и удобочитаемость.

Какая архитектура лежит в основе GLM-4.6?

Является ли GLM-4.6 моделью «смешанных экспертов»?

Непрерывность метода вывода: Команда GLM отмечает, что GLM-4.5 и GLM-4.6 используют один и тот же фундаментальный конвейер вывода, что позволяет модернизировать существующие конфигурации развёртывания с минимальными трудностями. Это снижает операционный риск для команд, уже использующих GLM-4.x. При этом параметры масштабирования и выбор дизайна модели делают акцент на специализации для агентного мышления, кодирования и эффективного вывода. В отчёте GLM-4.5 представлено наиболее чёткое из доступных для публичного ознакомления описание стратегии и режима обучения MoE семейства (многоэтапное предварительное обучение, итерация экспертной модели, обучение с подкреплением для согласования); GLM-4.6 применяет эти знания, одновременно корректируя длину контекста и возможности, специфичные для конкретных задач.

Практические архитектурные заметки для инженеров

- Параметрический след в сравнении с активированными вычислениями: Большие значения параметров (сотни миллиардов) напрямую не переводятся в эквивалентную стоимость активации для каждого запроса — MoE означает, что только подмножество экспертов активируется для каждой последовательности токенов, что обеспечивает более выгодное соотношение стоимости и пропускной способности для многих рабочих нагрузок.

- Точность и форматы токенов: Публичные веса распространяются в форматах BF16 и F32, а квантизации сообщества (GGUF, 4-/8-/бит) появляются быстро; они позволяют командам запускать GLM-4.6 на различных аппаратных профилях.

- Совместимость стека вывода: Z.ai документирует vLLM и другие современные среды выполнения LLM как совместимые бэкэнды вывода, что делает GLM-4.6 пригодным как для облачных, так и для локальных развертываний.

Тест производительности: каковы результаты GLM-4.6?

Какие контрольные показатели были представлены?

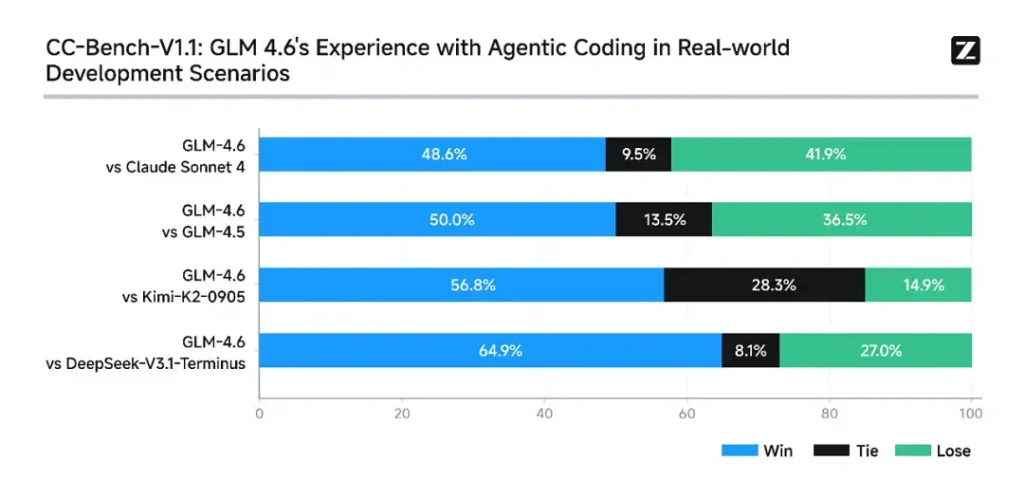

Z.ai оценил GLM-4.6 по набору восемь публичных ориентиров Они охватывают агентные задачи, рассуждения и кодирование. Они также расширили CC-Bench (тест производительности программирования на реальных задачах, оцениваемый человеком в изолированных Docker-средах) для более точной имитации задач производственного проектирования (разработка front-end, тестирование, решение алгоритмических задач). В этих задачах GLM-4.6 показал стабильное превосходство над GLM-4.5.

Производительность кодирования

- Победы в реальных задачах: В испытаниях на людях CC-Bench GLM-4.6 достиг почти паритет с Клодом Соннетом 4 от Anthropic в многоходовых задачах лицом к лицу — Z.ai сообщает о 48.6% винрейт В их изолированных от Docker и оцениваемых человеком оценках (интерпретация: примерно 50/50 с Claude Sonnet 4 в их курируемом наборе). В то же время GLM-4.6 превзошла ряд отечественных открытых моделей (например, варианты DeepSeek) при выполнении своих задач.

- Эффективность токена: Отчеты Z.ai ~на 15% меньше токенов используется для завершения задач по сравнению с GLM-4.5 в траекториях CC-Bench — это имеет значение как для задержки, так и для стоимости.

Рассуждение и математика

GLM-4.6 демонстрирует улучшенную способность к рассуждению и более высокую эффективность использования инструментов по сравнению с GLM-4.5. В то время как GLM-4.5 делал акцент на гибридном «мышлении» и режимах прямого ответа, GLM-4.6 повышает надёжность многошагового рассуждения, особенно при интеграции с инструментами поиска или выполнения.

Публичные сообщения Z.ai позиционируют GLM-4.6 как конкурентоспособны с ведущими международными и отечественными моделями В выбранных ими тестах производительности, в частности, конкурентоспособен с Claude Sonnet 4 и превосходит некоторые отечественные альтернативы, такие как варианты DeepSeek, в задачах кодирования/агента. Однако в некоторых специфичных для кодирования субтестах** GLM-4.6 всё ещё уступает Claude Sonnet 4.5 (более поздней версии Anthropic), что говорит о наличии скорее тесной конкуренции, чем явного доминирования.

Как получить доступ к GLM-4.6

- 1. Через платформу Z.ai: Разработчики могут получить доступ к GLM-4.6 напрямую через API Z.ai or **интерфейс чата (chat.z.ai)**Эти размещённые сервисы позволяют быстро экспериментировать и интегрировать решения без локального развертывания. API поддерживает как стандартное автодополнение текста, так и режимы структурированного вызова инструментов, что крайне важно для рабочих процессов агентов.

- 2. Открытые веса на Hugging Face и ModelScope: Для тех, кто предпочитает локальное управление, Zhipu AI выпустил файлы модели GLM-4.6 на Обнимая лицо и МодельОбласть, включая версии safetensors в BF16 и F32 Точность. Разработчики сообщества уже создали квантованные версии GGUF, позволяющие проводить анализ на графических процессорах потребительского уровня.

- 3. Интеграционные фреймворки: GLM-4.6 легко интегрируется с основными механизмами вывода, такими как vLLM, СГЛанг и LMDeploy, что делает его адаптируемым к современным системам обслуживания. Эта универсальность позволяет предприятиям выбирать между облако, край и локальное развертывание в зависимости от требований соответствия или задержки.

CometAPI — это унифицированная платформа API, которая объединяет более 500 моделей ИИ от ведущих поставщиков, таких как серия GPT OpenAI, Gemini от Google, Claude от Anthropic, Midjourney, Suno и других, в единый, удобный для разработчиков интерфейс. Предлагая последовательную аутентификацию, форматирование запросов и обработку ответов, CometAPI значительно упрощает интеграцию возможностей ИИ в ваши приложения. Независимо от того, создаете ли вы чат-ботов, генераторы изображений, композиторов музыки или конвейеры аналитики на основе данных, CometAPI позволяет вам выполнять итерации быстрее, контролировать расходы и оставаться независимыми от поставщика — и все это при использовании последних достижений в экосистеме ИИ.

Новейшая интеграция GLM-4.6 скоро появится на CometAPI, так что следите за новостями! Пока мы завершаем загрузку моделей GLM 4.6, изучите другие наши модели на странице «Модели» или попробуйте их в AI Playground.

Разработчики могут получить доступ API GLM‑4.5 через CometAPI, последняя версия модели Всегда обновляется на официальном сайте. Для начала изучите возможности модели в Детская Площадка и проконсультируйтесь с API-руководство для получения подробных инструкций. Перед доступом убедитесь, что вы вошли в CometAPI и получили ключ API. CometAPI предложить цену намного ниже официальной, чтобы помочь вам интегрироваться.

Готовы к работе?→ Зарегистрируйтесь в CometAPI сегодня !

Заключение — Почему GLM-4.6 важен сейчас

GLM-4.6 — важная веха в линейке GLM, поскольку она сочетает в себе практические улучшения для разработчиков — более длинные контекстные окна, целевое кодирование и оптимизацию агентов, а также ощутимый прирост производительности — с открытостью и гибкостью экосистемы, необходимыми многим организациям. Для команд, разрабатывающих помощников по кодированию, агентов для работы с длинными документами или автоматизированные решения с использованием инструментов, GLM-4.6 заслуживает оценки как один из лучших кандидатов.