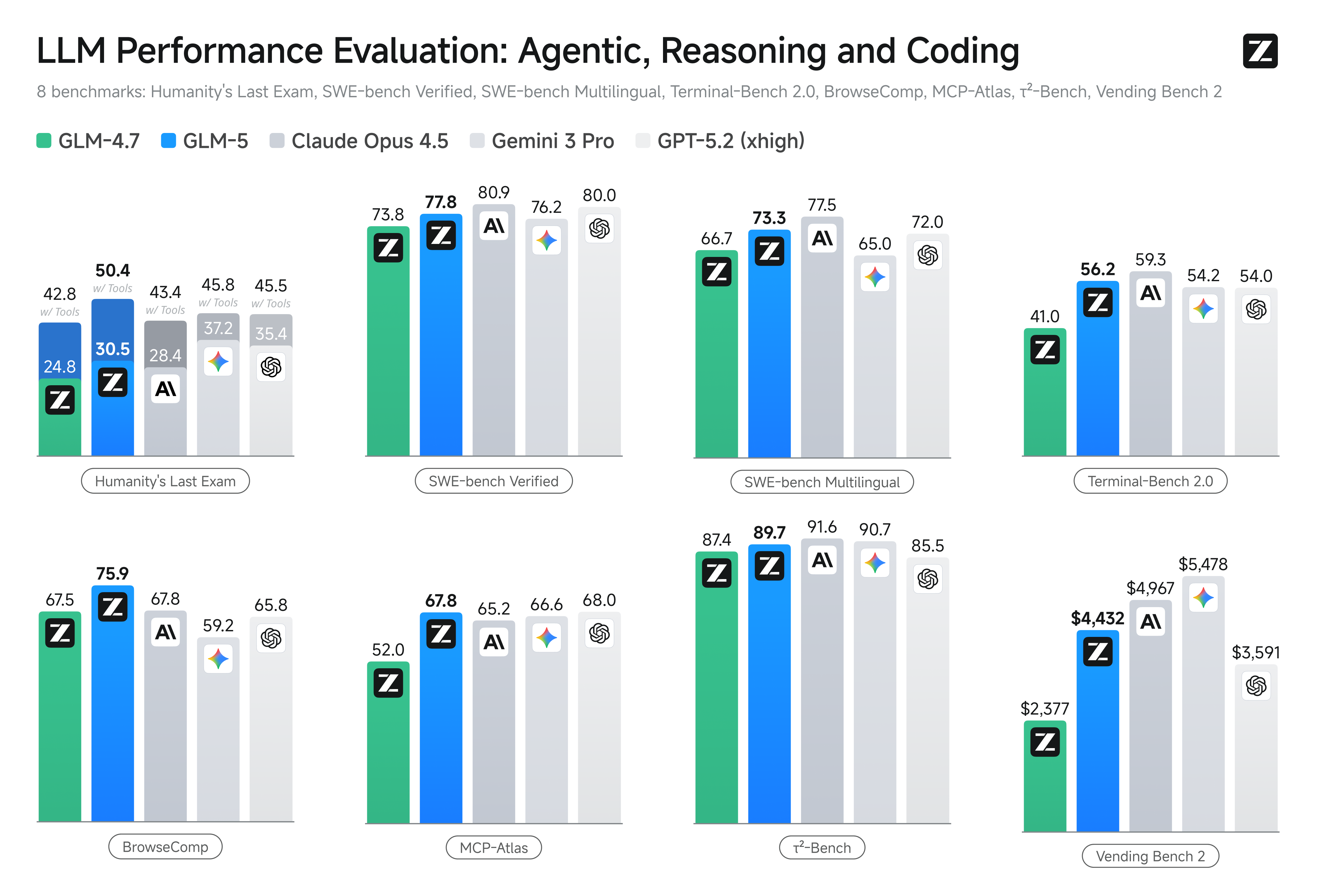

การเปิดตัว GLM-5 ซึ่งเผยโฉมในสัปดาห์นี้โดย Zhipu AI ของจีน (ทำการตลาดสาธารณะในชื่อ Z.AI / zai-org ในหลายช่องทางของนักพัฒนา) ถือเป็นอีกก้าวหนึ่งในจังหวะการปล่อยโมเดลขนาดใหญ่ที่เร่งตัวขึ้น โมเดลใหม่นี้ถูกวางตำแหน่งให้เป็นเรือธงของ Zhipu: มีขนาดใหญ่ขึ้น ปรับจูนเพื่อภารกิจเชิง agentic ระยะยาว และสร้างด้วยตัวเลือกทางวิศวกรรมที่มุ่งลดต้นทุนการอนุมานพร้อมคงบริบทยาวไว้ รายงานเบื้องต้นในอุตสาหกรรมและบันทึกจากนักพัฒนาที่ทดลองใช้งานบ่งชี้ว่ามีความก้าวหน้าที่มีนัยสำคัญในด้านการเขียนโค้ด การให้เหตุผลหลายขั้น และการประสานงานเอเจนต์เมื่อเทียบกับ GLM รุ่นก่อน — และในบางการทดสอบยังท้าทาย Claude 4.5 ด้วย

GLM-5 คืออะไร และใครเป็นผู้พัฒนา?

GLM-5 เป็นรุ่นหลักล่าสุดในตระกูล GLM: โมเดลฐานขนาดใหญ่แบบโอเพนซอร์สที่พัฒนาและเผยแพร่โดย Z.ai (ทีมผู้อยู่เบื้องหลังซีรีส์ GLM) ประกาศเมื่อต้นกุมภาพันธ์ 2026 GLM-5 ถูกนำเสนอว่าเป็นโมเดลยุคถัดไปที่ปรับจูนเป็นพิเศษสำหรับงานเชิง "agentic" — กล่าวคือ เวิร์กโฟลว์หลายขั้นตอน ระยะยาว ที่โมเดลต้องวางแผน เรียกใช้เครื่องมือ ดำเนินการ และคงบริบทสำหรับบทสนทนาหรือเอเจนต์อัตโนมัติที่ยืดเยื้อ การเปิดตัวนี้โดดเด่นไม่เพียงด้านการออกแบบโมเดล แต่ยังรวมถึงกระบวนการและแพลตฟอร์มการฝึก: Z.ai ใช้ฮาร์ดแวร์และทูลเชนภายในประเทศจีนผสมผสานกันเป็นส่วนหนึ่งของความพยายามด้านความพึ่งพาตนเอง

ตัวเลขสถาปัตยกรรมและการฝึกที่ถูกรายงานประกอบด้วย:

- การสเกลพารามิเตอร์: GLM-5 สเกลขึ้นไปถึงราวๆ 744B parameters (โดยมีจำนวนผู้เชี่ยวชาญที่ "active" น้อยกว่าตามบันทึกเทคนิคบางแห่ง เช่น active 40B) เทียบกับขนาดตระกูล GLM-4 ก่อนหน้าประมาณ 355B/32B active

- ข้อมูลพรีเทรน: ขนาดคอร์ปัสฝึก reportedly เพิ่มจาก ~23 ล้านล้านโทเคน (รุ่น GLM-4) เป็น ~28.5 ล้านล้านโทเคน สำหรับ GLM-5

- Sparse attention / DeepSeek Sparse Attention (DSA): สคีมาสนใจแบบ sparse เพื่อคงบริบทยาวขณะลดต้นทุนคำนวณระหว่างการอนุมาน

- แนวเน้นการออกแบบ: ตัวเลือกทางวิศวกรรมที่โฟกัสการประสานงานเอเจนต์ การให้เหตุผลบนบริบทยาว และการอนุมานที่คุ้มค่า

ที่มาและการวางตำแหน่ง

GLM-5 สานต่อจากสายผลิตภัณฑ์ที่รวมถึง GLM-4.5 (เปิดตัวกลางปี 2025) และอัปเดตย่อยอย่าง 4.7 Z.ai วางตำแหน่ง GLM-5 ว่าเป็นการก้าวกระโดดจาก "vibe coding" (เอาต์พุตโค้ดแบบขั้นตอนเดี่ยวรวดเร็ว) ไปสู่ “agentic engineering”: การให้เหตุผลต่อเนื่อง การประสานหลายเครื่องมือ และการสังเคราะห์ระบบบนบริบทยาว วัสดุสาธารณะชี้ว่า GLM-5 ออกแบบมาเพื่อรองรับงานวิศวกรรมระบบที่ซับซ้อน — การสร้าง ประสาน และคงพฤติกรรมเอเจนต์หลายขั้น มากกว่าการตอบคำถามแบบโดดเดี่ยว

ฟีเจอร์ใหม่ใน GLM-5 มีอะไรบ้าง?

การเปลี่ยนแปลงทางสถาปัตยกรรมหลัก

- การสเกลแบบ sparse ขนาดมหึมา (MoE): GLM-5 เปลี่ยนไปสู่สถาปัตยกรรม Mixture-of-Experts แบบ sparse ที่ใหญ่ขึ้นมาก ตัวเลขสาธารณะจากเพจนักพัฒนาและบทความอิสระระบุโมเดลอยู่ที่ประมาณ 744B พารามิเตอร์ทั้งหมด โดย ~40B active ต่อโทเคน — เพิ่มขึ้นอย่างมีนัยสำคัญจากคอนฟิก ~355B / 32B active ของ GLM-4.5 การสเกลแบบ sparse นี้ทำให้โมเดลมีขีดความสามารถรวมสูงมาก ขณะยังคงการคำนวณต่อโทเคนให้อยู่ในระดับที่รับได้

- DeepSeek Sparse Attention (DSA): เพื่อคงความสามารถบริบทยาวโดยไม่ให้ต้นทุนอนุมานสเกลตามเส้นตรง GLM-5 ผสานกลไก attention แบบ sparse (ภายใต้แบรนด์ DeepSeek) เพื่อคงการพึ่งพาระยะไกลที่สำคัญไว้ในสเกลใหญ่ ขณะตัดทอนต้นทุนของ attention บนบริบทที่ยาวมาก

Agentic engineering เป็นเป้าหมายการออกแบบพื้นฐาน

หนึ่งในไฮไลท์ของ GLM-5 คือการออกแบบมาอย่างชัดเจนเพื่อ agentic engineering — หมายความว่าโมเดลตั้งใจใช้เป็น “สมอง” ของเอเจนต์หลายขั้นตอน ไม่ใช่เพียงแชตครั้งเดียวหรือสรุปสั้นๆ แต่เพื่อการวางแผน ออกคำสั่งเรียกใช้เครื่องมือ จัดการสถานะ และให้เหตุผลบนบริบทยาว Z.ai วาง GLM-5 ให้ทำงานในลูปออร์เคสเตรชัน: แตกปัญหาซับซ้อน เรียกใช้เครื่องมือ/API ภายนอก และติดตามงานยาวๆ หลายเทิร์น

ทำไมการออกแบบแบบ agentic จึงสำคัญ

เวิร์กโฟลว์แบบ agentic เป็นหัวใจของระบบอัตโนมัติในโลกจริง: ผู้ช่วยวิจัยอัตโนมัติ วิศวกรซอฟต์แวร์อัตโนมัติ การออร์เคสเตรตปฏิบัติการ และการควบคุมการจำลอง โมเดลที่สร้างมาเพื่อโลกนี้ต้องมีความสามารถในการวางแผนที่แข็งแกร่ง พฤติกรรมการเรียกใช้เครื่องมือที่เสถียร และความทนทานต่อบริบทจำนวนหลายพันโทเคน

การเขียนโค้ด เหตุผล และพฤติกรรม “ระยะยาว” ที่ดีขึ้น

GLM-5 เน้นการปรับปรุงการสร้างโค้ดและการให้เหตุผล Z.ai อ้างการปรับปรุงแบบมุ่งเป้าที่ความสามารถในการเขียน รีแฟกเตอร์ และดีบักโค้ด พร้อมความสม่ำเสมอของการให้เหตุผลหลายขั้นตอนตลอดปฏิสัมพันธ์ยาว รายงานการเข้าถึงก่อนกำหนดและการประเมินจากพาร์ตเนอร์พบว่าโมเดลแข็งแกร่งขึ้นอย่างเห็นได้ชัดในงานที่เน้นนักพัฒนามากกว่ารุ่น GLM ก่อนหน้า

ฟีเจอร์เชิงปฏิบัติสำหรับนักพัฒนา

- หน้าต่างบริบทที่ใหญ่ขึ้นเพื่อบรรจุเอกสาร โค้ดเบส และสถานะบทสนทนา

- พื้นฐานเครื่องมือสำหรับการเรียกใช้เครื่องมืออย่างปลอดภัยและการจัดการผลลัพธ์

- ประสิทธิภาพ few-shot และ chain-of-thought ที่ดีขึ้นเพื่อแตกและดำเนินงานซับซ้อน

- ฟีเจอร์ agentic และการเรียกใช้เครื่องมือ: GLM-5 เน้นการรองรับเอเจนต์แบบเนทีฟ: การเรียกใช้ฟังก์ชัน/เครื่องมือ เซสชันแบบมีสถานะ และการจัดการบทสนทนายาวและลำดับการใช้เครื่องมือที่ดีขึ้น ช่วยให้สร้างเอเจนต์ที่ผสานเว็บเสิร์ช ฐานข้อมูล หรือระบบอัตโนมัติของงานได้ง่ายขึ้น

GLM-5 ทำผลงานบนเบนช์มาร์กอย่างไร?

ไฮไลท์เบนช์มาร์กเฉพาะ

- เบนช์มาร์กการเขียนโค้ด: GLM-5 ใกล้เคียง (และบางกรณีเทียบเท่า) ประสิทธิภาพด้านโค้ดของโมเดลเชิงพาณิชย์ที่ปรับแต่งสูงอย่าง Claude Opus 4.5 บนงานโค้ดเฉพาะ ผลลัพธ์ขึ้นอยู่กับงาน (ยูนิตเทสต์ โค้ดเชิงอัลกอริทึม การใช้ API) แต่ก็สะท้อนการปรับปรุงชัดเจนจาก GLM-4.5

- การให้เหตุผลและการทดสอบเชิง agentic: บนชุดประเมินการให้เหตุผลหลายขั้นตอนและ agentic (เช่น การวางแผนหลายเทิร์น เบนช์มาร์กการแตกงาน) GLM-5 ทำคะแนนได้ดีที่สุดในกลุ่มโมเดลโอเพนซอร์ส และในบางเมตริกเหนือกว่าโมเดลปิดคู่แข่งบนงานเป้าหมาย

จะเข้าถึงและลองใช้ GLM-5 ได้อย่างไร?

GLM-5 คือโมเดลภาษาขนาดใหญ่รุ่นที่ห้าจาก Zhipu AI (Z.ai) ที่สร้างด้วยสถาปัตยกรรม Mixture-of-Experts (~745 B ทั้งหมด, ~44 B active) และมุ่งสู่เวิร์กโฟลว์การให้เหตุผล การเขียนโค้ด และ agentic ที่แข็งแกร่ง เปิดตัวอย่างเป็นทางการราววันที่ 12 ก.พ. 2026

ณ ตอนนี้มีสองวิธีหลักที่ผู้คนเข้าถึงมัน:

A) การเข้าถึงผ่าน API อย่างเป็นทางการ (Z.ai หรือผู้รวมบริการ)

Zhipu AI เองมี API สำหรับโมเดลของตน และคุณสามารถเรียก GLM-5 ผ่าน API เหล่านั้น

ขั้นตอนทั่วไป:

- สมัครบัญชี Z.ai/Open BigModel API

- รับคีย์ API จากแดชบอร์ด

- ใช้ปลายทางแบบ OpenAPI หรือ REST API พร้อมชื่อโมเดล (เช่น

glm-5)

(คล้ายกับวิธีเรียกใช้โมเดล GPT จาก OpenAI) - ตั้งค่าพรอมป์ต์และส่งคำขอ HTTP

👉 หน้า定价ของ Z.ai แสดงราคาดโทเคนอย่างเป็นทางการของ GLM-5 โดยประมาณดังนี้:

- ~$1.0 ต่อหนึ่งล้านโทเคนขาเข้า

- ~$3.2 ต่อหนึ่งล้านโทเคนขาออก

B) ตัวห่อ API จากบุคคลที่สาม ——CometAPI

API อย่าง CometAPI หรือ WaveSpeed จะรวบรวมโมเดล AI หลายตัว (OpenAI, Claude, Z.ai เป็นต้น) ไว้หลังอินเทอร์เฟซเดียว

- ด้วยบริการอย่าง CometAPI คุณสามารถเรียกโมเดล GLM ได้โดยสลับ ID ของโมเดล

(ปัจจุบัน CometAPI รองรับ GLM-5/GLM-4.7.) - ราคา glm-5 ของ CometAPI อยู่ที่ 20% ของราคาทางการ

| ประเภทการใช้งาน | ราคา |

|---|---|

| โทเคนขาเข้า | ~$0.8 per 1M tokens |

| โทเคนขาออก | ~$2.56 per 1M tokens |

ทำไมเรื่องนี้สำคัญ: คุณคงโค้ดไคลเอนต์ที่เข้ากันได้กับ OpenAI ที่มีอยู่ แล้วแค่เปลี่ยน base URL/model ID

C) โฮสต์เองผ่าน Hugging Face / Weights

มีที่เก็บน้ำหนักของ GLM-5 แบบไม่เป็นทางการ (เช่น เวอร์ชันชื่อ glm-5/glm-5-fp8) ปรากฏในรายการโมเดลของ Hugging Face

ด้วยสิ่งเหล่านี้คุณสามารถ:

- ดาวน์โหลดน้ำหนักของโมเดล

- ใช้เครื่องมืออย่าง vLLM, SGLang, xLLM, หรือ Transformers เพื่อให้บริการในเครื่องหรือบนคลาวด์ GPU ของคุณ

ข้อดี: ควบคุมได้สูงสุด ไม่มีค่าใช้จ่าย API ต่อเนื่อง

ข้อเสีย: ต้องการทรัพยากรคอมพิวต์ที่ มหาศาล — น่าจะต้องใช้ GPU ระดับสูงหลายตัวและหน่วยความจำ (หลายร้อย GB) ทำให้ไม่เหมาะกับระบบขนาดเล็ก

แล้ว GLM-5 คุ้มไหม และควรเก็บ GLM-4.7 ไว้หรือไม่?

คำตอบสั้นๆ (สรุปผู้บริหาร)

- หากงานของคุณต้องการพฤติกรรม agentic หลายขั้นที่แข็งแกร่ง การสร้างโค้ดระดับผลิต และระบบอัตโนมัติระดับระบบ: GLM-5 ควรค่าแก่การประเมินทันที สถาปัตยกรรม ขนาด และการปรับจูนของมันเน้นผลลัพธ์เหล่านี้โดยตรง

- หากคุณต้องการไมโครเซอร์วิสคุ้มค่า ปริมาณสูง (แชตสั้น การจัดประเภท พรอมป์ต์เบา): GLM-4.7 น่าจะยังคงเป็นตัวเลือกที่ประหยัดที่สุด GLM-4.7 รักษาความสามารถที่แข็งแกร่งในต้นทุนต่อโทเคนที่ต่ำกว่ามากในผู้ให้บริการหลายราย และผ่านศึกมาแล้ว

คำตอบยาว (คำแนะนำเชิงปฏิบัติ)

ใช้กลยุทธ์โมเดลแบบแบ่งชั้น: ใช้ GLM-4.7 สำหรับปฏิสัมพันธ์ประจำวันปริมาณสูง และสำรอง GLM-5 สำหรับปัญหาวิศวกรรมมูลค่าสูงและการออร์เคสเตรชันเชิง agentic เริ่มนำร่อง GLM-5 บนส่วนย่อยของผลิตภัณฑ์ที่ทดสอบบริบทยาว การผสานเครื่องมือ และความถูกต้องของโค้ด วัดทั้งเวลาวิศวกรรมที่ประหยัดได้และต้นทุนโมเดลที่เพิ่มขึ้น เมื่อเวลาผ่านไป คุณจะรู้ว่าอัปเกรดด้านความสามารถของ GLM-5 คุ้มต่อการย้ายใช้งานกว้างขึ้นหรือไม่

ด้วย CometAPI คุณสามารถสลับระหว่าง GLM-4.7 และ GLM-5 ได้ตลอดเวลา

กรณีใช้งานจริงที่ GLM-5 โดดเด่น

1. การออร์เคสเตรตเอเจนต์ที่ซับซ้อน

โฟกัสการออกแบบของ GLM-5 ที่การวางแผนหลายขั้นและการเรียกใช้เครื่องมือทำให้เหมาะกับระบบที่ต้องประสานการค้นหา การเรียก API และการรันโปรแกรม (เช่น ผู้ช่วยวิจัยอัตโนมัติ เครื่องมือสร้างโค้ดแบบวนซ้ำ หรือเอเจนต์บริการลูกค้าหลายขั้นที่ต้องปรึกษาฐานข้อมูลและ API ภายนอก)

2. วิศวกรรมแบบงานยาว & การให้เหตุผลบนโค้ดเบส

เมื่อคุณต้องการให้โมเดลวิเคราะห์ รีแฟกเตอร์ หรือสังเคราะห์ข้ามไฟล์จำนวนมากหรือโค้ดเบสใหญ่ บริบทที่ขยายและ attention แบบ sparse ของ GLM-5 เป็นข้อได้เปรียบโดยตรง — ลดโหมดล้มเหลวจากบริบทถูกตัดทอน และเพิ่มความสม่ำเสมอระยะยาว

3. การสังเคราะห์ความรู้เชิงลึก

นักวิเคราะห์และทีมผลิตภัณฑ์ที่สร้างรายงานที่ซับซ้อน — บทสรุปวิจัยหลายส่วน สรุปกฎหมาย หรือเอกสารกำกับดูแล — จะได้ประโยชน์จากการปรับปรุงด้านการให้เหตุผลหลายขั้นอย่างสม่ำเสมอและการลดอภินิหารในผลทดสอบที่ผู้ขายรายงาน

4. ระบบอัตโนมัติแบบ agentic สำหรับเวิร์กโฟลว์

ทีมที่สร้างระบบอัตโนมัติซึ่งต้องออร์เคสเตรตหลายระบบ (เช่น การวางแผน + ตั๋วงาน + สายการดีพลอย) สามารถใช้ GLM-5 เป็นตัววางแผนและผู้ดำเนินการหลัก โดยมีเฟรมเวิร์กการเรียกใช้เครื่องมือและตัวครอบความปลอดภัยรองรับ

บทสรุป

GLM-5 เป็นการเปิดตัวที่สำคัญในภูมิทัศน์โมเดลแนวหน้าอันเปลี่ยนแปลงรวดเร็ว การเน้น agentic engineering การเขียนโค้ดและการให้เหตุผลที่ดีขึ้น และความพร้อมของน้ำหนักแบบเปิด ทำให้มันน่าสนใจสำหรับทีมที่สร้างระบบ AI ที่ต้องการบริบทยาวและการใช้เครื่องมือจริง มีความก้าวหน้าจริงบนงานที่เลือกและอัตราส่วนต้นทุน/ประสิทธิภาพที่น่าพอใจ — แต่ผู้ใช้ควรประเมิน GLM-5 กับงานเฉพาะของตนเองและรันเบนช์มาร์กแบบควบคุมก่อนตัดสินใจนำไปใช้จริง

นักพัฒนาสามารถเข้าถึง GLM-5 ผ่าน CometAPI ได้แล้ว ขึ้นต้นด้วยการสำรวจความสามารถของโมเดลใน Playground และดู API guide สำหรับคำแนะนำโดยละเอียด ก่อนเข้าถึง โปรดตรวจสอบให้แน่ใจว่าคุณได้เข้าสู่ระบบ CometAPI และได้รับคีย์ API แล้ว CometAPI เสนอราคาที่ต่ำกว่าราคาทางการอย่างมากเพื่อช่วยให้คุณรวมใช้งานได้

Ready to Go?→ สมัครใช้งาน glm-5 วันนี้ !

หากต้องการเคล็ดลับ คำแนะนำ และข่าวสารเกี่ยวกับ AI มากขึ้น ติดตามเราได้ทาง VK, X และ Discord!