GPT-4o API แบบเรียลไทม์: จุดสิ้นสุดการสตรีมแบบหลายโหมดที่มีความล่าช้าต่ำซึ่งช่วยให้นักพัฒนาสามารถส่งและรับข้อความ เสียง และข้อมูลภาพที่ซิงโครไนซ์ผ่าน WebRTC หรือ WebSocket ได้ (รุ่น =gpt-4o-realtime-preview-<date>, stream=true) สำหรับการใช้งานแบบโต้ตอบแบบเรียลไทม์

ข้อมูลพื้นฐานและคุณสมบัติ

OpenAI's GPT-4o เรียลไทม์ (รหัสรุ่น: gpt-4o-พรีวิวแบบเรียลไทม์-2025-06-03) เป็นแบบจำลองฐานรากแบบสาธารณะรุ่นแรกที่ออกแบบมาเพื่อ การพูดต่อเสียงจากต้นทางถึงปลายทาง (S2S) ปฏิสัมพันธ์กับ ความหน่วงต่ำกว่าวินาที. ฟิวส์ Realtime ที่ได้รับมาจากตระกูล GPT-4o “omni” การจดจำเสียงพูด การใช้เหตุผลในภาษาธรรมชาติ และการแปลงข้อความเป็นเสียงด้วยระบบประสาท ให้เป็นเครือข่ายเดียว ช่วยให้นักพัฒนาสามารถสร้างตัวแทนเสียงที่สามารถสนทนาได้อย่างลื่นไหลเหมือนมนุษย์ โดยโมเดลนี้จะถูกเปิดเผยผ่านเครือข่ายที่สร้างขึ้นเพื่อจุดประสงค์นี้โดยเฉพาะ API แบบเรียลไทม์ และผสานรวมเข้ากับความใหม่ได้อย่างแน่นแฟ้น ตัวแทนเรียลไทม์ ความนามธรรมภายใน ตัวแทน SDK (TypeScript และ Python)

ชุดคุณสมบัติหลัก — S2S แบบครบวงจร • การจัดการการขัดจังหวะ • การเรียกใช้เครื่องมือ

• การพูดเป็นคำพูดของเจ้าของภาษา: อินพุตเสียงจะถูกนำเข้าเป็นสตรีมต่อเนื่อง โทเค็นภายใน พิจารณาเหตุผล และส่งคืนเป็นเสียงสังเคราะห์ ไม่จำเป็นต้องมีบัฟเฟอร์ STT/TTS ภายนอก จึงขจัดความล่าช้าของไปป์ไลน์หลายวินาที

• ความหน่วงในระดับมิลลิวินาที: การตัดแต่งสถาปัตยกรรม การกลั่นแบบจำลอง และสแต็กการเสิร์ฟที่ปรับให้เหมาะกับ GPU ช่วยให้ เวลาแฝงของโทเค็นแรกประมาณ 300–500 มิลลิวินาที ในการใช้งานระบบคลาวด์ทั่วไป จะใกล้เคียงกับบรรทัดฐานการสนทนาแบบมนุษย์

• คำแนะนำที่มั่นคง - การปฏิบัติตาม: ปรับแต่งสคริปต์การสนทนาและการติดตามการเรียกใช้ฟังก์ชัน GPT-4o Realtime แสดงให้เห็น >25% ลดข้อผิดพลาดในการดำเนินการงาน เมื่อเทียบกับค่าพื้นฐาน GPT-2024o ในเดือนพฤษภาคม 4

• การเรียกเครื่องมือแบบกำหนด: โมเดลนี้สร้าง JSON ที่มีโครงสร้างที่สอดคล้องกับ OpenAI รูปแบบการเรียกใช้ฟังก์ชันอนุญาตให้เรียกใช้ API แบ็คเอนด์ (ระบบการจอง ฐานข้อมูล IoT) ได้อย่างแม่นยำ มีการลองซ้ำโดยคำนึงถึงข้อผิดพลาดและการตรวจสอบอาร์กิวเมนต์ในตัว

• การขัดจังหวะอย่างสง่างาม: เครื่องตรวจจับกิจกรรมเสียงแบบเรียลไทม์ที่จับคู่กับการถอดรหัสแบบเพิ่มหน่วยช่วยให้ตัวแทนสามารถ หยุดพูดกลางประโยคดูดซับการขัดจังหวะของผู้ใช้ และดำเนินการตอบสนองต่อหรือวางแผนใหม่ได้อย่างราบรื่น

• อัตราการพูดที่กำหนดค่าได้: ใหม่ ความเร็ว พารามิเตอร์ (0.25–4× แบบเรียลไทม์) ช่วยให้นักพัฒนาสามารถปรับแต่งการกำหนดอัตราผลลัพธ์ให้เหมาะสมกับการเข้าถึงหรือแอพพลิเคชั่นที่ทำงานอย่างรวดเร็ว

สถาปัตยกรรมทางเทคนิค — หม้อแปลงมัลติโหมดรวม

ตัวเข้ารหัส-ตัวถอดรหัสแบบรวม: GPT-4o Realtime แบ่งปันสถาปัตยกรรม Omni หม้อแปลงไฟฟ้าแบบชั้นเดียว ซึ่งโทเค็นเสียง ข้อความ และวิสัยทัศน์ (ในอนาคต) อยู่ร่วมกันในพื้นที่แฝงหนึ่งแห่ง การคำนวณแบบปรับตัวตามเลเยอร์จะลัดเฟรมเสียงไปยังบล็อกความสนใจในภายหลังโดยตรง ทำให้ลดเวลาลง 20–40 มิลลิวินาทีต่อครั้ง

การสร้างโทเค็นเสียงแบบลำดับชั้น: PCM ดิบ 16 kHz ถูกแบ่งเป็นแพตช์ log-mel → แบ่งปริมาณเป็นโทเค็นอะคูสติกแบบหยาบ → บีบอัดเป็นโทเค็นเชิงความหมาย เพื่อเพิ่มประสิทธิภาพ โทเค็นต่อวินาที งบประมาณโดยไม่ต้องเสียสละความไพเราะ

เคอร์เนลอนุมานบิตต่ำ: น้ำหนักที่วางไว้จะวิ่งที่ การวัดปริมาณ NF4 4 บิต ผ่านเคอร์เนล Triton / TensorRT-LLM เพิ่มทรูพุตเป็นสองเท่าเมื่อเทียบกับ fp16 ในขณะที่ยังคงรักษาระดับการสูญเสียคุณภาพ MOS น้อยกว่า 1 dB

สตรีมความสนใจ: การฝังแบบหมุนหน้าต่างเลื่อนและการแคชคีย์-ค่าช่วยให้โมเดลสามารถเข้าถึงเสียง 15 วินาทีสุดท้ายด้วยหน่วยความจำ O(L) ซึ่งมีความสำคัญสำหรับบทสนทนาที่มีความยาวระหว่างการโทรศัพท์

รายละเอียดทางเทคนิค

- เวอร์ชัน API:

2025-06-03-preview - โปรโตคอลการขนส่ง:

- WebRTC:ความหน่วงต่ำพิเศษ (< 80 มิลลิวินาที) สำหรับสตรีมเสียง/วิดีโอฝั่งไคลเอนต์

- WebSocket:การสตรีมจากเซิร์ฟเวอร์ถึงเซิร์ฟเวอร์ด้วยความล่าช้าต่ำกว่า 100 มิลลิวินาที

- การเข้ารหัสข้อมูล:

- บทประพันธ์ โคเดกภายใน RTP แพ็กเก็ตสำหรับเสียง

- H.264 / H.265 เฟรมแรปเปอร์สำหรับวิดีโอ

- ที่พริ้ว: รองรับ

stream: trueที่จะส่งมอบ ที่เพิ่มขึ้น การตอบสนองบางส่วนเป็นโทเค็นที่ถูกสร้างขึ้น - จานเสียงใหม่:แนะนำเสียงใหม่แปดเสียง—โลหะผสม, เถ้า, บทกวี, ปะการัง, เสียงสะท้อน, ปราชญ์, ระยับและ กลอน—สำหรับข้อมูลเพิ่มเติม ที่แสดงออก, เหมือนมนุษย์ การโต้ตอบ..

วิวัฒนาการของ GPT-4o เรียลไทม์

- พฤษภาคม: GPT-4o โอมนิ เปิดตัวด้วยการรองรับหลายโหมดสำหรับข้อความ เสียง และภาพ

- ตุลาคม 2024: API แบบเรียลไทม์ เข้าสู่เบต้าส่วนตัว (

2024-10-01-preview) ปรับให้เหมาะสมสำหรับเสียงที่มีความล่าช้าต่ำ - ธันวาคม 2024:ขยายความพร้อมใช้งานทั่วโลกของ

gpt-4o-realtime-preview-2024-12-17เพิ่ม การแคชพร้อมท์ และเสียงอื่นๆอีกมากมาย - มิถุนายน 3, 2025: ปรับปรุงล่าสุด (

2025-06-03-preview) เปิดตัวผลิตภัณฑ์อันประณีต จานเสียง และการเพิ่มประสิทธิภาพการทำงาน

ประสิทธิภาพมาตรฐาน

- มมส: 88.7แซงหน้า GPT-4 ที่ทำไว้ 86.5 ความเข้าใจภาษามัลติทาสก์จำนวนมาก .

- การรู้จำเสียง: บรรลุผล ชั้นนำของอุตสาหกรรม อัตราข้อผิดพลาดของคำในสภาพแวดล้อมที่มีเสียงดังเกิน กระซิบ เส้นพื้นฐาน

- การทดสอบความหน่วงเวลา:

- จบสิ้น (คำพูดเข้า → ข้อความออก): 50–80 มิลลิวินาที ผ่านทาง WebRTC

- เสียงรอบทิศทาง (คำพูดเข้า → คำพูดออก): <100 ms .

ตัวชี้วัดทางเทคนิค

- ทางเข้า: ยั่งยืน 15 โทเค็น/วินาที สำหรับสตรีมข้อความ กิโลบิตต่อวินาที 24 ผลงานด้านเสียง

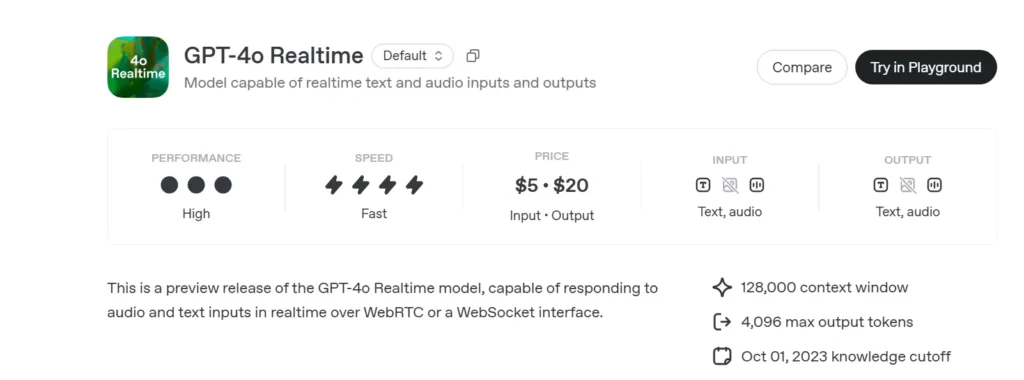

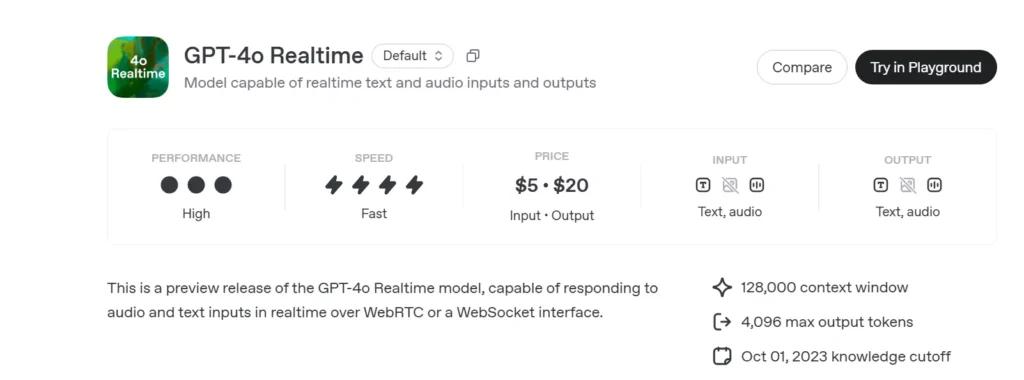

- ราคา:

- ข้อความ:5 ดอลลาร์ต่อโทเค็นอินพุต 1 ล้านหน่วย; 20 ดอลลาร์ต่อโทเค็นเอาต์พุต 1 ล้านหน่วย

- เสียง:100 ดอลลาร์ต่อโทเค็นอินพุต 1 ล้านหน่วย; 200 ดอลลาร์ต่อโทเค็นเอาต์พุต 1 ล้านหน่วย

- ความพร้อมที่จะให้บริการ:ใช้งานทั่วโลกในทุกภูมิภาคที่รองรับ Realtime API

วิธีการเรียกใช้ GPT-4o Realtime API จาก CometAPI

GPT-4o Realtime การกำหนดราคา API ใน CometAPI:

- อินพุตโทเค็น: $2 / M โทเค็น

- โทเค็นเอาต์พุต: $8 / M โทเค็น

ขั้นตอนที่ต้องดำเนินการ

- เข้าสู่ระบบเพื่อ โคเมตาปิดอทคอม. หากคุณยังไม่ได้เป็นผู้ใช้ของเรา กรุณาลงทะเบียนก่อน

- รับรหัส API ของข้อมูลรับรองการเข้าถึงของอินเทอร์เฟซ คลิก "เพิ่มโทเค็น" ที่โทเค็น API ในศูนย์ส่วนบุคคล รับรหัสโทเค็น: sk-xxxxx และส่ง

- รับ url ของเว็บไซต์นี้: https://api.cometapi.com/

วิธีการใช้งาน

- เลือก“

gpt-4o-realtime-preview-2025-06-03” จุดสิ้นสุดในการส่งคำขอและกำหนดเนื้อหาคำขอ วิธีการร้องขอและเนื้อหาคำขอได้รับจากเอกสาร API ของเว็บไซต์ของเรา เว็บไซต์ของเรายังจัดเตรียมการทดสอบ Apifox ไว้เพื่อความสะดวกของคุณอีกด้วย - แทนที่ ด้วยคีย์ CometAPI จริงจากบัญชีของคุณ

- แทรกคำถามหรือคำขอของคุณลงในช่องเนื้อหา—นี่คือสิ่งที่โมเดลจะตอบสนอง

- ประมวลผลการตอบสนองของ API เพื่อรับคำตอบที่สร้างขึ้น

สำหรับข้อมูลการเข้าถึงโมเดลใน Comet API โปรดดู เอกสาร API.

สำหรับข้อมูลราคาโมเดลใน Comet API โปรดดู https://api.cometapi.com/pricing.

ตัวอย่างโค้ดและการรวม API

import openai

openai.api_key = "YOUR_API_KEY"

# Establish a Realtime WebRTC connection

connection = openai.Realtime.connect(

model="gpt-4o-realtime-preview-2025-06-03",

version="2025-06-03-preview",

transport="webrtc"

)

# Stream audio frames and receive incremental text

with open("user_audio.raw", "rb") as audio_stream:

for chunk in iter(lambda: audio_stream.read(2048), b""):

result = connection.send_audio(chunk)

print("Assistant:", result)

- พารามิเตอร์สำคัญ:

model: “gpt-4o-พรีวิวแบบเรียลไทม์-2025-06-03”version: “2025 มิถุนายน 06-พรีวิว”transport: “เว็บอาร์ทีซี” สำหรับ เวลาแฝงขั้นต่ำstream:trueสำหรับ ที่เพิ่มขึ้น การปรับปรุง

โดยการรวม รัฐของศิลปะ การใช้เหตุผลแบบหลายโหมด แข็งแรง จานเสียงใหม่และ ต่ำพิเศษ การสตรีมแบบหน่วงเวลา GPT-4o เรียลไทม์ (2025 มิถุนายน 06) ช่วยให้นักพัฒนาสามารถสร้างได้อย่างแท้จริง การโต้ตอบ, การสนทนา การประยุกต์ใช้ AI

ดูเพิ่มเติม o3-โปร เอพีไอ

ความปลอดภัยและการปฏิบัติตามข้อกำหนด

OpenAI จัดส่ง GPT-4o Realtime พร้อมด้วย:

• ราวกั้นระดับระบบ: นโยบายที่ปรับแต่งเพื่อปฏิเสธคำขอที่ไม่อนุญาต (ความสุดโต่ง พฤติกรรมที่ผิดกฎหมาย)

• การกรองเนื้อหาแบบเรียลไทม์: ตัวจำแนกประเภทย่อย 100 มิลลิวินาทีจะคัดกรองทั้งอินพุตของผู้ใช้และเอาท์พุตของแบบจำลองก่อนการส่งออก

• เส้นทางการอนุมัติของมนุษย์: เรียกใช้งานเมื่อมีการเรียกใช้เครื่องมือที่มีความเสี่ยงสูง (การชำระเงิน คำแนะนำทางกฎหมาย) โดยใช้ประโยชน์จากการอนุมัติเบื้องต้นใหม่ของ Agents SDK