grok-code-fast-1 เป็นของ xAI โมเดลการเข้ารหัสแบบเอเจนต์ที่เน้นความเร็วและคุ้มต้นทุน ออกแบบมาเพื่อขับเคลื่อนการรวม IDE และตัวแทนการเข้ารหัสอัตโนมัติ โดยเน้นที่ เวลาแฝงต่ำ, พฤติกรรมตัวแทน (การเรียกเครื่องมือ การติดตามการใช้เหตุผลแบบขั้นตอน) และโปรไฟล์ต้นทุนแบบกะทัดรัดสำหรับเวิร์กโฟลว์ของนักพัฒนาในแต่ละวัน

คุณสมบัติหลัก (โดยสังเขป)

- ปริมาณงานสูง / ความหน่วงต่ำ: มุ่งเน้นที่การส่งออกโทเค็นที่รวดเร็วและการเสร็จสิ้นอย่างรวดเร็วสำหรับการใช้งาน IDE

- การเรียกใช้ฟังก์ชันและเครื่องมือของตัวแทน: รองรับการเรียกใช้ฟังก์ชันและการประสานงานเครื่องมือภายนอก (การทดสอบการรัน ลินเตอร์ การดึงไฟล์) เพื่อเปิดใช้งานตัวแทนการเข้ารหัสหลายขั้นตอน

- หน้าต่างบริบทขนาดใหญ่: ออกแบบมาเพื่อรองรับฐานโค้ดขนาดใหญ่และบริบทไฟล์หลายไฟล์ (ผู้ให้บริการรายชื่อหน้าต่างบริบท 256 รายการในอะแดปเตอร์ตลาด)

- การให้เหตุผล / ร่องรอยที่มองเห็นได้: การตอบสนองอาจรวมถึงการติดตามการใช้เหตุผลแบบขั้นตอนที่มุ่งหมายเพื่อให้การตัดสินใจของตัวแทนสามารถตรวจสอบและแก้ไขได้

รายละเอียดทางเทคนิค

สถาปัตยกรรมและการฝึกอบรม: xAI ระบุว่า grok-code-fast-1 ถูกสร้างขึ้นใหม่ทั้งหมดด้วยสถาปัตยกรรมใหม่และคลังข้อมูลก่อนการฝึกที่เต็มไปด้วยเนื้อหาการเขียนโปรแกรม จากนั้นโมเดลจะได้รับการดูแลหลังการฝึกบนชุดข้อมูล pull-request/code ที่มีคุณภาพสูงจากการใช้งานจริง ไพพ์ไลน์ทางวิศวกรรมนี้มีเป้าหมายเพื่อสร้างโมเดล เวิร์กโฟลว์ภายในตัวแทนที่ใช้งานได้จริง (IDE + การใช้เครื่องมือ)

การให้บริการและบริบท: grok-code-fast-1 และรูปแบบการใช้งานทั่วไปจะถือว่ามีเอาต์พุตแบบสตรีมมิ่ง การเรียกใช้ฟังก์ชัน และการฉีดบริบทที่หลากหลาย (การอัปโหลด/การรวบรวมไฟล์) ตลาดคลาวด์และอะแดปเตอร์แพลตฟอร์มหลายแห่งได้แสดงรายการนี้ไว้แล้วพร้อมการรองรับบริบทขนาดใหญ่ (บริบท 256k ในอะแดปเตอร์บางตัว)

คุณสมบัติการใช้งาน: มองเห็นได้ ร่องรอยการใช้เหตุผล (โมเดลนี้จะแสดงการวางแผน/การใช้เครื่องมือ) คำแนะนำด้านวิศวกรรมที่รวดเร็วและตัวอย่างการบูรณาการ และการบูรณาการกับพันธมิตรที่เปิดตัวในระยะเริ่มต้น (เช่น GitHub Copilot, Cursor)

ประสิทธิภาพเกณฑ์มาตรฐาน (สิ่งที่ได้คะแนน)

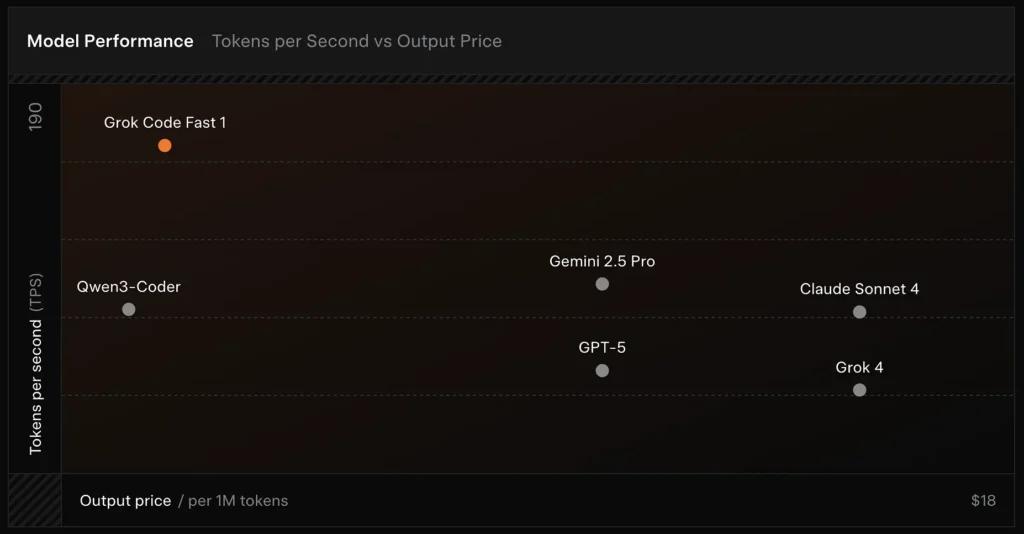

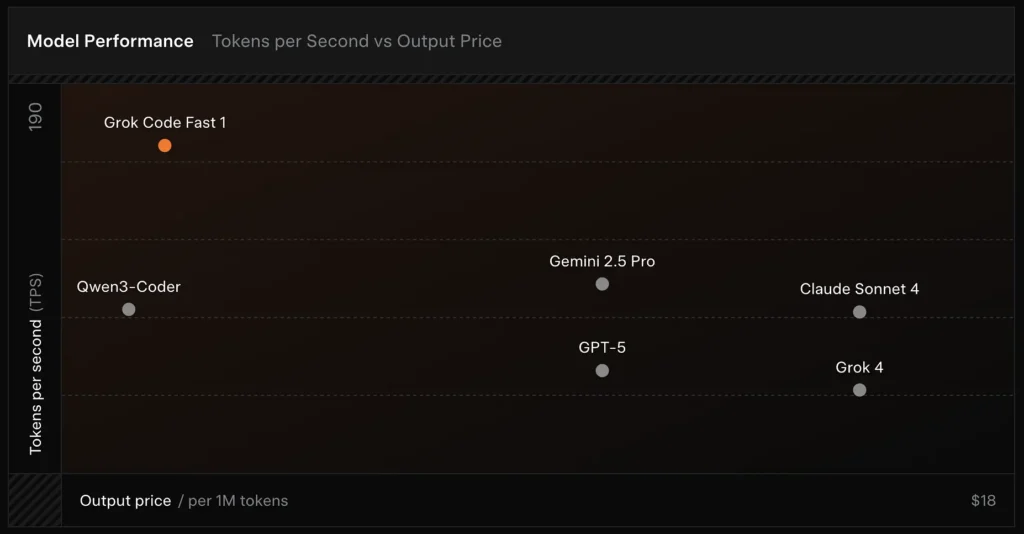

SWE-Bench-Verified: xAI รายงาน 70.8% คะแนนบนสายรัดภายในของพวกเขาเมื่อเทียบกับชุดย่อย SWE-Bench-Verified ซึ่งเป็นเกณฑ์มาตรฐานที่ใช้กันทั่วไปสำหรับการเปรียบเทียบโมเดลวิศวกรรมซอฟต์แวร์ การประเมินเชิงปฏิบัติเมื่อเร็วๆ นี้รายงานว่า คะแนนเฉลี่ยของมนุษย์ ≈ 7.6 บนชุดโค้ดแบบผสม — แข่งขันกับโมเดลที่มีมูลค่าสูงบางรุ่น (เช่น Gemini 2.5 Pro) แต่ตามหลังโมเดลแบบมัลติโมดัล/“best-reasoner” ขนาดใหญ่กว่า เช่น Claude Opus 4 และ Grok 4 ของ xAI เองในงานที่ใช้เหตุผลระดับสูง เกณฑ์มาตรฐานยังแสดงให้เห็นถึงความแปรปรวนของแต่ละงาน ซึ่งเหมาะอย่างยิ่งสำหรับการแก้ไขข้อบกพร่องทั่วไปและการสร้างโค้ดที่กระชับ แต่อ่อนกว่าในบางปัญหาเฉพาะกลุ่มหรือเฉพาะไลบรารี (ตัวอย่าง Tailwind CSS)

การเปรียบเทียบ :

- vs Grok 4: Grok-code-fast-1 แลกเปลี่ยนความถูกต้องแน่นอนและเหตุผลที่ลึกซึ้งยิ่งขึ้นสำหรับ ต้นทุนต่ำกว่ามากและปริมาณงานที่รวดเร็วกว่า; Grok 4 ยังคงเป็นตัวเลือกที่มีขีดความสามารถสูงกว่า

- vs Claude Opus / GPT-class: โมเดลเหล่านี้มักจะนำไปสู่การทำงานที่ใช้เหตุผลที่ซับซ้อน สร้างสรรค์ หรือยากลำบาก Grok-code-fast-1 แข่งขันได้ดีในงานนักพัฒนาที่มีปริมาณงานสูงและเป็นกิจวัตร ซึ่งความล่าช้าและต้นทุนเป็นเรื่องสำคัญ

ข้อจำกัดและความเสี่ยง

ข้อจำกัดในทางปฏิบัติที่สังเกตได้จนถึงขณะนี้:

- ช่องว่างโดเมน: ประสิทธิภาพลดลงในไลบรารีเฉพาะกลุ่มหรือปัญหาที่มีกรอบที่ไม่ปกติ (ตัวอย่าง ได้แก่ กรณีขอบของ Tailwind CSS)

- การแลกเปลี่ยนต้นทุนการใช้เหตุผลกับโทเค็น: เนื่องจากโมเดลสามารถปล่อยโทเค็นการใช้เหตุผลภายในได้ การใช้เหตุผลที่มีตัวแทน/ละเอียดมากจึงสามารถเพิ่มความยาวเอาต์พุตของการอนุมาน (และต้นทุน) ได้

- ความแม่นยำ / กรณีขอบ: ในขณะที่แข็งแกร่งในงานประจำ Grok-code-fast-1 สามารถทำได้ ภาพหลอน หรือสร้างโค้ดที่ไม่ถูกต้องสำหรับอัลกอริทึมใหม่หรือคำชี้แจงปัญหาเชิงโต้แย้ง อาจทำงานได้ต่ำกว่าประสิทธิภาพแบบจำลองที่เน้นการใช้เหตุผลระดับสูงในเกณฑ์มาตรฐานอัลกอริทึมที่เข้มงวด

กรณีใช้งานทั่วไป

- ความช่วยเหลือด้าน IDE และการสร้างต้นแบบอย่างรวดเร็ว: การทำงานที่รวดเร็ว การเขียนโค้ดแบบเพิ่มหน่วย และการดีบักแบบโต้ตอบ

- ตัวแทนอัตโนมัติ / เวิร์กโฟลว์โค้ด: ตัวแทนที่ทำหน้าที่ประสานการทดสอบ รันคำสั่ง และแก้ไขไฟล์ (เช่น ตัวช่วย CI ผู้ตรวจสอบบอท)

- งานวิศวกรรมประจำวัน: การสร้างโครงร่างโค้ด การรีแฟกเตอร์ ข้อเสนอแนะการคัดแยกจุดบกพร่อง และการสร้างโครงร่างโครงการหลายไฟล์ โดยที่ความล่าช้าต่ำช่วยปรับปรุงการทำงานของนักพัฒนาได้อย่างมาก

วิธีการเรียกใช้ API grok-code-fast-1 จาก CometAPI

grok-code-fast-1 ราคา API ใน CometAPI ลด 20% จากราคาอย่างเป็นทางการ:

- อินพุตโทเค็น: $0.16/M โทเค็น

- โทเค็นเอาต์พุต: $2.0/ M โทเค็น

ขั้นตอนที่ต้องดำเนินการ

- เข้าสู่ระบบเพื่อ โคเมตาปิดอทคอม. หากคุณยังไม่ได้เป็นผู้ใช้ของเรา กรุณาลงทะเบียนก่อน

- รับรหัส API ของข้อมูลรับรองการเข้าถึงของอินเทอร์เฟซ คลิก "เพิ่มโทเค็น" ที่โทเค็น API ในศูนย์ส่วนบุคคล รับรหัสโทเค็น: sk-xxxxx และส่ง

ใช้วิธีการ

- เลือก“

grok-code-fast-1” จุดสิ้นสุดในการส่งคำขอ API และกำหนดเนื้อหาคำขอ วิธีการคำขอและเนื้อหาคำขอได้รับจากเอกสาร API ของเว็บไซต์ของเรา เว็บไซต์ของเรายังมีการทดสอบ Apifox เพื่อความสะดวกของคุณอีกด้วย - แทนที่ ด้วยคีย์ CometAPI จริงจากบัญชีของคุณ

- แทรกคำถามหรือคำขอของคุณลงในช่องเนื้อหา—นี่คือสิ่งที่โมเดลจะตอบสนอง

- ประมวลผลการตอบสนองของ API เพื่อรับคำตอบที่สร้างขึ้น

CometAPI มอบ REST API ที่เข้ากันได้อย่างสมบูรณ์ เพื่อการย้ายข้อมูลที่ราบรื่น รายละเอียดสำคัญ เอกสาร API:

- URL ฐาน: https://api.cometapi.com/v1/chat/completions

- ชื่อรุ่น: "

grok-code-fast-1" - รับรองความถูกต้อง: โทเค็นผู้ถือผ่าน

Authorization: Bearer YOUR_CometAPI_API_KEYส่วนหัว - ชนิดของเนื้อหา:

application/json.

การรวม API และตัวอย่าง

ตัวอย่าง Python สำหรับ เสร็จสิ้นการแชท โทรผ่าน CometAPI:

pythonimport openai

openai.api_key = "YOUR_CometAPI_API_KEY"

openai.api_base = "https://api.cometapi.com/v1/chat/completions"

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Summarize grok-code-fast-1's main features."}

]

response = openai.ChatCompletion.create(

model="grok-code-fast-1",

messages=messages,

temperature=0.7,

max_tokens=500

)

print(response.choices.message)

ดูเพิ่มเติม กร็อก 4