Qwen2.5-Max ถือเป็นความก้าวหน้าครั้งสำคัญในขอบเขตของโมเดลภาษาขนาดใหญ่ ซึ่งแสดงให้เห็นถึงความสามารถที่โดดเด่นในการทำความเข้าใจและสร้างภาษาธรรมชาติ โมเดลนี้ได้รับการพัฒนาโดยทีมงาน Qwen โดยใช้เทคนิคที่ล้ำสมัยเพื่อมอบประสิทธิภาพที่เหนือกว่าในเกณฑ์มาตรฐานต่างๆ

Qwen2.5-Max คืออะไร?

Qwen2.5-Max เป็นโมเดลภาษาขนาดใหญ่ที่ล้ำสมัยซึ่งออกแบบมาเพื่อขยายขอบเขตความเข้าใจและการสร้างภาษาธรรมชาติ พัฒนาด้วยสถาปัตยกรรมแบบผสมผสานของผู้เชี่ยวชาญ (MoE) ทำให้สามารถปรับขนาดการคำนวณได้อย่างมีประสิทธิภาพในขณะที่มอบประสิทธิภาพที่เหนือกว่าในเกณฑ์มาตรฐาน AI ต่างๆ โมเดลนี้ได้รับการฝึกอบรมล่วงหน้าบนชุดข้อมูลที่ครอบคลุมกว่า 20 ล้านล้านโทเค็น ช่วยให้เข้าใจภาษา หัวข้อ และสาขาวิชาทางเทคนิคต่างๆ ได้อย่างกว้างและลึก

คุณสมบัติหลักของ Qwen2.5-Max

- สถาปัตยกรรมแบบผสมผสานผู้เชี่ยวชาญ (MoE):เพิ่มประสิทธิภาพการคำนวณโดยการเลือกผู้เชี่ยวชาญเฉพาะทางสำหรับแต่ละแบบสอบถามเพื่อเพิ่มประสิทธิภาพ

- การฝึกอบรมเบื้องต้นอย่างครอบคลุม:ได้รับการฝึกฝนบนชุดข้อมูลขนาดใหญ่เพื่อความเข้าใจและการแสดงความรู้ที่เหนือกว่า

- การใช้เหตุผลและความเข้าใจที่เพิ่มขึ้น:มีประสิทธิภาพเหนือกว่าโมเดลอื่นในการแก้ปัญหาทางคณิตศาสตร์ การใช้เหตุผลเชิงตรรกะ และการเขียนโค้ด

- ปรับแต่งด้วยการเรียนรู้แบบมีผู้ดูแลและการเสริมแรง:ผสานการเรียนรู้เสริมแรงจากข้อเสนอแนะของมนุษย์ (RLHF) เพื่อปรับแต่งคำตอบและปรับปรุงการใช้งาน

Qwen2.5-Max ทำงานอย่างไร?

1. สถาปัตยกรรมแบบผสมผสานผู้เชี่ยวชาญ (MoE)

Qwen2.5-Max ใช้ระบบ Mixture-of-Experts ซึ่งจะเลือกเครือข่ายประสาทเทียมของผู้เชี่ยวชาญเป็นกลุ่มย่อยแบบไดนามิกสำหรับแต่ละแบบสอบถาม วิธีนี้ช่วยให้มีประสิทธิภาพสูงและปรับขนาดได้ เนื่องจากมีเพียงผู้เชี่ยวชาญที่เกี่ยวข้องเท่านั้นที่เปิดใช้งานสำหรับงานเฉพาะ จึงช่วยลดภาระในการคำนวณในขณะที่ยังคงความแม่นยำไว้ได้

2. การฝึกอบรมเบื้องต้นอย่างครอบคลุม

โมเดลนี้ได้รับการฝึกอบรมบนชุดข้อมูลที่หลากหลายซึ่งครอบคลุมหลายโดเมน รวมถึงวรรณกรรม การเข้ารหัส วิทยาศาสตร์ และภาษาสนทนา การฝึกอบรมที่ครอบคลุมนี้ช่วยให้ Qwen2.5-Max สามารถเข้าใจและสร้างข้อความได้อย่างคล่องแคล่วและถูกต้องตามบริบทอย่างน่าทึ่ง

3. การปรับปรุงการเรียนรู้ภายใต้การดูแลและการเสริมแรง

หลังจากการฝึกอบรมเบื้องต้น Qwen2.5-Max จะได้รับการปรับแต่งโดยใช้ข้อมูลที่มีป้ายกำกับโดยมนุษย์และการเรียนรู้เสริมแรงจากข้อเสนอแนะของมนุษย์ (RLHF) การปรับปรุงนี้ช่วยให้สอดคล้องกับความคาดหวังของมนุษย์มากขึ้น ทำให้เชื่อถือได้มากขึ้นสำหรับการใช้งานต่างๆ

4. ประสิทธิภาพมาตรฐาน

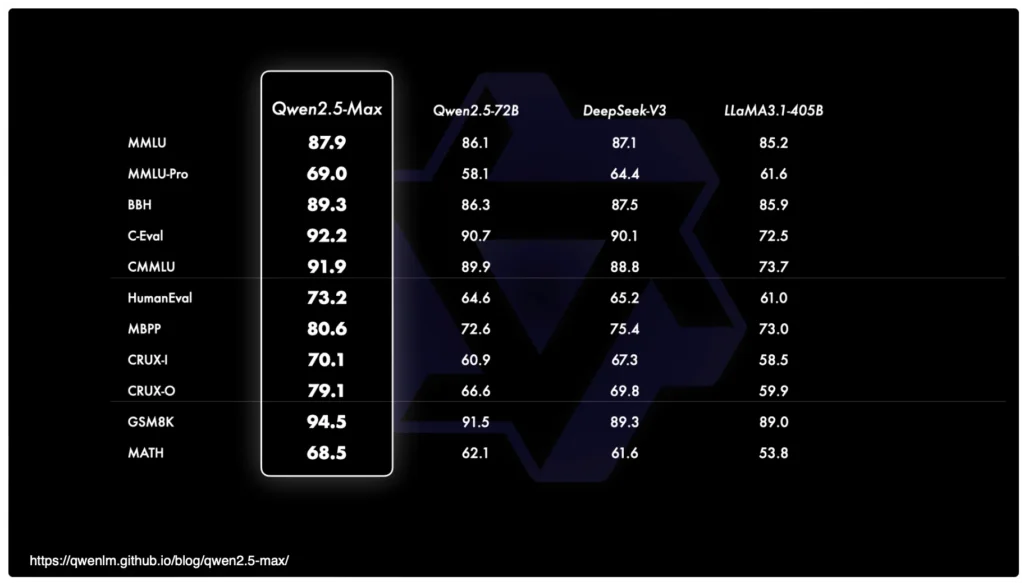

Qwen2.5-Max มีประสิทธิภาพเหนือกว่าโมเดล AI ชั้นนำในเกณฑ์มาตรฐานอุตสาหกรรมหลายประการ:

- Arena-Hard, LiveBench, LiveCodeBench และ GPQA-Diamond:อยู่ในอันดับสูงสุดในระดับอย่างต่อเนื่องในแพลตฟอร์มการประเมิน AI เหล่านี้

- คณิตศาสตร์และการเขียนโปรแกรม:ครองตำแหน่งแรกในด้านการท้าทายด้านการใช้เหตุผลเชิงคำนวณและการเข้ารหัส

- การจัดการงานที่ซับซ้อน:ได้รับอันดับสองในการแก้ไขปัญหาที่ซับซ้อนและหลายขั้นตอน

วิธีใช้ Qwen2.5-Max

1. การเข้าถึง Qwen2.5-Max

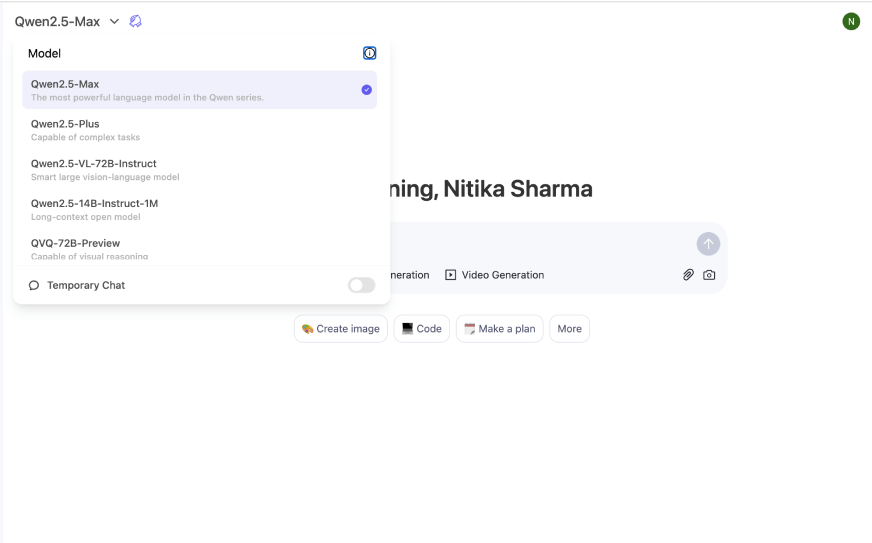

Qwen2.5-Max สามารถใช้งานได้ผ่านจุดเชื่อมต่อหลายจุด ด้านล่างนี้คือขั้นตอนโดยละเอียดในการเข้าถึง:

เข้าถึงผ่านทางเว็บไซต์อย่างเป็นทางการ

วิธีที่เร็วที่สุดในการสัมผัส Qwen2.5-Max คือผ่าน ควินน์ แชท แพลตฟอร์ม นี่คืออินเทอร์เฟซบนเว็บที่ช่วยให้คุณโต้ตอบกับโมเดลได้โดยตรงในเบราว์เซอร์ของคุณ เช่นเดียวกับที่คุณใช้ ChatGPT ในเบราว์เซอร์ของคุณ

- เยี่ยมชมเว็บไซต์ Qwen2.5-Max อย่างเป็นทางการ

- ลงทะเบียนหรือเข้าสู่ระบบโดยใช้ข้อมูลประจำตัวของคุณ

- ไปที่ส่วน “เริ่มต้น”

- เลือกแผนการเข้าถึงฟรี (หากมี) หรือแบบสมัครสมาชิก

- ปฏิบัติตามคำแนะนำการใช้งานเบื้องต้นเพื่อเริ่มใช้งานโมเดลนี้

การใช้ Qwen2.5-Max API

- ไปที่หน้าเอกสาร API ของ Qwen อย่างเป็นทางการ

- ลงทะเบียนเพื่อรับรหัส API โดยการลงทะเบียนบัญชี

- เมื่อตรวจสอบแล้ว ให้เข้าสู่ระบบและรับข้อมูลรับรอง API ของคุณ

- ใช้ API โดยการส่งคำขอไปยังจุดสิ้นสุดที่กำหนดพร้อมการรับรองความถูกต้องที่เหมาะสม

- บูรณาการ API เข้ากับแอปพลิเคชันของคุณโดยใช้ Python, JavaScript หรือภาษาการเขียนโปรแกรมอื่น ๆ ที่ต้องการ

การเข้าถึงผ่านแพลตฟอร์มคลาวด์

- เยี่ยมชมผู้ให้บริการคลาวด์ที่โฮสต์ Qwen 2.5-Max เช่น Alibaba Cloud หรือ Hugging Face

- สร้างบัญชีหากคุณยังไม่มี

- ค้นหา “Qwen2.5-Max” ในส่วน AI/ML

- เลือกโมเดลและกำหนดค่าการตั้งค่าการเข้าถึงของคุณ (พลังประมวลผล, หน่วยความจำ ฯลฯ)

- ปรับใช้โมเดลและเริ่มใช้ผ่านสภาพแวดล้อมแบบโต้ตอบหรือการเรียก API

การใช้งาน Qwen2.5-Max ในพื้นที่

- ตรวจสอบเวอร์ชันโอเพ่นซอร์สหรือดาวน์โหลดได้บน GitHub หรือเว็บไซต์อย่างเป็นทางการ

- ตรวจสอบให้แน่ใจว่าระบบของคุณตรงตามข้อกำหนดฮาร์ดแวร์ (GPU, หน่วยความจำ, พื้นที่เก็บข้อมูล)

- ปฏิบัติตามคำแนะนำในการติดตั้งซึ่งมีอยู่ในเอกสารประกอบ

- ติดตั้งสิ่งที่ต้องมีและกำหนดค่าสภาพแวดล้อม

- เรียกใช้โมเดลในเครื่องและทดสอบความสามารถ

การใช้ CometAPI (แพลตฟอร์ม AI ของบุคคลที่สาม)

CometAPI เสนอราคาที่ต่ำกว่าราคาอย่างเป็นทางการมากเพื่อช่วยให้คุณรวม qwen 2.5 max API และคุณจะได้รับ $1 ในบัญชีของคุณหลังจากลงทะเบียนและเข้าสู่ระบบ!

CometAPI มอบการเข้าถึงโมเดล AI มากกว่า 500 โมเดล รวมถึงโมเดลโอเพ่นซอร์สและโมเดลมัลติโมดัลเฉพาะทางสำหรับการแชท รูปภาพ โค้ด และอื่นๆ จุดแข็งหลักของ CometAPI อยู่ที่การทำให้กระบวนการบูรณาการ AI ที่มีความซับซ้อนแบบดั้งเดิมนั้นง่ายขึ้น ยินดีต้อนรับสู่การลงทะเบียนและสัมผัสประสบการณ์ CometAPI

- ล็อกอิน ไปยัง โคเมตาปิดอทคอม. หากคุณยังไม่ได้เป็นผู้ใช้ของเรา กรุณาลงทะเบียนก่อน

- รับรหัส API ของข้อมูลรับรองการเข้าถึง ของอินเทอร์เฟซ คลิก "เพิ่มโทเค็น" ที่โทเค็น API ในศูนย์ส่วนบุคคล รับคีย์โทเค็น: sk-xxxxx และส่ง

- เข้าถึง Qwen2.5-Max (ชื่อรุ่น: qwen-max) ผ่านทางอินเทอร์เฟซเว็บ API หรือบริการแชทบอท

- ใช้เครื่องมือในตัวเพื่อสร้างข้อความ โค้ด หรือวิเคราะห์ข้อมูล

2. การนำไปปฏิบัติจริง

- AI สนทนา: ใช้สำหรับแชทบอท และผู้ช่วยเสมือน

- ความช่วยเหลือด้านรหัส:ช่วยให้นักพัฒนาสร้างและดีบักโค้ดอย่างมีประสิทธิภาพ

- การสนับสนุนด้านการศึกษา:ปรับปรุงระบบการสอนพิเศษด้วยความสามารถในการใช้เหตุผลในระดับสูง

- การสร้างเนื้อหา:สร้างบทความ บทสรุป และข้อความการตลาดด้วยความแม่นยำสูง

2. การนำไปปฏิบัติจริง

- AI สนทนา: ใช้สำหรับแชทบอท และผู้ช่วยเสมือน

- ความช่วยเหลือด้านรหัส:ช่วยให้นักพัฒนาสร้างและดีบักโค้ดอย่างมีประสิทธิภาพ

- การสนับสนุนด้านการศึกษา:ปรับปรุงระบบการสอนพิเศษด้วยความสามารถในการใช้เหตุผลในระดับสูง

- การสร้างเนื้อหา:สร้างบทความ บทสรุป และข้อความการตลาดด้วยความแม่นยำสูง

เปรียบเทียบกับโมเดล AI อื่นๆ

Qwen2.5-Max เทียบกับ GPT-4

| ลักษณะ | Qwen2.5-สูงสุด | จีพีที-4 |

|---|---|---|

| สถาปัตยกรรม | ส่วนผสมของผู้เชี่ยวชาญ | หม้อแปลงหนาแน่น |

| ข้อมูลก่อนการฝึกอบรม | โทเค็นมากกว่า 20 ล้านล้าน | ~13 ล้านล้านโทเค็น |

| อย่างมีประสิทธิภาพ | สูง (เปิดใช้งานเฉพาะผู้เชี่ยวชาญที่จำเป็นเท่านั้น) | ล่าง (ประมวลผลแบบจำลองทั้งหมด) |

| ความเข้าใจโค้ด | แข็งแกร่ง (อยู่ในอันดับต้นๆ ของเกณฑ์มาตรฐานการเข้ารหัส) | แข็งแกร่ง (มีประสิทธิภาพดีแต่ต่ำกว่า Qwen2.5-Max) |

| การใช้เหตุผลเชิงคณิตศาสตร์ | ค้นหาระดับสูง | ปานกลาง |

Qwen2.5-Max เทียบกับ DeepSeek-V3

| ลักษณะ | Qwen2.5-สูงสุด | ดีพซีค-V3 |

|---|---|---|

| ความรู้ที่ครอบคลุม | กว้าง (หลายโดเมน) | มุ่งเน้น (ตามหลักเทคนิคและวิทยาศาสตร์) |

| เหตุผลเชิงตรรกะ | จุดสูง | ปานกลาง |

| ความพร้อมใช้งานของ API | ใช่ | ถูก จำกัด |

| การปรับตัวของโมเดล | ปรับแต่งให้เหมาะกับการใช้งานหลากหลาย | มีความเชี่ยวชาญเฉพาะด้านจำนวนน้อย |

รุ่นอื่น ๆ

อนาคตอนาคต

คาดว่า Qwen2.5-Max จะพัฒนาต่อไปด้วยการผสานความสามารถแบบหลายโหมดเข้าด้วยกัน ซึ่งช่วยให้สามารถประมวลผลรูปภาพ วิดีโอ และข้อมูลที่มีโครงสร้างได้ การทำซ้ำในอนาคตอาจรวมถึงการเรียนรู้แบบเรียลไทม์ที่ดีขึ้นและการจัดการการโต้ตอบที่ได้รับการปรับปรุง ซึ่งจะทำให้เป็นเครื่องมือที่มีประสิทธิภาพยิ่งขึ้นสำหรับโซลูชันที่ขับเคลื่อนด้วย AI

สรุป

Qwen 2.5-Max ถือเป็นความก้าวหน้าครั้งสำคัญในด้านปัญญาประดิษฐ์ ซึ่งเหนือกว่าโมเดลที่มีอยู่เดิมในด้านการใช้เหตุผล ความเข้าใจ และการดำเนินการงาน ด้วยสถาปัตยกรรมแบบผสมผสานของผู้เชี่ยวชาญ การฝึกอบรมที่ครอบคลุม และประสิทธิภาพการวัดประสิทธิภาพที่เหนือกว่า จึงพร้อมที่จะปฏิวัติการใช้งานในทุกอุตสาหกรรม ตั้งแต่การพัฒนาซอฟต์แวร์ไปจนถึงการสนับสนุนลูกค้าและการศึกษา ในขณะที่ปัญญาประดิษฐ์ยังคงพัฒนาต่อไป Qwen 2.5-Max ก็อยู่ในตำแหน่งที่ดีในการเป็นผู้นำในการส่งมอบโซลูชันที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ที่ล้ำสมัย