ซีรีส์ GLM-4.5 ซึ่งพัฒนาโดย Zhipu AI (Z.ai) ถือเป็นความก้าวหน้าครั้งสำคัญในโมเดลภาษาขนาดใหญ่ (LLM) แบบโอเพนซอร์ส GLM-4.5 ออกแบบมาเพื่อผสานรวมความสามารถในการใช้เหตุผล การเขียนโค้ด และการทำงานแบบเอเจนต์เข้าด้วยกัน มอบประสิทธิภาพที่แข็งแกร่งในแอปพลิเคชันต่างๆ ไม่ว่าคุณจะเป็นนักพัฒนา นักวิจัย หรือผู้ที่ชื่นชอบ คู่มือนี้จะให้ข้อมูลโดยละเอียดเกี่ยวกับวิธีการเข้าถึงและใช้งานซีรีส์ GLM-4.5 อย่างมีประสิทธิภาพ

ซีรีส์ GLM-4.5 คืออะไร และเหตุใดจึงมีความสำคัญ?

GLM-4.5 เป็นแบบจำลองการใช้เหตุผลแบบผสมผสานที่รวมสองโหมดที่แตกต่างกันไว้ด้วยกัน ได้แก่ “โหมดการคิด” สำหรับการใช้เหตุผลที่ซับซ้อนและการใช้เครื่องมือ และ “โหมดการไม่ใช้ความคิด” สำหรับการตอบสนองทันที วิธีการแบบสองโหมดนี้ช่วยให้แบบจำลองสามารถจัดการงานที่หลากหลายได้อย่างมีประสิทธิภาพ ชุดแบบจำลองประกอบด้วยสองรูปแบบหลัก:

- GLM-4.5:ด้วยคุณสมบัติพารามิเตอร์รวม 355 พันล้านพารามิเตอร์พร้อมพารามิเตอร์ที่ทำงานอยู่ 32 พันล้านพารามิเตอร์ โมเดลนี้ได้รับการออกแบบมาสำหรับการใช้งานในระดับขนาดใหญ่ในงานด้านการใช้เหตุผล การสร้าง และงานหลายเอเจนต์

- GLM-4.5-แอร์:เวอร์ชันน้ำหนักเบาที่มีพารามิเตอร์รวม 106 พันล้านพารามิเตอร์และพารามิเตอร์ที่ทำงานอยู่ 12 พันล้านพารามิเตอร์ ปรับให้เหมาะสมสำหรับการอนุมานบนอุปกรณ์และคลาวด์ขนาดเล็กโดยไม่ต้องเสียสละความสามารถหลัก

ทั้งสองโมเดลรองรับโหมดการใช้เหตุผลแบบไฮบริด ซึ่งมีโหมด "คิด" และ "ไม่คิด" เพื่อสร้างสมดุลระหว่างงานการใช้เหตุผลที่ซับซ้อนและการตอบสนองอย่างรวดเร็ว โดยเป็นโอเพ่นซอร์สและเผยแพร่ภายใต้ใบอนุญาต MIT ทำให้สามารถเข้าถึงได้สำหรับการใช้งานเชิงพาณิชย์และการพัฒนารอง

หลักสถาปัตยกรรมและการออกแบบ

โดยพื้นฐานแล้ว GLM-4.5 ใช้ประโยชน์จาก MoE เพื่อกำหนดเส้นทางโทเค็นแบบไดนามิกผ่านเครือข่ายย่อยของผู้เชี่ยวชาญเฉพาะด้าน ช่วยให้พารามิเตอร์มีประสิทธิภาพและพฤติกรรมการปรับขนาดที่เหนือกว่า () แนวทางนี้หมายความว่าจำเป็นต้องเปิดใช้งานพารามิเตอร์น้อยลงต่อการส่งไปข้างหน้า ลดต้นทุนการดำเนินงาน ขณะเดียวกันก็รักษาประสิทธิภาพขั้นสูงสำหรับงานการให้เหตุผลและการเขียนโค้ด ()

ความสามารถหลัก

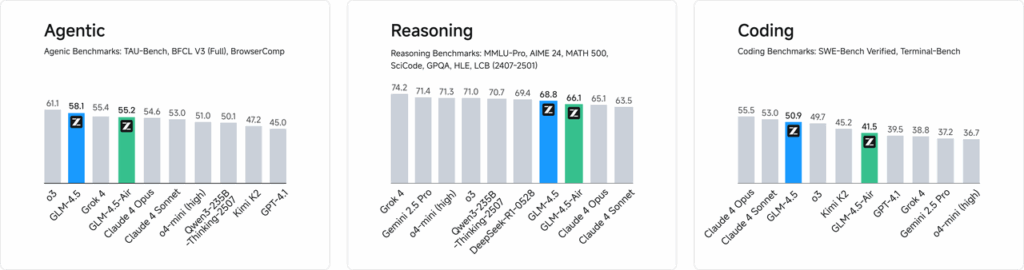

- การใช้เหตุผลและการเข้ารหัสแบบไฮบริด:GLM-4.5 สาธิตประสิทธิภาพของ SOTA ในการประเมินความเข้าใจภาษาธรรมชาติและการทดสอบการสร้างโค้ด โดยมักจะแข่งขันกับโมเดลที่เป็นกรรมสิทธิ์ในด้านความแม่นยำและความคล่องแคล่ว

- การบูรณาการแบบตัวแทนอินเทอร์เฟซการเรียกเครื่องมือในตัวช่วยให้ GLM-4.5 สามารถจัดการเวิร์กโฟลว์หลายขั้นตอน เช่น การค้นหาฐานข้อมูล การประสานงาน API และการสร้างส่วนหน้าแบบโต้ตอบภายในเซสชันเดียว

- สิ่งประดิษฐ์หลายโหมด:จากมินิแอป HTML/CSS ไปจนถึงการจำลองที่ใช้ Python และ SVG แบบโต้ตอบ GLM-4.5 สามารถแสดงอาร์ทิแฟกต์ที่มีฟังก์ชันครบถ้วน เพิ่มการมีส่วนร่วมของผู้ใช้และผลผลิตของนักพัฒนา

เหตุใด GLM-4.5 จึงเป็น Game-Changer?

GLM-4.5 ได้รับการยกย่องไม่เพียงแต่ในด้านประสิทธิภาพที่เป็นธรรมชาติเท่านั้น แต่ยังรวมถึงการกำหนดคุณค่าใหม่ของ LLM โอเพนซอร์สในองค์กรและการวิจัยอีกด้วย

Benchmarks ประสิทธิภาพ

จากการประเมินอิสระในงานเขียนโปรแกรม 52 งาน ครอบคลุมการพัฒนาเว็บ การวิเคราะห์ข้อมูล และระบบอัตโนมัติ GLM-4.5 มีประสิทธิภาพเหนือกว่าโมเดลโอเพนซอร์สชั้นนำอื่นๆ อย่างต่อเนื่อง ทั้งในด้านความน่าเชื่อถือของการเรียกใช้เครื่องมือและความสมบูรณ์ของงานโดยรวม ในการทดสอบเปรียบเทียบกับ Claude Code, Kimi-K2 และ Qwen3-Coder GLM-4.5 ได้รับคะแนนสูงสุดในเกณฑ์มาตรฐานต่างๆ เช่น ลีดเดอร์บอร์ด “SWE-bench Verified”

ประสิทธิภาพต้นทุน

นอกเหนือจากความแม่นยำแล้ว การออกแบบ MoE ของ GLM-4.5 ยังช่วยลดต้นทุนการอนุมานได้อย่างมาก ราคาสาธารณะสำหรับการเรียกใช้ API เริ่มต้นเพียง 0.8 หยวนต่อหนึ่งล้านโทเค็นอินพุต และ 2 หยวนต่อหนึ่งล้านโทเค็นเอาต์พุต ซึ่งคิดเป็นประมาณหนึ่งในสามของต้นทุนผลิตภัณฑ์ที่เป็นกรรมสิทธิ์ที่เทียบเคียงได้ เมื่อรวมกับความเร็วในการสร้างสูงสุดที่ 100 โทเค็น/วินาที โมเดลนี้จึงรองรับการใช้งานที่มีปริมาณงานสูงและความหน่วงต่ำโดยไม่มีค่าใช้จ่ายที่สูงเกินไป

คุณจะเข้าถึง GLM-4.5 ได้อย่างไร?

1. การเข้าถึงโดยตรงผ่านแพลตฟอร์ม Z.ai

วิธีที่ตรงไปตรงมาที่สุดในการโต้ตอบกับ GLM-4.5 คือผ่านแพลตฟอร์ม Z.ai โดยการเยี่ยมชม แชท.z.aiผู้ใช้สามารถเลือกรุ่น GLM-4.5 และเริ่มโต้ตอบผ่านอินเทอร์เฟซที่ใช้งานง่าย แพลตฟอร์มนี้ช่วยให้สามารถทดสอบและสร้างต้นแบบได้ทันทีโดยไม่จำเป็นต้องผสานรวมที่ซับซ้อน ผู้ใช้สามารถเลือกรุ่น GLM-4.5 หรือ GLM-4.5-Air ได้จากมุมซ้ายบนและเริ่มแชทได้ทันที อินเทอร์เฟซนี้ใช้งานง่ายและไม่ต้องตั้งค่าใดๆ จึงเหมาะสำหรับการโต้ตอบและการสาธิตอย่างรวดเร็ว

2. การเข้าถึง API สำหรับนักพัฒนา

สำหรับนักพัฒนาที่ต้องการผสานรวม GLM-4.5 เข้ากับแอปพลิเคชัน แพลตฟอร์ม Z.ai API ให้การสนับสนุนที่ครอบคลุม API นี้มีอินเทอร์เฟซที่เข้ากันได้กับ OpenAI สำหรับทั้งโมเดล GLM-4.5 และ GLM-4.5-Air ช่วยให้การผสานรวมเข้ากับเวิร์กโฟลว์ที่มีอยู่ได้อย่างราบรื่น สามารถดูเอกสารประกอบและแนวทางการผสานรวมโดยละเอียดได้ที่ เอกสาร API ของ Z.ai .

3. การปรับใช้โอเพนซอร์ส

สำหรับผู้ที่สนใจการใช้งานภายในเครื่อง โมเดล GLM-4.5 มีให้บริการบนแพลตฟอร์มต่างๆ เช่น Hugging Face และ ModelScope โมเดลเหล่านี้เผยแพร่ภายใต้ใบอนุญาตโอเพนซอร์ส MIT ซึ่งอนุญาตให้ใช้งานเชิงพาณิชย์และพัฒนาต่อได้ โมเดลเหล่านี้สามารถผสานรวมกับเฟรมเวิร์กการอนุมานหลักๆ เช่น vLLM และ SGLang ได้

4. การบูรณาการกับ CometAPI

โคเมทเอพีไอ เสนอการเข้าถึงที่คล่องตัวไปยังโมเดล GLM-4.5 ผ่านแพลตฟอร์ม API แบบรวมที่ กระดานข้อมูลการผสานรวมนี้ช่วยลดความยุ่งยากในการยืนยันตัวตน การจำกัดอัตรา และการจัดการข้อผิดพลาด จึงเป็นตัวเลือกที่ยอดเยี่ยมสำหรับนักพัฒนาที่ต้องการการตั้งค่าที่ไม่ยุ่งยาก นอกจากนี้ รูปแบบ API ที่เป็นมาตรฐานของ CometAPI ยังช่วยให้การสลับโมเดลและการทดสอบ A/B ระหว่าง GLM-4.5 กับโมเดลอื่นๆ ที่มีอยู่เป็นเรื่องง่าย

นักพัฒนาสามารถเข้าถึงซีรี่ส์ GLM-4.5 ได้อย่างไร

มีช่องทางต่างๆ มากมายในการรับและใช้งาน GLM-4.5 ตั้งแต่การดาวน์โหลดโมเดลโดยตรงไปจนถึง API ที่ได้รับการจัดการ

ผ่านการกอดใบหน้าและ ModelScope

ทั้ง Hugging Face และ ModelScope โฮสต์ซีรีส์ GLM-4.5 ฉบับเต็มภายใต้เนมสเปซ zai-org หลังจากยอมรับใบอนุญาต MIT แล้ว นักพัฒนาสามารถ:

- โคลนพื้นที่เก็บข้อมูล:

git clone https://huggingface.co/zai-org/GLM-4.5

- ติดตั้ง Dependencies:

pip install transformers accelerate

- โหลดโมเดล:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("zai-org/GLM-4.5")

model = AutoModelForCausalLM.from_pretrained("zai-org/GLM-4.5")

``` :contentReference{index=15}.

ผ่าน CometAPI

โคเมทเอพีไอ ให้บริการ API แบบไร้เซิร์ฟเวอร์สำหรับ จีแอลเอ็ม‑4.5 และ GLM-4.5 แอร์ API ด้วยอัตราการจ่ายต่อโทเค็นที่เข้าถึงได้ผ่านการกำหนดค่าจุดสิ้นสุดที่เข้ากันได้กับ OpenAI คุณสามารถเรียกใช้ GLM-4.5 ผ่านไคลเอนต์ Python ของ OpenAI ด้วยการปรับเปลี่ยนฐานโค้ดที่มีอยู่เพียงเล็กน้อย CometAPI ไม่เพียงแต่ให้บริการ GLM4.5 และ GLM-4.5-air เท่านั้น แต่ยังรวมถึงโมเดลอย่างเป็นทางการทั้งหมดอีกด้วย:

| ชื่อรุ่น | แนะนำ | ราคา |

glm-4.5 | แบบจำลองการใช้เหตุผลอันทรงพลังที่สุดของเรา มีพารามิเตอร์ 355 พันล้านรายการ | โทเค็นอินพุต $0.48 โทเค็นเอาต์พุต $1.92 |

glm-4.5-air | คุ้มค่า น้ำหนักเบา ประสิทธิภาพแข็งแกร่ง | โทเค็นอินพุต $0.16 โทเค็นเอาต์พุต $1.07 |

glm-4.5-x | ประสิทธิภาพสูง การตอบสนองที่รวดเร็วเป็นพิเศษ | โทเค็นอินพุต $1.60 โทเค็นเอาต์พุต $6.40 |

glm-4.5-airx | น้ำหนักเบา ประสิทธิภาพแข็งแกร่ง ตอบสนองรวดเร็วเป็นพิเศษ | โทเค็นอินพุต $0.02 โทเค็นเอาต์พุต $0.06 |

glm-4.5-flash | ประสิทธิภาพที่ยอดเยี่ยมสำหรับการเข้ารหัสเหตุผลและตัวแทน | โทเค็นอินพุต $3.20 โทเค็นเอาต์พุต $12.80 |

การรวม Python และ REST API

สำหรับการปรับใช้แบบเฉพาะ องค์กรต่างๆ สามารถโฮสต์ GLM-4.5 บนคลัสเตอร์ GPU เฉพาะโดยใช้ Docker หรือ Kubernetes การตั้งค่า RESTful ทั่วไปประกอบด้วย:

การเปิดตัวเซิร์ฟเวอร์ Inference:

bashdocker run -p 8000:8000 zai-org/glm-4.5:latest

ส่งคำขอ:

bashcurl -X POST http://localhost:8000/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "Translate to French: Hello.", "max_tokens": 50}' Responses conform to the JSON formats used by popular LLM APIs .

แนวทางปฏิบัติที่ดีที่สุดในการบูรณาการ GLM-4.5 ในแอปพลิเคชันคืออะไร

เพื่อเพิ่ม ROI ให้สูงสุดและมั่นใจถึงประสิทธิภาพที่มั่นคง ทีมงานควรพิจารณาสิ่งต่อไปนี้:

การเพิ่มประสิทธิภาพ API และขีดจำกัดอัตรา

- คำขอการแบ่งชุด:จัดกลุ่มคำเตือนที่คล้ายกันเพื่อลดค่าใช้จ่ายและเพิ่มประสิทธิภาพปริมาณงาน GPU

- การแคชแบบสอบถามทั่วไป:จัดเก็บการดำเนินการที่เสร็จสิ้นบ่อยครั้งไว้ในเครื่องเพื่อหลีกเลี่ยงการเรียกอนุมานซ้ำซ้อน

- การสุ่มตัวอย่างแบบปรับตัว: ปรับแบบไดนามิก

temperatureและtop_pโดยอิงตามความซับซ้อนของแบบสอบถามเพื่อสร้างสมดุลระหว่างความคิดสร้างสรรค์และการกำหนดล่วงหน้า

ความปลอดภัยและการปฏิบัติตามข้อกำหนด

- การล้างข้อมูล:ประมวลผลอินพุตล่วงหน้าเพื่อลบข้อมูลที่ละเอียดอ่อนก่อนที่จะส่งไปยังโมเดล

- Access Control:นำคีย์ API, รายการอนุญาต IP และการควบคุมอัตรามาใช้เพื่อป้องกันการใช้งานในทางที่ผิดและการละเมิด

- การบันทึกการตรวจสอบ:บันทึกคำเตือน การเสร็จสมบูรณ์ และข้อมูลเมตาเพื่อให้เป็นไปตามข้อกำหนดขององค์กรและกฎระเบียบ โดยเฉพาะอย่างยิ่งในบริบททางการเงินหรือการดูแลสุขภาพ

เริ่มต้นใช้งาน

CometAPI เป็นแพลตฟอร์ม API แบบรวมที่รวบรวมโมเดล AI มากกว่า 500 โมเดลจากผู้ให้บริการชั้นนำ เช่น ซีรีส์ GPT ของ OpenAI, Gemini ของ Google, Claude ของ Anthropic, Midjourney, Suno และอื่นๆ ไว้ในอินเทอร์เฟซเดียวที่เป็นมิตรกับนักพัฒนา ด้วยการนำเสนอการตรวจสอบสิทธิ์ การจัดรูปแบบคำขอ และการจัดการการตอบสนองที่สอดคล้องกัน CometAPI จึงทำให้การรวมความสามารถของ AI เข้ากับแอปพลิเคชันของคุณง่ายขึ้นอย่างมาก ไม่ว่าคุณจะกำลังสร้างแชทบ็อต เครื่องกำเนิดภาพ นักแต่งเพลง หรือไพพ์ไลน์การวิเคราะห์ที่ขับเคลื่อนด้วยข้อมูล CometAPI ช่วยให้คุณทำซ้ำได้เร็วขึ้น ควบคุมต้นทุน และไม่ขึ้นอยู่กับผู้จำหน่าย ทั้งหมดนี้ในขณะที่ใช้ประโยชน์จากความก้าวหน้าล่าสุดในระบบนิเวศ AI

สำหรับนักพัฒนาที่ต้องการผสานรวม GLM-4.5 เข้ากับแอปพลิเคชันของตน แพลตฟอร์ม CometAPI นำเสนอโซลูชันที่แข็งแกร่ง API นี้มีอินเทอร์เฟซที่เข้ากันได้กับ OpenAI ช่วยให้สามารถผสานรวมเข้ากับเวิร์กโฟลว์ที่มีอยู่ได้อย่างราบรื่น มีเอกสารประกอบและแนวทางการใช้งานโดยละเอียดอยู่บน หน้า API ของ Comet.

นักพัฒนาสามารถเข้าถึงได้ จีแอลเอ็ม‑4.5 และ GLM-4.5 แอร์ API ตลอด โคเมทเอพีไอรุ่นล่าสุดที่ระบุไว้เป็นข้อมูล ณ วันที่เผยแพร่บทความ เริ่มต้นด้วยการสำรวจความสามารถของโมเดลใน สนามเด็กเล่น และปรึกษา คู่มือ API สำหรับคำแนะนำโดยละเอียด ก่อนเข้าใช้งาน โปรดตรวจสอบให้แน่ใจว่าคุณได้เข้าสู่ระบบ CometAPI และได้รับรหัส API แล้ว โคเมทเอพีไอ เสนอราคาที่ต่ำกว่าราคาอย่างเป็นทางการมากเพื่อช่วยคุณบูรณาการ

สรุป

GLM-4.5 แสดงให้เห็นถึงความก้าวหน้าครั้งสำคัญในด้านโมเดลภาษาขนาดใหญ่ นำเสนอโซลูชันที่หลากหลายสำหรับการใช้งานที่หลากหลาย สถาปัตยกรรมการให้เหตุผลแบบไฮบริด ความสามารถเชิงเอเจนต์ และลักษณะโอเพนซอร์ส ทำให้ GLM-4.5 เป็นตัวเลือกที่น่าสนใจสำหรับนักพัฒนาและองค์กรที่ต้องการใช้ประโยชน์จากเทคโนโลยี AI ขั้นสูง ด้วยการสำรวจวิธีการเข้าถึงที่หลากหลายที่ระบุไว้ในคู่มือนี้ ผู้ใช้สามารถผสานรวม GLM-XNUMX เข้ากับโครงการของตนได้อย่างมีประสิทธิภาพ และมีส่วนร่วมในการพัฒนาอย่างต่อเนื่อง