OpenAI ได้ประกาศอัปเดตหลายรายการเมื่อเร็วๆ นี้ รวมถึงการเปิดตัวโมเดล GPT-5-Codex-Mini การปรับปรุงขีดจำกัดอัตราสำหรับลำดับชั้นผู้ใช้หลายคน และการปรับปรุงประสิทธิภาพการประมวลผลโมเดล

OpenAI's GPT-5-โคเด็กซ์-มินิ เป็น GPT-5-Codex เวอร์ชันใหม่ที่มุ่งเน้นนักพัฒนาโดยเฉพาะ มีขนาดเล็กลง ประหยัดต้นทุน และปริมาณงาน ออกแบบมาเพื่อรองรับการเขียนโค้ดส่วนใหญ่ของ GPT-5-Codex แต่มีต้นทุนต่ำกว่ามากและมีปริมาณการใช้งานที่สูงกว่า เวอร์ชัน "Mini" นี้ถูกวางตำแหน่งให้เป็นตัวเลือกที่ใช้งานได้จริงสำหรับเซสชันการเขียนโค้ดที่ยาวนาน ระบบอัตโนมัติเบื้องหลัง และเวิร์กโฟลว์ของนักพัฒนาที่มีความถี่สูง ซึ่งความสามารถสูงสุดแบบดิบๆ มีความสำคัญน้อยกว่าการได้รับโทเค็น/คำขอเพิ่มเติมสำหรับแผนเดียวกัน

GPT-5-Codex-Mini คืออะไร และมีคุณลักษณะอย่างไร?

GPT-5-Codex-Mini เป็นโมเดล GPT-5-Codex ของ OpenAI ที่กะทัดรัดและคุ้มค่า ซึ่งออกแบบมาเฉพาะสำหรับพื้นผิวผลิตภัณฑ์ Codex (การผสานรวม CLI และ IDE) โดยวางตำแหน่งเป็นโมเดล “ขนาดเล็กกว่า คุ้มค่ากว่า” ที่แลกกับความสามารถสูงสุดเพียงเล็กน้อย แลกกับการใช้ทรัพยากรที่ลดลงอย่างมาก และโควต้าการใช้งานที่สูงขึ้นสำหรับเวิร์กโฟลว์แบบอินเทอร์แอคทีฟของนักพัฒนา โมเดลขนาดเล็กนี้มีวัตถุประสงค์เพื่อให้นักพัฒนาสามารถเขียนโค้ดได้มากขึ้น (OpenAI อธิบายคร่าวๆ) ใช้งานได้มากกว่า 4 เท่า สำหรับระดับการสมัครใช้งาน ChatGPT เดียวกัน) ในขณะที่ยังคงรักษาความหน่วงและต้นทุนให้ต่ำสำหรับงานวิศวกรรมทั่วไปที่มีการกำหนดไว้อย่างชัดเจน

ในด้านสมรรถนะ GPT-5-Codex-Mini สืบทอดคุณสมบัติหลักของกลุ่มผลิตภัณฑ์ Codex ได้แก่ ความเข้าใจเชิงลึกเกี่ยวกับฐานโค้ดและการดำเนินการงานหลายขั้นตอนในลักษณะ "ตัวแทน" นักพัฒนาสามารถส่งคำสั่งภาษาธรรมชาติ โค้ดสั้นๆ ภาพหน้าจอ หรือไดอะแกรมการออกแบบอินเทอร์เฟซไปยัง Codex ในเทอร์มินัลแบบอินเทอร์แอคทีฟได้ โดยใช้คุณสมบัติ Codex CLI แบบจำลองนี้จะจัดทำแผนงานก่อน จากนั้นจะเรียกดูไฟล์ แก้ไขโค้ด รันคำสั่ง และทดสอบโดยอัตโนมัติหลังจากได้รับการอนุมัติจากผู้ใช้

จากมุมมองแบบโมดัล ผลิตภัณฑ์ Codex อนุญาตให้แนบรูปภาพ (เช่น ภาพหน้าจอ UI แบบร่างการออกแบบ หรือภาพหน้าจอข้อความแสดงข้อผิดพลาด) เข้ากับเซสชันในเทอร์มินัลหรือ IDE โมเดลสามารถเข้าใจทั้งเนื้อหาข้อความและรูปภาพ แต่ผลลัพธ์ยังคงเป็นโค้ดข้อความและคำอธิบายเป็นหลัก ดังนั้น GPT-5-Codex-Mini จึงถือเป็นโมเดลตัวแทนโค้ดที่เน้น "อินพุตข้อความ + รูปภาพ, เอาต์พุตข้อความ" เป็นหลัก และไม่ดำเนินการงานต่างๆ เช่น การสร้างภาพ การสร้างเสียง หรือการสร้างวิดีโอ

GPT-5-Codex-Mini เปรียบเทียบกับ GPT-5-Codex ได้อย่างไร?

มีอะไรใหม่ใน Codex?

นอกจาก GPT-5-Codex-Mini ที่ใช้งานได้จริงแล้ว OpenAI ยังได้เพิ่มขีดจำกัดอัตรา Codex ขึ้น 50% อย่างสม่ำเสมอสำหรับระดับผู้ใช้ ChatGPT Plus, Business และ Edu ซึ่งช่วยเพิ่มขีดจำกัดคำขอที่ใช้งานได้อย่างมีนัยสำคัญ ขณะเดียวกัน ผู้ใช้ ChatGPT Pro จะได้รับสิทธิ์การประมวลผลแบบลำดับความสำคัญ เพื่อปรับปรุงความเร็วในการตอบสนองและประสบการณ์การดำเนินงาน

นอกจากนี้ OpenAI ยังได้อัปเกรดโมเดล GPT-5-Codex เล็กน้อย เพื่อเพิ่มประสิทธิภาพการทำงานในสถานการณ์การทำงานร่วมกัน โมเดลที่อัปเดตนี้แสดงให้เห็นถึงการปรับปรุงตัวชี้วัดการประเมินที่สำคัญหลายจุดเปอร์เซ็นต์ ประสิทธิภาพการใช้งานโทเค็นเพิ่มขึ้นประมาณ 3% และความทนทานที่มากขึ้นในการจัดการกรณีขอบ จึงช่วยลดความจำเป็นในการให้คำแนะนำแก่ผู้ใช้

| ระดับผู้ใช้ | จีพีที-5-โคเด็กซ์ | GPT-5-โคเด็กซ์-มินิ |

|---|---|---|

| พลัส/บิซ/อีดู | เพิ่มปริมาณข้อความ 1.5 เท่าตามลำดับ | เพิ่มปริมาณข้อความ 6 เท่าตามลำดับ |

GPT-5-Codex-Mini เทียบกับ GPT-5-Codex: ความแตกต่างของเกณฑ์มาตรฐาน

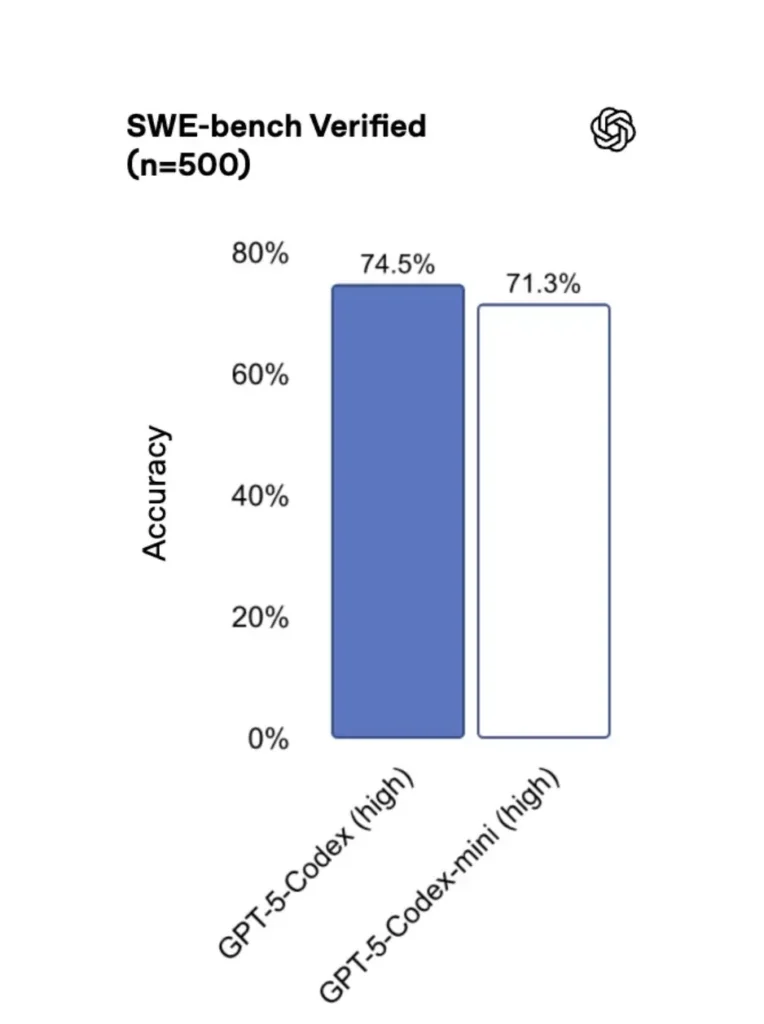

GPT-5-Codex-Mini เมื่อเทียบกับเวอร์ชันดั้งเดิม ประสิทธิภาพลดลงเล็กน้อย แต่นักพัฒนาจะได้รับเครดิตการใช้งานเพิ่มขึ้นประมาณสี่เท่า ในการทดสอบ SWE-bench Verified พบว่า GPT-5 High ได้คะแนน 72.8%, GPT-5-Codex ได้คะแนน 74.5% และ GPT-5-Codex-Mini ได้คะแนน 71.3%

Codex (และรูปแบบมินิ) ใช้โทเค็นน้อยลงอย่างมากสำหรับการโต้ตอบแบบเบา—วัสดุของ OpenAI อ้างว่ามีการลดลงในระดับสิบเปอร์เซ็นต์สำหรับคำเตือนง่ายๆ (เช่น ตัวเลขที่อ้างถึง) โทเค็นน้อยลง ≈93.7% เกี่ยวกับการโต้ตอบน้ำหนักเบาสำหรับตระกูล Codex เทียบกับ GPT-5 ในบางสถานการณ์)

GPT-5-Codex-Mini เทียบกับ GPT-5-Codex: ความแตกต่างของคุณสมบัติ

- ขนาดและราคา: Mini มีขนาดเล็กกว่าและคุ้มค่ากว่าอย่างเห็นได้ชัด OpenAI ระบุว่ารองรับการใช้งานได้มากขึ้นประมาณ 4 เท่าภายใต้ข้อจำกัดการสมัครใช้งานแบบเดียวกัน นี่คือการเพิ่มประสิทธิภาพโควต้า/ประสิทธิภาพสำหรับงานนักพัฒนาทั่วไป

- ซองความสามารถ: GPT-5-Codex ยังคงเป็นตัวเลือกที่มีขีดความสามารถสูงกว่าสำหรับงานเอเจนต์ที่ซับซ้อนและยาวนาน (การรีแฟกเตอร์ขนาดใหญ่ การตรวจสอบโค้ดอย่างละเอียด และรอบการทดสอบที่ขยายออกไป) Mini ได้รับการปรับแต่งให้ทำงานรวดเร็วขึ้นและใช้ทรัพยากรน้อยลงสำหรับการโต้ตอบสั้นๆ ที่เกิดขึ้นบ่อยครั้ง

- ขีดจำกัดความหน่วงและอัตรา: โดยทั่วไปแล้ว Mini จะมอบความหน่วงเวลาที่ต่ำกว่าและอนุญาตให้มีอัตราจำกัดที่สูงกว่าต่อแผน ทำให้เหมาะสำหรับเวิร์กโฟลว์แบบโต้ตอบที่มีความหนาแน่น

- พื้นผิวเริ่มต้น: Mini มีให้เป็นโมเดลที่เลือกได้ใน Codex CLI และ IDE Extension ส่วน GPT-5-Codex เป็นค่าเริ่มต้นสำหรับงานบนคลาวด์และการตรวจสอบโค้ดเชิงลึกใน Codex

เมื่อใดควรใช้ Mini หรือ Full Codex

- ใช้ มินิ สำหรับ: การสร้างนั่งร้าน การสร้างโค้ดซ้ำ การรีแฟกเตอร์ขนาดเล็ก การดำเนินการแบบโต้ตอบในระหว่างการแก้ไข และเมื่อทำงานภายใต้โควตาหรือข้อจำกัดด้านต้นทุน

- ใช้ จีพีที-5-โคเด็กซ์ สำหรับ: การตรวจสอบโค้ดอย่างครอบคลุม งานอัตโนมัติหลายชั่วโมง การรีแฟกเตอร์ที่ซับซ้อน และงานที่ต้องใช้การใช้เหตุผลที่แข็งแกร่งที่สุดของโมเดลและการดำเนินการตามการทดสอบ

ฉันจะเข้าถึง GPT-5-Codex-Mini (CLI, IDE, API) ได้อย่างไร

Codex CLI (เทอร์มินัลก่อน)

เปิดตัว OpenAI gpt-5-codex-mini เป็นตัวเลือกโมเดลภายใน Codex CLI รูปแบบการใช้งานทั่วไปเป็นไปตามเวิร์กโฟลว์ของ Codex CLI: เริ่มเซสชันแบบอินเทอร์แอคทีฟ ระบุโมเดล แนบไฟล์หรือภาพหน้าจอ เรียกใช้ "งาน Codex Cloud" และอื่นๆ อีกมากมาย CLI ยังรองรับการทำงานแบบรวดเร็ว /model การสลับระหว่างเต็ม gpt-5-codex และ gpt-5-codex-miniเมื่อรันครั้งแรก คุณจะต้องยืนยันตัวตนโดยใช้บัญชี ChatGPT/Pro/Enterprise ของคุณ (หรือระบุรหัส API) CLI มีคำสั่งต่างๆ ที่ช่วยให้ Codex สามารถสแกนฐานโค้ด รันการทดสอบ เปิด REPL หรือใช้คำแนะนำแพตช์ได้

ตัวอย่าง (เซสชันโต้ตอบ Codex CLI):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

การไหลดังกล่าวสะท้อนค่าเริ่มต้น Codex CLI ใหม่ โดยที่เครื่องมือจะแนะนำ Mini ใกล้ถึงขีดจำกัดการใช้งาน

ส่วนขยาย VS Code / IDE

ใช่ — ส่วนขยาย Codex IDE (VS Code) มีอยู่แล้ว gpt-5-codex-mini เป็นตัวเลือกหนึ่ง ติดตั้งส่วนขยาย Codex ใน Visual Studio Code เพื่อรับการเติมโค้ดแบบอินไลน์ คำแนะนำในการรีแฟกเตอร์ และการแก้ไขปัญหาอย่างรวดเร็วด้วย AI ส่วนขยายนี้ยังแสดงการดำเนินการด่วน (สร้างโค้ด อธิบายโค้ดที่เลือก รีแฟกเตอร์) และสามารถเรียกใช้งาน Codex Cloud จากตัวแก้ไข ขั้นตอน VS Code:

- ติดตั้งส่วนขยาย OpenAI Codex / ChatGPT สำหรับ VS Code

- ลงชื่อเข้าใช้ด้วยบัญชี ChatGPT ของคุณ (Plus/Pro/Business)

- เปิดจานคำสั่ง:

Cmd/Ctrl+Shift+P → Codex: Set Model→ เลือกgpt-5-codex-mini. - ใช้คำสั่งอินไลน์ (เลือกโค้ด → คลิกขวา → “อธิบายด้วย Codex” หรือ กดปุ่มลัดที่กำหนดค่าไว้)

ตัวอย่าง: คำสั่งอินไลน์ของ VS Code (ขั้นตอนจำลอง)

- เลือกฟังก์ชั่นใน

user_service.py. - ข่าวประชาสัมพันธ์

Cmd/Ctrl+Shift+P → Codex: Explain Selectionหรือใช้คลิกขวา → “อธิบายด้วย Codex” - ส่วนขยายจะเปิดแผงด้านข้างพร้อมคำอธิบายของ Mini การทดสอบที่แนะนำ และปุ่ม "สร้าง PR" แบบคลิกเดียวที่ใช้งาน Codex Cloud เพื่อส่งสาขาเพื่อตรวจสอบ

แล้ว API ล่ะ ฉันสามารถเรียกใช้จากแอปของฉันได้ไหม

การประกาศของ OpenAI บ่งชี้ว่า การรองรับ API กำลังจะมาเร็วๆ นี้ สำหรับ GPT-5-Codex-Mini; ในขณะที่เขียน โมเดลจะพร้อมใช้งานใน Codex toolchain ก่อน (CLI/IDE) ซึ่งหมายความว่าไคลเอนต์ API การผลิตควรเตรียมพร้อมสำหรับชื่อโมเดล gpt-5-codex-mini ใน Requests/Responses API เมื่อเผยแพร่แล้ว ในระหว่างนี้ คุณสามารถสร้างต้นแบบด้วย Codex CLI และ IDE flows ได้

เมื่อเปิดใช้งานการเข้าถึง API การโทรทั่วไป (รูปแบบการตอบกลับ) อาจมีลักษณะดังนี้:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

แนวทางปฏิบัติที่ดีที่สุดสำหรับวิศวกรรมอย่างรวดเร็วด้วย Codex Mini คืออะไร

ด้านล่างนี้คือแนวทางปฏิบัติและรูปแบบที่ดีที่สุดที่ผ่านการทดสอบภาคสนามอย่างเป็นรูปธรรมเพื่อให้ได้รับประโยชน์สูงสุดจาก Codex Mini ในเวิร์กโฟลว์ทางวิศวกรรมการผลิต

1) กลยุทธ์การเลือกโมเดล — ผสมผสานและจับคู่

ใช้ Mini สำหรับงานที่มีความถี่สูงและมีความซับซ้อนต่ำ (การจัดรูปแบบ การรีแฟกเตอร์ขนาดเล็ก การทดสอบอัตโนมัติ) และกลับไปใช้ Codex เต็มรูปแบบสำหรับงานออกแบบที่ซับซ้อน การดีบักเชิงลึก หรือการแปลงข้อมูลขนาดใหญ่ทั่วทั้งรีโพ สลับการทำงานอัตโนมัติ: Codex CLI แนะนำ Mini ไว้แล้วเมื่อใช้งานไปแล้ว 90% และคุณสามารถเขียนสคริปต์ได้ /model การสลับเครื่องมือของคุณเพื่อเลือกโมเดลตามความซับซ้อนของงาน

2) เทมเพลตวิศวกรรมพร้อมท์

สร้างเทมเพลตพรอมต์ขนาดเล็กที่กำหนดค่าได้สำหรับงานที่ทำซ้ำได้ เช่น การสร้างการทดสอบ ร่างบันทึกการเปลี่ยนแปลง การสร้างข้อความคอมมิท และคำอธิบาย PR จัดเก็บสิ่งเหล่านี้ไว้เป็นสไนปเป็ตที่นำมาใช้ซ้ำได้ในที่เก็บของคุณ หรือเป็นพรอมต์ที่ตั้งไว้ล่วงหน้าของ Codex

ตัวอย่างเทมเพลตคำเตือนสำหรับการทดสอบยูนิต:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) สร้างระบบความปลอดภัยอัตโนมัติ — การอนุมัติและการควบคุม CI

อย่าอนุญาตให้โมเดลพุชโค้ดโดยตรงโดยไม่ได้รับอนุมัติจากมนุษย์ ใช้โหมดการอนุมัติของ Codex และงาน Codex Cloud เพื่อสร้างความแตกต่างและกำหนดให้ต้องมีการอนุมัติจากมนุษย์ใน CI Codex CLI รองรับ "โหมดการอนุมัติ" ดังนั้นการแก้ไขจะต้องได้รับการอนุมัติก่อนนำไปใช้

4) การแคชและการเรียกแบบจำลองซ้ำซ้อน

สำหรับการแจ้งเตือนซ้ำๆ (เช่น การอธิบายฟังก์ชัน) ให้แคชการตอบสนองที่เชื่อมโยงกับการแจ้งเตือน + แฮชไฟล์ ซึ่งจะช่วยลดการเรียกซ้ำซ้อนและทำให้โปรไฟล์ต้นทุนสามารถคาดการณ์ได้

5) ใช้การสตรีม + ความแตกต่างที่เพิ่มขึ้น

หากเป็นไปได้ ให้ขอเอาต์พุตแบบสตรีมมิ่งและส่วนต่างที่เพิ่มขึ้น แทนที่จะเขียนไฟล์ใหม่ทั้งหมด ซึ่งจะช่วยลดการใช้โทเค็นและช่วยให้ผู้ตรวจสอบเห็นการเปลี่ยนแปลงที่ตรงเป้าหมาย

6) การทดสอบยูนิต-เครื่องกำเนิดไฟฟ้ากระแสแรก

สร้างการทดสอบและรันการทดสอบแบบโลคัลในสภาพแวดล้อมชั่วคราว หากการทดสอบล้มเหลว ให้ทำซ้ำโดยใช้โมเดลที่จัดเตรียมวิธีแก้ไขปัญหาการทดสอบล้มเหลว กำหนดให้แต่ละรอบการทำซ้ำเป็นพรอมต์แบบแยกส่วนพร้อมผลลัพธ์การทดสอบ

ตัวอย่างโค้ดอัตโนมัติ Codex CLI (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

สรุป

GPT-5-Codex-Mini ถือเป็นการพัฒนาผลิตภัณฑ์ที่เน้นการใช้งานจริง โดยยอมรับว่าเวิร์กโฟลว์ของนักพัฒนามักถูกครอบงำด้วยปฏิสัมพันธ์ระยะสั้นจำนวนมาก ซึ่งความหน่วง ต้นทุน และการไหลที่ต่อเนื่องเป็นสิ่งสำคัญ ด้วยการนำเสนอระดับย่อยที่มุ่งเน้นการใช้งาน IDE และ CLI OpenAI ช่วยให้ทีมงานสามารถปรับขนาดความช่วยเหลือด้านการเขียนโค้ดแบบรายวันได้ โดยไม่ต้องเรียกใช้โมเดลต้นทุนสูงสุดสำหรับการโต้ตอบแต่ละครั้งทันที

นักพัฒนาสามารถเข้าถึงได้ API GPT-5-โคเด็กซ์ ,GPT-5 โปร API ผ่านทาง CometAPI รุ่นล่าสุดของ cometAPI ที่ระบุไว้เป็นข้อมูล ณ วันที่เผยแพร่บทความ ก่อนเข้าถึง โปรดตรวจสอบให้แน่ใจว่าคุณได้เข้าสู่ระบบ CometAPI และได้รับรหัส API แล้วโคเมทเอพีไอ เสนอราคาที่ต่ำกว่าราคาอย่างเป็นทางการมากเพื่อช่วยคุณบูรณาการ

พร้อมไปหรือยัง?→ ลงทะเบียน CometAPI วันนี้ !

หากคุณต้องการทราบเคล็ดลับ คำแนะนำ และข่าวสารเกี่ยวกับ AI เพิ่มเติม โปรดติดตามเราที่ VK, X และ ไม่ลงรอยกัน!