ในช่วงปี 2025-2026 ภาพรวมของเครื่องมือ AI ยังคงแข็งแกร่งอย่างต่อเนื่อง โดย API ของเกตเวย์ (เช่น CometAPI) ได้ขยายตัวเพื่อให้สามารถเข้าถึงโมเดลหลายร้อยโมเดลได้ในรูปแบบ OpenAI ขณะที่แอปพลิเคชัน LLM สำหรับผู้ใช้ปลายทาง (เช่น AnythingLLM) ยังคงพัฒนาผู้ให้บริการ "Generic OpenAI" อย่างต่อเนื่อง เพื่อให้แอปพลิเคชันที่เน้นการใช้งานบนเดสก์ท็อปและบนเครื่องสามารถเรียกใช้งานอุปกรณ์ปลายทางที่รองรับ OpenAI ได้ ซึ่งทำให้ปัจจุบันการกำหนดเส้นทางการรับส่งข้อมูล AnythingLLM ผ่าน CometAPI เป็นเรื่องง่ายขึ้น ได้รับประโยชน์จากตัวเลือกโมเดล การกำหนดเส้นทางต้นทุน และการเรียกเก็บเงินแบบรวม ในขณะที่ยังคงใช้ UI และ RAG/agent ของ AnythingLLM ในพื้นที่

AnythingLLM คืออะไร และเหตุใดคุณจึงต้องการเชื่อมต่อมันกับ CometAPI?

AnythingLLM คืออะไร?

AnythingLLM คือแอปพลิเคชัน AI แบบโอเพนซอร์สแบบครบวงจรและไคลเอนต์แบบโลคัล/คลาวด์สำหรับการสร้างผู้ช่วยแชท เวิร์กโฟลว์การสร้างเสริมการดึงข้อมูล (RAG) และเอเจนต์ที่ขับเคลื่อนด้วย LLM แอปพลิเคชันนี้มาพร้อมกับ UI ที่ทันสมัย API สำหรับนักพัฒนา ฟีเจอร์เวิร์กสเปซ/เอเจนต์ และการสนับสนุน LLM แบบโลคัลและคลาวด์ ซึ่งออกแบบมาให้เป็นส่วนตัวตามค่าเริ่มต้นและสามารถขยายได้ผ่านปลั๊กอิน AnythingLLM เปิดเผย OpenAI ทั่วไป ผู้ให้บริการที่ให้สามารถพูดคุยกับ LLM API ที่เข้ากันได้กับ OpenAI

CometAPI คืออะไร?

CometAPI เป็นแพลตฟอร์มรวม API เชิงพาณิชย์ที่เปิดเผย โมเดล AI มากกว่า 500 แบบ ผ่านอินเทอร์เฟซ REST สไตล์ OpenAI เดียวและการเรียกเก็บเงินแบบรวมศูนย์ ในทางปฏิบัติ ช่วยให้คุณสามารถเรียกใช้โมเดลจากหลายผู้จำหน่าย (OpenAI, Anthropic, Google/Gemini รุ่นต่างๆ, โมเดลภาพ/เสียง ฯลฯ) ผ่านอินเทอร์เฟซเดียวกัน https://api.cometapi.com/v1 จุดสิ้นสุดและคีย์ API เดียว (รูปแบบ sk-xxxxx) CometAPI รองรับจุดสิ้นสุดแบบมาตรฐานสไตล์ OpenAI เช่น /v1/chat/completions, /v1/embeddingsฯลฯ ซึ่งทำให้สามารถปรับใช้เครื่องมือที่รองรับ API ที่เข้ากันได้กับ OpenAI ได้อย่างง่ายดาย

เหตุใดจึงต้องรวม AnythingLLM เข้ากับ CometAPI?

เหตุผลเชิงปฏิบัติสามประการ:

- ความยืดหยุ่นในการเลือกโมเดลและผู้จำหน่าย: AnythingLLM สามารถใช้ LLM ที่ "เข้ากันได้กับ OpenAI" ใดๆ ก็ได้ ผ่าน Generic OpenAI wrapper การชี้ wrapper นั้นไปที่ CometAPI จะทำให้เข้าถึงโมเดลหลายร้อยแบบได้ทันที โดยไม่ต้องเปลี่ยน UI หรือโฟลว์ของ AnythingLLM

- การเพิ่มประสิทธิภาพต้นทุน/การดำเนินการ: การใช้ CometAPI ช่วยให้คุณสามารถสลับโมเดล (หรือลดระดับเป็นโมเดลที่ถูกกว่า) จากศูนย์กลางเพื่อควบคุมต้นทุน และรักษาการเรียกเก็บเงินแบบรวมศูนย์แทนที่จะต้องสลับคีย์ผู้ให้บริการหลายราย

- การทดลองที่เร็วขึ้น: คุณสามารถทำ A/B โมเดลต่างๆ ได้ (เช่น

gpt-4o,gpt-4.5, รูปแบบ Claude หรือโมเดลโอเพนซอร์สหลายโหมด) ผ่านทาง AnythingLLM UI เดียวกัน ซึ่งมีประโยชน์สำหรับตัวแทน การตอบสนอง RAG การสรุป และงานหลายโหมด

สภาพแวดล้อมและเงื่อนไขที่ต้องเตรียมก่อนการบูรณาการ

ข้อกำหนดของระบบและซอฟต์แวร์ (ระดับสูง)

- เดสก์ท็อปหรือเซิร์ฟเวอร์ที่ใช้ AnythingLLM (Windows, macOS, Linux) — ติดตั้งบนเดสก์ท็อปหรือโฮสต์อินสแตนซ์ด้วยตนเอง โปรดตรวจสอบว่าคุณใช้บิลด์ล่าสุดที่เปิดเผย การตั้งค่า LLM / ผู้ให้บริการ AI การตั้งค่า

- บัญชี CometAPI และรหัส API (

sk-xxxxxความลับของสไตล์) คุณจะใช้ความลับนี้ในผู้ให้บริการ Generic OpenAI ของ AnythingLLM - การเชื่อมต่อเครือข่ายจากเครื่องของคุณไปยัง

https://api.cometapi.com(ไม่มีไฟร์วอลล์ที่บล็อก HTTPS ขาออก) - ทางเลือกแต่ขอแนะนำ: สภาพแวดล้อม Python หรือ Node สมัยใหม่สำหรับการทดสอบ (Python 3.10+ หรือ Node 18+), curl และไคลเอนต์ HTTP (Postman / HTTPie) เพื่อตรวจสอบความเหมาะสมของ CometAPI ก่อนที่จะเชื่อมต่อกับ AnythingLLM

เงื่อนไขเฉพาะของ AnythingLLM

การขอ OpenAI ทั่วไป ผู้ให้บริการ LLM เป็นเส้นทางที่แนะนำสำหรับปลายทางที่เลียนแบบพื้นผิว API ของ OpenAI เอกสารของ AnythingLLM เตือนว่าผู้ให้บริการนี้มุ่งเน้นนักพัฒนา และคุณควรเข้าใจอินพุตที่คุณให้ หากคุณใช้การสตรีมมิงหรือปลายทางของคุณไม่รองรับการสตรีมมิง AnythingLLM มีการตั้งค่าเพื่อปิดใช้งานการสตรีมมิงสำหรับ OpenAI ทั่วไป

รายการตรวจสอบความปลอดภัยและการปฏิบัติงาน

- ปฏิบัติต่อคีย์ CometAPI เช่นเดียวกับความลับอื่นๆ — อย่าคอมมิตมันไปที่ที่เก็บข้อมูล แต่จัดเก็บไว้ในพวงกุญแจระบบปฏิบัติการหรือตัวแปรสภาพแวดล้อมหากเป็นไปได้

- หากคุณวางแผนที่จะใช้เอกสารที่มีความละเอียดอ่อนใน RAG โปรดตรวจสอบให้แน่ใจว่าการรับประกันความเป็นส่วนตัวของปลายทางตรงตามความต้องการในการปฏิบัติตามข้อกำหนดของคุณ (ตรวจสอบเอกสาร/ข้อกำหนดของ CometAPI)

- ตัดสินใจเกี่ยวกับจำนวนโทเค็นสูงสุดและขีดจำกัดหน้าต่างบริบทเพื่อป้องกันค่าใช้จ่ายที่สูงเกินไป

คุณจะกำหนดค่า AnythingLLM ให้ใช้ CometAPI ได้อย่างไร (ทีละขั้นตอน)

ด้านล่างนี้เป็นลำดับขั้นตอนที่ชัดเจน ตามด้วยตัวแปรสภาพแวดล้อมตัวอย่างและชิ้นส่วนโค้ดสำหรับการทดสอบการเชื่อมต่อก่อนที่คุณจะบันทึกการตั้งค่าใน UI ของ AnythingLLM

ขั้นตอนที่ 1 — รับรหัส CometAPI ของคุณ

- ลงทะเบียนหรือลงชื่อเข้าใช้ที่ CometAPI

- ไปที่ “API Keys” และสร้างคีย์ — คุณจะได้รับสตริงที่มีลักษณะดังนี้

sk-xxxxx. เก็บเป็นความลับ.

ขั้นตอนที่ 2 — ตรวจสอบว่า CometAPI ทำงานได้กับคำขอด่วน

ใช้ curl หรือ Python เพื่อเรียกจุดสิ้นสุดการแชทแบบง่าย ๆ เพื่อยืนยันการเชื่อมต่อ

ตัวอย่างการม้วนงอ

curl -X POST "https://api.cometapi.com/v1/chat/completions" \

-H "Authorization: Bearer sk-xxxxx" \

-H "Content-Type: application/json" \

-d '{

"model": "gpt-4o",

"messages": ,

"max_tokens": 50

}'

หากส่งคืน 200 และการตอบสนอง JSON ด้วย choices อาร์เรย์ คีย์ และเครือข่ายของคุณทำงานได้ (เอกสารของ CometAPI แสดงพื้นผิวและจุดสิ้นสุดสไตล์ OpenAI)

ตัวอย่าง Python (คำขอ)

import requests

url = "https://api.cometapi.com/v1/chat/completions"

headers = {"Authorization": "Bearer sk-xxxxx", "Content-Type": "application/json"}

payload = {

"model": "gpt-4o",

"messages": ,

"max_tokens": 64

}

r = requests.post(url, json=payload, headers=headers, timeout=15)

print(r.status_code, r.json())

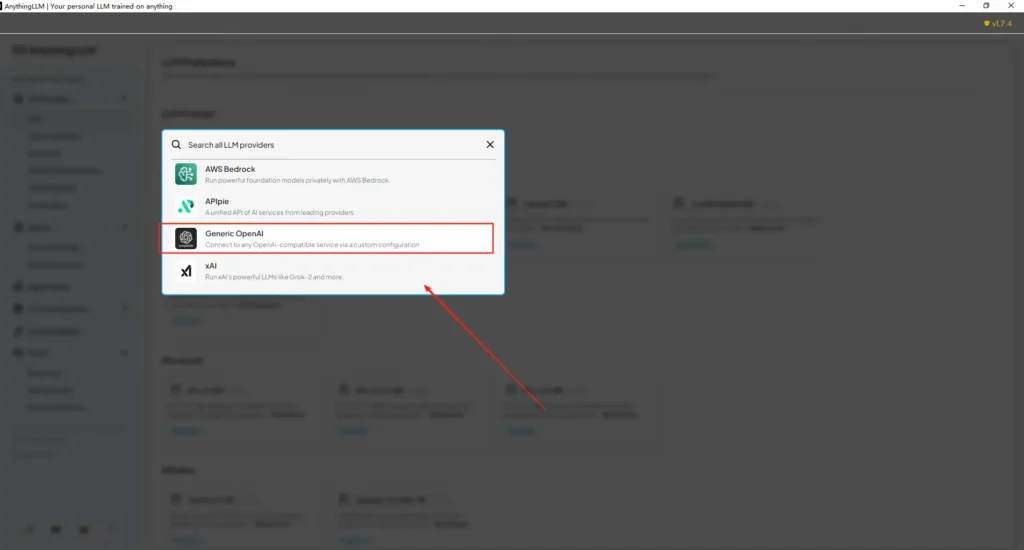

ขั้นตอนที่ 3 — กำหนดค่า AnythingLLM (UI)

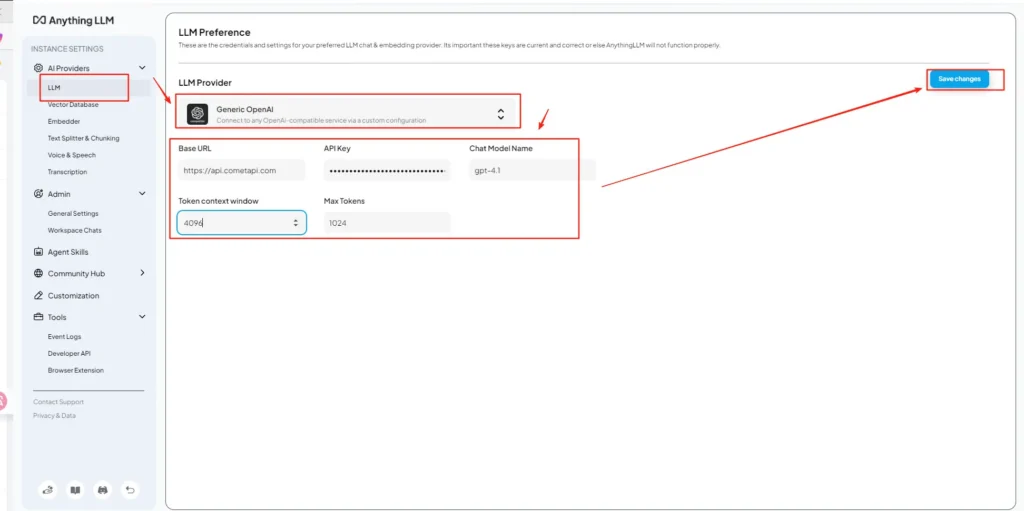

เปิด AnythingLLM → การตั้งค่า → ผู้ให้บริการ AI → การตั้งค่า LLM (หรือเส้นทางที่คล้ายกันในเวอร์ชันของคุณ) ใช้ OpenAI ทั่วไป ผู้ให้บริการและกรอกข้อมูลดังต่อไปนี้:

การกำหนดค่า API (ตัวอย่าง)

• เข้าสู่เมนูการตั้งค่า AnythingLLM ค้นหา LLM Preferences ภายใต้ AI Providers

• เลือก Generic OpenAI เป็นผู้ให้บริการโมเดล ป้อนhttps://api.cometapi.com/v1ในช่อง URL

• วางsk-xxxxxจาก CometAPI ในช่องป้อนคีย์ API กรอกหน้าต่างบริบทโทเค็นและจำนวนโทเค็นสูงสุดตามโมเดลจริง คุณยังสามารถปรับแต่งชื่อโมเดลในหน้านี้ได้ เช่น การเพิ่มgpt-4oแบบ

สิ่งนี้สอดคล้องกับแนวทาง “Generic OpenAI” ของ AnythingLLM (ตัวห่อสำหรับนักพัฒนา) และแนวทาง URL ฐานที่เข้ากันได้กับ OpenAI ของ CometAPI

ขั้นตอนที่ 4 — ตั้งชื่อโมเดลและจำกัดโทเค็น

บนหน้าจอการตั้งค่าเดียวกัน ให้เพิ่มหรือปรับแต่งชื่อโมเดลให้ตรงกับที่ CometAPI เผยแพร่ (เช่น gpt-4o, minimax-m2, kimi-k2-thinking) เพื่อให้ AnythingLLM UI สามารถนำเสนอโมเดลเหล่านั้นให้กับผู้ใช้ได้ CometAPI เผยแพร่สตริงโมเดลสำหรับแต่ละผู้จำหน่าย

ขั้นตอนที่ 5 — ทดสอบใน AnythingLLM

เริ่มแชทใหม่หรือใช้พื้นที่ทำงานที่มีอยู่ เลือกผู้ให้บริการ OpenAI ทั่วไป (หากคุณมีผู้ให้บริการหลายราย) เลือกชื่อโมเดล CometAPI หนึ่งชื่อที่คุณเพิ่มเข้าไป และรันคำสั่งง่ายๆ หากผลลัพธ์มีความสอดคล้องกัน แสดงว่าคุณได้ผสานรวมแล้ว

AnythingLLM ใช้การตั้งค่าเหล่านี้ภายในอย่างไร

Wrapper OpenAI ทั่วไปของ AnythingLLM สร้างคำขอสไตล์ OpenAI (/v1/chat/completions, /v1/embeddings) ดังนั้นเมื่อคุณระบุ URL ฐานและระบุคีย์ CometAPI แล้ว AnythingLLM จะกำหนดเส้นทางการแชท การโทรหาตัวแทน และคำขอแบบฝังผ่าน CometAPI อย่างโปร่งใส หากคุณใช้ตัวแทน AnythingLLM ( @agent กระแสข้อมูล) พวกเขาจะสืบทอดผู้ให้บริการรายเดียวกัน

แนวทางปฏิบัติที่ดีที่สุดและข้อผิดพลาดที่อาจเกิดขึ้นคืออะไร?

ปฏิบัติที่ดีที่สุด

- ใช้การตั้งค่าบริบทที่เหมาะสมกับโมเดล: จับคู่ Token Context Window และ Max Token ของ AnythingLLM กับโมเดลที่คุณเลือกบน CometAPI ความไม่ตรงกันจะนำไปสู่การตัดทอนที่ไม่คาดคิดหรือการเรียกที่ล้มเหลว

- รักษาคีย์ API ของคุณให้ปลอดภัย: เก็บคีย์ CometAPI ไว้ในตัวแปรสภาพแวดล้อมและ/หรือ Kubernetes/ตัวจัดการความลับ อย่าตรวจสอบคีย์เหล่านี้ใน git AnythingLLM จะเก็บคีย์ไว้ในการตั้งค่าภายในเครื่องหากคุณป้อนคีย์เหล่านี้ใน UI — ถือว่าพื้นที่เก็บข้อมูลโฮสต์เป็นข้อมูลสำคัญ

- เริ่มต้นด้วยโมเดลราคาถูกกว่า/เล็กกว่าสำหรับกระแสการทดลอง: ใช้ CometAPI เพื่อทดลองใช้โมเดลต้นทุนต่ำสำหรับการพัฒนา และสำรองโมเดลพรีเมียมสำหรับการผลิตจริง CometAPI โฆษณาการเปลี่ยนต้นทุนและการเรียกเก็บเงินแบบรวมอย่างชัดเจน

- ติดตามการใช้งานและตั้งค่าการแจ้งเตือน: CometAPI มีแดชบอร์ดการใช้งาน — กำหนดงบประมาณ/การแจ้งเตือนเพื่อหลีกเลี่ยงค่าใช้จ่ายที่ไม่คาดคิด

- ตัวแทนทดสอบและเครื่องมือแบบแยกส่วน: ตัวแทน AnythingLLM สามารถทริกเกอร์การดำเนินการได้ ทดสอบด้วยคำเตือนที่ปลอดภัยและบนอินสแตนซ์การจัดเตรียมก่อน

ข้อผิดพลาดทั่วไป

- UI เทียบกับ

.envความขัดแย้ง: เมื่อทำการโฮสต์ด้วยตนเอง การตั้งค่า UI สามารถเขียนทับได้.envการเปลี่ยนแปลง (และในทางกลับกัน) ตรวจสอบที่สร้างขึ้น/app/server/.envหากทุกอย่างกลับมาเป็นปกติหลังจากรีสตาร์ท รายงานปัญหาชุมชนLLM_PROVIDERรีเซ็ต - ชื่อรุ่นไม่ตรงกัน: การใช้ชื่อโมเดลที่ไม่มีใน CometAPI จะทำให้เกิดข้อผิดพลาด 400/404 จากเกตเวย์ โปรดตรวจสอบชื่อโมเดลที่มีอยู่ในรายการโมเดล CometAPI เสมอ

- ขีดจำกัดโทเค็นและการสตรีม: หากคุณต้องการการตอบสนองแบบสตรีมมิ่ง โปรดตรวจสอบว่าโมเดล CometAPI รองรับการสตรีมมิ่งหรือไม่ (และเวอร์ชัน UI ของ AnythingLLM รองรับ) ผู้ให้บริการบางรายมีความหมายของการสตรีมมิ่งที่แตกต่างกัน

การผสานรวมนี้จะปลดล็อกกรณีการใช้งานในโลกแห่งความเป็นจริงใดบ้าง

การดึงข้อมูล-Augmented Generation (RAG)

ใช้ตัวโหลดเอกสารของ AnythingLLM + ฐานข้อมูลเวกเตอร์ ร่วมกับ CometAPI LLM เพื่อสร้างคำตอบที่คำนึงถึงบริบท คุณสามารถทดลองใช้การฝังแบบประหยัด + โมเดลแชทราคาแพง หรือจะเก็บทุกอย่างไว้บน CometAPI เพื่อการเรียกเก็บเงินแบบรวมก็ได้ โฟลว์ RAG ของ AnythingLLM เป็นฟีเจอร์หลักในตัว

ระบบอัตโนมัติของตัวแทน

AnythingLLM รองรับ @agent เวิร์กโฟลว์ (เรียกดูเพจ เรียกใช้เครื่องมือ เรียกใช้งานระบบอัตโนมัติ) การเรียกใช้ LLM ของตัวแทนการกำหนดเส้นทางผ่าน CometAPI ช่วยให้คุณเลือกโมเดลสำหรับขั้นตอนการควบคุม/การตีความโดยไม่ต้องแก้ไขโค้ดของตัวแทน

การทดสอบ A/B หลายโมเดลและการเพิ่มประสิทธิภาพต้นทุน

สลับโมเดลต่อพื้นที่ทำงานหรือคุณลักษณะ (เช่น gpt-4o สำหรับคำตอบการผลิต gpt-4o-mini สำหรับการพัฒนา) CometAPI ทำให้การสลับโมเดลเป็นเรื่องง่ายและรวมต้นทุนไว้ที่ศูนย์กลาง

ท่อส่งหลายโหมด

CometAPI นำเสนอโมเดลภาพ เสียง และโมเดลเฉพาะทาง การสนับสนุนหลายโหมดของ AnythingLLM (ผ่านผู้ให้บริการ) บวกกับโมเดลของ CometAPI ช่วยให้สามารถสร้างคำบรรยายภาพ สรุปข้อมูลหลายโหมด หรือถอดเสียงผ่านอินเทอร์เฟซเดียวกันได้

สรุป

CometAPI ยังคงวางตำแหน่งตัวเองในฐานะเกตเวย์แบบหลายโมเดล (มากกว่า 500 โมเดล, API สไตล์ OpenAI) ซึ่งทำให้ CometAPI เป็นพันธมิตรที่เหมาะสมกับแอปพลิเคชันอย่าง AnythingLLM ที่รองรับผู้ให้บริการ Generic OpenAI อยู่แล้ว เช่นเดียวกัน ผู้ให้บริการ Generic ของ AnythingLLM และตัวเลือกการกำหนดค่าล่าสุด ช่วยให้การเชื่อมต่อกับเกตเวย์เหล่านี้เป็นเรื่องง่าย การผสานรวมนี้ช่วยลดความยุ่งยากในการทดลองและการย้ายข้อมูลการผลิตในช่วงปลายปี 2025

วิธีเริ่มต้นใช้งาน Comet API

CometAPI เป็นแพลตฟอร์ม API แบบรวมที่รวบรวมโมเดล AI มากกว่า 500 โมเดลจากผู้ให้บริการชั้นนำ เช่น ซีรีส์ GPT ของ OpenAI, Gemini ของ Google, Claude ของ Anthropic, Midjourney, Suno และอื่นๆ ไว้ในอินเทอร์เฟซเดียวที่เป็นมิตรกับนักพัฒนา ด้วยการนำเสนอการตรวจสอบสิทธิ์ การจัดรูปแบบคำขอ และการจัดการการตอบสนองที่สอดคล้องกัน CometAPI จึงทำให้การรวมความสามารถของ AI เข้ากับแอปพลิเคชันของคุณง่ายขึ้นอย่างมาก ไม่ว่าคุณจะกำลังสร้างแชทบ็อต เครื่องกำเนิดภาพ นักแต่งเพลง หรือไพพ์ไลน์การวิเคราะห์ที่ขับเคลื่อนด้วยข้อมูล CometAPI ช่วยให้คุณทำซ้ำได้เร็วขึ้น ควบคุมต้นทุน และไม่ขึ้นอยู่กับผู้จำหน่าย ทั้งหมดนี้ในขณะที่ใช้ประโยชน์จากความก้าวหน้าล่าสุดในระบบนิเวศ AI

เริ่มต้นด้วยการสำรวจความสามารถของโมเดลโคเมทเอพีไอ ที่ สนามเด็กเล่น และดูคำแนะนำโดยละเอียดในคู่มือ API ก่อนเข้าใช้งาน โปรดตรวจสอบให้แน่ใจว่าคุณได้เข้าสู่ระบบ CometAPI และได้รับรหัส API แล้ว ด้วยetAPI เสนอราคาที่ต่ำกว่าราคาอย่างเป็นทางการมากเพื่อช่วยคุณบูรณาการ

พร้อมไปหรือยัง?→ ลงทะเบียน CometAPI วันนี้ !

หากคุณต้องการทราบเคล็ดลับ คำแนะนำ และข่าวสารเกี่ยวกับ AI เพิ่มเติม โปรดติดตามเราที่ VK, X และ ไม่ลงรอยกัน!