GPT-5.2 API คืออะไร

GPT-5.2 API เหมือนกับ GPT-5.2 Thinking ใน ChatGPT GPT-5.2 Thinking เป็นรุ่นระดับกลางของตระกูล GPT-5.2 ของ OpenAI ออกแบบมาเพื่อ งานเชิงลึก: การให้เหตุผลหลายขั้นตอน การสรุปเอกสารยาว การสร้างโค้ดคุณภาพ และงานความรู้ระดับมืออาชีพที่ให้ความสำคัญกับความแม่นยำและโครงสร้างที่ใช้งานได้มากกว่าความเร็วดิบ ใน API จะถูกเปิดให้ใช้ในรูปแบบโมเดล gpt-5.2 (Responses API / Chat Completions) และอยู่กึ่งกลางระหว่างรุ่น Instant ที่หน่วงต่ำและรุ่น Pro ที่คุณภาพสูงกว่าแต่มีค่าใช้จ่ายมากกว่า

คุณสมบัติหลัก

- บริบทยาวมากและการบีบอัด: หน้าต่างบริบทที่ใช้งานได้จริง 400K และเครื่องมือบีบอัดเพื่อจัดการความเกี่ยวข้องในบทสนทนาและเอกสารยาว

- สามารถปรับระดับความพยายามในการให้เหตุผลได้:

none | medium | high | xhigh(xhigh เปิดใช้การประมวลผลภายในสูงสุดสำหรับงานให้เหตุผลที่ยาก)xhighใช้ได้ในรุ่น Thinking/Pro - การรองรับเครื่องมือและฟังก์ชันที่แข็งแกร่งขึ้น: การเรียกใช้เครื่องมือแบบชั้นหนึ่ง ไวยากรณ์ (CFG/Lark) เพื่อจำกัดผลลัพธ์เชิงโครงสร้าง และพฤติกรรมเชิงเอเจนต์ที่ปรับปรุงเพื่อให้การทำงานอัตโนมัติหลายขั้นตอนที่ซับซ้อนง่ายขึ้น

- การทำความเข้าใจแบบมัลติโมดัล: การทำความเข้าใจภาพและข้อความที่สมบูรณ์ยิ่งขึ้นและการบูรณาการเข้าสู่ภารกิจหลายขั้นตอน

- ความปลอดภัยและการจัดการเนื้อหาที่อ่อนไหวที่ดีขึ้น: การแทรกแซงแบบมุ่งเป้าเพื่อลดการตอบสนองที่ไม่พึงประสงค์ในประเด็นอย่างเช่นการทำร้ายตนเองและบริบทอ่อนไหวอื่น ๆ

ขีดความสามารถทางเทคนิคและสเปก (มุมมองนักพัฒนา)

- API endpoints & model IDs:

gpt-5.2สำหรับ Thinking (Responses API),gpt-5.2-chat-latestสำหรับเวิร์กโฟลว์แบบแชต/instant และgpt-5.2-proสำหรับระดับ Pro; ใช้งานได้ผ่าน Responses API และ Chat Completions ตามที่ระบุ - Reasoning tokens & effort management: API รองรับพารามิเตอร์แบบชัดเจนเพื่อจัดสรรคอมพิวต์ (ความพยายามในการให้เหตุผล) ต่อคำขอ; ความพยายามที่สูงขึ้นทำให้หน่วงและต้นทุนเพิ่มขึ้น แต่ช่วยปรับปรุงคุณภาพผลลัพธ์สำหรับงานที่ซับซ้อน

- เครื่องมือเอาต์พุตเชิงโครงสร้าง: รองรับไวยากรณ์ (Lark / CFG) เพื่อจำกัดผลลัพธ์ของโมเดลให้เป็น DSL หรือไวยากรณ์ที่แม่นยำ (เหมาะกับ SQL, JSON, การสร้าง DSL)

- การเรียกใช้เครื่องมือแบบขนานและการประสานงานเชิงเอเจนต์: การทำงานขนานที่ดีขึ้นและการจัดวางเครื่องมือที่สะอาดขึ้นช่วยลดความจำเป็นของพรอมป์ระบบที่ซับซ้อนและโครงสร้างหลายเอเจนต์

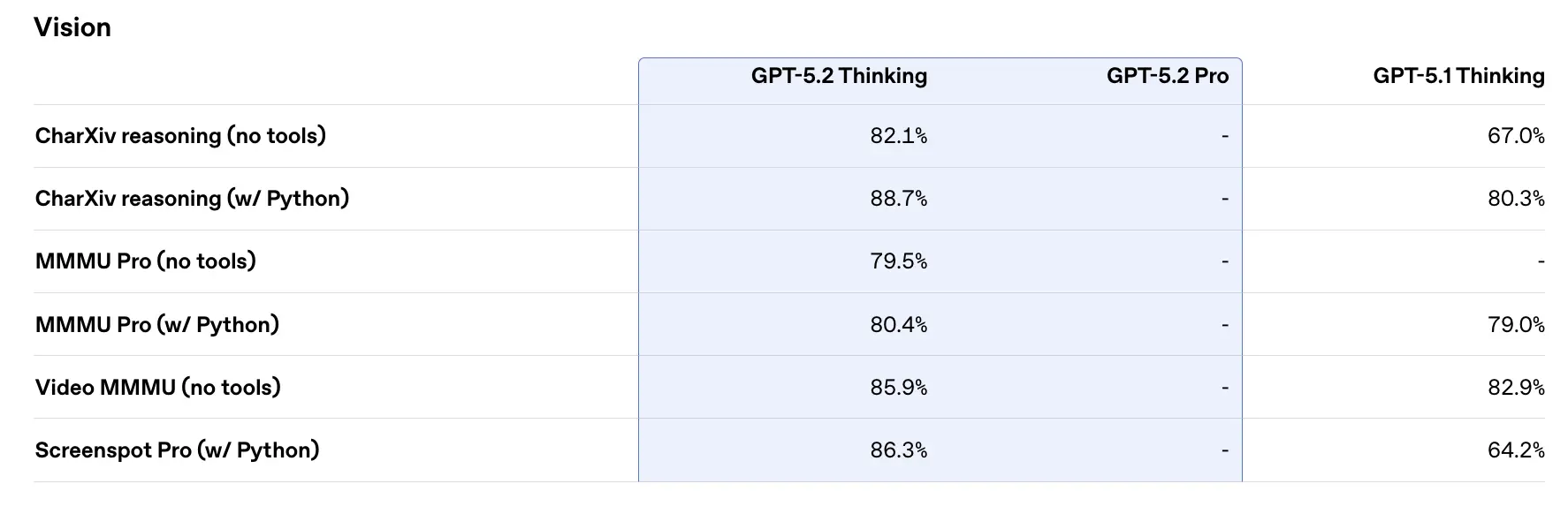

ประสิทธิภาพตามเบนช์มาร์กและข้อมูลสนับสนุน

OpenAI เผยแพร่ผลทดสอบภายในและภายนอกหลากหลายสำหรับ GPT-5.2 ไฮไลต์ที่คัดมาบางส่วน (ตามตัวเลขที่ OpenAI รายงาน):

- GDPval (44 อาชีพ, งานความรู้) — GPT-5.2 Thinking “ชนะหรือสูสีกับมืออาชีพระดับสูงของอุตสาหกรรมใน 70.9% ของการเปรียบเทียบ”; OpenAI รายงานว่าผลลัพธ์ถูกผลิตด้วย >11× ความเร็ว และ <1% ต้นทุน เมื่อเทียบกับมืออาชีพผู้เชี่ยวชาญในงาน GDPval ของพวกเขา (ค่าประมาณความเร็วและต้นทุนอิงข้อมูลในอดีต) งานเหล่านี้รวมถึงโมเดลสเปรดชีต สไลด์นำเสนอ และวิดีโอสั้น

- SWE-Bench Pro (coding) — GPT-5.2 Thinking ทำได้ ≈55.6% บน SWE-Bench Pro และ ~80% บน SWE-Bench Verified (เฉพาะ Python) ตามที่ OpenAI ระบุ สถิตินี้ตั้งมาตรฐานใหม่สำหรับการสร้างโค้ด/การประเมินเชิงวิศวกรรมในการทดสอบของพวกเขา ซึ่งในทางปฏิบัติหมายถึงการดีบักที่เชื่อถือได้มากขึ้นและการแก้ไขแบบปลายทางถึงปลายทางตามตัวอย่างของ OpenAI

- GPQA Diamond (graduate-level science Q&A) — GPT-5.2 Pro: 93.2%, GPT-5.2 Thinking: 92.4% บน GPQA Diamond (ไม่ใช้เครื่องมือ, เหตุผลสูงสุด)

- ARC-AGI series — บน ARC-AGI-2 (เบนช์มาร์กการให้เหตุผลแบบไหลที่ยากกว่า) GPT-5.2 Thinking ได้คะแนน 52.9% และ GPT-5.2 Pro 54.2% (OpenAI ระบุว่านี่คือสถิติ state-of-the-art ใหม่สำหรับโมเดลสไตล์ chain-of-thought)

- Long-context (OpenAI MRCRv2) — GPT-5.2 Thinking แสดงความแม่นยำเกือบ 100% บนตัวแปร MRCR แบบ 4-needle จนถึง 256k โทเค็น และได้คะแนนที่ดีขึ้นอย่างมีนัยสำคัญเทียบกับ GPT-5.1 ในสภาพแวดล้อมบริบทยาว (OpenAI เผยแพร่กราฟและตาราง MRCRv2)

การเปรียบเทียบกับรุ่นร่วมสมัย

- vs Google Gemini 3 (Gemini 3 Pro / Deep Think): Gemini 3 Pro มีการประชาสัมพันธ์ว่ามีหน้าต่างบริบท ~1,048,576 (≈1M) โทเค็น และอินพุตมัลติโมดัลที่กว้าง (ข้อความ ภาพ เสียง วิดีโอ PDF) และการผสานรวมเชิงเอเจนต์ที่แข็งแรงผ่าน Vertex AI / AI Studio ตามสเปกบนกระดาษ หน้าต่างบริบทที่ใหญ่กว่าของ Gemini 3 เป็นตัวแบ่งแยกสำหรับงานโหลดขนาดใหญ่มากในเซสชันเดียว ส่วนข้อแลกเปลี่ยนรวมถึงพื้นผิวเครื่องมือและความเหมาะสมของระบบนิเวศ

- vs Anthropic Claude Opus 4.5: Opus 4.5 ของ Anthropic เน้นเวิร์กโฟลว์การโค้ด/เอเจนต์สำหรับองค์กร และรายงานผล SWE-bench ที่แข็งแกร่งและความทนทานสำหรับเซสชันเชิงเอเจนต์ที่ยาว Anthropic วางตำแหน่ง Opus สำหรับระบบอัตโนมัติและการสร้างโค้ดด้วยหน้าต่างบริบท 200k และการผสานรวมเอเจนต์/Excel แบบเฉพาะทาง Opus 4.5 เป็นคู่แข่งที่แข็งแกร่งในงานระบบอัตโนมัติระดับองค์กรและงานโค้ด

ข้อสรุปเชิงปฏิบัติ: GPT-5.2 มุ่งเป้าการปรับปรุงแบบสมดุล (บริบท 400k เอาต์พุตโทเค็นสูง การให้เหตุผล/การโค้ดที่ดีขึ้น) Gemini 3 มุ่งเป้าบริบทเซสชันเดียวที่ใหญ่ที่สุด (≈1M) ขณะที่ Claude Opus เน้นความแข็งแรงเชิงเอเจนต์และวิศวกรรมสำหรับองค์กร เลือกให้ตรงกับขนาดบริบท ความต้องการด้านโมดาลิตี้ ความเหมาะสมของฟีเจอร์/เครื่องมือ และสมดุลต้นทุน/หน่วง

วิธีเข้าถึงและใช้งาน GPT-5.2 API

ขั้นตอนที่ 1: สมัครรับ API Key

เข้าสู่ระบบที่ cometapi.com หากคุณยังไม่เป็นผู้ใช้ของเรา โปรดลงทะเบียนก่อน ลงชื่อเข้าใช้ CometAPI console รับ API key สิทธิ์เข้าถึงของอินเทอร์เฟซ คลิก “Add Token” ที่ API token ในศูนย์ส่วนบุคคล รับ token key: sk-xxxxx และส่ง

ขั้นตอนที่ 2: ส่งคำขอไปยัง GPT-5.2 API

เลือก endpoint “gpt-5.2” เพื่อส่งคำขอ API และตั้งค่า request body วิธีการและโครงสร้างคำขอสามารถดูได้จากเอกสาร API บนเว็บไซต์ของเรา เว็บไซต์ของเรามีการทดสอบด้วย Apifox เพื่อความสะดวกของคุณ แทนที่ <YOUR_API_KEY> ด้วย CometAPI key จริงจากบัญชีของคุณ นักพัฒนาจะเรียกใช้ผ่าน Responses API / Chat endpoints

ใส่คำถามหรือคำขอของคุณในฟิลด์ content—นี่คือสิ่งที่โมเดลจะตอบกลับ ประมวลผลการตอบกลับของ API เพื่อรับคำตอบที่สร้างขึ้น

ขั้นตอนที่ 3: ดึงและตรวจสอบผลลัพธ์

ประมวลผลการตอบกลับของ API เพื่อรับคำตอบที่สร้างขึ้น หลังการประมวลผล API จะตอบกลับด้วยสถานะงานและข้อมูลผลลัพธ์

ดูเพิ่มเติม Gemini 3 Pro Preview API