API Qwen2.5-Omni-7B มอบวิธีการที่เข้ากันได้กับ OpenAI แก่ผู้พัฒนาเพื่อโต้ตอบกับโมเดล ทำให้สามารถประมวลผลอินพุตข้อความ ภาพ เสียง และวิดีโอ และสร้างทั้งข้อความและการตอบสนองเสียงพูดธรรมชาติแบบเรียลไทม์

Qwen2.5-Omni-7B คืออะไร?

Qwen2.5-Omni-7B คือโมเดล AI มัลติโหมดเรือธงของ Alibaba ที่มีพารามิเตอร์ 7 พันล้านตัว ออกแบบมาเพื่อประมวลผลและทำความเข้าใจโหมดข้อมูลต่างๆ รองรับอินพุตข้อความ รูปภาพ เสียง และวิดีโอ โมเดลนี้รองรับการโต้ตอบด้วยคำพูดและวิดีโอแบบเรียลไทม์ ทำให้เป็นเครื่องมืออเนกประสงค์สำหรับแอปพลิเคชันต่างๆ

คุณสมบัติหลักของ Qwen2.5-Omni-7B

- การประมวลผลหลายโหมด: สามารถจัดการอินพุตที่หลากหลาย รวมถึงข้อความ รูปภาพ เสียง และวิดีโอ ช่วยให้เข้าใจข้อมูลได้อย่างครอบคลุม

- การโต้ตอบแบบเรียลไทม์: รองรับการประมวลผลความหน่วงต่ำ ช่วยให้สามารถพูดคุยและสนทนาผ่านวิดีโอได้แบบเรียลไทม์

- สถาปัตยกรรมนักคิด-นักพูด: ใช้ระบบสถาปัตยกรรมแบบคู่ โดยที่ 'Thinker' ทำหน้าที่จัดการประมวลผลข้อมูลและการทำความเข้าใจ ในขณะที่ 'Talker' ทำหน้าที่สร้างเอาต์พุตเสียงพูดที่ลื่นไหล

- TMRoPE แบบหลายโหมดที่ปรับเวลาตามที่กำหนด (TMRoPE): ใช้ TMRoPE เพื่อการซิงโครไนซ์ข้อมูลชั่วคราวอย่างแม่นยำในรูปแบบต่างๆ เพื่อให้เกิดความเข้าใจและการตอบสนองที่สอดคล้องกัน

การวัดประสิทธิภาพ

ความสำเร็จของเกณฑ์มาตรฐาน

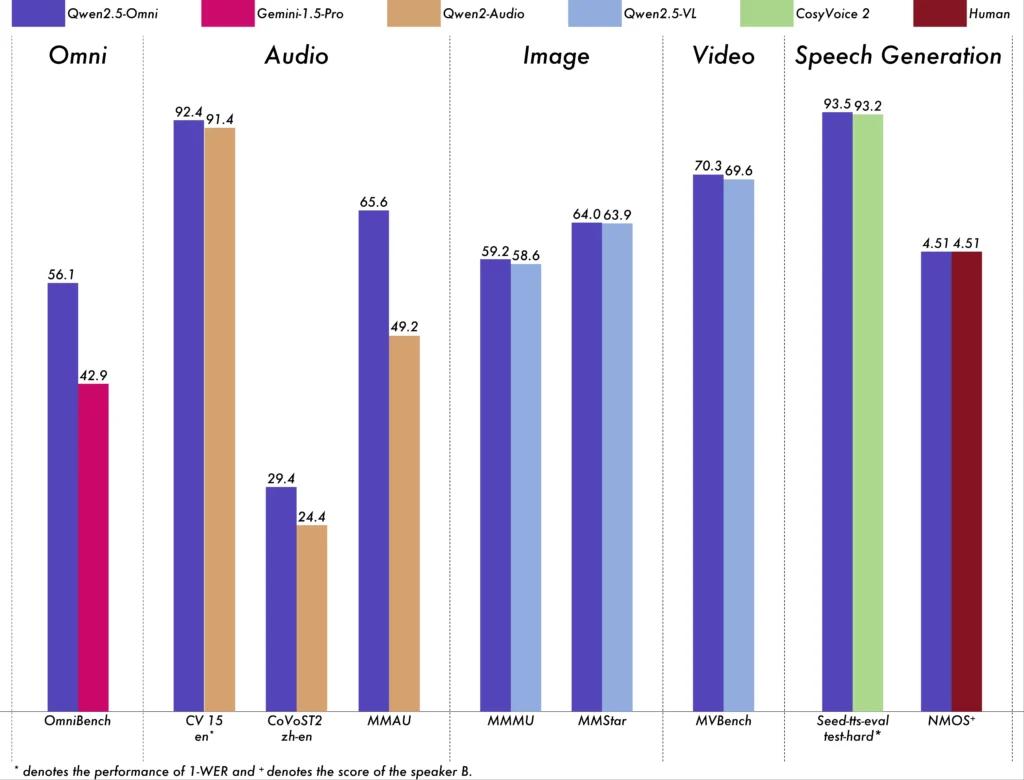

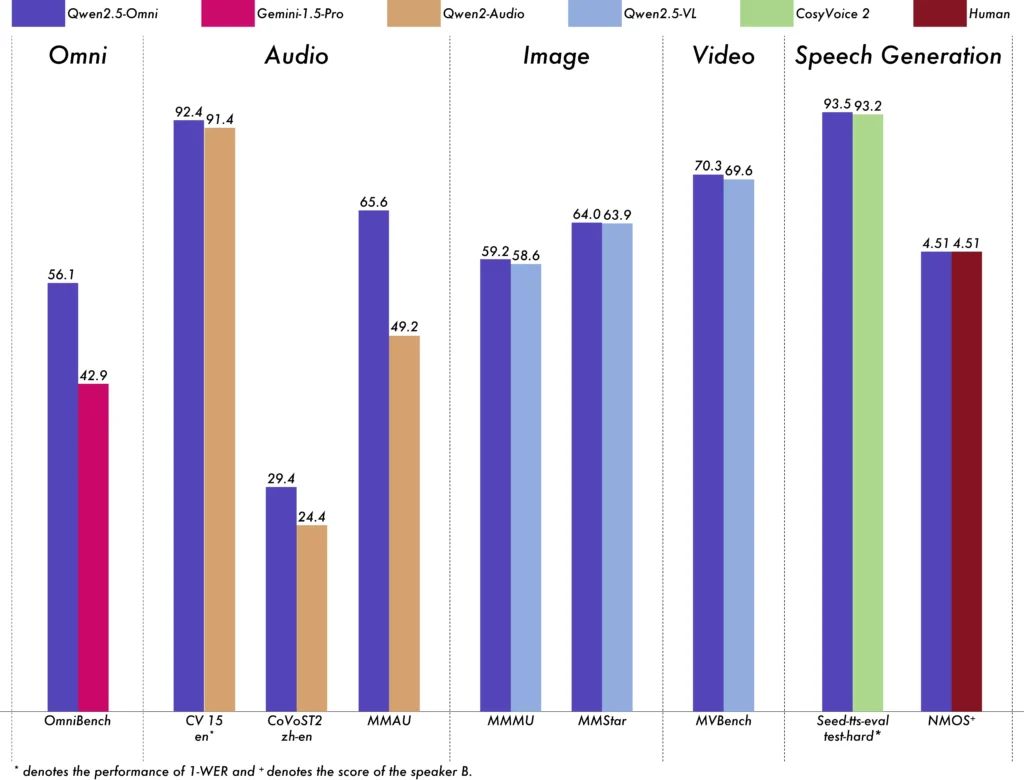

Qwen2.5-Omni-7B ได้แสดงให้เห็นถึงประสิทธิภาพที่โดดเด่นในเกณฑ์มาตรฐานต่างๆ:

- ออมนิเบนช์: ทำคะแนนเฉลี่ยได้ 56.13% เหนือกว่ารุ่นอื่นๆ เช่น Gemini-1.5-Pro (42.91%) และ MIO-Instruct (33.80%)

- การรู้จำเสียง: บนชุดข้อมูล Librispeech สามารถบรรลุอัตราข้อผิดพลาดของคำที่อยู่ในช่วง 1.6% ถึง 3.5% ซึ่งเทียบได้กับโมเดลเฉพาะ เช่น Whisper-large-v3

- การจดจำเหตุการณ์เสียง: ได้รับคะแนน 0.570 บนชุดข้อมูล Meld ซึ่งสร้างมาตรฐานใหม่ในสาขานี้

- ความเข้าใจเกี่ยวกับดนตรี: ได้รับคะแนน 0.88 จากเกณฑ์มาตรฐาน GiantSteps Tempo ซึ่งแสดงให้เห็นถึงความสามารถในการทำความเข้าใจดนตรี

ความสามารถในการประมวลผลแบบเรียลไทม์

Qwen2.5-Omni-7B ออกแบบมาสำหรับแอปพลิเคชันแบบเรียลไทม์ รองรับการสตรีมแบบบล็อกต่อบล็อก ช่วยให้สร้างเสียงได้ทันทีโดยมีความหน่วงต่ำ คุณสมบัตินี้มีประโยชน์อย่างยิ่งสำหรับแอปพลิเคชันที่ต้องการการตอบสนองทันที เช่น ผู้ช่วยเสมือนและระบบ AI แบบโต้ตอบ

รายระเอียดทางเทคนิค

การออกแบบสถาปัตยกรรม

- กรอบความคิดนักคิด-นักพูด: ส่วนประกอบ 'Thinker' ประมวลผลและทำความเข้าใจอินพุตแบบหลายโหมด สร้างการแสดงความหมายระดับสูงและเอาต์พุตข้อความ 'Talker' แปลงการแสดงเหล่านี้เป็นคำพูดที่เป็นธรรมชาติและลื่นไหล ช่วยให้การสื่อสารระหว่างระบบ AI และผู้ใช้เป็นไปอย่างราบรื่น

- กลไก TMRoPE: จัดการกับความท้าทายในการซิงโครไนซ์ข้อมูลชั่วคราวจากแหล่งต่าง ๆ โดยการจัดเรียงไทม์สแตมป์ของอินพุตวิดีโอและเสียง อำนวยความสะดวกในการทำความเข้าใจหลายโหมดอย่างสอดคล้องกัน

วิธีการฝึกอบรม

โมเดลดังกล่าวได้รับกระบวนการฝึกอบรมสามขั้นตอน:

- ระยะที่หนึ่ง: แก้ไขพารามิเตอร์โมเดลภาษาในระหว่างการฝึกตัวเข้ารหัสภาพและเสียงโดยใช้คู่เสียง-ข้อความและภาพ-ข้อความอย่างครอบคลุมเพื่อปรับปรุงความเข้าใจหลายโหมด

- ระยะที่สอง: ยกเลิกการตรึงพารามิเตอร์ทั้งหมดและฝึกอบรมบนชุดข้อมูลที่หลากหลายประกอบด้วยภาพ วิดีโอ เสียง และข้อความ เพื่อปรับปรุงความเข้าใจโหมดหลายโหมดอย่างครอบคลุมยิ่งขึ้น

- ขั้นตอนที่สาม: มุ่งเน้นไปที่การฝึกอบรมข้อมูลลำดับยาวเพื่อเสริมความสามารถของโมเดลในการจัดการอินพุตที่ซับซ้อนและขยายออก

วิวัฒนาการของโมเดลคเวน

ความก้าวหน้าจาก Qwen ไปสู่ Qwen2.5

วิวัฒนาการจาก Qwen ไปเป็น Qwen2.5 ถือเป็นก้าวกระโดดครั้งสำคัญในการพัฒนาโมเดล AI:

- พารามิเตอร์ที่ปรับปรุง: Qwen2.5 ขยายตัวเป็นโมเดลที่มีพารามิเตอร์สูงสุดถึง 72 พันล้านพารามิเตอร์ ซึ่งนำเสนอโซลูชันที่ปรับขนาดได้สำหรับการใช้งานที่หลากหลาย

- การประมวลผลบริบทขยาย: เปิดตัวความสามารถในการประมวลผลโทเค็นได้สูงสุดถึง 128,000 โทเค็น ช่วยอำนวยความสะดวกในการจัดการเอกสารจำนวนมากและการสนทนาที่ซับซ้อน

- ความสามารถในการเขียนโค้ด: เวอร์ชัน Qwen2.5-Coder รองรับภาษาการเขียนโปรแกรมมากกว่า 92 ภาษา ช่วยในการสร้างโค้ด การดีบัก และงานการเพิ่มประสิทธิภาพ

ข้อดีของ Qwen2.5-Omni-7B

การบูรณาการหลายโหมดที่ครอบคลุม

Qwen2.5-Omni-7B มอบโซลูชัน AI แบบองค์รวมที่เหมาะกับการใช้งานที่หลากหลาย โดยการประมวลผลข้อความ รูปภาพ เสียง และวิดีโออย่างมีประสิทธิภาพ

การโต้ตอบแบบเรียลไทม์

การประมวลผลที่มีความหน่วงต่ำช่วยให้ตอบสนองได้ทันที ช่วยเพิ่มประสบการณ์ของผู้ใช้ในแอปพลิเคชันแบบโต้ตอบ

การเข้าถึงแบบโอเพ่นซอร์ส

เนื่องจากเป็นโมเดลโอเพนซอร์ส Qwen2.5-Omni-7B จึงส่งเสริมความโปร่งใส และอนุญาตให้นักพัฒนาปรับแต่งและรวมโมเดลนี้เข้ากับแพลตฟอร์มต่างๆ โดยไม่มีข้อจำกัดด้านกรรมสิทธิ์

ตัวชี้วัดทางเทคนิค

- พารามิเตอร์รุ่น: 7 พันล้าน

- วิธีการป้อนข้อมูล: ข้อความ รูปภาพ เสียง วีดิโอ

- โหมดเอาต์พุต: ข้อความ,คำพูด

- ความสามารถในการประมวลผล: การโต้ตอบด้วยคำพูดและวิดีโอแบบเรียลไทม์

- เกณฑ์มาตรฐานประสิทธิภาพ:

- ออมนิเบนช์: คะแนนเฉลี่ย 56.13%

- Librispeech (อัตราข้อผิดพลาดของคำ): ทดสอบความสะอาด: 1.8%, ทดสอบอื่นๆ: 3.4%

สถานการณ์แอ็พพลิเคชัน

ผู้ช่วยเสมือนแบบโต้ตอบ

การประมวลผลแบบเรียลไทม์และการเข้าใจหลายโหมดของ Qwen2.5-Omni-7B ช่วยให้เหมาะอย่างยิ่งสำหรับผู้ช่วยเสมือนที่สามารถมองเห็น ได้ยินและตอบสนองได้อย่างเป็นธรรมชาติ

การสร้างเนื้อหามัลติมีเดีย

ผู้สร้างเนื้อหาสามารถใช้ประโยชน์จากโมเดลนี้เพื่อสร้างเนื้อหามัลติมีเดียที่น่าสนใจ โดยผสมผสานข้อความ รูปภาพ และเสียงได้อย่างลงตัว

เทคโนโลยีสิ่งอำนวยความสะดวก

ความสามารถของโมเดลนี้สามารถช่วยเหลือบุคคลที่มีความพิการได้ เช่น การให้คำบรรยายเสียงสำหรับเนื้อหาภาพ

เคล็ดลับการใช้งาน

การเพิ่มประสิทธิภาพ

เพื่อให้ได้ประสิทธิภาพที่เหมาะสมที่สุด โดยเฉพาะในแอปพลิเคชันแบบเรียลไทม์ ขอแนะนำให้ใช้ตัวเร่งความเร็วฮาร์ดแวร์และตรวจสอบให้แน่ใจว่ามีหน่วยความจำ GPU เพียงพอ

บูรณาการกับระบบที่มีอยู่

นักพัฒนาควรพิจารณารูปแบบอินพุตและเอาต์พุตของโมเดลเมื่อรวมเข้ากับแอปพลิเคชันที่มีอยู่เพื่อให้แน่ใจถึงความเข้ากันได้และประสิทธิภาพสูงสุด

กำลังปรับปรุง

ตรวจสอบที่เก็บข้อมูลอย่างเป็นทางการและเอกสารประกอบเป็นประจำเพื่อดูการอัปเดตและแนวทางปฏิบัติที่ดีที่สุดเพื่อใช้ประโยชน์จากความสามารถของ Qwen2.5-Omni-7B อย่างเต็มที่

หัวข้อที่เกี่ยวข้อง วิธีการเรียกใช้โมเดล Qwen2.5-Omni-7B

สรุป

Qwen2.5-Omni-7B เป็นตัวอย่างของการบรรจบกันของการวิจัย AI ขั้นสูงและการประยุกต์ใช้ในทางปฏิบัติ โดยนำเสนอโซลูชันที่หลากหลายและมีประสิทธิภาพสำหรับงานต่างๆ มากมายในอุตสาหกรรมต่างๆ ลักษณะโอเพนซอร์สทำให้มั่นใจได้ว่าจะสามารถเข้าถึงและปรับเปลี่ยนได้ ช่วยปูทางไปสู่นวัตกรรมในอนาคตในด้าน AI หลายโหมด

วิธีการเรียกใช้ API Qwen2.5-Omni-7B จาก CometAPI

1.ล็อกอิน ไปยัง โคเมตาปิดอทคอม. หากคุณยังไม่ได้เป็นผู้ใช้ของเรา กรุณาลงทะเบียนก่อน

2.รับรหัส API ของข้อมูลรับรองการเข้าถึง ของอินเทอร์เฟซ คลิก "เพิ่มโทเค็น" ที่โทเค็น API ในศูนย์ส่วนบุคคล รับคีย์โทเค็น: sk-xxxxx และส่ง

-

รับ URL ของเว็บไซต์นี้: https://api.cometapi.com/

-

เลือกจุดสิ้นสุด Qwen2.5-Omni-7B เพื่อส่งคำขอ API และตั้งค่าเนื้อหาคำขอ วิธีการคำขอและเนื้อหาคำขอจะได้รับจาก เอกสาร API ของเว็บไซต์ของเราเว็บไซต์ของเรายังให้บริการทดสอบ Apifox เพื่อความสะดวกของคุณอีกด้วย

-

ประมวลผลการตอบสนองของ API เพื่อรับคำตอบที่สร้างขึ้น หลังจากส่งคำขอ API แล้ว คุณจะได้รับอ็อบเจ็กต์ JSON ที่มีคำตอบที่สร้างขึ้น