เมื่อวันที่ 19–20 พฤศจิกายน 2025 OpenAI ได้เปิดตัวการอัปเกรดที่เกี่ยวข้องแต่แตกต่างกันสองรายการ: GPT-5.1-โคเด็กซ์-แม็กซ์โมเดลการเข้ารหัสแบบเอเจนต์ใหม่สำหรับ Codex ที่เน้นการเข้ารหัสแบบขอบเขตยาว ประสิทธิภาพของโทเค็น และ "การบีบอัด" เพื่อรองรับเซสชันหลายหน้าต่าง และ จีพีที-5.1 โปรโมเดล ChatGPT ระดับ Pro-tier ที่ได้รับการปรับปรุงใหม่ ปรับแต่งเพื่อคำตอบที่ชัดเจนและมีประสิทธิภาพมากขึ้นในการทำงานที่ซับซ้อนและเป็นมืออาชีพ

GPT-5.1-Codex-Max คืออะไร และกำลังพยายามแก้ไขปัญหาอะไร?

GPT-5.1-Codex-Max เป็นโมเดล Codex เฉพาะทางจาก OpenAI ที่ได้รับการปรับแต่งสำหรับเวิร์กโฟลว์การเขียนโค้ดที่ต้องการ การใช้เหตุผลและการดำเนินการที่ยั่งยืนในระยะยาวในกรณีที่โมเดลทั่วไปอาจเกิดข้อผิดพลาดจากบริบทที่ยาวนานมาก เช่น การรีแฟกเตอร์ไฟล์หลายไฟล์ ลูปตัวแทนที่ซับซ้อน หรืองาน CI/CD ที่ต่อเนื่อง Codex-Max ได้รับการออกแบบมาเพื่อ บีบอัดและจัดการสถานะเซสชันโดยอัตโนมัติในหน้าต่างบริบทหลายหน้าต่างทำให้สามารถทำงานอย่างต่อเนื่องได้อย่างสอดคล้องกันในขณะที่โปรเจ็กต์เดียวครอบคลุมโทเค็นหลายพัน (หรือมากกว่า) OpenAI กำหนดให้ Codex-Max เป็นก้าวต่อไปในการสร้างเอเจนต์ที่สามารถเขียนโค้ดได้ให้เป็นประโยชน์อย่างแท้จริงสำหรับงานวิศวกรรมที่ขยายขอบเขต

GPT-5.1-Codex-Max คืออะไร และกำลังพยายามแก้ไขปัญหาอะไร?

GPT-5.1-Codex-Max เป็นโมเดล Codex เฉพาะทางจาก OpenAI ที่ได้รับการปรับแต่งสำหรับเวิร์กโฟลว์การเขียนโค้ดที่ต้องการ การใช้เหตุผลและการดำเนินการที่ยั่งยืนในระยะยาวในกรณีที่โมเดลทั่วไปอาจเกิดข้อผิดพลาดจากบริบทที่ยาวนานมาก เช่น การรีแฟกเตอร์ไฟล์หลายไฟล์ ลูปตัวแทนที่ซับซ้อน หรืองาน CI/CD ที่ต่อเนื่อง Codex-Max ได้รับการออกแบบมาเพื่อ บีบอัดและจัดการสถานะเซสชันโดยอัตโนมัติในหน้าต่างบริบทหลายหน้าต่างทำให้สามารถทำงานอย่างต่อเนื่องได้อย่างสอดคล้องกันในขณะที่โครงการเดียวครอบคลุมโทเค็นหลายพัน (หรือมากกว่า)

OpenAI อธิบายว่า "รวดเร็วกว่า ชาญฉลาดกว่า และใช้โทเค็นอย่างมีประสิทธิภาพมากขึ้นในทุกขั้นตอนของวงจรการพัฒนา" และมีวัตถุประสงค์อย่างชัดเจนเพื่อแทนที่ GPT-5.1-Codex เป็นโมเดลเริ่มต้นใน Codex surfaces

ภาพรวมคุณลักษณะ

- การบีบอัดเพื่อความต่อเนื่องของหลายหน้าต่าง: ตัดแต่งและรักษาบริบทที่สำคัญเพื่อให้ทำงานสอดคล้องกันในโทเค็นและชั่วโมงนับล้าน 0

- ปรับปรุงประสิทธิภาพโทเค็นเมื่อเปรียบเทียบกับ GPT-5.1-Codex: ลดจำนวนโทเค็นการคิดลงได้ถึง ~30% สำหรับความพยายามในการใช้เหตุผลที่คล้ายกันในการทดสอบโค้ดบางอย่าง

- ความทนทานของสารออกฤทธิ์ในระยะไกล: สังเกตภายในเพื่อรักษาการทำงานของตัวแทนแบบหลายชั่วโมง/หลายวัน (OpenAI ได้บันทึกการทำงานภายใน >24 ชั่วโมง)

- การบูรณาการแพลตฟอร์ม: พร้อมใช้งานแล้ววันนี้ใน Codex CLI, ส่วนขยาย IDE, คลาวด์ และเครื่องมือตรวจสอบโค้ด ส่วนการเข้าถึง API จะมีขึ้นเร็วๆ นี้

- การรองรับสภาพแวดล้อม Windows: OpenAI ระบุโดยเฉพาะว่า Windows ได้รับการสนับสนุนเป็นครั้งแรกในเวิร์กโฟลว์ของ Codex ซึ่งขยายการเข้าถึงนักพัฒนาในโลกแห่งความเป็นจริง

เมื่อเปรียบเทียบกับผลิตภัณฑ์คู่แข่ง (เช่น GitHub Copilot หรือ AI การเขียนโค้ดอื่นๆ) เป็นอย่างไร?

GPT-5.1-Codex-Max ถูกนำเสนอในฐานะเครื่องมือการทำงานร่วมกันแบบอิสระและครอบคลุมพื้นที่การทำงานมากกว่าเมื่อเทียบกับเครื่องมือการกรอกแบบต่อคำขอ แม้ว่า Copilot และผู้ช่วยที่คล้ายกันจะโดดเด่นในการกรอกแบบระยะสั้นภายในโปรแกรมแก้ไข แต่จุดแข็งของ Codex-Max อยู่ที่การจัดการงานหลายขั้นตอน การรักษาสถานะที่สอดคล้องกันในแต่ละเซสชัน และการจัดการเวิร์กโฟลว์ที่ต้องมีการวางแผน การทดสอบ และการวนซ้ำ อย่างไรก็ตาม แนวทางที่ดีที่สุดในทีมส่วนใหญ่จะเป็นแบบไฮบริด: ใช้ Codex-Max สำหรับการทำงานอัตโนมัติที่ซับซ้อนและงานเอเจนต์ที่ต่อเนื่อง และใช้ผู้ช่วยที่มีน้ำหนักเบากว่าสำหรับการกรอกแบบระดับบรรทัด

GPT-5.1-Codex-Max ทำงานอย่างไร?

“การบีบอัด” คืออะไร และช่วยให้ทำงานได้นานขึ้นได้อย่างไร

ความก้าวหน้าทางเทคนิคกลางคือ การบดอัด—กลไกภายในที่ตัดประวัติเซสชันในขณะที่รักษาส่วนสำคัญของบริบทไว้เพื่อให้โมเดลสามารถดำเนินงานที่สอดคล้องกันต่อไปได้ หลาย หน้าต่างบริบท ในทางปฏิบัติ หมายความว่าเซสชัน Codex ที่ใกล้ถึงขีดจำกัดบริบทจะถูกบีบอัด (โทเค็นที่เก่ากว่าหรือมีมูลค่าต่ำกว่าจะถูกสรุป/เก็บรักษาไว้) เพื่อให้เอเจนต์มีหน้าต่างใหม่และสามารถทำซ้ำได้เรื่อยๆ จนกว่างานจะเสร็จสมบูรณ์ OpenAI รายงานการทำงานภายในที่โมเดลทำงานกับงานอย่างต่อเนื่องนานกว่า 24 ชั่วโมง

การใช้เหตุผลแบบปรับตัวและประสิทธิภาพของโทเค็น

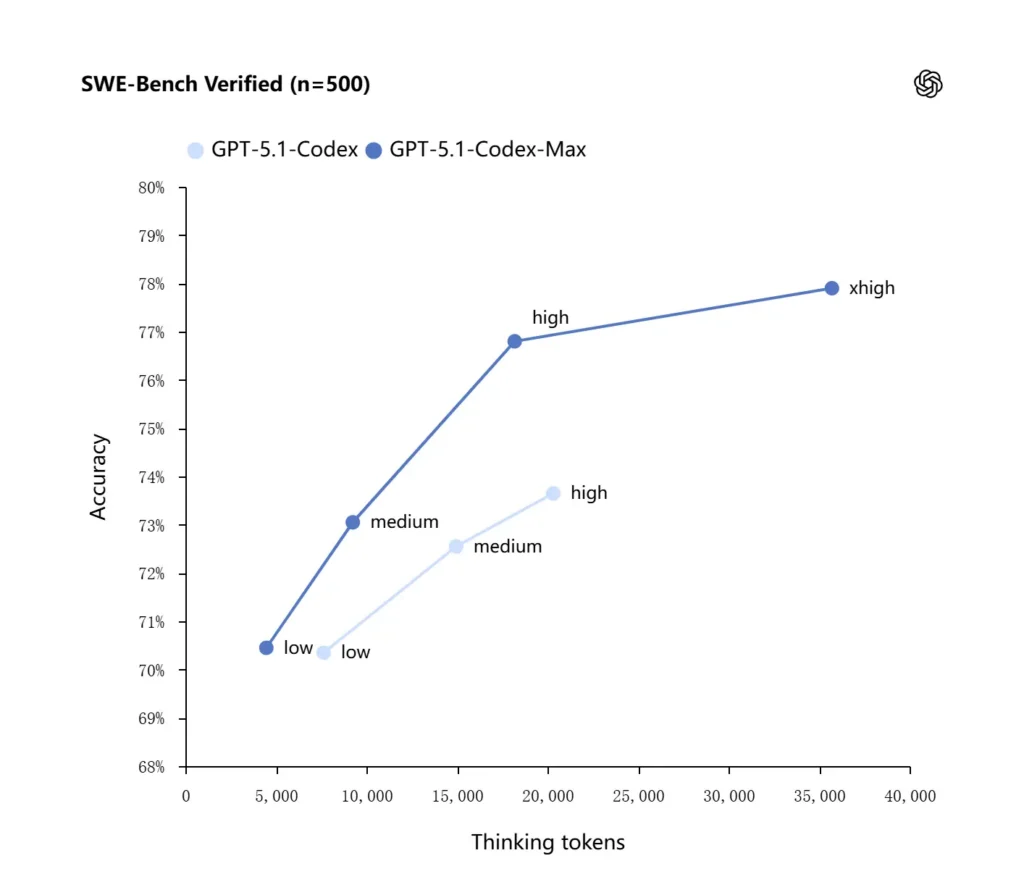

GPT-5.1-Codex-Max ใช้กลยุทธ์การใช้เหตุผลที่ได้รับการปรับปรุงเพื่อให้มีประสิทธิภาพการใช้โทเค็นมากขึ้น: ในรายงานประสิทธิภาพภายในของ OpenAI โมเดล Max บรรลุประสิทธิภาพที่ใกล้เคียงหรือดีกว่า GPT-5.1-Codex ในขณะที่ใช้โทเค็น "การคิด" น้อยกว่าอย่างมีนัยสำคัญ - OpenAI อ้างอิงโดยประมาณ น้อยลง 30% โทเค็นการคิดบน SWE-bench ได้รับการยืนยันเมื่อทำงานด้วยความพยายามในการใช้เหตุผลเท่ากัน แบบจำลองนี้ยังนำเสนอโหมดความพยายามในการใช้เหตุผล “Extra High (xhigh)” สำหรับงานที่ไม่ไวต่อความล่าช้า ซึ่งช่วยให้สามารถใช้เหตุผลภายในได้มากขึ้นเพื่อให้ได้ผลลัพธ์ที่มีคุณภาพสูงขึ้น

การบูรณาการระบบและเครื่องมือตัวแทน

Codex-Max กำลังถูกเผยแพร่ภายในเวิร์กโฟลว์ Codex (CLI, ส่วนขยาย IDE, คลาวด์ และส่วนตรวจสอบโค้ด) เพื่อให้สามารถโต้ตอบกับชุดเครื่องมือของนักพัฒนาได้จริง การผสานรวมในระยะแรกประกอบด้วย Codex CLI และเอเจนต์ IDE (VS Code, JetBrains และอื่นๆ) และมีแผนที่จะเข้าถึง API ตามมา เป้าหมายการออกแบบไม่เพียงแต่เป็นการสังเคราะห์โค้ดที่ชาญฉลาดยิ่งขึ้นเท่านั้น แต่ยังเป็น AI ที่สามารถรันเวิร์กโฟลว์แบบหลายขั้นตอน ได้แก่ เปิดไฟล์ รันการทดสอบ แก้ไขข้อผิดพลาด รีแฟกเตอร์ และรันซ้ำอีกครั้ง

GPT-5.1-Codex-Max มีประสิทธิภาพเพียงใดในการทดสอบประสิทธิภาพและการทำงานจริง?

การใช้เหตุผลอย่างต่อเนื่องและภารกิจระยะยาว

การประเมินชี้ให้เห็นถึงการปรับปรุงที่วัดได้ในเหตุผลอย่างต่อเนื่องและงานระยะยาว:

- การประเมินภายในของ OpenAICodex-Max สามารถทำงานกับงานต่างๆ ได้ "นานกว่า 24 ชั่วโมง" ในการทดลองภายใน และการรวม Codex เข้ากับเครื่องมือของนักพัฒนาช่วยเพิ่มตัวชี้วัดประสิทธิภาพการทำงานด้านวิศวกรรมภายใน (เช่น การใช้งานและปริมาณงานจากคำขอ Pull Request) สิ่งเหล่านี้เป็นข้ออ้างภายในของ OpenAI และบ่งชี้ถึงการปรับปรุงประสิทธิภาพการทำงานจริงในระดับงาน

- การประเมินอิสระ (METR):รายงานอิสระของ METR วัด สังเกตช่วงเวลา 50% (สถิติที่แสดงเวลาเฉลี่ยที่โมเดลสามารถรักษาการทำงานที่ยาวนานได้อย่างสอดคล้องกัน) สำหรับ GPT-5.1-Codex-Max ที่ประมาณ 2 ชั่วโมง 40 นาที (โดยมีช่วงความเชื่อมั่นกว้าง) เพิ่มขึ้นจาก 2 ชั่วโมง 17 นาทีของ GPT-5 ในการวัดที่เปรียบเทียบได้ ซึ่งถือเป็นการปรับปรุงแนวโน้มที่สำคัญในด้านความสอดคล้องอย่างยั่งยืน วิธีการและ CI ของ METR เน้นย้ำถึงความแปรปรวน แต่ผลลัพธ์สนับสนุนแนวคิดที่ว่า Codex-Max ช่วยปรับปรุงประสิทธิภาพการทำงานในระยะไกลในทางปฏิบัติ

เกณฑ์มาตรฐานโค้ด

OpenAI รายงานผลลัพธ์ที่ดีขึ้นในการประเมินโค้ดแนวหน้า โดยเฉพาะอย่างยิ่ง SWE-bench Verified ซึ่ง GPT-5.1-Codex-Max มีประสิทธิภาพเหนือกว่า GPT-5.1-Codex ด้วยประสิทธิภาพโทเค็นที่ดีกว่า บริษัทเน้นย้ำว่าเมื่อใช้ความพยายามในการหาเหตุผลระดับ "ปานกลาง" เท่ากัน โมเดล Max ให้ผลลัพธ์ที่ดีกว่า ในขณะที่ใช้โทเค็นการคิดน้อยลงประมาณ 30% สำหรับผู้ใช้ที่อนุญาตให้ใช้เหตุผลภายในนานกว่า โหมด xhigh สามารถเพิ่มระดับคำตอบได้มากขึ้นโดยแลกกับความหน่วงแฝง

| GPT‑5.1-Codex (สูง) | GPT‑5.1-Codex-Max (สูง) | |

| SWE-bench ได้รับการยืนยัน (n=500) | 73.7% | 77.9% |

| SWE-แลนเซอร์ IC SWE | 66.3% | 79.9% |

| เทอร์มินัล-เบ็นช์ 2.0 | 52.8% | 58.1% |

GPT-5.1-Codex-Max เปรียบเทียบกับ GPT-5.1-Codex ได้อย่างไร?

ความแตกต่างด้านประสิทธิภาพและวัตถุประสงค์

- ขอบเขต: GPT-5.1-Codex เป็นตัวแปรการเข้ารหัสประสิทธิภาพสูงของตระกูล GPT-5.1 โคเด็กซ์-แม็กซ์ เป็นตัวแทนโดยชัดเจนที่สืบทอดมาในขอบเขตระยะยาว ซึ่งตั้งใจให้เป็นค่าเริ่มต้นที่แนะนำสำหรับ Codex และสภาพแวดล้อมที่คล้ายกับ Codex

- ประสิทธิภาพโทเค็น: Codex-Max แสดงให้เห็นถึงประสิทธิภาพโทเค็นที่เพิ่มขึ้น (OpenAI อ้างว่าโทเค็นที่คิดได้น้อยลงประมาณ 30%) บน SWE-bench และในการใช้งานภายใน

- การจัดการบริบท: Codex-Max นำเสนอการบีบอัดและการจัดการหลายหน้าต่างดั้งเดิมเพื่อรองรับงานที่เกินหน้าต่างบริบทเดียว Codex ไม่ได้ให้ความสามารถนี้ในระดับเดียวกันโดยธรรมชาติ

- ความพร้อมของเครื่องมือ: Codex-Max จัดส่งเป็นโมเดล Codex เริ่มต้นทั่วทั้ง CLI, IDE และพื้นผิวการตรวจสอบโค้ด ซึ่งเป็นสัญญาณของการไมเกรชันสำหรับเวิร์กโฟลว์ของนักพัฒนาการผลิต

เมื่อใดควรใช้รุ่นไหน?

- ใช้ GPT-5.1-Codex สำหรับความช่วยเหลือในการเขียนโค้ดแบบโต้ตอบ การแก้ไขอย่างรวดเร็ว การรีแฟกเตอร์เล็กน้อย และกรณีการใช้งานที่มีความล่าช้าต่ำ โดยที่บริบทที่เกี่ยวข้องทั้งหมดสามารถใส่ไว้ในหน้าต่างเดียวได้อย่างง่ายดาย

- ใช้ GPT-5.1-Codex-Max สำหรับการรีแฟกเตอร์ไฟล์หลายไฟล์ งานตัวแทนอัตโนมัติที่ต้องใช้รอบการวนซ้ำหลายรอบ เวิร์กโฟลว์แบบ CI/CD หรือเมื่อคุณต้องการให้โมเดลถือมุมมองระดับโครงการข้ามการโต้ตอบต่างๆ มากมาย

รูปแบบคำเตือนเชิงปฏิบัติและตัวอย่างเพื่อผลลัพธ์ที่ดีที่สุด?

รูปแบบการกระตุ้นที่ได้ผลดี

- ระบุเป้าหมายและข้อจำกัดอย่างชัดเจน: “รีแฟกเตอร์ X, รักษา API สาธารณะ, เก็บชื่อฟังก์ชัน และให้แน่ใจว่าการทดสอบ A, B, C ผ่าน”

- ให้บริบทที่สามารถทำซ้ำได้ขั้นต่ำ: ลิงก์ไปยังการทดสอบที่ล้มเหลว รวมถึงการติดตามสแต็ก และตัวอย่างไฟล์ที่เกี่ยวข้อง แทนที่จะทิ้งทั้งคลัง Codex-Max จะบีบอัดประวัติตามความจำเป็น

- ใช้คำแนะนำแบบขั้นตอนสำหรับงานที่ซับซ้อน: แบ่งงานขนาดใหญ่เป็นลำดับของงานย่อย และให้ Codex-Max ดำเนินการวนซ้ำผ่านงานเหล่านั้น (เช่น "1) รันการทดสอบ 2) แก้ไขการทดสอบ 3 อันดับแรกที่ล้มเหลว 3) รันลินเตอร์ 4) สรุปการเปลี่ยนแปลง")

- ขอคำอธิบายและความแตกต่าง: ขอทั้งแพตช์และเหตุผลสั้นๆ เพื่อให้ผู้ตรวจสอบสามารถประเมินความปลอดภัยและเจตนาได้อย่างรวดเร็ว

ตัวอย่างเทมเพลตคำเตือน

งานรีแฟกเตอร์

“รีแฟกเตอร์

payment/โมดูลสำหรับแยกการประมวลผลการชำระเงินลงในpayment/processor.pyรักษาลายเซ็นฟังก์ชันสาธารณะให้มีเสถียรภาพสำหรับผู้เรียกใช้งานที่มีอยู่ สร้างการทดสอบยูนิตสำหรับprocess_payment()ที่ครอบคลุมความสำเร็จ ความล้มเหลวของเครือข่าย และการ์ดที่ไม่ถูกต้อง รันชุดทดสอบและส่งกลับผลการทดสอบที่ล้มเหลวและแพตช์ในรูปแบบ unified diff

แก้ไขจุดบกพร่อง + ทดสอบ

“การทดสอบ

tests/test_user_auth.py::test_token_refreshล้มเหลวด้วย traceback ตรวจสอบสาเหตุที่แท้จริง เสนอวิธีแก้ไขโดยเปลี่ยนแปลงน้อยที่สุด และเพิ่มการทดสอบยูนิตเพื่อป้องกันการถดถอย ลองใช้แพตช์และรันการทดสอบ

การสร้าง PR แบบวนซ้ำ

“นำฟีเจอร์ X มาใช้: เพิ่มจุดสิ้นสุด

POST /api/exportซึ่งสตรีมจะส่งออกผลลัพธ์และได้รับการรับรองความถูกต้อง สร้างจุดสิ้นสุด เพิ่มเอกสาร สร้างการทดสอบ และเปิด PR พร้อมสรุปและรายการตรวจสอบของรายการด้วยตนเอง

สำหรับสิ่งเหล่านี้ส่วนใหญ่ ให้เริ่มต้นด้วย กลาง ความพยายาม; เปลี่ยนไป สูง เมื่อคุณต้องการให้โมเดลทำการวิเคราะห์เชิงลึกกับไฟล์จำนวนมากและทดสอบซ้ำหลายครั้ง

คุณเข้าถึง GPT-5.1-Codex-Max ได้อย่างไร

มีจำหน่ายที่ไหนในปัจจุบัน

OpenAI ได้รวม GPT-5.1-Codex-Max เข้าไว้ เครื่องมือ Codex วันนี้: Codex CLI, ส่วนขยาย IDE, คลาวด์ และโฟลว์การตรวจสอบโค้ดใช้ Codex-Max ตามค่าเริ่มต้น (คุณสามารถเลือกใช้ Codex-Mini ได้) ต้องเตรียมพร้อมสำหรับ API ให้พร้อมใช้งาน GitHub Copilot มีรุ่นตัวอย่างสาธารณะที่รวมถึงโมเดลซีรีส์ GPT-5.1 และ Codex

นักพัฒนาสามารถเข้าถึง GPT-5.1-Codex-Max และ API GPT-5.1-โคเด็กซ์ ผ่าน CometAPI เริ่มต้นด้วยการสำรวจความสามารถของโมเดลโคเมทเอพีไอ ที่ สนามเด็กเล่น และดูคำแนะนำโดยละเอียดในคู่มือ API ก่อนเข้าใช้งาน โปรดตรวจสอบให้แน่ใจว่าคุณได้เข้าสู่ระบบ CometAPI และได้รับรหัส API แล้ว ด้วยetAPI เสนอราคาที่ต่ำกว่าราคาอย่างเป็นทางการมากเพื่อช่วยคุณบูรณาการ

พร้อมไปหรือยัง?→ ลงทะเบียน CometAPI วันนี้ !

หากคุณต้องการทราบเคล็ดลับ คำแนะนำ และข่าวสารเกี่ยวกับ AI เพิ่มเติม โปรดติดตามเราที่ VK, X และ ไม่ลงรอยกัน!

การเริ่มต้นอย่างรวดเร็ว (ขั้นตอนปฏิบัติทีละขั้นตอน)

- ตรวจสอบให้แน่ใจว่าคุณสามารถเข้าถึงได้: ยืนยันแผนผลิตภัณฑ์ ChatGPT/Codex ของคุณ (Plus, Pro, Business, Edu, Enterprise) หรือแผน API สำหรับนักพัฒนาของคุณรองรับโมเดลตระกูล GPT-5.1/Codex

- ติดตั้งส่วนขยาย Codex CLI หรือ IDE: หากคุณต้องการรันโค้ดในเครื่อง ให้ติดตั้ง Codex CLI หรือส่วนขยาย Codex IDE สำหรับ VS Code / JetBrains / Xcode ตามความเหมาะสม เครื่องมือจะตั้งค่าเริ่มต้นเป็น GPT-5.1-Codex-Max ในการตั้งค่าที่รองรับ

- เลือกความพยายามในการใช้เหตุผล: เริ่มกับ กลาง ความพยายามสำหรับงานส่วนใหญ่ สำหรับการดีบักเชิงลึก การรีแฟกเตอร์ที่ซับซ้อน หรือเมื่อคุณต้องการให้โมเดลคิดหนักขึ้นและคุณไม่สนใจความล่าช้าในการตอบสนอง ให้เปลี่ยนไปใช้ สูง or สูง โหมด สำหรับการแก้ไขเล็กๆ น้อยๆ อย่างรวดเร็ว ต่ำ มีความสมเหตุสมผล

- ให้บริบทที่เก็บข้อมูล: กำหนดจุดเริ่มต้นที่ชัดเจนให้กับโมเดล — URL ของที่เก็บหรือชุดไฟล์และคำสั่งสั้นๆ (เช่น "ปรับโครงสร้างโมดูลการชำระเงินให้ใช้ I/O แบบอะซิงโครนัสและเพิ่มการทดสอบยูนิต เก็บสัญญาระดับฟังก์ชัน") Codex-Max จะบีบอัดประวัติเมื่อใกล้ถึงขีดจำกัดบริบทและดำเนินงานต่อ

- ทำซ้ำด้วยการทดสอบ: หลังจากที่โมเดลสร้างแพตช์แล้ว ให้รันชุดทดสอบและป้อนกลับข้อผิดพลาดเป็นส่วนหนึ่งของเซสชันที่กำลังดำเนินอยู่ การบีบอัดข้อมูลและความต่อเนื่องของหลายหน้าต่างช่วยให้ Codex-Max สามารถรักษาบริบทการทดสอบที่ล้มเหลวที่สำคัญและทำซ้ำได้

สรุป:

GPT-5.1-Codex-Max ถือเป็นก้าวสำคัญสู่ผู้ช่วยเขียนโค้ดแบบเอเจนต์ ที่สามารถสนับสนุนงานวิศวกรรมที่ซับซ้อนและใช้เวลานานได้อย่างมีประสิทธิภาพและการใช้เหตุผลที่ดีขึ้น ความก้าวหน้าทางเทคนิค (การบีบอัดข้อมูล โหมดความพยายามในการใช้เหตุผล การฝึกอบรมสภาพแวดล้อม Windows) ทำให้โมเดลนี้เหมาะสมอย่างยิ่งสำหรับองค์กรวิศวกรรมสมัยใหม่ หากทีมต่างๆ จับคู่โมเดลนี้เข้ากับการควบคุมการปฏิบัติงานแบบอนุรักษ์นิยม นโยบายที่เชื่อมโยงมนุษย์กับวงจรชีวิตที่ชัดเจน และการตรวจสอบที่รัดกุม สำหรับทีมที่ปรับใช้โมเดลนี้ด้วยความระมัดระวัง Codex-Max มีศักยภาพที่จะเปลี่ยนแปลงวิธีการออกแบบ ทดสอบ และบำรุงรักษาซอฟต์แวร์ เปลี่ยนงานวิศวกรรมที่ซ้ำซากจำเจให้กลายเป็นความร่วมมือที่มีคุณค่ายิ่งขึ้นระหว่างมนุษย์และโมเดล