Kimi K2 ถือเป็นก้าวสำคัญในโมเดลภาษาโอเพนซอร์สขนาดใหญ่ โดยผสานสถาปัตยกรรมแบบผสมผสานของผู้เชี่ยวชาญที่ทันสมัยเข้ากับการฝึกอบรมเฉพาะทางสำหรับงานแบบเอเจนต์ ด้านล่างนี้ เราจะสำรวจต้นกำเนิด การออกแบบ ประสิทธิภาพ และข้อควรพิจารณาเชิงปฏิบัติสำหรับการเข้าถึงและการใช้งาน

Kimi K2 คืออะไร?

Kimi K2 คือแบบจำลองภาษาแบบผสมผู้เชี่ยวชาญ (MoE) ที่มีพารามิเตอร์หลายล้านล้านตัวที่พัฒนาโดย Moonshot AI แบบจำลองนี้ประกอบด้วยพารามิเตอร์ที่ "เปิดใช้งาน" แล้ว 32 พันล้านตัว ซึ่งแต่ละตัวทำงานต่อโทเค็น และจำนวนพารามิเตอร์ผู้เชี่ยวชาญทั้งหมด 1 ล้านล้านตัว ทำให้มีขีดความสามารถมหาศาลโดยไม่ต้องเสียค่าใช้จ่ายในการอนุมานเชิงเส้น Kimi K2 สร้างขึ้นบน Muon optimizer และได้รับการฝึกฝนด้วยโทเค็นมากกว่า 15.5 ล้านล้านตัว ทำให้มีเสถียรภาพในระดับที่ก่อนหน้านี้ถือว่าไม่สามารถใช้งานได้จริง แบบจำลองนี้มีให้เลือกสองรูปแบบหลัก:

Kimi‑K2‑สั่งสอน: ปรับแต่งไว้ล่วงหน้าสำหรับแอปพลิเคชันเชิงสนทนาและเชิงตัวแทน พร้อมสำหรับการใช้งานทันทีในระบบสนทนาและเวิร์กโฟลว์ที่เปิดใช้งานเครื่องมือ

Kimi‑K2‑ฐาน: แบบจำลองพื้นฐานที่เหมาะสำหรับการวิจัย การปรับแต่งแบบกำหนดเอง และการทดลองระดับต่ำ

สถาปัตยกรรมของมันทำงานอย่างไร?

- ผู้เชี่ยวชาญหลากหลายสาขา (MoE): ในแต่ละชั้น กลไกการเกตจะเลือกผู้เชี่ยวชาญกลุ่มย่อยจำนวนเล็กน้อย (8 คนจากทั้งหมด 384 คน) เพื่อประมวลผลโทเค็นแต่ละตัว ซึ่งจะช่วยลดการประมวลผลเพื่อการอนุมานลงอย่างมาก ในขณะที่ยังคงรักษาฐานความรู้จำนวนมหาศาลไว้

- ชั้นเฉพาะ: ประกอบด้วยชั้นหนาแน่นชั้นเดียวควบคู่ไปกับชั้นทั้งหมด 61 ชั้น โดยมีหัวความสนใจจำนวน 64 หัวและมิติที่ซ่อนอยู่ซึ่งปรับแต่งสำหรับประสิทธิภาพของ MoE

- บริบทและคำศัพท์: รองรับโทเค็นสูงสุด 128 K ในความยาวบริบทและคำศัพท์โทเค็น K 160 รายการ ช่วยให้เข้าใจและสร้างรูปแบบยาวได้

ทำไม Kimi K2 ถึงสำคัญ?

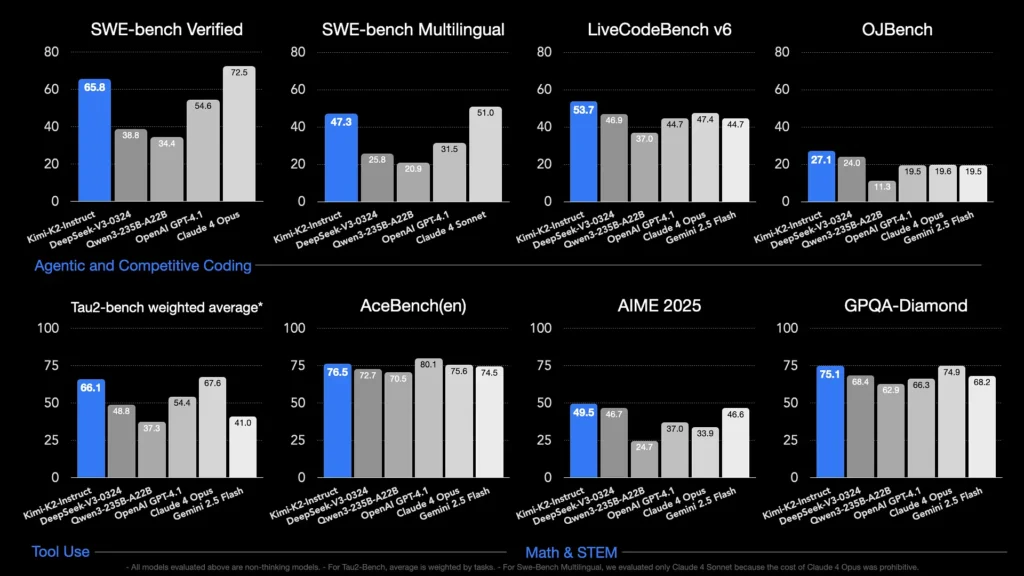

Kimi K2 ขยายขอบเขตของ AI โอเพ่นซอร์สด้วยการมอบประสิทธิภาพที่ทัดเทียมกับโมเดลกรรมสิทธิ์ชั้นนำ โดยเฉพาะอย่างยิ่งในการเข้ารหัสและการเปรียบเทียบประสิทธิภาพการใช้เหตุผล

เกณฑ์มาตรฐานใดบ้างที่แสดงให้เห็นถึงศักยภาพของมัน?

- LiveCodeBench v6: มีอัตราการผ่าน 1 ครั้งอยู่ที่ 53.7% เป็นผู้นำโมเดลโอเพ่นซอร์สและแข่งขันกับระบบปิดอย่าง GPT‑4.1 (44.7%)

- SWE‑bench ได้รับการยืนยัน: ทำคะแนนได้ 65.8% เหนือกว่า GPT‑4.1 ที่ได้ 54.6% และเป็นรองเพียง Claude Sonnet 4 ในการทดสอบเปรียบเทียบที่เปิดเผยต่อสาธารณะ

- MultiPL‑E และ OJBench: แสดงให้เห็นถึงความสามารถในการเขียนโค้ดหลายภาษาที่แข็งแกร่ง (85.7% บน MultiPL‑E) และประสิทธิภาพที่เชื่อถือได้ท่ามกลางความท้าทายด้านการเขียนโปรแกรมในโลกแห่งความเป็นจริง

- คณิตศาสตร์-500:บรรลุคะแนน 97.4% แซงหน้า GPT-4.1 ที่ได้ 92.4% แสดงให้เห็นถึงความสามารถด้านการใช้เหตุผลทางคณิตศาสตร์อย่างเป็นทางการ

มีการปรับให้เหมาะสมกับงานของตัวแทนอย่างไร?

นอกเหนือจากการสร้างข้อมูลดิบแล้ว Kimi K2 ยังได้รับการฝึกฝนด้วยสถานการณ์จำลองการใช้งานเครื่องมือสังเคราะห์ ซึ่งก็คือข้อมูล Model Context Protocol (MCP) เพื่อเรียกใช้เครื่องมือภายนอก วิเคราะห์กระบวนการหลายขั้นตอน และแก้ไขปัญหาโดยอัตโนมัติ ซึ่งทำให้ Kimi KXNUMX มีความสามารถพิเศษในสภาพแวดล้อมอย่าง Cline ที่สามารถจัดการการทำงานของโค้ด การโต้ตอบกับ API และการทำงานอัตโนมัติของเวิร์กโฟลว์ได้อย่างราบรื่น

ฉันจะเข้าถึง Kimi K2 ได้อย่างไร?

ตัวเลือกการเข้าถึงครอบคลุมแพลตฟอร์มอย่างเป็นทางการ การแจกจ่ายโอเพ่นซอร์ส และการผสานรวมกับบุคคลที่สาม ตอบโจทย์การวิจัย การพัฒนา และความต้องการขององค์กร

แพลตฟอร์ม AI Moonshot อย่างเป็นทางการ

Moonshot AI นำเสนอการอนุมานแบบโฮสต์ผ่านแพลตฟอร์ม ซึ่งมอบการเข้าถึง API ที่มีความหน่วงต่ำสำหรับทั้ง Kimi‑K2‑Base และ Kimi‑K2‑Instruct ราคาจะแบ่งตามระดับการใช้งานการประมวลผล โดยแพ็กเกจสำหรับองค์กรจะรวมการสนับสนุนตามลำดับความสำคัญและการใช้งานแบบ on-prem ผู้ใช้สามารถลงทะเบียนได้ที่เว็บไซต์ Moonshot AI และดึงคีย์ API สำหรับการผสานรวมทันที

โคเมทเอพีไอ

CometAPI ได้ผสานรวม K2 เข้ากับบริการต่างๆ แล้ว โดยผสานรวมการอนุมาน K2 เข้ากับโครงสร้างพื้นฐาน GPU ที่ได้รับการจัดการ การรับประกัน SLA และระดับราคาที่ปรับขนาดได้ ช่วยให้องค์กรต่างๆ สามารถเลือกระหว่างการใช้งาน API แบบจ่ายตามการใช้งานจริง หรือความจุสำรองพร้อมส่วนลดตามปริมาณการใช้งาน

CometAPI เป็นแพลตฟอร์ม API แบบรวมที่รวบรวมโมเดล AI มากกว่า 500 โมเดลจากผู้ให้บริการชั้นนำ เช่น ซีรีส์ GPT ของ OpenAI, Gemini ของ Google, Claude ของ Anthropic, Midjourney, Suno และอื่นๆ ไว้ในอินเทอร์เฟซเดียวที่เป็นมิตรกับนักพัฒนา ด้วยการนำเสนอการตรวจสอบสิทธิ์ การจัดรูปแบบคำขอ และการจัดการการตอบสนองที่สอดคล้องกัน CometAPI จึงทำให้การรวมความสามารถของ AI เข้ากับแอปพลิเคชันของคุณง่ายขึ้นอย่างมาก

นักพัฒนาสามารถเข้าถึงได้ คิมิ เค2 เอพีไอ(kimi-k2-0711-preview)ผ่าน โคเมทเอพีไอเริ่มต้นด้วยการสำรวจความสามารถของโมเดลใน สนามเด็กเล่น และปรึกษา คู่มือ APIสำหรับคำแนะนำโดยละเอียด ก่อนเข้าใช้งาน โปรดตรวจสอบให้แน่ใจว่าคุณได้เข้าสู่ระบบ CometAPI และได้รับรหัส API แล้ว

การผสานรวมเครื่องมือของบุคคลที่สาม

- ไคลน์: IDE ที่เน้นโค้ดยอดนิยมที่รองรับ Kimi K2 โดยตรงผ่านทาง

cline:moonshotai/kimi-k2ผู้ให้บริการที่ให้ผู้พัฒนาเข้าถึงการแชท การสร้างโค้ด และเวิร์กโฟลว์ของตัวแทนภายในตัวแก้ไขของพวกเขาได้ด้วยการคลิกเพียงครั้งเดียว - พื้นที่ใบหน้ากอด: เดโมที่โฮสต์โดยชุมชนและ UI ขั้นต่ำช่วยให้ผู้ใช้สามารถโต้ตอบกับโมเดล K2-Instruct ได้โดยตรงในเบราว์เซอร์ จำเป็นต้องมีบัญชี Hugging Face และประสิทธิภาพอาจแตกต่างกันไปตามทรัพยากรแบ็กเอนด์ที่ใช้ร่วมกัน

ฉันจะใช้ Kimi K2 ได้อย่างไร?

เมื่อคุณเลือกวิธีการเข้าถึงแล้ว คุณสามารถใช้ K2 สำหรับงานต่างๆ ได้หลากหลาย ตั้งแต่การแชท การดำเนินการโค้ด ไปจนถึงตัวแทนอัตโนมัติ

ผ่านทาง API หรือ SDK ของแพลตฟอร์ม

- ตรวจสอบสิทธิ์: ดึงรหัส API ของคุณจาก Moonshot AI หรือ CometAPI

- เริ่มต้นไคลเอนต์: ใช้ SDK อย่างเป็นทางการ (Python/JavaScript) หรือคำขอ HTTP มาตรฐาน

- เลือกรุ่นตัวแปร:

- คิมิ-เค2-เบส เพื่อการปรับแต่งและการวิจัย

- คิมิ-เค2-อินสตัดท์ สำหรับการแชทและตัวแทนแบบ plug-and-play

- แบบจำลองของ CometAPI:

kimi-k2-0711-preview

- ส่งคำเตือน: จัดรูปแบบอินพุตตามเทมเพลตการแชท (ระบบ ผู้ใช้ บทบาทผู้ช่วย) เพื่อใช้ประโยชน์จากพฤติกรรมการปฏิบัติตามคำแนะนำที่ได้รับการปรับให้เหมาะสม

ทำงานในเครื่องด้วย llama.cpp

สำหรับการตั้งค่าแบบออฟไลน์หรือโฮสต์ด้วยตนเอง ให้ใช้ค่า GGUF ที่ถูกวัดปริมาณแบบ Unsloth (245 GB สำหรับควอนต์แบบไดนามิก 1.8 บิต)

- ดาวน์โหลดน้ำหนัก: จาก GitHub หรือที่เก็บข้อมูล Hugging Face ของ Moonshot AI

- ติดตั้ง llama.cpp: ตรวจสอบให้แน่ใจว่าคุณมีดิสก์เพียงพอ (≥ 250 GB) และ RAM+VRAM รวม (≥ 250 GB) สำหรับปริมาณข้อมูลประมาณ 5 โทเค็นต่อวินาที

- รุ่นเปิดตัว:

./main --model kimi-k2-gguf.q8_0 --prompt "Your prompt here" - ปรับการตั้งค่า: ใช้พารามิเตอร์ที่แนะนำ (

rope_freq_base,context_len) ได้รับการบันทึกไว้ในคู่มือ Unsloth เพื่อประสิทธิภาพที่เสถียร

การบูรณาการกับเครื่องมือการพัฒนา

- ปลั๊กอิน IDE: ปลั๊กอินชุมชนหลายตัวเปิดใช้งาน K2 ใน VS Code, Neovim และ JetBrains IDE โดยทั่วไปการกำหนดค่าจะเกี่ยวข้องกับการระบุจุดสิ้นสุด API และรหัสโมเดลในการตั้งค่า

- กรอบการทำงานอัตโนมัติ: ใช้ประโยชน์จากแกนกลางของเอเจนต์ของ K2 ด้วยเฟรมเวิร์กเช่น LangChain หรือ Haystack เพื่อเชื่อมโยงคำเตือน การเรียก API และขั้นตอนการดำเนินโค้ดเข้ากับระบบอัตโนมัติที่ซับซ้อน

กรณีการใช้งานทั่วไปของ Kimi K2 มีอะไรบ้าง?

การผสมผสานระหว่างขนาด การฝึกอบรมตัวแทน และการเข้าถึงแบบเปิดของ K2 ทำให้มีความยืดหยุ่นในทุกโดเมน

ความช่วยเหลือด้านการเข้ารหัส

ตั้งแต่การสร้างและการรีแฟกเตอร์สำเร็จรูปไปจนถึงการแก้ไขจุดบกพร่องและการสร้างโปรไฟล์ประสิทธิภาพ เกณฑ์มาตรฐานการเขียนโค้ด SOTA ของ K2 จะแปลงเป็นผลกำไรด้านประสิทธิภาพในโลกแห่งความเป็นจริง โดยมักจะเหนือกว่าทางเลือกอื่นๆ ในด้านการอ่านและความเรียบง่าย

ความรู้และการให้เหตุผล

ด้วยความยาวบริบท 128 กิโลไบต์ K2 จึงสามารถจัดการเอกสารยาวๆ คำถามและคำตอบหลายเอกสาร และการใช้เหตุผลแบบห่วงโซ่ความคิด สถาปัตยกรรม MoE ช่วยให้มั่นใจได้ถึงการเก็บรักษาความรู้ที่หลากหลายโดยไม่เกิดการลืมเลือนอย่างร้ายแรง

เวิร์กโฟลว์ของตัวแทน

K2 โดดเด่นในการจัดการงานหลายขั้นตอน เช่น การดึงข้อมูล การเรียกใช้ API การอัปเดตฐานโค้ด และการสรุปผลลัพธ์ ทำให้เหมาะอย่างยิ่งสำหรับผู้ช่วยเหลืออัตโนมัติในการสนับสนุนลูกค้า การวิเคราะห์ข้อมูล และ DevOps

Kimi K2 เปรียบเทียบกับรุ่นโอเพ่นซอร์สอื่น ๆ ได้อย่างไร?

ในขณะที่การเปิดตัว V3 ของ DeepSeek และ Meta ล่าสุดครองหัวข้อข่าวในช่วงต้นปี 2025 Kimi K2 ได้สร้างความแตกต่างให้กับตัวเองด้วย:

สติปัญญาของตัวแทน

Kimi K2 ได้รับการออกแบบมาโดยเฉพาะสำหรับเวิร์กโฟลว์แบบ "ตัวแทน" ซึ่งทำงานอัตโนมัติผ่านการเรียกใช้เครื่องมือ คำสั่งเชลล์ การทำงานอัตโนมัติบนเว็บ และการผสานรวม API ชุดข้อมูลการฝึกเสริมที่เล่นเองได้ประกอบด้วยตัวอย่างการเรียกใช้เครื่องมือที่หลากหลาย ช่วยให้สามารถผสานรวมกับระบบจริงได้อย่างราบรื่น

ประสิทธิภาพต้นทุน

ด้วยต้นทุนการอนุมานต่อโทเค็นที่ต่ำกว่าประมาณ 80–90% เมื่อเทียบกับโมเดลอย่าง Claude Sonnet 4 Kimi K2 จึงมอบประสิทธิภาพระดับองค์กรโดยไม่ต้องกำหนดราคาสูงลิ่ว กระตุ้นให้เกิดการนำไปใช้ในกลุ่มนักพัฒนาที่คำนึงถึงราคาอย่างรวดเร็ว

ใบอนุญาตและการเข้าถึง

ไม่เหมือนกับการเปิดตัวโอเพ่นซอร์สบางรุ่นที่ถูกจำกัดด้วยใบอนุญาตที่จำกัด Kimi K2 นั้นมีให้ใช้งานภายใต้ใบอนุญาตแบบอนุญาตให้ใช้ในเชิงพาณิชย์ มีผลงานดัดแปลง และใช้งานภายในเครื่อง ซึ่งสอดคล้องกับจริยธรรมโอเพ่นซอร์สของ Moonshot AI

- ด้วยการผสานรวมการออกแบบ MoE ที่ทันสมัย การฝึกอบรมด้านเอเจนต์ที่เข้มงวด และความพร้อมใช้งานของโอเพนซอร์ส Kimi K2 ช่วยให้นักพัฒนาและนักวิจัยสามารถสร้างแอปพลิเคชันอัจฉริยะที่ทำงานอัตโนมัติได้โดยไม่ต้องเสียค่าใช้จ่ายสูงเกินไปหรือต้องพึ่งพาระบบนิเวศแบบปิด ไม่ว่าคุณจะกำลังเขียนโค้ด สร้างเวิร์กโฟลว์ที่ซับซ้อนหลายขั้นตอน หรือทดลองใช้การใช้เหตุผลขนาดใหญ่ K2 มอบรากฐานที่ยืดหยุ่นและมีประสิทธิภาพสูง