เมื่อวันที่ 17 มิถุนายน 2025 บริษัท MiniMax (หรือที่รู้จักในชื่อ Xiyu Technology) ซึ่งตั้งอยู่ในเซี่ยงไฮ้ ผู้นำด้าน AI ได้เปิดตัว MiniMax-M1 (ต่อไปนี้จะเรียกว่า "M1") อย่างเป็นทางการ ซึ่งเป็นโมเดลการให้เหตุผลแบบไฮบริดที่ใช้การให้ความสนใจแบบเปิดขนาดใหญ่รุ่นแรกของโลก โดยการผสมผสานสถาปัตยกรรมแบบผสมผสานของผู้เชี่ยวชาญ (MoE) เข้ากับกลไก Lightning Attention ที่สร้างสรรค์ใหม่ ทำให้ M1 บรรลุประสิทธิภาพชั้นนำของอุตสาหกรรมในงานที่เน้นด้านผลผลิต โดยแข่งขันกับระบบแบบปิดชั้นนำได้ในขณะที่ยังคงความคุ้มทุนที่ไม่มีใครเทียบได้ ในบทความเชิงลึกนี้ เราจะมาสำรวจว่า M1 คืออะไร ทำงานอย่างไร มีคุณสมบัติที่กำหนด และคำแนะนำที่เป็นประโยชน์ในการเข้าถึงและใช้งานโมเดลดังกล่าว

MiniMax-M1 คืออะไร?

MiniMax-M1 เป็นตัวแทนของจุดสุดยอดของการวิจัยกลไกการให้ความสนใจที่มีประสิทธิภาพและปรับขนาดได้ของ MiniMaxAI โดยอาศัยรากฐานของ MiniMax-Text-01 การทำซ้ำ M1 จะผสานการให้ความสนใจแบบรวดเร็วเข้ากับกรอบงาน MoE เพื่อให้ได้ประสิทธิภาพที่ไม่เคยมีมาก่อนทั้งในระหว่างการฝึกและการอนุมาน การผสมผสานนี้ทำให้โมเดลสามารถรักษาประสิทธิภาพที่สูงได้แม้ในขณะที่ประมวลผลลำดับที่ยาวมาก ซึ่งเป็นข้อกำหนดสำคัญสำหรับงานที่เกี่ยวข้องกับฐานโค้ดจำนวนมาก เอกสารทางกฎหมาย หรือเอกสารทางวิทยาศาสตร์

สถาปัตยกรรมหลักและการกำหนดพารามิเตอร์

โดยพื้นฐานแล้ว MiniMax-M1 ใช้ประโยชน์จากระบบ MoE แบบไฮบริดที่ส่งโทเค็นผ่านเครือข่ายย่อยของผู้เชี่ยวชาญในเครือข่ายย่อยแบบไดนามิก แม้ว่าโมเดลจะประกอบด้วยพารามิเตอร์ทั้งหมด 456 พันล้านตัว แต่มีเพียง 45.9 พันล้านตัวเท่านั้นที่เปิดใช้งานสำหรับแต่ละโทเค็น ซึ่งช่วยเพิ่มประสิทธิภาพการใช้ทรัพยากร การออกแบบนี้ได้รับแรงบันดาลใจจากการใช้งาน MoE ก่อนหน้านี้ แต่ปรับแต่งตรรกะการกำหนดเส้นทางให้ละเอียดขึ้นเพื่อลดภาระการสื่อสารระหว่าง GPU ในระหว่างการอนุมานแบบกระจาย

ความสนใจอย่างรวดเร็วและการสนับสนุนในบริบทระยะยาว

คุณลักษณะพิเศษของ MiniMax-M1 คือกลไกการให้ความสนใจแบบสายฟ้าแลบ ซึ่งช่วยลดภาระในการคำนวณของการให้ความสนใจตัวเองสำหรับลำดับยาวๆ ได้อย่างมาก ด้วยการประมาณเมทริกซ์ความสนใจผ่านการผสมผสานของเคอร์เนลท้องถิ่นและระดับโลก โมเดลนี้จึงลด FLOP ลงได้มากถึง 75% เมื่อเทียบกับหม้อแปลงแบบเดิมเมื่อประมวลผลลำดับโทเค็น 100 รายการ ประสิทธิภาพนี้ไม่เพียงแต่เร่งการอนุมานเท่านั้น แต่ยังเปิดประตูสู่การจัดการหน้าต่างบริบทที่มีโทเค็นมากถึงหนึ่งล้านรายการโดยไม่ต้องใช้ฮาร์ดแวร์ที่มากเกินไป

MiniMax-M1 บรรลุประสิทธิภาพการประมวลผลได้อย่างไร

ประสิทธิภาพที่เพิ่มขึ้นของ MiniMax-M1 มาจากนวัตกรรมหลักสองประการ ได้แก่ สถาปัตยกรรมแบบผสมผสานของผู้เชี่ยวชาญและอัลกอริทึมการเรียนรู้เสริมแรง CISPO แบบใหม่ที่ใช้ระหว่างการฝึกอบรม เมื่อรวมกันแล้ว องค์ประกอบเหล่านี้ช่วยลดทั้งเวลาในการฝึกอบรมและต้นทุนการอนุมาน ทำให้สามารถทดลองและปรับใช้ได้อย่างรวดเร็ว

การกำหนดเส้นทางแบบผสมผสานของผู้เชี่ยวชาญ

ส่วนประกอบ MoE ใช้เครือข่ายย่อยของผู้เชี่ยวชาญ 32 เครือข่าย ซึ่งแต่ละเครือข่ายมีความเชี่ยวชาญในด้านต่างๆ ของการใช้เหตุผลหรืองานเฉพาะโดเมน ในระหว่างการอนุมาน กลไกการจำกัดที่เรียนรู้จะเลือกผู้เชี่ยวชาญที่เกี่ยวข้องมากที่สุดสำหรับแต่ละโทเค็นแบบไดนามิก โดยเปิดใช้งานเฉพาะเครือข่ายย่อยที่จำเป็นในการประมวลผลอินพุต การเปิดใช้งานแบบเลือกสรรนี้จะลดการคำนวณซ้ำซ้อนและลดความต้องการแบนด์วิดท์หน่วยความจำ ทำให้ MiniMax-M1 มีข้อได้เปรียบอย่างมากในด้านประสิทธิภาพต้นทุนเมื่อเทียบกับรุ่นหม้อแปลงโมโนลิธิก

CISPO: อัลกอริธึมการเรียนรู้การเสริมแรงแบบใหม่

เพื่อเพิ่มประสิทธิภาพในการฝึกอบรมให้ดียิ่งขึ้น MiniMaxAI ได้พัฒนา CISPO (Clipped Importance Sampling with Partial Overrides) ซึ่งเป็นอัลกอริทึม RL ที่แทนที่การอัปเดตน้ำหนักในระดับโทเค็นด้วยการตัดตามการสุ่มตัวอย่างความสำคัญ CISPO ช่วยลดปัญหาการระเบิดของน้ำหนักที่พบได้ทั่วไปในการตั้งค่า RL ขนาดใหญ่ เร่งการบรรจบกัน และรับรองการปรับปรุงนโยบายที่เสถียรในเกณฑ์มาตรฐานที่หลากหลาย ผลลัพธ์คือ การฝึกอบรม RL เต็มรูปแบบของ MiniMax-M1 บน GPU H512 จำนวน 800 ตัวเสร็จสิ้นในเวลาเพียงสามสัปดาห์ โดยมีค่าใช้จ่ายประมาณ 534,700 ดอลลาร์ ซึ่งเป็นเพียงเศษเสี้ยวของต้นทุนที่รายงานสำหรับการฝึกอบรม GPT-4 ที่เทียบเคียงได้

เกณฑ์การวัดประสิทธิภาพของ MiniMax-M1 คืออะไร?

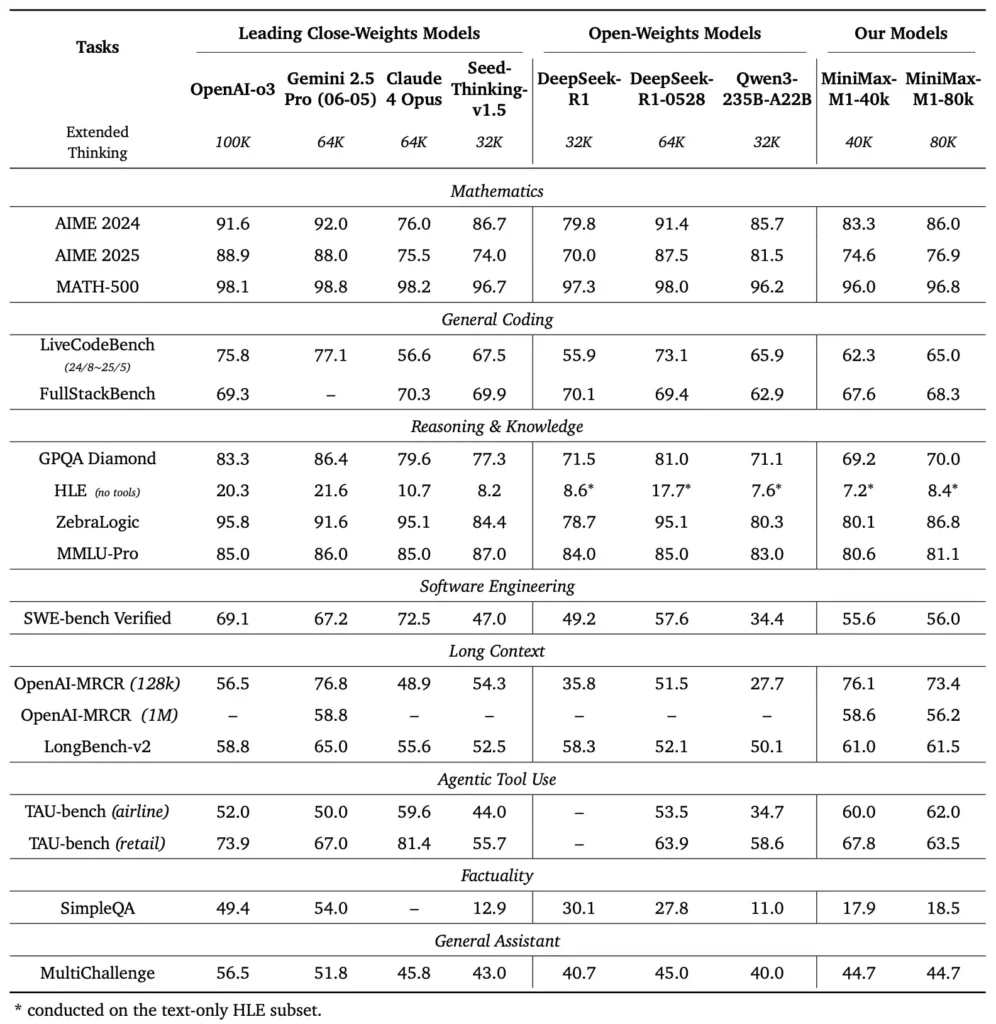

MiniMax-M1 โดดเด่นในเกณฑ์มาตรฐานและเกณฑ์มาตรฐานเฉพาะโดเมนที่หลากหลาย แสดงให้เห็นถึงความสามารถในการจัดการการใช้เหตุผลในบริบทระยะยาว การแก้ปัญหาทางคณิตศาสตร์ และการสร้างโค้ด

งานการให้เหตุผลในบริบทระยะยาว

ในการทดสอบความเข้าใจเอกสารอย่างละเอียด MiniMax-M1 ประมวลผลหน้าต่างบริบทได้มากถึง 1,000,000 โทเค็น ซึ่งมีประสิทธิภาพเหนือกว่า DeepSeek-R1 ถึงแปดเท่าในด้านความยาวบริบทสูงสุดและลดความต้องการในการคำนวณลงครึ่งหนึ่งสำหรับลำดับ 100 โทเค็น ในการประเมินประสิทธิภาพ เช่น การประเมินบริบทขยายของ NarrativeQA โมเดลนี้บรรลุคะแนนความเข้าใจที่ทันสมัยที่สุด โดยให้เครดิตกับความสามารถของการโฟกัสอย่างรวดเร็วในการจับความสัมพันธ์ทั้งในระดับท้องถิ่นและระดับโลกอย่างมีประสิทธิภาพ

วิศวกรรมซอฟต์แวร์และการใช้เครื่องมือ

MiniMax-M1 ได้รับการฝึกอบรมโดยเฉพาะในสภาพแวดล้อมทางวิศวกรรมซอฟต์แวร์แบบแซนด์บ็อกซ์โดยใช้ RL ขนาดใหญ่ ทำให้สามารถสร้างและแก้ไขโค้ดได้อย่างแม่นยำ ในเกณฑ์มาตรฐานการเข้ารหัส เช่น HumanEval และ MBPP โมเดลนี้บรรลุอัตราการผ่านที่เทียบเคียงได้หรือดีกว่า Qwen3-235B และ DeepSeek-R1 โดยเฉพาะในฐานโค้ดหลายไฟล์และงานที่ต้องใช้การอ้างอิงแบบไขว้ของเซกเมนต์โค้ดยาว นอกจากนี้ การสาธิตในช่วงแรกของ MiniMaxAI ยังแสดงให้เห็นถึงความสามารถของโมเดลในการบูรณาการกับเครื่องมือสำหรับนักพัฒนา ตั้งแต่การสร้างไปป์ไลน์ CI/CD ไปจนถึงเวิร์กโฟลว์การจัดทำเอกสารอัตโนมัติ

นักพัฒนาสามารถเข้าถึง MiniMax-M1 ได้อย่างไร?

เพื่อส่งเสริมการนำไปใช้ในวงกว้าง MiniMaxAI จึงได้เปิดให้ MiniMax-M1 ใช้งานได้ฟรีในรูปแบบโมเดลน้ำหนักเปิด นักพัฒนาสามารถเข้าถึงจุดตรวจสอบที่ผ่านการฝึกอบรมล่วงหน้า น้ำหนักโมเดล และโค้ดอนุมานได้ผ่านทางคลังข้อมูล GitHub อย่างเป็นทางการ

การเปิดตัวแบบเปิดน้ำหนักบน GitHub

MiniMaxAI เผยแพร่ไฟล์โมเดลของ MiniMax-M1 และสคริปต์ที่เกี่ยวข้องภายใต้ใบอนุญาตโอเพนซอร์สแบบอนุญาตบน GitHub ผู้ใช้ที่สนใจสามารถโคลนที่เก็บข้อมูลได้ที่ https://github.com/MiniMax-AI/MiniMax-M1 ซึ่งโฮสต์จุดตรวจสอบสำหรับตัวแปรงบประมาณโทเค็นทั้ง 40 และ 80 โทเค็น รวมถึงตัวอย่างการรวมสำหรับเฟรมเวิร์ก ML ทั่วไป เช่น PyTorch และ TensorFlow

จุดสิ้นสุด API และการรวมระบบคลาวด์

นอกเหนือจากการใช้งานในพื้นที่แล้ว MiniMaxAI ยังได้ร่วมมือกับผู้ให้บริการคลาวด์รายใหญ่เพื่อเสนอบริการ API ที่ได้รับการจัดการ ผ่านความร่วมมือเหล่านี้ นักพัฒนาสามารถเรียกใช้ MiniMax-M1 ผ่านจุดสิ้นสุด RESTful โดยมี SDK ที่พร้อมใช้งานสำหรับ Python, JavaScript และ Java API ประกอบด้วยพารามิเตอร์ที่กำหนดค่าได้สำหรับความยาวของบริบท เกณฑ์การกำหนดเส้นทางของผู้เชี่ยวชาญ และงบประมาณโทเค็น ช่วยให้ผู้ใช้ปรับแต่งประสิทธิภาพให้เหมาะกับกรณีการใช้งานของตนเองได้ในขณะที่ตรวจสอบการใช้การคำนวณแบบเรียลไทม์

วิธีการบูรณาการและใช้งาน MiniMax-M1 ในแอพพลิเคชั่นจริงได้อย่างไร?

การใช้ประโยชน์จากความสามารถของ MiniMax-M1 ต้องมีความเข้าใจรูปแบบ API แนวทางปฏิบัติที่ดีที่สุดสำหรับการแจ้งเตือนบริบทระยะยาว และกลยุทธ์สำหรับการประสานงานเครื่องมือ

ตัวอย่างการใช้งาน API ขั้นพื้นฐาน

การเรียกใช้ API ทั่วไปเกี่ยวข้องกับการส่งข้อมูล JSON ที่มีข้อความอินพุตและการกำหนดค่าที่ไม่จำเป็น ตัวอย่างเช่น:

POST /v1/minimax-m1/generate

{

"input": "Analyze the following 500K token legal document and summarize the key obligations:",

"max_output_tokens": 1024,

"context_window": 500000,

"expert_threshold": 0.6

}

การตอบสนองจะส่งคืน JSON ที่มีโครงสร้างพร้อมด้วยข้อความที่สร้างขึ้น สถิติการใช้งานโทเค็น และบันทึกการกำหนดเส้นทาง ช่วยให้สามารถตรวจสอบการเปิดใช้งานของผู้เชี่ยวชาญได้อย่างละเอียด

การใช้เครื่องมือและตัวแทน MiniMax

นอกเหนือไปจากโมเดลหลัก MiniMaxAI ยังได้เปิดตัว MiniMax Agent ซึ่งเป็นเฟรมเวิร์กเอเจนต์รุ่นเบตาที่สามารถเรียกใช้เครื่องมือภายนอกได้ตั้งแต่สภาพแวดล้อมการดำเนินการโค้ดไปจนถึงเว็บสเครเปอร์ นักพัฒนาสามารถสร้างอินสแตนซ์เซสชันเอเจนต์ที่เชื่อมโยงการใช้เหตุผลของโมเดลกับการเรียกใช้เครื่องมือ เช่น เรียกค้นข้อมูลแบบเรียลไทม์ ดำเนินการคำนวณ หรืออัปเดตฐานข้อมูล แบบจำลองเอเจนต์นี้ช่วยลดความซับซ้อนในการพัฒนาแอปพลิเคชันแบบครบวงจร ทำให้ MiniMax-M1 สามารถทำหน้าที่เป็นออร์เคสตราเตอร์ในเวิร์กโฟลว์ที่ซับซ้อนได้

แนวทางปฏิบัติที่ดีที่สุดและข้อผิดพลาด

- วิศวกรรมพร้อมท์สำหรับบริบทที่ยาวนาน:แบ่งอินพุตออกเป็นส่วนๆ ที่มีความสอดคล้องกัน ฝังสรุปในช่วงเวลาที่สมเหตุสมผล และใช้กลยุทธ์ "สรุปก่อนแล้วจึงให้เหตุผล" เพื่อรักษาโฟกัสของโมเดล

- การคำนวณเทียบกับประสิทธิภาพ:ทดลองด้วยเกณฑ์ผู้เชี่ยวชาญที่ต่ำลงหรือลดงบประมาณการคิด (เช่น รุ่น 40K) สำหรับแอปพลิเคชันที่ไวต่อความล่าช้า

- การติดตามและการกำกับดูแล:ใช้บันทึกการกำหนดเส้นทางและสถิติโทเค็นเพื่อตรวจสอบการใช้งานของผู้เชี่ยวชาญและเพื่อให้เป็นไปตามงบประมาณต้นทุน โดยเฉพาะอย่างยิ่งในสภาพแวดล้อมการผลิต

โดยปฏิบัติตามแนวทางเหล่านี้ นักพัฒนาสามารถใช้ประโยชน์จากจุดแข็งของ MiniMax-M1 ได้ ไม่ว่าจะเป็นการจัดการบริบทที่ครอบคลุมและการใช้เหตุผลที่มีประสิทธิภาพ ขณะเดียวกันก็บรรเทาความเสี่ยงที่เกี่ยวข้องกับการปรับใช้โมเดลขนาดใหญ่

MiniMax-M1 ใช้ยังไงคะ?

เมื่อติดตั้งแล้ว สามารถเรียกใช้ M1 ได้ผ่านสคริปต์ Python ง่ายๆ หรือสมุดบันทึกแบบโต้ตอบ

สคริปต์อนุมานพื้นฐานมีลักษณะเป็นอย่างไร?

from minimax_m1 import MiniMaxM1Tokenizer, MiniMaxM1ForCausalLM

tokenizer = MiniMaxM1Tokenizer.from_pretrained("MiniMax-AI/MiniMax-M1-40k")

model = MiniMaxM1ForCausalLM.from_pretrained("MiniMax-AI/MiniMax-M1-40k")

inputs = tokenizer("Translate the following paragraph to French: ...", return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=200)

print(tokenizer.decode(outputs))

ตัวอย่างนี้เรียกใช้ตัวแปรงบประมาณ 40 เหรียญ โดยสลับไปที่ "MiniMax-AI/MiniMax-M1-80k" ปลดล็อคงบการใช้เหตุผล 80 เต็มจำนวน ()

คุณจัดการกับบริบทที่ยาวมากได้อย่างไร?

สำหรับอินพุตที่เกินขนาดบัฟเฟอร์ทั่วไป M1 รองรับการโทเค็นแบบสตรีมมิ่ง ใช้ stream=True ตั้งค่าสถานะในโทเค็นไนเซอร์เพื่อป้อนโทเค็นเป็นชิ้นๆ และใช้ประโยชน์จากการอนุมานรีสตาร์ทจุดตรวจสอบเพื่อรักษาประสิทธิภาพเหนือลำดับโทเค็นล้านตัว

คุณจะปรับแต่งหรือปรับเปลี่ยน M1 ได้อย่างไร?

แม้ว่าจุดตรวจสอบพื้นฐานจะเพียงพอสำหรับงานส่วนใหญ่ แต่ผู้วิจัยสามารถปรับ RL ให้ละเอียดได้โดยใช้โค้ด CISPO ที่รวมอยู่ในที่เก็บ โดยการจัดหาฟังก์ชันรางวัลแบบกำหนดเอง ตั้งแต่ความถูกต้องของโค้ดไปจนถึงความเที่ยงตรงของความหมาย ผู้ปฏิบัติสามารถปรับ M1 ให้เข้ากับเวิร์กโฟลว์เฉพาะโดเมนได้

สรุป

MiniMax-M1 โดดเด่นในฐานะโมเดล AI ที่ก้าวล้ำ โดยขยายขอบเขตความเข้าใจและการใช้เหตุผลในภาษาในบริบทยาว ด้วยสถาปัตยกรรม MoE แบบไฮบริด กลไกการให้ความสนใจอย่างรวดเร็ว และระบบการฝึกอบรมที่ได้รับการสนับสนุนจาก CISPO โมเดลนี้จึงมอบประสิทธิภาพสูงในงานต่างๆ ตั้งแต่การวิเคราะห์ทางกฎหมายไปจนถึงวิศวกรรมซอฟต์แวร์ ขณะเดียวกันก็ลดค่าใช้จ่ายในการคำนวณลงอย่างมาก ด้วยการเปิดตัวแบบเปิดและข้อเสนอ API บนคลาวด์ MiniMax-M1 จึงเข้าถึงนักพัฒนาและองค์กรต่างๆ มากมายที่ต้องการสร้างแอปพลิเคชันที่ขับเคลื่อนด้วย AI รุ่นต่อไป ในขณะที่ชุมชน AI ยังคงสำรวจศักยภาพของโมเดลบริบทขนาดใหญ่ นวัตกรรมของ MiniMax-M1 ก็พร้อมที่จะมีอิทธิพลต่อการวิจัยและการพัฒนาผลิตภัณฑ์ในอนาคตทั่วทั้งอุตสาหกรรม

เริ่มต้นใช้งาน

CometAPI มอบอินเทอร์เฟซ REST แบบรวมที่รวบรวมโมเดล AI หลายร้อยโมเดล รวมถึงกลุ่ม ChatGPT ภายใต้จุดสิ้นสุดที่สอดคล้องกัน พร้อมการจัดการคีย์ API ในตัว โควตาการใช้งาน และแดชบอร์ดการเรียกเก็บเงิน แทนที่จะต้องจัดการ URL และข้อมูลรับรองของผู้ขายหลายราย

เริ่มต้นด้วยการสำรวจความสามารถของโมเดลใน สนามเด็กเล่น และปรึกษา คู่มือ API สำหรับคำแนะนำโดยละเอียด ก่อนเข้าใช้งาน โปรดตรวจสอบให้แน่ใจว่าคุณได้เข้าสู่ระบบ CometAPI และได้รับรหัส API แล้ว

API ของ MiniMax‑M1 ที่ผสานรวมล่าสุดจะปรากฏบน CometAPI เร็วๆ นี้ โปรดติดตาม! ในขณะที่เรากำลังสรุปการอัปโหลดโมเดล MiniMax‑M1 ให้สำรวจโมเดลอื่นๆ ของเราใน หน้าโมเดล หรือลองพวกเขาใน เอไอ เพลย์กราวด์. รุ่นล่าสุดของ MiniMax ใน CometAPI คือ Minimax ABAB7-ตัวอย่าง API และ มินิแม็กซ์วีดีโอ-01 API ,อ้างถึง: