GLM-4.6, Z.ai’nin (eski adıyla Zhipu AI) GLM ailesindeki en son büyük sürüm: ajan odaklı iş akışları, uzun bağlamlı akıl yürütme ve gerçek dünyaya yönelik kodlama için ayarlanmış, 4. nesil, büyük dil MoE (Mixture-of-Experts) modeli. Sürüm, pratik ajan/araç entegrasyonuna, çok büyük bağlam penceresine ve yerel dağıtım için açık ağırlıkların kullanılabilirliğine vurgu yapar.

Temel özellikler

- Uzun bağlam — yerel 200K token bağlam penceresi (128K’dan genişletildi). (docs.z.ai)

- Kodlama ve ajanik yetenek — gerçek dünya kodlama görevlerinde duyurulan iyileştirmeler ve ajanlar için daha iyi araç çağırma.

- Verimlilik — Z.ai’nin testlerinde GLM-4.5’e kıyasla ~%30 daha düşük token tüketimi bildirildi.

- Dağıtım ve kuantizasyon — Cambricon çipleri için duyurulan ilk FP8 ve Int4 entegrasyonu; vLLM aracılığıyla Moore Threads üzerinde yerel FP8 desteği.

- Model boyutu ve tensör türü — yayımlanan artifaktlar, Hugging Face üzerinde ~357B parametreli bir modeli (BF16 / F32 tensörler) gösteriyor.

Teknik ayrıntılar

Modaliteler ve biçimler. GLM-4.6 yalnızca metin LLM’dir (girdi ve çıktı modaliteleri: metin). Bağlam uzunluğu = 200K token; azami çıktı = 128K token.

Kuantizasyon ve donanım desteği. Ekip, Cambricon çiplerinde FP8/Int4 kuantizasyonu ve çıkarım için vLLM kullanarak Moore Threads GPU’larında yerel FP8 yürütmeyi rapor ediyor — çıkarım maliyetini düşürmek ve şirket içi ile yerel bulut dağıtımlarını mümkün kılmak açısından önemli.

Araçlar ve entegrasyonlar. GLM-4.6, Z.ai’nin API’si, üçüncü taraf sağlayıcı ağları (ör. CometAPI) üzerinden dağıtılır ve kodlama ajanlarına (Claude Code, Cline, Roo Code, Kilo Code) entegre edilir.

Teknik ayrıntılar

Modaliteler ve biçimler. GLM-4.6 yalnızca metin LLM’dir (girdi ve çıktı modaliteleri: metin). Bağlam uzunluğu = 200K token; azami çıktı = 128K token.

Kuantizasyon ve donanım desteği. Ekip, Cambricon çiplerinde FP8/Int4 kuantizasyonu ve çıkarım için vLLM kullanarak Moore Threads GPU’larında yerel FP8 yürütmeyi rapor ediyor — çıkarım maliyetini düşürmek ve şirket içi ile yerel bulut dağıtımlarını mümkün kılmak açısından önemli.

Araçlar ve entegrasyonlar. GLM-4.6, Z.ai’nin API’si, üçüncü taraf sağlayıcı ağları (ör. CometAPI) üzerinden dağıtılır ve kodlama ajanlarına (Claude Code, Cline, Roo Code, Kilo Code) entegre edilir.

Kıyaslama performansı

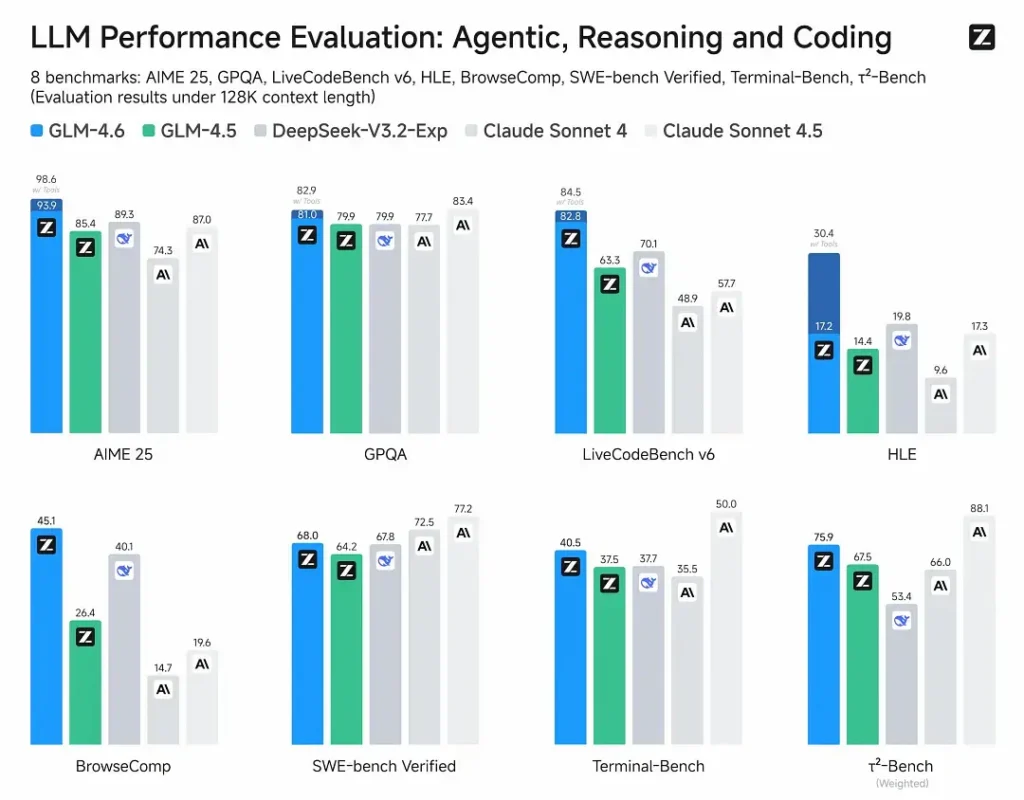

- Yayımlanan değerlendirmeler: GLM-4.6, ajanlar, akıl yürütme ve kodlamayı kapsayan sekiz açık kıyaslamada test edildi ve GLM-4.5’e göre belirgin kazanımlar gösteriyor. İnsan değerlendirmeli, gerçek dünya kodlama testlerinde (genişletilmiş CC-Bench), GLM-4.6 GLM-4.5’e kıyasla ~%15 daha az token kullanıyor ve Anthropic’in Claude Sonnet 4’üne karşı ~%48.6 kazanım oranı sergiliyor (birçok lider tabloda neredeyse parite).

- Konumlandırma: sonuçlar, GLM-4.6’nın önde gelen yerli ve uluslararası modellerle rekabetçi olduğunu iddia ediyor (örnekler arasında DeepSeek-V3.1 ve Claude Sonnet 4 bulunuyor).

Sınırlamalar ve riskler

- Halüsinasyonlar ve hatalar: mevcut tüm LLM’ler gibi, GLM-4.6 da olgusal hatalar yapabilir — Z.ai’nin belgeleri çıktılarda hata bulunabileceğini açıkça uyarıyor. Kullanıcılar kritik içerik için doğrulama ve retrieval/RAG uygulamalıdır.

- Model karmaşıklığı ve hizmet maliyeti: 200K bağlam ve çok büyük çıktılar bellek ve gecikme taleplerini dramatik biçimde artırır ve çıkarım maliyetlerini yükseltebilir; ölçekli çalıştırma için kuantizasyon/çıkarım mühendisliği gereklidir.

- Alan boşlukları: GLM-4.6 güçlü ajan/kodlama performansı bildirse de bazı kamuya açık raporlar, belirli mikro kıyaslamalarda hâlâ bazı rakip modellerin sürümlerinin gerisinde kaldığını belirtir (ör., bazı kodlama metriklerinde Sonnet 4.5’e karşı). Üretim modellerini değiştirmeden önce göreve göre değerlendirin.

- Güvenlik ve politika: açık ağırlıklar erişilebilirliği artırır ancak aynı zamanda koruyuculuk ve yönetişim sorularını gündeme getirir (önlemler, koruma mekanizmaları ve red-teaming kullanıcının sorumluluğundadır).

Kullanım senaryoları

- Ajanik sistemler ve araç orkestrasyonu: uzun ajan izleri, çoklu araç planlama, dinamik araç çağırma; modelin ajanik ayarı önemli bir satış noktasıdır.

- Gerçek dünya kodlama yardımcıları: çok turlu kod üretimi, kod incelemesi ve etkileşimli IDE asistanları (Z.ai’ye göre Claude Code, Cline, Roo Code ile entegre). Token verimliliği iyileştirmeleri yoğun kullanım geliştirici planları için cazip kılar.

- Uzun belge iş akışları: özetleme, çok belgelik sentez, 200K pencere sayesinde uzun hukuki/teknik incelemeler.

- İçerik üretimi ve sanal karakterler: genişletilmiş diyaloglar, çok turlu senaryolarda tutarlı persona sürdürme.

GLM-4.6 diğer modellerle nasıl karşılaştırılır

- GLM-4.5 → GLM-4.6: bağlam boyutunda (128K → 200K) ve token verimliliğinde (CC-Bench’te ~%15 daha az token) sıçrama; geliştirilmiş ajan/araç kullanımı.

- GLM-4.6 vs Claude Sonnet 4 / Sonnet 4.5: Z.ai, birçok sıralamada neredeyse parite ve CC-Bench gerçek dünya kodlama görevlerinde ~%48.6 kazanım oranı bildirmektedir (yani yakın rekabet; bazı mikro kıyaslamalarda Sonnet hâlâ önde). Birçok mühendislik ekibi için GLM-4.6, maliyet açısından verimli bir alternatif olarak konumlandırılıyor.

- GLM-4.6 vs diğer uzun bağlam modelleri (DeepSeek, Gemini varyantları, GPT-4 ailesi): GLM-4.6, büyük bağlam ve ajanik kodlama iş akışlarını vurgular; göreli güçlü yanlar ölçüte bağlıdır (token verimliliği/araç entegrasyonu vs ham kod sentezi doğruluğu veya güvenlik hatları). Ampirik seçim görev odaklı olmalıdır.

Zhipu AI’nin en yeni amiral gemisi modeli GLM-4.6 yayımlandı: toplam 355B parametre, 32B aktif. Tüm temel yeteneklerde GLM-4.5’i geride bırakır.

- Kodlama: Claude Sonnet 4 ile eş düzeyde, Çin’de en iyisi.

- Bağlam: 200K’a genişletildi (128K’dan).

- Akıl yürütme: iyileştirildi, çıkarım sırasında araç çağırmayı destekler.

- Arama: geliştirilmiş araç çağırma ve ajan performansı.

- Yazma: stil, okunabilirlik ve rol yapma konusunda insan tercihleriyle daha iyi uyum sağlar.

- Çok dilli: diller arası çeviri güçlendirildi.