17 Haziran 2025'te, Şanghay merkezli AI lideri MiniMax (Xiyu Technology olarak da bilinir) resmi olarak MiniMax-M1'i (bundan sonra "M1") yayınladı - dünyanın ilk açık ağırlık, büyük ölçekli, hibrit dikkat akıl yürütme modeli. Bir Uzmanlar Karışımı (MoE) mimarisini yenilikçi bir Lightning Dikkat mekanizmasıyla birleştiren M1, üretkenliğe yönelik görevlerde sektör lideri performans elde ediyor, benzersiz maliyet etkinliğini korurken en iyi kapalı kaynaklı sistemlerle rekabet ediyor. Bu derinlemesine makalede, M1'in ne olduğunu, nasıl çalıştığını, tanımlayıcı özelliklerini ve modele erişme ve kullanma konusunda pratik rehberliği inceliyoruz.

MiniMax-M1 nedir?

MiniMax-M1, MiniMaxAI'nin ölçeklenebilir, verimli dikkat mekanizmalarına yönelik araştırmasının doruk noktasını temsil eder. MiniMax-Text-01 temeline dayanan M1 yinelemesi, hem eğitim hem de çıkarım sırasında benzeri görülmemiş bir verimlilik elde etmek için yıldırım dikkatini bir MoE çerçevesiyle bütünleştirir. Bu kombinasyon, modelin son derece uzun dizileri işlerken bile yüksek performansı korumasını sağlar; bu, kapsamlı kod tabanları, yasal belgeler veya bilimsel literatür içeren görevler için önemli bir gerekliliktir.

Çekirdek mimarisi ve parametrelendirme

MiniMax-M1, özünde, token'ları uzman alt ağların bir alt kümesi aracılığıyla dinamik olarak yönlendiren bir hibrit MoE sisteminden yararlanır. Model toplamda 456 milyar parametreden oluşurken, her token için yalnızca 45.9 milyarı etkinleştirilerek kaynak kullanımı optimize edilir. Bu tasarım, önceki MoE uygulamalarından ilham alır ancak dağıtılmış çıkarım sırasında GPU'lar arasındaki iletişim yükünü en aza indirmek için yönlendirme mantığını iyileştirir.

Yıldırım hızında dikkat ve uzun bağlam desteği

MiniMax-M1'in tanımlayıcı bir özelliği, uzun diziler için kendi kendine dikkatin hesaplama yükünü önemli ölçüde azaltan yıldırım dikkat mekanizmasıdır. Yerel ve küresel çekirdeklerin bir kombinasyonu aracılığıyla dikkat matrislerini yaklaştırarak, model 75K belirteç dizilerini işlerken FLOP'ları geleneksel dönüştürücülere kıyasla %100'e kadar azaltır. Bu verimlilik yalnızca çıkarımı hızlandırmakla kalmaz, aynı zamanda engelleyici donanım gereksinimleri olmadan bir milyon belirtece kadar bağlam pencerelerinin işlenmesine de kapı açar.

MiniMax-M1 hesaplama verimliliğini nasıl sağlıyor?

MiniMax-M1'in verimlilik kazanımları iki temel yenilikten kaynaklanmaktadır: hibrit Uzman Karışımı mimarisi ve eğitim sırasında kullanılan yeni CISPO takviyeli öğrenme algoritması. Bu unsurlar birlikte hem eğitim süresini hem de çıkarım maliyetini azaltarak hızlı deney ve dağıtıma olanak tanır.

Hibrit Uzman Karışımı yönlendirme

MoE bileşeni, her biri muhakeme veya alan-özel görevlerin farklı yönlerinde uzmanlaşmış 32 uzman alt ağı kullanır. Çıkarım sırasında, öğrenilmiş bir geçit mekanizması her belirteç için en alakalı uzmanları dinamik olarak seçer ve yalnızca girdiyi işlemek için gereken alt ağları etkinleştirir. Bu seçici etkinleştirme, gereksiz hesaplamaları azaltır ve bellek bant genişliği taleplerini azaltır, MiniMax-M1'e monolitik trafo modellerine göre maliyet verimliliğinde önemli bir avantaj sağlar.

CISPO: Yeni bir takviyeli öğrenme algoritması

Eğitim verimliliğini daha da artırmak için MiniMaxAI, token düzeyindeki ağırlık güncellemelerini önem örnekleme tabanlı kırpma ile değiştiren bir RL algoritması olan CISPO'yu (Kısmi Geçersiz Kılmalarla Kesilmiş Önem Örneklemesi) geliştirdi. CISPO, büyük ölçekli RL kurulumlarında yaygın olan ağırlık patlaması sorunlarını azaltır, yakınsamayı hızlandırır ve çeşitli kıyaslamalarda istikrarlı politika iyileştirmesi sağlar. Sonuç olarak, MiniMax-M1'in 512 H800 GPU'daki tam RL eğitimi sadece üç haftada tamamlanır ve yaklaşık 534,700 dolara mal olur; bu da benzer GPT-4 eğitim çalışmaları için bildirilen maliyetin bir kısmıdır.

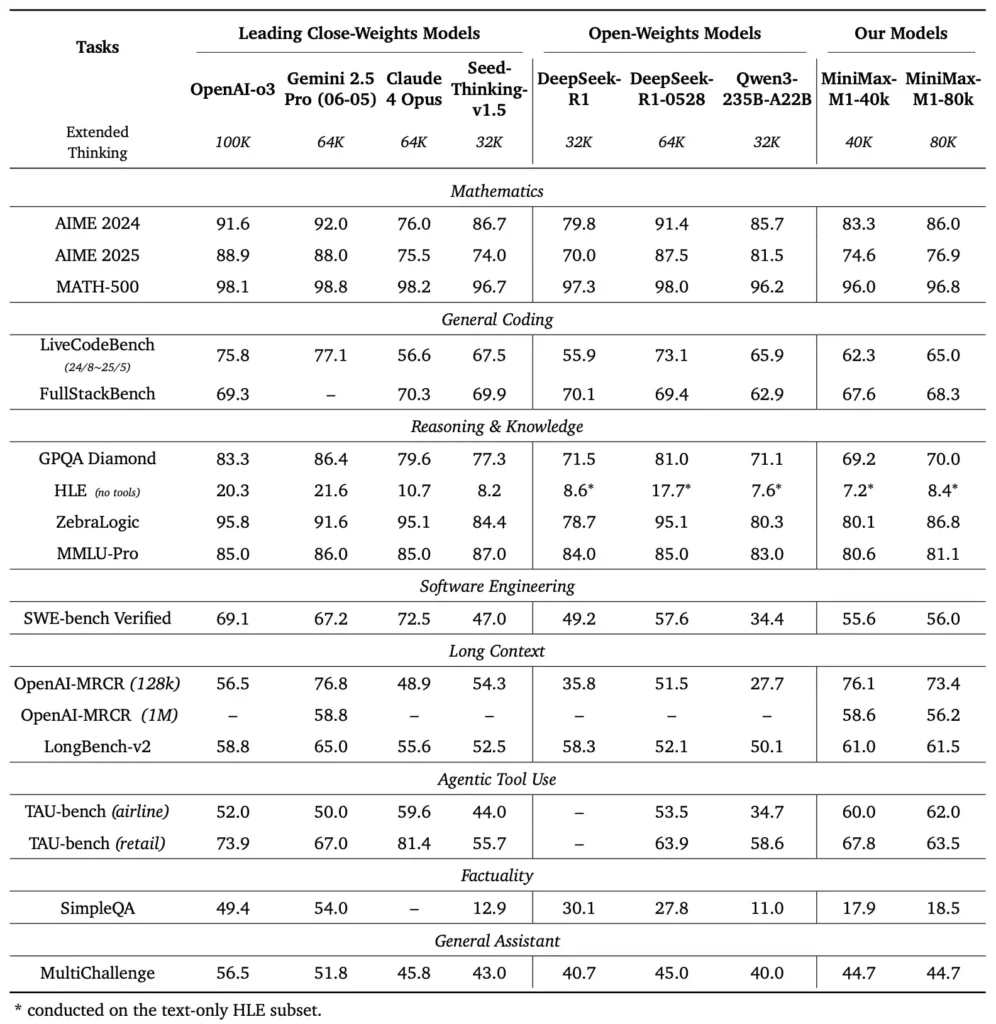

MiniMax-M1'in performans kıyaslamaları nelerdir?

MiniMax-M1, uzun bağlamlı muhakeme, matematiksel problem çözme ve kod oluşturma konusundaki ustalığını göstererek çeşitli standart ve alan-özgü kıyaslamalarda üstün performans göstermektedir.

Uzun bağlamlı muhakeme görevleri

Kapsamlı belge anlama testlerinde, MiniMax-M1, 1,000,000 token'a kadar bağlam pencerelerini işler, DeepSeek-R1'i maksimum bağlam uzunluğunda sekiz kat geride bırakır ve 100K token'lık diziler için hesaplama gereksinimlerini yarıya indirir. NarrativeQA genişletilmiş bağlam değerlendirmesi gibi kıyaslamalarda, model, hem yerel hem de küresel bağımlılıkları etkili bir şekilde yakalama yeteneğinin yıldırım hızına atfedilen en son anlayış puanlarına ulaşır.

Yazılım mühendisliği ve araç kullanımı

MiniMax-M1, büyük ölçekli RL kullanılarak özel olarak korumalı yazılım mühendisliği ortamlarında eğitildi ve bu sayede dikkat çekici bir doğrulukla kod üretip hata ayıklayabildi. HumanEval ve MBPP gibi kodlama kıyaslamalarında, model özellikle çok dosyalı kod tabanlarında ve uzun kod segmentlerine çapraz referans gerektiren görevlerde Qwen3-235B ve DeepSeek-R1'inkine eşit veya daha yüksek geçiş oranlarına ulaşıyor. Ayrıca, MiniMaxAI'nin erken gösterileri, modelin CI/CD boru hatları üretmekten otomatik dokümantasyon iş akışlarına kadar geliştirici araçlarıyla bütünleşme yeteneğini sergiliyor.

Geliştiriciler MiniMax-M1'e nasıl erişebilir?

Yaygın bir benimsemeyi teşvik etmek için MiniMaxAI, MiniMax-M1'i açık ağırlıklı bir model olarak serbestçe kullanılabilir hale getirdi. Geliştiriciler, resmi GitHub deposu aracılığıyla önceden eğitilmiş kontrol noktalarına, model ağırlıklarına ve çıkarım koduna erişebilir.

GitHub'da açık ağırlık sürümü

MiniMaxAI, MiniMax-M1'in model dosyalarını ve eşlik eden betikleri GitHub'da izin verici bir açık kaynak lisansı altında yayınladı. İlgilenen kullanıcılar, hem 1K hem de 40K token bütçe varyantları için kontrol noktalarına ev sahipliği yapan ve PyTorch ve TensorFlow gibi yaygın ML çerçeveleri için entegrasyon örneklerine ev sahipliği yapan https://github.com/MiniMax-AI/MiniMax-M80 adresindeki deponun klonunu oluşturabilir.

API uç noktaları ve bulut entegrasyonu

MiniMaxAI, yerel dağıtımın ötesinde yönetilen API hizmetleri sunmak için büyük bulut sağlayıcılarıyla ortaklık kurdu. Bu ortaklıklar sayesinde geliştiriciler, Python, JavaScript ve Java için SDK'lar mevcutken RESTful uç noktaları aracılığıyla MiniMax-M1'i çağırabilir. API'ler, bağlam uzunluğu, uzman yönlendirme eşikleri ve belirteç bütçeleri için yapılandırılabilir parametreler içerir ve kullanıcıların gerçek zamanlı olarak hesaplama tüketimini izlerken performansı kullanım durumlarına göre uyarlamalarına olanak tanır.

MiniMax-M1'i gerçek uygulamalara nasıl entegre edebilir ve kullanabiliriz?

MiniMax-M1'in yeteneklerinden yararlanmak için API modellerinin, uzun bağlamlı istemler için en iyi uygulamaların ve araç orkestrasyonu stratejilerinin anlaşılması gerekir.

Temel API kullanım örneği

Tipik bir API çağrısı, giriş metnini ve isteğe bağlı yapılandırma geçersiz kılmalarını içeren bir JSON yükü göndermeyi içerir. Örneğin:

POST /v1/minimax-m1/generate

{

"input": "Analyze the following 500K token legal document and summarize the key obligations:",

"max_output_tokens": 1024,

"context_window": 500000,

"expert_threshold": 0.6

}

Yanıt, uzman aktivasyonlarının ayrıntılı bir şekilde izlenmesini sağlayan, oluşturulan metin, belirteç kullanım istatistikleri ve yönlendirme günlükleri içeren yapılandırılmış bir JSON döndürür.

Araç kullanımı ve MiniMax Agent

MiniMaxAI, çekirdek modelin yanı sıra, kod yürütme ortamlarından web kazıyıcılarına kadar dış araçları arka planda çağırabilen bir beta aracı çerçevesi olan MiniMax Agent'ı tanıttı. Geliştiriciler, örneğin gerçek zamanlı verileri almak, hesaplamalar yapmak veya veritabanlarını güncellemek için model akıl yürütmeyi araç çağrısıyla zincirleyen bir aracı oturumu oluşturabilir. Bu aracı paradigması, uçtan uca uygulama geliştirmeyi basitleştirerek MiniMax-M1'in karmaşık iş akışlarında orkestra şefi olarak işlev görmesini sağlar.

En iyi uygulamalar ve tuzaklar

- Uzun bağlamlar için hızlı mühendislik: Girdiyi tutarlı parçalara ayırın, özetleri mantıksal aralıklarla yerleştirin ve model odağını korumak için "önce özetle sonra mantık yürüt" stratejilerini kullanın.

- Hesaplama ve performans arasındaki dengeler: Gecikmeye duyarlı uygulamalar için daha düşük uzman eşikleri veya azaltılmış düşünme bütçeleri (örneğin, 40K varyantı) deneyin.

- İzleme ve yönetişim: Uzman kullanımını denetlemek ve özellikle üretim ortamlarında maliyet bütçelerine uyumu sağlamak için yönlendirme günlüklerini ve belirteç istatistiklerini kullanın.

Geliştiriciler bu yönergeleri izleyerek MiniMax-M1'in geniş bağlam işleme ve etkili akıl yürütme gibi güçlü yönlerinden yararlanabilir ve aynı zamanda büyük ölçekli model dağıtımlarıyla ilişkili riskleri azaltabilirler.

MiniMax-M1 nasıl kullanılır?

M1 kurulduktan sonra basit Python betikleri veya etkileşimli not defterleri aracılığıyla çağrılabilir.

Temel Çıkarım Komut Dosyası Nasıl Olmalıdır?

from minimax_m1 import MiniMaxM1Tokenizer, MiniMaxM1ForCausalLM

tokenizer = MiniMaxM1Tokenizer.from_pretrained("MiniMax-AI/MiniMax-M1-40k")

model = MiniMaxM1ForCausalLM.from_pretrained("MiniMax-AI/MiniMax-M1-40k")

inputs = tokenizer("Translate the following paragraph to French: ...", return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=200)

print(tokenizer.decode(outputs))

Bu örnek 40 bin bütçeli varyantı çağırır; takas "MiniMax-AI/MiniMax-M1-80k" 80 bin akıl yürütme bütçesinin tamamını açar ().

Çok Uzun Bağlamlarla Nasıl Başa Çıkıyorsunuz?

Tipik arabellek boyutlarını aşan girdiler için M1, akış belirteçlemesini destekler. stream=True token'ları parçalar halinde beslemek için tokenleştiricide bayrak kullanın ve milyonlarca token dizisinde performansı korumak için kontrol noktası yeniden başlatma çıkarımından yararlanın.

M1'i Nasıl İnce Ayarlayabilir veya Uyarlayabilirsiniz?

Temel kontrol noktaları çoğu görev için yeterli olsa da araştırmacılar, depoda bulunan CISPO kodunu kullanarak RL ince ayarını uygulayabilirler. Kod doğruluğundan semantik sadakate kadar değişen özel ödül işlevleri sağlayarak uygulayıcılar M1'i alan-özel iş akışlarına uyarlayabilirler.

Sonuç

MiniMax-M1, uzun bağlamlı dil anlayışı ve muhakeme sınırlarını zorlayan çığır açıcı bir AI modeli olarak öne çıkıyor. Hibrit MoE mimarisi, yıldırım dikkat mekanizması ve CISPO destekli eğitim rejimiyle model, yasal analizden yazılım mühendisliğine kadar çeşitli görevlerde yüksek performans sunarken, hesaplama masraflarını önemli ölçüde azaltır. Açık ağırlık sürümü ve bulut API teklifleri sayesinde MiniMax-M1, yeni nesil AI destekli uygulamalar oluşturmak isteyen çok çeşitli geliştiriciler ve kuruluşlar tarafından erişilebilirdir. AI topluluğu geniş bağlamlı modellerin potansiyelini keşfetmeye devam ederken, MiniMax-M1'in yenilikleri sektör genelinde gelecekteki araştırma ve ürün geliştirmeyi etkilemeye hazırdır.

Başlamak

CometAPI, ChatGPT ailesi dahil yüzlerce AI modelini tutarlı bir uç nokta altında toplayan birleşik bir REST arayüzü sağlar; yerleşik API anahtarı yönetimi, kullanım kotaları ve faturalama panoları ile. Birden fazla satıcı URL'sini ve kimlik bilgilerini bir arada yürütmek yerine.

Başlamak için, modellerin yeteneklerini keşfedin Oyun Alanı ve danışın API kılavuzu Ayrıntılı talimatlar için. Erişimden önce, lütfen CometAPI'ye giriş yaptığınızdan ve API anahtarını edindiğinizden emin olun.

En son MiniMax‑M1 API entegrasyonu yakında CometAPI'de görünecek, bu yüzden bizi izlemeye devam edin! MiniMax‑M1 Model yüklemesini tamamlarken, diğer modellerimizi keşfedin Modeller sayfası veya bunları deneyin yapay zeka oyun alanı. MiniMax'ın CometAPI'deki en son Modeli Minimax ABAB7-Önizleme API'si ve MiniMax Video-01 API ,bakınız: