15 دسمبر 2025 تک دستیاب عوامی حقائق سے ظاہر ہوتا ہے کہ Google’s Gemini 3 Pro (preview) اور OpenAI’s GPT-5.2 دونوں نے استدلال، ملٹی ماڈیلٹی اور طویل سیاقی کام میں نئی سرحدیں قائم کی ہیں — لیکن ان کے انجینئرنگ راستے مختلف ہیں (Gemini → اسپارس MoE + بہت بڑا کانٹیکسٹ؛ GPT-5.2 → ڈینس/“روٹنگ” ڈیزائنز، کمپیکشن اور x-high ریزننگ موڈز) اور اسی بنا پر وہ بینچ مارک میں چوٹی کی جیتوں بمقابلہ انجینئرنگ کی پیشبینی پذیری، ٹولنگ اور ایکوسسٹم میں مختلف سمجھوتے کرتے ہیں۔ کون سا “بہتر” ہے یہ آپ کی بنیادی ضرورت پر منحصر ہے: انتہائی کانٹیکسٹ، ملٹی ماڈل ایجنٹک ایپلی کیشنز کے لیے رجحان Gemini 3 Pro کی طرف ہوگا؛ مستحکم انٹرپرائز ڈیولپر ٹولنگ، قابلِ پیشبینی لاگت اور فوری API دستیابی کے لیے GPT-5.2 موزوں ہے۔

GPT-5.2 کیا ہے اور اس کی نمایاں خصوصیات کیا ہیں؟

GPT-5.2، OpenAI کی 11 دسمبر 2025 کی ریلیز ہے (ورژنز: Instant، Thinking، Pro)۔ یہ کمپنی کے سب سے قابل ماڈل کے طور پر پوزیشنڈ ہے جو “پروفیشنل نالج ورک” کے لیے موزوں ہے — اسپریڈشیٹس، پریزنٹیشنز، طویل سیاقی استدلال، ٹول کالنگ، کوڈ جنریشن اور وژن ٹاسکس کے لیے بہتر بنایا گیا ہے۔ OpenAI نے GPT-5.2 کو ادائیگی کرنے والے ChatGPT صارفین اور OpenAI API (Responses API / Chat Completions) کے ذریعے دستیاب کر دیا ہے، جس کے ماڈل نام مثلاً gpt-5.2, gpt-5.2-chat-latest, اور gpt-5.2-pro ہیں۔

ماڈل کے ورژنز اور متوقع استعمال

- gpt-5.2 / GPT-5.2 (Thinking) — پیچیدہ، کثیر مرحلہ استدلال کے لیے بہترین (Responses API میں استعمال ہونے والا ڈیفالٹ “Thinking” فیملی ورژن)۔

- gpt-5.2-chat-latest / Instant — کم لیٹنسی کے روزمرہ اسسٹنٹ اور چیٹ استعمال کے لیے۔

- gpt-5.2-pro / Pro — سب سے زیادہ وفاداری/اعتماد کے ساتھ مشکل ترین مسائل کے لیے (اضافی کمپیوٹ،

reasoning_effort: "xhigh"کی سپورٹ)۔

کلیدی تکنیکی خصوصیات (یوزر کے نقطۂ نظر سے)

- Vision اور ملٹی ماڈل بہتریاں — تصاویر پر بہتر مکانی استدلال اور ویڈیو سمجھ بوجھ میں پیش رفت (جب Python ٹول کے ساتھ جوڑی جائے)، نیز کوڈ-Interpreter طرز کے ٹولز کے ذریعے اسنِپٹس چلانے کی سپورٹ۔

- Configurable reasoning effort (

reasoning_effort: none|minimal|low|medium|high|xhigh) تاکہ لیٹنسی/لاگت اور گہرائی کے درمیان توازن کیا جا سکے۔xhighGPT-5.2 کے لیے نیا ہے (اور Pro پر سپورٹڈ)۔ - بہتر طویل سیاق ہینڈلنگ اور کمپیکشن فیچرز تاکہ لاکھوں ٹوکنز تک کے سیاق پر استدلال کیا جا سکے (OpenAI کے مطابق MRCRv2 / لانگ-کانٹیکسٹ میٹرکس پر مضبوط نتائج)۔

- ایڈوانسڈ ٹول کالنگ اور ایجنٹک ورک فلو — ملٹی-ٹرن کوآرڈینیشن مزید مضبوط، “سنگل میگا-ایجنٹ” طرز کی آرکیٹیکچر میں ٹولز کی آرکسٹریشن بہتر (OpenAI نے Tau2-bench ٹول پرفارمنس کو نمایاں کیا)۔

Gemini 3 Pro Preview کیا ہے؟

Gemini 3 Pro Preview Google کا سب سے جدید جنریٹو AI ماڈل ہے، جو نومبر 2025 میں Gemini 3 فیملی کے حصے کے طور پر جاری ہوا۔ یہ ملٹی ماڈل سمجھ بوجھ پر زور دیتا ہے — متن، تصاویر، ویڈیو اور آڈیو کو سمجھنے اور ترکیب دینے کی صلاحیت — اور ایک بڑا کانٹیکسٹ ونڈو (تقریباً 1 ملین ٹوکنز) فراہم کرتا ہے تاکہ وسیع دستاویزات یا کوڈ بیسز کو ہینڈل کیا جا سکے۔

Google نے Gemini 3 Pro کو استدلال کی گہرائی اور نزاکت میں جدید ترین قرار دیا ہے، اور یہ متعدد ڈیولپر اور انٹرپرائز ٹولز کا بنیادی انجن ہے، جن میں Google AI Studio، Vertex AI، اور ایجنٹک ڈیولپمنٹ پلیٹ فارمز جیسے Google Antigravity شامل ہیں۔

فی الحال، Gemini 3 Pro پری ویو میں ہے — یعنی فعالیت اور رسائی ابھی وسعت پا رہی ہیں، مگر ماڈل پہلے ہی منطق، ملٹی ماڈل ادراک اور ایجنٹک ورک فلو کے بینچ مارکس میں بلند کارکردگی دکھا رہا ہے۔

تکنیکی و پروڈکٹ کی کلیدی خصوصیات

- Context window: Gemini 3 Pro Preview 1,000,000 ٹوکن ان پٹ کانٹیکسٹ ونڈو (اور 64k ٹوکن آؤٹ پٹ) سپورٹ کرتا ہے، جو ایک ہی درخواست میں انتہائی بڑی دستاویزات، کتب یا ویڈیو ٹرانسکرپٹس کو شامل کرنا ممکن بناتا ہے۔

- API خصوصیات:

thinking_levelپیرامیٹر (low/high) تاکہ لیٹنسی اور استدلال کی گہرائی میں توازن کیا جا سکے؛media_resolutionسیٹنگز ملٹی ماڈل وفاداری اور ٹوکن استعمال کو کنٹرول کرتی ہیں؛ سرچ گراؤنڈنگ، فائل/URL کانٹیکسٹ، کوڈ ایگزیکیوشن اور فنکشن کالنگ سپورٹڈ ہیں۔ Thought signatures اور context caching ملٹی کال ورک فلو میں اسٹیٹ برقرار رکھنے میں مدد کرتے ہیں۔ - Deep Think موڈ / بلند استدلال: “Deep Think” آپشن اضافی استدلال پاس دیتا ہے تاکہ مشکل بینچ مارکس پر اسکورز کو بڑھایا جا سکے۔ Google اسے پیچیدہ مسائل کے لیے علیحدہ ہائی-پرفارمنس راستے کے طور پر شائع کرتا ہے۔

- نیٹو ملٹی ماڈل سپورٹ: متن، تصویر، آڈیو اور ویڈیو ان پٹس کے ساتھ مضبوط گراؤنڈنگ (سرچ اور پروڈکٹ انٹیگریشنز)؛ Google نے Video-MMMU اور دیگر ملٹی ماڈل بینچ مارکس کو نمایاں کیا ہے۔

تیز نظر — GPT-5.2 بمقابلہ Gemini 3 Pro

اہم ترین حقائق کے ساتھ ایک مختصر تقابلی جدول (ذرائع حوالہ شدہ)۔

| Aspect | GPT-5.2 (OpenAI) | Gemini 3 Pro (Google / DeepMind) |

|---|---|---|

| Vendor / positioning | OpenAI — فلیگ شپ GPT-5.x اپ گریڈ جو پروفیشنل نالج ورک، کوڈنگ، اور ایجنٹک ورک فلو پر مرکوز ہے۔ | Google DeepMind / Google AI — فلیگ شپ Gemini جنریشن جو الٹرا لانگ-کانٹیکسٹ ملٹی ماڈل استدلال اور ٹول انٹیگریشن پر مرکوز ہے۔ |

| Main model flavors | Instant، Thinking، Pro (اور ان کے درمیان خودکار سوئچنگ)۔ Pro میں بلند تر reasoning effort شامل ہے۔ | Gemini 3 فیملی، جس میں Gemini 3 Pro اور Deep-Think موڈز شامل؛ ملٹی ماڈل/ایجنٹک فوکس۔ |

| Context window (input / output) | ~400,000 ٹوکن کُل ان پٹ گنجائش؛ 128,000 تک آؤٹ پٹ/ریزننگ ٹوکنز (بہت طویل دستاویزات اور کوڈ بیسز کے لیے ڈیزائنڈ)۔ | تقریباً ~1,000,000 ٹوکن ان پٹ/کانٹیکسٹ ونڈو (1M) اور 64K ٹوکنز تک آؤٹ پٹ |

| Key strengths / focus | طویل سیاقی استدلال، ایجنٹک ٹول-کالنگ، کوڈنگ، ساختہ دفتری کام (اسپریڈشیٹس، پریزنٹیشنز)؛ سیفٹی/سسٹم کارڈ اپ ڈیٹس قابلِ اعتماد ہونے پر زور دیتی ہیں۔ | بڑے پیمانے کی ملٹی ماڈل سمجھ بوجھ، استدلال + امیج کمپوزیشن، بہت بڑا کانٹیکسٹ + “Deep Think” ریزننگ موڈ، Google ایکوسسٹم میں مضبوط ٹول/ایجنٹ انٹیگریشنز۔ |

| Multimodal & image capabilities | وژن اور ملٹی ماڈل گراؤنڈنگ میں بہتری؛ ٹول استعمال اور دستاویزاتی تجزیے کے لیے ٹیوننگ۔ | ہائی-فِڈیلیٹی امیج جنریشن + استدلال-بہتر کمپوزیشن، ملٹی-ریفرنس امیج ایڈیٹنگ اور واضح/قابلِ مطالعہ ٹیکسٹ رینڈرنگ۔ |

| Latency / interactivity | وینڈر نے پچھلے GPT-5.x ماڈلز کے مقابلے میں تیز تر انفرنس اور فوری پرامپٹ ریسپانس پر زور دیا؛ متعدد درجات (Instant / Thinking / Pro)۔ | Google “Flash”/سرونگ کی آپٹیمائزیشن اور بہت سے فلو میں قابلِ موازنہ انٹرایکٹو اسپیڈز پر زور دیتا ہے؛ Deep Think موڈ گہرے استدلال کے بدلے لیٹنسی بڑھاتا ہے۔ |

| Notable features / differentiators | reasoning effort لیولز (medium/high/xhigh)، بہتر ٹول-کالنگ، اعلیٰ معیار کوڈ جنریشن، انٹرپرائز ورک فلو کے لیے بلند ٹوکن-افیشنسی۔ | 1M ٹوکن کانٹیکسٹ، مضبوط نیٹو ملٹی ماڈل اِن جَسٹ (ویڈیو/آڈیو)، “Deep Think” ریزننگ موڈ، Google پروڈکٹس (Docs/Drive/NotebookLM) کے ساتھ قریبی انٹیگریشنز۔ |

| Typical best uses (short) | طویل دستاویزاتی تجزیہ، ایجنٹک ورک فلو، پیچیدہ کوڈنگ پروجیکٹس، انٹرپرائز آٹومیشن (اسپریڈشیٹس/رپورٹس)۔ | انتہائی بڑے ملٹی ماڈل پروجیکٹس، 1M ٹوکن کانٹیکسٹ کے ساتھ طویل افق ایجنٹک ورک فلو، ایڈوانسڈ امیج + ریزننگ پائپ لائنز۔ |

GPT-5.2 اور Gemini 3 Pro ساخت کے لحاظ سے کیسے موازنہ ہوتے ہیں؟

بنیادی ساخت

- Benchmarks / حقیقی کام کی جانچ: GPT-5.2 Thinking نے GDPval (44 پیشوں پر نالج ورک ایوال) میں 70.9% جیت/برابری حاصل کی اور پچھلے GPT-5 ورژنز کے مقابلے انجینیئرنگ اور ریاضی کے بینچ مارکس پر بڑے اضافہ دکھائے۔ کوڈنگ (SWE-Bench Pro) اور ڈومین سائنس QA (GPQA Diamond) میں نمایاں بہتری۔

- ٹولنگ اور ایجنٹس: ٹول کالنگ، Python ایگزیکیوشن، اور ایجنٹک ورک فلو (دستاویزاتی تلاش، فائل تجزیہ، ڈیٹا سائنس ایجنٹس) کے لیے مضبوط اندرونی سپورٹ۔ کچھ GDPval ٹاسکس میں انسانی ماہرین کے مقابلے 11x رفتار / <1% لاگت (ممکنہ معاشی قدر کی پیمائش، 70.9% بمقابلہ پہلے ~38.8%)، اور اسپریڈشیٹ ماڈلنگ میں ٹھوس بہتری (مثلاً GPT-5.1 کے مقابلے جونیئر انویسٹمنٹ بینکنگ ٹاسک پر +9.3%)۔

- Gemini 3 Pro: Sparse Mixture-of-Experts Transformer (MoE)۔ ماڈل فی ٹوکن چند ایکسپرٹس کو ایکٹیویٹ کرتا ہے، جس سے انتہائی بڑے کل پیرامیٹر کیپسٹی ممکن ہوتی ہے جبکہ فی ٹوکن کمپیوٹ سب-لینیئر رہتا ہے۔ Google کے ماڈل کارڈ کے مطابق اسپارس MoE ڈیزائن کارکردگی کے پروفائل میں بنیادی کردار ادا کرتا ہے۔ یہ آرکیٹیکچر بغیر لینیئر انفرنس لاگت کے ماڈل کیپسٹی بہت آگے تک بڑھانے کو ممکن بناتا ہے۔

- GPT-5.2 (OpenAI): OpenAI GPT-5 فیملی میں Transformer بنیاد پر روٹنگ/کمپیکشن حکمت عملیاں استعمال کرتا ہے (ایک “راوٹر” مختلف موڈز — Instant بمقابلہ Thinking — کو ٹرگر کرتا ہے، اور کمپنی لمبے سیاق کے لیے کمپیکشن اور ٹوکن-مینجمنٹ ٹیکنیکس کو دستاویزی بناتی ہے)۔ GPT-5.2 “جوابدہی سے پہلے سوچنے” کی تربیت/جانچ اور طویل افقی ٹاسکس کے لیے کمپیکشن پر زور دیتا ہے، بجائے اس کے کہ بڑے پیمانے پر کلاسک اسپارس-MoE کے اعلان کرے۔

ساختی فرق کے اثرات

- لیٹنسی اور لاگت کے سمجھوتے: MoE ماڈلز جیسے Gemini 3 Pro بہت سے ٹاسکس پر فی ٹوکن بلند تر عروجی قابلیت فراہم کر سکتے ہیں جبکہ انفرنس لاگت کم رکھتے ہیں، کیونکہ صرف چند ایکسپرٹس چلتے ہیں۔ تاہم، یہ سرونگ اور شیڈولنگ میں پیچیدگی بڑھا سکتے ہیں (کولڈ-اسٹارٹ ایکسپرٹ بیلنسنگ، IO)۔ GPT-5.2 کا طریقہ (ڈینس/روٹڈ مع کمپیکشن) قابلِ پیشبینی لیٹنسی اور ڈیولپر ایروگانومکس کو ترجیح دیتا ہے — خاص طور پر جب Responses، Realtime، Assistants اور بیچ APIs جیسے قائم شدہ OpenAI ٹولنگ کے ساتھ مربوط ہو۔

- طویل کانٹیکسٹ کی اسکیلنگ: Gemini کا 1M ان پٹ ٹوکنز والا فیچر آپ کو انتہائی طویل دستاویزات اور ملٹی ماڈل اسٹریمز کو نیٹو طور پر فیڈ کرنے دیتا ہے۔ GPT-5.2 کا تقریباً 400k مشترک کانٹیکسٹ (ان پٹ + آؤٹ پٹ) بھی بہت بڑا ہے اور زیادہ تر انٹرپرائز ضروریات پوری کرتا ہے، لیکن Gemini کے 1M سے چھوٹا ہے۔ بہت بڑے کارپس یا کئی گھنٹوں کے ویڈیو ٹرانسکرپٹس کے لیے Gemini کی اسپیکس واضح تکنیکی برتری دیتی ہیں۔

ٹولنگ، ایجنٹس، اور ملٹی ماڈل انفراسٹرکچر

- OpenAI: ٹول کالنگ، Python ایگزیکیوشن، “Pro” ریزننگ موڈز، اور ادائیگی والے ایجنٹ ایکوسسٹمز (ChatGPT Agents / انٹرپرائز ٹول انٹیگریشنز) کے ساتھ گہری انٹیگریشن۔ کوڈ-سنٹرک ورک فلوز اور اسپریڈشیٹس/سلائیڈز کی جنریشن بطور فرسٹ-کلاس آؤٹ پٹس فوکس میں۔

- Google / Gemini: Google Search گراؤنڈنگ (اختیاری بل شدہ فیچر)، کوڈ ایگزیکیوشن، URL اور فائل کانٹیکسٹ، اور میڈیا ریزولیوشن کنٹرولز کے ساتھ بلٹ-اِن سپورٹ، تاکہ ٹوکنز بمقابلہ بصری وفاداری میں توازن ہو۔ API میں

thinking_levelاور دیگر نوبز لاگت/لیٹنسی/کوالٹی ٹیوننگ کے لیے موجود ہیں۔

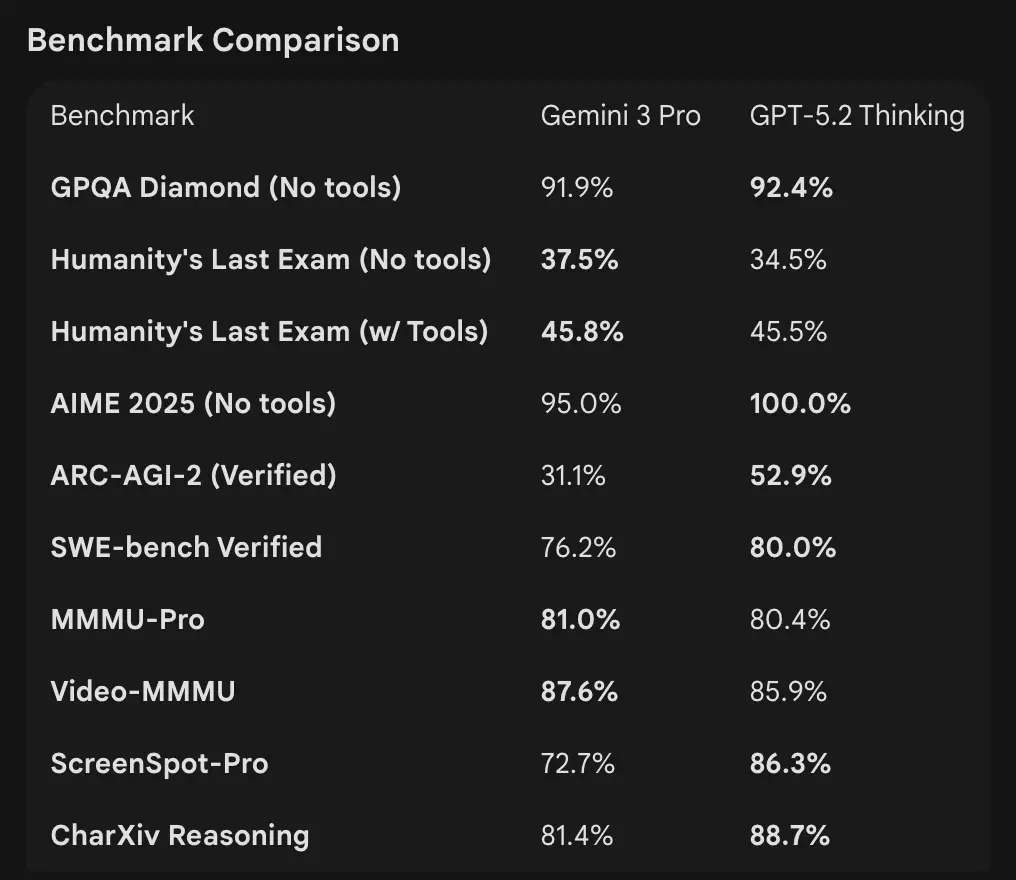

بینچ مارک نمبرز کا تقابل کیسا ہے

کانٹیکسٹ ونڈوز اور ٹوکن ہینڈلنگ

- Gemini 3 Pro Preview: 1,000,000 ان پٹ ٹوکنز / 64k آؤٹ پٹ ٹوکنز (Pro پری ویو ماڈل کارڈ)۔ علمی کٹ آف: جنوری 2025 (Google)۔

- GPT-5.2: OpenAI نے طویل کانٹیکسٹ کارکردگی (MRCRv2 اسکورز 4k–256k نیڈل ٹاسکس پر >85–95% رینجز کئی سیٹنگز میں) اور کمپیکشن فیچرز دکھائے؛ OpenAI کے عوامی کانٹیکسٹ مثالیں بہت بڑے کانٹیکسٹ پر بھی مضبوط کارکردگی ظاہر کرتی ہیں مگر OpenAI ورژن-متعلقہ ونڈوز کی فہرست دیتا ہے (اور ایک واحد 1M نمبر کے بجائے کمپیکشن پر زور دیتا ہے)۔ API استعمال کے لیے ماڈل نام

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-proہیں۔

استدلال اور ایجنٹک بینچ مارکس

- OpenAI (منتخب): Tau2-bench Telecom 98.7% (GPT-5.2 Thinking)، ملٹی-اسٹیپ ٹول استعمال اور ایجنٹک ٹاسکس میں بڑے اضافہ (OpenAI نے ملٹی-ایجنٹ سسٹمز کو “میگا-ایجنٹ” میں سمونے کو نمایاں کیا)۔ GPQA Diamond اور ARC-AGI میں GPT-5.1 کے مقابلے نمایاں بہتری۔

- Google (منتخب): Gemini 3 Pro: LMArena 1501 Elo، MMMU-Pro 81%، Video-MMMU 87.6%، GPQA اور Humanity’s Last Exam پر بلند اسکورز؛ Google نے ایجنٹک مثالوں کے ذریعے طویل افق منصوبہ بندی بھی دکھائی۔

ٹولنگ اور ایجنٹس:

GPT-5.2: ٹول کالنگ، Python ایگزیکیوشن، اور ایجنٹک ورک فلو (دستاویزاتی تلاش، فائل تجزیہ، ڈیٹا سائنس ایجنٹس) کے لیے مضبوط بلٹ-اِن سپورٹ۔ کچھ GDPval ٹاسکس میں انسانی ماہرین کے مقابلے 11x رفتار / <1% لاگت (ممکنہ معاشی قدر کی پیمائش ، 70.9% بمقابلہ پہلے ~38.8%)، اور اسپریڈشیٹ ماڈلنگ میں ٹھوس بہتری (مثلاً GPT-5.1 کے مقابلے جونیئر انویسٹمنٹ بینکنگ ٹاسک پر +9.3%)۔

تشریح: بینچ مارکس ایک دوسرے کے تکملہ ہیں — OpenAI نے حقیقی دنیا کے نالج ورک بینچ مارکس (GDPval) پر زور دیا جن سے ظاہر ہوتا ہے کہ GPT-5.2 پروڈکشن ٹاسکس جیسے اسپریڈشیٹس، سلائیڈز، اور طویل ایجنٹک سلسلوں میں ممتاز ہے۔ Google نے خام استدلال لیڈر بورڈز اور بہت بڑے سنگل-ریکوئسٹ کانٹیکسٹ ونڈوز پر زور دیا۔ کس بات کی زیادہ اہمیت ہے یہ آپ کے ورک لوڈ پر منحصر ہے: ایجنٹک، طویل دستاویزی انٹرپرائز پائپ لائنز GPT-5.2 کی ثابت شدہ GDPval کارکردگی سے فائدہ اٹھاتی ہیں؛ وسیع خام کانٹیکسٹ (جیسے مکمل ویڈیو کارپس/پوری کتابیں ایک پاس میں) کی اِن جَسٹ کے لیے Gemini کا 1M ان پٹ ونڈو زیادہ پُرکشش ہے۔

ملٹی ماڈل صلاحیتوں کا تقابل کیسے ہے؟

ان پٹس اور آؤٹ پٹس

- Gemini 3 Pro Preview: متن، تصویر، ویڈیو، آڈیو، PDF ان پٹس اور متن آؤٹ پٹس سپورٹ؛ Google

media_resolutionکے گرینولر کنٹرولز اورthinking_levelپیرامیٹر فراہم کرتا ہے تاکہ ملٹی ماڈل کام کے لیے لاگت بمقابلہ وفاداری ٹیون کی جا سکے۔ آؤٹ پٹ ٹوکن کیپ 64k؛ ان پٹ 1M ٹوکنز تک۔ - GPT-5.2: بھرپور وژن اور ملٹی ماڈل ورک فلو سپورٹ؛ OpenAI نے بہتر مکانی استدلال (امیج کمپوننٹ باؤنڈنگ/لیبلنگ) اور ویڈیو سمجھ بوجھ (Video MMMU اسکورز) کو نمایاں کیا اور ٹول-Enabled وژن (Python ٹول کے ساتھ) سے اسکورز میں بہتری دکھائی۔ GPT-5.2 پر زور ہے کہ پیچیدہ وژن + کوڈ ٹاسکس میں ٹول سپورٹ (Python کوڈ ایگزیکیوشن) بہت فائدہ دیتی ہے۔

عملی فرق

Granularity بمقابلہ وسعت: Gemini ملٹی ماڈل نوبز (media_resolution، thinking_level) کا سوٹ پیش کرتا ہے تاکہ ڈیولپرز ہر میڈیا ٹائپ کے لیے ٹریڈ آف ٹیون کر سکیں۔ GPT-5.2 مربوط ٹول-یوز پر زور دیتا ہے (لوپ میں Python چلانا) تاکہ وژن، کوڈ اور ڈیٹا ٹرانسفارمیشن ٹاسکس مل کر کام کریں۔ اگر آپ کا استعمال بھاری ویڈیو + امیج اینالیسس کے ساتھ انتہائی بڑے کانٹیکسٹ کا متقاضی ہے تو Gemini کا 1M کانٹیکسٹ پرکشش ہے؛ اگر آپ کے ورک فلو میں لوپ میں کوڈ ایگزیکیوشن (ڈیٹا ٹرانسفارمیشن، اسپریڈشیٹ جنریشن) درکار ہے تو GPT-5.2 کی کوڈ ٹولنگ اور ایجنٹ-فرینڈلی نیچر زیادہ سہل ہو سکتی ہے۔

API ایکسیس، SDKs اور پرائسنگ کے بارے میں کیا خیال ہے؟

OpenAI GPT-5.2 (API اور پرائسنگ)

- API:

gpt-5.2,gpt-5.2-chat-latest,gpt-5.2-proبذریعہ Responses API / Chat Completions۔ مستحکم SDKs (Python/JS)، کُک بُک گائیڈز اور پختہ ایکوسسٹم۔ - Pricing (public): $1.75 / 1M ان پٹ ٹوکنز اور $14 / 1M آؤٹ پٹ ٹوکنز؛ کیشنگ ڈسکاؤنٹس (Cached inputs پر 90%) بار بار کے ڈیٹا کے لیے مؤثر لاگت گھٹاتے ہیں۔ OpenAI ٹوکن افیشنسی پر زور دیتا ہے (فی ٹوکن قیمت بلند مگر مطلوبہ کوالٹی تک پہنچنے کے لیے کل لاگت کم)۔

Gemini 3 Pro Preview (API اور پرائسنگ)

- API:

gemini-3-pro-previewبذریعہ Google GenAI SDK اور Vertex AI/GenerativeLanguage اینڈ پوائنٹس۔ نئے پیرامیٹرز (thinking_level,media_resolution) اور Google گراؤنڈنگز/ٹولز کے ساتھ انٹیگریشن۔ - Pricing (public preview): تقریباً $2 / 1M ان پٹ ٹوکنز اور $12 / 1M آؤٹ پٹ ٹوکنز پری ویو ٹائرز (200k ٹوکنز سے کم) کے لیے؛ Search گراؤنڈنگ، Maps یا دیگر Google سروسز کے لیے اضافی چارجز لاگو ہو سکتے ہیں (Search گراؤنڈنگ بلنگ 5 جنوری 2026 سے شروع)۔

CometAPI کے ذریعے GPT-5.2 اور Gemini 3 دونوں استعمال کریں

CometAPI ایک گیٹ وے/ایگریگیٹر API ہے: ایک واحد، OpenAI-اسٹائل REST API اینڈ پوائنٹ جو آپ کو متعدد وینڈرز کے سینکڑوں ماڈلز (LLMs، امیج/ویڈیو ماڈلز، ایمبیڈنگ ماڈلز وغیرہ) تک متحدہ رسائی دیتا ہے۔ متعدد وینڈر SDKs کو ضم کرنے کے بجائے، CometAPI مانوس OpenAI-فارمیٹ اینڈ پوائنٹس (chat/completions/embeddings/images) فراہم کرتا ہے جبکہ اندرونی طور پر ماڈلز یا وینڈرز بدلے جا سکتے ہیں۔

ڈیولپرز ایک ہی وقت میں دو مختلف کمپنیوں کے فلیگ شپ ماڈلز سے لطف اندوز ہو سکتے ہیں CometAPI کے ذریعے، وینڈر بدلے بغیر، اور API قیمتیں زیادہ سستی ہوتی ہیں، عموماً 20% کم۔

مثال: فوری API اسنیپٹس (کاپی-پیست کر کے آزمائیں)

ذیل میں کم سے کم مثالیں ہیں جو آپ چلا سکتے ہیں۔ یہ وینڈرز کے شائع شدہ کوئک اسٹارٹس (OpenAI Responses API + Google GenAI کلائنٹ) کی عکاسی کرتی ہیں۔ $OPENAI_API_KEY / $GEMINI_API_KEY اپنی چابیاں سے بدلیں۔

GPT-5.2 — Python (OpenAI Responses API، گہرے مسائل کے لیے reasoning کو xhigh پر سیٹ)

# Python (requires openai SDK that supports responses API)from openai import OpenAIclient = OpenAI(api_key="YOUR_OPENAI_API_KEY")resp = client.responses.create( model="gpt-5.2-pro", # gpt-5.2 or gpt-5.2-pro input="Summarize this 50k token company report and output a 10-slide presentation outline with speaker notes.", reasoning={"effort": "xhigh"}, # deeper reasoning max_output_tokens=4000)print(resp.output_text) # or inspect resp to get structured outputs / tokens

نوٹس: reasoning.effort آپ کو لاگت بمقابلہ گہرائی میں توازن کرنے دیتا ہے۔ روزمرہ چیٹ طرز کے لیے gpt-5.2-chat-latest استعمال کریں۔ OpenAI ڈاکس میں responses.create کی مثالیں موجود ہیں۔

GPT-5.2 — curl (سادہ)

curl https://api.openai.com/v1/responses \ -H "Authorization: Bearer $OPENAI_API_KEY" \ -H "Content-Type: application/json" \ -d '{ "model": "gpt-5.2", "input": "Write a Python function that converts a PDF with tables into a normalized CSV with typed columns.", "reasoning": {"effort":"high"} }'

(JSON میں output_text یا اسٹرکچرڈ آؤٹ پٹس دیکھیں۔)

Gemini 3 Pro Preview — Python (Google GenAI کلائنٹ)

# Python (google genai client) — example from Google docsfrom google import genaiclient = genai.Client(api_key="YOUR_GEMINI_API_KEY")response = client.models.generate_content( model="gemini-3-pro-preview", contents="Find the race condition in this multi-threaded C++ snippet: <paste code here>", config={ "thinkingConfig": {"thinking_level": "high"} })print(response.text)

نوٹس: thinking_level ماڈل کی داخلی غور و فکر کو کنٹرول کرتا ہے؛ تصاویر/ویڈیوز کے لیے media_resolution سیٹ کیا جا سکتا ہے۔ REST اور JS مثالیں Google کی Gemini ڈیو گائیڈ میں ہیں۔

Gemini 3 Pro — curl (REST)

curl "https://generativelanguage.googleapis.com/v1beta/models/gemini-3-pro-preview:generateContent" \ -H "x-goog-api-key: $GEMINI_API_KEY" \ -H "Content-Type: application/json" \ -X POST \ -d '{ "contents": [{ "parts": [{"text": "Explain the race condition in this C++ code: ..."}] }], "generationConfig": {"thinkingConfig": {"thinkingLevel": "high"}} }'

Google کی ڈاکس میں ملٹی ماڈل مثالیں شامل ہیں (امیج اِن لائن ڈیٹا، media_resolution)۔

کون سا ماڈل “بہتر” ہے — عملی رہنمائی

کوئی ایک ہی حل ہر جگہ موزوں نہیں؛ انتخاب استعمال کے کیس اور پابندیوں پر منحصر ہے۔ ذیل ایک مختصر فیصلہ جاتی میٹرکس ہے۔

GPT-5.2 منتخب کریں اگر:

- آپ کو کوڈ-ایگزیکیوشن ٹولز (OpenAI کے interpreter/ٹول ایکوسسٹم) کے ساتھ گہری انٹیگریشن درکار ہو — پروگراماتی ڈیٹا پائپ لائنز، اسپریڈشیٹ جنریشن، یا ایجنٹک کوڈ ورک فلوز کے لیے۔ OpenAI نے Python ٹول میں بہتری اور میگا-ایجنٹ استعمال کو نمایاں کیا۔

- آپ ٹوکن افیشنسی کو ترجیح دیتے ہیں اور Cached inputs پر بڑے ڈسکاؤنٹس کے ساتھ واضح، قابلِ پیشبینی OpenAI فی-ٹوکن پرائسنگ چاہتے ہیں (بیچ/پروڈکشن ورک فلوز میں مفید)۔

- آپ OpenAI ایکوسسٹم چاہتے ہیں (ChatGPT پروڈکٹ انٹیگریشن، Azure/Microsoft شراکتیں، اور Responses API اور Codex کے گرد ٹولنگ)۔

Gemini 3 Pro منتخب کریں اگر:

- آپ کو انتہائی ملٹی ماڈل ان پٹ (ویڈیو + امیجز + آڈیو + PDFs) چاہیے اور ایک ایسا واحد ماڈل چاہتے ہیں جو نیٹو طور پر ان سب کو 1,000,000 ٹوکن ان پٹ ونڈو کے ساتھ قبول کرے۔ Google اسے طویل ویڈیوز، بڑی دستاویز + ویڈیو پائپ لائنز، اور Interactive Search/AI Mode استعمال کے کیسز کے لیے واضح طور پر مارکیٹ کرتا ہے۔

- آپ Google Cloud / Vertex AI پر بناتے ہیں اور Google سرچ گراؤنڈنگ، Vertex پروویژننگ، اور GenAI کلائنٹ APIs کے ساتھ قریبی انٹیگریشن چاہتے ہیں۔ آپ Google پروڈکٹ انٹیگریشنز (Search AI Mode، AI Studio، Antigravity ایجنٹ ٹولنگ) سے فائدہ اٹھائیں گے۔

نتیجہ: 2026 میں کون بہتر ہے؟

GPT-5.2 بمقابلہ Gemini 3 Pro Preview میں جواب سیاق پر منحصر ہے:

- GPT-5.2 پروفیشنل نالج ورک، تحلیلی گہرائی، اور ساختہ ورک فلوز میں آگے ہے۔

- Gemini 3 Pro Preview ملٹی ماڈل سمجھ بوجھ، مربوط ایکوسسٹمز، اور بڑے کانٹیکسٹ والے ٹاسکس میں ممتاز ہے۔

کوئی بھی ماڈل عالمگیر طور پر “بہتر” نہیں — بلکہ ان کی طاقتیں حقیقی دنیا کی مختلف ضروریات کو پورا کرنے میں ایک دوسرے کی تکمیل کرتی ہیں۔ سمجھدار اپنانے والے ماڈل کا انتخاب اپنے مخصوص استعمالی کیسز، بجٹ پابندیوں، اور ایکوسسٹم الائنمنٹ سے ہم آہنگ کریں۔

اگر آپ فوراً آزمانا چاہتے ہیں، تو GPT-5.2 اور Gemini 3 Pro کی صلاحیتیں CometAPI کے Playground میں دیکھیں اور تفصیلی ہدایات کے لیے API گائیڈ سے رجوع کریں۔ ایکسیس سے پہلے، براہِ کرم یقینی بنائیں کہ آپ CometAPI میں لاگ اِن ہیں اور API key حاصل کر چکے ہیں۔ CometAPI سرکاری قیمت سے کہیں کم قیمت پیش کرتا ہے تاکہ آپ کے انضمام میں مدد ملے۔

Ready to Go?→ Free trial of GPT-5.2 and Gemini 3 Pro !

If you want to