OpenAI نے حال ہی میں کئی اپ ڈیٹس کا اعلان کیا ہے، بشمول GPT-5-Codex-Mini ماڈل کی ریلیز، کثیر صارف کے درجہ بندی کے لیے شرح کی حد میں بہتری، اور ماڈل پروسیسنگ کی کارکردگی میں اصلاح۔

اوپن اے آئی GPT-5-Codex-Mini GPT-5-Codex کا ایک نیا اعلان کردہ، ڈویلپر فوکسڈ ویرینٹ ہے: ایک چھوٹا، لاگت اور تھرو پٹ-آپٹمائزڈ ماڈل جس کا مقصد GPT-5-Codex کی زیادہ تر کوڈنگ امداد فراہم کرنا ہے لیکن بہت کم قیمت اور زیادہ قابل استعمال والیوم پر۔ "منی" ویرینٹ کو طویل کوڈنگ سیشنز، بیک گراؤنڈ آٹومیشن، اور ہائی فریکوئنسی ڈویلپر ورک فلو کے لیے ایک عملی انتخاب کے طور پر رکھا گیا ہے جہاں ایک ہی پلان کے لیے مزید ٹوکن/درخواستیں حاصل کرنے سے خام چوٹی کی صلاحیت کم اہم ہے۔

GPT-5-Codex-Mini اور اس کی خصوصیت کیا ہے؟

GPT-5-Codex-Mini OpenAI کے GPT-5-Codex فیملی کا ایک کمپیکٹ، لاگت سے موثر ویرینٹ ہے جو خاص طور پر کوڈیکس پروڈکٹ کی سطحوں (CLI اور IDE انٹیگریشن) کے لیے پیک کیا گیا ہے۔ اسے ایک "چھوٹے، زیادہ لاگت کے قابل" ماڈل کے طور پر رکھا گیا ہے جو مادی طور پر کم وسائل کی کھپت اور انٹرایکٹو ڈویلپر ورک فلو کے لیے زیادہ قابل استعمال کوٹہ کے لیے تھوڑی مقدار میں اعلیٰ صلاحیت کی تجارت کرتا ہے۔ منی ماڈل کا مقصد ڈویلپرز کو مزید کوڈنگ موڑ چلانے دینا ہے (OpenAI تقریباً بیان کرتا ہے 4× مزید استعمال اسی چیٹ جی پی ٹی سبسکرپشن ٹائر کے لیے) عام، اچھی طرح سے طے شدہ انجینئرنگ کاموں کے لیے تاخیر اور لاگت کو کم کرتے ہوئے

صلاحیتوں کے لحاظ سے، GPT-5-Codex-Mini کوڈیکس پروڈکٹ لائن کی بنیادی خصوصیات وراثت میں ملتی ہیں: کوڈبیس کی گہری سمجھ اور "ایجنٹ" کے انداز میں ملٹی سٹیپ کاموں کو انجام دینا۔ کوڈیکس سی ایل آئی کی خصوصیات کی بنیاد پر، ڈویلپرز ایک انٹرایکٹو ٹرمینل میں کوڈیکس کو قدرتی زبان کے حکم، کوڈ کے ٹکڑوں، اسکرین شاٹس، یا انٹرفیس ڈیزائن کے خاکے جمع کر سکتے ہیں۔ ماڈل پہلے ایک منصوبہ فراہم کرے گا، اور پھر خود بخود فائلوں کو براؤز کرے گا، کوڈ میں ترمیم کرے گا، کمانڈز چلاے گا، اور صارف کی منظوری حاصل کرنے کے بعد ٹیسٹ کرے گا۔

موڈل نقطہ نظر سے، کوڈیکس مصنوعات ٹرمینل یا IDE میں سیشن میں تصاویر (جیسے UI اسکرین شاٹس، ڈیزائن ڈرافٹ، یا ایرر میسج اسکرین شاٹس) کو منسلک کرنے کی اجازت دیتی ہیں۔ ماڈل متن اور تصویری مواد دونوں کو سمجھ سکتا ہے، لیکن آؤٹ پٹ اب بھی بنیادی طور پر ٹیکسٹ کوڈ اور وضاحت ہے۔ لہذا، GPT-5-Codex-Mini کو ایک کوڈ پراکسی ماڈل کے طور پر سمجھا جا سکتا ہے جو بنیادی طور پر "ٹیکسٹ + امیج ان پٹ، ٹیکسٹ آؤٹ پٹ" ہے، اور امیج جنریشن، آڈیو جنریشن یا ویڈیو جنریشن جیسے کام نہیں کرتا ہے۔

GPT-5-Codex-Mini کا موازنہ GPT-5-Codex سے کیسے ہوتا ہے؟

کوڈیکس میں نیا کیا ہے؟

GPT-5-Codex-Mini realsed کے علاوہ، OpenAI نے ChatGPT Plus، Business، اور Edu صارف کی سطح کے لیے Codex کی شرح کی حد میں یکساں طور پر 50% اضافہ کیا ہے، جس سے دستیاب درخواست کی حد میں نمایاں اضافہ ہوا ہے۔ دریں اثنا، ChatGPT پرو صارفین جوابی رفتار اور ٹاسک پر عمل درآمد کے تجربے کو بہتر بنانے کے لیے ترجیحی پروسیسنگ کی اجازتیں حاصل کریں گے۔

مزید برآں، OpenAI نے GPT-5-Codex ماڈل میں ایک معمولی اپ گریڈ کیا ہے، جس سے باہمی تعاون کے حالات میں اپنی کارکردگی کو بہتر بنایا گیا ہے۔ اپ ڈیٹ شدہ ماڈل کلیدی تشخیصی میٹرکس پر کئی فیصد پوائنٹس کی بہتری، ٹوکن کے استعمال کی کارکردگی میں تقریباً 3% اضافہ، اور ایج کیسز کو سنبھالنے میں زیادہ مضبوطی کو ظاہر کرتا ہے، اس طرح صارف کی رہنمائی کی ضرورت کو کم کرتا ہے۔

| صارف کی سطح | GPT-5-Codex | GPT-5-Codex-Mini |

|---|---|---|

| پلس/بز/ایڈو | پیغام کے حجم کو بالترتیب 1.5 گنا بڑھاتا ہے۔ | پیغام کے حجم کو بالترتیب 6x بڑھاتا ہے۔ |

GPT-5-Codex-Mini بمقابلہ GPT-5-Codex: بینچ مارک فرق

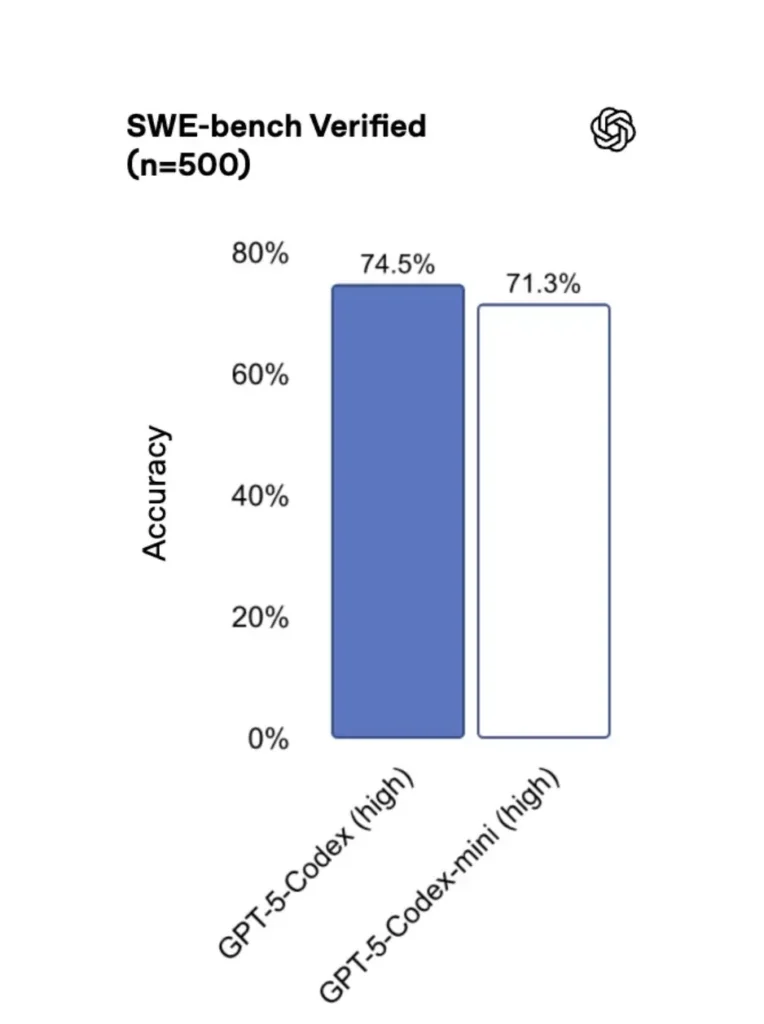

GPT-5-Codex-Mini اصل ورژن کے مقابلے میں، اس کی کارکردگی قدرے کم ہے، لیکن ڈویلپرز کو استعمال کا کریڈٹ تقریباً چار گنا ملتا ہے۔ SWE- بنچ تصدیق شدہ ٹیسٹ میں، GPT-5 ہائی نے 72.8%، GPT-5-Codex نے 74.5%، اور GPT-5-Codex-Mini نے 71.3% اسکور کیا۔

کوڈیکس (اور اس کا منی ویرینٹ) ہلکے پھلکے تعاملات کے لیے ڈرامائی طور پر کم ٹوکنز کا استعمال کرتا ہے — اوپن اے آئی کا مواد سادہ اشارے کے لیے دسیوں فیصد پوائنٹس کی ترتیب پر کمی کا دعویٰ کرتا ہے (مثلاً، ایک حوالہ دیا گیا اعداد و شمار ≈93.7% کم ٹوکن کچھ منظرناموں میں کوڈیکس فیملی بمقابلہ GPT-5 کے لیے ہلکے پھلکے تعاملات پر)۔

GPT-5-Codex-Mini بمقابلہ GPT-5-Codex: خصوصیت کے فرق

- سائز اور قیمت: منی واضح طور پر چھوٹا اور زیادہ لاگت والا ہے۔ OpenAI اسے اسی رکنیت کی پابندیوں کے تحت تقریباً 4× مزید استعمال کے قابل بناتا ہے۔ یہ روٹین ڈویلپر کے کاموں کے لیے کوٹہ/کارکردگی کی اصلاح ہے۔

- قابلیت کا لفافہ: GPT-5-Codex طویل، پیچیدہ ایجنٹی کاموں (بڑے ریفیکٹرز، گہرے کوڈ کے جائزے، توسیعی ٹیسٹ سائیکل) کے لیے اعلیٰ صلاحیت کا اختیار ہے۔ بار بار مختصر تعاملات کے لیے منی کو تیز تر اور کم وسائل کے لیے بنایا گیا ہے۔

- تاخیر اور شرح کی حدود: Mini عام طور پر کم تاخیر فراہم کرتا ہے اور فی منصوبہ زیادہ شرح کی حد کی اجازت دیتا ہے — اسے گھنے، متعامل ورک فلو کے لیے موزوں بناتا ہے۔

- پہلے سے طے شدہ سطحیں: Mini کوڈیکس CLI اور IDE ایکسٹینشن میں قابل انتخاب ماڈل کے طور پر دستیاب ہے۔ GPT-5-Codex کوڈیکس میں کلاؤڈ ٹاسک اور گہرے کوڈ ریویو فلو کے لیے ڈیفالٹ ہے۔

منی بمقابلہ مکمل کوڈیکس کب استعمال کریں۔

- استعمال مینی کے لیے: سہاروں، بار بار کوڈ جنریشن، چھوٹے ریفیکٹرز، ترمیم کے دوران انٹرایکٹو تکمیل، اور جب کوٹہ یا لاگت کی پابندی کے تحت کام کرنا۔

- استعمال GPT-5-Codex کے لیے: جامع کوڈ کے جائزے، کئی گھنٹے کے خود مختار کام، پیچیدہ ریفیکٹرز، اور ایسے کام جن کے لیے ماڈل کی مضبوط ترین استدلال اور ٹیسٹ پر مبنی عمل درآمد کی ضرورت ہوتی ہے۔

میں GPT-5-Codex-Mini (CLI، IDE، API) تک کیسے رسائی حاصل کر سکتا ہوں؟

کوڈیکس سی ایل آئی (ٹرمینل فرسٹ)

اوپن اے آئی متعارف کرایا gpt-5-codex-mini کوڈیکس CLI کے اندر ایک ماڈل آپشن کے طور پر۔ عام استعمال کے نمونے Codex CLI ورک فلو کی پیروی کرتے ہیں: ایک انٹرایکٹو سیشن شروع کریں، ماڈل کی وضاحت کریں، فائلیں یا اسکرین شاٹس منسلک کریں، "Codex Cloud ٹاسک" چلائیں اور مزید بہت کچھ۔ CLI بھی فوری سپورٹ کرتا ہے۔ /model مکمل کے درمیان سوئچنگ gpt-5-codex اور gpt-5-codex-mini. پہلی بار چلانے پر، آپ کو اپنے ChatGPT/Pro/Enterprise اکاؤنٹ (یا API کلید فراہم کریں) کا استعمال کرتے ہوئے تصدیق کرنے کی ضرورت ہوگی۔ CLI مختلف کمانڈز فراہم کرتا ہے جو Codex کو کوڈ بیس اسکین کرنے، ٹیسٹ چلانے، REPLs کھولنے، یا پیچ کی سفارشات کو لاگو کرنے کے قابل بناتا ہے۔

مثال (کوڈیکس CLI انٹرایکٹو سیشن):

# Install Codex CLI (npm)

npm i -g @openai/codex

# or Homebrew on macOS

brew install --cask codex

# Launch in a repo

cd myproject

# Open a codex interactive session

codex

# In the session you can switch the model:

# (this is typed in the Codex TUI)

> /model gpt-5-codex-mini

# Ask Codex to generate a unit test

> Write pytest tests for function `calculate_discount` in discounts.py

یہ بہاؤ نئے کوڈیکس CLI ڈیفالٹس کا آئینہ دار ہے جہاں ٹول استعمال کی حد کے قریب Mini تجویز کرے گا۔

VS کوڈ / IDE توسیع

ہاں — کوڈیکس IDE ایکسٹینشن (VS Code) پہلے سے ہی شامل ہے۔ gpt-5-codex-mini ایک اختیار کے طور پر. ان لائن کوڈ کی تکمیل، ری فیکٹرنگ کی تجاویز، اور AI سے چلنے والی فوری اصلاحات حاصل کرنے کے لیے Visual Studio Code میں Codex ایکسٹینشن انسٹال کریں۔ ایکسٹینشن فوری کارروائیوں کو بھی ظاہر کرتی ہے (کوڈ تیار کریں، منتخب کوڈ کی وضاحت کریں، ریفیکٹر) اور ایڈیٹر سے کوڈیکس کلاؤڈ ٹاسک چلا سکتے ہیں، VS کوڈ کے اقدامات:

- VS کوڈ کے لیے OpenAI Codex / ChatGPT ایکسٹینشن انسٹال کریں۔

- اپنے ChatGPT اکاؤنٹ (Plus/Pro/Business) کے ساتھ سائن ان کریں۔

- کمانڈ پیلیٹ کھولیں:

Cmd/Ctrl+Shift+P → Codex: Set Model→ منتخب کریں۔gpt-5-codex-mini. - ان لائن کمانڈز استعمال کریں (کوڈ منتخب کریں → دائیں کلک کریں → "کوڈیکس کے ساتھ وضاحت کریں" یا کنفیگرڈ ہاٹکی دبائیں)۔

مثال: VS کوڈ ان لائن کمانڈ (سیڈو اقدامات)

- میں ایک فنکشن منتخب کریں۔

user_service.py. - پریس

Cmd/Ctrl+Shift+P → Codex: Explain Selectionیا دائیں کلک کا استعمال کریں → "کوڈیکس کے ساتھ وضاحت کریں۔" - ایکسٹینشن مینی کی وضاحت، تجویز کردہ ٹیسٹس، اور ایک کلک پر "پی آر بنائیں" بٹن کے ساتھ ایک سائیڈ پینل کھولتا ہے جو کوڈیکس کلاؤڈ ٹاسک استعمال کرتا ہے تاکہ برانچ کو جائزہ کے لیے آگے بڑھایا جا سکے۔

API کے بارے میں کیا خیال ہے - کیا میں اسے اپنی ایپ سے کال کر سکتا ہوں؟

اوپن اے آئی کے اعلانات بتاتے ہیں۔ API سپورٹ جلد آرہا ہے۔ GPT-5-Codex-Mini کے لیے؛ لکھنے کے وقت ماڈل کوڈیکس ٹول چین پہلے (CLI/IDE) میں دستیاب ہے۔ اس کا مطلب ہے کہ پروڈکشن API کلائنٹس کو ماڈل کے نام کی تیاری کرنی چاہیے۔ gpt-5-codex-mini Requests/Responses API میں شائع ہونے کے بعد۔ اس دوران، آپ کوڈیکس CLI اور IDE بہاؤ کے ساتھ پروٹو ٹائپ کر سکتے ہیں۔

جب API رسائی کو فعال کیا جاتا ہے، تو ایک عام کال (جوابات کی طرز) اس طرح نظر آسکتی ہے:

# illustrative — check OpenAI docs for final param names

from openai import OpenAI

client = OpenAI(api_key="sk-...")

resp = client.responses.create(

model="gpt-5-codex-mini",

input="Write a Python function that validates an email address and includes unit tests.",

max_tokens=512,

temperature=0.2

)

print(resp.output_text)

کوڈیکس مینی کے ساتھ تیز رفتار انجینئرنگ کے بہترین طریقے کیا ہیں؟

ذیل میں پروڈکشن انجینئرنگ ورک فلو میں Codex Mini سے زیادہ سے زیادہ قیمت حاصل کرنے کے لیے کنکریٹ، فیلڈ ٹیسٹ شدہ بہترین طریقے اور نمونے ہیں۔

1) ماڈل کے انتخاب کی حکمت عملی - مکس اینڈ میچ

ہائی فریکوئنسی، کم پیچیدگی والے کاموں (فارمیٹنگ، چھوٹے ریفیکٹرز، آٹو ٹیسٹ) کے لیے Mini کا استعمال کریں، اور پیچیدہ ڈیزائن، گہری ڈیبگنگ، یا بڑے ریپو وائیڈ ٹرانسفارمیشنز کے لیے مکمل کوڈیکس پر واپس جائیں۔ سوئچ کو خودکار بنائیں: کوڈیکس CLI پہلے ہی 90% استعمال پر Mini تجویز کرتا ہے، اور آپ اسکرپٹ کرسکتے ہیں۔ /model کام کی پیچیدگی کی بنیاد پر ماڈل کا انتخاب کرنے کے لیے اپنے ٹولنگ میں سوئچ کرنا۔

2) فوری انجینئرنگ ٹیمپلیٹس

دہرائے جانے والے کاموں کے لیے چھوٹے، عزمی پرامپٹ ٹیمپلیٹس تیار کریں: ٹیسٹ جنریشن، چینج لاگ ڈرافٹ، کمٹ میسج جنریشن، اور PR کی تفصیل۔ ان کو اپنے ریپو میں دوبارہ قابل استعمال ٹکڑوں کے طور پر یا کوڈیکس پرامپٹ پیش سیٹ کے طور پر اسٹور کریں۔

یونٹ ٹیسٹ کے لیے مثال کے طور پر فوری ٹیمپلیٹ:

# Template: generate_pytests

System: You are a precise Python developer. Produce pytest tests.

User: Given the function below, produce parametrized pytest functions that cover typical edge cases.

--- file: discounts.py

<insert function>

---

Return only valid Python test code with imports and fixtures.

3) خودکار حفاظتی جال — منظوری اور CI گیٹنگ

کبھی بھی کسی ماڈل کو انسانی منظوری کے بغیر کوڈ کو براہ راست پش کرنے کی اجازت نہ دیں۔ کوڈیکس کے منظوری کے طریقوں اور کوڈیکس کلاؤڈ ٹاسک کا استعمال کریں تاکہ اختلافات پیدا ہوں اور CI میں ہیومن سائن آف کی ضرورت ہو۔ کوڈیکس CLI "منظوری کے طریقوں" کو سپورٹ کرتا ہے لہذا لاگو ہونے سے پہلے ترمیم کی منظوری ہونی چاہیے۔

4) کیشے اور ڈپلیکیٹ ماڈل کالز

دہرائے جانے والے اشارے کے لیے (مثال کے طور پر، کسی فنکشن کی وضاحت)، پرامپٹ + فائل ہیش کے ذریعے کلید کردہ جواب کو کیش کریں۔ یہ فالتو کالوں کو کم کرتا ہے اور لاگت کے پروفائل کو قابل قیاس رکھتا ہے۔

5) سٹریمنگ + انکریمنٹل ڈف کا استعمال کریں۔

جب ممکن ہو تو، پوری فائل کو دوبارہ لکھنے کے بجائے سٹریمنگ آؤٹ پٹس اور انکریمنٹل ڈیف کی درخواست کریں۔ اس سے ٹوکن کا استعمال کم ہوتا ہے اور جائزہ لینے والوں کو ہدفی تبدیلیاں دیکھنے میں مدد ملتی ہے۔

6) یونٹ ٹیسٹ-پہلے جنریٹر کا بہاؤ

ٹیسٹ تیار کریں اور انہیں عارضی ماحول میں مقامی طور پر چلائیں۔ اگر ٹیسٹ ناکام ہو جاتے ہیں، تو ناکامی ٹیسٹ کی اصلاحات فراہم کرنے والے ماڈل کے ساتھ دہرائیں۔ ٹیسٹ آؤٹ پٹس کے ساتھ ہر تکرار کو ایک مجرد پرامپٹ کے طور پر فریم کریں۔

مثال کوڈیکس CLI آٹومیشن اسنیپٹ (bash):

# Generate tests

codex --model gpt-5-codex-mini request "Generate pytest tests for discounts.py" > generated_tests.py

# Run tests locally

pytest generated_tests.py -q || {

echo "Tests failed. Opening Codex for debugging..."

codex --model gpt-5-codex-mini request "Tests failed. Here's pytest output: $(tail -n 50 pytest_output.txt). Propose a fix for discounts.py."

}

نتیجہ

GPT-5-Codex-Mini ایک عملی پروڈکٹ اقدام ہے: یہ تسلیم کرتا ہے کہ ڈویلپر کے ورک فلو پر اکثر بہت سے مختصر تعاملات کا غلبہ ہوتا ہے جہاں تاخیر، لاگت، اور بلاتعطل بہاؤ اہمیت رکھتا ہے۔ IDE اور CLI کے استعمال کا مقصد ایک چھوٹے درجے کی فراہمی کے ذریعے، OpenAI ٹیموں کو یہ صلاحیت فراہم کرتا ہے کہ وہ ہر تعامل کے لیے فوری طور پر سب سے زیادہ لاگت والے ماڈل کی درخواست کیے بغیر یومیہ کوڈنگ امداد کی پیمائش کریں۔

ڈویلپرز رسائی حاصل کر سکتے ہیں۔ GPT-5-Codex API ,GPT-5 Pro API CometAPI کے ذریعے، CometAPI کے تازہ ترین ماڈلز مضمون کی اشاعت کی تاریخ کے مطابق ہیں۔ رسائی کرنے سے پہلے، براہ کرم یقینی بنائیں کہ آپ نے CometAPI میں لاگ ان کیا ہے اور API کلید حاصل کر لی ہے۔CometAPI آپ کو انضمام میں مدد کے لیے سرکاری قیمت سے کہیں کم قیمت پیش کریں۔

جانے کے لیے تیار ہیں؟→ CometAPI کے لیے آج ہی سائن اپ کریں۔ !

اگر آپ AI پر مزید ٹپس، گائیڈز اور خبریں جاننا چاہتے ہیں تو ہمیں فالو کریں۔ VK, X اور Discord!